(完整word版)多种最小二乘算法分析+算法特点总结

各类最小二乘算法

β N −1 H* = N 0

β N −2

β 2( N −1) WN = 0

β 2( N −2)

0 ⋱ 1

三、递推算法 ∵

k θ(k ) = ∑ β i =1

∧

2(k −i) h (i )h T (i )

2随着采样次数的增多数据量不断增加ls估计有可能出现所谓的数据饱和现象导致递推算法不能接近参数真二关于数据饱和现象的分析所谓数据饱和现象就是随着时间的推移采集到的数据越来越多新数据所提供的信息被淹没在老数据的海洋之中

Ⅴ 各种最小二乘类参数辨识算法 §1 概 述

最小二乘类参数辨识算法(一次完成算法、递推算法) 最小二乘类参数辨识算法 (一次完成算法 、 递推算法 ) 是一种 最基本和常用的参数估计方法。但研究和应用表明, 最基本和常用的参数估计方法。 但研究和应用表明, 这一算 法仍存在明显的不足。 法仍存在明显的不足。 一、LS 算法的主要不足之处 1、当模型噪声为有色噪声时,LS 估计不再是无偏估计、一致 、当模型噪声为有色噪声时, 估计不再是无偏估计、 估计。 估计。 2、随着采样次数的增多,数据量不断增加,LS估计有可能出 、随着采样次数的增多,数据量不断增加, 估计有可能出 现所谓的“数据饱和”现象, 现所谓的“数据饱和”现象,导致递推算法不能接近参数真 值。

于是有: 于是有:

α P ( k ) P − 1 ( k − 1) = I − P ( k ) h ( k ) h T ( k )

则:

ˆ θ ( k ) = P ( k ) H * T Z * = P ( k ) α H * −1T Z * −1 + h ( k ) z ( k ) k k k k

(完整word版)多位数乘法口算巧算

乘法口算巧算技法两位数乘法1.十几乘十几:口诀:头乘头,尾加尾,尾乘尾。

例:12×14=?解:1×1=12+4=62×4=812×14=168注:个位相乘,不够两位数要用0占位。

2.头相同,尾互补(尾相加等于10):口诀:一个头加1后,头乘头,尾乘尾。

例:23×27=?解:2+1=32×3=63×7=2123×27=621注:个位相乘,不够两位数要用0占位。

3.第一个乘数互补,另一个乘数数字相同:口诀:一个头加1后,头乘头,尾乘尾。

例:37×44=?解:3+1=44×4=167×4=2837×44=1628注:个位相乘,不够两位数要用0占位。

4.几十一乘几十一:口诀:头乘头,头加头,尾乘尾。

例:21×41=?解:2×4=82+4=61×1=121×41=8615.11乘任意数:口诀:首尾不动下落,中间之和下拉。

例:11×23125=?解:2+3=53+1=41+2=32+5=72和5分别在首尾11×23125=254375 注:和满十要进一。

6.十几乘任意数:口诀:第二乘数首位不动向下落,第一因数的个位乘以第二因数后面每一个数字,加下一位数,再向下落。

例:13×467=?解:13个位是33×4+6=183×6+7=253×7=2113×467=6071注:和满十要进一。

7.多位数乘以多位数口诀:前一个因数逐一乘后一个因数的每一位,第二位乘10倍,第三位乘100倍……以此类推例:33*132=?33*1=3333*3=9933*2=6699*10=99033*100=330066+990+3300=435633*132=4356注:和满十要进一。

数学中关于两位数乘法的“首同末和十”和“末同首和十”速算法。

(完整word版)多种最小二乘算法分析+算法特点总结

第一部分:程序设计思路、辨识结果分析和算法特点总结 (3)一:RLS遗忘因子法 (3)RLS遗忘因子法仿真思路和辨识结果 (3)遗忘因子法的特点: (4)二:RFF遗忘因子递推算法 (4)仿真思路和辨识结果 (4)遗忘因子递推算法的特点: (6)三:RFM限定记忆法 (6)仿真思路和辨识结果 (6)RFM限定记忆法的特点: (7)四:RCLS偏差补偿最小二乘法 (7)仿真思路和辨识结果 (7)RCLS偏差补偿最小二乘递推算法的特点: (9)五:增广最小二乘法 (9)仿真思路和辨识结果 (9)RELS增广最小二乘递推算法的特点: (11)六:RGLS广义最小二乘法 (11)仿真思路和辨识结果 (11)RGLS广义最小二乘法的特点: (13)七:RIV辅助变量法 (14)仿真思路和辨识结果 (14)RIV辅助变量法的特点: (15)八:Cor-ls相关最小二乘法(二步法) (15)仿真思路和辨识结果 (15)Cor—ls相关最小二乘法(二步法)特点: (17)九:MLS多级最小二乘法 (17)仿真思路和辨识结果 (17)MLS多级最小二乘法的特点: (21)十:yule_walker辨识算法 (21)仿真思路和辨识结果 (21)yule_walker辨识算法的特点: (22)第二部分:matlab程序 (23)一:RLS遗忘因子算法程序 (23)二:RFF遗忘因子递推算法 (24)三:RFM限定记忆法 (26)四:RCLS偏差补偿最小二乘递推算法 (29)五:RELS增广最小二乘的递推算法 (31)六;RGLS 广义最小二乘的递推算法 (33)七:Tally辅助变量最小二乘的递推算法 (37)八:Cor-ls相关最小二乘法(二步法) (39)九:MLS多级最小二乘法 (42)十yule_walker辨识算法 (46)第一部分:程序设计思路、辨识结果分析和算法特点总结一:RLS遗忘因子法RLS遗忘因子法仿真思路和辨识结果仿真对象如下:其中, v(k )为服从N(0,1)分布的白噪声。

最小二乘法和theil-sen趋势估计方法_概述说明以及解释

最小二乘法和theil-sen趋势估计方法概述说明以及解释1. 引言1.1 概述引言部分将总体介绍本篇文章的研究主题和方法。

本文将探讨最小二乘法和Theil-Sen趋势估计方法,这两种方法旨在通过拟合数据来寻找变量间的关系,并用于预测和估计未来的趋势。

最小二乘法是一种常见且广泛应用的回归分析方法,而Theil-Sen趋势估计方法是一种鲁棒性更强的非参数统计方法。

1.2 文章结构引言部分还需要简要描述整篇文章的结构以供读者参考。

本文包含以下几个主要部分:引言、最小二乘法、Theil-Sen趋势估计方法、对比与对比分析、结论与展望。

每个部分将详细说明相关概念、原理及其在实际应用中的特点。

1.3 目的引言部分还需明确指出本文的目的。

本文旨在比较和对比最小二乘法和Theil-Sen趋势估计方法,评估它们在不同场景下的优缺点,并为读者提供选择适当方法进行数据拟合和趋势预测的依据。

此外,我们也会展望未来这两种方法的改进和应用领域扩展的可能性。

以上为“1. 引言”部分的详细清晰撰写内容。

2. 最小二乘法:2.1 原理介绍:最小二乘法是一种常用的回归分析方法,用于寻找一个函数(通常是线性函数)来逼近已知数据点的集合。

其基本原理是通过最小化实际观测值与模型预测值之间的残差平方和,寻找到使得残差最小化的系数,并将其作为估计值。

利用最小二乘法可以得到拟合直线、曲线或者更复杂的函数来描述数据点之间的关系。

2.2 应用场景:最小二乘法广泛应用于各种领域和行业,包括经济学、社会科学、物理学等。

例如,在经济学中,最小二乘法可以用于研究变量之间的关系以及预测未来趋势。

在工程领域,它可以用于建立模型并进行参数估计。

2.3 优缺点分析:最小二乘法具有以下优点:- 算法简单易行:只需要对数据进行简单处理即可求解出最佳拟合曲线。

- 表示能力强:可以适应不同类型函数的拟合。

- 结果一致性较好:针对相同数据集,得到的结果通常是一致的。

然而,最小二乘法也存在一些缺点:- 对异常值敏感:在数据集中存在离群值时,会对拟合曲线产生较大影响。

最小二乘估计的特点

最小二乘估计的特点

1.理论上可行:最小二乘估计是一种基于数学原理的估计方法,其在理论上是可行的。

通过求解模型中的估计参数,可以得到最小化残差平方和的最优解。

2. 适用性广泛:最小二乘估计可以应用于各种类型的模型,包

括线性模型、非线性模型、多元模型等。

此外,该方法还可以用于处理有误差的测量数据,例如测量误差、观测误差等。

3. 稳健性强:最小二乘估计对于数据的异常值比较敏感,但是

可以通过使用一些统计方法来提高其稳健性,例如加权最小二乘估计、岭回归、lasso回归等。

4. 计算简单:最小二乘估计的计算比较简单,可以通过求解线

性方程组来得到估计参数的解。

此外,在计算过程中还可以使用矩阵运算来加速计算速度。

5. 非唯一性:最小二乘估计中,存在多组参数估计值可以使残

差平方和最小化。

此时需要根据实际情况来选择最合适的估计结果。

总之,最小二乘估计是一种非常重要的估计方法,在各种领域都有着广泛的应用。

它的特点包括理论可行、适用性广泛、稳健性强、计算简单和非唯一性等。

- 1 -。

最小二乘估计的特点

最小二乘估计的特点最小二乘估计是一种常用的数学工具,用于研究多元线性回归等问题。

它的特点包括可解性、稳定性、无偏性和最优性等方面,下面将就这些特点进行详细阐述。

可解性最小二乘估计是一种易于实现的算法,其可解性是其显著优势之一。

以线性最小二乘为例,其求解只需要对原始数据进行简单的矩阵运算即可得到解析解。

对于比较大规模的数据,使用数学软件也可以快速求解。

因此,最小二乘估计在数据科学领域得到了广泛应用。

稳定性最小二乘估计在一定条件下具有很好的稳定性。

其所谓稳定性是指当数据的测量误差较小或多样本的样本量较大时,能够得到较为稳定的估计结果。

这是因为最小二乘估计所依赖的假设条件比较强,尤其是在存在离群点(outlier)的情况下易出现不切实际的结果。

因此,在使用最小二乘估计时,应当对数据进行适当的处理,以提高结果的可靠性。

无偏性最小二乘估计在一定条件下是无偏的。

所谓无偏性是指,对于不同的样本数据,其所得到的估计结果在统计意义上是相等的。

这是因为该方法所得到的估计量在数学上是对真实参数的有效估计,不对误差产生任何影响。

最优性最小二乘估计在一定条件下是最优的。

所谓最优性是指,在满足一定条件的情况下,该方法所得到的估计结果在所有无偏估计方法中具有最小的方差,即具有最小的均方误差(MSE)。

在满足高斯-马尔科夫假设的情况下,线性最小二乘估计是最优的无偏估计。

这也是最小二乘估计被广泛应用的原因之一。

总体性质最小二乘估计还有一个重要的优点,即其可应用于总体参数的估计。

所谓总体参数是指,对于一个群体或大型数据集,除了我们观察到的样本之外,其中还存在其他数据。

最小二乘法能够基于我们从样本中获得的信息,推断出这些数据的一些特性,即总体参数。

这使得最小二乘法在大样本时的应用得以实现,从而可以对总体参数进行有效估计。

综上所述,最小二乘估计具有可解性、稳定性、无偏性和最优性等显著特点,在解决线性回归等问题时具有很好的应用前景。

然而,使用最小二乘估计也存在一些限制,比如数据的假设条件比较严格,存在离群点时易出现不切实际的结果等,因此,在使用最小二乘估计时应当对数据进行适当的处理,以提高结果的可靠性。

系统辨识之最小二乘

写成矩阵的形式为:

Y = Fq + e

3.6

é - y(n)

- y(n -1) … - y(1) u(n) … u(1) ù

F

=

ê ê ê

-

y(n "

-1)

- y(n) "

… - y(2)

u(n +1)

…

u(2)

ú ú

…"

" # "ú

êë- y(n + N ) - y(n + N -1) ! - y(N ) u(n + N ) ! u(N )úû

q = F -1y

如果噪声x ¹ 0,则 q = F-1y - F-1x

从上式可以看出噪声 x 对参数估计有影响,为了尽量减小噪声 x 对q 估值的影响,应取 N>(2n+1), 即方程数大于未知数数目。在这种情况下,不能用解方程的办法来求q ,而要采用数理统计的办法, 以便减小噪声对q 估值的影响。在给定输出向量 y 和测量矩阵 F 的条件下求系统参数q 的估值,这 就是系统辨识问题。可用最小二乘法来就q 的估值。

在科学研究中,为了揭示某些相关量之间的关系,找出其规律,往往需要求解其函数解析式。

一种方法是采用插值逼近法,即所构造的近似函数 f (x) 在已知节点 xi 上必须满足 f(xi) = yi 要求逼 近函数 f (xi) 与被逼近函数 f (x) 在各已知点 xi 处的误差为零,即要求 f (x) 的曲线必须通过所有的

取泛函 J (q )为

N

å å J (q ) = (Y - Fq )2 = e2 (n + i) = eT • e = (Y - Fq )T (Y - Fq ) i =1

各种最小二乘算法总结

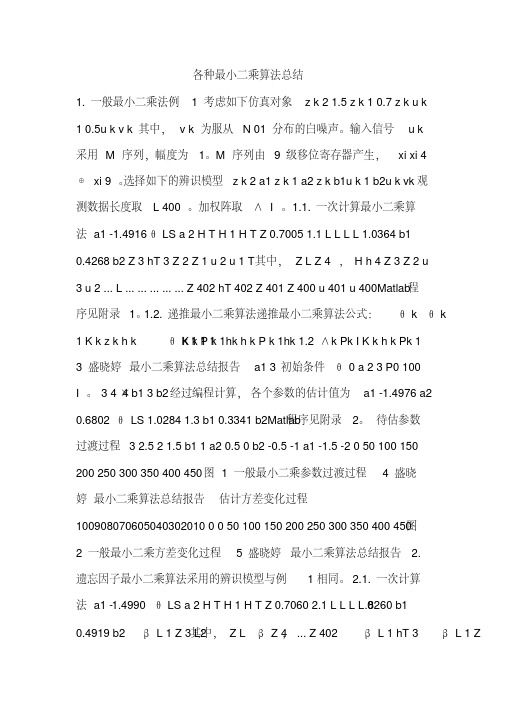

各种最小二乘算法总结1. 一般最小二乘法例 1 考虑如下仿真对象z k 2 1.5 z k 1 0.7 z k u k1 0.5u k v k 其中,v k 为服从N 01 分布的白噪声。

输入信号u k采用M 序列,幅度为1。

M 序列由9 级移位寄存器产生,xi xi 4⊕xi 9 。

选择如下的辨识模型z k 2 a1 z k 1 a2 z k b1u k 1 b2u k vk 观测数据长度取L 400 。

加权阵取∧I 。

1.1. 一次计算最小二乘算法a1 -1.4916 θ LS a 2 H T H 1 H T Z 0.7005 1.1 L L L L 1.0364 b10.4268 b2 Z 3 hT 3 Z 2 Z 1 u 2 u 1 T其中,Z L Z 4 ,H h 4 Z 3 Z 2 u3 u 2 ... L ... ... ... ... ... Z 402 hT 402 Z 401 Z 400 u 401 u 400Matlab程序见附录1。

1.2. 递推最小二乘算法递推最小二乘算法公式:θ k θ kK k P k 1hk h k P k 1hk 1.2 ∧k Pk I K k h k Pk 11 K k z k h k θ k 1 1 13 盛晓婷最小二乘算法总结报告a1 3 初始条件θ 0 a 2 3 P0 100I 。

3 4×4 b1 3 b2经过编程计算,各个参数的估计值为a1 -1.4976 a2程序见附录2。

待估参数0.6802θ LS 1.0284 1.3 b1 0.3341 b2Matlab过渡过程 3 2.5 2 1.5 b1 1 a2 0.5 0 b2 -0.5 -1 a1 -1.5 -2 0 50 100 150200 250 300 350 400 450 图 1 一般最小二乘参数过渡过程 4 盛晓婷最小二乘算法总结报告估计方差变化过程100908070605040302010 0 0 50 100 150 200 250 300 350 400 450 图2 一般最小二乘方差变化过程 5 盛晓婷最小二乘算法总结报告 2.遗忘因子最小二乘算法采用的辨识模型与例1相同。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第一部分:程序设计思路、辨识结果分析和算法特点总结 (2)一:RLS遗忘因子法 (2)RLS遗忘因子法仿真思路和辨识结果 (2)遗忘因子法的特点: (3)二:RFF遗忘因子递推算法 (4)仿真思路和辨识结果 (4)遗忘因子递推算法的特点: (5)三:RFM限定记忆法 (5)仿真思路和辨识结果 (5)RFM限定记忆法的特点: (7)四:RCLS偏差补偿最小二乘法 (7)仿真思路和辨识结果 (7)RCLS偏差补偿最小二乘递推算法的特点: (9)五:增广最小二乘法 (9)仿真思路和辨识结果 (9)RELS增广最小二乘递推算法的特点: (11)六:RGLS广义最小二乘法 (12)仿真思路和辨识结果 (12)RGLS广义最小二乘法的特点: (14)七:RIV辅助变量法 (14)仿真思路和辨识结果 (14)RIV辅助变量法的特点: (16)八:Cor-ls相关最小二乘法(二步法) (17)仿真思路和辨识结果 (17)Cor-ls相关最小二乘法(二步法)特点: (18)九:MLS多级最小二乘法 (19)仿真思路和辨识结果 (19)MLS多级最小二乘法的特点: (22)十:yule_walker辨识算法 (23)仿真思路和辨识结果 (23)yule_walker辨识算法的特点: (24)第二部分:matlab程序 (24)一:RLS遗忘因子算法程序 (24)二:RFF遗忘因子递推算法 (26)三:RFM限定记忆法 (28)四:RCLS偏差补偿最小二乘递推算法 (31)五:RELS增广最小二乘的递推算法 (33)六;RGLS 广义最小二乘的递推算法 (36)七:Tally辅助变量最小二乘的递推算法 (39)八:Cor-ls相关最小二乘法(二步法) (42)九:MLS多级最小二乘法 (45)十yule_walker辨识算法 (49)第一部分:程序设计思路、辨识结果分析和算法特点总结一:RLS遗忘因子法RLS遗忘因子法仿真思路和辨识结果仿真对象如下:其中, v(k )为服从N(0,1)分布的白噪声。

输入信号u(k)采用M 序列,幅度为 1。

M 序列由 9 级移位寄存器产生,x(i)=x(i-4)⊕x(i-9)。

选择如下辨识模型:加权阵取Λ=I。

衰减因子β = 0.98,数据长度 L = 402。

辨识结果与理论值比较,基本相同。

辨识结果可信:Estimate =-1.46660.65030.97360.3035遗忘因子法的特点:对老数据加上遗忘因子,以降低老数据对辨识的影响,相对增加新数据对辨识的影响,不会出现“数据饱和”现象。

如模型噪声是有色噪声,则Ø是有偏估计量。

常用作其他辨识方式的起步,以获得其他方式的初始值。

二:RFF遗忘因子递推算法仿真思路和辨识结果辨识模型与遗忘因子法所用模型相同。

其中, 0 ≤µ≤1为遗忘因子,此处取0.98。

数据长度L=402,初始条件:参数a1 a2 b1 b2的估计值:ans =-1.49770.68631.19030.4769待估参数变化过程如图所示:遗忘因子递推算法的特点:从上面两个例子可以看出对于相同的仿真对象,一次算法和递推算法结果基本一致,但递推算法可以实现在线实时辨识,而且可以减少计算量和存储量。

三:RFM限定记忆法仿真思路和辨识结果辨识模型与遗忘因子法所用模型相同。

辨识结果与理论值比较,基本相同。

辨识结果可信:参数 a1 a2 b1 b2 的估计值为:Theta_a =-1.51280.70990.83930.4416待估参数的过渡过程如下:RFM限定记忆法的特点:辨识所使用的数据长度保持不变,每增加一个新数据就抛掉一个老数据,使参数估计值始终只依赖于有限个新数据所提供的新消息,克服了遗忘因子法不管多老的数据都在起作用的缺点,因此该算法更能有效的克服数据饱和现象。

四:RCLS偏差补偿最小二乘法仿真思路和辨识结果辨识模型与遗忘因子法所用模型相同。

辨识结果与理论值比较,基本相同。

辨识结果可信:参数a1 a2 b1 b2的估计值为:ans =-1.49160.70051.03650.4271RCLS偏差补偿最小二乘递推算法的特点:算法思想::在最小二乘参数估计值的基础上,引进补偿项σW2C-1D Ø0,则获得了参数的无偏估计。

针对模型噪声来说,RCLS算法的适应能力比RLS更好。

五:增广最小二乘法仿真思路和辨识结果考虑如下仿真对象:其中,为服从N(0,1)分布的白噪声。

输入信号采用 M 序列,幅度为 1。

M 序列由 9 级移位寄存器产生,x(i)=x(i-4)⊕x(i-9)。

选择如下的辨识模型:观测数据长度取L =402 。

加权阵取Λ=I。

辨识结果与理论值比较,基本相同,同时又能获得噪声模型的参数估计。

辨识结果可信:参数a1、a2、b1、b2、d1、d2估计结果:ans =-1.50000.70001.00010.5002-0.99990.2000RELS增广最小二乘递推算法的特点:增广最小二乘的递推算法对应的噪声模型为滑动平均噪声,扩充了参数向量和数据向量H(k)的维数,把噪声模型的辨识同时考虑进去。

最小二乘法只能获得过程模型的参数估计,而增广最小二乘法同时又能获得噪声模型的参数估计,若噪声模型为平均滑动模型,,则只能用RELS算法才能获得无偏估计。

当数据长度较大时,辨识精度低于极大似然法。

六:RGLS广义最小二乘法仿真思路和辨识结果模型结构选择:模型结构选用:其中,各个参数的真值为:广义最小二乘算法为:辨识结果与理论值比较,基本相同,同时又能获得噪声传递系数的参数估计。

辨识结果可信:参数a1 a2 b1 b2的估计结果:ans =-1.50580.69720.93160.4833噪声传递系数c1 c2的估计结果:ans =0.62030.2210RGLS广义最小二乘法的特点:该算法用于自回归输入模型,是一种迭代的算法。

其基本思想是基于对数据先进行一次滤波处理,后利用普通最小二乘法对滤波后的数据进行辨识,进而获得无偏一致估计。

但是当过程的输出信噪比比较大或模型参数较多时,这种数据白色化处理的可靠性就会下降,辨识结果往往会是有偏估计。

数据要充分多,否则辨识精度下降。

模型阶次不宜过高。

初始值对辨识结果有较大影响。

七:RIV辅助变量法仿真思路和辨识结果辨识模型与遗忘因子法所用模型相同,只不过此处噪声为有色噪声,产生过程为:e(k)=v(k)+0.5v(k-1)+0.2v(k-2),v(k)为0均值的不相关随机噪声。

按照Tally法选取辅助变量x(k)=z(k-n d), n d为误差传递函数的阶数,此处为2.则有辅助变量法的递推公式可写成:辨识结果与理论值比较,基本相同。

辨识结果可信:参数a1 a2 b1 b2的估计结果:ans =-1.53140.74610.99990.4597RIV辅助变量法的特点:适当选择辅助变量,使之满足相应条件,参数估计值就可以是无偏一致。

估计辅助变量法的计算量与最小二乘法相当,但辨识效果却比最小二乘法好的多。

尤其当噪声是有色的,而噪声的模型结构又不好确定时,增广最小二乘法和广义最小二乘法一般都不好直接应用,因为他们需要选用特定的模型结构,而辅助变量法不需要确定噪声的模型结构,因此辅助变量法就显得更为灵活,但辅助变量法不能同时获得噪声模型的参数估计。

八:Cor-ls相关最小二乘法(二步法)仿真思路和辨识结果辨识模型与遗忘因子法所用模型相同:,e(k)=v(k)+0.5v(k-1)+0.2v(k-2),v(k)为0均值的不相关随机噪声。

Cor-ls的递推公式可写成:其中:,M(k)为输入M序列。

初始条件:辨识结果与理论值比较,基本相同,辨识结果可信:参数a1 a2 b1 b2的估计结果:ans =-1.48960.68581.01680.4362Cor-ls相关最小二乘法(二步法)特点:把辨识分成两步进行:第一步:利用相关分析法获得对象的非参数模型(脉冲响应或相关函数);第二步:利用最小二乘法、辅助变量法或增广最小二乘法等,进一步求的对象的参数模型。

如果模型噪声与输入无关,则Cor-ls相关最小二乘法(二步法)可以得到较好的辨识结果。

Cor-ls相关最小二乘法(二步法)实质上是先对数据进行一次相关分析,滤除了有色噪声的影响,再利用最小二乘法必然就会改善辨识结果。

能适应较宽广的噪声范围,计算量不大,初始值对辨识结果影响较小。

但要求输入信号与噪声不相关。

九:MLS多级最小二乘法仿真思路和辨识结果仿真对象如下:其中,u (k)是输入变量,此处为 M 序列;v (k ) 是零均值、方差为 1 的不相关随机噪声,通过控制λ的大小来控制信噪比。

辨识模型结构选用:其中,辨识过程如下:第一级,辅助模型参数辨识原模型可写为:利用最小二乘法可获得辅助模型的参数无偏一致估计值:数据长度 L=400,第二级,过程模型参数辨识:根据最小二乘算法可以获得过程模型的参数估计值为:第三级,噪声模型参数辨识:根据最小二乘算法可以获得过程模型的参数估计值为辨识结果与理论值比较,基本相同。

辨识结果可信:第一级辅助模型参数 e1 e2 e3 e3 e4 f1 f2 f3 f4 辨识结果:E =1.90621.44540.52790.0613-0.00260.7988-0.8694-1.3037-0.6318第二级过程模型参数 a1 a2 a3 b1 b2 辨识结果:E2 =0.93040.15960.01130.7998-1.6502第三级噪声模型参数 c1 c2 辨识结果:E3 =0.97500.3824MLS多级最小二乘法的特点:当信噪比较大时,采用广义最小二乘法可能会出现多个局部收敛点,解决这个问题的方法可用多级最小二乘法,一般来说多级最小二乘法包含三级辨识过程。

利用输入输出数据,通过多级最小二乘法,可分别求的辅助模型,过程模型和噪声模型的参数估计值。

在高噪声的情况下,多级最小二乘法明显优于广义最小二乘法,其收敛点唯一。

十:yule_walker辨识算法仿真思路和辨识结果仿真对象如下:,z (k)是可观测变量;v (k )是均值为零,方差为 1 的不相关随机噪声;数据长度取 L=1024。

相关函数按下式计算:参数的估计算法按下式计算:辨识结果与理论值比较,基本相同,同时又能获得噪声模型的参数估计。

辨识结果可信:辨识结果为:Theta =0.85970.2955-0.0034d =1.0025yule_walker辨识算法的特点:yule_walker辨识算法可以方便的辨识形如的参数估计值。

第二部分:matlab程序一:RLS遗忘因子算法程序clearclc%==========================================%最小二乘法辨识对象% Z(k+2)=1.5*Z(k+1)-0.7*Z(k)+u(k+1)+0.5*u(k)+v(k)%==========产生M序列作为输入===============x=[0 1 0 1 1 0 1 1 1]; %初始值n=403; %n为脉冲数目M=[]; %存放M序列for i=1:ntemp=xor(x(4),x(9));M(i)=x(9);for j=9:-1:2x(j)=x(j-1);endx(1)=temp;end;%产生高斯白噪声v=randn(1,400);z=[];z(1)=-1;z(2)=0;u=0.98;% 遗忘因子L=400;for i=3:402z(i)=1.5*z(i-1)-0.7*z(i-2)+M(i-1)+0.5*M(i-2)+v(i-2); zstar(i)=z(i)*u^(L-i+2);endH=zeros(400,4);for i=1:400H(i,1)=-z(i+1)*u^(L-i);H(i,2)=-z(i)*u^(L-i);H(i,3)=M(i+1)*u^(L-i);H(i,4)=M(i)*u^(L-i);endEstimate=inv(H'*H)*H'*(zstar(3:402))'二:RFF遗忘因子递推算法%最小二乘遗忘因子的递推算法仿真对象%Z(k+2)=1.5*Z(k+1)-0.7*Z(k)+u(k+1)+0.5*u(k)+v(k)%========================================clearclc%==========400 个产生M序列作为输入===============x=[0 1 0 1 1 0 1 1 1]; %initial valuen=403; %n为脉冲数目M=[]; %存放M 序列for i=1:ntemp=xor(x(4),x(9));M(i)=x(9);for j=9:-1:2x(j)=x(j-1);endx(1)=temp;end%===========产生均值为0,方差为1 的高斯白噪声=========v=randn(1,400);%==============产生观测序列z=================z=zeros(402,1);z(1)=-1;z(2)=0;for i=3:402z(i)=1.5*z(i-1)-0.7*z(i-2)+M(i-1)+0.5*M(i-2)+v(i-2); end%==============递推求解=================P=10*eye(4); %估计方差Theta=zeros(4,401); %参数的估计值,存放中间过程估值Theta(:,1)=[0.001;0.001;0.001;0.001];K=zeros(4,400); %增益矩阵K=[10;10;10;10];u=0.98; %遗忘因子for i=3:402h=[-z(i-1);-z(i-2);M(i-1);M(i-2)];K=P*h*inv(h'*P*h+u);Theta(:,i-1)=Theta(:,i-2)+K*(z(i)-h'*Theta(:,i-2)); P=(eye(4)-K*h')*P/u;end%==========================输出结果及作图=============================disp('参数a1 a2 b1 b2的估计值:')Theta(:,401)i=1:401;figure(1)plot(i,Theta(1,:),i,Theta(2,:),i,Theta(3,:),i,Theta(4,:)) title('待估参数过渡过程')三:RFM限定记忆法%限定记忆最小二乘的递推算法辨识对象%Z(k+2)=1.5*Z(k+1)-0.7*Z(k)+u(k+1)+0.5*u(k)+v(k)%========================================clearclc%==========产生M序列作为输入===============x=[0 1 0 1 1 0 1 1 1]; %initial valuen=403; %n为脉冲数目M=[]; %存放M 序列for i=1:ntemp=xor(x(4),x(9));M(i)=x(9);for j=9:-1:2x(j)=x(j-1);endx(1)=temp;end%===========产生均值为0,方差为1 的高斯白噪声=========v=randn(1,402);%==============产生观测序列z=================z=zeros(402,1);z(1)=-1;z(2)=0;for i=3:402z(i)=1.5*z(i-1)-0.7*z(i-2)+M(i-1)+0.5*M(i-2)+v(i);end%递推求解P_a=100*eye(4); %估计方差Theta_a=[3;3;3;3];L=20; %记忆长度for i=3:L-1 %利用最小二乘递推算法获得初步参数估计值和P 阵h=[-z(i-1);-z(i-2);M(i-1);M(i-2)];K=P_a*h*inv(h'*P_a*h+1);Theta_a=Theta_a+K*(z(i)-h'*Theta_a);P_a=(eye(4)-K*h')*P_a;endfor k=0:380hL=[-z(k+L-1);-z(k+L-2);M(k+L-1);M(k+L-2)];%增加新数据的信息K_b=P_a*hL*inv(1+hL'*P_a*hL);Theta_b=Theta_a+K_b*(z(k+L)-hL'*Theta_a);P_b=(eye(4)-K_b*hL')*P_a;hk=[-z(k+L);-z(k+L-1);M(k+L);M(k+L-1);];%去掉老数据的信息K_a=P_b*hk*inv(1+hk'*P_b*hk);Theta_a=Theta_b-K_a*(z(k+L+1)-hk'*Theta_b);P_a=(eye(4)+K_a*hk')*P_b;Theta_Store(:,k+1)=Theta_a;end%========================输出结果及作图===========================disp('参数 a1 a2 b1 b2 的估计值为:')Theta_ai=1:381;figure(1)plot(i,Theta_Store(1,:),i,Theta_Store(2,:),i,Theta_Store(3, :),i,Theta_Store(4,:))title('待估参数过渡过程')四:RCLS偏差补偿最小二乘递推算法%偏差补偿最小二乘的递推算法辨识对象%Z(k+2)=1.5*Z(k+1)-0.7*Z(k)+u(k+1)+0.5*u(k)+v(k)%========================================clearclc%==========产生M序列作为输入===============x=[0 1 0 1 1 0 1 1 1]; %initial valuen=403; %n为脉冲数目M=[]; %存放M 序列for i=1:ntemp=xor(x(4),x(9));M(i)=x(9);for j=9:-1:2x(j)=x(j-1);endx(1)=temp;end%===========产生均值为0,方差为1 的正态分布噪声========= v=random('Normal',0,1,1,400);%==============产生观测序列z=================z=zeros(402,1);z(1)=-1;z(2)=0;for i=3:402z(i)=1.5*z(i-1)-0.7*z(i-2)+M(i-1)+0.5*M(i-2)+v(i-2);end%===================递推求解==================%赋初值P=100*eye(4); %估计方差Theta=zeros(4,401); %参数的估计值,存放中间过程估值Theta(:,1)=[3;3;3;3];K=[10;10;10;10]; %增益J=0;ThetaC=zeros(4,401); %偏差补偿后的估计值ThetaC(:,1)=[2;3;1;3.5];D=[1 0 0 0;0 1 0 0;0 0 0 0;0 0 0 0];for i=3:402h=[-z(i-1);-z(i-2);M(i-1);M(i-2)];J=J+(z(i-1)-h'*Theta(:,i-1))^2/(1+h'*P*h);K=P*h*inv(h'*P*h+1);Theta(:,i-1)=Theta(:,i-2)+K*(z(i)-h'*Theta(:,i-2));P=(eye(4)-K*h')*P;endes=J/((i-1)*(1+(ThetaC(:,i-2))'*D*Theta(:,i-1)));ThetaC(:,i-1)=Theta(:,i-1)+(i-1)*es*P*D*ThetaC(:,i-2);%==============输出参数估计结果及作图================disp('参数a1 a2 b1 b2的估计值为:')Theta(:,401)i=1:401;figure(1)plot(i,Theta(1,:),i,Theta(2,:),i,Theta(3,:),i,Theta(4,:)) title('待估参数过渡过程')五:RELS增广最小二乘的递推算法%增广最小二乘的递推算法辨识对象%Z(k+2)=1.5*Z(k+1)-0.7*Z(k)+u(k+1)+0.5*u(k)-v(k+1)+0.2*v(k) %========================================clearclc%==========产生M序列作为输入===============x=[0 1 0 1 1 0 1 1 1]; %initial valuen=403; %n为脉冲数目M=[]; %存放M 序列for i=1:ntemp=xor(x(4),x(9));M(i)=x(9);for j=9:-1:2x(j)=x(j-1);endx(1)=temp;end%===========产生均值为0,方差为1 的高斯白噪声=========v=randn(1,402);%==============产生观测序列z=================z=zeros(402,1);z(1)=-1;z(2)=0;for i=3:402z(i)=1.5*z(i-1)-0.7*z(i-2)+M(i-1)+0.5*M(i-2)-v(i-1)+0.2*v(i -2);end%递推求解P=100*eye(6); %估计方差Theta=zeros(6,401); %参数的估计值,存放中间过程估值Theta(:,1)=[3;3;3;3;3;3];% K=zeros(4,400); %增益矩阵K=[10;10;10;10;10;10];for i=3:402h=[-z(i-1);-z(i-2);M(i-1);M(i-2);v(i-1);v(i-2)];K=P*h*inv(h'*P*h+1);Theta(:,i-1)=Theta(:,i-2)+K*(z(i)-h'*Theta(:,i-2));P=(eye(6)-K*h')*P;end%========================================================== =============disp('参数a1、a2、b1、b2、d1、d2估计结果:')Theta(:,401)i=1:401;figure(1)plot(i,Theta(1,:),i,Theta(2,:),i,Theta(3,:),i,Theta(4,:),i, Theta(5,:),i,Theta(6,:))title('待估参数过渡过程')六;RGLS 广义最小二乘的递推算法%广义最小二乘的递推算法仿真模型%Z(k+2)=1.5*Z(k+1)-0.7*Z(k)+u(k+1)+0.5*u(k)+e(k)%e(k+2)+2.1*e(k+1)-2.5*e(k)=v(k+2)%========================================clearclc%==========400 个产生M序列作为输入===============x=[0 1 0 1 1 0 1 1 1]; %initial valuen=403; %n为脉冲数目M=[]; %存放M 序列for i=1:ntemp=xor(x(4),x(9));M(i)=x(9);for j=9:-1:2x(j)=x(j-1);endx(1)=temp;end%===========产生均值为0,方差为1 的高斯白噪声========= v=randn(1,400);e=[]; e(1)=v(1); e(2)=v(2);for i=3:400e(i)=0*e(i-1)+0*e(i-2)+v(i);end%==============产生观测序列z=================z=zeros(400,1);z(1)=-1;z(2)=0;for i=3:400z(i)=1.5*z(i-1)-0.7*z(i-2)+M(i-1)+0.5*M(i-2)+e(i); end%变换后的观测序列zf=[];zf(1)=-1;zf(2)=0;for i=3:400zf(i)=z(i)-0*z(i-1)-0*z(i-2);end%变换后的输入序列uf=[]; uf(1)=M(1); uf(2)=M(2);for i=3:400uf(i)=M(i)-0*M(i-1)-0*M(i-2);end%赋初值P=100*eye(4); %估计方差Theta=zeros(4,400); %参数的估计值,存放中间过程估值Theta(:,2)=[3;3;3;3];K=[10;10;10;10]; %增益PE=10*eye(2);ThetaE=zeros(2,400);ThetaE(:,2)=[0.5;0.3];KE=[10;10];%递推Thetafor i=3:400h=[-zf(i-1);-zf(i-2);uf(i-1);uf(i-2)];K=P*h*inv(h'*P*h+1);Theta(:,i)=Theta(:,i-1)+K*(z(i)-h'*Theta(:,i-1));P=(eye(4)-K*h')*P;endhe=[-e(i-1);-e(i-2)];%递推ThetaEKE=PE*he*inv(1+he'*PE*he);ThetaE(:,i)=ThetaE(:,i-1)+KE*(e(i)-he'*ThetaE(:,i-1)); PE=(eye(2)-KE*he')*PE;%=====================输出结果及作图=========================disp('参数a1 a2 b1 b2的估计结果:')Theta(:,400)disp('噪声传递系数c1 c2的估计结果:')ThetaE(:,400)i=1:400;figure(1)plot(i,Theta(1,:),i,Theta(2,:),i,Theta(3,:),i,Theta(4,:)) title('待估参数过渡过程')七:Tally辅助变量最小二乘的递推算法%Tally辅助变量最小二乘的递推算法%Z(k+2)=1.5*Z(k+1)-0.7*Z(k)+u(k+1)+0.5*u(k)+e(k),e(k)为有色噪声%e(k)=v(k)+0.5*v(k-1)+0.2*v(k-2),v(k)为零均值的不相关随机噪声%========================================clearclc%==========产生M序列作为输入===============x=[0 1 0 1 1 0 1 1 1]; %initial valuen=403; %n为脉冲数目M=[]; %存放M 序列for i=1:ntemp=xor(x(4),x(9));M(i)=x(9);for j=9:-1:2x(j)=x(j-1);endx(1)=temp;end%===========产生均值为0,方差为1 的高斯白噪声========= v=randn(1,400);e=[];e(1)=0.3;e(2)=0.5;for i=3:400e(i)=v(i)+0.5*v(i-1)+0.2*v(i-2);end%==============产生观测序列z=================z=zeros(402,1);z(1)=-1;z(2)=0;for i=3:400z(i)=1.5*z(i-1)-0.7*z(i-2)+M(i-1)+0.5*M(i-2)+e(i); end%递推求解P=100*eye(4); %估计方差Theta=zeros(4,400); %参数的估计值,存放中间过程估值Theta(:,1)=[3;3;3;3];Theta(:,2)=[3;3;3;3];Theta(:,3)=[3;3;3;3];Theta(:,4)=[3;3;3;3];% K=zeros(4,400); %增益矩阵K=[10;10;10;10];for i=5:400h=[-z(i-1);-z(i-2);M(i-1);M(i-2)];hstar=[-z(i-2-1);-z(i-2-2);M(i-1);M(i-2)]; %辅助变量 %递推算法K=P*hstar*inv(h'*P*hstar+1);Theta(:,i)=Theta(:,i-1)+K*(z(i)-h'*Theta(:,i-1));P=(eye(4)-K*h')*P;end%==================结果输出及作图=================== disp('参数a1 a2 b1 b2的估计结果:')Theta(:,400)i=1:400;figure(1)plot(i,Theta(1,:),i,Theta(2,:),i,Theta(3,:),i,Theta(4,:)) title('待估参数过渡过程')八:Cor-ls相关最小二乘法(二步法)%两步法的递推算法%Z(k+2)=1.5*Z(k+1)-0.7*Z(k)+u(k+1)+0.5*u(k)+e(k),e(k)为零均值的不相关随机噪声%e(k)=v(k)+0.5*v(k-1)+0.2*v(k-2)%========================================clearclc%==========产生M序列作为输入===============x=[0 1 0 1 1 0 1 1 1]; %initial valuen=403; %n为脉冲数目M=[]; %存放M 序列for i=1:ntemp=xor(x(4),x(9));M(i)=x(9);for j=9:-1:2x(j)=x(j-1);endx(1)=temp;end%===========产生均值为0,方差为1 的高斯白噪声========= v=randn(1,400);e=[];e(1)=0.3;e(2)=0.5;for i=3:400e(i)=v(i)+0.5*v(i-1)+0.2*v(i-2);end%==============产生观测序列z===========z=zeros(402,1);z(1)=-1;z(2)=0;for i=3:400z(i)=1.5*z(i-1)-0.7*z(i-2)+M(i-1)+0.5*M(i-2)+e(i);end%递推求解P=100*eye(4); %估计方差Theta=zeros(4,400); %参数的估计值,存放中间过程估值Theta(:,1)=[3;3;3;3];Theta(:,2)=[3;3;3;3];Theta(:,3)=[3;3;3;3];Theta(:,4)=[3;3;3;3];K=zeros(4,400); %增益矩阵K=[10;10;10;10];for i=5:400h=[-z(i-1);-z(i-2);M(i-1);M(i-2)];hstar=[M(i-1);M(i-2);M(i-3);M(i-4)]; %辅助变量%递推K=P*hstar*inv(h'*P*hstar+1);Theta(:,i)=Theta(:,i-1)+K*(z(i)-h'*Theta(:,i-1));P=(eye(4)-K*h')*P;end%==================结果输出及作图===================disp('参数a1 a2 b1 b2的估计结果:')Theta(:,400)i=1:400;figure(1)plot(i,Theta(1,:),i,Theta(2,:),i,Theta(3,:),i,Theta(4,:)) title('待估参数过渡过程')九:MLS多级最小二乘法clearclc%==========================================%Z(k+3)=-0.9*Z(k+2)-0.15*Z(k+1)-0.02*z(k)+0.7*u(k+2)-1.5*u(k +1)+e(k)%e(k+2)+1.0*e(k+1)+0.41*e(k)=r*v(k+2)%==========产生M 序列作为输入===============x=[0 1 0 1 1 0 1 1 1]; %initial valuen=405; %n为脉冲数目M=[]; %存放M 序列for i=1:ntemp=xor(x(4),x(9));M(i)=x(9);for j=9:-1:2x(j)=x(j-1);endx(1)=temp;end%===========产生均值为0,方差为1 的高斯白噪声============= v=randn(1,405);e=[];e(1)=0.3;e(2)=0.7;r=0.9; %控制信噪比for i=3:405e(i)=-1.0*e(i-1)-0.41*e(i-2)+r*v(i);end%=================产生观测序列===================z=[];z(1)=-1;z(2)=0;z(3)=1.5;for i=4:405z(i)=-0.9*z(i-1)-0.15*z(i-2)-0.02*z(i-3)+0.7*M(i-1)-1.5*M(i -2)+e(i);end%================第一级辨识辅助模型参数辨识==================H=zeros(400,9);for i=1:400H(i,1)=-z(i+4);H(i,2)=-z(i+3);H(i,3)=-z(i+2);H(i,4)=-z(i+1);H(i,5)=-z(i);H(i,6)=M(i+4);H(i,7)=M(i+3);H(i,8)=M(i+2);H(i,9)=M(i+1);enddisp('第一级辅助模型参数 e1 e2 e3 e3 e4 f1 f2 f3 f4 辨识结果:')E=inv(H'*H)*H'*(z(6:405))'e1=E(1);e2=E(2);e3=E(3);e4=E(4);e5=E(5);f1=E(6);f2=E(7);f3=E(8);f4=E(9);%=================第二级辨识过程模型参数辨识====================z2=[f1;f2;f3;f4;0;0;0];H2=[ 0 0 0 1 0;-f1 0 0 e1 1;-f2 -f1 0 e2 e1;-f3 -f2 -f1 e3 e2;-f4 -f3 -f2 e4 e3;0 -f4 -f3 e5 e4;0 0 -f4 0 e5;];disp('第二级过程模型参数 a1 a2 a3 b1 b2 辨识结果:') E2=inv(H2'*H2)*H2'*z2a1=E2(1);a2=E2(2);a3=E2(3);b1=E2(4);b2=E2(5);%================第三级辨识噪声模型参数辨识=======================z3=[e1-a1;e2-a2;e3-a3;e4;e5;f2-b2;f3;f4];H3=[1 0;a1 1;a2 a1;a3 a2;0 a3;b1 0;b2 b1;0 b2;];disp('第三级噪声模型参数 c1 c2 辨识结果:')E3=inv(H3'*H3)*H3'*z3十yule_walker辨识算法%Yule-Walker 辨识算法%辨识模型:z(k)=-0.9*z(k-1)-0.36*z(k-2)-0.054*z(k-3)+v(k) %========================================================== ==%产生随机噪声v=random('Normal',0,1,1,1024); %均值为零,方差为 1%产生观测序列z=[];z(1)=0;z(2)=1;z(3)=1.5;for i=4:1024z(i)=-0.9*z(i-1)-0.36*z(i-2)-0.054*z(i-3)+v(i); end%计算 z(k)的自相关函数Rz0=0;Rz1=0;Rz2=0;Rz3=0;for i=1:1024Rz0=Rz0+z(i)^2;endRz0=Rz0/1024;for i=1:1023Rz1=Rz1+z(i+1)*z(i);endRz1=Rz1/1024;for i=1:1022。