bert 中文分词方法

bert_document-segmentation_chinese-base 文档语义分割模型

BERT-based Document Segmentation for Chinese的语义分割模型主要用于文本的自动分段,特别是在中文文本处理中。

它使用BERT(Bidirectional Encoder Representations from Transformers)模型,这是一种基于Transformer的深度双向编码器模型,用于自然语言处理任务,包括文本分类、命名实体识别和情感分析等。

在文本分段任务中,模型接受一个长文本作为输入,并自动将其分割成多个有意义的段落或句子。

这种分段可以根据语义内容进行,而不仅仅是根据固定的格式或规则。

使用BERT进行文档语义分割的优点包括:

1.深度双向处理:BERT能够理解上下文并捕捉句子间的关系,从而使模型能够

更准确地分割文本。

2.强大的预训练:BERT在大量无监督数据上进行预训练,使其能够适应各种语

言和任务。

3.可扩展性:由于BERT的架构,可以通过添加更多的层或使用更强大的硬件来

提高模型的性能。

然而,这种模型也有一些局限性,例如计算复杂度高和需要大量训练数据。

此外,对于某些特定的文本分段任务,可能需要更具体的模型或额外的训练数据。

中文预训练 bert 中文语法

中文预训练 bert 中文语法中文预训练BERT(Bidirectional Encoder Representationsfrom Transformers)是一个基于Transformer架构的深度学习模型,通过预训练和微调的方式,可以在各种中文语言任务上取得出色的表现。

在这篇文章中,我们将重点讨论BERT在中文语法方面的应用。

BERT的预训练模型采用了无监督的方式,利用大规模的中文文本数据进行训练。

通过两个任务来预训练模型:掩码语言模型和下一句预测。

对于掩码语言模型任务,BERT会随机选择一些位置并掩盖掉对应的词汇,然后通过上下文中的其他词汇来预测这些被掩盖的词汇。

这个任务能够使BERT学会理解词汇在上下文中的语义关系。

而下一句预测任务则是通过判断两个句子是否是连续的,来让BERT学习句子间的语义关系。

BERT在中文语法任务中的应用主要可以分为三个方面:词性标注、依存句法分析和语义角色标注。

首先是词性标注,词性标注是对文本中的每个词语标注其所属的词性类别的任务,例如动词、名词、形容词等。

BERT可以通过将文本输入预训练模型中,然后利用其对词汇在上下文中的理解能力来完成词性标注任务。

通过预测每个词汇对应的词性,BERT能够更好地理解词汇在句子中的语法角色。

其次是依存句法分析,依存句法分析是指对句子中的每个词语建立其与其他词语之间的依赖关系。

例如,主谓关系、动宾关系等。

BERT可以通过将句子输入预训练模型中,然后利用其对句子结构的理解能力来完成依存句法分析任务。

通过预测每个词语与其他词语之间的依存关系,BERT能够更好地理解句子的语法结构。

最后是语义角色标注,语义角色标注是指对句子中的每个词语建立其与谓词之间的语义角色关系,例如主体、客体、施事者等。

BERT 可以通过将句子和谓词输入预训练模型中,然后利用其对语义信息的理解能力来完成语义角色标注任务。

通过预测每个词语与谓词之间的语义角色关系,BERT能够更好地理解句子中的语义信息。

bert base chinese 使用方法

bert base chinese 使用方法BERT (Bidirectional Encoder Representations from Transformers)是一种基于Transformer结构的语言模型,可用于自然语言处理任务。

BERT模型在处理中文文本时,需经过以下步骤进行使用:1. 下载和导入模型:从官方网站或其他可信源获取预训练好的BERT中文模型。

将模型文件下载并保存在本地。

使用Python的相关库,如transformers、torch等,导入下载的BERT模型。

2. 文本预处理:在使用BERT模型之前,需要对文本进行预处理。

首先,将文本分割成句子,然后将句子分割成词语或子词。

一种常用的方法是使用分词工具,如jieba。

对于中文文本,通常使用字或字粒度进行分词。

将分词后的文本编码成数字表示,以便输入BERT模型。

3. 输入编码:BERT模型对输入文本进行编码,生成词嵌入。

BERT 使用字嵌入和词嵌入结合的方式来表示文本。

将分词后的文本转换为对应的WordPiece编码,并添加特殊标记如[CLS]和[SEP],以示BERT模型输入的起始和结束。

可以通过依次查找字/词在词表中的索引,将文本转换为词嵌入。

长度不足的文本可以通过填充特殊的[PAD]标记来使其具有相同的长度。

4. 模型输入:将编码后的文本输入BERT模型进行处理。

BERT模型是一个多层双向Transformer结构,其中包含了注意力机制来捕捉上下文信息。

输入文本经过模型的多层结构,在每一层都会得到一个表示,即隐藏状态。

可以根据需要获取某些层的隐藏状态,并进行下一步的处理。

5. 下游任务应用:BERT模型的输出可用于各种下游任务,例如文本分类、命名实体识别等。

通过将BERT模型的输出连接到任务相关的网络层,进行进一步的训练和调优。

BERT模型的使用可通过调整各种超参数和模型结构来适应不同的任务需求。

在实际应用中,一般会进行模型选择、参数调优和训练过程等步骤。

bert base chinese 分词训练文件

bert base chinese 分词训练文件分词是自然语言处理中的一项基础任务,它将连续的文本字符串切分为一个个有意义的词语。

在中文自然语言处理中,由于缺乏明显的词语边界,分词任务显得尤为重要。

而BERT模型,作为一种预训练的语言表示模型,在中文分词任务中也取得了非常好的效果。

BERT Base Chinese是谷歌公司在预训练模型BERT中针对中文语言特点所提供的一种预训练模型。

它是基于未标记的大规模中文文本进行预训练得到的,可以用于各种中文自然语言处理任务。

其中,分词任务就是BERT模型在中文自然语言处理中的一项重要任务之一。

BERT Base Chinese的分词模型是通过在大规模中文文本中进行掩码预测任务来进行训练的。

具体而言,模型会将输入的文本进行分词,并将其中的一部分词语进行掩码处理。

然后,模型通过对掩码位置的词语进行预测,来学习到更好的词向量表示。

BERT Base Chinese的训练文件是在大规模的中文文本上训练得到的,其中包括了各种不同领域和主题的文本数据。

通过这些训练文件,BERT模型可以学习到丰富的语言表示,并且能够在中文分词任务中表现出较高的准确性和鲁棒性。

对于中文分词而言,BERT模型的预训练文件对分词的效果影响很大。

由于中文语言的复杂性和上下文的歧义性,一个好的分词模型需要能够准确地识别出不同词语之间的边界,并正确地切分文本。

BERT 模型通过学习大规模的中文文本,可以从中获取到更多的语言知识和规律,提高分词的准确性。

总结起来,BERT Base Chinese的分词模型是通过在大规模中文文本上训练得到的。

这个训练文件使得BERT模型能够学习到更好的中文语言表示,从而在中文分词任务中取得更好的效果。

中文分词是中文自然语言处理中的基础任务,对于BERT模型的应用来说,这个训练文件是它在中文分词任务中取得成功的重要因素之一。

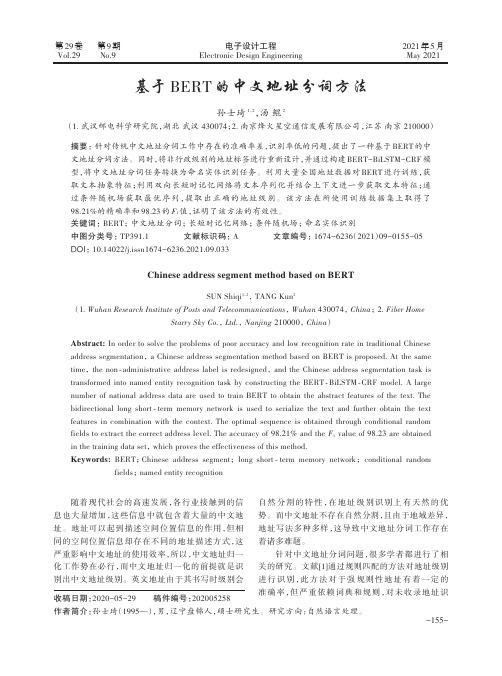

基于BERT的中文地址分词方法

Keywords: BERT;Chinese address segment;long short ⁃ term memory network;conditional random

fields;named entity recognition

随着现代社会的高速发展,各行业接触到的信

自 然 分 割 的 特 性 ,在 地 址 级 别 识 别 上 有 天 然 的 优

bidirectional long short ⁃ term memory network is used to serialize the text and further obtain the text

features in combination with the context. The optimal sequence is obtained through conditional random

ö÷

log F LossFunction = S(X,y) - log æç∑e

è ŷ ∈ Y

ø

还添加了[CLS]和[SEP]两个标签,[CLS]标签主要用在

2 实验与分析间分割。Fra bibliotek2.1

分 类 任 务 当 中 ,非 分 类 任 务 可 以 忽 略 ,[SEP]代 表 句

1.2.2

BiLSTM-CRF

用双向 Transformer 获取上下文的信息,有助于正确

识 别 地 址 级 别 ,GPT 和 BERT 的 结 构 对 比 如 图 1 所

示 。 而 谷 歌 同 时 开 源 了 两 个 版 本 的 模 型 ,分 别 为

BERTBase 和 BERTLarge,如表 1 所示。

数 据 标 注 采 用 BIO 三 段 标 注 法,将 词 的 首 字 标

bert-base-chinese 使用案例

bert-base-chinese 使用案例随着自然语言处理技术的不断发展,深度学习模型成为了处理自然语言任务的重要工具。

BERT(Bidirectional Encoder Representations from Transformers)作为一种基于变压器的预训练模型,具有在各种自然语言处理任务上取得卓越性能的能力。

本文将介绍几个bert-base-chinese的使用案例,展示该模型在不同领域任务中的应用。

一、文本分类任务文本分类是自然语言处理中的一项重要任务,常见于新闻分类、情感分析等场景。

bert-base-chinese作为一种预训练模型,可以用于文本分类任务。

首先,我们需要将待分类的文本经过分词处理,然后输入到bert-base-chinese模型中。

模型将生成词向量表示,并通过多层感知机进行分类。

通过训练模型,可以获得一个高性能的文本分类器,对输入文本进行准确分类。

二、命名实体识别任务命名实体识别是信息抽取和自然语言处理领域的重要任务,其目标是从文本中识别并分类出实体的各个部分。

bert-base-chinese可以应用于命名实体识别任务并取得很好的效果。

首先,我们需要将待处理的文本进行分词,并使用标签对实体进行标注。

然后,将经过标注的文本输入到bert-base-chinese模型中进行训练。

通过学习,模型可以提取出文本中的实体,并进行准确的分类。

三、问答系统问答系统是人工智能领域的热门研究方向,旨在实现机器对自然语言问题的理解和准确回答。

bert-base-chinese可以用于问答系统的搭建。

首先,我们需要将问题和相关文本进行编码,然后将编码后的问题和文本输入到bert-base-chinese模型中。

模型将生成问题和文本之间的相似度得分,根据得分可以准确地选择和问题相关的答案。

四、机器翻译机器翻译是将一种语言的文本转化为另一种语言的过程。

bert-base-chinese可以应用于机器翻译任务,并取得不错的效果。

berttokenizer 分词

berttokenizer 分词分词是自然语言处理中的一项重要任务,它将连续的文本序列切分成有意义的小单位,通常是单词或者字。

在中文中,由于没有像英文中的空格来进行分隔,因此分词任务更为复杂。

为了解决这个问题,一种常用的方法是使用预训练的分词模型,如BERT Tokenizer。

本文将介绍BERT Tokenizer的基本原理和使用方法。

一、BERT Tokenizer的基本原理BERT Tokenizer是基于BERT预训练模型的一种分词工具。

BERT (Bidirectional Encoder Representations from Transformers)是一种基于Transformer结构的预训练模型,其主要利用了上下文信息来对文本进行编码。

在进行分词任务时,BERT Tokenzier会将输入的文本序列按照一定的规则进行切分,并为每个切分出的单词或者字分配一个唯一的编号。

BERT Tokenizer的基本原理包括以下几个步骤:1. 文本清洗:首先,BERT Tokenizer会对输入的文本进行清洗,去除无用的字符和标点符号。

2. 单词切分:接下来,BERT Tokenizer会将清洗后的文本按照一定的规则进行切分,通常以空格或标点符号作为切分点。

3. 单词编码:切分出的每个单词会被转化为一个对应的编号,这个编号可以表示这个单词在BERT预训练模型中的位置。

4. 特殊标记:在文本序列的开头和结尾,BERT Tokenizer会加入特殊的标记,以便模型能够识别出序列的起始和结束。

5. 填充与截断:为了满足模型输入的要求,BERT Tokenizer还会对序列进行填充或截断,使其符合固定长度。

二、BERT Tokenizer的使用方法使用BERT Tokenizer进行分词的基本步骤如下:1. 导入库和模型:首先,需要导入相关的库和BERT预训练模型。

```import torchfrom transformers import BertTokenizer, BertModeltokenizer = BertTokenizer.from_pretrained("bert-base-uncased")model = BertModel.from_pretrained("bert-base-uncased")```2. 分词:接下来,可以使用BERT Tokenizer对文本进行分词。

基于bert的中文文本分类

基于bert的中文文本分类基于BERT的中文文本分类是一种利用自然语言处理技术对中文文本进行分类的方法。

BERT(Bidirectional Encoder Representations from Transformers)是一种预训练的深度双向Transformer模型,具有强大的语义理解能力和上下文感知能力。

通过使用BERT模型,我们可以对中文文本进行有效的分类,从而实现对文本内容的自动分析和理解。

中文文本分类在许多应用场景中都有广泛的应用。

例如,我们可以使用中文文本分类来对新闻文章进行分类,将其归类为政治、经济、娱乐等不同的类别。

我们也可以利用中文文本分类来对用户评论进行情感分析,判断评论是正面的、负面的还是中性的。

此外,中文文本分类还可以用于文本垃圾邮件过滤、舆情监控等领域。

在进行中文文本分类时,我们首先需要对文本进行预处理。

这包括分词、去除停用词等操作,以便将文本转化为机器可处理的形式。

接下来,我们可以使用BERT模型对预处理后的文本进行编码,得到文本的语义表示。

最后,我们可以使用这些表示来训练分类器,以实现对文本的自动分类。

通过基于BERT的中文文本分类,我们可以更好地理解和分析中文文本。

与传统的基于规则或特征工程的方法相比,基于BERT的中文文本分类具有更高的准确性和泛化能力。

它可以从大量的中文语料中自动学习语义信息,并在分类任务中得到更好的表现。

基于BERT的中文文本分类是一种强大的技术,可以帮助我们对中文文本进行自动分类和分析。

它在许多领域中都有广泛的应用,为我们提供了更多的可能性和便利性。

随着自然语言处理技术的不断发展,基于BERT的中文文本分类将会在未来发挥越来越重要的作用。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

bert 中文分词方法

BERT(Bidirectional Encoder Representations from Transformers)是一个基于Transformer的预训练模型,主要用于自然语言处理任务。

在中文分词方面,BERT并没有专门的设计,因为它本质上是一个基于字的分词方法,而非基于词的分词方法。

这意味着BERT在处理中文文本时,会将每个字作为一个基本单位,而不是将整个词作为一个单位。

尽管BERT没有专门的中文分词方法,但它在中文NLP 任务中仍然表现出色。

这是因为BERT的预训练任务包括掩码语言模型和下一句子预测,这些任务有助于模型理解句子的上下文信息和语义关系。

这使得BERT在处理中文文本时,能够自动学习并理解词的边界和含义。

当使用BERT进行中文分词时,你可以将句子中的每个字作为输入,然后利用BERT的模型结构和预训练参数进行预测。

具体来说,你可以将句子中的每个字作为一个token 输入到BERT模型中,然后获取模型输出的每个token的表示向量。

接着,你可以使用这些表示向量来进行后续的任务,如命名实体识别、情感分析等。

需要注意的是,尽管BERT本身没有专门的中文分词方法,但你可以结合其他中文分词工具或算法来提高分词效果。

例如,你可以使用基于统计的分词方法、基于规则的分词方法或基于深度学习的分词方法来对BERT的输出进行后处理,

以获得更准确的分词结果。

总之,BERT在中文分词方面采用的是基于字的分词方法,没有专门的中文分词工具。

但你可以结合其他分词方法或算法来提高分词效果。