中文模糊匹配 分词标注算法

中文句子中的模糊字符串匹配

中文句子中的模糊字符串匹配摘要:一、模糊字符串匹配的概念与背景1.定义模糊字符串2.背景与意义二、中文句子中的模糊字符串匹配方法1.传统的字符串匹配方法2.基于词性标注的匹配方法3.基于词汇的匹配方法4.基于机器学习的匹配方法三、模糊字符串匹配在中文自然语言处理中的应用1.中文分词2.语义角色标注3.命名实体识别四、未来发展趋势与挑战1.结合深度学习的方法2.处理未登录词问题3.提高匹配效率与准确率正文:中文句子中的模糊字符串匹配是自然语言处理领域中的一个重要研究方向。

模糊字符串是指具有不确定性的字符串,如“某人”、“某个地方”等。

在中文自然语言处理任务中,处理模糊字符串对于提高系统的准确性和鲁棒性具有重要意义。

本文将介绍中文句子中的模糊字符串匹配方法及其在自然语言处理中的应用。

一、模糊字符串匹配的概念与背景模糊字符串匹配是指在一定范围内寻找与给定字符串相似的字符串的过程。

在中文自然语言处理中,模糊字符串广泛存在于词汇、句子和篇章中。

为了更好地理解和处理中文文本,研究模糊字符串匹配方法具有重要的实际意义。

二、中文句子中的模糊字符串匹配方法传统的字符串匹配方法主要采用简单的字符匹配,如编辑距离、Levenshtein 距离等。

但这些方法对于模糊字符串的处理能力较弱。

为了解决这一问题,研究者们提出了基于词性标注、词汇和机器学习的匹配方法。

1.基于词性标注的匹配方法:通过分析句子中词的词性,将词性信息引入匹配过程,提高匹配的准确性。

例如,将名词与名词进行匹配,动词与动词进行匹配。

2.基于词汇的匹配方法:通过构建词汇表,将词汇表中的词汇与句子中的词进行匹配。

这种方法可以有效地处理一词多义和未登录词问题。

例如,通过词干提取、词形还原等方法将词汇进行规范化,再进行匹配。

3.基于机器学习的匹配方法:通过训练分类器,实现对模糊字符串的自动匹配。

例如,使用支持向量机(SVM)、神经网络等模型进行匹配。

这些方法可以自动学习文本的特征表示,提高匹配的准确性和泛化能力。

中文句子中的模糊字符串匹配

中文句子中的模糊字符串匹配一、引言在自然语言处理领域,中文句子中的模糊字符串匹配一直是一个具有挑战性的课题。

随着大数据和人工智能技术的发展,模糊匹配算法在各个领域得到了广泛的应用。

本文将介绍模糊字符串匹配的原理,以及在中文字符串中的应用方法和实际案例。

二、模糊字符串匹配原理1.模糊匹配与精确匹配的区别精确匹配是指两个字符串完全相同,而模糊匹配则允许一定程度的差异。

在中文句子中,精确匹配往往难以实现,因为中文字符数量庞大,且词义相近的字符较多。

因此,模糊匹配更具实际意义。

2.模糊字符串匹配的方法常见的模糊匹配方法有:编辑距离(Levenshtein距离)、Jaccard相似度、Jaro-Winkler相似度等。

这些方法都可以在一定程度上度量两个字符串的相似度。

三、中文句子中的模糊字符串匹配应用1.姓名匹配在人际关系挖掘、客户管理等场景中,姓名匹配是一项基本任务。

通过模糊匹配算法,可以找到同名同姓的潜在关联,进一步挖掘有用信息。

2.地名匹配地名匹配在地理信息系统、路径规划等应用中具有重要意义。

通过对地名进行模糊匹配,可以找到相近的地名,方便用户查询和定位。

3.关键词匹配在信息检索、文本挖掘等领域,关键词匹配是核心任务。

通过模糊匹配算法,可以找到与关键词相似的词条,提高检索效果。

四、案例分析1.实际应用场景以客户管理系统为例,通过模糊匹配算法,可以找到同名客户的信息,便于企业进行数据分析和管理。

2.匹配效果评估评估模糊匹配效果的指标有:准确率、召回率、F1值等。

在实际应用中,需要根据具体场景选择合适的评估指标,优化匹配算法。

五、总结与展望本文对中文句子中的模糊字符串匹配进行了简要介绍。

随着大数据和人工智能技术的不断发展,模糊匹配算法在未来将有更广泛的应用前景。

es基于match_phrasefuzzy的模糊匹配原理及使用

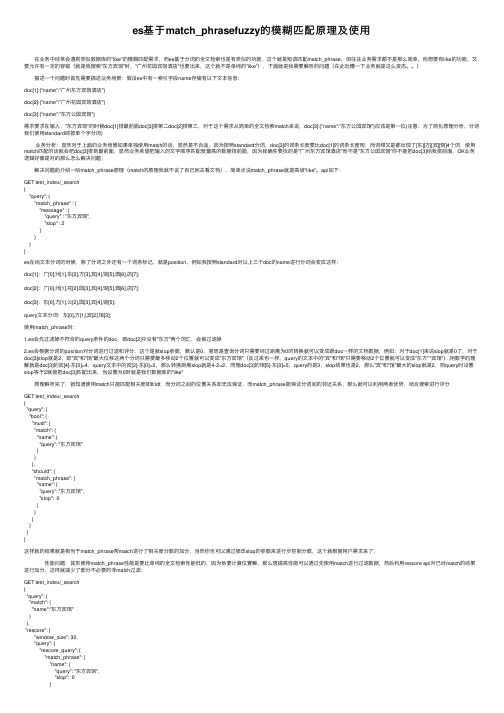

es基于match_phrasefuzzy的模糊匹配原理及使⽤ 在业务中经常会遇到类似数据库的"like"的模糊匹配需求,⽽es基于分词的全⽂检索也是有类似的功能,这个就是短语匹配match_phrase,但往往业务需求都不是那么简单,他想要有like的功能,⼜要允许有⼀定的容错(就是我搜索"东⽅宾馆"时,"⼴州花园宾馆酒店"也要出来,这个就不是单纯的"like"),下⾯就是我需要解析的问题(在此吐槽⼀下业务就是这么变态。

) 描述⼀个问题时⾸先需要描述业务场景:假设es中有⼀索引字段name存储有以下⽂本信息:doc[1]:{"name":"⼴州东⽅宾馆酒店"}doc[2]:{"name":"⼴州花园宾馆酒店"}doc[3]:{"name":"东⽅公园宾馆"}需求要求在输⼊:"东⽅宾馆"的时候doc[1]排最前⾯doc[3]排第⼆doc[2]排第三,对于这个需求从简单的全⽂检索match来说,doc[3]:{"name":"东⽅公园宾馆"}应该是第⼀位(注意:为了简化原理分析,分词我们使⽤standard即按单个字分词) 业务分析:显然对于上⾯的业务场景如果单独使⽤match的话,显然是不合适,因为按照standard分词,doc[3]的词条长度要⽐doc[1]的词条长度短,⽽词频⼜是都出现了[东][⽅][宾][馆]4个词,使⽤match匹配的话就会吧doc[3]排到最前⾯,显然业务希望把输⼊的⽂字顺序匹配度最⾼的数据排前⾯,因为我确实要找的是"⼴州东⽅宾馆酒店"⽽不是"东⽅公园宾馆"你不能把doc[3]给我排前⾯,OK业务逻辑好像是对的那么怎么解决问题; 解决问题前介绍⼀哈match_phrase原理(match的原理我就不说了⾃⼰回去看⽂档),简单点说match_phrase就是⾼级"like"。

excel模糊匹配文字公式

excel模糊匹配文字公式Excel模糊匹配文字公式是一种实用的Excel函数,它可以帮助我们在大量文本数据中快速查找匹配的内容。

本文将介绍Excel模糊匹配文字公式的概念、用法和实际应用。

一、Excel模糊匹配文字公式的概念Excel模糊匹配文字公式是指在Excel表格中,使用文本函数来查找一定程度上匹配的字符串。

一定程度上的匹配是因为我们可以指定匹配的条件,比如只匹配前缀、后缀或者包含指定字符等。

这种模糊匹配文字公式可以帮助我们在复杂的文本数据中快速查找到需要的信息。

二、Excel模糊匹配文字公式的用法Excel模糊匹配文字公式一般用在查找、筛选和计数等操作中。

以下是Excel常用的模糊匹配文字公式:1. LEFT函数:查找以指定字符开始的字符串LEFT函数是常用的模糊匹配文字公式之一,它可以用来查找以指定字符开始的字符串。

LEFT函数的基本语法为:LEFT(text,num_chars)其中,text是需要查找的字符串,num_chars是需要截取的字符数。

比如我们需要查找以“A”开始的字符串,可以使用以下公式:=IF(LEFT(A1,1)="A",A1,"")该公式会检查A1单元格中的字符串是否以“A”开头,如果是,则返回原字符串,否则返回空值。

2. RIGHT函数:查找以指定字符结尾的字符串RIGHT函数是LEFT函数的反向操作,它可以用来查找以指定字符结尾的字符串。

RIGHT函数的基本语法为:RIGHT(text,num_chars)其中,text是需要查找的字符串,num_chars是需要截取的字符数。

比如我们需要查找以“B”结尾的字符串,可以使用以下公式:=IF(RIGHT(A1,1)="B",A1,"")该公式会检查A1单元格中的字符串是否以“B”结尾,如果是,则返回原字符串,否则返回空值。

3. MID函数:查找包含指定字符的字符串MID函数是一种通用的模糊匹配文字公式,它可以帮助我们查找包含指定字符的字符串。

中文 关键字 匹配算法

中文关键字匹配算法关键字匹配算法是一种用于从一段文本中检索指定关键字的算法。

它是信息检索领域中的一项关键技术,被广泛应用于搜索引擎、文本分类、文本摘要等应用中。

在关键字匹配算法中,主要包括以下几个步骤:1.分词:将待匹配的文本进行分词处理,将文本划分成一个个独立的词语。

分词是关键字匹配的第一步,对于中文文本来说,由于中文没有像英文那样明显的单词边界,所以需要进行中文分词处理,以便后续的匹配过程。

2.关键字提取:从待匹配的文本中提取关键字。

关键字是用户要查询或匹配的目标内容,可以手动指定,也可以从文本中自动提取。

3.关键字匹配:将提取出的关键字与分词后的文本进行匹配。

匹配可以采用简单的字符串匹配算法,例如使用KMP算法、BM算法等。

也可以使用更高级的算法,如基于索引的匹配算法、向量空间模型等。

关键字匹配算法的核心在于确定匹配的方式和评价的标准。

对于关键字匹配,可以有以下几种方式:1.精确匹配:只有当待匹配文本中出现完全与关键字相同的词语时,才认为匹配成功。

这种方式适用于要求匹配结果精确的场景。

2.模糊匹配:允许在待匹配文本中出现与关键字近似的词语,通过计算文本中每个词语与关键字的相似度,然后选择最相似的词语作为匹配结果。

这种方式适用于要求模糊匹配的场景,例如拼写纠错。

3.权重匹配:在待匹配文本中出现的关键字可以设置不同的权重,根据关键字在文本中的重要程度,给予不同的权重值,然后通过计算权重的加权和来确定最终的匹配结果。

这种方式适用于需要考虑关键字的重要性的场景。

关键字匹配算法的应用广泛,例如在搜索引擎中,用户通过输入关键字查询相关内容;在文本分类中,根据文本中的关键字将文本归类;在文本摘要中,提取关键字构成文本的摘要等。

不同应用场景下的关键字匹配算法可能会选择不同的分词工具、匹配方式和评价标准。

总结来说,关键字匹配算法是一种用于从文本中检索指定关键字的技术,它通过分词、关键字提取和匹配过程来实现。

自然语言处理 中文分词 mm 算法-概述说明以及解释

自然语言处理中文分词mm 算法-概述说明以及解释1.引言概述部分的内容可以描述自然语言处理(NLP)在当今社会中的重要性,并介绍中文分词作为NLP领域的重要任务。

以下是一种可能的文章概述的写法:“引言1.1 概述自然语言处理(NLP)是计算机科学和人工智能领域的一个重要研究方向。

它涉及计算机与人类自然语言之间的交互,使得计算机能够理解、分析和生成人类语言。

在这个数字化时代,NLP的应用正在不断扩展,包括智能助理、机器翻译、情感分析、信息抽取等等。

其中,中文分词作为NLP领域的关键任务之一,正在受到越来越多的关注。

中文分词指的是将连续的中文文本按照语义逻辑进行切割,将其划分为最小的有意义的单元,称为词语。

中文分词是其他中文处理任务的基础和先决条件,对于提高机器对中文文本的理解和处理能力至关重要。

中文分词的难点在于中文没有像英文那样使用空格来分割单词,而是以字为基本单位。

而且中文词与词之间没有明显的边界,因此需要通过算法来进行切分。

在过去的几十年里,许多中文分词算法被提出,其中最经典和常用的算法之一是MM算法。

本文将会详细介绍自然语言处理和中文分词的背景与重要性,并重点介绍MM算法的原理、流程以及其在中文分词中的应用。

同时,还将对该算法的优缺点进行评述,并进行实验设计,比较MM算法与其他算法的性能差异。

最后,对MM算法进行全面的评价,并探讨研究的局限性和未来的研究方向。

”以上是文章1.1 概述部分的内容,希望对你有所帮助!1.2文章结构1.2 文章结构本文共分为三个部分,分别是引言、正文和结论。

引言部分首先概述了整篇文章的主题,介绍了自然语言处理和中文分词的背景和定义。

随后,简要说明了本文的结构和目的,并对整篇文章进行了总结。

正文部分包括了多个小节,详细介绍了自然语言处理、中文分词的重要性以及现有的中文分词算法。

其中,我们重点讨论了MM算法,包括其算法原理、流程以及优缺点。

此外,我们还探讨了MM算法在中文分词中的应用,并设计了实验来验证其性能。

中文文本自动分词与标注汉语词义自动标注技术

– 大量同音字、同音詞語,化成書面多可消除 歧義。

– 單字多義項者占53.6%(如「打」字之義項數

為26) ;詞組/合成詞多義項者僅占0.46%。

2020/5/30

6

漢字字義組合結構

• 向心性字組 Vs. 離心性字組

– 冰山,青山,火山,高山(核心字在後) Vs. 山峰,山城,山溝, 山村(核心字在前)

多義詞 義項號 搭配類別(L/R)

頻次

註:頻次表示在本次標注語料中該搭配出現的次數

– 根據統計數據自動調整學習進度,逐漸增加上下窗口 長度來學到儘可能多的搭配。

– 打-B01:毆打,攻打→打倒∣打擊∣打架∣… ∣打手 – 打-B02:用手或器具撞擊物體→打鼓∣打火∣… ∣敲

鑼打鼓 –鼓-A01:打擊樂器→鼓板∣鼓槌∣打鼓∣…∣重振旗鼓 –鼓-A02:發動,激起→鼓動∣鼓舞∣… ∣鼓足幹勁

2020/5/30

11

自組織的漢語詞義排歧方法-步驟1

• 以<現代漢語辭海>提供的搭配實例作為多義詞的 初始搭配知識庫,無需人工標注初始語料,用適當 的統計和自組織方法做訓練並自動擴大搭配集。

• 建立基於語義類的語言模型,為語音識別、手寫體 識別和音字轉換提供幫助。

2020/5/30

3

詞義自動標注 ( Word Sense Tagging )

• 也稱為詞義自動排歧 ( Word Sense Disambiguation )

– 計算機運用邏輯運算與推理機制,對出現在一定上下 文中詞語的語義進行正確的判斷,自動確定其正確的 義項並加以標注的過程。

– 語義編碼:是用符號代表語義,關注的是語言 所能表達的意義,每種語言都有自己的語義系 統。漢語和英語屬於不同的語系,前者屬於漢藏語系,

自然语言处理之中文分词算法

自然语言处理之中文分词算法

中文分词算法主要有以下几种:

1. 正向最大匹配算法(Maximum Match Algorithm,MMA):从左到

右匹配词典中最长的词,并不断缩小待匹配文本的长度,直到将整个文本

分词完毕。

2. 逆向最大匹配算法(Reverse Maximum Match Algorithm,RMM):与正向最大匹配算法相反,从右到左匹配词典中最长的词。

3. 双向最大匹配算法(Bidirectional Maximum Match Algorithm,BMM):同时使用正向和逆向最大匹配算法,比较两种结果,选择其中一

种较好的分词结果。

4. 最短路径分词算法(Shortest Path Algorithm,SPA):将文本

看作一个有向有权图,通过最短路径的方式实现分词。

5. 隐马尔可夫模型(Hidden Markov Model,HMM):将分词问题建

模为一个马尔可夫链,利用训练集中的统计信息来找到最可能的分词结果。

这些算法在实际应用中有各自的优劣势,通常需要结合具体的领域和

语料来选择适合的算法。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

中文模糊匹配分词标注算法

中文分词标注算法是自然语言处理中的一项重要技术,它可以将中文文本按照词语的语义进行切分和标注,为后续的文本分析和语义理解提供基础。

本文将介绍中文分词标注算法的原理、常用方法以及应用场景。

我们需要了解中文分词的概念。

中文是一种没有明确的词语边界的语言,因此在自然语言处理中,需要将连续的中文字符序列切分成有意义的词语。

中文分词的目标是找出文本中的词语,并为每个词语标注其词性和其他语义信息。

中文分词标注算法的原理是基于统计和规则的方法。

统计方法通过建立大规模的语料库,利用词频、概率等统计特征对词语进行切分和标注。

常用的统计方法包括隐马尔可夫模型(Hidden Markov Model,HMM)、最大熵模型(Maximum Entropy Model,MEM)和条件随机场(Conditional Random Field,CRF)等。

隐马尔可夫模型是一种常用的序列标注模型,它将分词和标注任务看作是一个序列标注问题。

模型的输入是一个由字符组成的序列,输出是对应的词语序列及其词性标注。

隐马尔可夫模型通过训练语料库中的词语序列和其对应的词性标注,学习词语之间的转移概率和字符到词语的发射概率,从而对新的文本进行分词和标注。

最大熵模型是一种基于信息论的统计模型,它通过最大化熵值来选

择最合适的词语切分和标注方式。

最大熵模型将分词和标注问题转化为一个优化问题,通过最大化模型的似然函数来确定最优的词语切分和标注。

条件随机场是一种概率图模型,它能够对给定的输入序列和输出序列进行联合建模。

条件随机场综合考虑了整个序列的上下文信息,通过学习输入序列和输出序列之间的条件概率分布,实现对文本的准确切分和标注。

除了统计方法,规则方法也常用于中文分词标注。

规则方法通过人工定义一系列规则和规则模板,根据词语的语法和语义特征进行切分和标注。

规则方法的优点是可以根据具体任务和领域进行定制化,但缺点是需要耗费大量人力和时间进行规则的定义和调整。

中文分词标注算法在自然语言处理和信息检索等领域有广泛的应用。

在文本分类和情感分析中,准确的词语切分和标注可以提取关键词和特征,从而进行有效的文本分类和情感分析。

在信息检索中,中文分词标注算法可以帮助搜索引擎更准确地理解用户输入的查询词,提高搜索结果的相关性和准确性。

中文分词标注算法是自然语言处理中的重要技术,它能够将中文文本按照词语的语义进行切分和标注。

常用的算法包括隐马尔可夫模型、最大熵模型和条件随机场等。

中文分词标注算法在文本分类、情感分析和信息检索等领域有广泛的应用。