基于网络爬虫的Web应用程序漏洞扫描器的研究与实现

网络安全漏洞扫描工具的设计与实现

网络安全漏洞扫描工具的设计与实现网络安全一直是各个行业以及个人关注的重点,而网络安全漏洞一直是网络安全的薄弱环节。

为了及时发现并修复漏洞,网络安全漏洞扫描工具应运而生。

本文将介绍一款基于Python语言开发的网络安全漏洞扫描工具的设计与实现。

一、需求分析在设计和实现漏洞扫描工具之前,我们需要分析其主要需求:1.支持多种漏洞扫描方式,包括端口扫描、Web应用程序漏洞扫描等;2.支持多种漏洞检测方法,包括漏洞匹配、漏洞利用等;3.具有可扩展性和可定制性,可以定制新的漏洞检测脚本和扫描方式;4.提供漏洞报告,便于用户查看和分析漏洞情况。

二、设计方案基于以上需求,我们设计了一款名为“NetVulner”的网络安全漏洞扫描工具,其主要设计方案如下:1.采用Python语言开发,具有良好的跨平台性和可移植性;2.支持多种扫描方式,包括端口扫描、Web应用程序扫描、漏洞利用等;3.支持多种漏洞检测方法,包括漏洞匹配、漏洞利用等;4.具有可扩展性和可定制性,用户可以自己编写插件脚本,添加新的扫描方式和漏洞检测方法;5.提供漏洞报告,报告内容包括漏洞详情、严重性等信息,便于用户查看和分析。

三、实现细节1.架构设计NetVulner的整体架构设计采用了模块化的方式,根据功能不同拆分成多个模块,方便维护和扩展。

主要的模块包括:扫描引擎模块、漏洞检测模块、报告生成模块等。

2.扫描引擎模块扫描引擎模块是NetVulner的核心,主要负责扫描目标主机,并将扫描结果传递给漏洞检测模块。

我们采用了nmap工具进行端口扫描,并利用requests库模拟HTTP请求,对Web应用程序进行漏洞扫描。

同时,为了增加扫描精度和速度,我们采用了多线程和协程的方式进行扫描,并对扫描过程中的错误进行了处理,保证扫描结果的准确性。

3.漏洞检测模块漏洞检测模块是NetVulner的关键模块之一,主要负责根据扫描结果,检测目标主机上的漏洞。

我们采用了Metasploit框架中的漏洞模块作为基础,根据漏洞模块的特征和漏洞利用方式,编写相应的检测脚本。

Web应用安全漏洞扫描工具的设计与实现的开题报告

Web应用安全漏洞扫描工具的设计与实现的开题报告题目:Web应用安全漏洞扫描工具的设计与实现一、研究背景及意义随着Web应用的发展,Web应用安全问题也日益突出,各种类型的漏洞不断出现。

黑客攻击、数据泄露等安全问题的发生给企业和个人带来了不可估量的经济损失和信息泄露风险。

因此,如何有效地发现和解决Web应用的安全问题,成为了人们关注的重点之一。

Web应用安全漏洞扫描工具可以对Web应用进行全面的安全扫描,并发现其中存在的漏洞。

它可以帮助企业或个人发现并解决Web应用中存在的安全问题,降低安全风险。

因此,设计和实现一款高效、准确、易用的Web应用安全漏洞扫描工具具有重要的实际意义和应用价值。

二、研究内容与目标本文拟研究如何设计和实现一款基于Web应用的安全漏洞扫描工具,包括以下内容:1.研究Web应用漏洞的类型和传播方式,如SQL注入、跨站脚本等。

2.研究Web应用安全漏洞扫描的技术和方法,如爬虫技术、Fuzzing 技术等。

3.设计和实现一款基于Web应用的安全漏洞扫描工具,包括对输入、链接、表单等进行安全测试、自动化爬虫实现站点映射、基于漏洞特征的Fuzzing等。

4.进行测试和验证,评估工具的准确性、可用性和性能指标等。

三、研究方法本文采用文献法、实验法、案例分析法等研究方法,具体如下:1.通过查找相关文献,了解Web应用漏洞类型和传播方式,熟悉现有的安全漏洞扫描工具。

2.设计并实现一款基于Web应用的安全漏洞扫描工具,借助Fuzzing技术和自动化爬虫实现站点映射,对Web应用进行测试。

3.通过实验,对工具的准确性、可用性和性能指标等进行测试分析,评估工具的优点和不足,提出改进方案。

四、预期结果及贡献通过本次研究,预期实现以下结果和贡献:1.实现一款基于Web应用的安全漏洞扫描工具,帮助企业或个人发现并解决Web应用中存在的安全问题。

2.提出一种基于漏洞特征的Fuzzing方法,增加漏洞扫描的准确性和可靠性。

基于网络爬虫的高校WEB应用漏洞检测

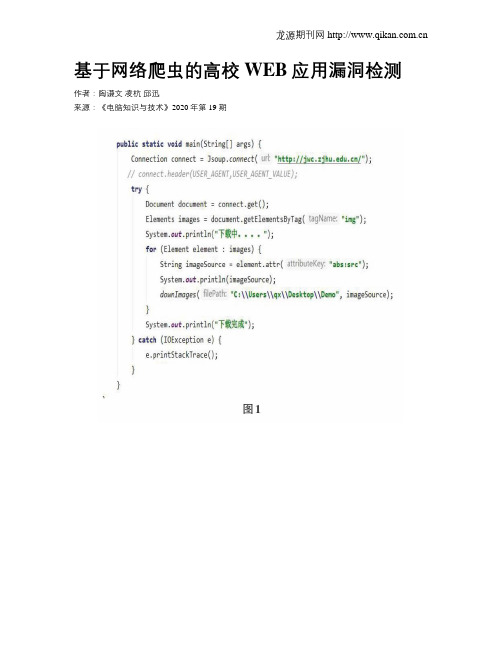

基于网络爬虫的高校WEB应用漏洞检测作者:陶谦文凌杭邱迅来源:《电脑知识与技术》2020年第19期基于网络爬虫的高校WEB应用漏洞检测陶谦文凌杭邱迅摘要:网络安全问题是现代社会非常重视的一个问题,在信息科学技术稳定发展和广泛应用的时期,高校网络安全引起社会广泛关注,因为高校网站集信息发布、数据统计、数据分析、软件办公、共同交流等功能于一体,这使得对学生与教师数据安全与个人隐私的保护尤为重要,为此,本文将讨论通过对各大高校网站统计常见漏洞出现频率,针对各常见漏洞,对其特征进行分析统计,并应用于高校网站,观察高校潜在漏洞。

利用网络爬虫技术,对高校网络进行爬取,提取特征,寻找漏洞,并正确处理。

关键词:网络安全;网络爬虫;网络漏洞中图分类号:TP311 文献标识码:A文章编号:1009-3044(2020)19-0044-03开放科学(资源服务)际i只码(OSID):1 引言当前,中国正处于信息化网络教学调整变革的重要时期,各大高校拥有各自的校园网站以及学生教师数据库。

正是这样的背景下,家长接到的诈骗电话也在不断增加,侧面的反映了各大高校网站信息的安全性是低下的,如何保证高校校园信息安全成为当今社会的热点问题。

因此,本文将讨论通过各大高校网站统计常见漏洞出现频率,针对各常见漏洞,对其特征进行分析统计,并应用于高校网站,观察高校潜在漏洞,实现对各大高校提供模拟攻击服务,应用条件概率模型,对攻击结果形成检测报告。

使用网络爬虫技术建立起高校安全的云平台,以高校网站为主要群体,进行开发应用,以验证检测效率。

2 网络爬虫技术概要网络爬虫,在互联网已经被广泛应用的一种按照确定的逻辑去自动抓取WEB资源(图片,音频等资源)的程序。

爬虫对于WEB系统的访问,一般是难以防范的,爬虫会抢占网络带宽和占用WEB服务器的计算资源,挤占普通用户所分配的资源,使得普通用户使用WEB应用时出现卡顿,频繁掉线等情况从而影响WEB系统的正常运作。

基于Web应用的网络安全漏洞发现与研究

基于Web应用的网络安全漏洞发现与研究Web应用程序已成为当前网络应用程序的主要形式之一。

然而,它同时也是网络攻击行为的主要目标之一。

攻击者可以通过网络安全漏洞入侵Web应用,从而窃取敏感信息或制造其他危险后果。

因此,发现和修复Web应用的漏洞非常重要。

本文将介绍基于Web应用的网络安全漏洞的发现和研究。

Web应用的漏洞形式Web应用的漏洞可以分为输入验证、访问控制、错误处理、密码管理、会话管理、授权和身份认证等多个方面,涉及的形式也非常丰富。

其中比较常见的漏洞形式如下:1. SQL注入攻击者利用SQL注入攻击手段,通过Web应用的输入界面,将恶意SQL语句注入到后台数据库。

当后台对这个恶意SQL语句执行时,攻击者可以窃取数据或者破坏数据库结构,甚至可以控制整个Web应用程序。

2. XSS漏洞XSS(Cross-Site Scripting)漏洞是指攻击者通过向Web应用程序注入恶意脚本,来获取用户的敏感数据、劫持用户会话或者操纵虚拟帐户。

恶意脚本会在被攻击者的浏览器上执行,导致安全风险。

3. CSRF漏洞CSRF(Cross-Site Request Forgery)漏洞是指攻击者在用户不知情的情况下,通过已登录的用户访问模拟伪造请求,使Web应用程序接受未经授权的指令。

攻击者可以通过CSRF漏洞迫使用户执行一些不希望执行的操作,例如发送给其他用户的恶意邮件、转移资金以及转移有效帐户。

Web应用程序的研究和发现是网络安全工作者的重要任务之一。

下面将介绍一些基于Web应用的安全漏洞发现方法:1. 手动测试手动测试是最基本的Web安全漏洞发现方法。

安全工作者可以通过模拟用户或黑客的攻击方式,手工测试每个输入表单、搜索引擎、HTTP请求和隐藏字段来寻找漏洞。

2. 基于漏洞扫描器的测试Web应用漏洞扫描器是一种自动化工具,用于检查Web应用程序的漏洞。

扫描器通过发送恶意输入和处理请求,来测试Web应用程序的安全性和漏洞。

基于Web应用的网络安全漏洞发现与研究

基于Web应用的网络安全漏洞发现与研究

随着Web应用的广泛应用,网络安全问题也逐渐引起人们的关注。

Web应用的网络安

全漏洞指的是应用开发者在设计和实现过程中存在的安全性缺陷,这些漏洞可能会被黑客

利用,从而对系统造成损害。

本文将重点讨论基于Web应用的网络安全漏洞的发现与研

究。

基于Web应用的网络安全漏洞的发现是非常重要的。

通过发现系统中的漏洞,开发者

可以及时修复这些漏洞,从而避免黑客利用漏洞对系统造成损害。

目前,一些自动化的漏

洞扫描工具可以帮助开发者快速地发现系统中的漏洞。

这些工具通过模拟黑客的攻击行为,来检测系统是否存在某种漏洞。

由于Web应用的复杂性,这些自动化工具无法发现所有的

漏洞,因此需要结合人工的方式进行漏洞发现。

基于Web应用的网络安全漏洞的研究也是非常重要的。

通过深入地研究漏洞的原理和

机制,可以帮助开发者更好地理解漏洞的危害性和修复方法。

目前,一些研究者通过分析

已经发现的漏洞,总结了一些常见的漏洞类型,如跨站脚本攻击(XSS)和SQL注入攻击。

这些研究成果可以为开发者提供一些指导方针,来避免这些常见漏洞的出现。

基于Web应用的网络安全漏洞的研究还需要关注一些新兴的漏洞类型。

随着Web应用

的发展,一些新的漏洞类型可能会出现,并且可能具有更加复杂的攻击机制。

研究者需要

密切关注这些新兴漏洞,并开展相关的研究工作。

基于Web应用的网络安全漏洞发现与研究

基于Web应用的网络安全漏洞发现与研究网络安全是当今社会亟待解决的重要问题之一。

随着互联网的普及和网络应用的广泛使用,网络安全漏洞的发现和研究变得尤为重要。

基于Web应用的网络安全漏洞发现与研究是一种通过对Web应用进行安全测试,发现并研究其中存在的漏洞的方法。

Web应用是基于网络的应用程序,广泛应用于电子商务、社交媒体、在线银行等领域。

由于Web应用的复杂性和使用的不安全实践,导致了大量的网络安全漏洞存在。

这些漏洞可能导致用户信息泄露、黑客入侵、拒绝服务攻击等问题,给用户和企业造成严重损失。

基于Web应用的网络安全漏洞发现与研究方法旨在通过对Web应用进行系统性的安全测试,发现其中潜在的安全漏洞,并进行深入研究。

该方法通常包括以下步骤:1. 收集信息:收集关于目标Web应用的信息,包括URL、功能、用户权限等。

通过分析这些信息,可以帮助安全研究人员更加准确地定位漏洞。

2. 识别脆弱点:通过对目标Web应用进行扫描和审计,识别其可能存在的脆弱点。

这些脆弱点可能包括弱密码、SQL注入、跨站脚本攻击(XSS)等。

3. 验证漏洞:对被发现的潜在漏洞进行验证。

通过模拟攻击,验证漏洞是否真实存在,并评估其对系统的威胁程度。

4. 报告漏洞:对已验证的漏洞进行详细报告。

报告中应包括漏洞的描述、可能的影响和建议的修复方法。

5. 修复漏洞:将报告中提到的漏洞进行修复。

修复漏洞是确保Web应用安全的关键步骤,需要技术人员对应用程序进行代码修复、配置更改等。

通过基于Web应用的网络安全漏洞发现与研究,可以及早发现并解决Web应用中存在的漏洞,从而提高系统的安全性。

还可以通过研究已发现的漏洞,发展新的安全措施和技术,以提供更好的网络安全保障。

基于Web应用的网络安全漏洞发现与研究是一种重要的网络安全方法,可以帮助保护用户和企业免受网络攻击的威胁。

只有不断加强网络安全意识,采取有效的安全措施,才能确保网络世界的安全稳定。

基于Web应用的网络安全漏洞发现与研究

基于Web应用的网络安全漏洞发现与研究随着互联网的普及和Web应用的广泛应用,网络安全问题日益凸显。

Web应用的网络安全漏洞对于企业、组织和个人来说都是一个严重的隐患,可能造成信息泄露、数据损坏、服务中断等严重后果。

对于Web应用的网络安全漏洞的发现与研究既具有重要意义,也是当前亟待解决的问题。

一、Web应用的网络安全漏洞Web应用的网络安全漏洞是指那些可能被攻击者利用的缺陷或弱点,导致Web应用的数据、服务或系统遭受损害。

常见的Web应用的网络安全漏洞包括但不限于SQL注入、跨站脚本攻击(XSS)、跨站请求伪造(CSRF)、文件包含漏洞、权限控制问题等。

SQL注入是一种利用Web应用程序对用户输入数据的检查不严谨,导致攻击者可以通过提交恶意的SQL查询来获取潜在的敏感数据的攻击手段。

跨站脚本攻击(XSS)是指攻击者通过在Web页面中插入恶意的脚本代码,从而在用户浏览时将恶意代码执行或者将用户的Cookie等信息窃取的一种攻击手段。

跨站请求伪造(CSRF)是指攻击者盗用了你的身份,以你的名义发送恶意请求的一种攻击手段。

文件包含漏洞是指Web应用程序在包含其他文件的时候存在安全漏洞,导致攻击者可以利用这一漏洞来执行恶意代码。

权限控制问题是指在Web应用程序中没有适当的权限控制机制,导致攻击者可以通过绕过权限机制来获取未授权的访问权限。

以上所述的网络安全漏洞只是Web应用中的一部分,实际上Web应用的网络安全漏洞是一个庞大且复杂的系统。

为了更好地发现和研究这些网络安全漏洞,需要各界共同努力,进行系统的研究和探索。

Web应用的网络安全漏洞的发现是一个复杂而又必不可少的过程。

一方面,网络安全漏洞的发现可以帮助企业、组织和个人及时发现并修复已存在的安全漏洞,保障系统的安全和稳定。

网络安全漏洞的发现也可以帮助研究人员更好地了解网络安全漏洞的种类、原理和攻击手段,为建立更加有效的网络安全防护体系提供理论和实践支持。

使用Python网络爬虫进行网站漏洞扫描与安全评估

使用Python网络爬虫进行网站漏洞扫描与安全评估在当今的数字化时代,互联网已经贯穿了我们日常生活的方方面面。

然而,互联网的广泛应用也带来了一系列安全风险,特别是网站的漏洞。

为了保护用户和企业的隐私和安全,对网站进行漏洞扫描和安全评估显得尤为重要。

本文将介绍使用Python网络爬虫进行网站漏洞扫描与安全评估的方法。

一、Python网络爬虫简介Python是一种简单而强大的编程语言,具有广泛的应用场景。

在网络爬虫领域,Python以其简洁的语法、丰富的库和强大的功能而受到广大开发者的青睐。

Python的网络爬虫框架如Scrapy和Beautiful Soup等可以帮助我们高效地访问和抓取网页数据,为后续的漏洞扫描和安全评估提供基础。

二、网站漏洞扫描流程1. 收集目标网站信息在进行网站漏洞扫描之前,我们首先需要获取目标网站的相关信息。

这些信息可以包括目标网站的URL、IP地址、网页结构等。

Python的网络爬虫可以用于收集这些信息。

通过分析目标网站的HTML和其他资源,我们可以获取网页的结构信息以及内部链接等。

2. 发现网站漏洞一旦我们获取了目标网站的相关信息,接下来的步骤就是发现网站的漏洞。

这可以通过使用Python的网络爬虫来模拟常见的攻击行为,如SQL注入、XSS攻击等。

通过向目标网站发送特定的请求和参数,我们可以分析响应结果,判断是否存在漏洞。

3. 漏洞验证和利用在发现潜在的漏洞后,我们需要进一步验证其是否有效,并评估其对网站安全的威胁程度。

通过使用Python的网络爬虫,我们可以自动化地进行漏洞验证和利用。

这些验证和利用的过程包括发送恶意代码、读取敏感信息等。

通过模拟真实攻击行为,我们可以评估网站的安全性,并找到需要修复的漏洞。

4. 漏洞报告和修复建议完成网站漏洞扫描和安全评估后,我们需要生成漏洞报告,并提供相应的修复建议。

使用Python的网络爬虫和数据处理库,我们可以高效地分析漏洞数据,生成详细的报告。