用Kibana和logstash快速搭建实时日志查询、收集与分析系统

Java日志收集与分析:使用Logstash、Elasticsearch和Kibana进行日志处理

Java日志收集与分析:使用Logstash、Elasticsearch和Kibana进行日志处理引言:在现代软件开发中,日志记录是一项至关重要的任务。

通过记录应用程序的运行时信息和错误,我们可以更好地了解应用程序的行为和性能。

然而,随着应用程序规模的增长,日志数据量也越来越庞大,如何高效地收集、存储和分析这些日志数据成为了一个挑战。

本文将介绍如何使用Logstash、Elasticsearch和Kibana这三个开源工具来进行Java日志的收集和分析。

一、Logstash简介Logstash是一个开源的数据收集引擎,它可以从各种来源(如日志文件、消息队列、数据库等)收集数据,并将其转换为统一的格式,最后输出到指定的目的地。

Logstash具有强大的过滤和转换功能,可以对数据进行各种操作,如解析结构化日志、过滤无关信息、添加额外的字段等。

二、Elasticsearch简介Elasticsearch是一个分布式的实时搜索和分析引擎,它可以快速地存储、搜索和分析大量的数据。

Elasticsearch使用倒排索引的方式来存储数据,使得数据的搜索和分析变得非常高效。

它支持全文搜索、聚合分析、地理位置搜索等功能,非常适合用于日志数据的存储和分析。

三、Kibana简介Kibana是一个基于Elasticsearch的开源数据可视化工具,它可以通过简单的配置和操作来创建各种图表和仪表盘,帮助用户更直观地理解和分析数据。

Kibana支持多种图表类型,如柱状图、折线图、饼图等,还可以对数据进行过滤、聚合、排序等操作,使得数据的可视化分析变得非常方便。

四、日志收集与处理流程1. 安装和配置Logstash首先,我们需要在服务器上安装和配置Logstash。

通过编辑Logstash的配置文件,我们可以指定要收集的日志文件路径、日志格式、过滤规则等。

同时,我们还可以配置Logstash的输出插件,将处理后的日志数据发送到Elasticsearch进行存储。

日志查看方法

日志查看方法在计算机领域,日志是一种记录系统运行情况和事件发生的记录。

无论是服务器、应用程序还是操作系统,都会生成日志文件。

通过查看日志文件,我们可以了解到系统的运行状态,分析问题的原因以及追踪事件的发生过程。

本文将介绍一些常用的日志查看方法,帮助读者快速准确地查看和分析日志。

一、Windows系统下的日志查看方法在Windows系统中,我们可以使用“事件查看器”来查看系统日志、安全日志和应用程序日志等。

以下是详细的操作步骤:1. 打开“事件查看器”在Windows操作系统中,点击“开始”按钮,然后在搜索栏中输入“事件查看器”,并打开该程序。

2. 选择日志类型在事件查看器中,左侧窗口将显示各种日志类型,包括应用程序、安全性、安全性汇总、系统等等。

根据需要,选择相应的日志类型进行查看。

3. 过滤和检索日志右侧窗口将显示所选日志的详细信息。

可以使用筛选器来过滤显示的日志内容,也可以使用关键词搜索来检索特定的日志。

二、Linux系统下的日志查看方法在Linux系统中,日志通常存储在/var/log目录下,并按照不同的服务和应用程序分为多个文件。

以下是一些常用的Linux日志查看命令:1. 检查系统日志使用命令“tail /var/log/syslog”可以查看系统的日志文件。

可以通过加入“-n”参数来指定显示的行数,例如“tail -n 100 /var/log/syslog”将显示最后100行的系统日志。

2. 检查应用程序日志应用程序的日志通常存储在/var/log目录下特定的文件中。

以Apache服务器为例,可以使用命令“tail /var/log/apache2/error.log”来查看Apache服务器的错误日志。

三、使用日志分析工具除了直接查看日志文件,我们还可以使用各种日志分析工具来帮助我们更加高效地分析和查看日志。

以下是一些常用的工具:1. ELK StackELK Stack是一套开源的日志分析平台,包括Elasticsearch、Logstash和Kibana三个工具。

Mac命令行如何使用Logstash进行日志收集和分析

Mac命令行如何使用Logstash进行日志收集和分析日志是应用程序和系统运行过程中产生的关键信息,用于故障排查、性能监测和安全分析等方面。

Logstash是由Elastic公司推出的开源工具,可以用于日志的收集、处理和分析。

在Mac上使用Logstash进行日志收集和分析,可以帮助我们更好地理解和优化应用程序和系统的运行状态。

以下是Mac命令行下使用Logstash进行日志收集和分析的步骤:1. 安装Java Development Kit (JDK)在Mac上使用Logstash之前,首先需要安装JDK。

打开终端,输入以下命令安装JDK:```brew install openjdk@11```2. 安装Logstash在终端中运行以下命令来安装Logstash:```brew tap elastic/tapbrew install elastic/tap/logstash-full```3. 创建Logstash配置文件在终端中使用编辑器创建一个Logstash配置文件,例如,使用vim编辑器创建一个名为`logstash.conf`的文件:```vim logstash.conf```在配置文件中添加以下内容,用于指定日志输入、过滤和输出的插件:```input {file {path => "/path/to/your/logfile.log"start_position => "beginning"}}filter {# 根据需要添加过滤规则}output {elasticsearch {hosts => ["localhost:9200"] # Elasticsearch的地址和端口index => "mylogs-%{+YYYY.MM.dd}" # 索引名称}}```将`/path/to/your/logfile.log`替换为您要收集和分析的实际日志文件路径。

服务器日志管理及分析工具推荐

服务器日志管理及分析工具推荐随着互联网的快速发展,服务器日志管理和分析变得越来越重要。

服务器日志包含了服务器上发生的各种活动和事件记录,通过对这些日志进行管理和分析,可以帮助管理员监控服务器运行状态、排查问题、优化性能等。

为了更高效地管理和分析服务器日志,推荐以下几款优秀的工具:1. **ELK Stack**ELK Stack 是一个开源的日志管理和分析平台,由三个核心组件组成:Elasticsearch、Logstash 和 Kibana。

Elasticsearch 是一个分布式搜索和分析引擎,可以用于存储和检索大量日志数据;Logstash是一个日志收集工具,可以将各种日志数据收集、过滤和转发到Elasticsearch 中;Kibana 则是一个数据可视化工具,可以帮助用户通过图表、表格等形式直观地展示日志数据。

ELK Stack 能够快速构建起一个强大的日志管理和分析系统,广泛应用于各种规模的企业和组织中。

2. **Splunk**Splunk 是一款功能强大的日志管理和分析工具,可以帮助用户实时监控、搜索、分析和可视化各种类型的日志数据。

Splunk 支持从各种来源收集日志数据,包括服务器日志、应用程序日志、网络设备日志等,用户可以通过 Splunk 的搜索语言快速查询和分析日志数据。

此外,Splunk 还提供了丰富的可视化功能,用户可以通过仪表盘、报表等方式直观地展示日志数据的分析结果。

3. **Graylog**Graylog 是一款开源的日志管理平台,提供了日志收集、存储、搜索和分析等功能。

Graylog 支持从各种来源收集日志数据,包括Syslog、GELF、HTTP 等,用户可以通过 Graylog 的搜索功能快速定位和分析特定的日志事件。

此外,Graylog 还提供了警报功能,用户可以设置警报规则,及时发现和响应异常事件。

4. **Fluentd**Fluentd 是一款开源的日志收集工具,支持从各种来源收集日志数据,并将数据转发到不同的目的地,如 Elasticsearch、Kafka、Hadoop 等。

ELK之方便的日志收集、搜索、展示工具

ELK之⽅便的⽇志收集、搜索、展⽰⼯具⼤家在做分部署系统开发的时候是不是经常因为查找⽇志⽽头疼,因为各服务器各应⽤都有⾃⼰⽇志,但⽐较分散,查找起来也⽐较⿇烦,今天就给⼤家推荐⼀整套⽅便的⼯具ELK,ELK是Elastic公司开发的⼀整套完整的⽇志分析技术栈,它们是Elasticsearch,Logstash,和Kibana,简称ELK。

Logstash做⽇志收集分析,Elasticsearch是搜索引擎,⽽Kibana是Web展⽰界⾯。

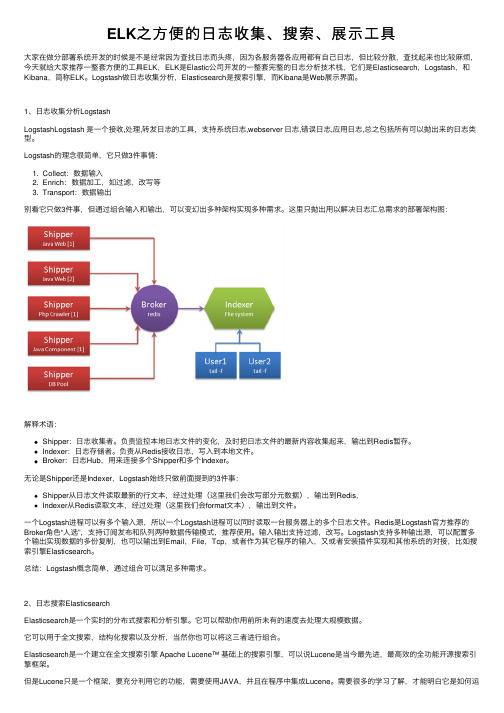

1、⽇志收集分析LogstashLogstashLogstash 是⼀个接收,处理,转发⽇志的⼯具,⽀持系统⽇志,webserver ⽇志,错误⽇志,应⽤⽇志,总之包括所有可以抛出来的⽇志类型。

Logstash的理念很简单,它只做3件事情:1. Collect:数据输⼊2. Enrich:数据加⼯,如过滤,改写等3. Transport:数据输出别看它只做3件事,但通过组合输⼊和输出,可以变幻出多种架构实现多种需求。

这⾥只抛出⽤以解决⽇志汇总需求的部署架构图:解释术语:Shipper:⽇志收集者。

负责监控本地⽇志⽂件的变化,及时把⽇志⽂件的最新内容收集起来,输出到Redis暂存。

Indexer:⽇志存储者。

负责从Redis接收⽇志,写⼊到本地⽂件。

Broker:⽇志Hub,⽤来连接多个Shipper和多个Indexer。

⽆论是Shipper还是Indexer,Logstash始终只做前⾯提到的3件事:Shipper从⽇志⽂件读取最新的⾏⽂本,经过处理(这⾥我们会改写部分元数据),输出到Redis,Indexer从Redis读取⽂本,经过处理(这⾥我们会format⽂本),输出到⽂件。

⼀个Logstash进程可以有多个输⼊源,所以⼀个Logstash进程可以同时读取⼀台服务器上的多个⽇志⽂件。

Redis是Logstash官⽅推荐的Broker⾓⾊“⼈选”,⽀持订阅发布和队列两种数据传输模式,推荐使⽤。

Docker容器的日志收集与分析工具推荐

Docker容器的日志收集与分析工具推荐一、介绍Docker容器的日志收集与分析工具Docker是一种开源的容器化平台,它提供了一种轻量级且可移植的方式来打包和分发应用程序。

随着容器化技术的普及,对容器日志的收集和分析变得愈发重要。

在这篇文章中,我将为您介绍几个常用的Docker容器日志收集与分析工具。

二、ELK StackELK Stack是一个常用的开源工具集,由Elasticsearch、Logstash和Kibana组成,用于实时日志收集和分析。

其中,Elasticsearch是一个分布式搜索和分析引擎,Logstash是一个用于数据收集、转换和传输的工具,Kibana是一个用于数据可视化的工具。

使用ELK Stack进行Docker容器的日志收集与分析,可以通过使用Logstash来收集容器日志,并将其发送到Elasticsearch实例中进行存储和索引。

然后,使用Kibana来可视化和查询日志数据,以便进行实时监控和分析。

ELK Stack具有强大的搜索和过滤功能,可以轻松处理大量的日志数据,并提供丰富的可视化工具,帮助用户更好地理解和分析日志。

三、FluentdFluentd是另一个广泛使用的开源日志收集工具,它支持多种数据源和目标,并能够在分布式环境中进行扩展。

Fluentd可以轻松地与Docker容器集成,通过收集容器日志并将其发送至指定的目标,实现日志的集中存储和分析。

Fluentd通过插件的方式支持多种各类数据源和目标,包括文件、数据库、消息队列等。

其灵活的插件架构使得用户可以根据需求自定义数据的收集和输出方式。

此外,Fluentd还支持日志的过滤和转换,方便用户进行数据清洗和格式转换。

通过配置Fluentd插件,用户可以灵活地实现对Docker容器日志的收集和分析。

四、PrometheusPrometheus是一种开源的监控和警报工具,专注于时序数据的收集与查询。

它具有强大的数据模型和灵活的查询语言,适用于各种复杂的监控场景。

Linux上的日志收集和分析工具比较ELKvsGraylog

Linux上的日志收集和分析工具比较ELKvsGraylogLinux上的日志收集和分析工具比较:ELK vs Graylog在现代的计算机系统中,日志收集和分析是至关重要的。

它们可以帮助管理员监控系统运行情况、诊断问题,并提供安全的实时警报。

对于Linux系统而言,有多种选择可供选择,其中两个主要的选项是ELK和Graylog。

本文将比较这两个工具,以帮助您了解它们的特点和适用场景。

ELK(Elasticsearch, Logstash, Kibana)是一个开源的日志收集和分析工具套件。

它包含三个主要组件:Elasticsearch、Logstash和Kibana。

Elasticsearch是一个实时分布式搜索和分析引擎,它可以快速地存储、搜索和分析大量的数据。

Logstash是一个用于数据收集、过滤、转换和发送的服务器端管道工具。

Kibana是一个用于展示和可视化数据的工具,它提供了强大的图表和仪表盘功能。

相比之下,Graylog是另一个功能强大的开源日志管理平台。

它提供了与ELK类似的功能,但有一些不同之处。

Graylog使用Elasticsearch作为其底层数据存储引擎,因此可以实现类似的实时搜索和分析功能。

然而,Graylog还提供了一些其他功能,例如可配置的警报和通知机制,以及用户和权限管理。

在性能方面,ELK和Graylog都可以处理大量的日志数据。

然而,根据具体的部署要求和硬件配置,它们之间的性能差异可能会有所不同。

ELK在大规模和高吞吐量的数据处理方面表现出色,但在处理较小规模的环境时可能会导致性能损失。

与之相反,Graylog在处理中小规模数据时表现得更加灵活和高效。

在用户界面方面,Kibana和Graylog都提供了直观且易于使用的界面。

Kibana的用户界面可以通过图表、仪表盘和搜索来展示和分析数据,而Graylog则提供了一个类似于电子邮件收件箱的界面,用户可以轻松地搜索、筛选和分析日志数据。

kibana用法

kibana用法Kibana是一种开源的分析和可视化工具,可以帮助用户挖掘和分析大量数据,获得更多信息。

它有助于提升工作效率,改善企业的决策能力和可视度。

Kibana可以与Elasticsearch和Logstash一起使用,搭建一个完整的搜索和分析平台。

Kibana可以帮助用户快速分析和可视化大量数据,可以帮助用户发现隐藏在数据中的未知情况,从而帮助他们作出正确的决策。

Kibana的可视化功能可以使数据变得更加清晰明了,从而帮助用户发现数据之间的关系,更快地发现趋势并作出更明智的决策。

Kibana可以帮助用户以更快的速度查询和分析数据,能够快速建立可视化展示,可以搜索实时日志,以快速索引、检索和分析数据。

此外,它还可以显示动态的地图数据和图表。

Kibana的使用可以分为四个阶段:安装Kibana、配置Kibana、使用Kibana和管理Kibana。

安装Kibana是使用Kibana的第一步,主要是从ElasticSearch 网站上下载Kibana的安装包,然后按照安装说明步骤,完成Kibana 的安装。

配置Kibana主要是对Kibana的一些参数进行设置,同样也是使用Kibana的必备步骤,这一步主要是针对Kibana本身和ElasticSearch服务器上的一些参数进行调整,比如日志类型、日志文件字段、索引名称等等,以便进行搜索和分析。

使用Kibana主要是通过Kibana界面进行搜索和分析,用户可以根据自己的需要,设置搜索条件,然后点击“搜索”,就可以查看搜索结果,并且可以使用可视化的工具将搜索结果以图表的形式展示出来,让数据更加直观。

最后,管理Kibana,是指在使用Kibana的过程中,根据使用情况和需求进行的调整和优化。

比如,对Kibana的参数进行调整,以达到更好的分析效果;Kibana界面也需要不断地优化,以达到更加方便使用的目的;此外,还可以定期对Kibana系统进行备份和维护,以保证其正常运行。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

用Kibana和logstash快速搭建实时日志查询、收集与分析系统Logstash是一个完全开源的工具,他可以对你的日志进行收集、分析,并将其存储供以后使用(如,搜索),您可以使用它。

说到搜索,logstash带有一个web界面,搜索和展示所有日志。

kibana 也是一个开源和免费的工具,他可以帮助您汇总、分析和搜索重要数据日志并提供友好的web界面。

他可以为 Logstash 和 ElasticSearch 提供的日志分析的 Web 界面说到这里,我们看看 kibana 和 logstash到底能为我们做些什么呢?下面是kibana的界面简单来讲他具体的工作流程就是 logstash agent 监控并过滤日志,将过滤后的日志内容发给redis(这里的redis只处理队列不做存储),logstash index将日志收集在一起交给全文搜索服务ElasticSearch 可以用ElasticSearch进行自定义搜索通过Kibana来结合自定义搜索进行页面展示,下图是 Kibana官网上的流程图好了让我们一步步的把这套环境搭建起来吧,先看看都需要安装什么软件包ruby 运行Kibana 必须,rubygems 安装ruby扩展必须bundler 功能类似于yumJDK 运行java程序必须redis 用来处理日志队列logstash 收集、过滤日志ElasticSearch 全文搜索服务(logstash集成了一个)kibana 页面展示这里有三台服务器192.168.233.128 logstash index,ElasticSearch,kibana,JDK192.168.233.129 logstash agent,JDK192.168.233.130 redis首先到 logstash index服务器上面,logstash分为 index和aget ,agent负责监控、过滤日志,index负责收集日志并将日志交给ElasticSearch 做搜索此外 logstash 的收集方式分为 standalone 和 centralized。

standalone 是所有功能都在一个服务器上面,自发自收,centralized 就是集中收集,一台服务器接收所有shipper(个人理解就是logstash agent)的日志。

其实 logstash本身不分什么 shipper 和 collector ,只不过就是配置文件不同而已,我们这次按照集中的方式来测试在 logstash index上安装基础的软件环境1.[192.168.233.128 root@nodec:~]2.# cd /soft/3.[192.168.233.128 root@nodec:/soft]4.# wget /distfiles/jdk-6u13-dlj-linux-i586.bin5.从oracle下载实在是太慢了,从CU下载会快一些,如果需要最新版本请访问这里6./technetwork/java/javase/downloads/jdk7-downloads-1880260.html7.[192.168.233.128 root@nodec:/soft]8.# sh jdk-6u13-dlj-linux-i586.bin9.输入yes 便开始安装了10.安装完成后设置一下 JAVA_HOME11.[192.168.233.128 root@nodec:/soft/Kibana-0.2.0]12.# vim /etc/profile13.e xport JAVA_HOME=/usr/java14.e xport PATH=$JAVA_HOME/bin:$PATH15.e xport CLASSPATH=.:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar:$CLASSPATH16.17.安装ruby 就比较简单了(Kibana需要ruby 1.8.7以上版本)18.[192.168.233.128 root@nodec:/soft]19.# yum install ruby rubygems20...... 安装内容省略21.安装完成后用 rubygems 来安装bundler22.[192.168.233.128 root@nodec:/soft]23.# /usr/bin/gem install bundler24......25.26.o k 这样基本的环境就已经有了,下面就是安装kibana 和 logstash27.其实logstash 就是一个java脚本,不需要安装... 下载即用28.[192.168.233.128 root@nodec:/soft]29.# wget /release/logstash-1.1.0-monolithic.jar30.现在看看这个脚本应该怎么去执行31.[192.168.233.128 root@nodec:/soft]32.# java -jar /soft/logstash-1.1.0-monolithic.jar -h33.N o such command "-h"34.A vailable commands:35. -v36. -V37.--version38. agent39. web40. test41.显然没有 -h 参数,不过列出了能用的参数,但是logstash的参数可不止这些,42.j ava -jar /soft/logstash-1.1.0-monolithic.jar agent --help43.这些是在agent模式下的命令参数44.-f, --config CONFIGFILE45. Load the logstash config from a specific file, directory, or a wildcard. If given a directory or wildcard, config files will be read in order lexigraphically.46.-e CONFIGSTRING47. Use the given string as the configuration data. Same syntax as the config file. If not input is specified, 'stdin { type => stdin }'is default. If no output is specified, 'stdout { debug => true }}'is default.48.-w, --filterworks COUNT49. Run COUNT filter workers (default: 1)50.--watchdog-timeout TIMEOUT51. Set watchdog timeout value.52.-l, --log FILE53. Log to a given path. Default is to log to stdout54.-v55. Increase verbosity. There are multiple levels of verbosity available with '-vv' currently being the highest56.--pluginpath PLUGIN_PATH57. A colon-delimted path to find other logstash plugins in58.j ava -jar /soft/logstash-1.1.0-monolithic.jar web --help59.下面的是在web界面的参数60.--log FILE61. Log to a given path. Default is stdout.62.--address ADDRESS63. Address on which to start webserver. Default is 0.0.0.0.64.--port PORT65. Port on which to start webserver. Default is 9292.66.-B, --elasticsearch-bind-host ADDRESS67. Address on which to bind elastic search node.68.-b, --backend URL69. The backend URL to use. Default is elasticsearch:/// (assumes multicast discovery). You can specify elasticsearch://[host][:port]/[clustername]如果上面的这些命令都能执行正常的话就表示logstash可以使用了,但要让他启动还需要一个配置文件1.[192.168.233.128 root@nodec:/soft]2.3.# vim redis.conf4.5.input {6.redis {7. host => '192.168.233.130'8. data_type => 'list'9. port => "6379"10. key => 'logstash:redis'11. type => 'redis-input'12. }13. }14.15.o utput {16. elasticsearch {17. embedded => true18. }19. }解释一下logstash的配置文件由 input filter output 等几个基本的部分组成,顾名思义 input 就是在那收集数据,output就是输出到哪,filter代表一个过滤规则意思是什么内容会被收集。

上面这段是让logstash去192.168.233.130 这个redis服务器上去收集日志redis端口为6379,key是logstash:redis类型为redis-input ,(注意:这几个值必须跟logstash agent的output 所对应),收集完成后输出到elasticsearch ,embedded => true 的意思是使用logstash 内嵌的elasticsearch。