4 分类和预测(1)决策树

聚类算法和分类算法总结

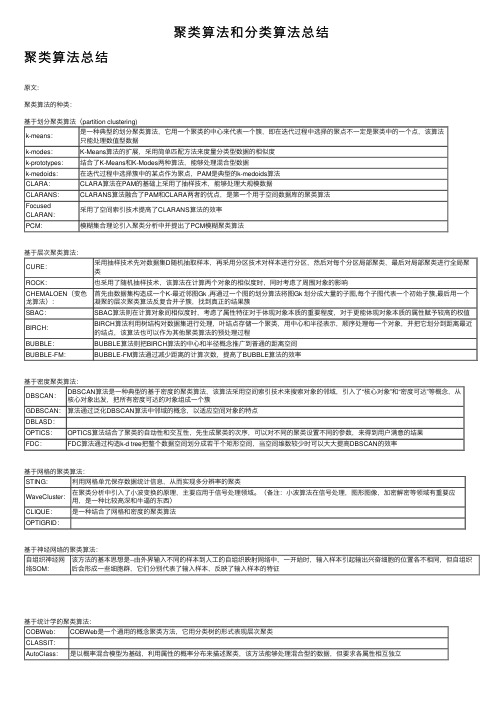

聚类算法和分类算法总结聚类算法总结原⽂:聚类算法的种类:基于划分聚类算法(partition clustering)k-means:是⼀种典型的划分聚类算法,它⽤⼀个聚类的中⼼来代表⼀个簇,即在迭代过程中选择的聚点不⼀定是聚类中的⼀个点,该算法只能处理数值型数据k-modes:K-Means算法的扩展,采⽤简单匹配⽅法来度量分类型数据的相似度k-prototypes:结合了K-Means和K-Modes两种算法,能够处理混合型数据k-medoids:在迭代过程中选择簇中的某点作为聚点,PAM是典型的k-medoids算法CLARA:CLARA算法在PAM的基础上采⽤了抽样技术,能够处理⼤规模数据CLARANS:CLARANS算法融合了PAM和CLARA两者的优点,是第⼀个⽤于空间数据库的聚类算法FocusedCLARAN:采⽤了空间索引技术提⾼了CLARANS算法的效率PCM:模糊集合理论引⼊聚类分析中并提出了PCM模糊聚类算法基于层次聚类算法:CURE:采⽤抽样技术先对数据集D随机抽取样本,再采⽤分区技术对样本进⾏分区,然后对每个分区局部聚类,最后对局部聚类进⾏全局聚类ROCK:也采⽤了随机抽样技术,该算法在计算两个对象的相似度时,同时考虑了周围对象的影响CHEMALOEN(变⾊龙算法):⾸先由数据集构造成⼀个K-最近邻图Gk ,再通过⼀个图的划分算法将图Gk 划分成⼤量的⼦图,每个⼦图代表⼀个初始⼦簇,最后⽤⼀个凝聚的层次聚类算法反复合并⼦簇,找到真正的结果簇SBAC:SBAC算法则在计算对象间相似度时,考虑了属性特征对于体现对象本质的重要程度,对于更能体现对象本质的属性赋予较⾼的权值BIRCH:BIRCH算法利⽤树结构对数据集进⾏处理,叶结点存储⼀个聚类,⽤中⼼和半径表⽰,顺序处理每⼀个对象,并把它划分到距离最近的结点,该算法也可以作为其他聚类算法的预处理过程BUBBLE:BUBBLE算法则把BIRCH算法的中⼼和半径概念推⼴到普通的距离空间BUBBLE-FM:BUBBLE-FM算法通过减少距离的计算次数,提⾼了BUBBLE算法的效率基于密度聚类算法:DBSCAN:DBSCAN算法是⼀种典型的基于密度的聚类算法,该算法采⽤空间索引技术来搜索对象的邻域,引⼊了“核⼼对象”和“密度可达”等概念,从核⼼对象出发,把所有密度可达的对象组成⼀个簇GDBSCAN:算法通过泛化DBSCAN算法中邻域的概念,以适应空间对象的特点DBLASD:OPTICS:OPTICS算法结合了聚类的⾃动性和交互性,先⽣成聚类的次序,可以对不同的聚类设置不同的参数,来得到⽤户满意的结果FDC:FDC算法通过构造k-d tree把整个数据空间划分成若⼲个矩形空间,当空间维数较少时可以⼤⼤提⾼DBSCAN的效率基于⽹格的聚类算法:STING:利⽤⽹格单元保存数据统计信息,从⽽实现多分辨率的聚类WaveCluster:在聚类分析中引⼊了⼩波变换的原理,主要应⽤于信号处理领域。

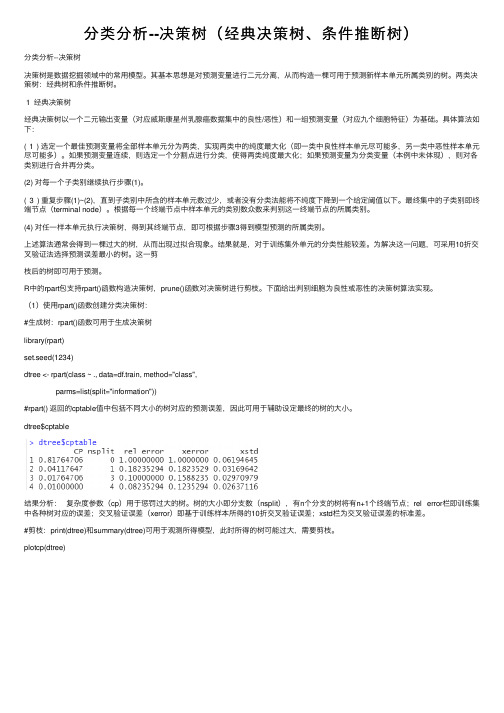

分类分析--决策树(经典决策树、条件推断树)

分类分析--决策树(经典决策树、条件推断树)分类分析--决策树决策树是数据挖掘领域中的常⽤模型。

其基本思想是对预测变量进⾏⼆元分离,从⽽构造⼀棵可⽤于预测新样本单元所属类别的树。

两类决策树:经典树和条件推断树。

1 经典决策树经典决策树以⼀个⼆元输出变量(对应威斯康星州乳腺癌数据集中的良性/恶性)和⼀组预测变量(对应九个细胞特征)为基础。

具体算法如下:(1) 选定⼀个最佳预测变量将全部样本单元分为两类,实现两类中的纯度最⼤化(即⼀类中良性样本单元尽可能多,另⼀类中恶性样本单元尽可能多)。

如果预测变量连续,则选定⼀个分割点进⾏分类,使得两类纯度最⼤化;如果预测变量为分类变量(本例中未体现),则对各类别进⾏合并再分类。

(2) 对每⼀个⼦类别继续执⾏步骤(1)。

(3) 重复步骤(1)~(2),直到⼦类别中所含的样本单元数过少,或者没有分类法能将不纯度下降到⼀个给定阈值以下。

最终集中的⼦类别即终端节点(terminal node)。

根据每⼀个终端节点中样本单元的类别数众数来判别这⼀终端节点的所属类别。

(4) 对任⼀样本单元执⾏决策树,得到其终端节点,即可根据步骤3得到模型预测的所属类别。

上述算法通常会得到⼀棵过⼤的树,从⽽出现过拟合现象。

结果就是,对于训练集外单元的分类性能较差。

为解决这⼀问题,可采⽤10折交叉验证法选择预测误差最⼩的树。

这⼀剪枝后的树即可⽤于预测。

R中的rpart包⽀持rpart()函数构造决策树,prune()函数对决策树进⾏剪枝。

下⾯给出判别细胞为良性或恶性的决策树算法实现。

(1)使⽤rpart()函数创建分类决策树:#⽣成树:rpart()函数可⽤于⽣成决策树library(rpart)set.seed(1234)dtree <- rpart(class ~ ., data=df.train, method="class",parms=list(split="information"))#rpart() 返回的cptable值中包括不同⼤⼩的树对应的预测误差,因此可⽤于辅助设定最终的树的⼤⼩。

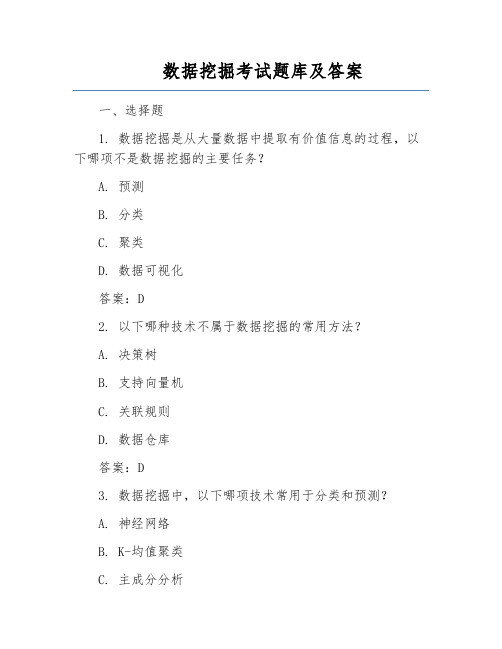

数据挖掘考试题库及答案

数据挖掘考试题库及答案一、选择题1. 数据挖掘是从大量数据中提取有价值信息的过程,以下哪项不是数据挖掘的主要任务?A. 预测B. 分类C. 聚类D. 数据可视化答案:D2. 以下哪种技术不属于数据挖掘的常用方法?A. 决策树B. 支持向量机C. 关联规则D. 数据仓库答案:D3. 数据挖掘中,以下哪项技术常用于分类和预测?A. 神经网络B. K-均值聚类C. 主成分分析D. 决策树答案:D4. 在数据挖掘中,以下哪个概念表示数据集中的属性?A. 数据项B. 数据记录C. 数据属性D. 数据集答案:C5. 数据挖掘中,以下哪个算法用于求解关联规则?A. Apriori算法B. ID3算法C. K-Means算法D. C4.5算法答案:A二、填空题6. 数据挖掘的目的是从大量数据中提取______信息。

答案:有价值7. 在数据挖掘中,分类任务分为有监督学习和______学习。

答案:无监督8. 决策树是一种用于分类和预测的树形结构,其核心思想是______。

答案:递归划分9. 关联规则挖掘中,支持度表示某个项集在数据集中的出现频率,置信度表示______。

答案:包含项集的记录中同时包含结论的记录的比例10. 数据挖掘中,聚类分析是将数据集划分为若干个______的子集。

答案:相似三、判断题11. 数据挖掘只关注大量数据中的异常值。

()答案:错误12. 数据挖掘是数据仓库的一部分。

()答案:正确13. 决策树算法适用于处理连续属性的分类问题。

()答案:错误14. 数据挖掘中的聚类分析是无监督学习任务。

()答案:正确15. 关联规则挖掘中,支持度越高,关联规则越可靠。

()答案:错误四、简答题16. 简述数据挖掘的主要任务。

答案:数据挖掘的主要任务包括预测、分类、聚类、关联规则挖掘、异常检测等。

17. 简述决策树算法的基本原理。

答案:决策树算法是一种自顶向下的递归划分方法。

它通过选择具有最高信息增益的属性进行划分,将数据集划分为若干个子集,直到满足停止条件。

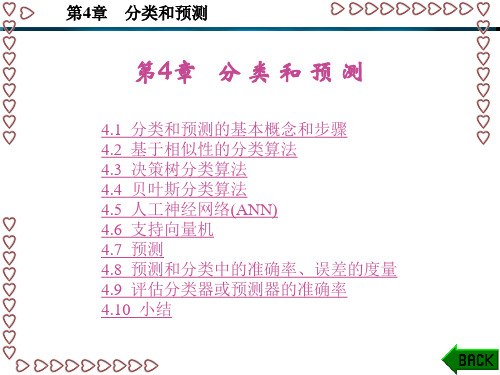

数据挖掘原理、 算法及应用第4章 分类和预测

第4章 分类和预测

4.3 决策树分类算法

从数据中生成分类器的一个特别有效的方法是生成一个 决策树(Decision Tree)。决策树表示方法是应用最广泛的逻辑 方法之一,它从一组无次序、无规则的事例中推理出决策树 表示形式的分类规则。决策树分类方法采用自顶向下的递归 方式,在决策树的内部结点进行属性值的比较,根据不同的 属性值判断从该结点向下的分支,在决策树的叶结点得到结 论。所以,从决策树的根到叶结点的一条路径就对应着一条 合取规则,整棵决策树就对应着一组析取表达式规则。

第4章 分类和预测

4.3.2 ID3算法 1. 信息论简介 1948年Shannon提出并发展了信息论,以数学的方法度

量并研究信息,通过通信后对信源中各种符号出现的不确定 程度的消除来度量信息量的大小。他提出了自信息量、信息 熵、条件熵及平均互信息量等一系列概念。

第4章 分类和预测 条件熵及平均互信息量等一系列概念。 (1) 自信息量。在收到ai之前,收信者对信源发出ai的不 确定性定义为信息符号ai的自信息量I(ai),即I(ai)=-lbp(ai), 其中p(ai)为信源发出ai的概率。 (2) 信息熵。自信息量只能反映符号的不确定性,而信 息熵可以用来度量整个信源X整体的不确定性,定义如下:

第4章 分类和预测

图4-3 表4-1所训练生成的决策树

第4章 分类和预测

5. ID3算法性能分析 ID3算法可以描述成从一个假设空间中搜索一个拟合训 练样例的假设。被ID3算法搜索的假设空间就是可能的决策 树的集合。ID3算法以一种从简单到复杂的爬山算法遍历这 个假设空间,从空的树开始,然后逐步考虑更加复杂的假设, 目的是搜索到一个正确分类训练数据的决策树。引导这种爬 山搜索的评估函数是信息增益度量。

决策树算法介绍

3.1 分类与决策树概述3.1。

1 分类与预测分类是一种应用非常广泛的数据挖掘技术,应用的例子也很多。

例如,根据信用卡支付历史记录,来判断具备哪些特征的用户往往具有良好的信用;根据某种病症的诊断记录,来分析哪些药物组合可以带来良好的治疗效果。

这些过程的一个共同特点是:根据数据的某些属性,来估计一个特定属性的值。

例如在信用分析案例中,根据用户的“年龄”、“性别”、“收入水平"、“职业”等属性的值,来估计该用户“信用度”属性的值应该取“好”还是“差",在这个例子中,所研究的属性“信用度"是一个离散属性,它的取值是一个类别值,这种问题在数据挖掘中被称为分类。

还有一种问题,例如根据股市交易的历史数据估计下一个交易日的大盘指数,这里所研究的属性“大盘指数”是一个连续属性,它的取值是一个实数。

那么这种问题在数据挖掘中被称为预测.总之,当估计的属性值是离散值时,这就是分类;当估计的属性值是连续值时,这就是预测.3。

1.2 决策树的基本原理1.构建决策树通过一个实际的例子,来了解一些与决策树有关的基本概念.表3—1是一个数据库表,记载着某银行的客户信用记录,属性包括“姓名”、“年龄”、“职业”、“月薪”、..。

..。

、“信用等级”,每一行是一个客户样本,每一列是一个属性(字段)。

这里把这个表记做数据集D.银行需要解决的问题是,根据数据集D,建立一个信用等级分析模型,并根据这个模型,产生一系列规则。

当银行在未来的某个时刻收到某个客户的贷款申请时,依据这些规则,可以根据该客户的年龄、职业、月薪等属性,来预测其信用等级,以确定是否提供贷款给该用户。

这里的信用等级分析模型,就可以是一棵决策树. 在这个案例中,研究的重点是“信用等级”这个属性。

给定一个信用等级未知的客户,要根据他/她的其他属性来估计“信用等级”的值是“优”、“良"还是“差”,也就是说,要把这客户划分到信用等级为“优”、“良"、“差"这3个类别的某一类别中去.这里把“信用等级”这个属性称为“类标号属性”。

分类预测的算法

分类预测的算法分类预测算法是一种常见的机器学习算法,它在数据分析和预测中具有广泛应用。

分类预测算法的目的是在给定数据集的情况下,将其分成多个类别或标签,以便对未来的数据进行准确预测。

本文将介绍一些常见的分类预测算法,并提供一些应用示例和实践指南。

一、常见分类预测算法1.决策树算法决策树算法是一种常见的分类预测算法。

它使用树形结构来表示所有可能的决策路径和结果。

在分类问题中,决策树通过将数据分成不同的区域来确定最终分类结果。

它的优点是易于实现,并且能够处理各种不同的数据类型。

2.支持向量机算法支持向量机算法是一种基于统计学的分类预测算法。

它尝试找到一条最优直线或超平面,将不同的数据点分为两个或更多个类别。

它的优点是具有良好的鲁棒性和分类性能。

3.朴素贝叶斯算法朴素贝叶斯算法是一种概率分类预测算法。

它使用贝叶斯公式来预测未来的数据。

该算法假设所有特征之间相互独立,从而简化了计算难度。

它还可以有效地处理大型数据集。

4.神经网络算法神经网络算法是一种基于生物神经系统工作原理的分类预测算法。

它使用大量的神经元来模拟人脑的功能,对多维数据进行复杂的分类和预测。

该算法的优点是可以从数据中自动学习特征,并且适用于大型高维数据集。

二、分类预测算法的应用示例分类预测算法在实际应用中有很多应用场景,以下是一些示例:1.医疗诊断预测分类预测算法可以用于医疗领域中的疾病预测和诊断。

例如,可以使用朴素贝叶斯算法来预测患有特定疾病的人的概率。

医生可以根据预测结果为患者进行进一步的检查和治疗。

2.金融风险分析分类预测算法可以用于金融领域中的风险分析。

例如,可以使用支持向量机算法来预测贷款违约的风险。

这种预测可以帮助银行减少贷款违约的风险,保护自身的财产安全。

3.商品推荐分类预测算法可以用于电子商务平台中的商品推荐。

例如,可以使用神经网络算法来分析用户的浏览和购买历史,预测用户感兴趣的商品类型,并将相关商品推荐给用户。

三、分类预测算法的实践指南在使用分类预测算法时,以下是一些实践指南:1.选择合适的算法不同的分类预测算法适用于不同类型的数据集。

大数据关键技术有哪些(一)

大数据关键技术有哪些(一)引言概述:随着大数据时代的到来,大数据的处理和分析成为业务领域中的一个重要挑战。

为了应对这一挑战,大数据关键技术得以发展和应用,以提供高效的数据处理和分析解决方案。

本文将介绍大数据关键技术的第一部分。

正文内容:一、数据存储技术1. 分布式文件系统:如Hadoop Distributed File System (HDFS),提供高可靠性和可伸缩性的文件存储方案。

2. 列式存储:将数据按照列存储,提高数据压缩率和查询效率。

3. 内存数据库:将数据存储在内存中,提高数据读写速度。

二、数据处理技术1. 批处理:通过将数据划分为批次进行处理,适用于对历史数据进行分析。

2. 流式处理:实时处理数据流,适用于对实时数据进行分析和决策。

3. 图计算:通过图的结构和算法进行大规模数据的分析和计算。

三、数据挖掘技术1. 分类与预测:通过训练模型对数据进行分类和预测,如决策树、支持向量机等。

2. 聚类分析:发现数据中的相似性,将数据聚集在一起形成群组,如k-means算法等。

3. 关联规则挖掘:挖掘数据中的关联关系,如购物篮分析、关联规则算法等。

四、数据可视化技术1. 图表可视化:通过绘制图表展示数据分布和趋势,如折线图、柱状图等。

2. 地理可视化:将数据在地理空间上进行可视化展示,如地图、热力图等。

3. 交互可视化:与用户进行交互,让用户自由探索数据,如可拖动、可放大缩小等。

五、数据安全与隐私保护技术1. 数据加密:对数据进行加密处理,确保数据传输和存储的安全。

2. 访问控制:限制用户对数据的访问权限,确保数据的隐私性。

3. 匿名化处理:对数据进行脱敏处理,保护用户的隐私。

总结:本文介绍了大数据关键技术的第一部分,包括数据存储技术、数据处理技术、数据挖掘技术、数据可视化技术以及数据安全与隐私保护技术。

这些技术在大数据时代的应用中发挥着重要作用,为数据处理和分析提供了有效的解决方案。

在后续的文章中,将继续探讨大数据关键技术的其他方面。

分类算法总结

分类算法数据挖掘中有很多领域,分类就是其中之一,什么是分类,分类就是把一些新得数据项映射到给定类别的中的某一个类别,比如说当我们发表一篇文章的时候,就可以自动的把这篇文章划分到某一个文章类别,一般的过程是根据样本数据利用一定的分类算法得到分类规则,新的数据过来就依据该规则进行类别的划分.分类在数据挖掘中是一项非常重要的任务,有很多用途,比如说预测,即从历史的样本数据推算出未来数据的趋向,有一个比较著名的预测的例子就是大豆学习。

再比如说分析用户行为,我们常称之为受众分析,通过这种分类,我们可以得知某一商品的用户群,对销售来说有很大的帮助。

分类器的构造方法有统计方法,机器学习方法,神经网络方法等等。

常见的统计方法有knn算法,基于事例的学习方法。

机器学习方法包括决策树法和归纳法,上面讲到的受众分析可以使用决策树方法来实现.神经网络方法主要是bp算法,这个俺也不太了解。

文本分类,所谓的文本分类就是把文本进行归类,不同的文章根据文章的内容应该属于不同的类别,文本分类离不开分词,要将一个文本进行分类,首先需要对该文本进行分词,利用分词之后的的项向量作为计算因子,再使用一定的算法和样本中的词汇进行计算,从而可以得出正确的分类结果.在这个例子中,我将使用庖丁分词器对文本进行分词。

目前看到的比较全面的分类算法,总结的还不错。

2。

4.1 主要分类方法介绍解决分类问题的方法很多[40—42] ,单一的分类方法主要包括:决策树、贝叶斯、人工神经网络、K-近邻、支持向量机和基于关联规则的分类等;另外还有用于组合单一分类方法的集成学习算法,如Bagging和Boosting等。

(1)决策树决策树是用于分类和预测的主要技术之一,决策树学习是以实例为基础的归纳学习算法,它着眼于从一组无次序、无规则的实例中推理出以决策树表示的分类规则.构造决策树的目的是找出属性和类别间的关系,用它来预测将来未知类别的记录的类别。

它采用自顶向下的递归方式,在决策树的内部节点进行属性的比较,并根据不同属性值判断从该节点向下的分支,在决策树的叶节点得到结论.主要的决策树算法有ID3、C4.5(C5.0)、CART、PUBLIC、SLIQ和SPRINT算法等.它们在选择测试属性采用的技术、生成的决策树的结构、剪枝的方法以及时刻,能否处理大数据集等方面都有各自的不同之处. (2)贝叶斯贝叶斯(Bayes)分类算法是一类利用概率统计知识进行分类的算法,如朴素贝叶斯(Naive Bayes)算法.这些算法主要利用Bayes定理来预测一个未知类别的样本属于各个类别的可能性,选择其中可能性最大的一个类别作为该样本的最终类别。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

这样,子集X1的期望信息为: Info(n11,n12)=-p11*log(p11)-p12*log(p12) =-0.4*log(0.4)-0.6*log(0.6)

xi表示测试集中第i个样本;

yi表示样本xi的类标号。 被正确分类的样本数量为TPj ; 被错误分类的样本数量为FNj ;

对于测试集的第j个类别,分类结果如下:

其他类别被错误分类为该类的样本数据量为FPj 。

17

分类的评价标准

精确度(正确率):表示测试集中被正确 分类的数据所占的比例。

q

其中:

Info( n1 s ,...,nms ) p js log2 ( p js ) , 且 p js n js / ns

j 1 m

表示在子集 Xs中 类 别 为 Cj的 数 据 样 本 所 占 的 比 。 例

32

ID3算法

计算属性Af划分数据集时的信息增益:

Gain( Af ) Info(n1 , n2 ,..., nm ) E ( Af )

对未知类别的数据进行分类(分配类别标号)。

第二步——使用模型

7

第一步——建立模型

分类模型

训练数据集

NAME RANK M ike M ary B ill Jim D ave Anne A ssistan t P ro f A ssistan t P ro f P ro fesso r A sso ciate P ro f A ssistan t P ro f A sso ciate P ro f

xi (i=1, 2, ..., total)用d维特征向量xi = (xi1, xi2, ..., xid) 来表示,xi1, xi2, ..., xid分别对应d个属性A1, A2, ..., Ad 的具体取值; yi (i=1, 2, ..., total)表示样本xi的类标号,假设要研究 的分类问题有m个类别,则yi∈{c1, c2, ..., cm}。

35

ID3算法——示例(buy_computer)

其次,计算各属性划分数据集时的信息增益:

先计算属性age的熵。由于属性age有三个不同取值 (youth,middle_aged,senior),因此可将数据集 划分成三个子集:X1, X2和X3。 对于子集X1(age=youth),它的样本数量为n1=5,其 中类标号为Yes的数量n11=2,类标号为No的数量 n12=3,则这两类样本在子集X1中所占的比例分别为: p11=n11/n1=2/5=0.4 p12=n12/n1=3/5=0.6

由数据的不同属性逐次划分数据集,直至得 到的数据子集只包含同一类数据为止,这样 可形成一棵树,称为决策树。

结构上类似于程序流程图; 每个内部结点表示在一个属性上的测试; 每个分枝代表一个测试的输出; 每个叶结点存放一个类标号。

由树的根结点到某个叶结点的属性的合取可 形成一条分类规则;所有规则的析取可形成 一整套分类规则。

student

no no no no yes yes yes no yes yes yes no yes no

credit_rating

fair excellent fair fair fair excellent excellent fair fair fair excellent excellent fair excellent

在执行分类过程之前,通过对数据进行预 处理,可以提高分类过程的准确性、有效 性和可伸缩性。 常用的预处理操作包括:

数据清理 相关分析:数据中的有些属性可能与当前任务 不相关或者是冗余的,则可以删除这些属性以 加快学习过程,并使学习结果更精确。

例如:主成分分析(PCA)

14

数据变换

分类过程的数据预处理

预测(Prediction)

4

4.1 分类和预测的定义——示例

分类

银行贷款员需要分析数据,来弄清哪些贷款申 请者是安全的,哪些是有风险的。 构造一个映射(模型)将申请者分为两类:

安全 有风险

预测

如何建立具体 的映射(模型)?

银行贷款员需要分析数据,来预测贷给某个顾 客多少钱是安全的。 构造一个映射(模型)来预测一个连续值。

YEARS TENURED 3 7 2 7 6 3 no yes yes yes no no

分类规则

IF rank = ‘professor’ OR years > 6 THEN tenured = ‘yes’

8

第二步——使用模型

分类规则

测试数据集

未知数据 (Jeff, Professor, 4)

20

决策树

如何从训练数据集生成 相应决策树,是本节所 关注的内容。

生成

目标:根据客户的如下属性,是否有贷款、婚姻状况、 收入水平,来判断客户是否存在“金融欺骗”行为。

21

决策树——分类过程

22

决策树——分类过程

23

决策树——分类过程

24

决策树——分类过程

25

决策树——分类过程

26

决策树——分类过程

33

ID3算法——示例(buy_computer)

age

youth youth middle_aged senior senior senior middle_aged youth youth senior youth middle_aged middle_aged senior

income

high high high medium low low low medium low medium medium medium high medium

m

31

ID3算法

计算属性Af划分数据集X所得的熵:

假设Af有q个不同取值,可按q的不同取值将 X划分 为q个不同的子集{X1, X2, …, Xs, …, Xq};

假设ns表示Xs中的样本数量,njs表示Xs中属于类别cj 的样本数量,则由属性Af划分数据集X的熵为:

n1 s nms E ( Af ) Info(n1 s , n2 s ,..., nms ) s 1 total

29

ID3算法

特点:在选择根结点和各个内部结点的分枝属 性时,采用信息增益作为度量标准 ,因此每 次都会选择具有最高信息增益的属性作为分枝 属性。

ID3算法只能处理属性值为离散型的数据集的划 分。

30

ID3算法

给定数据集X = {(xi, yi) | i=1, 2, …, total}。

5

4.1 分类和预测的定义

数据分类和预测的步骤如下:

第一步——建立模型 第二步——使用模型

下面以分类为例,详细介绍这两个步骤。

6

4.1 分类和预测的定义

第一步——建立模型

训练数据集:由若干数据(通常用n维属性向量 表示)和它们相对应的类标号组成。 训练样本:训练数据集中的单个数据及其类 标号。 从训练数据集“学习”相关知识来构造分类模 型。 分类模型可能会以分类规则、决策树或数学公 式等形式呈现出来。

决策树 神经网络 SVM 贝叶斯网络 线性回归 非线性回归

3

4.3 数据预测方法

4.1 分类和预测的定义

分类(Classification)

给定一个数据集D={t1, t2, …, tn}和一个类别集合 C={C1, C2, …, Cm},数据分类就是通过定义一 个映射f : DC,为数据集D中的每条数据ti分 配C中的一个类Cj。 它是一种分类的泛化,当分类的类别是一个连 续值时(可看成无限多类),就是数据预测。

buy_computer

no no yes yes yes no yes no yes yes yes yes yes no

34

ID3算法——示例(buy_computer)

首先,计算数据集分类所需的期望信息:

在数据集中,给定的样本数量为14,类标号为Yes (表示购买电脑)的样本数量为n1=9,类标号为No (表示不购买电脑)的样本数量为n2=5,因此数据集 中两个类别的先验概率分别为: p(Yes)=n1/total=9/14 p(No)=n2/total=5/14 对数据集分类所需的期望信息为: Info(n1,n2)=-p(Yes)*log(p(Yes))-p(No)*log(p(No)) =-9/14*log(9/14)-5/14*log(5/14) ≈0.94

在执行分类过程之前,通过对数据进行预 处理,可以提高分类过程的准确性、有效 性和可伸缩性。 常用的预处理操作包括:

数据清理 相关分析 数据变换:数据可以通过规范化,将给定属性 的所有值按比例进行缩放,使其落入一个较小 的指定区间中。

例如:[0.0, 1.0](神经网络中常用)。

15

分类过程的数据预处理

NAME Tom M erlisa G eorge Joseph

RANK Y E A R S TE N U R E D A ssistant P rof 2 no A ssociate P rof 7 no P rofessor 5 yes A ssistant P rof 7 yes

Tenured?

假设nj是数据集X中属于类别cj的样本数量,则 各类别的先验概率为: