基于大数据集的自动花朵分类(Automated Flower Classification over a Large Number of Classes)

计算机视觉花卉识别项目介绍

计算机视觉花卉识别项目介绍

计算机视觉花卉识别项目是一项基于计算机视觉技术的应用项目,旨在通过对花卉图像的分析和识别,实现花卉种类的自动识别和分类。

该项目主要包括以下几个方面的工作:

1.数据收集和预处理:通过互联网等渠道收集大量的花卉图像数据,对数据进行预处理,包括图像尺寸统一、图像灰度化、图像增强等操作。

2.特征提取和选择:通过特征提取算法,提取花卉图像中的特征信息,如颜色、纹理、形态等,选择对花卉种类具有区分度的特征。

3.分类模型训练和测试:根据特征提取的结果,使用机器学习算法训练分类模型,通过测试数据对模型进行验证和优化。

4.系统实现和优化:将训练好的模型应用到实际场景中,构建花卉识别系统,对系统进行优化和改进。

该项目的应用前景十分广阔,可以应用于植物识别、花卉产业、园林景观等领域,具有很高的商业价值和社会价值。

- 1 -。

基于人工智能的花卉养护系统研究与实现

基于人工智能的花卉养护系统研究与实现花卉作为一种常见的植物,不仅可以美化环境,还可以提供一定的空气净化效果。

然而,由于人们的生活节奏越来越快,越来越多的人无法抽出时间来细心地照顾自己的花园和盆栽。

为了解决这一问题,研究人员们开始将人工智能技术应用于花卉养护系统的研究与实现中。

一、人工智能技术在花卉养护中的应用人工智能技术在花卉养护中应用比较广泛,主要体现在以下几个方面:1.数据采集——通过对花卉的生长环境、化学成分和生长过程等方面进行数据采集,可以更加精确地分析出花卉的养护需求。

2.预测分析——通过将采集到的数据进行处理和分析,可以根据花卉的品种和生长环境等条件,对花卉的生长情况进行预测和分析。

3.控制管理——将采集到的数据和分析结果应用于花卉的控制和管理中,可以更加有效地进行花卉的养护和管理,以实现花卉良好的生长和发展。

二、基于人工智能的花卉养护系统的实现基于人工智能技术的花卉养护系统的实现主要分为以下几个方面:1.传感器技术——在花卉的生长环境中,通过安装一些传感器,可以对花卉的环境参数进行监测和采集。

如,光照、温度、湿度以及相对湿度等参数。

2.数据处理技术——对采集到的数据进行处理和分析,包括数据的分类、聚类、挖掘等技术,从而对花卉的生长环境进行分析和预测,建立预测模型支持花卉的养护。

3.控制执行技术——在花卉的养护过程中,需要应用于花卉养护的控制技术以保证花卉得到最优的养护条件。

如智能控制水的喷洒量、温度、湿度、光线的控制等等。

三、基于人工智能的花卉养护系统的优势及未来发展基于人工智能的花卉养护系统有许多的优势,如能够精准地监测和控制花卉的生长环境,从而提高花卉的生长效率和品质。

同时,这种技术还可以有效地降低人工费用,节约时间和成本。

随着人工智能技术的持续发展和不断完善,基于人工智能的花卉养护系统也将朝着更加智能化、效率化和人性化的方向不断发展。

同时,随着人们对绿化和美化环境的需求不断增加,这种技术的应用也将越来越广泛。

基于大数据的园林植物自动化养护系统设计与实现

基于大数据的园林植物自动化养护系统设计与实现随着科技的不断进步,越来越多的领域开始向数字化、自动化方向发展。

园林行业也不例外,传统的手工养护方式已经无法满足现代城市园林的需求。

在这样的背景下,基于大数据技术的园林植物自动化养护系统便应运而生。

一、概述园林植物自动化养护系统是一种通过人工智能、大数据、物联网等技术实现植物养护和管理的系统。

它借助不同形态的传感器采集园林内各项数据,通过大数据分析,获取植物生长状态数据,从而实现自动的植物养护,在保障植物生长质量的同时,减少了人工管理产生的资源浪费,提高了园林经营效益。

二、系统架构园林植物自动化养护系统采用分布式结构,包含传感器采集层、数据传输层、数据分析层和执行层。

其中,传感器采集层主要采集园林内的环境信息及植物生长状态数据,数据传输层负责将采集到的数据传送至数据分析层。

数据分析层借助大数据分析技术,将采集到的数据进行分析,得出植物的生长状态,再将养护方案传送至执行层,实现对植物的自动化养护。

三、系统模块3.1 传感器模块传感器模块是园林植物自动化养护系统的基础模块,它主要采集园林内的环境信息,包括气象数据、土地信息、水源情况等。

在采集植物生长状态数据方面,传感器采用多种类型传感器,包括温度传感器、湿度传感器、光照传感器、二氧化碳传感器以及植物生长状态传感器等。

3.2 数据传输模块数据传输模块负责将传感器采集的数据传送至数据分析层,以保证实时的数据传输和分析。

接入协议方面,采取了HTTP/HTTPS协议,建立安全的数据加密与传输通道,保证数据传输的安全性。

3.3 数据分析模块数据分析模块中主要采用机器学习、数据挖掘等技术来对采集的数据进行分析与处理。

机器学习方面,本系统采用卷积神经网络等深度学习技术进行图像识别,降低了对人工干预的依赖性,提升了养护效率。

3.4 执行模块执行模块负责执行养护方案,实现对植物的自动化养护功能。

本系统采用IoT设备,建立了连接植物生长状态传感器和农艺工具的物联网架构,实现了养护方案的快速响应和执行。

基于机器学习的花卉识别技术研究

基于机器学习的花卉识别技术研究随着科技的不断发展,机器学习技术在各个领域中得到了广泛应用。

其中,基于机器学习技术的花卉识别技术受到了人们的广泛关注。

花卉识别技术可以帮助人们更好地认识和利用花草植物资源,满足人们对于美好生活的追求。

本文将介绍花卉识别技术的研究现状、原理和应用前景。

一、研究现状花卉识别技术是机器学习技术在计算机视觉领域的重要应用之一。

早期的花卉识别技术主要是通过图像处理技术,对花卉图像进行特征提取和匹配,从而实现花卉的识别。

随着机器学习技术的发展,尤其是深度学习技术的崛起,花卉识别技术也得到了很大的发展。

深度学习技术中最为重要的是卷积神经网络(Convolutional Neural Networks,CNN)。

CNN是一种具有多个卷积层和池化层的神经网络结构,能够有效地进行图像、音频、视频等多媒体数据的处理和分类。

通过对花卉图像进行训练,CNN可以学习花卉的特征,从而实现对花卉的准确识别。

二、原理花卉识别技术的原理是将花卉图像输入到机器学习模型中进行训练,得到具有代表性的特征向量,然后对新的花卉图像进行分类。

具体流程如下:1. 数据集收集首先需要收集一定数量的带有标签的花卉图像,作为训练和测试集。

数据集的规模和质量对于模型的训练效果和分类准确率都有很大的影响。

2. 特征提取对于每张花卉图像,需要通过CNN模型进行特征提取。

CNN模型的卷积层和池化层可以有效地提取花卉的纹理、颜色等特征。

3. 特征降维通过特征降维算法,将从CNN模型中得到的高维特征向量转化为低维特征向量。

这样可以减少特征向量的维度,缩短花卉识别的时间成本。

4. 分类器训练使用训练集的特征向量和标签数据,训练分类器模型。

分类器模型可以是支持向量机(Support Vector Machine,SVM)、k最近邻算法(k-Nearest Neighbor,kNN)等。

5. 分类器测试使用测试集的特征向量和标签数据,测试已经训练好的分类器模型,得出分类结果。

Flower102的鲜花分类数据准备及处理教程

Flower102的鲜花分类数据准备及处理教程flower102数据集写在前面写这篇文章的初衷是想帮助像我一样疑惑在flower102分类中数据处理阶段的小朋友。

不知大家发现没有,现有的网络资源中,大部分博主都详细记载了分类过程,但是对于数据准备阶段,都轻描淡写的说“简单处理一下”。

如下图所示,只告诉了数据的组织方式,却没有告知如何生成这种数据的组织方式。

项目组织目录1项目组织目录2当然啦,博主们热心的提供了已做好处理的数据收费链接,而我呢,就不想花钱。

如果你也有上述疑惑和需求,那就继续往下看吧~flower102数据集链接地址为:数据链接主页面2、数据预处理编码data_prepare/pic/train/class1/img1img2...class2img1img2...validation/class1/img1img2...class2img1img2...项目组织目录3在项目中新建文件夹prepare_pic,再在prepare_pic下新建文件夹test、train、validation。

实现数据集划分的编码: # encoding:utf-8import scipy.ioimport numpy as npimport osfrom PIL import Imageimport shutillabels = scipy.io.loadmat('D:\\felicity\\code\\flower102\\imagelabels.mat')#该地址为imagelabels.mat的绝对地址labels = np.array(labels['labels'][0]) - 1print("labels:", labels)setid = scipy.io.loadmat('D:\\felicity\\code\\flower102\\setid.mat')#该地址为setid.mat的绝对地址validation = np.array(setid['valid'][0]) - 1np.random.shuffle(validation)train = np.array(setid['trnid'][0]) - 1np.random.shuffle(train)test = np.array(setid['tstid'][0]) - 1np.random.shuffle(test)flower_dir = listfor img in os.listdir("D:\\felicity\\code\\flower102\\flower_data\\jpg"):#该地址为源数据图片的绝对地址 flower_dir.append(os.path.join("D:\\felicity\\code\\flower102\\flower_dat a\\jpg", img))flower_dir.sort# print(flower_dir)des_folder_train = "D:\\felicity\\code\\flower102\\prepare_pic\\train"#该地址为新建的训练数据集文件夹的绝对地址for tid in train:img = Image.open(flower_dir[tid])print(img)# print(flower_dir[tid])img = img.resize((256, 256), Image.ANTIALIAS)lable = labels[tid]# print(lable)path = flower_dir[tid]print("path:", path)base_path = os.path.basename(path)print("base_path:", base_path)classes = "c" + str(lable)class_path = os.path.join(des_folder_train, classes)# 判断结果if not os.path.exists(class_path):os.makedirs(class_path)print("class_path:", class_path)despath = os.path.join(class_path, base_path)print("despath:", despath)img.save(despath)des_folder_validation = "D:\\felicity\\code\\flower102\\prepare_pic\\validation"#该地址为新建的验证数据集文件夹的绝对地址for tid in validation:img = Image.open(flower_dir[tid])# print(flower_dir[tid])img = img.resize((256, 256), Image.ANTIALIAS)lable = labels[tid]# print(lable)path = flower_dir[tid]print("path:", path)base_path = os.path.basename(path)print("base_path:", base_path)classes = "c" + str(lable)class_path = os.path.join(des_folder_validation, classes)# 判断结果if not os.path.exists(class_path):os.makedirs(class_path)print("class_path:", class_path)despath = os.path.join(class_path, base_path)print("despath:", despath)img.save(despath)des_folder_test = "D:\\felicity\\code\\flower102\\prepare_pic\\test"#该地址为新建的测试数据集文件夹的绝对地址for tid in test:img = Image.open(flower_dir[tid])# print(flower_dir[tid])img = img.resize((256, 256), Image.ANTIALIAS)lable = labels[tid]# print(lable)path = flower_dir[tid]print("path:", path)base_path = os.path.basename(path)print("base_path:", base_path)classes = "c" + str(lable)class_path = os.path.join(des_folder_test, classes)# 判断结果if not os.path.exists(class_path):os.makedirs(class_path)print("class_path:", class_path)despath = os.path.join(class_path, base_path)print("despath:", despath)img.save(despath)将所有涉及的地址部分修改正确后,就可以运行该文件,我将该文件命名为data_prepare.py。

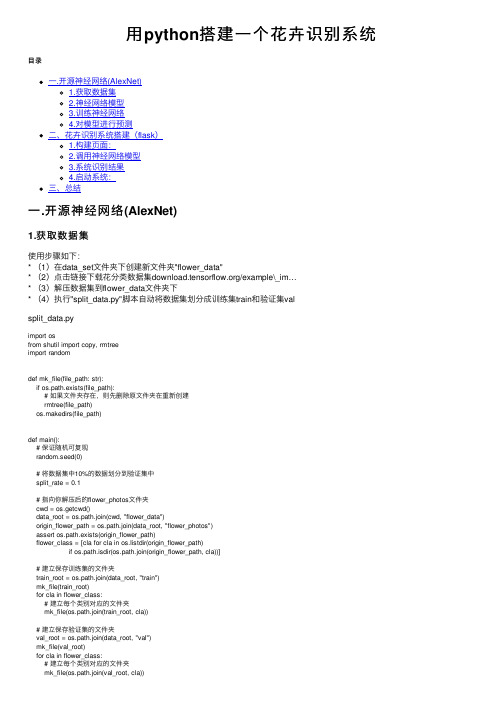

用python搭建一个花卉识别系统

⽤python搭建⼀个花卉识别系统⽬录⼀.开源神经⽹络(AlexNet)1.获取数据集2.神经⽹络模型3.训练神经⽹络4.对模型进⾏预测⼆、花卉识别系统搭建(flask)1.构建页⾯:2.调⽤神经⽹络模型3.系统识别结果4.启动系统:三、总结⼀.开源神经⽹络(AlexNet)1.获取数据集使⽤步骤如下:* (1)在data_set⽂件夹下创建新⽂件夹"flower_data"* (2)点击链接下载花分类数据集/example\_im…* (3)解压数据集到flower_data⽂件夹下* (4)执⾏"split_data.py"脚本⾃动将数据集划分成训练集train和验证集valsplit_data.pyimport osfrom shutil import copy, rmtreeimport randomdef mk_file(file_path: str):if os.path.exists(file_path):# 如果⽂件夹存在,则先删除原⽂件夹在重新创建rmtree(file_path)os.makedirs(file_path)def main():# 保证随机可复现random.seed(0)# 将数据集中10%的数据划分到验证集中split_rate = 0.1# 指向你解压后的flower_photos⽂件夹cwd = os.getcwd()data_root = os.path.join(cwd, "flower_data")origin_flower_path = os.path.join(data_root, "flower_photos")assert os.path.exists(origin_flower_path)flower_class = [cla for cla in os.listdir(origin_flower_path)if os.path.isdir(os.path.join(origin_flower_path, cla))]# 建⽴保存训练集的⽂件夹train_root = os.path.join(data_root, "train")mk_file(train_root)for cla in flower_class:# 建⽴每个类别对应的⽂件夹mk_file(os.path.join(train_root, cla))# 建⽴保存验证集的⽂件夹val_root = os.path.join(data_root, "val")mk_file(val_root)for cla in flower_class:# 建⽴每个类别对应的⽂件夹mk_file(os.path.join(val_root, cla))for cla in flower_class:cla_path = os.path.join(origin_flower_path, cla)images = os.listdir(cla_path)num = len(images)# 随机采样验证集的索引eval_index = random.sample(images, k=int(num*split_rate))for index, image in enumerate(images):if image in eval_index:# 将分配⾄验证集中的⽂件复制到相应⽬录image_path = os.path.join(cla_path, image)new_path = os.path.join(val_root, cla)copy(image_path, new_path)else:# 将分配⾄训练集中的⽂件复制到相应⽬录image_path = os.path.join(cla_path, image)new_path = os.path.join(train_root, cla)copy(image_path, new_path)print("\r[{}] processing [{}/{}]".format(cla, index+1, num), end="") # processing barprint()print("processing done!")if __name__ == '__main__':main()2.神经⽹络模型model.pyimport torch.nn as nnimport torchclass AlexNet(nn.Module):def __init__(self, num_classes=1000, init_weights=False):super(AlexNet, self).__init__()# ⽤nn.Sequential()将⽹络打包成⼀个模块,精简代码self.features = nn.Sequential( # 卷积层提取图像特征nn.Conv2d(3, 48, kernel_size=11, stride=4, padding=2), # input[3, 224, 224] output[48, 55, 55] nn.ReLU(inplace=True), # 直接修改覆盖原值,节省运算内存nn.MaxPool2d(kernel_size=3, stride=2), # output[48, 27, 27]nn.Conv2d(48, 128, kernel_size=5, padding=2), # output[128, 27, 27]nn.ReLU(inplace=True),nn.MaxPool2d(kernel_size=3, stride=2), # output[128, 13, 13]nn.Conv2d(128, 192, kernel_size=3, padding=1), # output[192, 13, 13]nn.ReLU(inplace=True),nn.Conv2d(192, 192, kernel_size=3, padding=1), # output[192, 13, 13]nn.ReLU(inplace=True),nn.Conv2d(192, 128, kernel_size=3, padding=1), # output[128, 13, 13]nn.ReLU(inplace=True),nn.MaxPool2d(kernel_size=3, stride=2), # output[128, 6, 6])self.classifier = nn.Sequential( # 全连接层对图像分类nn.Dropout(p=0.5), # Dropout 随机失活神经元,默认⽐例为0.5nn.Linear(128 * 6 * 6, 2048),nn.ReLU(inplace=True),nn.Dropout(p=0.5),nn.Linear(2048, 2048),nn.ReLU(inplace=True),nn.Linear(2048, num_classes),)if init_weights:self._initialize_weights()# 前向传播过程def forward(self, x):x = self.features(x)x = torch.flatten(x, start_dim=1) # 展平后再传⼊全连接层x = self.classifier(x)return x# ⽹络权重初始化,实际上 pytorch 在构建⽹络时会⾃动初始化权重def _initialize_weights(self):for m in self.modules():if isinstance(m, nn.Conv2d): # 若是卷积层nn.init.kaiming_normal_(m.weight, mode='fan_out', # ⽤(何)kaiming_normal_法初始化权重nonlinearity='relu')if m.bias is not None:nn.init.constant_(m.bias, 0) # 初始化偏重为0elif isinstance(m, nn.Linear): # 若是全连接层nn.init.normal_(m.weight, 0, 0.01) # 正态分布初始化nn.init.constant_(m.bias, 0) # 初始化偏重为03.训练神经⽹络train.py# 导⼊包import torchimport torch.nn as nnfrom torchvision import transforms, datasets, utilsimport matplotlib.pyplot as pltimport numpy as npimport torch.optim as optimfrom model import AlexNetimport osimport jsonimport time# 使⽤GPU训练device = torch.device("cuda" if torch.cuda.is_available() else "cpu")with open(os.path.join("train.log"), "a") as log:log.write(str(device)+"\n")#数据预处理data_transform = {"train": pose([transforms.RandomResizedCrop(224), # 随机裁剪,再缩放成 224×224transforms.RandomHorizontalFlip(p=0.5), # ⽔平⽅向随机翻转,概率为 0.5, 即⼀半的概率翻转, ⼀半的概率不翻转 transforms.ToTensor(),transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))]),"val": pose([transforms.Resize((224, 224)), # cannot 224, must (224, 224)transforms.ToTensor(),transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))])}#导⼊、加载训练集# 导⼊训练集#train_set = torchvision.datasets.CIFAR10(root='./data', # 数据集存放⽬录# train=True, # 表⽰是数据集中的训练集# download=True, # 第⼀次运⾏时为True,下载数据集,下载完成后改为False# transform=transform) # 预处理过程# 加载训练集#train_loader = torch.utils.data.DataLoader(train_set, # 导⼊的训练集# batch_size=50, # 每批训练的样本数# shuffle=False, # 是否打乱训练集# num_workers=0) # num_workers在windows下设置为0# 获取图像数据集的路径data_root = os.path.abspath(os.path.join(os.getcwd(), "../..")) # get data root path 返回上上层⽬录image_path = data_root + "/jqsj/data_set/flower_data/" # flower data_set path# 导⼊训练集并进⾏预处理train_dataset = datasets.ImageFolder(root=image_path + "/train",transform=data_transform["train"])train_num = len(train_dataset)# 按batch_size分批次加载训练集train_loader = torch.utils.data.DataLoader(train_dataset, # 导⼊的训练集batch_size=32, # 每批训练的样本数shuffle=True, # 是否打乱训练集num_workers=0) # 使⽤线程数,在windows下设置为0#导⼊、加载验证集# 导⼊验证集并进⾏预处理validate_dataset = datasets.ImageFolder(root=image_path + "/val",transform=data_transform["val"])val_num = len(validate_dataset)# 加载验证集validate_loader = torch.utils.data.DataLoader(validate_dataset, # 导⼊的验证集batch_size=32,shuffle=True,num_workers=0)# 存储索引:标签的字典# 字典,类别:索引 {'daisy':0, 'dandelion':1, 'roses':2, 'sunflower':3, 'tulips':4}flower_list = train_dataset.class_to_idx# 将 flower_list 中的 key 和 val 调换位置cla_dict = dict((val, key) for key, val in flower_list.items())# 将 cla_dict 写⼊ json ⽂件中json_str = json.dumps(cla_dict, indent=4)with open('class_indices.json', 'w') as json_file:json_file.write(json_str)#训练过程net = AlexNet(num_classes=5, init_weights=True) # 实例化⽹络(输出类型为5,初始化权重)net.to(device) # 分配⽹络到指定的设备(GPU/CPU)训练loss_function = nn.CrossEntropyLoss() # 交叉熵损失optimizer = optim.Adam(net.parameters(), lr=0.0002) # 优化器(训练参数,学习率)save_path = './AlexNet.pth'best_acc = 0.0for epoch in range(150):########################################## train ############################################### net.train() # 训练过程中开启 Dropoutrunning_loss = 0.0 # 每个 epoch 都会对 running_loss 清零time_start = time.perf_counter() # 对训练⼀个 epoch 计时for step, data in enumerate(train_loader, start=0): # 遍历训练集,step从0开始计算images, labels = data # 获取训练集的图像和标签optimizer.zero_grad() # 清除历史梯度outputs = net(images.to(device)) # 正向传播loss = loss_function(outputs, labels.to(device)) # 计算损失loss.backward() # 反向传播optimizer.step() # 优化器更新参数running_loss += loss.item()# 打印训练进度(使训练过程可视化)rate = (step + 1) / len(train_loader) # 当前进度 = 当前step / 训练⼀轮epoch所需总stepa = "*" * int(rate * 50)b = "." * int((1 - rate) * 50)with open(os.path.join("train.log"), "a") as log:log.write(str("\rtrain loss: {:^3.0f}%[{}->{}]{:.3f}".format(int(rate * 100), a, b, loss))+"\n")print("\rtrain loss: {:^3.0f}%[{}->{}]{:.3f}".format(int(rate * 100), a, b, loss), end="")print()with open(os.path.join("train.log"), "a") as log:log.write(str('%f s' % (time.perf_counter()-time_start))+"\n")print('%f s' % (time.perf_counter()-time_start))########################################### validate ########################################### net.eval() # 验证过程中关闭 Dropoutacc = 0.0with torch.no_grad():for val_data in validate_loader:val_images, val_labels = val_dataoutputs = net(val_images.to(device))predict_y = torch.max(outputs, dim=1)[1] # 以output中值最⼤位置对应的索引(标签)作为预测输出acc += (predict_y == val_labels.to(device)).sum().item()val_accurate = acc / val_num# 保存准确率最⾼的那次⽹络参数if val_accurate > best_acc:best_acc = val_accuratetorch.save(net.state_dict(), save_path)with open(os.path.join("train.log"), "a") as log:log.write(str('[epoch %d] train_loss: %.3f test_accuracy: %.3f \n' %(epoch + 1, running_loss / step, val_accurate))+"\n")print('[epoch %d] train_loss: %.3f test_accuracy: %.3f \n' %(epoch + 1, running_loss / step, val_accurate))with open(os.path.join("train.log"), "a") as log:log.write(str('Finished Training')+"\n")print('Finished Training')训练结果后,准确率是94%训练⽇志如下:4.对模型进⾏预测predict.pyimport torch接着对其中⼀个花卉图⽚进⾏识别,其结果如下:可以看到只有⼀个识别结果(daisy雏菊)和准确率1.0是100%(范围是0~1,所以1对应100%)为了⽅便使⽤这个神经⽹络,接着我们将其开发成⼀个可视化的界⾯操作⼆、花卉识别系统搭建(flask)1.构建页⾯:2.调⽤神经⽹络模型main.py# coding:utf-8from flask import Flask, render_template, request, redirect, url_for, make_response, jsonifyfrom werkzeug.utils import secure_filenameimport osimport time####################模型所需库包import torchfrom model import AlexNetfrom PIL import Imagefrom torchvision import transformsimport matplotlib.pyplot as pltimport json# read class_indicttry:json_file = open('./class_indices.json', 'r')class_indict = json.load(json_file)except Exception as e:print(e)exit(-1)# create modelmodel = AlexNet(num_classes=5)# load model weightsmodel_weight_path = "./AlexNet.pth"#, map_location='cpu'model.load_state_dict(torch.load(model_weight_path, map_location='cpu'))# 关闭 Dropoutmodel.eval()###################from datetime import timedelta# 设置允许的⽂件格式ALLOWED_EXTENSIONS = set(['png', 'jpg', 'JPG', 'PNG', 'bmp'])def allowed_file(filename):return '.' in filename and filename.rsplit('.', 1)[1] in ALLOWED_EXTENSIONSapp = Flask(__name__)# 设置静态⽂件缓存过期时间app.send_file_max_age_default = timedelta(seconds=1)#图⽚装换操作def tran(img_path):# 预处理data_transform = pose([transforms.Resize((224, 224)),transforms.ToTensor(),transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))])# load imageimg = Image.open("pgy2.jpg")#plt.imshow(img)# [N, C, H, W]img = data_transform(img)# expand batch dimensionimg = torch.unsqueeze(img, dim=0)return img@app.route('/upload', methods=['POST', 'GET']) # 添加路由def upload():path=""if request.method == 'POST':f = request.files['file']if not (f and allowed_file(f.filename)):return jsonify({"error": 1001, "msg": "请检查上传的图⽚类型,仅限于png、PNG、jpg、JPG、bmp"})basepath = os.path.dirname(__file__) # 当前⽂件所在路径path = secure_filename(f.filename)upload_path = os.path.join(basepath, 'static/images', secure_filename(f.filename)) # 注意:没有的⽂件夹⼀定要先创建,不然会提⽰没有该路径 # upload_path = os.path.join(basepath, 'static/images','test.jpg') #注意:没有的⽂件夹⼀定要先创建,不然会提⽰没有该路径print(path)img = tran('static/images'+path)###########################预测图⽚with torch.no_grad():# predict classoutput = torch.squeeze(model(img)) # 将输出压缩,即压缩掉 batch 这个维度predict = torch.softmax(output, dim=0)predict_cla = torch.argmax(predict).numpy()res = class_indict[str(predict_cla)]pred = predict[predict_cla].item()#print(class_indict[str(predict_cla)], predict[predict_cla].item())res_chinese = ""if res=="daisy":res_chinese="雏菊"if res=="dandelion":res_chinese="蒲公英"if res=="roses":res_chinese="玫瑰"if res=="sunflower":res_chinese="向⽇葵"if res=="tulips":res_chinese="郁⾦⾹"#print('result:', class_indict[str(predict_class)], 'accuracy:', prediction[predict_class])##########################f.save(upload_path)pred = pred*100return render_template('upload_ok.html', path=path, res_chinese=res_chinese,pred = pred, val1=time.time())return render_template('upload.html')if __name__ == '__main__':# app.debug = Trueapp.run(host='127.0.0.1', port=80,debug = True)3.系统识别结果<!DOCTYPE html><html lang="en"><head><meta charset="UTF-8"><title>李运⾠-花卉识别系统v1.0</title><link rel="stylesheet" type="text/css" href="../static/css/bootstrap.min.css" rel="external nofollow" ><link rel="stylesheet" type="text/css" href="../static/css/fileinput.css" rel="external nofollow" ><script src="../static/js/jquery-2.1.4.min.js"></script><script src="../static/js/bootstrap.min.js"></script><script src="../static/js/fileinput.js"></script><script src="../static/js/locales/zh.js"></script></head><body><h1 align="center">李运⾠-花卉识别系统v1.0</h1><div align="center"><form action="" enctype='multipart/form-data' method='POST'><input type="file" name="file" class="file" data-show-preview="false" style="margin-top:20px;"/><br><input type="submit" value="上传" class="button-new btn btn-primary" style="margin-top:15px;"/></form><p style="size:15px;color:blue;">识别结果:{{res_chinese}}</p></br><p style="size:15px;color:red;">准确率:{{pred}}%</p><img src="{{ './static/images/'+path }}" width="400" height="400" alt=""/></div></body></html>4.启动系统:python main.py接着在浏览器在浏览器⾥⾯访问http://127.0.0.1/upload出现如下界⾯:最后来⼀个识别过程的动图三、总结ok,这个花卉系统就已经搭建完成了,是不是超级简单,我也是趁着修了这个机器视觉这么课,才弄这么⼀个系统,回顾⼀下之前的知识,哈哈哈。

基于大数据的园林花卉分析与推荐技术

基于大数据的园林花卉分析与推荐技术近年来,随着大数据技术的不断普及和应用,各行各业都在积极探索和应用大数据技术。

园林花卉作为人们生活中不可缺少的一部分,也逐渐开始应用大数据技术进行分析和推荐,以提高园林花卉的种植质量、美化环境和为人们提供更好的服务。

一、园林花卉大数据分析的意义园林花卉大数据分析可以为园林花卉的管理提供重要支持和指导。

首先,园林花卉大数据分析可以通过收集和分析园林花卉的相关数据,包括土壤水分,气象条件等,来预测和评估园林花卉生长情况,帮助园林工程师和技术人员进行合理的管理和调节。

其次,园林花卉大数据分析可以为园林花卉的种植提供优化策略,减少草地病虫害的发生和扩散,提高园林花卉的抗病能力和品质。

同时,园林花卉大数据分析还可以促进园林花卉产业的发展。

通过对市场销售数据的分析,可以了解市场需求和趋势,为农业部门提供有针对性的决策与推广,带动产业升级和产品创新。

二、基于大数据的园林花卉分析与推荐技术1. 园林花卉数据采集园林花卉数据采集是园林花卉大数据分析的首要环节。

可以采用传感器网络技术对园林花卉的生长环境(如土壤温度、土壤湿度、光照等)进行实时数据采集,保证数据的真实性和准确性。

2. 园林花卉数据存储与管理为了方便数据的统计和分析,需要将采集的园林花卉数据进行存储和管理。

可以采用大容量数据库、数据仓库、分布式存储等技术,保证数据的高效存储和管理,并确保数据的安全性和可靠性。

3. 园林花卉数据分析园林花卉数据分析是大数据技术在园林花卉领域中的核心应用。

通过对园林花卉数据进行分析,从多个角度对园林花卉生长情况进行评估,包括土壤调节、水分管理、阳光照射、气候气象等方面,从而找出园林花卉生长的影响因素和规律。

4. 园林花卉推荐技术在园林花卉大数据分析的基础上,可通过基于大数据的自适应推荐算法,提供针对性的园林花卉种植策略和管理方案。

用户可根据相关需求,得到更个性化、科学化的园林花卉种植方案,提高花卉种植的成功率和基地的经济效益。

基于机器视觉的鲜花自动分级技术研究

基于机器视觉的鲜花自动分级技术研究随着人们生活水平的不断提高,对于鲜花这一美丽生命的需求也在不断增长。

在花市、超市等销售场所,我们可以看到各式各样的鲜花供消费者选择。

然而,这些鲜花在到达销售场所前需要进行分类和分级等繁琐的工作,而这些工作往往需要大量的人手和时间。

在现代社会,随着科技的发展,基于机器视觉的鲜花自动分级技术成为了一种新的选择。

本文将探讨基于机器视觉的鲜花自动分级技术的研究现状和应用前景。

一、鲜花自动分级技术的研究现状随着机器学习、人工智能等技术的不断发展,鲜花自动分级技术的研究也日渐深入。

目前,国内外许多研究机构和企业已经开始投入大量的研究和开发,以期能够实现更加准确和高效的鲜花自动分级。

这些研究主要涉及到图像处理、机器学习、人工智能等多个领域,涉及到多种算法和技术。

下面将对一些代表性研究进行简要介绍。

1.基于深度学习的鲜花自动分级技术深度学习在图像处理领域被广泛应用,也被用于鲜花自动分级技术的研究。

神经网络等深度学习算法可以自动提取鲜花图像中的特征,并进行分类和分级。

例如,美国芝加哥大学的一项研究利用深度学习算法对鲜花图像进行处理和分析,实现了自动分类和分级。

2.基于机器视觉的鲜花识别技术机器视觉技术可以对鲜花进行快速和准确的识别,这是鲜花自动分级技术中的重要环节。

目前,德国弗劳恩霍夫研究中心的识别系统可以在不到1秒的时间内对多达100种花卉进行识别。

识别系统使用了人工智能和深度学习等技术,能够帮助人们快速识别花卉,并了解每个花卉的生长环境和特征。

3.基于虚拟现实的鲜花自动分级技术虚拟现实技术可以模拟真实环境和物品,可以用于鲜花自动分级技术中的虚拟仿真。

研究人员可以利用虚拟现实技术对鲜花的特征进行模拟和分析,帮助提高鲜花自动分级的准确率和效率。

例如,英国诺丁汉大学的研究人员就研究了一种基于虚拟现实的鲜花自动分级技术,可以在虚拟环境中对鲜花进行分析和优化。

二、鲜花自动分级技术的应用前景鲜花自动分级技术不仅可以提高鲜花分级效率和准确率,在未来还有广阔的应用前景。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于大数据集的自动花朵分类(Automated Flower Classification over a Large Number of Classes)

数据介绍:

We investigate to what extent combinations of features can improve classification performance on a large dataset of similar classes. To this end we introduce a 103 class flower dataset. We compute four different features for the flowers, each describing different aspects, namely the local shape/texture, the shape of the boundary, the overall spatial distribution of petals, and the colour. We combine the features using a multiple kernel framework with a SVM classifier. The weights for each class are learnt using the method of Varma and Ray [16], which has achieved state of the art performance on other large dataset, such as Caltech 101/256. Our dataset has a similar challenge in the number of classes, but with the added difficulty of large between class similarity and small within class similarity. Results show that learning the optimum kernel combination of multiple features vastly improves the performance, from 55.1% for the best single feature to 72.8% for the combination of all feat

关键词:

计算机视觉,图形和图像处理,自动,花朵分类, Computer

Vision,Graphics and Image Processing,Automated,Flower Classification,

数据格式:

IMAGE

数据详细介绍:

Automated Flower Classification over a Large Number of Classes Proceedings of the Indian Conference on Computer Vision, Graphics and

Image Processing (2008)

Bibtex source | Abstract | Document: ps.gz PDF

Abstract

We investigate to what extent combinations of features can improve classification performance on a large dataset of similar classes. To this end we introduce a 103 class flower dataset. We compute four different features for the flowers, each describing different aspects, namely the local shape/texture, the shape of the boundary, the overall spatial distribution of petals, and the colour. We combine the features using a multiple kernel framework with a SVM classifier. The weights for each class are learnt using the method of Varma and Ray [16], which has achieved state of the art performance on other large dataset, such as Caltech 101/256. Our dataset has a similar challenge in the number of classes, but with the added difficulty of large between class similarity and small within class similarity. Results show that learning the optimum kernel combination of multiple features vastly improves the performance, from 55.1% for the best single feature to 72.8% for the combination of all features.

This material is presented to ensure timely dissemination of scholarly and technical work. Copyright and all rights therein are retained by authors or by other copyright holders. All persons copying this information are expected to adhere to the terms and constraints invoked by each author's copyright. In

most cases, these works may not be reposted without the explicit permission of the copyright holder.

Nilsback, M-E. and Zisserman, A.

数据预览:

点此下载完整数据集。