Mining for Empty Rectangles in Large Data Sets

数据挖掘原理、算法及应用章 (8)

第8章 复杂类型数据挖掘 1) 以Arc/info基于矢量数据模型的系统为例, 为了将空间

数据存入计算机, 首先, 从逻辑上将空间数据抽象为不同的 专题或层, 如土地利用、 地形、 道路、 居民区、 土壤单 元、 森林分布等, 一个专题层包含区域内地理要素的位置和 属性数据。 其次, 将一个专题层的地理要素或实体分解为点、 线、 面目标, 每个目标的数据由空间数据、 属性数据和拓 扑数据组成。

第8章 复杂类型数据挖掘 2. 空间数据具体描述地理实体的空间特征、 属性特征。 空

间特征是指地理实体的空间位置及其相互关系; 属性特征表 示地理实体的名称、 类型和数量等。 空间对象表示方法目前 采用主题图方法, 即将空间对象抽象为点、 线、 面三类, 根据这些几何对象的不同属性, 以层(Layer)为概念组织、 存储、 修改和显示它们, 数据表达分为矢量数据模型和栅格 数据模型两种。

第8章 复杂类型数据挖掘图Fra bibliotek-5 综合图层

第8章 复杂类型数据挖掘

图8-4 栅格数据模型

第8章 复杂类型数据挖掘

3. 虽然空间数据查询和空间挖掘是有区别的, 但是像其他数 据挖掘技术一样, 查询是挖掘的基础和前提, 因此了解空间 查询及其操作有助于掌握空间挖掘技术。

由于空间数据的特殊性, 空间操作相对于非空间数据要 复杂。 传统的访问非空间数据的选择查询使用的是标准的比 较操作符: “>”、 “<”、 “≤ ”、 “≥ ”、 “≠ ”。 而空间选择是一种在空间数据上的选择查询, 要用到空间操 作符.包括接近、 东、 西、 南、 北、 包含、 重叠或相交 等。

不同的实体之间进行空间性操作的时候, 经常需要在属性之 间进行一些转换。 如果非空间属性存储在关系型数据库中, 那么一种可行的存储策略是利用非空间元组的属性存放指向相 应空间数据结构的指针。 这种关系中的每个元组代表的是一 个空间实体。

Preprocessing处理

Variance and standard deviation (sample: s, population: σ)

Variance: (algebraic, scalable computation)

1 n 1 n 2 1 n 2 2 2 s ( xi x ) [ xi ( xi ) ] n 1 i 1 n 1 i 1 n i 1

Data Mining

Data Warehouse Data Cleaning and Integration Databases

2014/9/23

Flat files

2

Review

Learning the application domain

relevant prior knowledge and goals of application

Descriptive data summarization

Data cleaning Data integration and transformation Data reduction Discretization and concept hierarchy generation Summary

Creating a target data resource Data cleaning and preprocessing: (may take 60% of effort!) Data reduction and transformation

Find useful features, dimensionality/variable reduction, invariant representation

数据挖掘中的稀疏数据分析方法

数据挖掘中的稀疏数据分析方法数据挖掘是一项涵盖统计学、机器学习和数据库技术的跨学科领域,旨在从大量数据中发现有用的模式和关联。

然而,在实际应用中,我们常常面临的是稀疏数据,即大部分数据都是缺失的或者稀疏的。

在这篇文章中,我们将讨论一些常见的稀疏数据分析方法,并探讨它们在数据挖掘中的应用。

首先,稀疏数据分析的一个重要问题是如何填充缺失值。

在现实世界的数据中,缺失值是常见的,可能是由于测量设备故障、数据采集错误或者主观原因导致的。

为了解决这个问题,我们可以使用插补方法来估计缺失值。

常用的插补方法包括均值插补、最近邻插补和回归插补等。

均值插补是一种简单的方法,它假设缺失值与其他变量的均值相等。

最近邻插补则是根据与缺失值最相似的样本的值来填充缺失值。

回归插补则是根据其他变量的值来预测缺失值。

这些插补方法在稀疏数据分析中都有广泛的应用。

其次,稀疏数据分析中的另一个重要问题是特征选择。

在稀疏数据中,往往存在大量的特征,但其中只有少数几个特征对目标变量有重要的影响。

为了提高模型的准确性和解释性,我们需要选择最相关的特征。

常用的特征选择方法包括过滤法、包装法和嵌入法等。

过滤法是根据特征与目标变量之间的相关性来选择特征,常用的指标包括卡方检验、互信息和相关系数等。

包装法则是通过训练模型并评估特征的子集来选择最佳特征集合。

嵌入法则是在模型训练的过程中选择最佳特征。

这些特征选择方法在稀疏数据分析中都有广泛的应用。

此外,稀疏数据分析中的另一个重要问题是降维。

在稀疏数据中,往往存在高维度的特征空间,这会导致计算复杂度的增加和过拟合的问题。

为了解决这个问题,我们可以使用降维方法来减少特征的数量。

常用的降维方法包括主成分分析(PCA)、线性判别分析(LDA)和因子分析等。

主成分分析通过线性变换将高维数据映射到低维空间,使得映射后的数据保留了原始数据的大部分信息。

线性判别分析则是通过最大化类间距离和最小化类内距离来选择最佳投影方向。

数据挖掘的四大方法

数据挖掘的四大方法随着大数据时代的到来,数据挖掘在各行各业中的应用越来越广泛。

对于企业来说,掌握数据挖掘的技能可以帮助他们更好地分析数据、挖掘数据背后的价值,从而提升企业的竞争力。

数据挖掘有很多方法,在这篇文章中,我们将讨论四种常见的方法。

一、关联规则挖掘关联规则挖掘是数据挖掘中常用的方法之一。

它的基本思想是在一组数据中挖掘出两个或多个项目之间的相关性或关联性。

在购物中,关联规则挖掘可以被用来识别哪些产品常常被同时购买。

这样的信息可以帮助商家制定更好的促销策略。

关联规则挖掘的算法主要有 Apriori 和 FP-Growth 两种。

Apriori 算法是一种基于候选集搜索的方法,其核心思路是找到频繁项集,然后在频繁项集中生成关联规则。

FP-Growth 算法则是一种基于频繁模式树的方法,通过构建 FP-Tree 实现高效挖掘关联规则。

二、聚类分析聚类分析是另一种常用的数据挖掘方法。

它的主要目标是将数据集合分成互不相同的 K 个簇,使每个簇内的数据相似度较高,而不同簇内的数据相似度较低。

这种方法广泛应用于市场营销、医学、环境科学、地理信息系统等领域。

聚类分析的算法主要有 K-Means、二分 K-Means、基于密度的DBSCAN 等。

其中,K-Means 是一种较为简单的方法,通过随机初始化 K 个初始中心点,不断将数据点归类到最近的中心点中,最终形成 K 个簇。

DBSCAN 算法则是一种基于密度的聚类方法,而且在数据分布比较稀疏时表现较好。

三、分类方法分类方法是一种利用标记过的数据来训练一个分类模型,然后使用该模型对新样本进行分类的方法。

分类方法的应用非常广泛,例如将一封电子邮件分类为垃圾邮件或非垃圾邮件等。

常见的分类方法有决策树、朴素贝叶斯、支持向量机等。

决策树是一种易于理解、适用于大数据集的方法,通过分类特征为节点进行划分,构建一颗树形结构,最终用于样本的分类。

朴素贝叶斯是一种基于贝叶斯定理的分类方法,其核心思想是计算不同类别在给定数据集下的概率,从而进行分类决策。

Data Mining

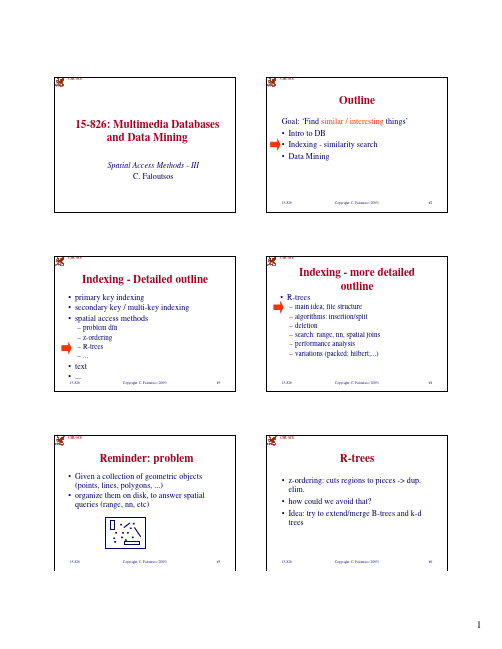

CMU SCSCMU SCSOutline 15-826: Multimedia Databases and Data MiningSpatial Access Methods - III C. Faloutsos Goal: ‘Find similar / interesting things’ • Intro to DB • Indexing - similarity search • Data Mining15-826Copyright: C. Faloutsos (2005)#2CMU SCSCMU SCSIndexing - Detailed outline• primary key indexing • secondary key / multi-key indexing • spatial access methods– – – – problem dfn z-ordering R-trees ...• R-treesIndexing - more detailed outline– main idea; file structure – algorithms: insertion/split – deletion – search: range, nn, spatial joins – performance analysis – variations (packed; hilbert;...)• text • ...15-826Copyright: C. Faloutsos (2005)#315-826Copyright: C. Faloutsos (2005)#4CMU SCSCMU SCSReminder: problem• Given a collection of geometric objects (points, lines, polygons, ...) • organize them on disk, to answer spatial queries (range, nn, etc)R-trees• z-ordering: cuts regions to pieces -> dup. elim. • how could we avoid that? • Idea: try to extend/merge B-trees and k-d trees15-826Copyright: C. Faloutsos (2005)#515-826Copyright: C. Faloutsos (2005)#61CMU SCSCMU SCS(first attempt: k-d-B-trees)• [Robinson, 81]: if f is the fanout, split pointset in f parts; and so on, recursively(first attempt: k-d-B-trees)• But: insertions/deletions are tricky (splits may propagate downwards and upwards) • no guarantee on space utilization15-826Copyright: C. Faloutsos (2005)#715-826Copyright: C. Faloutsos (2005)#8CMU SCSCMU SCSR-trees• [Guttman 84] Main idea: allow parents to overlap!– => guaranteed 50% utilization – => easier insertion/split algorithms. – (only deal with Minimum Bounding Rectangles - MBRs)R-trees• eg., w/ fanout 4: group nearby rectangles to parent MBRs; each group -> disk pageI AC B D E G H JF15-826Copyright: C. Faloutsos (2005)#915-826Copyright: C. Faloutsos (2005)#10CMU SCSCMU SCSR-trees• eg., w/ fanout 4:P1 AC B P2 D15-826R-trees• eg., w/ fanout 4:P1 AC B P3 F E GP3 F E GI HA B C D ECopyright: C. Faloutsos (2005)I HA B C D ECopyright: C. Faloutsos (2005)P1 P2 P3 P4P4 JH I F GJP2 D#11 15-826P4 JH I F GJ#122CMU SCSCMU SCSR-trees - format of nodes• {(MBR; obj-ptr)} for leaf nodesP1 P2 P3 P4R-trees - format of nodes• {(MBR; node-ptr)} for non-leaf nodesx-low; x-high node y-low; y-high ptr ... ...A B C P1 P2 P3 P4x-low; x-high obj y-low; y-high ptr ... ...15-826A B CCopyright: C. Faloutsos (2005)#1315-826Copyright: C. Faloutsos (2005)#14CMU SCSCMU SCSR-trees - range search?P1 AC B P2 D15-826R-trees - range search?P1 P3 AC BJP3 F E GI HA B C D ECopyright: C. Faloutsos (2005)P1 P2 P3 P4I G HA B C D ECopyright: C. Faloutsos (2005)P1 P2 P3 P4F EP4 JH I F GP2 D#15 15-826P4 JH I F GJ#16CMU SCSCMU SCSR-trees - range searchObservations: • every parent node completely covers its ‘children’ • a child MBR may be covered by more than one parent - it is stored under ONLY ONE of them. (ie., no need for dup. elim.)R-trees - range searchObservations - cont’d • a point query may follow multiple branches. • everything works for any dimensionality15-826Copyright: C. Faloutsos (2005)#1715-826Copyright: C. Faloutsos (2005)#183CMU SCSCMU SCS• R-treesIndexing - more detailed outlineP1 AC B X P2 DR-trees - insertion• eg., rectangle ‘X’P3 F E G I HA B C D ECopyright: C. Faloutsos (2005)– main idea; file structure – algorithms: insertion/split – deletion – search: range, nn, spatial joins – performance analysis – variations (packed; hilbert;...)P1 P2 P3 P4P4 JH I F GJ15-826Copyright: C. Faloutsos (2005)#1915-826#20CMU SCSCMU SCSR-trees - insertion• eg., rectangle ‘X’P1 AC B X P2 D15-826R-trees - insertion• eg., rectangle ‘Y’P1 P3 AC BJP3 F E GI HA B CP1 P2 P3 P4I G HA B C D ECopyright: C. Faloutsos (2005)P1 P2 P3 P4F EP4 JH I F GD E XCopyright: C. Faloutsos (2005)Y P2 D15-826P4 JH I F GJ#21#22CMU SCSCMU SCSR-trees - insertion• eg., rectangle ‘Y’ : extend suitable parent.P1 AC B Y P2 D15-826R-trees - insertion• eg., rectangle ‘Y’ : extend suitable parent. • Q: how to measure ‘suitability’ ?P3 F E GI HA B CP1 P2 P3 P4P4 JH I F GJD E YCopyright: C. Faloutsos (2005)#2315-826Copyright: C. Faloutsos (2005)#244CMU SCSCMU SCSR-trees - insertion• eg., rectangle ‘Y’ : extend suitable parent. • Q: how to measure ‘suitability’ ? • A: by increase in area (volume) (more details: later, under ‘performance analysis’ ) • Q: what if there is no room? how to split?P1 K AC B P2 D15-826 Copyright: C. Faloutsos (2005) #25 15-826R-trees - insertion• eg., rectangle ‘W’P3 W E F G I HA B C K D ECopyright: C. Faloutsos (2005)P1 P2 P3 P4P4 JH I F GJ#26CMU SCSCMU SCSR-trees - insertionP1R-trees - insertionP1• eg., rectangle ‘W’ - focus on ‘P1’ - how to split?K AC B W• eg., rectangle ‘W’ - focus on ‘P1’ - how to split?K • (A1: plane sweep, AC B W until 50% of rectangles) • A2: ‘linear’ split • A3: quadratic split • A4: exponential split15-826Copyright: C. Faloutsos (2005)#2715-826Copyright: C. Faloutsos (2005)#28CMU SCSCMU SCSR-trees - insertion & split• pick two rectangles as ‘seeds’ ; • assign each rectangle ‘R’ to the ‘closest’ ‘seed’seed2 R seed115-826 Copyright: C. Faloutsos (2005) #29 15-826R-trees - insertion & split• pick two rectangles as ‘seeds’ ; • assign each rectangle ‘R’ to the ‘closest’ ‘seed’ • Q: how to measure ‘closeness’ ?Copyright: C. Faloutsos (2005)#305CMU SCSCMU SCSR-trees - insertion & split• pick two rectangles as ‘seeds’ ; • assign each rectangle ‘R’ to the ‘closest’ ‘seed’ • Q: how to measure ‘closeness’ ? • A: by increase of area (volume)R-trees - insertion & split• pick two rectangles as ‘seeds’ ; • assign each rectangle ‘R’ to the ‘closest’ ‘seed’seed2 R seed115-826Copyright: C. Faloutsos (2005)#3115-826Copyright: C. Faloutsos (2005)#32CMU SCSCMU SCSR-trees - insertion & split• pick two rectangles as ‘seeds’ ; • assign each rectangle ‘R’ to the ‘closest’ ‘seed’seed2 R seed115-826 Copyright: C. Faloutsos (2005) #33 15-826R-trees - insertion & split• pick two rectangles as ‘seeds’ ; • assign each rectangle ‘R’ to the ‘closest’ ‘seed’ • smart idea: pre-sort rectangles according to delta of closeness (ie., schedule easiest choices first!)Copyright: C. Faloutsos (2005)#34CMU SCSCMU SCSR-trees - insertion - pseudocode• decide which parent to put new rectangle into (‘closest’ parent) • if overflow, split to two, using (say,) the quadratic split algorithm– propagate the split upwards, if necessaryR-trees - insertion observations• many more split algorithms exist (next!)• update the MBRs of the affected parents.15-826Copyright: C. Faloutsos (2005)#3515-826Copyright: C. Faloutsos (2005)#366CMU SCSCMU SCS• R-treesIndexing - more detailed outline– ??R-trees - deletion• delete rectangle • if underflow– main idea; file structure – algorithms: insertion/split – deletion – search: range, nn, spatial joins – performance analysis – variations (packed; hilbert;...)15-826Copyright: C. Faloutsos (2005)#3715-826Copyright: C. Faloutsos (2005)#38CMU SCSCMU SCSR-trees - deletion• delete rectangle • if underflow– temporarily delete all siblings (!); – delete the parent node and – re-insert themR-trees - deletion• variations: later (eg. Hilbert R-trees w/ 2-to1 merge)15-826Copyright: C. Faloutsos (2005)#3915-826Copyright: C. Faloutsos (2005)#40CMU SCSCMU SCS• R-treesIndexing - more detailed outlineR-trees - range searchpseudocode: check the root for each branch, if its MBR intersects the query rectangle apply range-search (or print out, if this is a leaf)#41 15-826 Copyright: C. Faloutsos (2005) #42– main idea; file structure – algorithms: insertion/split – deletion – search: range, nn, spatial joins – performance analysis – variations (packed; hilbert;...)15-826Copyright: C. Faloutsos (2005)7CMU SCSCMU SCSR-trees - nn searchP1 AC BqR-trees - nn search• Q: How? (find near neighbor; refine...)P1 AC BqP3 F E GI HP3 F E GI HP2 DP4 JP2 DP4 J15-826Copyright: C. Faloutsos (2005)#4315-826Copyright: C. Faloutsos (2005)#44CMU SCSCMU SCSR-trees - nn search• A1: depth-first search; then, range queryP1 AC BqR-trees - nn search• A1: depth-first search; then, range queryP1 AC BqP3 F E GI HP3 F E GI HP2 DP4 JP2 DP4 J15-826Copyright: C. Faloutsos (2005)#4515-826Copyright: C. Faloutsos (2005)#46CMU SCSCMU SCSR-trees - nn search• A1: depth-first search; then, range queryP1 AC BqR-trees - nn search• A2: [Roussopoulos+, sigmod95]:– priority queue, with promising MBRs, and their best and worst-case distanceP3 F E GI H• main idea:P2 DP4 J15-826Copyright: C. Faloutsos (2005)#4715-826Copyright: C. Faloutsos (2005)#488CMU SCSCMU SCSR-trees - nn searchconsider only P2 and P4, for illustration P1 AC BqR-trees - nn searchbest of P4 worst of P2 Hq=> P4 is useless for 1-nnP3 F E GI HP2 DP4 JP2 DEP4 J15-826Copyright: C. Faloutsos (2005)#4915-826Copyright: C. Faloutsos (2005)#50CMU SCSCMU SCSR-trees - nn search• what is really the worst of, say, P2?worst of P2R-trees - nn search• what is really the worst of, say, P2? • A: the smallest of the two red segments!qP2 DEqP2Copyright: C. Faloutsos (2005) #5215-826Copyright: C. Faloutsos (2005)#5115-826CMU SCSCMU SCSR-trees - nn search• variations: [Hjaltason & Samet] incremental nn:– build a priority queue – scan enough of the tree, to make sure you have the k nn – to find the (k+1)-th, check the queue, and scan some more of the tree• R-treesIndexing - more detailed outline– main idea; file structure – algorithms: insertion/split – deletion – search: range, nn, spatial joins – performance analysis – variations (packed; hilbert;...)• ‘optimal’ (but, may need too much memory)15-826 Copyright: C. Faloutsos (2005) #53 15-826 Copyright: C. Faloutsos (2005) #549CMU SCSCMU SCSR-trees - spatial joinsSpatial joins: find (quickly) all counties intersecting lakesR-trees - spatial joinsAssume that they are both organized in R-trees:15-826Copyright: C. Faloutsos (2005)#5515-826Copyright: C. Faloutsos (2005)#56CMU SCSCMU SCSR-trees - spatial joinsfor each parent P1 of tree T1 for each parent P2 of tree T2 if their MBRs intersect, process them recursively (ie., check their children)R-trees - spatial joinsImprovements - variations: - [Seeger+, sigmod 92]: do some pre-filtering; do plane-sweeping to avoid N1 * N2 tests for intersection - [Lo & Ravishankar, sigmod 94]: ‘seeded’ R-trees (FYI, many more papers on spatial joins, without Rtrees: [Koudas+ Sevcik], e.t.c.)15-826Copyright: C. Faloutsos (2005)#5715-826Copyright: C. Faloutsos (2005)#58CMU SCSCMU SCS• R-treesIndexing - more detailed outlineR-trees - performance analysis• How many disk (=node) accesses we’ ll need for– range – nn – spatial joins– main idea; file structure – algorithms: insertion/split – deletion – search: range, nn, spatial joins – performance analysis – variations (packed; hilbert;...)• why does it matter?15-826Copyright: C. Faloutsos (2005)#5915-826Copyright: C. Faloutsos (2005)#6010CMU SCSCMU SCSR-trees - performance analysis• How many disk (=node) accesses we’ ll need for– range – nn – spatial joinsR-trees - performance analysis• A: because we can design split etc algorithms accordingly; also, do queryoptimization • motivating question: on, e.g., split, should we try to minimize the area (volume)? the perimeter? the overlap? or a weighted combination? why?• why does it matter? • A: because we can design split etc algorithms accordingly; also, do queryoptimization15-826 Copyright: C. Faloutsos (2005) #6115-826Copyright: C. Faloutsos (2005)#62CMU SCSCMU SCSR-trees - performance analysis• How many disk accesses for range queries?– query distribution wrt location? – “ “ wrt size?R-trees - performance analysis• How many disk accesses for range queries?– query distribution wrt location? uniform; (biased) – “ “ wrt size? uniform15-826Copyright: C. Faloutsos (2005)#6315-826Copyright: C. Faloutsos (2005)#64CMU SCSCMU SCSR-trees - performance analysis• easier case: we know the positions of parent MBRs, eg:R-trees - performance analysis• How many times will P1 be retrieved (unif. queries)?x1 P1 x215-826Copyright: C. Faloutsos (2005)#6515-826Copyright: C. Faloutsos (2005)#6611CMU SCSCMU SCSR-trees - performance analysis• How many times will P1 be retrieved (unif. POINT queries)?x1 1 P1 x2R-trees - performance analysis• How many times will P1 be retrieved (unif. POINT queries)? A: x1*x2x1 1 P1 x2015-8260 0Copyright: C. Faloutsos (2005)1#6715-8260Copyright: C. Faloutsos (2005)1#68CMU SCSCMU SCSR-trees - performance analysis• How many times will P1 be retrieved (unif. queries of size q1xq2)?x1 1 P1 q2 x2R-trees - performance analysis• How many times will P1 be retrieved (unif. queries of size q1xq2)? A: (x1+q1)*(x2+q2)x1 1 P1 q2 x2015-8260q1Copyright: C. Faloutsos (2005)0 1#69 15-8260q1Copyright: C. Faloutsos (2005)1#70CMU SCSCMU SCSR-trees - performance analysis• Thus, given a tree with N nodes (i=1, ... N) we expect #DiskAccesses(q1,q2) = sum ( xi,1 + q1) * (xi,2 + q2) = sum ( xi,1 * xi,2 ) + q2 * sum ( xi,1 ) + q1* sum ( xi,2 ) q1* q2 * N15-826 Copyright: C. Faloutsos (2005) #71R-trees - performance analysis• Thus, given a tree with N nodes (i=1, ... N) we expect #DiskAccesses(q1,q2) = sum ( xi,1 + q1) * (xi,2 + q2) = sum ( xi,1 * xi,2 ) + ‘volume’ q2 * sum ( xi,1 ) + surface area q1* sum ( xi,2 ) q1* q2 * N count15-826 Copyright: C. Faloutsos (2005) #7212CMU SCSCMU SCSR-trees - performance analysisObservations: • for point queries: only volume matters • for horizontal-line queries: (q2=0): vertical length matters • for large queries (q1, q2 >> 0): the count N mattersR-trees - performance analysisObservations (cont’ ed) • overlap: does not seem to matter • formula: easily extendible to n dimensions • (for even more details: [Pagel +, PODS93], [Kamel+, CIKM93])15-826Copyright: C. Faloutsos (2005)#7315-826Copyright: C. Faloutsos (2005)#74CMU SCSCMU SCSR-trees - performance analysisConclusions: • splits should try to minimize area and perimeter • ie., we want few, small, square-like parent MBRs • rule of thumb: shoot for queries with q1=q2 = 0.1 (or =0.5 or so).R-trees - performance analysis• How many disk (=node) accesses we’ ll need for– range – nn – spatial joins15-826Copyright: C. Faloutsos (2005)#7515-826Copyright: C. Faloutsos (2005)#76CMU SCSCMU SCSR-trees - performance analysisRange queries - how many disk accesses, if we just now that we have - N points in n-d space? A: ?R-trees - performance analysisRange queries - how many disk accesses, if we just now that we have - N points in n-d space? A: can not tell! need to know distribution15-826Copyright: C. Faloutsos (2005)#7715-826Copyright: C. Faloutsos (2005)#7813CMU SCSCMU SCSR-trees - performance analysisWhat are obvious and/or realistic distributions?R-trees - performance analysisWhat are obvious and/or realistic distributions? A: uniform A: Gaussian / mixture of Gaussians A: self-similar / fractal. Fractal dimension ~ intrinsic dimension15-826Copyright: C. Faloutsos (2005)#7915-826Copyright: C. Faloutsos (2005)#80CMU SCSCMU SCSR-trees - performance analysisFormulas for range queries and k-nn queries: use fractal dimension [Kamel+, PODS94], [Korn+ ICDE2000] [Kriegel+, PODS97] Formulas for spatial joins of regions: open research question• R-treesIndexing - more detailed outline– main idea; file structure – algorithms: insertion/split – deletion – search: range, nn, spatial joins – performance analysis – variations (packed; hilbert;...)15-826Copyright: C. Faloutsos (2005)#8115-826Copyright: C. Faloutsos (2005)#82CMU SCSCMU SCSR-trees - variationsGuttman’ s R-trees sparked much follow-up work • can we do better splits? • what about static datasets (no ins/del/upd)? • what about other bounding shapes?R-trees - variationsGuttman’ s R-trees sparked much follow-up work • can we do better splits?– i.e, defer splits?15-826Copyright: C. Faloutsos (2005)#8315-826Copyright: C. Faloutsos (2005)#8414CMU SCSCMU SCSR-trees - variationsA: R*-trees [Kriegel+, SIGMOD90] • defer splits, by forced-reinsert, i.e.: instead of splitting, temporarily delete some entries, shrink overflowing MBR, and re-insert those entries • Which ones to re-insert? • How many?15-826 Copyright: C. Faloutsos (2005) #85R-trees - variationsA: R*-trees [Kriegel+, SIGMOD90] • defer splits, by forced-reinsert, i.e.: instead of splitting, temporarily delete some entries, shrink overflowing MBR, and re-insert those entries • Which ones to re-insert? • How many? A: 30%15-826 Copyright: C. Faloutsos (2005) #86CMU SCSCMU SCSR-trees - variationsQ: Other ways to defer splits?R-trees - variationsQ: Other ways to defer splits? A: Push a few keys to the closest sibling node (closest = ??)15-826Copyright: C. Faloutsos (2005)#8715-826Copyright: C. Faloutsos (2005)#88CMU SCSCMU SCSR-trees - variationsR*-trees: Also try to minimize area AND perimeter, in their split. Performance: higher space utilization; faster than plain R-trees. One of the most successful R-tree variants.R-trees - variationsGuttman’ s R-trees sparked much follow-up work • can we do better splits? • what about static datasets (no ins/del/upd)?– Hilbert R-trees• what about other bounding shapes?15-826Copyright: C. Faloutsos (2005)#8915-826Copyright: C. Faloutsos (2005)#9015CMU SCSCMU SCSR-trees - variations• what about static datasets (no ins/del/upd)? • Q: Best way to pack points?R-trees - variations• what about static datasets (no ins/del/upd)? • Q: Best way to pack points? • A1: plane-sweep great for queries on ‘x’ ; terrible for ‘y’15-826Copyright: C. Faloutsos (2005)#9115-826Copyright: C. Faloutsos (2005)#92CMU SCSCMU SCSR-trees - variations• what about static datasets (no ins/del/upd)? • Q: Best way to pack points? • A1: plane-sweep great for queries on ‘x’ ; bad for ‘y’R-trees - variations• what about static datasets (no ins/del/upd)? • Q: Best way to pack points? • A1: plane-sweep great for queries on ‘x’ ; terrible for ‘y’ • Q: how to improve?15-826Copyright: C. Faloutsos (2005)#9315-826Copyright: C. Faloutsos (2005)#94CMU SCSCMU SCSR-trees - variations• A: plane-sweep on HILBERT curve!R-trees - variations• A: plane-sweep on HILBERT curve! • In fact, it can be made dynamic (how?), as well as to handle regions (how?)15-826Copyright: C. Faloutsos (2005)#9515-826Copyright: C. Faloutsos (2005)#9616CMU SCSCMU SCSR-trees - variations• Dynamic (‘Hilbert Rtree):– each point has an ‘h’ value (hilbert value) – insertions: like a B-tree on the h-value – but also store MBR, for searchesR-trees - variations• Data structure of a node?LHVx-low, ylow x-high, y-highptrh-value >= LHV & MBRs: inside parent MBR15-826 Copyright: C. Faloutsos (2005) #97 15-826 Copyright: C. Faloutsos (2005) #98CMU SCSCMU SCSR-trees - variations• Data structure of a node?~B-tree x-low, ylow x-high, y-highR-trees - variations• Data structure of a node?~ R-treeLHVptrLHVx-low, ylow x-high, y-highptrh-value >= LHV & MBRs: inside parent MBR15-826 Copyright: C. Faloutsos (2005) #99 15-826h-value >= LHV & MBRs: inside parent MBRCopyright: C. Faloutsos (2005) #100CMU SCSCMU SCSR-trees - variationsGuttman’ s R-trees sparked much follow-up work • can we do better splits? • what about static datasets (no ins/del/upd)?– Hilbert R-trees - main idea – handling regions – performance/discusionR-trees - variations• What if we have regions, instead of points? • I.e., how to impose a linear ordering (‘hvalue’ ) on rectangles?• what about other bounding shapes?15-826 Copyright: C. Faloutsos (2005) #101 15-826 Copyright: C. Faloutsos (2005) #10217CMU SCSCMU SCSR-trees - variations• What if we have regions, instead of points? • I.e., how to impose a linear ordering (‘hvalue’ ) on rectangles? • A1: h-value of center • A2: h-value of 4-d point (center, x-radius, y-radius) • A3: ...15-826 Copyright: C. Faloutsos (2005) #103R-trees - variations• What if we have regions, instead of points? • I.e., how to impose a linear ordering (‘hvalue’ ) on rectangles? • A1: h-value of center • A2: h-value of 4-d point (center, x-radius, y-radius) • A3: ...15-826 Copyright: C. Faloutsos (2005) #104CMU SCSCMU SCSR-trees - variations• with h-values, we can have deferred splits, 2to-3 splits (3-to-4, etc) • experimentally: faster than R*-trees (reference: [Kamel Faloutsos vldb 94])R-trees - variationsGuttman’ s R-trees sparked much follow-up work • can we do better splits? • what about static datasets (no ins/del/upd)? • what about other bounding shapes?15-826Copyright: C. Faloutsos (2005)#10515-826Copyright: C. Faloutsos (2005)#106CMU SCSCMU SCSR-trees - variations• what about other bounding shapes? (and why?) • A1: arbitrary-orientation lines (cell-tree, [Guenther] • A2: P-trees (polygon trees) (MB polygon: 0, 90, 45, 135 degree lines)R-trees - variations• A3: L-shapes; holes (hB-tree) • A4: TV-trees [Lin+, VLDB-Journal 1994] • A5: SR-trees [Katayama+, SIGMOD97] (used in Informedia)15-826Copyright: C. Faloutsos (2005)#10715-826Copyright: C. Faloutsos (2005)#10818CMU SCSCMU SCSIndexing - Detailed outline• spatial access methods– problem dfn – z-ordering – R-trees – misc topics• • • •15-826R-trees - conclusions• • • • Popular method; like multi-d B-trees guaranteed utilization good search times (for low-dim. at least) Informix ships DataBlade with R-treesgrid files dimensionality curse metric trees other nn methodsCopyright: C. Faloutsos (2005) #109 15-826 Copyright: C. Faloutsos (2005) #110• text, ...CMU SCSCMU SCSReferences• Guttman, A. (June 1984). R-Trees: A Dynamic Index Structure for Spatial Searching. Proc. ACM SIGMOD, Boston, Mass. • Jagadish, H. V. (May 23-25, 1990). Linear Clustering of Objects with Multiple Attributes. ACM SIGMOD Conf., Atlantic City, NJ. • Lin, K.-I., H. V. Jagadish, et al. (Oct. 1994). “ The TV-tree - An Index Structure for High-dimensional Data.” VLDB Journal 3: 517-542.References, cont’d• Pagel, B., H. Six, et al. (May 1993). Towards an Analysis of Range Query Performance. Proc. of ACM SIGACTSIGMOD-SIGART Symposium on Principles of Database Systems (PODS), Washington, D.C. • Robinson, J. T. (1981). The k-D-B-Tree: A Search Structure for Large Multidimensional Dynamic Indexes. Proc. ACM SIGMOD. • Roussopoulos, N., S. Kelley, et al. (May 1995). Nearest Neighbor Queries. Proc. of ACM-SIGMOD, San Jose, CA.15-826Copyright: C. Faloutsos (2005)#11115-826Copyright: C. Faloutsos (2005)#11219。

稀疏数据处理方法

稀疏数据处理方法

稀疏数据指的是在大型数据集中具有很少非零元素的数据。

这种数据在现实世界中很常见,比如社交媒体、物联网和生物信息学等领域。

由于数据的稀疏性,传统的数据处理方法难以处理,因此需要一些特殊的处理技术来处理这种数据。

1. 稀疏数据表示方法

在稀疏数据处理中,最常用的表示方法是稀疏矩阵。

稀疏矩阵是一个矩阵,其中大多数元素都是零。

为了节省空间和计算资源,只需要存储非零元素和它们的位置。

通常情况下,非零元素的数量远远少于矩阵中所有的元素。

2. 稀疏数据的压缩

稀疏数据的压缩是减少存储空间和计算资源的有效方法。

最常用的压缩方法是压缩稀疏行(CSR)和压缩稀疏列(CSC)。

在CSR中,矩阵的非零元素按行存储,每一行存储一个非零元素的位置和值。

在CSC中,矩阵的非零元素按列存储,每一列存储一个非零元素的位置和值。

这种压缩方法可以大幅减少存储空间的占用。

3. 稀疏数据的算法

由于稀疏数据的特殊性质,传统的数据处理算法难以直接适用于稀疏数据。

因此,需要一些特殊的算法来处理稀疏数据。

最常用的算法包括稀疏矩阵乘法、岭回归和最小角回归等。

稀疏矩阵乘法是在稀疏矩阵上进行的一种特殊乘法运算。

它的思想是利用稀疏矩阵的特殊性质,将运算速度提高到O(NlogN)或O(N)。

岭回归是一种用于处理线性回归的方法。

它通过加入一个惩罚因子来解决过拟合的问题,同时利用稀疏矩阵的特殊性质来加速计算。

最小角回归是一种用于处理多元线性回归的方法。

它可以处理大规模的稀疏数据,并具有很强的稳定性和精度。

数据的无量纲化处理

数据的无量纲化处理引言概述:在数据分析和机器学习中,常常需要对数据进行预处理,其中无量纲化处理是其中一种重要的方法。

无量纲化处理可以使不同特征之间的数值范围一致,避免因为数值差异导致的模型不稳定或者收敛速度慢的问题。

本文将详细介绍数据的无量纲化处理方法及其应用。

一、无量纲化处理的方法1.1 最大-最小规范化(Min-Max Scaling):将数据线性地映射到[0,1]范围内。

1.2 零-均值规范化(Z-score Normalization):将数据转换为均值为0,标准差为1的分布。

1.3 小数定标规范化(Decimal Scaling):通过移动数据的小数点位置来实现无量纲化。

二、无量纲化处理的应用2.1 特征缩放:在机器学习中,特征缩放是无量纲化处理的一个重要应用,可以提高模型的性能。

2.2 聚类分析:在聚类分析中,不同特征之间的尺度差异会影响聚类结果,无量纲化处理可以解决这个问题。

2.3 数据可视化:在数据可视化中,无量纲化处理可以使不同特征的权重更加平衡,更好地展示数据特征。

三、无量纲化处理的优势3.1 提高模型性能:无量纲化处理可以提高模型的性能,减少因为特征尺度不同导致的问题。

3.2 加快模型收敛速度:无量纲化处理可以加快模型的收敛速度,提高训练效率。

3.3 改善模型稳定性:无量纲化处理可以改善模型的稳定性,减少模型在不同数据集上的波动。

四、无量纲化处理的注意事项4.1 数据分布:在进行无量纲化处理时,需要考虑数据的分布情况,选择合适的方法。

4.2 特征选择:在进行无量纲化处理时,需要注意选择哪些特征进行处理,避免对模型造成不必要的影响。

4.3 数据量级:在进行无量纲化处理时,需要考虑数据的量级,选择合适的处理方法。

五、总结数据的无量纲化处理是数据预处理中的重要步骤,通过无量纲化处理可以使不同特征之间的数值范围一致,避免因为数值差异导致的问题。

在实际应用中,根据数据的分布情况和特征选择合适的无量纲化处理方法,可以提高模型的性能和稳定性,加快模型的收敛速度,从而更好地应用于数据分析和机器学习任务中。

实用贴:机器学习的关键环节——数据预处理

实用贴:机器学习的关键环节——数据预处理众所周知,机器学习算法的表现不仅依赖模型的选择,也和数据本身的质量息息相关。

然而,现实世界中数据质量往往并不理想,很多负面的因素如数据丢失、数据噪声、数据冗余、数据维度灾难等严重影响了机器学习的表现。

正如在计算器科学与信息通信领域的一句习语:“Garbage in, garbage out!”,错误的、无意义的数据输入计算机,计算机自然也只能输出错误的、无意义的结果。

此外,数据预处理可能占用了整个工作流程40%-70%的时间成本,更凸显了数据预处理的复杂性和重要性,接下来我们将介绍目前数据预处理中主要问题,并给出相应的处理方法。

一、数据缺失在机器学习算法中,很大一部分都要求数据是完整的,然而,实际应用场景中样本数据中某些维度的缺失是很常见的。

如在金融风控领域,很多样本数据的提供者基于个人隐私的考虑并不会提供所有维度的信息(家庭成员信息,个人收入信息等),因此数据缺失问题并不能通过在数据搜集阶段的努力而得以回避。

面对数据缺失的问题,主要以下几种数据预处理方法:01.剔除非完整样本:如果数据样本总量较大,而含有缺失数据的样本占总样本比例较小,第一选择的方法就是剔除这些非完整的样本。

然而这种方法虽然简单,但剔除样本的同时也会丢失了一些重要的信息,而且如果样本数目总量有限,亦或者缺失数据样本较多,剔除数据将会影响机器学习的最终表现。

02.最大释然填充:最大释然填充是指根据数据的概率分布函数,通过最大释然估计,对缺失值进行填充。

该填充方法估计结果的准确性严重依赖于所假设的概率分布是否符合潜在的真实数据分布,因此需要对当前的应用场景本身有一定的经验知识。

然而数据本身的概率分布往往是未知的,如果确实想保留缺失数据其他维度提供的信息,可以采用均值填充或者中位数填充。

03.机器学习方法填充:如上文所述,数据本身的概率分布往往是未知的,而通过机器学习算法对缺失数据进行填充可以避免对数据的概率分布有过多的假设。

数据的无量纲化处理

数据的无量纲化处理引言概述:在数据分析和机器学习领域,数据的无量纲化处理是一种常见的预处理技术。

它的目的是消除不同特征之间的量纲差异,使得数据在进行模型建立和分析时更加准确和可靠。

本文将详细介绍数据无量纲化处理的概念、常见的方法和其在实际应用中的重要性。

一、标准化1.1 Z-score标准化Z-score标准化是一种常用的无量纲化处理方法。

它通过将每一个特征的值减去该特征的均值,再除以该特征的标准差,将数据转化为均值为0,标准差为1的分布。

这种方法适合于特征的分布近似正态分布的情况。

1.2 Min-max标准化Min-max标准化是一种常见的无量纲化处理方法。

它通过对每一个特征的值进行线性变换,将数据映射到一个指定的区间内。

通常情况下,将数据映射到[0, 1]的区间内。

这种方法适合于特征的分布没有明显的边界的情况。

1.3 小数定标标准化小数定标标准化是一种简单而有效的无量纲化处理方法。

它通过将每一个特征的值除以一个固定的基数,通常选择特征中的最大值或者最小值作为基数。

这种方法将数据映射到[-1, 1]或者[0, 1]的区间内,适合于特征的取值范围未知的情况。

二、正则化2.1 L1正则化L1正则化是一种常用的无量纲化处理方法。

它通过对每一个样本的特征向量进行归一化,使得每一个样本的特征向量的L1范数等于1。

这种方法适合于特征向量中存在大量的零值的情况,可以用于稀疏矩阵的处理。

2.2 L2正则化L2正则化是一种常见的无量纲化处理方法。

它通过对每一个样本的特征向量进行归一化,使得每一个样本的特征向量的L2范数等于1。

这种方法适合于特征向量中存在较多非零值的情况,可以用于降低特征向量中的噪声和异常值的影响。

2.3 弹性网正则化弹性网正则化是一种综合了L1和L2正则化的无量纲化处理方法。

它通过对每一个样本的特征向量进行归一化,并在L1和L2范数之间进行权衡,可以同时实现特征选择和模型稳定性的优化。

三、主成份分析(PCA)3.1 主成份分析的基本原理主成份分析是一种常用的无量纲化处理方法。

etl数据缺失值处理方法

etl数据缺失值处理方法E T L数据缺失值处理方法在数据处理过程中,经常会遇到数据缺失的情况。

数据缺失可能是由于各种原因导致的,比如传感器故障、人为错误、网络中断等。

在进行E T L (数据抽取、转换和加载)的过程中,我们需要对缺失的数据进行处理,以确保数据的完整性和准确性。

本文将介绍一些常用的E T L数据缺失值处理方法,并逐步解释它们的原理和应用场景。

1.数据丢弃(D r o p)数据丢弃是最简单的数据缺失处理方法之一。

当遇到缺失值时,我们可以选择直接忽略这些缺失数据,并将其从数据集中删除。

这种方法适用于缺失数据较少且对最终结果影响较小的情况。

然而,数据丢弃可能会导致数据集的减少,进而降低模型的可信度和预测能力。

2.均值填充(M e a n I m p u t a t i o n)均值填充是一种常用的处理缺失值的方法。

对于数值型数据,我们可以计算数据的均值,并用该均值填充缺失值。

这样做的原理是假设缺失值与其他观测值的平均值接近。

均值填充可以保持数据集的大小不变,并解决了数据丢失的问题。

然而,均值填充可能导致数据的扭曲,特别是当数据存在极端值或异常值时。

3.中位数填充(M e d i a n I m p u t a t i o n)中位数填充是一种类似于均值填充的方法,不同之处在于我们使用数据的中位数来填充缺失值。

中位数填充可以减少极端值对结果的影响,使数据的分布更加健壮。

然而,与均值填充一样,中位数填充也忽略了特征之间的相关性和差异。

4.众数填充(M o d e I m p u t a t i o n)众数填充是一种适用于分类型数据的缺失值处理方法。

对于缺失的分类型数据,我们可以找出最常出现的值,并用该值填充缺失值。

众数填充的优势在于能够保持数据的分布和特征之间的相关性。

然而,众数填充忽略了其他出现频率较低的值,可能会引入偏差。

5.插值法(I n t e r p o l a t i o n)插值法是一种基于已有数据的推测方法,用于填充缺失数据。