基于搜索编码的简单贝叶斯分类方法

基于机器学习的文本分类方法及实用性评估

基于机器学习的文本分类方法及实用性评估在当今信息爆炸的时代,大量的文本数据使得人们面临一个重要的挑战:如何高效地对海量文本进行分类和分析。

机器学习作为一种能够自动从数据中学习并提取知识的方法,被广泛应用于文本分类任务中。

本文将介绍基于机器学习的文本分类方法以及其在实际应用中的评估。

一、基于机器学习的文本分类方法1. 文本特征表示方法在进行文本分类之前,首先需要将文本数据转化为机器学习算法可以处理的特征向量。

常用的文本特征表示方法有以下几种:(1) 词袋模型 (Bag-of-Words Model): 该模型将文本看作是一组无序的词汇集合,忽略了词语之间的顺序和语法结构,只关注每个词出现的频率。

通过统计每个词在文本中出现的次数或者使用TF-IDF进行权重计算,可以将文本转化为高维稀疏的向量表示。

(2) Word2Vec: Word2Vec是一种基于神经网络的词向量表示方法,通过预训练的神经网络模型将每个词映射到一个固定长度的稠密向量。

Word2Vec考虑了词语的语义信息,可以更好地捕捉词语之间的关系。

(3) 文本主题模型 (Topic Models): 主题模型是一种能够自动发现文本中的主题信息的方法。

通过对文本进行主题建模,可以将文本表示为一个主题分布的向量。

2. 文本分类算法基于机器学习的文本分类算法可以分为有监督和无监督学习算法。

有监督学习算法通过已标注的训练数据学习分类模型,而无监督学习算法则从未标注的数据中自动学习分类规则。

(1) 朴素贝叶斯分类器 (Naive Bayes Classifier): 朴素贝叶斯分类器是一种基于概率的分类方法,假设特征之间相互独立。

该算法通过计算给定特征条件下的类别概率,来预测文本的类别。

(2) 支持向量机 (Support Vector Machine, SVM): SVM是一种二分类模型,通过在特征空间中建立一个最优超平面来进行分类。

其核函数的选取可以应用于非线性文本分类任务。

贝叶斯分类

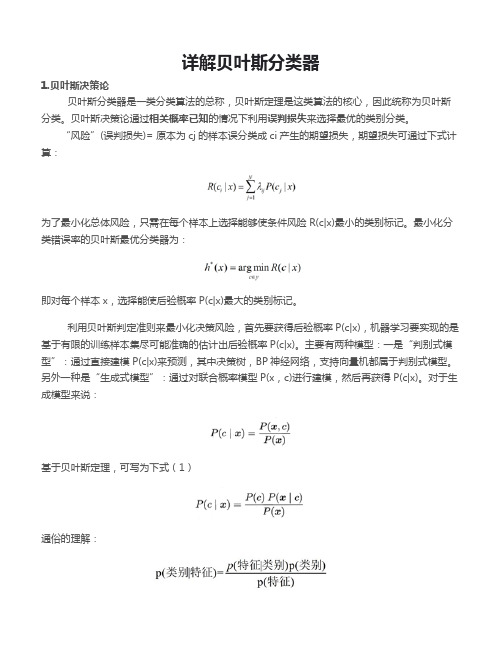

详解贝叶斯分类器1.贝叶斯决策论贝叶斯分类器是一类分类算法的总称,贝叶斯定理是这类算法的核心,因此统称为贝叶斯分类。

贝叶斯决策论通过相关概率已知的情况下利用误判损失来选择最优的类别分类。

“风险”(误判损失)= 原本为cj的样本误分类成ci产生的期望损失,期望损失可通过下式计算:为了最小化总体风险,只需在每个样本上选择能够使条件风险R(c|x)最小的类别标记。

最小化分类错误率的贝叶斯最优分类器为:即对每个样本x,选择能使后验概率P(c|x)最大的类别标记。

利用贝叶斯判定准则来最小化决策风险,首先要获得后验概率P(c|x),机器学习要实现的是基于有限的训练样本集尽可能准确的估计出后验概率P(c|x)。

主要有两种模型:一是“判别式模型”:通过直接建模P(c|x)来预测,其中决策树,BP神经网络,支持向量机都属于判别式模型。

另外一种是“生成式模型”:通过对联合概率模型P(x,c)进行建模,然后再获得P(c|x)。

对于生成模型来说:基于贝叶斯定理,可写为下式(1)通俗的理解:P(c)是类“先验”概率,P(x|c)是样本x相对于类标记c的类条件概率,或称似然。

p(x)是用于归一化的“证据”因子,对于给定样本x,证据因子p(x)与类标记无关。

于是,估计p(c|x)的问题变为基于训练数据来估计p(c)和p(x|c),对于条件概率p(x|c)来说,它涉及x所有属性的联合概率。

2.极大似然估计假设p(x|c))具有确定的形式并且被参数向量唯一确定,则我们的任务是利用训练集估计参数θc,将P(x|c)记为P(x|θc)。

令Dc表示训练集D第c类样本的集合,假设样本独立同分布,则参数θc对于数据集Dc的似然是对进行极大似然估计,就是去寻找能最大化P(Dc|θc)的参数值。

直观上看,极大似然估计是试图在θc所有可能的取值中,找到一个能使数据出现的“可能性”最大的值。

上式的连乘操作易造成下溢,通常使用对数似然:此时参数θc的极大似然估计为在连续属性情形下,假设概率密度函数,则参数和的极大似然估计为:也就是说,通过极大似然法得到的正态分布均值就是样本均值,方差就是的均值,在离散情况下,也可通过类似的方式估计类条件概率。

bayes分类的算法代码

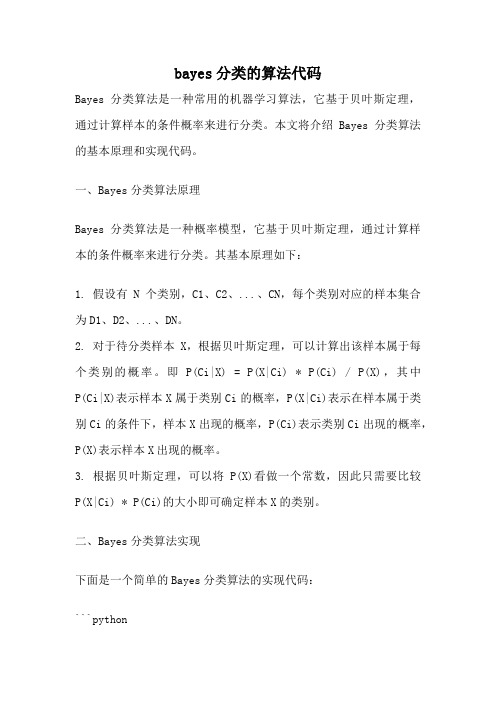

bayes分类的算法代码Bayes分类算法是一种常用的机器学习算法,它基于贝叶斯定理,通过计算样本的条件概率来进行分类。

本文将介绍Bayes分类算法的基本原理和实现代码。

一、Bayes分类算法原理Bayes分类算法是一种概率模型,它基于贝叶斯定理,通过计算样本的条件概率来进行分类。

其基本原理如下:1. 假设有N个类别,C1、C2、...、CN,每个类别对应的样本集合为D1、D2、...、DN。

2. 对于待分类样本X,根据贝叶斯定理,可以计算出该样本属于每个类别的概率。

即P(Ci|X) = P(X|Ci) * P(Ci) / P(X),其中P(Ci|X)表示样本X属于类别Ci的概率,P(X|Ci)表示在样本属于类别Ci的条件下,样本X出现的概率,P(Ci)表示类别Ci出现的概率,P(X)表示样本X出现的概率。

3. 根据贝叶斯定理,可以将P(X)看做一个常数,因此只需要比较P(X|Ci) * P(Ci)的大小即可确定样本X的类别。

二、Bayes分类算法实现下面是一个简单的Bayes分类算法的实现代码:```pythonimport numpy as npdef bayes_classify(train_data, train_labels, test_data):# 计算每个类别的先验概率labels = list(set(train_labels))prior_prob = {}for label in labels:prior_prob[label] = np.sum(np.array(train_labels) == label) / len(train_labels)# 计算每个特征在每个类别下的条件概率conditional_prob = {}for label in labels:label_data = train_data[np.array(train_labels) == label]for i in range(len(label_data[0])):feature_values = set(label_data[:, i])for value in feature_values:if (i, value, label) not in conditional_prob:conditional_prob[(i, value, label)] = np.sum(label_data[:, i] == value) / len(label_data)# 对测试样本进行分类test_labels = []for test_sample in test_data:max_prob = -1max_label = ''for label in labels:prob = prior_prob[label]for i in range(len(test_sample)):if (i, test_sample[i], label) in conditional_prob:prob *= conditional_prob[(i, test_sample[i], label)]if prob > max_prob:max_prob = probmax_label = labeltest_labels.append(max_label)return test_labels```三、代码解析上述代码中,我们首先计算了每个类别的先验概率,即P(Ci),然后计算了每个特征在每个类别下的条件概率,即P(X|Ci)。

python库中的5种贝叶斯算法

python库中的5种贝叶斯算法Python是一种广泛使用的编程语言,拥有丰富的库和工具包,其中包括了多种贝叶斯算法。

贝叶斯算法是一类基于贝叶斯定理的统计学方法,可以用于分类、聚类、概率估计等任务。

在Python中,我们可以使用以下5种常见的贝叶斯算法来解决不同的问题。

1. 朴素贝叶斯算法(Naive Bayes)朴素贝叶斯算法是一种简单而有效的分类算法,它假设所有特征之间相互独立。

在文本分类、垃圾邮件过滤等任务中得到了广泛应用。

在Python中,我们可以使用scikit-learn库中的`sklearn.naive_bayes`模块来实现朴素贝叶斯算法。

该模块提供了多种朴素贝叶斯分类器的实现,如高斯朴素贝叶斯、多项式朴素贝叶斯和伯努利朴素贝叶斯。

2. 高斯朴素贝叶斯算法(Gaussian Naive Bayes)高斯朴素贝叶斯算法假设特征的概率分布服从高斯分布。

它常用于处理连续型特征的分类问题。

在Python中,我们可以使用scikit-learn库中的`sklearn.naive_bayes.GaussianNB`类来实现高斯朴素贝叶斯算法。

该类提供了`fit`和`predict`等方法,可以用于拟合模型和进行预测。

3. 多项式朴素贝叶斯算法(Multinomial Naive Bayes)多项式朴素贝叶斯算法适用于处理离散型特征的分类问题,如文本分类中的词频统计。

在Python中,我们可以使用scikit-learn库中的`sklearn.naive_bayes.MultinomialNB`类来实现多项式朴素贝叶斯算法。

该类同样提供了`fit`和`predict`等方法,可以用于拟合模型和进行预测。

4. 伯努利朴素贝叶斯算法(Bernoulli Naive Bayes)伯努利朴素贝叶斯算法适用于处理二值型特征的分类问题,如文本分类中的二进制词袋模型。

在Python中,我们可以使用scikit-learn库中的`sklearn.naive_bayes.BernoulliNB`类来实现伯努利朴素贝叶斯算法。

贝叶斯算法简单介绍

贝叶斯算法简单介绍贝叶斯算法是一种基于统计学的算法,主要用于机器学习与人工智能领域中的分类问题。

该算法是在 18 世纪由英国数学家托马斯·贝叶斯发明的,因此得名贝叶斯算法。

在机器学习领域中,贝叶斯算法被用于解决分类问题。

分类问题就是将一个实例归类到已有类别中的某一个类别中,如将一条邮件归类为垃圾邮件或非垃圾邮件。

贝叶斯算法的基本思想是:给定一个分类问题和一组特征,通过求解特征的条件概率来得到每个类别的概率,从而将实例分到概率最大的那个类别中。

在贝叶斯算法中,最重要的是先验概率和后验概率。

先验概率是指在没有任何与特征相关的信息时,每个类别的概率。

例如,在分类汉字的问题中,让我们假设“大” 字比“小” 字常见,这样我们就可以认为“大” 字的先验概率比“小” 字的先验概率高。

后验概率是基于输入数据的特征,通过学习得出的概率。

例如,当给出一个汉字时,通过学习得出该字是“大” 字的后验概率。

通过计算先验概率和后验概率,就得到了分类问题的最终概率。

下面我们来看一个具体的例子,假设我们要通过贝叶斯算法判断一个邮箱中的邮件是否是垃圾邮件。

我们可以将邮件的内容和标题等相关特征看成先验概率,将垃圾邮件和非垃圾邮件看成后验概率,应用贝叶斯公式进行计算。

具体步骤如下:首先,我们需要收集一些已知类别的邮件数据,将其分为两个类别:垃圾邮件和非垃圾邮件。

然后,我们需要对每个单词进行分析,看它们与垃圾邮件和非垃圾邮件的关系。

例如,“买药”这个词汇就与垃圾邮件有强关系,而“会议”这个词汇就与非垃圾邮件有强关系。

接下来,我们将每个单词与它们在垃圾邮件和非垃圾邮件中的出现次数进行记录。

这个过程中,我们需要使用平滑处理的技巧,避免数据稀疏问题。

之后,通过贝叶斯公式,我们可以得到该邮件为垃圾邮件的概率,也可以得到非垃圾邮件的概率。

根据这些概率,我们可以将邮件进行分类,并进行后续的处理。

当然,贝叶斯算法并不仅仅适用于垃圾邮件分类问题,还可以应用于医学诊断、自然语言处理、金融风险管理等领域。

贝叶斯算法原理

贝叶斯算法原理贝叶斯算法是一种基于概率统计理论的分类方法,它的核心思想是利用已知的样本数据来计算待分类样本属于某个类别的概率。

在机器学习和数据挖掘领域,贝叶斯算法被广泛应用于文本分类、垃圾邮件过滤、情感分析等任务中,具有较好的分类性能和鲁棒性。

本文将从贝叶斯算法的原理、应用和优缺点等方面进行介绍。

贝叶斯算法的原理。

贝叶斯算法基于贝叶斯定理,通过已知的先验概率和样本数据的条件概率来计算后验概率,从而实现分类任务。

在分类问题中,我们需要将待分类的样本分到不同的类别中,而贝叶斯算法就是利用样本的特征和类别之间的关系来进行分类的。

具体来说,对于给定的样本特征X和类别Y,贝叶斯算法通过计算后验概率P(Y|X)来确定样本属于某个类别的概率。

而P(Y|X)可以根据贝叶斯定理表示为:P(Y|X) = P(X|Y) P(Y) / P(X)。

其中,P(X|Y)表示在类别Y下样本特征X的条件概率,P(Y)表示类别Y的先验概率,P(X)表示样本特征X的先验概率。

通过比较不同类别下的后验概率,我们可以将样本分到概率最大的类别中,从而实现分类。

贝叶斯算法的应用。

贝叶斯算法在文本分类、垃圾邮件过滤、情感分析等任务中有着广泛的应用。

在文本分类中,我们可以利用贝叶斯算法来对文本进行分类,如将新闻文章分为政治、经济、娱乐等类别。

在垃圾邮件过滤中,我们可以利用贝叶斯算法来判断邮件是否为垃圾邮件,从而提高邮件过滤的准确性。

在情感分析中,我们可以利用贝叶斯算法来分析文本中的情感倾向,如判断评论是正面的还是负面的。

贝叶斯算法的优缺点。

贝叶斯算法具有较好的分类性能和鲁棒性,但也存在一些缺点。

其优点主要包括:1. 算法简单,易于实现。

贝叶斯算法基于概率统计理论,计算过程相对简单,易于实现和理解。

2. 对小样本数据效果较好。

贝叶斯算法能够有效利用已知的样本数据,对小样本数据的分类效果较好。

3. 对噪声数据具有较强的鲁棒性。

贝叶斯算法能够通过概率计算来降低噪声数据的影响,具有较强的鲁棒性。

信息检索导论的文本分类及朴素贝叶斯方法总结知识

在信息检索导论中,文本分类是一个重要的主题,而朴素贝叶斯方法则是其中一种常用的分类方法。

在本文中,我们将深入探讨文本分类及朴素贝叶斯方法,并总结这方面的知识。

1. 信息检索导论信息检索是指从大规模数据中找到相关的信息。

在这个过程中,文本分类起着至关重要的作用,它可以帮助我们将大规模文本数据按照预先定义的类别进行组织和分类。

而朴素贝叶斯方法则是文本分类中常用的一种方法。

2. 文本分类文本分类是指将文本文件自动分类到一个或多个已知类别的过程。

这个过程通常包括文本预处理、特征提取和分类器训练等步骤。

在文本分类中,我们需要考虑到文本的深度和广度,即从文本的表面信息到更深层次的语义理解。

这一点需要在文本分类的训练和特征提取过程中得到充分考虑。

3. 朴素贝叶斯方法朴素贝叶斯方法是一种基于贝叶斯定理和特征条件独立假设的分类方法。

在文本分类中,朴素贝叶斯方法常常被用来对文本进行分类,尤其是在自然语言处理领域。

该方法在处理大规模文本数据时表现出色,而且其简单、高效的特点也使其受到广泛关注。

4. 总结及个人观点信息检索导论中的文本分类及朴素贝叶斯方法对我们理解大规模文本数据、提高信息检索效率等方面都具有重要意义。

在我看来,深入理解文本分类的深度和广度对于我们更好地利用文本数据至关重要。

朴素贝叶斯方法的简单和高效也让我对其在文本分类中的应用充满信心。

以上就是对信息检索导论中的文本分类及朴素贝叶斯方法的总结,希望对你有所帮助。

文本分类及朴素贝叶斯方法在信息检索领域中扮演着重要的角色。

信息检索是一个涉及大规模数据的过程,而文本分类则是帮助我们将这些数据进行有序分类的重要技术。

在这一过程中,朴素贝叶斯方法作为一种常用的文本分类方法,具有简单高效的特点,因此受到了广泛的关注和应用。

下面将从文本分类的重要性、朴素贝叶斯方法的原理与应用以及未来发展趋势等方面深入探讨信息检索导论中的这两个关键领域。

文本分类在信息检索中的重要性不言而喻。

基于搜索树的告警高效聚类算法和Bayes分类器的设计和研究

Ab ta t Ho t fe tv l n u a u b e a n r lb h vo s fo t e n me o s a am sa d lg r d c d b l s r c w O e fc i ey f d o tv la l b o ma e a i r r m h u r u lr n o s p o u e y a l i k n s o e u i r d c se e y a i d fs c rt p o u t v r d y.al f h m u tb n l z d a d t e tu n o - e u d n f r a in s o l e y l o e m s ea a y e n h r ea d n n r d n a ti o t n m to h u d b e t a td。wh c s h l f l O fn h e l r be a d t e o r c ig a to sc n b a e O p o e tt e s f t fs s x r ce ih i e p u i d t e r a o lm n h nc r e t c in a et k n t r t c h a e y o y — t p n tr . Th s i n f h i g s h l n e ih I sf cn . I h sp p r a i g i t c o n e r h t e i a en i s o eo e b g e t al g swh c DS i a ig n t i a e ,t k n n o a c u ts a c r e wh c c n t c e h d c e s e r h n p c n v ra e t r n a e t cu t rn l o i m a e n s a c r e i p e e td S s t e r a e s a c ig s a e a d o e l y v co ,a l r l se i g ag rt h b s d o e r h t e s r s n e . o a o ca sf e a e ta d c n h v o r l t n wi t e lr 。a l r c a sf d me h d b s d o a e in ca sf ri m — ls i n w l r n a a e c r e a i t o h rae t n ae t l s ii t o a e n B y sa ls i e Se y o h e i p a ia l r p s d. a t h t l p o o e At s ,KDD p 1 9 t su e Oe a u t h e f r a c fag rt m ,a d t ee p rme t e y l Cu 9 9 Da a i s d t v l a e t e p ro m n eo l o i h n h x e i n r s l h w h i h e f in yo h l o i m.Th p l a i n ft e t u t f r to - o r e it l g n il e e u t s o t e h g fi e c f ea g rt s c t h e a p i t so h m O M l ・n o ma i n s u c n e l e t — c o ii i as_ c rt u i n y t m n ia e t a h y wi a e a g o u u e f r i l me t to . u i a d t g s s e i d c t h tt e l h v o d f t r o mp e n a in y i l Ke wo d Al r c r ea in,B y sa ls i e ,S a c r e a g rt ,C u t r g y rs e t o rlt o a e in ca sf r e r h te l o i i m h I se i n

贝叶斯分类分类算法

贝叶斯分类分类算法贝叶斯分类(Bayesian classification)是一种基于贝叶斯定理的分类算法,它将特征之间的条件概率和类别的先验概率组合起来,通过计算后验概率来确定一个样本属于其中一类别的概率。

贝叶斯分类算法在文本分类、垃圾邮件过滤和情感分析等领域都有广泛应用。

贝叶斯分类的核心思想是通过条件概率来计算后验概率。

在分类问题中,我们要将一个样本进行分类,假设有 n 个特征变量 x1, x2, ..., xn,每个特征变量有 k 个可能的取值,将样本分为 m 个类别 C1,C2, ..., Cm。

需要计算的是给定样本的特征值 x1, x2, ..., xn 下,它属于每个类别的概率 P(C1,x1, x2, ..., xn), P(C2,x1, x2, ..., xn), ..., P(Cm,x1, x2, ..., xn)。

根据贝叶斯定理,P(Ci,x1, x2, ..., xn) = P(Ci) * P(x1,x2, ..., xn,Ci) / P(x1, x2, ..., xn)。

其中,P(Ci) 是类别 Ci 的先验概率,P(x1, x2, ..., xn,Ci) 是样本 x1, x2, ..., xn 在给定类别 Ci 的条件下的概率,P(x1, x2, ..., xn) 是样本 x1, x2, ..., xn出现的概率。

贝叶斯分类算法的核心是学习类别的先验概率和特征之间的条件概率。

通常采用的方法是从已有数据中估计这些概率。

假设训练数据集中有 N个样本,属于类别 Ci 的样本有 Ni 个。

类别 Ci 的先验概率可以估计为P(Ci) = Ni / N。

而特征之间的条件概率可以通过计算样本中特征的频率来估计,比如计算属于类别 Ci 的样本中特征 xj 取值为 a 的频率 P(xj = a,Ci) = Nij / Ni,其中 Nij 是属于类别 Ci 的样本中特征 xj 取值为 a 的个数。

朴素贝叶斯分类算法python代码

朴素贝叶斯分类算法python代码朴素贝叶斯分类算法是一种基于概率的统计分类算法,该算法的主要实现思想是对预测对象进行特征提取、概率计算和分类判断,以实现对对象的分类识别。

本文将重点介绍朴素贝叶斯分类算法在Python中的应用与实现,以帮助读者更好地理解该算法。

首先,我们需要了解Bayes理论,在Bayes理论中,条件概率是指在已知某些条件的情况下,某一事件发生的概率。

朴素贝叶斯分类算法是基于该理论的,以此为基础,实现了对预测对象的分类。

具体来说,朴素贝叶斯分类算法的过程如下:1. 建立分类模型:在统计学习中,首先需要建立一种分类模型,这种模型在朴素贝叶斯分类算法中是基于特征集的贝叶斯定理来定义的。

2. 提取特征:在对预测对象进行分类前,需要先对对象进行特征提取,将其转化为数值型特征,以便后续计算分析。

常用的特征提取方法包括文本处理技术、特征选择等。

3. 计算概率:得到特征集后,基于该特征集进行预测。

可以利用训练集中的概率分布计算当前对象的概率分布。

其中,朴素贝叶斯分类算法中的“朴素”指假设特征之间是独立的,即每个特征对目标类别的影响是相互独立的,这使得计算概率分布更为简单和快速。

4. 进行分类:根据最大化概率的准则,将对象分类到概率最高的类别中。

例如,若某对象概率最高的类别为“正常”,则将该对象分类到“正常”类别中。

在Python中,可以借助于sklearn包来实现朴素贝叶斯分类算法。

下面进行一些示例代码来对其进行解释:''' import numpy as np from sklearn.naive_bayes import GaussianNB from sklearn.model_selection import train_test_split from sklearn import datasets# 读取iris数据集 iris = datasets.load_iris() X = iris.data y = iris.target# 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3) # 建立高斯朴素贝叶斯分类器 gnb = GaussianNB() gnb.fit(X_train, y_train) # 训练模型# 对测试集进行预测 y_pred = gnb.predict(X_test)# 输出结果 print('Accuracy:', np.sum(y_pred == y_test) / len(y_test)) '''这段代码演示了如何使用sklearn包中的高斯朴素贝叶斯分类器进行分类。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1 简单贝叶斯算法

贝叶斯统计分类法的思想是将未知类别的样本 X = ( x 1 , x 2 , …, x l ) 分类给其最可能属于的类别 y , 即有 : ^

y = arg max P ( cj | x 1 , x 2 , …, x l )

j c ∈CS

j

根据贝叶斯理论 , 可将上式写为 :

y = arg max

l

| ck ) =

i =1

∏P ( x

i

| ck ) 。 因此简单贝叶斯法可描述为 :

l

y NB = arg max P ( ck ) ・

k c ∈CS

k

i =1

∏P ( x

i

| ck )

( 2)

式 ( 2) 中 , P ( ck ) 与 P ( x i | ck ) 的估计值分别为它们在训练样本集中出现的频率 。 上述关于贝叶斯方法的讨论是针对离散属性而言 , 若第 i 个属性为连续属性 , 显然不能用计数法确 定 P ( x i | ck ) , 可采用如下两种方法 :一是假定属性 i 关于第 k 个类别的条件概率密度函数 ( 用函数 f i| k 表示) 的形式已知 , 如服从正态分布 , 利用极大似然估计获得这些概率密度函数中的未知参数 , 然后预测 未知样本 X 的类别 :

2 搜索输出编码

2. 1 搜索编码算法

令 m 个长度为 n 的码字组成的集合为 CM , CM 可表示成大小为 m ×n 的矩阵形式 , 矩阵的每一 行对应一个码字 , 我们称 CM 为码矩阵 。在后面的讨论中 , 将码字的集合用码矩阵表示 , 并令 CM [ i ] 表示码矩阵的第 i 个码字 ( 即第 i 行) , CM [ 3 , j ]表示码矩阵的第 j 列 , CM [ i , j ]则表示 CM 中第 i 行 第 j 列对应位的值 。 纠错输出码将编码理论中纠错码的思想用于监督分类 。基于纠错输出码的监督分类过程可描述 为 :首先利用类别数 m 构造一个具有纠错能力的码矩阵 CM m ×n ( 称 CM 为纠错输出码 ) , 每个类别对 应着 CM 中一个长度为 n 的码字 , 这些码字的每一列对应一个两类分类问题 。令第 i 列的理想二值函 数为 f i , 样本 X 的真实类别的编号为 Cl ass ( X) , 则有 : 1 if CM [ Cl ass ( X) , i ] = 1 f i ( X) = 0 else 然后利用训练样本对各列的二值函数进行学习 , 获得 n 个二分器 ; 在分类阶段 , 各二分器的输出形成一 个输出向量 , 再利用决策方法判定该输出向量与 CM 中各码字的相似度 , 预测样本所属的类别 。纠错 输出码一方面将一个 m ( m ≥ 2) 类问题转化为 n 个两类问题 , 另一方面 , 利用输出码本身具有的纠错能 力 , 可以纠正某些二分器的错误输出 , 从而提高分类器的泛化能力 。 搜索编码法 [ 9 ] 通过对整数空间的顺序搜索 , 可以获得满足任意类别数与最小汉明距离要求的纠错 输出码 。该方法将非负整数与二进制位串对应起来 , 输入类别数 m 与期望的最小汉明距离 d , 利用计

If Dif f B it ( B i n ( x , n ) , B i n ( y , n ) ) < d Then Tag = False ;

313 If Tag = T rue Then CI = { x} ∪CI ; 314 x = x + 1 ; 41 For Each Element y in CI ;

A Bayesian Learning Algorithm Based on Search2Coding Method

J IAN G Yan2huang , YAN G Xue2jun

(College of Computer , National Univ1 of Defense Technology , Changsha 410073 ,China)

Abstract: Na ve2Bayes algorit hm is a stable supervised learning met hod , and it is difficult to improve its predicting accuracy. This paper analyzes t he properties of t he error2correcting output codes generated by search2coding met hod at first , t hen presents a search coding based on va ve Bayes algorit hm ( SCNB ) , and describes t he flow chart of SCNB in detail. Experimental results show t hat search2coding met hod is an efficient approach to improve t he generalization for Bayesian classifiers. Key words :supervised ;classification ;Na ve2Bayes algorit hm ;error2correcting output code ( ECOC) ;search2coding met hod

311 Tag = T rue ; 312 For Each Integer y in CI

If Dif f B it ( B i n ( x , n ) , B i n ( y , n) ) < d Then Tag = False ;

313 If Tag = T rue Then CI = { x} ∪CI ; 41 Return | CI | .

简单贝叶斯法 [ 1 ] 是监督分类中最为常用的学习算法 , 对于大多数的应用问题 , 即使属性之间不满 足独立性 ,仍然能够取得较为理想的分类结果 。提高学习算法的泛化能力 ( generalization) 一直是监督 分类的重要研究内容 ,高精度的预测结果也是应用的不断需求[ 2 ] 。由于简单贝叶斯法性能稳定 , 训练 样本集小的变动对学习结果的影响很小 ,因此很难通过分类器组合等方法来提高其预测精度[ 3 ] 。 纠错输出编码技术 [ 4 ,5 ] 不仅可用于将多类分类问题简化为多个两类问题来处理 , 扩展学习算法的 应用范围 ,而且利用输出码具有纠错能力这一特性 ,可以提高监督分类器的泛化能力 。搜索编码法对含 任意类别数的监督分类问题 ,均能产生满足要求的纠错输出码 。 在下面的讨论中 , 将样本 X 表示为属性向量的形式 , 即 X = ( x 1 , x 2 , …, x l ) , 元素 x j 为样本 X 的 在第 j 个属性上的值 , l 为属性的个数 , 各属性可以为离散或连续属性 ; 并令 CS = { c1 , c2 , …, c m } 为类别 的集合 , m 为类别的个数 ; | L S | 为训练样本集 L S 中的元素个数 。

基于搜索编码的简单贝叶斯分类方法

蒋艳凰 ,杨学军

( 国防科技大学计算机学院 ,湖南 长沙 410073)

Ξ

摘 要 :简单贝叶斯法性能稳定 ,分类精度难以提高 。通过分析搜索编码法产生的纠错输出码的性质 ,提 出基于搜索编码的简单贝叶斯算法 SCNB , 并详细阐述了 SCNB 算法的应用流程 。实验结果表明 , 采用搜索 编码法能够有效提高简单贝叶斯分类器的泛化能力 。 关键词 : 监督分类 ; 简单贝叶斯算法 ; 纠错输出码 ; 搜索编码法 中图分类号 : TP181 文献标识码 :A

国 防 科 技 大 学 学 报 第 26 卷第 5 期 JOURNAL OF NATIONAL UNIVERSITY OF DEFENSE TECHNOLOGY Vol. 26 No. 5 2004 文章编号 :1001 - 2486 ( 2004) 05 - 0063 - 07

© 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved.

蒋艳凰 ,等 : 基于搜索编码的简单贝叶斯分类方法

65

算机自动搜索出满足要求的 m 个码字 。图 1 ( a) 和图 1 ( b) 分别给出了搜索编码法中创建码数表项和生 成纠错输出码的伪代码 。

© 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved.

国 防 科 技 大 学 学

k

c ∈CS

P ( x 1 , x 2 , …, x l | ck ) ・ P ( ck ) P ( x 1 , x 2 , …, x l )

Ξ 收稿日期 :2004 - 08 - 06

基金项目 : 国家杰出青年科学基金资助项目 (69825104) ) ,女 ,博士生 。 作者简介 : 蒋艳凰 (1976 —

l

1

l

2

y NB = arg max P ( ck ) ・

k c ∈CS

k

i =1

∏

f i| k ( x i ) ・

j =1

∏P ( x

j

| ck )

( 3)

式 ( 3) 中 , l 1 与 l 2 分别表示连续属性与离散属性的数目 , 满足 l 1 + l 2 = l 。第二种方法是将连续属性的 取值范围离散化成若干区间 , 然后将该连续属性作为一个离散属性处理 , 每个区间对应离散属性的一个 取值 , 并将落入某区间内的属性值转化为该区间对应的离散值 , 最后统计每个区间内的样本数 , 并利用 式 ( 2) 计算预测结果 。由于大多数应用领域中概率分布形式难以用公式表示 , 因此将连续属性离散化是 一种更有效的方法 [ 6 , 7 ] 。 与决策树 、 B P 神经网络等方法不同 , 简单贝叶斯法是一种性能稳定的学习算法 , 由于算法本身利用 的是训练样本的统计信息 , 因此对训练样本集小的变动基本不会影响贝叶斯分类器的预测精度 。对于 性能稳定的监督学习算法 , 其分类精度难以提高 。如何提高简单贝叶斯法的泛化能力值得研究者的关 注[3 ,8 ] 。