数据挖掘基础算法在MapReduce中的实现

mapreduce基础编程

mapreduce基础编程MapReduce是一种用于大规模数据处理的编程模型和软件框架。

它可以将大数据集分成多个小数据集,并通过多个计算节点并行处理,最后汇总处理结果。

MapReduce将数据处理过程分成两个阶段:Map阶段和Reduce阶段。

在Map阶段中,数据被分成多个小数据集,每个小数据集上运行相同的计算任务,然后产生中间结果。

在Reduce阶段中,中间结果被合并,最终产生处理结果。

MapReduce的基础编程模型可以分为以下几个步骤:1. 输入数据的读取:输入数据可以来自于Hadoop Distributed File System (HDFS)、本地文件系统或其他数据源。

2. Map阶段的编写:开发者需要编写Map函数,该函数将输入数据切分成多个小数据集,并在每个小数据集上运行相同的计算任务,生成中间结果。

Map函数的输出通常是一个键值对(key-value pair),其中键表示中间结果的类型,值表示中间结果的值。

3. Reduce阶段的编写:开发者需要编写Reduce函数,该函数将中间结果根据键值进行合并,生成最终的处理结果。

Reduce函数的输出通常是一个键值对(key-value pair),其中键表示最终处理结果的类型,值表示最终处理结果的值。

4. 输出数据的写入:最终处理结果可以写入到HDFS或其他数据源中。

MapReduce程序的开发需要掌握Java或其他编程语言。

除了基础编程模型外,还需要了解MapReduce的一些高级编程技术,如Combiner、Partitioner、InputFormat、OutputFormat等。

通过这些技术,可以进一步提高MapReduce程序的性能和可扩展性。

总之,MapReduce是一种强大的大数据处理工具,掌握基础编程模型是进行大数据分析和处理的必要条件。

基于MapReduce的海量数据挖掘技术研究

行 运 算 。将 Ma p R e d u c e )  ̄用在 数据 挖掘 的三 个算 法 中 : 朴 素 贝叶斯 分 类算 法 、 K - mo d e s 聚类 算 法和 E C L A T频繁 项 集挖掘 算法 。 实验 结 果表 明 , 在 保证 算 法准确 率 的前提 下 , Ma p R e d u c e 可 以有 效提 高海量 数据 挖掘 工作 的效率 。 关键 词 : 云计 算 ; 数据 挖掘 ; , H a d o o p ; Ma p R e d u c e

C o m p u t e r E n g i n e e r i n g a n d A p p l i c a t i o n s 计算 机 工程 与应 用

基于 Ma p Re d u c e 的海 量 数 据 挖 掘 技术 研 究

李伟 卫 , 赵 航 , 张 阳 , 王 勇 。

LI We i we i , ZHAO Ha ng , ZHANG Ya ng ,e t a 1 . Re s e a r c h o n ma s s i v e d a t a mi n i n g b a s e d o n Ma p Re d u c e .Co mp u t e r En g i -

3 . 西北 工业 大学 计 算机 学院 , 西安 7 1 0 0 7 2

1 . Co l l e g e o f I n f o r ma t i o n En g i n e e r i n g , No r t h we s t A&F Un i v e r s i t y , Ya n g l i n g , S h a a n xi 7 1 2 1 0 0 , Ch i n a 2 . S c h o o l o fM e c h a n o — El e c t r o n i c En g i n e e r i n g , Xi d i a nUn i v e r s i t y , Xi ’ a n 7 1 0 0 7 2 , Ch i n a 3 . S c h o o l o fCo mp u t e r , No th r we s t e n r P o l y t e c h n i c a l Un i v e r s i t y , Xi ’ a n 7 1 0 0 7 2 . Ch i n a

mapreduce实现reduce过程的方法

在Java中,使用MapReduce框架实现reduce过程的方法如下:1. 首先,创建一个实现`Reducer`接口的类。

这个类需要重写`reduce()`方法,该方法接收两个参数:一个是键(key),另一个是值(value)列表。

```javaimport java.io.IOException;import java.util.Iterator;import org.apache.hadoop.io.IntWritable;import org.apache.hadoop.io.Text;import org.apache.hadoop.mapreduce.Reducer;public class MyReducer extends Reducer<Text, IntWritable, Text, IntWritable> { private IntWritable result = new IntWritable();@Overrideprotected void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {int sum = 0;for (IntWritable val : values) {sum += val.get();}result.set(sum);context.write(key, result);}}```2. 然后,在主程序中配置和运行MapReduce作业。

首先,创建一个`Job`对象,并设置其相关属性,如输入输出格式、Mapper类和Reducer类等。

最后,调用`job.waitForCompletion(true)`等待作业完成。

```javaimport org.apache.hadoop.conf.Configuration;import org.apache.hadoop.fs.Path;import org.apache.hadoop.io.IntWritable;import org.apache.hadoop.io.Text;import org.apache.hadoop.mapreduce.Job;import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;public class Main {public static void main(String[] args) throws Exception {Configuration conf = new Configuration();Job job = Job.getInstance(conf, "my mapreduce job");job.setJarByClass(Main.class);job.setMapperClass(MyMapper.class);job.setCombinerClass(MyReducer.class);job.setReducerClass(MyReducer.class);job.setOutputKeyClass(Text.class);job.setOutputValueClass(IntWritable.class);FileInputFormat.addInputPath(job, new Path(args[0]));FileOutputFormat.setOutputPath(job, new Path(args[1]));System.exit(job.waitForCompletion(true) ? 0 : 1);}}```这样,就实现了使用MapReduce框架在Java中实现reduce过程的方法。

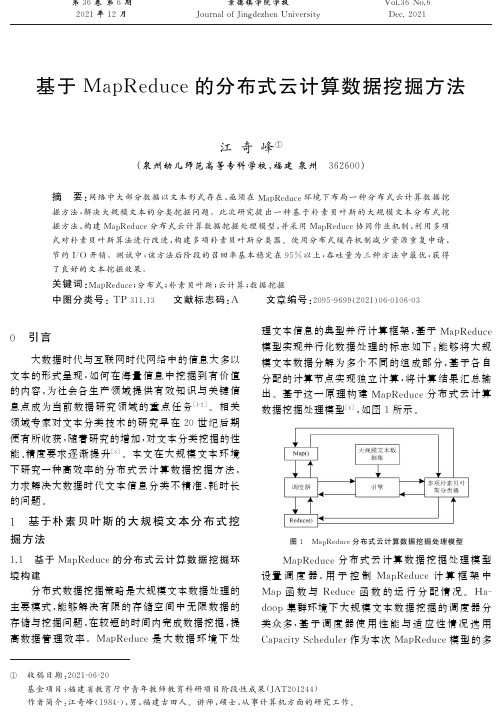

基于MapReduce的分布式云计算数据挖掘方法

[

5]

前人的诸多研究结果显示多项式模型的分类结

果优于一般模型的 分 类 结 果,能 够 更 加 精 准 地 实 现

分布式云 计 算 数 据 挖 掘 模 型 调 度 器 任 务 执 行 过 程

数据的计算与分类,因 此 对 朴 素 贝 叶 斯 进 行 优 化 得

中,大规模文本数据 被 划 分 成 分 片 数 据 后 由 调 度 器

领域专家对文本分 类 技 术 的 研 究 早 在 20 世 纪 后 期

便有所收获,随着研究的增加,对文本分类挖掘的性

能、精度要求 逐 渐 提 升 [3]。本 文 在 大 规 模 文 本 环 境

下研究一种高效率 的 分 布 式 云 计 算 数 据 挖 掘 方 法,

力求解决大数据时 代 文 本 信 息 分 类 不 精 准、耗 时 长

的时间开销 虽 然 稳 定,但 是 其 平 均 用 时 较 大,约 为

130s。综上可知,本 文 方 法 的 吞 吐 量 在 三 种 方 案 中

优势突出。

3 结论

图 2 三种文本挖掘方法的效果对比

图 2 数据显示,本 文 方 法 与 基 于 k

me

ans 的 文

本数据挖掘方法的起始召回 率 在 80% 左 右,基 于 朴

06

0106

03

理文本信息的典型 并 行 计 算 框 架,基 于 MapReduc

e

模型实现并行化数 据 处 理 的 标 志 如 下:能 够 将 大 规

大数据时代与互联网时代网络中的信息大多以

模文本数据分解为 多 个 不 同 的 组 成 部 分,基 于 各 自

文本的形式呈现,如 何 在 海 量 信 息 中 挖 掘 到 有 价 值

基于分布式数据挖掘方法的研究与应用

基于分布式数据挖掘方法的研究与应用

汪丽;张露

【期刊名称】《武汉理工大学学报(信息与管理工程版)》

【年(卷),期】2013(035)001

【摘要】针对关联规则Apriori算法多次重复扫描数据库和产生大量候选频繁项集的缺点,对其进行改进,并在MapReduce模型上得以实现.改进的Apriori算法只需要对整个数据库扫描一次,即可得到所有频繁项集的集合.仿真实验结果表明,随着节点数目的增多,改进算法比原算法执行时间要短,并且这种优势随着节点数目的增加而扩大,说明在异构集群环境下,MapReduce模型的Apriori算法能够提高关联规则挖掘的执行效率.将改进的分布式关联规则算法在分布式教育决策支持系统中应用,通过对实际数据的挖掘,证明了该方法对教育决策的有效性.

【总页数】4页(P40-43)

【作者】汪丽;张露

【作者单位】武汉理工大学统战部,湖北武汉430070;武汉理工大学计算机科学与技术学院,湖北武汉430070

【正文语种】中文

【中图分类】TP311.13

【相关文献】

1.分布式数据挖掘中基于扰乱的隐私保护方法 [J], 马进;李锋;李建华

2.基于过程方法的风险识别及管控方法研究与应用 [J], 许多;李庆军;龙敏浩;颜楚

强;钟智祎

3.基于高性能云的分布式数据挖掘方法 [J], 桂兵祥;何健

4.基于群体智能的分布式数据挖掘方法 [J], 刘波;潘久辉

5.基于降水要素分析方法的辽宁省汛期分期特征方法研究与应用 [J], 徐飞

因版权原因,仅展示原文概要,查看原文内容请购买。

基于人工智能技术的大数据分析方法研究进展

SOFTWARE 软 件2021第42卷 第11期2021年Vol. 42, No.110 引言大数据由于具备样本海量化、数据非结构化和实时性等常规调查数据难以达到的效果,被广泛应用在各个领域当中,是当下人类社会发展过程中最主要的资源,极有必要对其分析方法进行创新研究。

而围绕人工智能技术开展的大数据分析其本质目的是想要在有限的时间当中找到信息之间存在的关联价值,从中掌握一些具体的具有隐含性的信息内容,并由此制定出详细计划进行决策。

其中最典型的分析方法主要有机器学习、计算智能、深度学习等,所以在研究分析时则应从这几方面着手开展。

1 常见的分析方法1.1机器学习(1)聚类。

它能直接把对象分成多个不同组,从而进行高效准确的数据挖掘等。

大数据信息基本都是包含所有领域的,因此这就不能将常规聚类计算应用进去,所以有学者提出了映射和规约相互结合的编程形式。

这样一来,不但能促进常规聚类算法并行运算,还能提升计算本身的便捷性,高效化促进大数据信息集合与分类。

在此基础上,有学者进一步创新了聚类算法,比如通过分布式系统基础构架达到了“K-means”聚类算法,也有通过“MapReduce”编程框架进行了凝聚式层次聚类分析,给重要文件信息的传输带来了良好的保密效果,同时也促进了传输效率提升[1]。

另外,密度计算下的聚类方式,不仅能进一步开展数据预处理,还能找到需要实时整合信息,使其达到集中化处理的效果。

未来,在大数据传输和存储要求不断提升下,还需要对聚类算法进行更进一步创新。

作者简介:冯延龙,男,陕西榆林人,本科,研究方向:大数据。

基于人工智能技术的大数据分析方法研究进展冯延龙(陕西服装工程学院,陕西西安 712064)摘 要:受信息技术迅速发展的影响,围绕人工智能技术产生的大数据分析方法开始被广泛应用在各个领域中。

目前,该方法研究已经获得了一定成就,不但实现了大数据聚类、分类、关联分析以及预测几项挖掘任务,还在�Spark� 等平台上实现了分布式深化学习,促使数据挖掘效率得到了有效提升。

综采工作面海量数据挖掘分析平台设计

综采工作面海量数据挖掘分析平台设计王宏伟1, 杨焜1,2, 付翔1,2, 李进1,3, 贾思锋1,2(1. 太原理工大学 山西省煤矿智能装备工程研究中心,山西 太原 030024;2. 太原理工大学 矿业工程学院,山西 太原 030024;3. 太原理工大学 机械与运载工程学院,山西 太原 030024)摘要:当前综采工作面海量数据采集的实时性和完整性差、异常数据清洗耗时大、数据挖掘时延大,导致综采数据利用率低,无法辅助管理层实时下发决策指令。

针对上述问题,设计了一种综采工作面海量数据挖掘分析平台。

该平台由数据源层、数据采集存储层、数据挖掘层和前端应用层组成。

数据源层由工作面各类硬件设备提供原始数据;数据采集存储层使用OPC UA 网关实时采集井下传感器监测信息,再通过MQTT 协议和RESTful 接口将数据存入InfluxDB 存储引擎;数据挖掘层利用Hive 数据引擎和Yarn 资源管理器筛选数据采集过程中受工作现场干扰形成的异常数据,解决因网络延时导致的数据局部采集顺序紊乱问题,并利用Spark 分布式挖掘引擎挖掘工作面设备群海量工况数据的潜在价值,提高数据挖掘模型的运行速度;前端应用层利用可视化组件与后端数据库关联,再通过AJAX 技术与后端数据实时交互,实现模型挖掘结果和各类监测数据的可视化展示。

测试结果表明,该平台能够充分保证数据采集的实时性与完整性,清洗效率较单机MySQL 查询引擎提升5倍,挖掘效率较单机Python 挖掘引擎提升4倍。

关键词:综采工作面;海量数据;数据挖掘;数据采集;数据存储;数据清洗;数据可视化中图分类号:TD67 文献标志码:AMassive data mining and analysis platform design for fully mechanized working faceWANG Hongwei 1, YANG Kun 1,2, FU Xiang 1,2, LI Jin 1,3, JIA Sifeng 1,2(1. Center of Shanxi Engineering Research for Coal Mine Intelligent Equipment, Taiyuan University of Technology,Taiyuan 030024, China ; 2. College of Mining Engineering, Taiyuan University of Technology, Taiyuan 030024,China ; 3. College of Mechanical and Vehicle Engineering, Taiyuan University of Technology, Taiyuan 030024, China)Abstract : The current real-time and integrity of massive data acquisition in fully mechanized working faces are poor. The abnormal data cleaning takes a long time. The data mining delays are large. This leads to low utilization rate of fully mechanized working data and incapability to assist management in issuing decision-making instructions in real-time. In order to solve the above problems, a massive data mining and analysis platform for fully mechanized working faces is designed. The platform consists of a data source layer, a data acquisition and storage layer, a data mining layer, and a front-end application layer. The data source layer is provided with raw data by various hardware devices on the working surface. The data acquisition and storage layer uses the OPC UA gateway to collect real-time monitoring information from underground sensors, and then stores the data in the InfluxDB storage engine through the MQTT protocol and RESTful interface. The data收稿日期:2023-03-20;修回日期:2023-05-21;责任编辑:盛男。

大数据分析原理和应用_中央财经大学中国大学mooc课后章节答案期末考试题库2023年

大数据分析原理和应用_中央财经大学中国大学mooc课后章节答案期末考试题库2023年1.大数据的起源是()。

答案:互联网2.下列关于计算机存储容量单位的说法中,错误的是()。

答案:一个汉字需要一个字节的存储空间3.过一系列处理,在基本保持原始数据完整性的基础上,减小数据规模的是()。

答案:数据规约4.将原始数据进行集成、变换、维度规约、数值规约是在以下哪个步骤的任务?( )答案:数据预处理5.可用作数据挖掘分析中的关联规则算法有()。

Apriori算法、FP-Tree算法6.采用客户端读取HDFS存储的数据时,以下哪种描述是正确的?()答案:编程接口提供了隔离性,让用户无需深入了解HDFS便可以进行文件数据读写7.以下关于HDFS特点的描述错误的是()答案:只能有一个NameNode8.以下不是分布式文件系统的是()FAT9.以下哪个负责HDFS的数据存储()答案:DataNode10.以下关于SecondaryNameNode的描述,哪项是正确的?()答案:它的目的是帮助NameNode合并编辑日志,减少NameNode的启动时间11.以下哪个不属于NameNode的功能?()答案:保存文件块并汇报文件块信息12.Shuffle步骤在Map进行到哪一步时,就可以开始执行?()答案:至少有一个Map任务开始有输出13.下面关于MapReduce模型中Map函数与Reduce函数的描述正确的是()。

答案:一个Map函数就是对一部分原始数据进行指定的操作。

14.下列关于网络用户行为的说法中,错误的是()。

答案:数字轨迹用完即自动删除15.以下哪个和NameNode在同一个节点启动?()答案:JobTracker16.用4个V 来描述大数据的四个基本特征,这4V 是()。

答案:速度快产生价值体量大多样性17. HDFS的NameNode中,存储的有关核心数据包括()答案:文件系统树文件操作日志18.客户端上传文件时哪项正确?()答案:当某个DataNode失败,客户端会继续传给其他DataNode客户端将文件以block为单位,管道方式依次传到DataNode19.关于数据并行化,以下说法正确的是()答案:数据并行需要输入数据能够被切分成独立的若干块,可以分别处理不是所有数据都可以用数据平行的方法处理20.有人改进了MapReduce的架构,Map函数的输出不写入本地磁盘,而是直接(通过网络)传递给Reduce任务,reduce任务收到所有Map的输入后,再开始Reduce的处理。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

矿产资源开发利用方案编写内容要求及审查大纲

矿产资源开发利用方案编写内容要求及《矿产资源开发利用方案》审查大纲一、概述

㈠矿区位置、隶属关系和企业性质。

如为改扩建矿山, 应说明矿山现状、

特点及存在的主要问题。

㈡编制依据

(1简述项目前期工作进展情况及与有关方面对项目的意向性协议情况。

(2 列出开发利用方案编制所依据的主要基础性资料的名称。

如经储量管理部门认定的矿区地质勘探报告、选矿试验报告、加工利用试验报告、工程地质初评资料、矿区水文资料和供水资料等。

对改、扩建矿山应有生产实际资料, 如矿山总平面现状图、矿床开拓系统图、采场现状图和主要采选设备清单等。

二、矿产品需求现状和预测

㈠该矿产在国内需求情况和市场供应情况

1、矿产品现状及加工利用趋向。

2、国内近、远期的需求量及主要销向预测。

㈡产品价格分析

1、国内矿产品价格现状。

2、矿产品价格稳定性及变化趋势。

三、矿产资源概况

㈠矿区总体概况

1、矿区总体规划情况。

2、矿区矿产资源概况。

3、该设计与矿区总体开发的关系。

㈡该设计项目的资源概况

1、矿床地质及构造特征。

2、矿床开采技术条件及水文地质条件。