Migration of servers to Proxmox VE - Proxmox VE

ProxmoxVE(PVE)安装黑群晖DS918

ProxmoxVE(PVE)安装⿊群晖DS918【前⾔】本教程基于Proxmox VE(PVE)7.0虚拟机环境下安装⿊群晖DS918-7.01,因此对硬件的要求如下:1、CPU要求(如果CPU不满⾜要求,建议安装DS3615-7.01,安装DS3615-7.01的步骤和安装DS918-7.01的步骤⼤致⼀样,只是使⽤不同引导和不同安装包的区别。

)(1)⾄少要⽤第四代Intel酷睿处理器、或者同等级别的奔腾处理器、或者同等级别的赛扬处理器,⽐如:Intel i5-4430、J3455、N3160;(2)⾄强的处理器,要求是v3或者以上级别,⽐如:Intel Xeon E3-1230 v3;(3)如果是AMD,要求是锐龙3或者以上级别,⽐如:Ryzen 3 - 2200G;2、⽹卡要求(1)如果是⽤⽹卡直通的,要求使⽤Intel品牌的⽹卡;(2)⾮直通⽹卡要求⽀持E1000e,如果你的PVE不⽀持E1000e⽹卡类型,请先按照【给ProxmoxVE (PVE)的⽹络模型添加E1000e⽹卡,让你的DSM⽀持最新版本】教程添加E1000e;(3)截⽌2021年9⽉26⽇,使⽤RedPill项⽬开发组开源代码编译的DSM7.X引导,暂时不⽀持万兆物理⽹卡,建议采⽤千兆⽹卡(直通模式)或者E1000e虚拟⽹卡(⾮直通模式)。

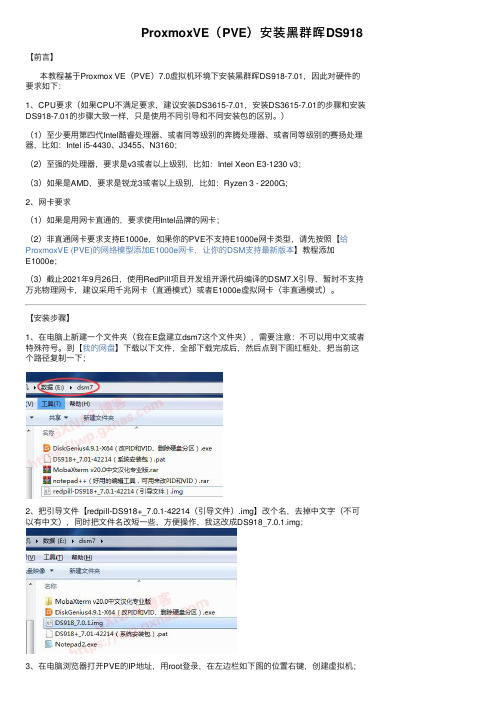

【安装步骤】1、在电脑上新建⼀个⽂件夹(我在E盘建⽴dsm7这个⽂件夹),需要注意:不可以⽤中⽂或者特殊符号。

到【我的⽹盘】下载以下⽂件,全部下载完成后,然后点到下图红框处,把当前这个路径复制⼀下;2、把引导⽂件【redpill-DS918+_7.0.1-42214(引导⽂件).img】改个名,去掉中⽂字(不可以有中⽂),同时把⽂件名改短⼀些,⽅便操作,我这改成DS918_7.0.1.img;3、在电脑浏览器打开PVE的IP地址,⽤root登录,在左边栏如下图的位置右键,创建虚拟机;4、填写虚拟机名称,VM ID这个数字⾃动⽣成不⽤更改,但是需要记住这个数字,后⾯需要⽤到;5、不使⽤任何介质,下⼀步;6、下⼀步;7、在“总结/设备”点⼀下,选“SATA”;8、磁盘⼤⼩先写⼀个“1”,临时的设置,等下会删除;9、单CPU的“插槽”写“1”(双路写2)、核⼼则根据⾃⼰使⽤的CPU真实核⼼数量填写(给群晖分配的CPU核⼼数量,不可以超过实际CPU核⼼数量),类别选“host”(使⽤⾄强v3或者以上的CPU如果⽤host启动后找不到IP地址,请改回“默认”),下⼀步;10、内存根据实际情况分配,我分配的是4096MB,下⼀步;⽹络模型添加E1000e⽹卡,让你的DSM⽀持最新版本》教程⾃⾏添加),下⼀步;12、完成;13、找到刚刚建⽴的虚拟机,选中前⾯临时建⽴那个1G的磁盘(sata0),选菜单上的“分离”;14、是;15、选中分离出来的这个“未使⽤的磁盘0”,点菜单上的“删除”;16、是;17、选中BIOS,编辑;18、改成“OVMF(UEFI)”;19、OK;20、选中“机器”,编辑;21、改成q35,OK;22、打开DiskGenius软件,点菜单上的“硬盘”—“打开虚拟硬盘⽂件”;23、进⼊第1步建⽴的⽂件夹,找到DS918_7.0.1.img⽂件,打开;24、在左边栏中点+,点grub⽂件夹,在右边找到grub.cfg⽂件,在此⽂件上点⿏标右键,弹出的菜单中选择“复制到指定的⽂件夹”;25、在⽂件夹处点⼀下,把在第1步建⽴的路径粘贴进去,确定;26、完成;27、⽤Notepad2打开grub.cfg⽂件,在菜单上的“查看”,找到⾃动换⾏,点⼀下;28、向下翻页到第58⾏和第68⾏,先找到下图圈出蓝⾊字,根据实际情况修改(58⾏和68⾏都要改),改好了就保存⽂件,关闭Notepad2;(1)netif_num=1:⽹⼝数量,默认为1,如果你要给虚拟机添加两个⽹⼝的,请改成netif_num=2;(2)mac1=001132123456:默认只填写了⼀个⽹⼝的mac地址,如果给虚拟机添加两个⽹⼝的,需要在mac1的后⾯添加了⼀个mac2=001132123466(两个mac值不可以⼀样);如果你有真实的洗⽩码,可以替换成洗⽩码mac的值;(3)sn=2021PDN123456:默认的序列号,如果你有真实的洗⽩码,可以替换成洗⽩码sn的值;(4)虚拟机安装,不需要改VID和PID。

服务器虚拟化技术OpenStackvsProxmoxVE

服务器虚拟化技术OpenStackvsProxmoxVE 随着云计算的快速发展,服务器虚拟化技术成为了企业管理和运维中不可忽视的一部分。

其中,OpenStack和Proxmox VE是两种备受关注的虚拟化平台。

本文将对它们进行比较和分析,帮助读者更好地了解它们的优势和适用场景。

一、OpenStack简介OpenStack是一个用于构建和管理云计算平台的开源软件,它提供了一系列的组件,用于实现云计算中的虚拟化、网络、存储等功能。

OpenStack旨在提供弹性、可扩展、安全的云计算解决方案,被广泛应用于公共云、私有云和混合云环境。

1.1 OpenStack的特点OpenStack具有以下特点:1. 开源:OpenStack是开源软件,允许用户自由访问和修改代码,满足个性化需求。

2. 弹性扩展:OpenStack采用分布式架构,可以根据需求自由扩展计算、存储和网络资源。

3. 多租户支持:OpenStack能够实现多个租户共享同一套基础设施,提高资源利用率。

4. 健壮可靠:OpenStack具备高可用性和自动化管理能力,能够保证云计算平台的稳定运行。

5. 多样化的组件:OpenStack提供了丰富的组件,如Nova、Neutron、Cinder等,可根据需求选择和定制。

1.2 OpenStack的组件OpenStack包含多个重要组件,如下所示:1. Nova:用于管理和调度计算资源,提供虚拟机实例的创建、调整和销毁等功能。

2. Neutron:用于管理网络资源,提供虚拟网络的创建、隔离和连接等功能。

3. Cinder:用于管理存储资源,提供块存储服务,支持虚拟机实例的持久化存储。

4. Glance:用于管理镜像资源,提供镜像的上传、下载和共享等功能。

5. Keystone:用于身份认证和访问控制,提供用户和角色管理、认证服务等功能。

二、Proxmox VE简介Proxmox VE(Virtual Environment)是一款基于开源的服务器虚拟化平台,提供了虚拟化和容器两种虚拟化技术。

Proxmox5.4中文手册

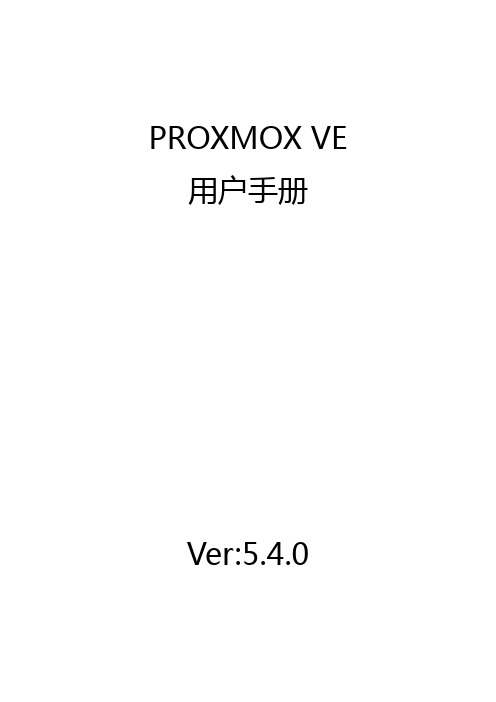

PROXMOX VE 用户手册Ver:5.4.0编辑记录翻译版本贡献人完成时间对应英文版本V1.0潶眼镜2017-02-16V4.4December9,2016 V1.01Tinkering2017-06-13V4.4December9,2016 V5.2.0潶眼镜2019-02-20V5.2May16,2018V5.3.0潶眼镜2019-06-03V5.3November29,2018 V5.4.0潶眼镜2019-06-18V5.4April8,2019目录第1章简介 (1)1.1集中管理 (1)1.2支持多种存储类型 (3)1.3虚拟机备份与恢复 (3)1.4高可用集群 (4)1.5支持多种虚拟网络技术 (4)1.6内嵌防火墙 (4)1.7开源的原因 (4)1.8Proxmox VE的优势 (4)1.9获取支持 (5)1.9.1Proxmox VE Wiki (5)1.9.2社区支持论坛 (5)1.9.3电子邮件列表 (5)1.9.4商业支持 (5)1.9.5Bug提交及跟踪 (6)1.10项目历程 (6)1.11参与完善Proxmox VE文档 (6)第2章Proxmox VE安装 (8)2.1系统安装需求 (8)2.1.1最小硬件配置,适用于测试评估场景 (8)2.1.2推荐系统硬件配置 (9)2.1.3性能概览 (9)2.1.4Web管理界面支持的浏览器 (9)2.2使用官方ISO光盘镜像安装Proxmox VE (10)2.2.1LVM高级配置 (15)2.2.2ZFS高级配置参数 (16)2.2.3ZFS性能提示 (16)2.3用U盘安装Proxmox VE (17)2.3.1制作U盘安装介质 (17)2.3.2GNU/Linux下的制作过程 (17)2.3.3OSX下的制作过程 (18)2.3.4Windows下的制作过程 (18)2.4.5用U盘引导启动服务器 (19)2.3在Debian系统上安装Proxmox VE (19)第3章Proxmox VE服务器管理 (20)3.1软件源 (20)3.1.1Proxmox VE企业版软件源 (20)3.1.2Proxmox VE免费版软件源 (21)3.1.3Proxmox VE测试版软件源 (21)3.1.4Proxmox VE Ceph软件源 (22)3.1.5Proxmox VE Ceph测试软件源 (22)3.1.6SecureApt (22)3.2系统软件升级 (23)3.3网络配置 (23)3.3.1命名规范 (23)3.3.2网络配置规划 (24)3.3.3基于网桥的默认配置 (25)3.3.4路由配置 (26)3.3.5基于iptables的网络地址转换配置(NAT) (27)3.3.6Linux多网口绑定 (28)3.3.7VLAN802.1Q (31)3.4时钟同步 (33)3.4.1使用自定义NPT服务器 (33)3.5外部监控服务器 (34)3.5.1配置Graphite服务器 (34)3.5.2配置Influxdb插件 (35)3.6硬盘健康状态监控 (35)3.7逻辑卷管理器(LVM) (36)3.7.1硬件 (36)3.7.2启动引导程序 (37)3.7.3创建卷组 (37)3.7.4为/var/lib/vz添加LV (37)3.7.5调整thin pool的容量 (38)3.7.6创建LVM-thin存储池 (38)3.8Linux上的ZFS (38)3.8.1硬件 (39)3.8.2用于根文件系统 (39)3.8.3系统启动程序 (41)3.8.4ZFS管理 (41)3.8.5使用邮件通知 (43)3.8.6配置ZFS内存使用上限 (43)3.9证书管理 (44)3.9.1集群通信认证 (44)3.9.2认证API和Web GUI界面 (44)第4章超融合基础设施 (48)4.1Proxmox VE超融合基础设施的优势 (48)4.2基于Proxmox VE的Ceph服务 (48)4.2.1前置条件 (50)4.2.2初始化Ceph安装和配置 (51)4.2.3安装Ceph (53)4.2.4初始化Ceph (53)4.2.5创建Ceph Monitor (54)4.2.6创建Ceph Manager (54)4.2.7创建Ceph OSD (55)4.2.8创建Ceph Pool (57)4.2.9Ceph CRUSH和设备类别 (58)4.2.10Ceph客户端 (59)4.2.11CephFS (60)4.2.12Ceph监控和故障排查 (61)第5章图形用户界面 (63)5.1功能 (63)5.2登录 (64)5.3GUI概览 (64)5.3.1标题栏 (65)5.3.2我的设置 (66)5.3.3资源树 (66)5.3.4日志面板 (67)5.4内容面板 (67)5.4.1数据中心 (68)5.4.2节点 (69)5.4.3客户机 (70)5.4.4存储 (72)5.4.5资源池 (73)第6章集群管理工具 (74)6.1部署要求 (74)6.2节点服务器准备 (75)6.3创建集群 (75)6.3.1同一网络内创建多个集群 (76)6.4新增集群节点 (76)6.4.1添加位于不同网段的节点 (77)6.5删除节点 (77)6.5.1隔离节点 (79)6.6多数票 (80)6.7集群网络 (81)6.7.1集群网络配置要求 (81)6.7.2独立集群网络 (81)6.7.3冗余环协议 (85)6.7.4创建集群时配置RRP (85)6.7.5创建集群后配置RRP (85)6.8外部Corosync投票节点 (86)6.8.1QDevice技术概览 (87)6.8.2部署方式 (87)6.8.3安装QDevice-Net (88)6.8.4常见问题 (88)6.9配置Corosync (89)6.9.1编辑corosync.conf (89)6.9.2故障排查 (90)6.9.3Corosync参数说明 (90)6.10集群冷启动 (91)6.11虚拟机迁移 (91)6.11.1迁移类型 (91)6.11.2专用迁移网络 (92)第7章Proxmox集群文件系统(pmxcfs) (94)7.1POSIX兼容性 (94)7.2文件访问权限 (94)7.3技术 (95)7.4文件系统布局 (95)7.4.1文件 (95)7.4.2符号链接 (96)7.4.3用于调试的特殊状态文件(JSON) (96)7.4.4启用/禁用调试 (97)7.5文件系统恢复 (97)7.5.1删除集群配置 (97)7.5.2从故障节点恢复/迁移虚拟机 (97)第8章Proxmox VE存储 (99)8.1存储类型 (99)8.1.1薄模式存储 (100)8.2存储配置 (100)8.2.1存储池 (101)8.2.2公共存储服务属性 (101)8.3存储卷 (102)8.3.1存储卷从属关系 (103)8.4命令行界面使用方法 (103)8.4.1示例 (103)8.5基于目录的后端存储 (104)8.5.1配置方法 (105)8.5.2文件命名规范 (105)8.5.3存储功能 (106)8.5.4示例 (107)8.6基于NFS的后端存储 (107)8.6.1配置方法 (107)8.6.2存储功能 (108)8.6.3示例 (108)8.7基于CIFS的后端存储 (109)8.7.1配置方法 (109)8.7.2存储功能 (110)8.7.3示例 (110)8.8基于GlusterFS的后端存储 (110)8.8.1配置方法 (111)8.8.2文件命名规范 (111)8.8.3存储功能 (111)8.9基于本地ZFS的后端存储 (112)8.9.1配置方法 (112)8.9.2文件命名规范 (112)8.9.3存储功能 (113)8.9.4示例 (113)8.10基于LVM的后端存储 (113)8.10.1配置方法 (113)8.10.2文件命名规范 (114)8.10.3存储功能 (114)8.10.4示例 (114)8.11基于LVM-thin的后端存储 (115)8.11.1配置方法 (115)8.11.2文件命名规范 (115)8.11.3存储功能 (115)8.11.4示例 (116)8.12基于Open-iSCSI的后端存储 (116)8.12.1配置方法 (116)8.12.2文件命名规范 (117)8.12.3存储功能 (117)8.12.4示例 (117)8.13基于用户空间iSCSI的后端存储 (117)8.13.1配置方法 (118)8.13.2存储功能 (118)8.14基于Ceph RADOS块设备的后端存储 (118)8.14.1配置方法 (119)8.14.2认证方式 (120)8.14.3存储功能 (120)8.15基于Ceph文件系统(CephFS)的后端存储 (120)8.15.1配置方法 (121)8.15.2认证方式 (121)8.15.3存储功能 (122)第9章存储复制 (123)9.1支持的存储类型 (123)9.2调度格式 (124)9.2.1配置说明 (124)9.2.2示例 (125)9.3错误处理 (126)9.3.1可能发生的故障 (126)9.3.2虚拟机故障转移 (126)9.3.3示例 (126)9.4调度任务管理 (127)第10章Qemu/KVM虚拟机 (129)10.1虚拟化硬件和半虚拟化硬件 (129)10.2虚拟机配置 (130)10.2.1通用配置 (130)10.2.2操作系统配置 (131)10.2.3系统设置 (131)10.2.4硬盘 (132)10.2.5CPU (134)10.2.6内存 (138)10.2.7网卡 (139)10.2.8显示器 (140)10.2.9USB直通 (141)10.2.10BIOS和UEFI (141)10.2.11内部虚拟机共享内存 (142)10.2.12虚拟机自启动和自关闭 (142)10.3虚拟机迁移 (143)10.3.1在线迁移 (144)10.3.2离线迁移 (144)10.4复制与克隆 (145)10.5虚拟机模板 (146)10.6虚拟机生成ID (146)10.7虚拟机和磁盘镜像导入 (146)10.7.1Windows OVF导入步骤示例 (147)10.7.2向虚拟机增加外部磁盘镜像 (147)10.8Cloud-Init支持 (148)10.8.1准备Cloud-Init镜像 (148)10.8.2部署Cloud-Init模板 (150)10.8.3Cloud-Init参数 (150)10.9PCI(e)直通 (151)10.9.1通用要求 (152)10.9.2主机设备直通 (153)10.9.3SR-IOV (154)10.9.4中介设备(vGPU,GVT-g) (155)10.9.5回调脚本 (156)10.10虚拟机管理命令qm (156)10.10.1命令行示例 (156)10.11虚拟机配置文件 (156)10.11.1配置文件格式 (157)10.11.2虚拟机快照 (157)10.11.3虚拟机配置项目 (158)10.12锁 (177)第11章Proxmox容器管理工具 (178)11.1技术概览 (178)11.3用户操作系统配置 (179)11.4容器镜像 (180)11.5容器存储 (181)11.5.1FUSE挂载 (182)11.5.2容器内设置存储配额 (182)11.5.3容器内设置访问控制列表 (182)11.5.4备份容器挂载点 (183)11.5.5复制容器挂载点 (183)11.6容器设置项 (183)11.6.1通用设置项 (183)11.6.2CPU (185)11.6.3内存 (186)11.6.4挂载点 (186)11.6.5网络 (189)11.6.6容器的自启动和自关闭 (190)11.6.7回调脚本 (191)11.7备份和恢复 (191)11.7.1容器备份 (191)11.7.2容器备份恢复 (191)11.8使用pct管理容器 (192)11.8.1命令行示例 (192)11.8.2获取调试日志 (193)11.9迁移 (193)11.10容器配置文件 (194)11.10.1配置文件格式 (194)11.10.2快照 (194)11.10.3参数项 (195)11.11锁 (199)第12章Proxmox VE防火墙 (200)12.1区域 (200)12.2配置文件 (200)12.2.1集群级别的防火墙配置 (200)12.2.2主机级别的防火墙配置 (202)12.2.3虚拟机和容器级别的防火墙配置 (203)12.3防火墙策略 (204)12.4安全组 (205)12.5IP地址别名 (205)12.5.1标准IP地址别名local_network (205)12.6IP地址集合 (206)12.6.1标准IP地址集合management (206)12.6.2标准IP地址集合blacklist (206)12.6.3标准IP地址集合ipfilter-net* (206)12.7服务及管理命令 (207)12.8.1进/出数据中心的丢弃/拒绝策略 (207)12.8.2进/出客户机的丢弃/拒绝策略 (208)12.9防火墙日志记录 (209)12.9.1用户自定义防火墙策略日志记录 (209)12.10提示和窍门 (210)12.10.1如何开放FTP (210)12.10.2集成Suricata IPS (210)12.11IPv6注意事项 (210)12.12Proxmox VE端口列表 (211)第13章用户管理 (212)13.1用户 (212)13.1.1系统管理员 (212)13.1.2组 (212)13.2认证域 (213)13.3双因子认证 (214)13.3.1强制双因子认证域 (214)13.3.2用户自定义TOTP认证 (214)13.3.3服务器端U2F配置 (215)13.3.4激活用户U2F认证 (216)13.4权限管理 (216)13.4.1角色 (216)13.4.2权限 (217)13.4.3对象和路径 (219)13.4.4资源池 (219)13.4.5我究竟需要哪些权限? (220)13.5命令行工具 (220)13.6实际应用示例 (221)13.6.1管理员组 (221)13.6.2审计员 (221)13.6.3分配用户管理权限 (221)13.6.4资源池 (222)第14章高可用性 (223)14.1部署条件 (224)14.2资源 (225)14.3管理任务 (225)14.4工作原理 (226)14.4.1资源状态 (226)14.4.2本地资源管理器 (227)14.4.3集群资源管理器 (228)14.5配置步骤 (229)14.5.1资源 (229)14.5.2组 (231)14.6隔离 (233)14.6.1Proxmox VE的隔离措施 (233)14.6.2硬件看门狗配置 (233)14.6.3恢复被隔离的服务 (234)14.7启动失败策略 (234)14.8错误恢复 (235)14.9软件包升级 (235)14.10节点维护 (235)14.10.1关机 (235)14.10.2重启 (236)14.10.3手工迁移资源 (236)第15章备份与恢复 (237)15.1备份模式 (237)15.2备份文件命名 (238)15.3恢复 (239)15.3.1恢复限速 (239)15.4配置文件 (239)15.5勾子脚本 (241)15.6排除文件 (241)15.7例子 (241)第16章重要服务 (242)16.1pvedaemon–Proxmox VE API守护进程 (242)16.2pveproxy–Proxmox VE API代理进程 (242)16.2.1基于主机的访问控制 (242)16.2.2SSL加密套件 (243)16.2.3Diffie-Hellman参数 (243)16.2.4其他HTTPS证书 (243)16.2.5压缩 (244)16.3pvestatd–Proxmox VE监控守护进程 (244)16.4spiceproxy–SPICE代理进程 (244)16.4.1基于主机的访问控制 (244)第17章命令行工具 (245)17.1pvesubscription–订阅管理工具 (245)17.2pveperf–Proxmox性能测试脚本 (245)17.3Proxmox VE API的命令行工具 (245)17.3.1示例 (246)17.4Proxmox节点管理 (246)17.4.1示例 (246)17.4.2局域网唤醒 (246)第18章常见问题 (247)第19章参考文献 (250)19.1Proxmox VE技术书籍 (250)19.2相关技术的书籍 (250)19.3相关主题的书籍 (251)第1章简介Proxmox VE是一个既可以运行虚拟机也可以运行容器的虚拟化平台。

如何将ESXi中的虚拟机通过OVAOVF导出的方式迁移到Proxmox 5

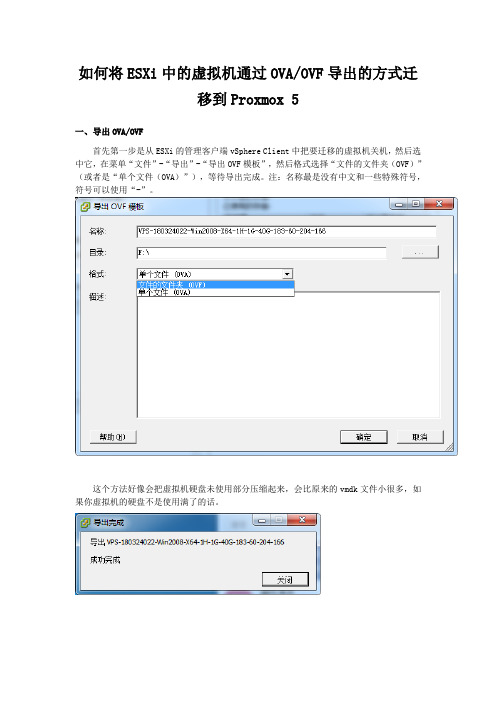

如何将ESXi中的虚拟机通过OVA/OVF导出的方式迁移到Proxmox 5一、导出OVA/OVF首先第一步是从ESXi的管理客户端vSphere Client中把要迁移的虚拟机关机,然后选中它,在菜单“文件”-“导出”-“导出OVF模板”,然后格式选择“文件的文件夹(OVF)”(或者是“单个文件(OVA)”),等待导出完成。

注:名称最是没有中文和一些特殊符号,符号可以使用“-”。

这个方法好像会把虚拟机硬盘未使用部分压缩起来,会比原来的vmdk文件小很多,如果你虚拟机的硬盘不是使用满了的话。

二、上传到目标主机然后就是把VPS-180324022-Win2008-X64-1H-1G-40G-183-60-204-166整个文件上传到proxmox到主机。

可以用winscp、xftp。

也可以用web端,用web端的时候。

在web左侧选择“文件夹视图”,然后展开“存储”,选中一个可以上传镜像的存储,比如“local(33ol)”,其中33ol是你的主机名字,在右边选择“内容”-“上传”即可。

因为上传的只能是iso或者容器模板,这里选择iso,然后把之前的文件夹做成iso后就可以上传成功了。

我是使用xftp上传到/var/lib/vz/template/iso里的。

其实上传到根目录也可以。

三、解压上传iso的主机,找到上传的文件后可以,使用ssh客户端或直接在web上里的控制台登录操作,例如上传的是:VPS-180324022-Win2008-X64-1H-1G-40G-183-60-204-166.iso则解压命令是:tar xvf VPS-180324022-Win2008-X64-1H-1G-40G-183-60-204-166.iso解压成功之后会得到以下文件:1.一个ovf文件,这个文件包含了虚拟机的硬件配置,例如cpu规格、内存等。

2.一个或多个vmdk文件,这些是虚拟机的硬盘镜像,数量取决于虚拟机有多少个硬盘。

保姆级教程来了 玩转虚拟机PVE

保姆级教程来了玩转虚拟机PVE作者:OverLord来源:《电脑爱好者》2021年第04期顾名思义,虚拟机的作用是管理硬件并将物理资源与虚拟环境分隔开。

来自物理环境的资源根据需要进行区分后,再分配给虚拟机模拟出的另一台“电脑”使用。

在这台“电脑”上,你可以靠虚拟机软件装系统、装软件、上网、和真实的电脑组成局域网,甚至同时运行的几台虚拟机也可以相互间组成局域网。

目前可选择的虚拟机有很多,而这其中PVE无疑是最友善的那个——免费、开源,而硬件直通效率最高(图1)。

虚拟机的玩法有很多,但是很多人还是丈二和尚摸不着头脑,连最基本的设置都还弄不明白。

今天,笔者就向大家介绍这款PVE(Proxmox Virtual Environment)的使用方法。

PVE的全称是Proxmox Virtual Environment(https:∥/),或简称为Proxmox VE。

它是一款开源的虚拟化方案,软件和社区支持都是免费的(基于Debian Linux 和KVM的虚拟化平台),企业用户则可以通过订阅制获得付费商业支持(图2)。

本来,这种系统多是用于服务器集群使用,不过随着个人用户对虚拟机的使用需求提升,PVE这种完全免费开源的虚拟机系统越发受到关注。

相比于其他虚拟机系统,PVE不仅仅是免费开源这么简单(当然非常重要),而且具备极低的硬件资源要求、配置极为简单,兼容性也非常出色。

当然了,对于服务器集群之类的应用,PVE的稳定性还略有欠缺,不过对个人用户毫无影响。

不过,要想自己的电脑使用虚拟机系统,必须满足一个先决条件——处理器支持虚拟化。

实际上这个要求并不苛刻,因为当今绝大部分处理器都具备硬件虚拟化技术,当然了,处理器性能越高、核心数量越多,在虚拟机上的运行分配就更加轻松自如。

要想知道自己的处理器能否支持虚拟化功能,我们可以使用一个简单的小软件来判断——这就是Securable。

下载Securable(下载地址:https:∥/securable.htm)后运行(只有一个运行文件),如图所示,如果最后一项“Hardware Virtualization”显示为“Yes”,则表示处理器支持(图3)。

proxmox backup server 备份原理 -回复

proxmox backup server 备份原理-回复Proxmox Backup Server is an open-source backup solution developed by Proxmox Server Solutions. It provides an efficient and reliable way to backup and restore virtual machines (VMs) and containers running on a Proxmox VE infrastructure. In this article, we will delve into the backup principles of Proxmox Backup Server and explore the step-by-step process of creating backups using this powerful tool.1. Introduction to Proxmox Backup Server:Proxmox Backup Server is built upon the open-source backup software Bacula, enhanced and optimized specifically for Proxmox VE environments. It utilizes the Bacula File daemon (FD) for efficient backup and restore operations. The backup server can be installed on a dedicated physical machine or as a virtual machine within the Proxmox VE infrastructure.2. Backup Storage Configuration:Before we can start backing up our VMs and containers, we need to configure the backup storage on the Proxmox Backup Server. This can be done through the web-based Proxmox Backup Server user interface (UI). We can define multiple storage targets,including local disks, network-attached storage (NAS), or cloud storage providers. Each storage target can have its own specific settings, such as retention policies and encryption options.3. Creating a Backup Job:Once the backup storage is configured, we can proceed to create a new backup job. In the Proxmox Backup Server UI, we specify the source VMs or containers that we want to back up, along with the backup target storage. We can choose to perform full backups or incremental backups, depending on our requirements. Full backups capture the entire VM or container at the time of backup, while incremental backups only capture the changes since the last backup.4. Backup Schedule and Retention Policies:We can set up a backup schedule for our job, defining the frequency and timing of backups. This can be done on a daily, weekly, or monthly basis. Additionally, we can configure retention policies to define how long the backups should be retained on the storage target. Proxmox Backup Server allows for flexible retention policies, enabling us to balance storage usage against the need for long-term backup availability.5. Backup Compression and Encryption:Proxmox Backup Server offers the option to compress the backups, reducing their size on the storage target. Compression helps to optimize storage utilization and reduce network bandwidth requirements during backup and restore operations. Furthermore, backups can be encrypted to ensure data privacy and security. Proxmox Backup Server supports different encryption algorithms and provides a built-in key management system.6. Backup Verification and Integrity Checking:To ensure the reliability of our backups, Proxmox Backup Server performs automatic verification and integrity checks. After each backup operation, the server verifies the backup data against the source VM or container. This process guarantees the integrity and consistency of the backed-up data, minimizing the risk of data corruption or loss during the restore process.7. Backup Monitoring and Reporting:Proxmox Backup Server provides extensive monitoring and reporting capabilities. We can track the status of backup jobs, view backup statistics, and receive notifications in case of backupfailures or other issues. The monitoring and reporting features help us ensure the ongoing success of our backup operations and provide valuable insights into the health and performance of our backup infrastructure.8. Restoring VMs and Containers:In the case of data loss or VM failure, Proxmox Backup Server allows for easy and efficient VM and container restoration. Through the web-based UI, we can browse the available backups, select the desired restore point, and initiate the restore process. The server takes care of restoring the VM or container, along with its associated configuration files and data.In conclusion, Proxmox Backup Server offers a comprehensive and reliable backup solution for Proxmox VE environments. By following the outlined steps, we can configure backup storage, create backup jobs, schedule backups, and restore VMs and containers. The server's robust features, such as compression, encryption, and verification, ensure the integrity and security of our backup data. With Proxmox Backup Server, administrators canconfidently implement a comprehensive backup strategy for their Proxmox VE infrastructure.。

proxmox backup server 备份原理 -回复

proxmox backup server 备份原理-回复Proxmox Backup Server(PBS)是一款基于开源软件的备份解决方案,为Proxmox Virtual Environment(PVE)虚拟化平台提供高可靠性的数据备份和恢复功能。

在这篇文章中,我们将详细介绍Proxmox Backup Server的备份原理,并逐步解释其工作流程。

第一步:备份计划和存储设置在使用Proxmox Backup Server之前,管理员需要先制定一个备份计划。

备份计划定义了备份频率、保留周期和备份存储目标。

管理员可以选择将备份数据存储在本地磁盘上,也可以使用网络储存协议(如NFS、iSCSI等)将备份数据存储在远程存储服务器上。

第二步:备份任务创建和调度一旦备份计划被定义,管理员就可以创建相应的备份任务。

备份任务指定了要备份的目标虚拟机和备份计划。

管理员可以选择完全备份虚拟机或只备份虚拟机的增量数据。

备份任务还可以包括备份前和备份后的脚本,以及备份的执行时间表。

第三步:备份数据传输和存储Proxmox Backup Server使用了一种名为PVC(Proxmox Virtualization Container)的容器化格式来存储备份数据。

当备份任务开始执行时,PBS会创建一个容器,将虚拟机的数据保存到其中。

PBS还能够利用COW(写时复制)技术,更高效地处理增量备份。

备份数据的传输是通过PVE和PBS之间的API完成的。

当PVE检测到有新的备份任务时,它会调用PBS的API将虚拟机的数据传输到PBS。

数据传输过程可以通过网络协议(如SSH)进行加密和压缩,以确保数据的安全和节约存储空间。

第四步:备份数据的验证和保留策略在备份过程中,PBS还会对备份数据进行验证,以确保数据的完整性和可恢复性。

验证可以通过计算数据的校验和或使用其他验证算法进行。

备份数据的保留策略是由备份计划和任务中定义的保留周期来确定的。

PVE主机系统LVM默认配置说明

PVE主机系统LVM默认配置说明⼤多数⼈直接在本地磁盘上安装 Proxmox VE。

Proxmox VE 安装 CD 提供了多种本地磁盘管理选项,以及当前的默认设置使⽤ LVM。

安装程序让您选择⼀个⽤于此类设置的单个磁盘,并将该磁盘⽤作物理卷的 Volume Group(VG) PVE 。

以下输出来⾃使⽤ 8GB ⼩磁盘测试安装:# pvsPV VG Fmt Attr PSize PFree/dev/sda3 pve lvm2 a-- 7.87g 876.00m# vgsVG #PV #LV #SN Attr VSize VFreepve 1 3 0 wz--n- 7.87g 876.00m安装程序会在上述 VG 内分配3个 Logical Volumes(LV):# lvsLV VG Attr LSize Pool Origin Data% Meta%data pve twi-a-tz-- 4.38g 0.00 0.63root pve -wi-ao---- 1.75gswap pve -wi-ao---- 896.00mroot根分区格式为 ext4 ,包含操作系统。

swap交换分区。

data此卷使⽤ LVM-thin,⽤于存储 VM 镜像。

LVM-thin 更适合这项任务,因为它提供了对快照和克隆的有效⽀持。

对于 4.1+ 的 Proxmox VE 版本,安装程序会创建⼀个标准的逻辑名为“data”的卷,挂载在 /var/lib/vz 。

从 4.2 版本开始,逻辑卷“data”是⼀个 LVM-thin 池,⽤于存储基于块的Guest镜像,⽽ /var/lib/vz 只是⼀个根⽂件系统上的⽬录。

硬件说明我们强烈建议使⽤硬件 RAID 控制器(带 BBU)这样的设置。

这提⾼了性能,提供了冗余,并使磁盘更换更容易(可热插拔)。

LVM 本⾝不需要任何特殊的硬件和内存要求⾮常低。

引导加载程序我们默认安装两个引导加载程序。

PVE备份和恢复介绍

PVE备份和恢复介绍任何明智的 IT 部署都需要备份,⽽ Proxmox VE 提供了⼀个完全集成的解决⽅案,使⽤每个存储和每个访客系统类型的功能。

这允许系统管理员通过备份⼀致性和访客系统停机时间之间的模式选项进⾏微调。

Proxmox VE 备份始终是完整备份 - 包含 VM/CT 配置和所有数据。

可以通过 GUI 或通过vzdump命令⾏⼯具启动备份。

备份存储在运⾏备份之前,必须定义备份存储。

有关如何添加存储的信息,请参阅存储⽂档。

备份存储必须是⽂件级存储,因为备份存储为常规⽂件。

在⼤多数情况下,使⽤ NFS 服务器是存储备份的好⽅法。

您可以稍后将这些备份保存到磁带驱动器中,以便进⾏异地存档。

计划备份可以安排备份作业,以便它们在特定⽇期和时间为可选节点和来宾系统⾃动执⾏。

计划备份的配置在 GUI 中的数据中⼼级别完成,这将在/etc/cron.d/vzdump 中⽣成⼀个 cron 条⽬。

备份模式有⼏种⽅法可以提供⼀致性(选项模式),具体取决于访客类型。

VM 的备份模式:停⽌模式此模式提供最⾼的备份⼀致性,但代价是 VM 操作的停机时间较短。

它的⼯作原理是依次关闭 VM,然后运⾏后台 Qemu 进程来备份 VM 数据。

备份启动后,如果 VM 之前正在运⾏,它会进⼊完整操作模式。

通过使⽤实时备份功能来保证⼀致性。

暂停模式此模式是出于兼容性原因提供的,并在调⽤快照模式之前挂起 VM 。

由于暂停虚拟机会导致较长的停机时间,并且不⼀定能提⾼数据的⼀致性,因此建议改⽤快照模式。

快照模式这种模式提供了最短的操作停机时间,但代价是很⼩的不⼀致风险。

它的⼯作原理是执⾏ Proxmox VE 实时备份,其中在 VM 运⾏时复制数据块。

如果启⽤了来宾代理 ( agent: 1 ) 并运⾏,它会调⽤ guest-fsfreeze-freeze 和 guest-fsfreeze-thaw 以提⾼⼀致性。

Proxmox VE 实时备份为任何存储类型提供类似快照的语义。

proxmox backup中文使用手册

Proxmox Backup 中文使用手册--------------------------目录1. Proxmox Backup 简介2. 系统要求3. 安装与配置4. 备份与恢复5. 备份策略6. 故障排除7. 结语1. Proxmox Backup 简介Proxmox Backup 是一款开源的备份解决方案,专为虚拟化环境而设计。

它能够对虚拟机和容器进行全量和增量备份,并提供可靠的恢复功能,同时支持多种存储后端。

Proxmox Backup 是基于现代的开源技术构建而成,具有高性能和稳定性。

2. 系统要求在使用 Proxmox Backup 之前,需要满足以下系统要求:- 一台运行 Proxmox VE 6.0 或更高版本的服务器- 至少 4GB 的内存和足够的存储空间- 支持 KVM 和 LXC 的虚拟化环境3. 安装与配置安装 Proxmox Backup 非常简单,只需执行以下几步操作:- 在 Proxmox VE 服务器上打开终端- 运行命令 `apt update` 更新软件包列表- 运行命令 `apt install proxmox-backup-server` 安装 Proxmox Backup 服务器- 运行命令 `systemctl start pbs` 启动 Proxmox Backup 服务器一旦安装完成,可以通过浏览器访问 Proxmox Backup 的 Web 界面进行配置。

在 Web 界面中,用户可以设置备份存储,添加虚拟机和容器,并配置备份策略。

4. 备份与恢复使用 Proxmox Backup 进行备份非常方便,只需按照以下步骤进行操作:- 在 Web 界面中选择要备份的虚拟机或容器- 点击“创建备份”按钮,选择备份存储和备份类型- 等待备份完成,可以在备份存储中查看备份文件恢复备份也非常简单,只需选择要恢复的备份文件并启动恢复过程即可。

Proxmox Backup 提供了灵活的恢复选项,用户可以选择完整恢复或者选择性恢复特定文件。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Migration of servers to Proxmox VEFrom Proxmox VEContents1 Introduction1.1 Windows systems specific P2V issues1.1.1 inaccessible boot device1.1.2 disk booting tips1.1.3 hidden nonpresent devices1.1.4 other suggested pages1.2 Fake Raid specific issues2 Physical server to Proxmox VE (KVM) using Clonezilla Live CDs3 How to migrate directly from a Windows physical machine to a VM raw file using SSH4 How to migrate directly from a Windows physical machine to a VM logical volume using NETCAT5 How to migrate from a physical machine to a VM, on a smaller partition5.1 main tool: fsarchiver5.2 mergeide5.3 running fsarchiver from SystemrescueCD5.4 backup the partition5.5 restore the partition5.6 successful cases6 Physical (running) server to Proxmox VE (KVM) using SelfImage6.1 Prepare the Windows operating system6.2 Prepare the Proxmox VE VM6.3 Do the migration7 Physical (running) server to Proxmox VE (KVM) using Windows backup7.1 The Workflow7.2 backup the physical machine7.3 creating a similar virtual machine7.4 restore the backup on the virtual machine7.5 reboot the virtual machine8 VMware to Proxmox VE (KVM)8.1 Prepare the Windows operating system8.1.1 Remove VMware tools8.1.2 Enable IDE8.2 Prepare the disk file8.3 Alternative migration using a rescue CD disk image8.4 Adapt the new KVM Virtual Machine9 XEN to Proxmox VE (KVM)10 KVM to Proxmox VE (KVM)11 Move OpenVZ containers to Proxmox VE12 Physical server (or KVM, VMware, XEN or other) to Proxmox VE OpenVZ Container13 Convert Windows to use SCSI (KVM)14 Physical (running) Windows server to Proxmox VE (KVM) using VMware Converter14.1 Prepare Windows14.1.1 Prepare location to save local image14.2 VMware vCenter Settings14.3 Prepare the VM on Proxmox14.4 Move the image to the Proxmox Server14.4.1 Using a USB Hard Drive14.5 Converting to qcow214.6 Final Steps

IntroductionYou can migrate existing servers to Proxmox VE. Moving Linux servers is always quite easy so you will not find much hints fortroubleshooting here.

Windows systems specific P2V issuesinaccessible boot deviceBooting a virtual clone (IDE) of a physical Windows system partition may fail with a BSOD referring to the problemSTOP: 0x0000007B (0xF741B84C,0xC0000034,0x00000000,0x00000000)INACCESSIBLE_BOOT_DEVICE

this means that the source physical windows machine had no support for IDE controller, or at least the one virtually replacedby kvm (see Microsoft KB article (http://support.microsoft.com/kb/314082/en-us) article for details): as Microsoft suggests,create a mergeide.reg file (File:Mergeide.zip) file on the physical machine and merge that in the registry, 'before the P2Vmigration. Btw, it may not be necessary but should be no harm, anyway, and save you lots of time and headaches.Windows 2000: see [1] (http://www.motherboard.windowsreinstall.com/problems.htm)disk booting tipscheck that your disk has "boot flag" enabled (you can check this with gparted, on ntfs disks, booting the vm from alivecd iso, see this gparted manual page (http://gparted.sourceforge.net/docs/help-manual/C/gparted.html#gparted-fix-operating-system-boot-problems) ) maybe not so windows-specific but better remind it here.be sure that boot.ini on your system partition is still suitable to your current disk/partition configuration (see thiskb article (http://support.microsoft.com/kb/124550) and this kb article (http://support.microsoft.com/kb/102873) )

hidden nonpresent devicesIf your source physical machine had network interface controllers (nics) with static IP assigned and then you clone the systemto a vm, you will need to add a virtual ethernet controller, provided by kvm, but Windows won't let you assign the same fixedIP to the new virtual nic, because (it reports) there is a hidden and nonpresent devices already configured with the same IP(see Microsoft KB article (http://support.microsoft.com/kb/241257) ).

For sure it should be removed from windows "known" hardware but, you won't find it in "device management", even if you specify"show hidden peripherals", why? because Microsoft is complicated :-)

To be able to see, and then remove the old physical nic from "device managemnt", you have toopen a console windowtype:

set devmgr_show_nonpresent_devices = 1and press enterthen, in the same console (do not close it) type:

start devmgmt.mscand press enterthis will open the same "device management" panel you could have open from the "control panel", but now if you set the"show hidden peripherals" flag, the "nonpresent" devices will appear, although dimmed somehow, and you will be able toremove them, freeing the IP for your virtual nic.