集成算法概述

【集成学习】:Stacking原理以及Python代码实现

【集成学习】:Stacking原理以及Python代码实现 Stacking集成学习在各类机器学习竞赛当中得到了⼴泛的应⽤,尤其是在结构化的机器学习竞赛当中表现⾮常好。

今天我们就来介绍下stacking这个在机器学习模型融合当中的⼤杀器的原理。

并在博⽂的后⾯附有相关代码实现。

总体来说,stacking集成算法主要是⼀种基于“标签”的学习,有以下的特点: ⽤法:模型利⽤交叉验证,对训练集进⾏预测,从⽽实现⼆次学习 优点:可以结合不同的模型 缺点:增加了时间开销,容易造成过拟合 关键点:模型如何进⾏交叉训练?下⾯我们来看看stacking的具体原理是如何进⾏实现的,stacking⼜是如何实现交叉验证和训练的。

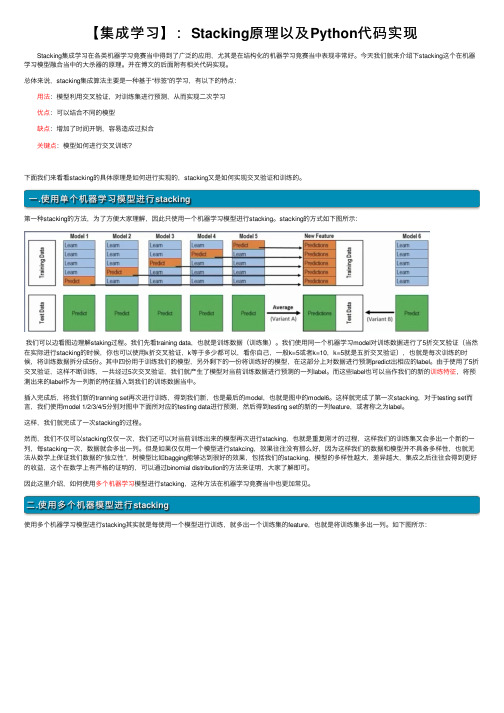

⼀.使⽤单个机器学习模型进⾏stacking第⼀种stacking的⽅法,为了⽅便⼤家理解,因此只使⽤⼀个机器学习模型进⾏stacking。

stacking的⽅式如下图所⽰:我们可以边看图边理解staking过程。

我们先看training data,也就是训练数据(训练集)。

我们使⽤同⼀个机器学习model对训练数据进⾏了5折交叉验证(当然在实际进⾏stacking的时候,你也可以使⽤k折交叉验证,k等于多少都可以,看你⾃⼰,⼀般k=5或者k=10,k=5就是五折交叉验证),也就是每次训练的时候,将训练数据拆分成5份。

其中四份⽤于训练我们的模型,另外剩下的⼀份将训练好的模型,在这部分上对数据进⾏预测predict出相应的label。

由于使⽤了5折交叉验证,这样不断训练,⼀共经过5次交叉验证,我们就产⽣了模型对当前训练数据进⾏预测的⼀列label。

⽽这些label也可以当作我们的新的训练特征,将预测出来的label作为⼀列新的特征插⼊到我们的训练数据当中。

插⼊完成后,将我们新的tranning set再次进⾏训练,得到我们新,也是最后的model,也就是图中的model6。

这样就完成了第⼀次stacking,对于testing set⽽⾔,我们使⽤model 1/2/3/4/5分别对图中下⾯所对应的testing data进⾏预测,然后得到testing set的新的⼀列feature,或者称之为label。

常见监督学习聚类集成降维推荐算法汇总(一)监督学习

常见监督学习聚类集成降维推荐算法汇总(一)监督学习1.线性回归:线性回归是一种用于建立线性模型的监督学习算法,在给定输入和输出之间建立一个线性关系,用于预测连续型输出。

它的目标是找到一条最佳拟合直线来描述输入和输出之间的关系。

2.逻辑回归:逻辑回归是一种用于建立分类模型的监督学习算法,用于预测二元型输出。

它通过将线性回归的结果经过一个激活函数转换为概率值,从而进行分类预测。

3.支持向量机:支持向量机是一种用于二分类和多分类的监督学习算法。

它通过将样本映射到高维特征空间中,构建一个超平面来实现对样本的划分。

其目标是找到一个最优的划分超平面,使得距离最近的样本点到超平面的间隔最大。

4.决策树:决策树是一种基于树形结构的监督学习算法,用于建立分类和回归模型。

它通过对特征进行划分,采用自顶向下的贪心策略构建决策树,从而实现对数据的分类和预测。

5.随机森林:随机森林是一种集成学习方法,通过构建多个决策树并对其结果进行综合来实现分类和回归。

每个决策树都是基于随机选择的样本和特征构建的,最终输出通过投票或平均等方式进行集成。

6.朴素贝叶斯:朴素贝叶斯是一种基于贝叶斯定理的分类算法,它假设特征之间相互独立,通过计算先验概率和条件概率来进行分类预测。

朴素贝叶斯算法简单快速,常用于文本分类等任务。

聚类是一种无监督学习算法,用于将数据集中的样本划分为多个类别或簇,使得同一类别内的样本相似度高,不同类别之间的样本相似度低。

常见的聚类算法包括K-means聚类、层次聚类、DBSCAN等。

1. K-means聚类:K-means聚类是一种划分聚类算法,通过迭代计算样本到聚类中心的距离,并将样本划分到距离最近的聚类中心所对应的类别中。

它的目标是最小化样本与聚类中心的距离总和。

2.层次聚类:层次聚类是一种基于层次性的聚类算法,通过合并或分割样本来构建聚类树。

它可以根据样本之间的相似度构建凝聚式聚类树或分裂式聚类树,并通过剪枝来确定最终的聚类结果。

集成学习介绍课件

典型集成方法介绍

1 投票法:多个模型投票,少数服从多数 2 平均法:多个模型预测结果求平均 3 加权平均法:根据模型性能分配权重,加权平均 4 堆叠法:将多个模型的输出作为新的输入,进行二次学习 5 提升法:将弱分类器组合成强分类器,如AdaBoost和GBDT 6 融合法:将多个模型的结果进行融合,如决策树和神经网络的融合

4

降低计算复杂度: 通过集成多个模 型,可以降低计 算复杂度,提高 计算效率

集成学习的方法

集成方法分类

平均法:将多个模型的预测结果进行平均,如 Bagging和Boosting

投票法:将多个模型的预测结果进行投票,如 Stacking和Blending

加权法:将多个模型的预测结果进行加权求和,如 AdaBoost和Gradient Boosting

集成学习可以提高

01

分类问题的准确率

集成学习可以处理

04

不平衡分类问题

02

集成学习可以降低

分类问题的方差

03

集成学习可以处理

高维分类问题

集成学习在回归问题中的应用

集成学习可以提高回归问 题的预测精度

集成学习可以降低回归问 题的过拟合风险

集成学习可以处理回归问 题的非线性特征

集成学习可以提高回归问 题的泛化能力

02

模型选择:如何选择合适的模型进行集成,以提高整体性能

03

模型融合:如何将不同模型的结果进行融合,以获得更好的预测效果

04

计算复杂度:集成学习通常需要较高的计算资源,如何降低计算复杂度是一 个挑战

集成学习的发展趋势

01 深度学习与集成学习的结合: 02 集成学习的可解释性:研究

随机森林的原理

随机森林的原理随机森林是一种集成学习算法,通过组合多个决策树来进行分类和回归任务。

它的原理基于决策树和随机抽样的思想,具有一定的鲁棒性和预测能力。

本文将详细介绍随机森林的原理和应用,并探讨其优缺点及改进方法。

一、随机森林的原理随机森林由多个决策树组成,每个决策树都是一个分类器。

在随机森林中,每个决策树的生成过程都是独立的,首先从样本集中通过有放回抽样(bootstrap)的方式抽取出n个样本,然后对每个样本随机选择k个特征,构建决策树。

这里的k是一个常数,通常取总特征数的平方根。

每个决策树都对应着一个子样本集和一个特征子集,通过递归地选择最优特征进行划分,直到满足某个停止条件(如节点样本数小于阈值或深度达到预定值)。

在决策树的生成过程中,每个节点通过计算一个评价指标(如信息增益或基尼指数)来选择最优特征进行划分。

决策树的划分过程会不断减少样本的纯度,直到达到叶节点。

叶节点的类别由该节点中样本的多数类确定。

每个决策树都会对新样本进行分类,最终通过投票的方式确定随机森林的预测结果。

二、随机森林的优点1. 随机森林能够处理高维数据和大规模数据集,具有较强的泛化能力。

2. 随机森林能够处理缺失值和不平衡数据集,并且对异常值具有较好的鲁棒性。

3. 随机森林能够评估特征的重要性,可以用于特征选择和特征工程。

4. 随机森林可以并行计算,提高了训练速度。

三、随机森林的应用1. 随机森林广泛应用于分类问题,如垃圾邮件过滤、疾病诊断等。

通过训练多个决策树,随机森林可以提高分类的准确度和鲁棒性。

2. 随机森林可以用于回归问题,如房价预测、股票走势预测等。

通过训练多个决策树,随机森林可以提供更加准确的预测结果。

3. 随机森林还可以用于异常检测、聚类分析等领域。

通过利用随机森林的特征选择和异常检测能力,可以有效地发现异常样本或聚类相似样本。

四、随机森林的改进方法尽管随机森林具有很多优点,但也存在一些缺点。

比如,随机森林在处理高维数据时容易过拟合,而且对噪声数据敏感。

boost any 原理

boost any 原理摘要:1.Boost 算法的原理概述2.Boost 算法的组成部分3.Boost 算法的核心思想4.Boost 算法的具体实现方式5.Boost 算法的应用和优势正文:Boost 算法,全称Bootstrap Aggregation,是一种集成学习算法,其核心思想是通过组合多个基本分类器来提高分类准确性。

下面我们将详细介绍Boost 算法的原理和实现方式。

1.Boost 算法的原理概述Boost 算法是一种自适应的加权投票算法,其主要目的是通过加权投票的方式,对多个基本分类器的输出结果进行综合,从而得到最终的分类结果。

其基本原理是,对于分类错误的样本,会增加其对应的基本分类器的权重,而对于分类正确的样本,则会降低其对应的基本分类器的权重。

这样,经过多轮迭代后,分类器对于分类错误的样本会有更高的关注度,从而提高分类准确性。

2.Boost 算法的组成部分Boost 算法主要由三个部分组成:弱学习器、强学习器和加权投票。

弱学习器是Boost 算法的基本单元,其主要负责对训练数据进行分类,并将分类结果输出给强学习器。

强学习器则是Boost 算法的核心部分,其主要负责对多个弱学习器的输出结果进行加权投票,从而得到最终的分类结果。

加权投票则是Boost 算法的一种决策方式,其主要根据弱学习器的权重来决定最终的分类结果。

3.Boost 算法的核心思想Boost 算法的核心思想是,通过加权投票的方式,对多个基本分类器的输出结果进行综合,从而得到最终的分类结果。

其基本原理是,对于分类错误的样本,会增加其对应的基本分类器的权重,而对于分类正确的样本,则会降低其对应的基本分类器的权重。

这样,经过多轮迭代后,分类器对于分类错误的样本会有更高的关注度,从而提高分类准确性。

4.Boost 算法的具体实现方式Boost 算法的具体实现方式主要有两种:一种是AdaBoost,另一种是XGBoost。

AdaBoost 是Boost 算法的一种基本实现方式,其主要通过自适应的方式,动态地调整基本分类器的权重,从而得到最终的分类结果。

机器学习的集成学习技术

机器学习的集成学习技术随着大数据和云计算技术的不断发展,机器学习作为人工智能的重要分支之一,越来越受到重视和关注。

近年来,集成学习技术在机器学习领域中得到了广泛的应用和研究。

本文将介绍机器学习的集成学习技术。

一、机器学习简介机器学习是一种能够让计算机从数据中自动学习模型的技术。

通常情况下,机器学习可以分为三种类型:有监督学习、无监督学习和强化学习。

其中,有监督学习是指在已知标记数据的情况下,训练模型来预测新的未知数据的标记;无监督学习是指在没有标记数据的情况下,训练模型来发现数据中的潜在结构和模式;强化学习则是指将智能体放置在环境中,通过与环境的互动来学习策略,并获得最大化奖励的目标。

机器学习通常需要解决两个主要问题:模型选择和参数调整。

模型选择是指选择最适合数据的模型;参数调整是指寻找最优的模型参数。

为了解决这些问题,通常需要使用集成学习技术。

二、集成学习技术集成学习是指将多个学习器组合起来,形成一个更强大的学习器。

通常情况下,集成学习可以分为两种类型:并行集成和串行集成。

并行集成是指将多个学习器同时应用于训练数据,然后将它们的输出进行投票或平均来得出最终结果。

其中,投票法是指每个学习器为一个类别投票,最终选取得票数最多的作为最终结果;平均法是指对多个学习器的输出取平均值,作为最终输出。

串行集成是指将多个学习器分成若干层,每一层的学习器输出作为下一层学习器的输入,最终由输出层输出最终结果。

其中,常见的串行集成算法包括boosting和bagging。

boosting是一种提高弱分类器的准确率的算法,它通过不断调整数据权值的方式来使得分类器能够更加关注难以分类的例子,从而提高分类效果。

常见的boosting算法包括AdaBoost和GBDT。

bagging是一种基于bootstrap采样的并行集成算法,它通过从原始数据集中采样若干子集,每个子集训练一个基分类器,最终将这些分类器进行投票或平均获得最终结果。

gbdt算法通俗理解

1.什么是GBDTGBDT属于集成算法的一种,基分类器是回归树(分类问题也是回归树,最后再用sigmoid或者softmax函数计算类别),是一种boosting算法,即逐步拟合逼近真实值,是一个串行的算法,可以减少bias(误差)却不能减少variance(偏差),因为每次基本都是全样本参与训练,不能消除偶然性的影响,但每次都逐步逼近真实值,可以减少误差。

GBDT包括三种基本用法,一是回归,二是二分类,三是多分类。

技术细节有点差异,但是整体思路都是一样的。

2.GBDT要知道的基础知识•基分类器是cart回归树,你要知道树怎么划分节点,怎么停止分裂,这个不知道的自己去百度吧。

•损失函数有很多,回归问题常用均方差,绝对值,huber和分位数也常用,但是基本的问题就用均方差解决了,因为求导特别方便;分类问题常用对数形式的损失函数,这里注意用的是(-1,1)形式的对数损失函数,可以证明和(0,1)形式的是等价的•目标函数值初始化,每次说到目标函数和损失函数都害怕大家误解,这里的目标函数指函数最终预测值。

初代的目标函数,根据目标函数的不同会有不同的初始化方案,比如均方差损失是均值,绝对值损失是中位数,对数损失是正负样本概率值比的一半。

•正则化,人家别的算法都在损失函数上加一个L2正则,这个树咋办啊,这个树有自己的办法,比如设置一个学习率,设置一个树的结构(最大的深度,最大的叶子节点数),也可以随机抽样本训练树,也可以随机抽指标参与训练,也可以用CART 的剪枝策略。

•回归和分类有什么区别,回归树叶子节点得分就是均值,然后每棵树每个样本都有一个得分,得分累加就是最后的预测值。

分类就不一样了,叶子节点的得分是用牛顿法计算出来的用偏差计算的一个数值,听听这个麻烦,你肯定不能它直接当预测结果,用sigmoid或者softmax算一下概率就出来分类了。

•为什么残差可以作为拟合的目标值,因为采用梯度下降算法,梯度就是求导,平方损失函数,残差就是梯度。

人工智能 分类算法

人工智能分类算法人工智能分类算法人工智能(Artificial Intelligence,AI)是一门研究如何使计算机能够模拟人类智能行为的学科。

而人工智能分类算法则是实现人工智能技术的关键。

它能够将数据集中的样本按照其特征进行分类,从而帮助计算机模拟人类的分类思维和判断能力。

下面将介绍几种常见的人工智能分类算法。

一、决策树算法决策树算法是一种基于树形结构的分类算法。

它通过对数据集进行分割,使得每个分割部分尽可能地纯净,即只包含属于同一类别的样本。

决策树算法的优点是易于理解和解释,可以处理具有缺失值的数据,同时对异常值具有鲁棒性。

然而,决策树算法也存在容易过拟合的问题,需要采取一些措施进行优化。

二、朴素贝叶斯算法朴素贝叶斯算法是一种基于贝叶斯定理的分类算法。

它假设特征之间相互独立,从而简化了模型的计算和参数估计。

朴素贝叶斯算法的优点是计算简单,速度快,对小规模数据集表现良好。

然而,朴素贝叶斯算法也存在对输入数据的要求较高,对特征之间的相关性敏感等缺点。

三、支持向量机算法支持向量机算法是一种基于统计学习理论的分类算法。

它通过找到一个最优的超平面,使得不同类别的样本能够被最大程度地分开。

支持向量机算法的优点是可以处理高维数据、非线性数据和小样本数据,并且对于噪声和异常值具有较好的鲁棒性。

然而,支持向量机算法也存在计算复杂度高、对参数选择敏感等问题。

四、神经网络算法神经网络算法是一种模拟人脑神经元工作原理的分类算法。

它通过构建多层的神经元网络,并通过学习调整网络中的连接权重,从而实现对样本的分类。

神经网络算法的优点是可以处理复杂的非线性问题,并且对于一些大规模数据集表现良好。

然而,神经网络算法也存在训练时间长、对初始参数敏感等问题。

五、集成学习算法集成学习算法是一种将多个分类器组合起来进行决策的分类算法。

它通过构建多个基分类器,并通过投票、加权平均等方式进行集成,从而提高分类的准确性和鲁棒性。

集成学习算法的优点是可以充分利用不同分类器的优势,并且对于一些复杂问题具有较好的泛化能力。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Overview of Ensemble Algorithms

Zhang Peipei

(Shandong Women's University, Jinan Shandong 250300, China)

相较于单个分类器的预测结果,通过这种方式得到的预测结 三种组合策略获得高度准确的分类决策。许多作者已通过集

果更准确。最初的集成方法是贝叶斯平均法 [5],之后又出现 成方法证明了显著的性能改进。当下比较流行的两种集成方

了装法算法、增强算法及叠加算法 [6],包括集成算法中并行、 法是装袋算法和增强算法。前者旨在降低方差,它在不剪枝

Abstract: With the development of artificial intelligence, machine learning has become a hot topic of current research. As a common machine learning algorithm, ensemble algorithm has been paid attention to. Therefore, the classical bagging algorithm and enhancement algorithm of ensemble learning algorithm are introduced respectively, and the corresponding specific algorithm design principle is given, and the performance of these two algorithms is compared simply. At the same time, the design principles of several derivative algorithms of these algorithms are introduced.

算法语言

信息与电脑 China Computer & Communication

集成算法概述

2019 年第 3 期

张佩佩

(山东女子学院,山东 济南 250300)

摘 要:随着人工智能的发展,机器学习也成为了当下研究的热点内容,集成算法作为常见的机器学习算法得到了 重视。因此,分别介绍了集成学习算法中较为经典的装袋算法和增强算法,给出了相应的具体算法设计原理,并在性能 方面简单比较了这两种算法。同时,介绍了这些算法的几种衍生算法的设计原理。

— 50 —

2019 年第 3 期

信息与电脑 China Computer & Communication

算法语言

1.1 装袋算法

那么增强算法易陷入局部最优解。

装袋算法的基本原理是对观测信息进行再抽样,进而对 总体的分布特性进行统计推断。装袋算法首先按照随机有放 回方式进行训练数据的选择,然后在利用选择的数据构造分 类器,最后对得到的分类器进行组合。详细来讲,首先从原 始数据集随机抽选多次,得到多个新数据集;其次使用相同 的模型对每个新数据集进行训练,进而得到多个分类器;然 后当有一个新输入样本进入时,就让这多个分类器分别进行 判断,得到多个分类结果;最后对这些结果按照“少数服从 多数”的选择进行投票,以得到新样本的最终分类结果。每 一基算法之间没有依赖,可以并行计算,它的结果参考了各 种情况,实现在欠拟合和过拟合之间取折中。在进行数值结 果预测时,利用聚合方式对多个分类器的结果进行平均,对 预测器结果进行简单投票。利用分类回归树和线性回归中的 子集选择对真实数据集和模拟数据集进行测试,结果表明, 套袋法在精度上有较大提高。

串行和树形结合的几种不同方式。装袋算法是把每一基模型 的决策树、神经网络取一个折中的结果。增强算法根据旧模型 低偏差,它基于泛化性能相当弱的学习器构建出很强的集成。

基金项目:山东女子学院青年课题“GARCH 期权定价方法中随机波动过程问题研究”(基金项目:2016ZD04)。 作者简介:张佩佩 (1990—),女,山东聊城人,硕士研究生,助教。研究方向:随机控制。

1.2 增强算法

基于错误提升分类器性能,不断迭代建立新模型的同时, 对样本分布特征进行调整,针对上一模型中被错误分类的样 本,新模型应更加重视,进而提升对数据样本整体的处理精 度,执行迭代直到基学习器数目达到指定的值,最后将训练 好的基学习器根据准确率加权组合得到训练结果。它是一种

中的错误对模型进行训练,进行层层改进,进而得到新模型。 叠加算法是把基模型组织起来 [7],基模型本身进行搭配组合, 该方法看起来更灵活,也更复杂。

笔者将重点陈述装法算法和增强算法的原理和算法设计 思路,给出具体的实现步骤,并解释为什么集合的性能通常 优于任何单个分类器,然后分别介绍这两类算法的优点、不 足以及应用中需要注意的问题。

研究提供了很好的思路。

1 算法介绍

集成算法作为常见的机器学习算法,由一组单独训练的

集成算法需先构造一个集合,在集合中的分类器具有多

分类器组成。在对测试集进行分类时,将各分类器的预测值 样性、独立性及较高的准确性。通过加法模型将集合中的弱

按照加权原则进行投票,进而对引入的新数据点进行分类。 分类器进行线性组合,最后利用平均法、投票法或学习法这

Key words: ensemble algorithm; bagging algorithm; boosting algorithm

0 引言

作为人工智能领域和深度学习领域的一种常用手段,机 器学习已成为当下研究的热点内容 [1]。针对机器学习中各种 方法,学者们进行了大量研究。根据常见任务划分,机器学 习研究的问题可分为回归、分类、聚类及降维问题 [2-3],还有 “没有免费的午餐”问题 [4]。集成算法把简单算法组织起来 [5], 集合各种算法优点产生综合的机器学习策略,为实际应用和