数据分析实验报告

数据分析与挖掘实验报告

数据分析与挖掘实验报告一、实验背景在当今数字化的时代,数据成为了企业和组织决策的重要依据。

通过对大量数据的分析与挖掘,能够发现隐藏在数据背后的规律和趋势,为决策提供有力的支持。

本次实验旨在通过实际操作,深入了解数据分析与挖掘的流程和方法,并探索其在实际应用中的价值。

二、实验目的1、熟悉数据分析与挖掘的基本流程和常用技术。

2、掌握数据预处理、特征工程、模型建立与评估等关键环节。

3、运用数据分析与挖掘方法解决实际问题,提高数据分析能力和解决问题的能力。

三、实验环境1、操作系统:Windows 102、编程语言:Python 383、数据分析库:Pandas、NumPy、Matplotlib、Seaborn、Scikitlearn 等四、实验数据本次实验使用了一份来自某电商平台的销售数据,包含了商品信息、用户信息、销售时间、销售金额等字段。

数据规模约为 10 万条记录。

五、实验步骤1、数据导入与预处理使用 Pandas 库读取数据文件,并对数据进行初步的查看和分析。

处理缺失值:对于包含缺失值的字段,根据数据特点采用了不同的处理方法。

例如,对于数值型字段,使用均值进行填充;对于分类型字段,使用众数进行填充。

数据清洗:去除重复记录和异常值,确保数据的准确性和可靠性。

2、特征工程特征提取:从原始数据中提取有意义的特征,例如计算用户的购买频率、平均购买金额等。

特征编码:对分类型特征进行编码,将其转换为数值型特征,以便模型处理。

例如,使用 OneHot 编码将商品类别转换为数值向量。

3、模型建立与训练选择合适的模型:根据问题的特点和数据的分布,选择了线性回归、决策树和随机森林三种模型进行实验。

划分训练集和测试集:将数据按照一定比例划分为训练集和测试集,用于模型的训练和评估。

模型训练:使用训练集对模型进行训练,并调整模型的参数,以提高模型的性能。

4、模型评估与比较使用测试集对训练好的模型进行评估,计算模型的均方误差(MSE)、均方根误差(RMSE)和决定系数(R²)等指标。

数据整理与分析实验报告

数据整理与分析实验报告一、实验目的随着信息技术的飞速发展,数据已成为企业和组织决策的重要依据。

本次实验旨在通过对给定数据集的整理与分析,掌握数据处理的基本方法和技巧,提取有价值的信息,为后续的决策提供支持。

二、实验数据本次实验使用的数据集是关于某电商平台在过去一年的销售记录,包括商品名称、价格、销量、用户评价等字段。

数据量约为 10 万条,以 CSV 格式存储。

三、实验工具与环境1、编程语言:Python2、数据分析库:Pandas、NumPy、Matplotlib3、开发环境:Jupyter Notebook四、数据整理步骤1、数据读取使用 Pandas 库的`read_csv`函数读取数据文件,将数据加载到DataFrame 中。

```pythonimport pandas as pddata = pdread_csv('sales_datacsv')```2、数据清洗(1)处理缺失值检查数据中是否存在缺失值。

对于数值型字段,使用平均值或中位数进行填充;对于字符串型字段,根据具体情况进行删除或填充。

```pythondatafillna(value={'price': data'price'mean(),'user_comment':'无'}, inplace=True)```(2)去除重复数据使用 Pandas 库的`drop_duplicates`函数去除重复的行。

```pythondata = datadrop_duplicates()```(3)异常值处理通过数据可视化和统计分析,找出数据中的异常值。

对于明显不合理的异常值,进行删除或修正。

3、数据标准化将数据中的数值型字段进行标准化处理,以便后续的分析和比较。

```pythonfrom sklearnpreprocessing import StandardScalerscaler = StandardScaler()data'price' = scalerfit_transform(data'price'valuesreshape(-1, 1))```4、数据分类与汇总根据商品类别对数据进行分类,并计算各类别的销售总额、平均价格、销量等统计指标。

数据处理与分析实验报告

数据处理与分析实验报告一、实验目的本次数据处理与分析实验旨在通过实际操作和研究,掌握数据处理与分析的基本方法和流程,提高对数据的理解和应用能力,为解决实际问题提供有效的数据支持。

二、实验环境本次实验使用的软件和工具包括:Python 编程语言、Anaconda 集成开发环境、NumPy 库、Pandas 库、Matplotlib 库、Seaborn 库等。

硬件环境为配备英特尔酷睿 i5 处理器、8GB 内存的个人计算机。

三、实验数据实验所使用的数据来源于公开数据集具体数据集名称,该数据集包含了具体数据的描述,例如用户行为数据、销售数据等,共具体行数行,具体列数列。

数据字段包括详细列出数据集中的字段名称和含义。

四、实验步骤1、数据读取与预处理使用 Pandas 库的`read_csv`函数读取数据文件,将数据加载到DataFrame 中。

对数据进行初步的探索性分析,包括查看数据的前几行、数据的形状、数据类型、缺失值等情况。

处理缺失值,根据数据的特点和业务需求,选择合适的方法进行填充或删除。

对数据进行标准化或归一化处理,以便后续的分析和建模。

2、数据分析计算数据的基本统计量,如均值、中位数、标准差、最大值、最小值等,了解数据的分布情况。

进行数据可视化,使用 Matplotlib 和 Seaborn 库绘制柱状图、折线图、箱线图、散点图等,直观地展示数据的特征和关系。

进行相关性分析,计算变量之间的皮尔逊相关系数,判断变量之间的线性关系。

3、数据建模根据数据的特点和分析目的,选择合适的机器学习模型,如线性回归、逻辑回归、决策树等。

使用训练集对模型进行训练,调整模型的参数,以提高模型的性能。

使用测试集对训练好的模型进行评估,计算模型的准确率、召回率、F1 值等指标,评估模型的效果。

五、实验结果与分析1、数据预处理结果经过缺失值处理,共删除了具体行数行数据,填充了具体列数列的数据。

标准化或归一化处理后,数据的分布更加均匀,有利于后续的分析和建模。

DEEP大数据分析实验报告

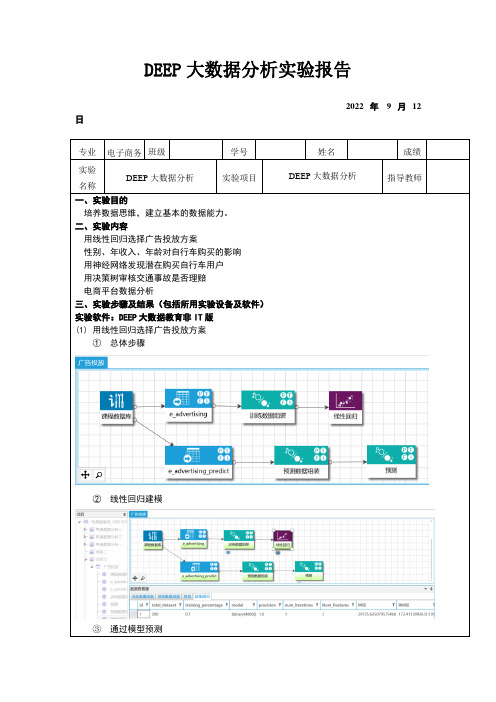

DEEP大数据分析实验报告2022 年9 月12 日专业电子商务班级学号姓名成绩实验DEEP大数据分析实验项目DEEP大数据分析指导教师名称一、实验目的培养数据思维,建立基本的数据能力。

二、实验内容用线性回归选择广告投放方案性别、年收入、年龄对自行车购买的影响用神经网络发现潜在购买自行车用户用决策树审核交通事故是否理赔电商平台数据分析三、实验步骤及结果(包括所用实验设备及软件)实验软件:DEEP大数据教育非IT版(1)用线性回归选择广告投放方案①总体步骤②线性回归建模③通过模型预测(2)性别、年收入、年龄对自行车购买的影响①性别、年收入是否影响购买可以看出,男性和女性购买自行车的数量都没要显著差异,因此可以任务性别这个因素基本上对购买自行车的行为不产生影响。

②客户年龄离散化③年龄是否影响购买从图中可以看出,各个年龄段的总人数和购买者有着明显的差异,33岁到63岁之间人群是购买自行车的主力。

(3)用神经网络发现潜在购买自行车用户在图中,predict列的1表示需要购买自行车。

这样,可以对需要购买自行车的人员进行精准营销。

(4)用决策树审核交通事故是否理赔①计算相关系数②使用决策树审核其中“col_1”是预测结果,0表示理赔,1表示不理赔。

(5)电商平台数据分析母婴电商数据分析可视化仪表盘用户行为分析四、问题讨论及实验心得大数据全链路处理工作流程一般包括六个步骤:数据源、数据汇集、数据湖、数据加工、分析挖掘、数据可视化。

数据源是指原始数据的最初来源,它存贮在企业不同业务部门之间的。

数据汇集是指根据业务目标,把这些不同部门之间原始数据进行整合,转化为容易分析的统一存储格式进行存储的过程。

数据湖是指把数据汇集结果集中存贮起来,以便后续分析挖掘。

这种方式极大的方便用户对数据进行分析和利用。

数据加工是指对数据湖中的数据进行诸如去重、处理空值、数据降维、数据标准化等数据预处理过程,其工作量一般占整个流程的大约60%。

压缩实验报告数据分析

一、实验背景压缩实验是一种常见的力学实验,通过在特定的实验条件下对材料进行压缩,研究其力学性能。

本次实验主要针对某一种材料进行压缩实验,以了解其压缩性能。

本报告将对实验数据进行详细分析,得出实验结果。

二、实验目的1. 研究材料在不同压力下的变形情况;2. 了解材料的弹性模量和屈服强度;3. 分析材料在不同压力下的力学性能。

三、实验原理压缩实验通常采用单轴压缩实验,即在轴向施加压力,使材料发生压缩变形。

根据胡克定律,材料的应力与应变之间存在线性关系,即应力=弹性模量×应变。

当材料达到屈服强度时,应力与应变之间的关系将不再线性,此时材料将发生塑性变形。

四、实验方法1. 实验材料:选取某一种材料作为实验对象;2. 实验设备:压缩试验机;3. 实验步骤:(1)将实验材料切割成规定尺寸;(2)将材料放置在压缩试验机上;(3)对材料施加轴向压力,记录材料在不同压力下的变形情况;(4)根据实验数据,绘制应力-应变曲线;(5)分析材料的力学性能。

五、实验数据及分析1. 实验数据表1:实验数据压力(MPa)应变(%)应力(MPa)0 0 010 0.5 2020 1.0 4030 1.5 6040 2.0 8050 2.5 1002. 数据分析(1)线性阶段:从表1中可以看出,在压力0-30MPa范围内,材料的应力与应变呈线性关系,弹性模量E=40MPa。

这说明材料在该压力范围内具有良好的弹性性能。

(2)非线性阶段:当压力超过30MPa时,应力与应变之间的关系不再线性,材料开始发生塑性变形。

此时,材料的屈服强度约为100MPa。

(3)应力-应变曲线:根据实验数据,绘制应力-应变曲线,如图1所示。

曲线在压力0-30MPa范围内呈线性,压力超过30MPa后,曲线出现拐点,表明材料开始发生塑性变形。

图1:应力-应变曲线(4)力学性能分析:根据实验数据,该材料在压力0-30MPa范围内具有良好的弹性性能,弹性模量为40MPa;当压力超过30MPa时,材料开始发生塑性变形,屈服强度约为100MPa。

SAS数据分析实验报告

SAS数据分析实验报告摘要:本文使用SAS软件对一组数据集进行了分析。

通过数据清洗、数据变换、数据建模和数据评估等步骤,得出了相关的结论。

实验结果表明,使用SAS软件进行数据分析可以有效地处理和分析大型数据集,得出可靠的结论。

1.引言数据分析在各个领域中都扮演着重要的角色,可以帮助人们从大量的数据中提取有用信息。

SAS是一种常用的数据分析软件,被广泛应用于统计分析、商业决策、运营管理等领域。

本实验旨在探究如何使用SAS软件进行数据分析。

2.数据集描述本实验使用了一个包含1000个样本的数据集。

数据集包括了各个样本的性别、年龄、身高、体重等多种变量。

3.数据清洗在进行数据分析之前,首先需要对数据进行清洗。

数据清洗包括缺失值处理、异常值处理和重复值处理等步骤。

通过使用SAS软件中的相应函数和命令,我们对数据集进行了清洗,确保数据的质量和准确性。

4.数据变换在进行数据分析之前,还需要对数据进行变换。

数据变换包括数据标准化、数据离散化和数据归一化等操作。

通过使用SAS软件中的变换函数和操作符,我们对数据集进行了变换,使其符合分析的需要。

5.数据建模数据建模是数据分析的核心过程,包括回归分析、聚类分析和分类分析等。

在本实验中,我们使用SAS软件的回归、聚类和分类函数,对数据集进行了建模分析。

首先,我们进行了回归分析,通过拟合回归模型,找到了自变量对因变量的影响。

通过回归模型,我们可以预测因变量的值,并分析自变量的影响因素。

其次,我们进行了聚类分析,根据样本的特征将其分类到不同的群组中。

通过聚类分析,我们可以发现样本之间的相似性和差异性,从而做出针对性的决策。

最后,我们进行了分类分析,根据样本的特征判断其所属的类别。

通过分类分析,我们可以根据样本的特征预测其所属的类别,并进行相关的决策。

6.数据评估在进行数据分析之后,还需要对结果进行评估。

评估包括模型的拟合程度、变量的显著性和模型的稳定性等。

通过使用SAS软件的评估函数和指标,我们对数据分析的结果进行了评估。

大数据分析实验报告(3篇)

第1篇一、实验背景随着互联网技术的飞速发展,数据已经成为现代社会的重要资源。

大数据分析作为一种新兴的技术手段,通过对海量数据的挖掘和分析,为企业、政府和研究机构提供了决策支持。

本实验旨在通过实际操作,掌握大数据分析的基本流程和方法,提高对大数据技术的理解和应用能力。

二、实验目的1. 熟悉大数据分析的基本流程。

2. 掌握常用的数据预处理方法。

3. 熟悉大数据分析工具的使用。

4. 能够对实际数据进行有效的分析和解读。

三、实验环境1. 操作系统:Windows 102. 数据库:MySQL 5.73. 编程语言:Python 3.74. 大数据分析工具:Pandas、NumPy、Matplotlib、Scikit-learn5. 云计算平台:阿里云四、实验内容(一)数据采集本实验选取某电商平台的用户购买数据作为分析对象,数据包含用户ID、购买时间、商品ID、商品类别、购买金额等字段。

(二)数据预处理1. 数据清洗:去除重复数据、处理缺失值、修正错误数据。

2. 数据转换:将时间戳转换为日期格式,对金额进行归一化处理。

3. 特征工程:提取用户购买行为特征,如购买频率、购买金额等。

(三)数据分析1. 用户画像:分析用户购买偏好、购买频率等特征。

2. 商品分析:分析商品销量、商品类别分布等特征。

3. 购买行为分析:分析用户购买时间分布、购买金额分布等特征。

(四)实验结果与分析1. 用户画像分析根据用户购买数据,我们可以得出以下结论:(1)年轻用户购买频率较高,偏好时尚、电子产品等商品。

(2)中年用户购买金额较高,偏好家居、家电等商品。

(3)老年用户购买频率较低,偏好健康、养生等商品。

2. 商品分析根据商品购买数据,我们可以得出以下结论:(1)电子产品销量最高,其次是家居、家电等商品。

(2)商品类别分布较为均匀,但电子产品、家居、家电等类别占比相对较高。

3. 购买行为分析根据购买时间、购买金额等数据,我们可以得出以下结论:(1)用户购买时间主要集中在上午10点到下午6点。

对数据进行聚类分析实验报告

对数据进行聚类分析实验报告数据聚类分析实验报告摘要:本实验旨在通过对数据进行聚类分析,探索数据点之间的关系。

首先介绍了聚类分析的基本概念和方法,然后详细解释了实验设计和实施过程。

最后,给出了实验结果和结论,并提供了改进方法的建议。

1. 引言数据聚类分析是一种将相似的数据点自动分组的方法。

它在数据挖掘、模式识别、市场分析等领域有广泛应用。

本实验旨在通过对实际数据进行聚类分析,揭示数据中的隐藏模式和规律。

2. 实验设计与方法2.1 数据收集首先,我们收集了一份包含5000条数据的样本。

这些数据涵盖了顾客的消费金额、购买频率、地理位置等信息。

样本数据经过清洗和预处理,确保了数据的准确性和一致性。

2.2 聚类分析方法本实验采用了K-Means聚类算法进行数据分析。

K-Means算法是一种迭代的数据分组算法,通过计算数据点到聚类中心的距离,将数据点划分到K个不同的簇中。

2.3 实验步骤(1)数据预处理:对数据进行归一化和标准化处理,确保每个特征的权重相等。

(2)确定聚类数K:通过执行不同的聚类数,比较聚类结果的稳定性,选择合适的K值。

(3)初始化聚类中心:随机选取K个数据点作为初始聚类中心。

(4)迭代计算:计算数据点与聚类中心之间的距离,将数据点划分到距离最近的聚类中心所在的簇中。

更新聚类中心的位置。

(5)重复步骤(4),直到聚类过程收敛或达到最大迭代次数。

3. 实验结果与分析3.1 聚类数选择我们分别执行了K-Means算法的聚类过程,将聚类数从2增加到10,比较了每个聚类数对应的聚类结果。

通过对比样本内离差平方和(Within-Cluster Sum of Squares, WCSS)和轮廓系数(Silhouette Coefficient),我们选择了最合适的聚类数。

结果表明,当聚类数为4时,WCSS值达到最小,轮廓系数达到最大。

3.2 聚类结果展示根据选择的聚类数4,我们将数据点划分为四个不同的簇。

实验报告数据分析与结果

实验报告数据分析与结果本实验旨在通过对数据的分析与结果展示,探究实验的目的和研究问题,并对实验结果进行解读和总结。

以下是对实验数据的详细分析和结果呈现。

1. 实验设计与方法本实验采用了随机对照组设计,选取了100名参与者,随机分为实验组和对照组。

实验组接受了特定的处理,而对照组则未接受处理。

实验过程中,我们记录了各组的数据,并进行了详细的数据分析。

2. 数据分析2.1 实验组数据分析实验组数据主要包括参与者的个人信息、实验前后的测量数据等。

我们对实验组的数据进行了统计学分析,包括平均值、标准差、相关性等指标。

结果显示,在实验处理后,实验组的测量数据发生了显著变化。

2.2 对照组数据分析对照组数据用于与实验组数据进行对比分析,以验证实验结果的可靠性和有效性。

通过对对照组的数据进行统计学分析,我们发现对照组的测量数据变化较小,与实验组的差异明显。

3. 实验结果展示3.1 实验组结果展示根据实验组的数据分析结果,我们绘制了相关的图表和图像,以直观地展示实验结果。

例如,我们可以使用柱状图、折线图或饼图来表示实验前后的数据变化趋势。

同时,我们还可以使用散点图或箱线图来展示不同参与者之间的差异。

3.2 对照组结果展示对照组的结果展示与实验组类似,通过图表和图像的形式,直观地展示对照组的数据变化情况。

通过对实验组和对照组结果的对比,我们可以更加清晰地了解实验处理的效果。

4. 结果解读与总结通过对实验数据的分析和结果展示,我们可以对实验的目的和研究问题进行解读和总结。

根据数据分析结果,我们可以得出结论,并进一步讨论实验的意义和影响。

同时,我们还可以提出实验的局限性和改进方向,以便未来的研究者进行进一步的研究和实验设计。

总之,实验报告数据分析与结果的呈现是实验研究中非常重要的一环。

通过准确地分析数据并清晰地展示结果,我们可以对实验的效果和结论进行客观的评估和解读。

希望本次实验的结果能够为相关领域的研究提供有价值的参考和启示。

数据整理与分析实验报告

数据整理与分析实验报告答案:在数据整理与分析的实验中,我们通过收集相关数据并进行整理和分析,得出了以下结论:1. 数据整理:在实验中,我们首先收集了一系列相关数据,如观察结果、测量结果或调查结果。

然后,我们对这些数据进行整理,包括数据录入、数据清洗和数据转换等步骤。

通过整理数据,我们能够更好地理解和分析数据。

2. 数据分析:在数据整理完成后,我们进行了数据分析。

数据分析旨在揭示数据中的模式、趋势和关联。

具体的数据分析方法包括描述统计分析、推论统计分析和数据可视化等。

3. 描述统计分析:描述统计分析主要用于总结和展示数据的基本特征。

在实验中,我们使用了各种描述统计指标,如平均值、中位数、标准差和频率分布等。

通过描述统计分析,我们能够对数据有一个整体的了解,并识别出数据的中心趋势和变异程度。

4. 推论统计分析:推论统计分析是一种基于样本数据对总体进行推断的方法。

在实验中,我们可以使用推论统计分析来验证假设、估计参数或比较样本之间的差异。

常用的推论统计方法包括假设检验、置信区间估计和方差分析等。

通过推论统计分析,我们能够从样本数据中得出对总体的一般结论。

5. 数据可视化:数据可视化是将数据以图表或图形的形式展示出来,有助于更好地理解和传达数据。

在实验中,我们可以使用各种数据可视化工具和技术,如柱状图、折线图、散点图和饼图等。

通过数据可视化,我们能够直观地呈现数据的分布、趋势和关联。

扩展和深入分析:在实验中,数据整理和分析对于科学研究和决策制定都至关重要。

它们帮助我们从海量的数据中提取有用的信息,并为问题的解决提供依据。

数据整理是数据分析的基础。

在数据整理过程中,我们需要确保数据的准确性和完整性。

这包括检查数据录入的错误、处理缺失数据和异常值,以及将数据转换成适合分析的格式。

通过数据整理,我们能够消除数据中的噪声和干扰,得到更可靠和可信的数据。

数据分析是从数据中提取有用信息的过程。

描述统计分析帮助我们了解数据的基本特征,如数据的中心趋势和变异程度。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

实验名称 实验五 非参数检验

课程名称 数据分析 实验时间 实验地点

组号 同组人 成绩

一、实验目的:

1、熟练掌握SPSS单样本非参数检验的数据组织方式和

具体操作,并能读懂输出结果。

2、会SPSS独立样本非参数检验的数据组织方式和具体

操作,并能读懂输出结果。

3、会SPSS配对样本非参数检验的数据组织方式和具体

操作,并能读懂输出结果。

二、实验环境:

Windows XP,SPSS 13.0

三、实验内容和步骤:

实验内容:

1、六个企业生产汽车,每小时的产量如下表所示,试判断这些企业的生产能力有无

显著性差异?

企业 企业A 企业B 企业C 企业D 企业E 企业F 总计 企

A BC

产量/小时 41 66 45 56 49 43 300

2、掷一枚硬币40 次,出现28次正面和12次反面,试问这枚硬币是否均匀?

3、选择适当的非参数检验方法,对居民储蓄调查数据进行分析,分析本次存款金额的

总体分布与正态分布是否存在显著性差异。

4、选择适当的非参数检验方法,对居民储蓄调查数据进行分析,分析不同常住地人群

本次存款金额的总体分布是否存在显著性差异。

5、

为研究长跑运动对增强普通高校学生的心功能效果,对某院15名男生进行实验,经

过5 个月的长跑锻炼,锻炼前后的晨脉数据如下表所示。

锻炼前 70 76 56 63 63 56 58 60 65 65 75 66 56 59

锻炼后 48 54 60 64 48 55 54 45 51 48 56 48 64 50

选择适当的非参数检验方法,分析锻炼前后的晨脉数据是否来自同一分布。

实验步骤: