GPU加速与L-ORB特征提取的全景视频实时拼接

多路高清YUV视频GPU实时拼接研究

多路高清YUV视频GPU实时拼接研究王震;许晓航;王静;李圣;郑宏【摘要】To improve the real-time performance of high-definition video stitching,a stitching method of GPU-based real-time multi-channel high-definition YUV video is proposed.Firstly,the perspective model of YUV422 image stitching is deduced,and then parallel optimization of the stitching steps including perspective warping and image blending are realized and performed on GPU by Compute Unified DeviceArchitecture(CUDA)technology.The experimental results show that,on the condition of implementing four-channel 1080p video stitching,the method in this paper achieves 20%~40% improvement in real-time performance over RGB color model-based stitching method on different GPU,and video frame rate of 33 frame per second on GTX 780.%为提高高清视频拼接的实时性能,提出一种基于GPU的多路高清YUV视频实时拼接方法,推导出YUV422图像拼接中的透视模型,并结合计算统一设备架构技术,实现透视变换、无缝融合等关键拼接步骤在GPU上的并行优化.在4路1080p高清视频上的实验结果表明,相比基于RGB颜色模型的拼接方法,该方法的实时拼接性能在不同GPU架构上有20%~40%的提升,并且在GRX780上能达到33 frame/s的视频帧率.【期刊名称】《计算机工程》【年(卷),期】2016(042)012【总页数】7页(P314-320)【关键词】视频拼接;YUV颜色模型;透视模型;图形处理器;计算统一设备架构【作者】王震;许晓航;王静;李圣;郑宏【作者单位】武汉大学电子信息学院,武汉 430072;湖北省视觉感知与智能交通技术研发中心,武汉 430072;武汉大学电子信息学院,武汉 430072;湖北省视觉感知与智能交通技术研发中心,武汉 430072;武汉大学电子信息学院,武汉 430072;湖北省视觉感知与智能交通技术研发中心,武汉 430072;武汉大学电子信息学院,武汉430072;湖北省视觉感知与智能交通技术研发中心,武汉 430072;武汉大学电子信息学院,武汉 430072;湖北省视觉感知与智能交通技术研发中心,武汉 430072【正文语种】中文【中图分类】TP37在使用多相机监控大范围区域时,可以通过视频拼接来获得宽视野视频,这样不仅方便连续监控运动目标,而且降低了视频数据的冗余度。

基于GPU加速的视觉SLAM算法研究

基于GPU加速的视觉SLAM算法研究随着人工智能技术的不断发展,机器视觉的应用越来越广泛。

在机器视觉中,SLAM技术是一个非常重要的研究方向。

SLAM 技术可以实现对未知环境的建图和自主导航,是机器人和自动驾驶等领域关键技术之一。

然而,SLAM技术的计算量非常大,实时性较差,这也就限制了SLAM技术在实际应用中的广泛应用。

为了解决这一问题,近年来研究者们开始将GPU加速技术应用于视觉SLAM算法中,将CPU和GPU的计算能力相结合,实现了视觉SLAM算法的实时运行和加速。

本文将介绍基于GPU加速的视觉SLAM算法研究的最新进展和应用。

一、GPU在SLAM中的应用随着硬件技术的不断进步,GPU的计算能力越来越强大,现在的GPU已经可以实现比CPU更加快速的并行计算。

而在SLAM 算法中,大量的计算任务可以分为许多小的计算单元,在GPU并行计算下可以更加高效地完成相关任务。

因此,GPU加速技术被应用于SLAM算法的研究中,可以高效地实现对大量数据的处理和追踪。

二、GPU加速的实时、快速SLAM算法目前,基于GPU加速的实时、快速视觉SLAM算法已经成为研究的热点之一。

这些算法可以处理多种不同类型的视觉数据,如RGB-D、单目或多目摄像头等,并利用GPU并行计算快速生成3D地图和位姿估计。

以下是目前研究较为成熟的一些GPU加速SLAM算法:1.ORB-SLAM2:ORB-SLAM2是一种很流行的基于单目相机的视觉SLAM算法。

相比于其前身ORB-SLAM,ORB-SLAM2具有更高的运行速度和更好的性能表现。

通过对于ORB特征点的跟踪和匹配,并结合GPU并行计算的技术,ORB-SLAM2可以生成高精度的3D地图和相机路径等信息。

2.MVSLAM:MVSLAM是一种基于多目相机的视觉SLAM算法,可以快速、准确地建立3D场景模型。

MVSLAM主要依靠GPU并行计算中的子图算法来实现SLAM算法的加速,使其具有更快的执行速度和更好的计算性能。

全景图像拼接

实验目的:图像拼接的目的是将有衔接重叠的图像拼成一张高分辨率全景图像,它是计算机视觉、图像处理和计算机图形学等多学科的综合应用技术。

图像拼接技术是指将对同一场景、不同角度之间存在相互重叠的图像序列进行图像配准,然后再把图像融合成一张包含各图像信息的高清图像的技术。

本实验是根据输入的只有旋转的一系列图像序列,经过匹配,融合后生成一张360度的全景图像。

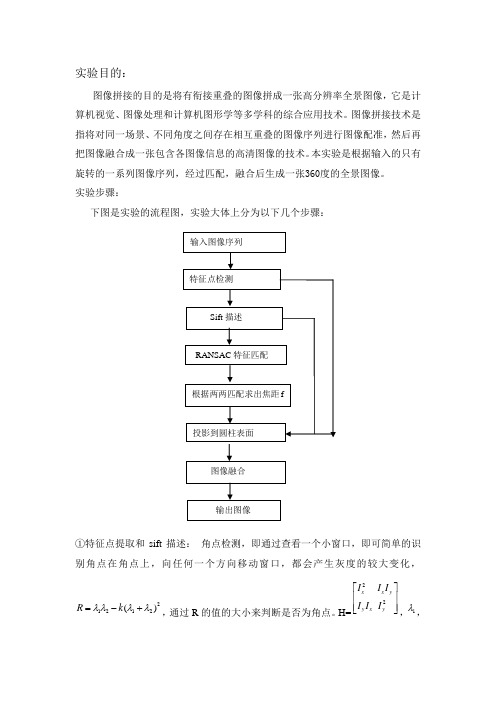

实验步骤:下图是实验的流程图,实验大体上分为以下几个步骤:①特征点提取和sift 描述: 角点检测,即通过查看一个小窗口,即可简单的识别角点在角点上,向任何一个方向移动窗口,都会产生灰度的较大变化,21212()R k λλλλ=-+,通过R 的值的大小来判断是否为角点。

H=22x x y y x y I I I I I I ⎡⎤⎢⎥⎢⎥⎣⎦,1λ,输入图像序列 特征点检测 Sift 描述RANSAC 特征匹配根据两两匹配求出焦距f投影到圆柱表面图像融合输出图像为矩阵的两个特征值。

实验中的SIFT描述子是对每个角点周围进行4个区域2进行描述,分别是上下左右四个区域,每个方块大小为5*5,然后对每个方块的每个点求其梯度方向。

SIFT方向共有8个方向,将每个点的梯度方向做统计,最后归为8个方向中的一个,得到分别得到sift(k,0),sift(k,1)···sift(k,8),k为方块序列,0-8为方向,共有四个方块,所以生成32维的向量,然后按幅值大小对这32维向量进行排序,并找出最大的作为主方向。

图为角点检测和sift描述后的图②.如果直接根据描述子32维向量进行匹配的话,因为噪声的影响,角点检测的不准确,会导致找出一些错误的匹配对,如何去掉这些错误的匹配呢?RANSAC算法是基于特征的图像配准算法中的典型算法,其优点是:可靠、稳定、精度高,对图像噪声和特征点提取不准确,有强健的承受能力,鲁棒性强,并且具有较好的剔出误匹配点的能力,经常被使用在图像特征匹配中。

基于GPU加速的视觉SLAM技术研究

基于GPU加速的视觉SLAM技术研究 近年来,在自动驾驶、智能家居、机器人、无人机等领域,SLAM技术已经成为一个热门的话题。

SLAM是指同时定位和建图(Simultaneous Localization and Mapping)技术,它通过传感器获取环境信息,实时地构建场景地图,并实现机器人或自动驾驶汽车在地图中的定位,从而将机器人或自动驾驶汽车引向目标点。

GPU是指图形处理器(Graphics Processing Unit),它的强大计算能力已经被应用到很多领域,如游戏、科学计算等,近年来也被应用在SLAM技术中,成为加速SLAM技术的重要工具。

在SLAM技术中,图像处理是非常重要的环节。它需要对传感器采集到的原始数据进行处理,并提取其中的特征点。然后利用这些特征点,进行匹配和优化,最终得到地图和机器人的姿态。由于SLAM的计算量较大,传统的CPU计算方式效率较低,不能满足实时性的要求。而GPU的并行计算能力恰好能够提高计算效率,从而使SLAM技术得以实时运行。这也使得基于GPU加速的视觉SLAM技术成为了一个热门研究课题。

基于GPU加速的视觉SLAM技术是利用GPU的高速并行计算能力,加快SLAM算法的运算速度,提高SLAM技术的实时性。其中较为常用的方法是将SLAM算法中的计算任务转移到GPU上运行。例如,在ORB-SLAM2算法中,将特征点检测、特征描述和匹配等任务都由GPU完成,大大提高了算法的实时性。

另外,由于GPU在图形处理上的优势,还可以对SLAM技术中的图像信息进行处理和优化,提高算法的准确性。例如,在Bundle Adjustment优化中,可以利用GPU对图像信息进行快速的Blur处理,提高BA算法的精度和稳定性。

除了GPU的并行计算能力外,GPU的显存也是基于GPU加速的视觉SLAM技术不可或缺的一部分。其显存可以存储原始图像、特征点、特征描述等信息,为运算提供即时的快速访问,从而提高了算法的效率。而且在SLAM算法中,由于需要反复的读写内存,显存的高速缓存能够避免CPU主存与GPU的频繁IO操作,使得SLAM算法更为高效快速。

全景图像拼接技术研究

全景图像拼接技术研究摘要:随着VR/AR技术的逐渐普及,全景图像呈现出了广泛的应用前景,本文介绍了全景图像拼接技术的实现方式、优缺点,同时对相关算法进行了分析和评估,并对未来的发展方向进行了展望。

第一章:绪论VR/AR技术的普及使得全景图像具备了非常广泛的应用前景,在游戏、旅游等领域得到了广泛的使用,同时也受到了科学家们的广泛关注,为了实现高质量的全景图像呈现有时需要进行多张图像的拼接,为此我们需要一种高效、准确的全景图像拼接技术。

第二章:全景图像拼接技术实现1.传统拼接方法传统的全景图像拼接方法主要是基于图像对接,并在对接时消除拼接位置的重叠部分。

这种方法需要针对拼接位置的交叉部分进行大量的处理,需要进行复杂的图像变换、像素的重新分配等操作,因此对计算资源有较高的需求,同时也会导致一定的误差。

2.基于特征点匹配的拼接方法基于特征点匹配的拼接方法主要是利用图像中的特征点来做匹配,并得出拼接后图像的变换矩阵,然而使用这种方法需要针对图像提前进行特征提取,同时在匹配阶段还需要进行特征点的匹配和筛选,这意味着这种方法会带来更多的计算开销,且针对具体的图像需要选择不同的特征点提取算法。

3.基于深度学习的拼接方法近年来,随着深度学习技术的发展,越来越多的学者开始尝试将其应用到全景图像拼接领域中,这种方法主要是根据大量的训练数据,使用卷积神经网络进行特征提取和图像匹配,这种方法能够克服传统拼接方法的缺陷,大幅度减小计算开销,并且还能够有效避免图像的失配问题。

第三章:全景图像拼接技术优缺点分析1.传统拼接方法优点:传统拼接方法较为简单易懂,可以在不需要大量计算资源和训练数据的情况下进行拼接。

缺点:算法难以消除图像拼接时产生的重叠区域,同时也难以保证拼接后的图像的准确性。

2.基于特征点匹配的拼接方法优点:在图像识别和匹配方面有较高的准确率,能够有效提高拼接图像的质量和准确性。

缺点:特征点的提取和匹配需要耗费大量计算资源,同时对于不同的图像场景需要选择不同的特征点提取算法。

一种无人机地理视频影像实时拼接方法

一种无人机地理视频影像实时拼接方法摘要:随着无人机技术的快速进步,无人机地理视频影像实时拼接方法成为了数字地理信息处理领域的一个重要探究方向。

本文提出了一种基于无人机得到的视频影像的实时拼接方法,该方法能够有效地将无人机所拍摄的多个小区域的视频影像拼接成整个区域的地理视频影像。

通过试验验证,本方法具有较高的拼接质量和实时性能,能够满足实际应用的需求。

关键词:无人机;地理视频影像;实时拼接;拼接质量;实时性能一、引言无人机技术的广泛应用使得得到地理信息变得更加容易。

无人机可以高空俯瞰地表,拍摄高区分率的地理视频影像。

然而,由于无人机平台的挪动性和拍摄条件的不确定性,往往导致无人机所拍摄的视频影像存在不连续、重叠度不高等问题,给后续的地理信息处理带来了困难。

为了解决这一问题,本文提出了。

该方法基于无人机得到的连续视频影像,通过图像处理和拼接算法,将多个小区域的视频影像拼接成整个区域的地理视频影像。

二、实时拼接方法2.1 视频预处理起首,对无人机所拍摄的视频进行预处理。

预处理包括视频帧的平滑处理、去噪和颜色校正等步骤。

平滑处理可以降低视频帧之间的不连续性;去噪可以缩减图像中的噪声干扰;颜色校正可以使得不同视频帧之间的颜色一致。

2.2 特征点提取和匹配通过特征点提取和匹配可以得到视频帧之间的相对位置干系。

在特征点提取过程中,我们接受了标准不变特征变换(SIFT)算法,该算法能够在不同标准和旋转角度下提取到稳定的特征点。

然后,使用特征描述子对提取到的特征点进行匹配,找到对应的特征点对。

通过特征点的匹配,可以得到视频帧之间的相对运动干系。

2.3 图像拼接基于得到的相对运动干系,我们可以对视频帧进行拼接。

起首,选择一个参考帧作为基准帧,将其他视频帧与其对齐。

然后,依据特征点的匹配结果,使用全局变换模型对视频帧进行变换,使得它们与参考帧对齐。

最后,将对齐后的视频帧进行叠加,得到整个区域的地理视频影像。

三、试验结果与分析为了验证本方法的有效性,我们进行了一系列试验。

全景图像拼接方法研究与实现

基于模型的配准算法则假设图像之间存在某种数学模型,通过拟合该模型实 现图像配准。而基于全局优化的配准算法则通过优化全局目标函数来寻找最优的 配准结果。

四、融合算法

融合算法是将多个待拼接图像融合成一个完整的全景图像的过程,也是全景 图像拼接的关键步骤之一。在融合过程中,需要考虑如何平滑地过渡不同图像之 间的边界,以及如何避免出现明显的视觉瑕疵。常见的融合算法包括基于多频段 融合的融合算法、基于泊松方程的融合算法和基于深度学习的融合算法等。

四、结论

本次演示主要探讨了360全景图像拼接技术的原理、方法和实现过程。通过 对不同方法的比较和分析,发现基于特征匹配的方法是目前最常用的方法。在实 现全景图像拼接时,需要选择合适的拼接算法并对图像进行预处理、找到匹配点 并计算变换参数、进行图像拼接和后处理等步骤。通过对这些步骤的详细介绍, 可以为相关领域的研究人员提供有益的参考。

2、处理速度:在保证拼接效果的同时,本次演示方法优化了算法结构,减 少了计算量和时间复杂度。相较于传统方法,本次演示方法在处理速度上有明显 提升。

3、拼接效果:通过采用基于多频段融合的图像融合算法,本次演示方法在 拼接缝隙处理上取得了良好的效果,有效避免了拼接痕迹和色差问题。同时,我 们还引入了区域生长算法对拼接结果进行优化,使全景图像更加自然、连续。

研究现状

近年来,许多研究者提出了各种全景图像拼接方法,取得了显著成果。然而, 现有的方法在处理复杂场景、大尺度变换和多视角图像拼接时仍存在一定局限性。 主要体现在以下几个方面:

1、图像分割:在图像拼接过程中,如何准确地将图像分割成不同的区域是 一个难题。现有的分割方法难以适应各种复杂场景,且在处理色彩、亮度变化时 效果不理想。

全景图像拼接方法研究与实现

全景拼接的步骤

全景拼接的步骤

全景拼接是将多张相邻的图片拼接成一张全景图的技术。

在进行全景拼接时,需要经过以下步骤:

1. 图像采集:首先需要采集多张相邻的图片,这些图片需要有一定的重叠区域,以便后续的图像拼接。

2. 图像预处理:在进行全景拼接之前,需要对采集到的图片进行预处理,包括图像校正、去除畸变等操作,确保每张图片的几何形状和光线条件一致。

3. 特征提取:通过特征提取算法,识别每张图片中的关键特征点,这些特征点具有一定的稳定性和可重复性。

4. 特征匹配:将相邻图片中的特征点进行匹配,确定它们之间的对应关系。

5. 图像变换:根据特征点的对应关系,对相邻图片进行图像变换,使它们的几何形状和光线条件一致。

6. 图像拼接:将变换后的相邻图片进行拼接,生成全景图像。

7. 后期处理:对全景图像进行后期处理,包括色彩校正、去除拼接痕迹等操作,以提高全景图像的质量。

全景拼接技术在旅游、地图制作等领域有着广泛的应用,可以帮助人们更好地了解和认识周围的环境。

基于GPU的无人机遥感影像快速拼接

d 〇i :10.3969/j .issn .1672-4623.2017.02.0032017年2月 地理空间信息Feb.,2017第 15 卷第 2 期GEOSPATIAL INFORMATIONV 〇l.15,No.2基于G PU 的无人机遥感影像快速拼接孙和利\彭政杰2,李娟3,陈镇4(1.武汉大学遥感信息工程学院,湖北武汉430079;2.武汉市黄陂区木兰房产测绘队,湖北武汉430300 ;3.武汉市黄陂区木兰房产测绘队,湖北武汉430300;4.武汉市房产测绘中心,湖北武汉430015)摘要:近年来,无人机遥感技术得到较快的发展,无人机遥感技术有着实时性强、灵活性强、低成本以及获取影像分辨率高的特点,在处理应急响应任务时,运用无人机遥感技术,优势极为明显。

在无人机进行对地航拍时,所获取的是单张影像,由 于像幅的限制,影像并不能覆盖完整的目标区域,相邻的多张影像都有着一定的重叠度,利用重叠区域来将多幅影像依次拼接, 获得目标区域的一幅完整影像。

随着各种传感器技术的提升,无人机上的相机所获取到的影像的分辨率越来越高,这对影像拼 接的速度提出了新的要求。

基于无人机遥感影像的特点,采用S IF T 算子对无人机遥感影像进行拼接工作,并在C U D A 平台下 对配准算法进行加速处理,从而提高影像拼接的速度。

关键词:无人机遥感;影像拼接;C P U ;G P U ;C U D A ;影像配准中图分类号:P 237文献标志码:B文章编号:1672-4623 (2017) 02-0009-03目前,根据无人机遥感技术的研究状况分析来看, 无人机遥感影像的像幅较小,需要大量的单幅影像才 能完整地覆盖整个研究区域,另外,如果要得到完整 的正射影像,需要在拼接的过程中花费大量时间,所以, 研究如何提高无人机遥感影像的拼接速度,对于各种 灾害的应急响应有着非常重要的意义。

1无人机遥感影像拼接原理及实现i .i影像特征匹酉己影像匹配是进行影像拼接的前提,按照提取特征的层次来看,可以分为三大类:基于灰度,基于特征 以及基于解译的影像匹配[1]。

基于FPGA的全景视频图像拼接的设计与实现

电子设计工程Electronic Design Engineering第26卷Vol.26第2期No.22018年1月Jan.2018收稿日期:2017-03-02稿件编号:201703030作者简介:李勇(1982—),男,甘肃宁县人,硕士,高级技师,讲师。

研究方向:通信、网络工程。

近年来视频处理技术日新月异,以全景式、沉浸式用户体验为对象的视频技术开发已成为研究热点。

FPGA 器件以高性能、高可靠性、高运行速度、低设计周期、低成本和设计灵活等已成为视频图像处理的优先选项。

目前实时全景摄像机已充分融入网络传输、云计算和大数据等新兴技术,发展迅猛。

本次设计以FPGA 为平台,采用SIFT 算法,对系统采取优化设计,提出一种拼接全景视频图像的改进方法,旨在探索弥补在拼接中的实时性低的不足。

设计中借助ARM 平台来辅助进行算法换算及图像信号的压缩和网络传输,将图像拼接参数送达FPGA 最小系统处理最终呈现出实时全景图像。

文中重点探究FPGA 平台中的全景图像的拼接模块部分。

1视频图像拼接算法尺度不变特征转换(Scale Invariant feature transform ,SIFT )算法是由David G.Lowe 创立的,它有以下几个基本步骤:1.1构建图像尺度空间SIFT 算法中对图像的尺度构建是通过高斯算子的差分算子DOG 算子实现的,G (x ,y ,σ)为高斯算子,D (x ,y ,σ)为差分算子。

σ是尺度因子,它的较大值表示视频图像的整体轮廓特点,它的较小值显示图像的局部细微特点。

G (x ,y ,σ)=12πσ2e-x 2+y 22δ2(1)基于FPGA 的全景视频图像拼接的设计与实现李勇,王磊,钱罕林(新疆轻工职业技术学院信息与软件分院,新疆乌鲁木齐830021)摘要:针对多端全景摄像机在视频图像拼接过程中的耗时长的问题,探索采用一种设计方法,通过从算法和系统优化设计入手,采用简化的SIFT 算法,并且将FPGA 平台与此算法计算分离,转而由ARM 来承担图像配准参数的计算,由FPGA 平台依据参数结果进行全景视频图像的拼接。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

计算机研究与发展Journal of Com puter R esearch and Development D O I:10. 7544/issn l000-1239. 2017. 2017009554(6) :1316-1325 , 2017GPU加速与L-ORB特征提取的全景视频实时拼接杜承垚1袁景凌1;2陈旻骋1李涛3U武汉理工大学计算机科学与技术学院武汉430070)2(交通物联网技术湖北省重点实验室(武汉理工大学)武汉430070)3(佛罗里达大学电气与计算机工程系美国佛罗里达州盖恩斯维尔32611)(d u ch en g y a o@w h u t.ed )Real-Time Panoramic Video Stitching Based on GPU Acceleration Using Local ORB Feature ExtractionD u C h e n g y a o1 ,Y u a n Jingling1,2 ,C h e n M i n c h e n g1 ,and Li T a o31(S c h o o l o f C o m p u ter S cien ce a n d T e c h n o lo g y , W u han U n iv ersity o f T e c h n o lo g y , W u han430070)2(H u b e i K e y L a b o r a to r y o f T r a n s p o r ta tio n In tern et o f T h in g s (W u h an U n iv ersity o f T e c h n o lo g y ) , W u han430070)3(D ep a r tm e n t o f E le c t r ic a l a n d C o m p u ter E n g in e e r in g , U n iv ersity o f F l o r i d a , G a in e s v ille, F L,U SA32611)Abstract Panoramic video i s a sort of video recorded at the same point of view to record the full scene.T h e collecting devices of panoramic video are getting widespread attention with the development of V R and live-broadcasting video technology.Nevertheless?C P U and G P U are required to possess strong processing abilities to m a k e panoramic video.T h e traditional panoramic products depend on large equipment or post processing,which results in high power consumption,low stability,unsatisfying performance in real time and negative advantages to the information security.This paper proposes a L-O R B feature detection algorithm.T h e algorithm optimizes the feature detection regions of the video images and simplifies the support of the O R B algorithm in scale and rotation invariance.T h e n the features points are matched by the multi-probe L S H algorithm and the progressive sample consensus (P R O S A C)i s used to eliminate the false matches.Finally,w e get the mapping relation of image mosaic and use the multi-band fusion algorithm to eliminate the gap between the video.In addition,w e use the Nvidia Jetson T X1heterogeneous embedded system that integrates A R M A57 C P U and Maxwell G P U,leveraging its Teraflops floating point computing power and built-in video capture,storage,and wireless transmission modules to achieve multi-camera video information real-time panoramic splicing system,the effective use of G P U instructions block, thread,flow parallel strategy to speed up the image stitching algorithm.T h e experimental results s h o w that the algorithm mentioned can improve the performance in the stages of feature extraction of images stitching and matching,the running speed of which i s 11 times than that of the traditional O R B algorithm and 639 times than that of the traditional S I F T algorithm.T h e performance of the system accomplished in the article i s59 times than that of the former embedded o n e,while the power dissipation i s reduced to 10 W.收稿日期:2017-02-27;修回日期:2017-04-13基金项目:国家自然科学基金项目(61303029)This work was supported by the National Natural Science Foundation of China (61303029).通信作者:袁景凌(yuanj ingling@)杜承垚等:GP U加速与L -OR B特征提取的全景视频实时拼接1317Key words panoramic video ; image stitching ; heterogeneous computing ; embedded G P U ; orientedF A S T and rotated B R I E F (O R B )摘要全景视频是在同一视点拍摄记录全方位场景的视频.随着虚拟现实(V R )技术和视频直播技术 的发展,全景视频的采集设备受到广泛关注.然而制作全景视频要求C P U 和G P U 都具有很强的处理 能力,传统的全景产品往往依赖于庞大的设备和后期处理,导致高功耗、低稳定性、没有实时性且不利于 信息安全.为了解决这些问题,首先提出了 L -O R B 特征点提取算法,该算法优化了分割视频图像的特征 检测区域以及简化O R B 算法对尺度和旋转不变性的支持;然后利用局部敏感H a s h (Multi-ProbeL S H )算法对特征点进行匹配,用改进的样本一致性(progressive sample consensus ,P R O S A C )算法消除误匹配,得到帧图像拼接映射关系,并采用多频带融合算法消除视频间的接缝.此外,使用整合了A R M A 57 C P U 和Maxwell G P U 的Nvidia Jetson T X 1异构嵌入式系统,利用其Teraflops 的浮点计算能力和内建的视频采集、存储、无线传输模块,实现了多摄像头视频信息的实时全景拼接系统,有效地 利用G P U 指令的块、线程、流并行策略对图像拼接算法进行加速.实验结果表明,算法在图像拼接的特 征提取、特征匹配等各个阶段均有很好的性能提升,其算法速度是传统O R B 算法的11倍、传统S I F T 算法的639倍;系统较传统的嵌入式系统性能提升了 29倍,但其功耗低至10W .关键词全景视频;图像拼接;异构计算;嵌入式G P U ;O R B中图法分类号T P 391.41全景视频是在同一^视点拍摄记录全方位场景的 视频[13].全景视频在视频监控、机器人视觉、数字城 市、赛事直播以及新兴的虚拟现实中都具有广泛的 应用领域.利用全景摄像获取的全景视频,可以在虚 拟现实中进行任意角度的沉浸式交互漫游、旋转以 及缩放观察[4];将全景设备应用于军事监控,将提高 部队的战场感知能力,进而增强部队的单兵作战能 力;应用于无人机遥感、机器人视觉,将克服以往单 一摄像头视野有限的问题,增加探测及识别效率.生成全景视频需要对视频中的每一帧进行图像配准和图像融合,如图1所示.图像配准的关键为特 征提取[5].曹世翔等人[6]提出一种映速有效的边缘 特征点提取方法,实现多分辨率图像的融合拼接.该 方法通过构建边缘图像的G a u s s 金字塔,从中提取 稳定的特征点完成图像配准,并复用金字塔信息实 现图像融合,很大地缩短整体拼接的时间.EthanRublee 于 2011 年提出 O R B ( oriented F A S T and rotated B R I E F )算法[7],对F A S T 角点加人尺度不变特性,解决了 B R I E F ( binary robust independentelement feature )的旋转不变性和噪声敏感问题,效Fig. 1 Im age stitching pipeline图1图像拼接流程1318计算机研究与发展2017, 54(6)率较S I F T算法提升了 100倍.姜桂圆等人[8]提出一种S I F T特征的分布式并行提取算法D P-S I F T,该算法根据S I F T特征算法特点,设计了高度宽度受限的数据块划分方法、数据分配方法以及特征信息调整方法,并优化了数据分块原则与数据发送策略,极大减少了数据通信时间,提高算法的效率.崔哲等人[9]提出了在C U D A并行计算环境下的扩展S U R F算法,该算法在低分辨率下已经满足了实时性.?&1*1^[1°]在C U D A并行计算环境下应用O R B算法进行3D重建.智喜洋等人™实现了基于C UD A的实时图像配准和定位系统,较C P U快20倍,且满足实时处理的要求.创建全景图像需要经过很复杂的采集及拼接过程,因此要求C P U和G P U都具有很强的处理能力[12].传统的实时拼接设备配备了广角镜头和F P G A等处理组件,其成像分辨率低且无法通过复杂算法对图像进行细致的矫正™;此外,传统的基于软件的方法是不实时的[1416],因为图像被摄像机捕获之后,需要离线传输到拼接软件进行拼接.这为广大学者提出了新的挑战.本文主要工作如下:1)提出了 L-O R B图像特征提取算法,该算法 优化分割了特征检测区域,并对尺度不变性、旋转不变性进行了简化.然后利用多探寻的局部敏感H a s h (Multi-Probe L S H)算法对特征点进行匹配,用改进白勺样本 ~^致性(progressive sample consensus,P R O S A C)算法消除误匹配,得到帧图像拼接映射关系,并采用多频带融合算法消除视频间的接缝.2)利用整合了 A R M A57 C P U和 Maxwell G P U 的Nvidia Jetson T X1异构嵌人式系统中Teraflops的浮点计算能力和内建的视频采集、存储、无线传输模块,实现了多摄像头视频信息的实时全景拼接系统.有效地利用了 G P U指令的块、线程、流并行策略对图像拼接算法进行加速.实验结果表明本文的算法在图像拼接的特征提取、特征匹配等各个阶段均有很好的性能提升.1 L-O R B图像特征提取算法传统的图像拼接需要对整个图片的内容进行特征点检测及匹配,匹配到的特征点需要兼顾尺度不变与旋转不变性.在全景摄像机群中,相机的相对位置和方向固定不变,通过预先矫正好的参数对图像进行预处理,可以降低特征点检测的时空复杂度.L-O R B图像特征提取算法首先通过相机之间的位置参数对图像进行粗略的对齐,然后计算图像 的视野重合部分,得出特征点的分布范围[17],减少 了检测区域面积;L-O R B算法将F A S T特征点与 Harris角点度量方法相结合,并生成B R I E F特征描 述因子,相对于原始的O R B算法简化了尺度、旋转 不变性,使得效率大幅提升.1.1几何调整以及分割特征检测区域图像拼接需要提取图片之间重叠区域的特征点,我们通过全景摄像机群的相对位置计算出每个相机视野的重叠区域,以减少特征点检测的数据规模.全景摄像机群是将摄像机分散均勻地放置在以 一个点为圆心等半径的圆上,再与顶部、底部的摄像 机构成摄像机阵列[18].如图2所示,A,B为2架摄 像机,2架摄像机所在圆的半径为r,角度为心摄像机视野的角度为l n g6丄为物体到摄像机的距离,那 么,重影区对应的角度其中,a=7i~ (77+/?)?__兀I8沒range7=〇•/?=arctan _______sin 々X L_______L X cos 彳—2 X r X sin音 *(1)(2)(3)重影区的角度a随景物与摄像机距离L的增加 而非线性增加,最终收敛到一个固定值.当景物与摄 像机距离较近时,重叠区域差异明显;景物与摄像机 较远时,差异趋于稳定.通过对重影区域角度极值的 测试分析得出,在不同摄像机群配置中,重影区域的 面积处于10%〜40%之间,如图3所示.通过分割特征检测区域,筛选出重影区域进行特征检测,可缩 短特征检测和特征匹配的时间.杜承垚等:GP U加速与L -OR B特征提取的全景视频实时拼接13190 45 90 135 180 225 270 315 360Angle of Rotation/(°)Fig. 4M atching perform ance under synthetic rotations图4图像旋转角度与特征识别率的关系100浮点型数据作为特征描述因子,将占用大量的存储 空间且会增加特征匹配的时间.B R I E F 利用图像邻 域内随机点对的灰度关系来建立图像特征描述因 子,具有时间复杂度、空间复杂度低的特性B R I E F 特征描述因子的建立首先需要平滑图像,然后在特征点周围一定范围内通过特定的方法 来挑选出来叫个点对.对于每一个点对(l ,g ),如果 这2个点的亮度值I 符合,则这个点对生成的值为1;如果I (»<a (g ),则对应在二值串中 的值为一 1,否则为〇.对所有的点对就可以生成一 个〃d 长的二进制串.当图像旋转角度大于45°时,B R I E F 图像特征 描述因子的识别率几乎〇,因此不具有旋转不变性; 但当旋转角度为15°以内时,图像的识别率大于 70%,且旋转角度越低,识别率越高i 当旋转角度极 小时,识别率明显高于其他方法,如图4所示.在全 景摄像机群中,对齐后的重叠图像旋转幅度仅仅在 0〜15°的范围内,使用B R I E F 算法可以获得相对于 传统方法更快的速度和更好的效果.1.2基于H arris 特征的FAST 角点检测把图像重叠区域的图像进行粗略对齐后,图像 匹配所需要的特征点不需要尺度、旋转不变性,因此 我们对O R B 算法中的o F A S T 和r B R I E F 进行简 化,去掉其中的尺度、旋转不变性以得到性能的提升.F A S T 特征是由R o s t e n 等人提出的一种快速特征检测方法,不具有尺度不变性,且相比传统的S I F T 和S U R F 方法具有明显的速度优势[气F A S T算法检测的特征点定义为:若像素点P 周围邻域内 有足够多的连续像素点与该点相差较大,则认为该 点是F A S T 特征点.但F A S T 特征点不具备角点的 属性,因此需要利用Harris 角点[2°]的度量方法,从F A S T 特征点中挑选出角点响应函数值最大的N 个特征点,其中响应函数为只=det M — a (trace M )气 该方法具体步骤如算法1所示-算法1.基于H a m s 特征的F A S T 角点检测方法.输人:图像h输出:图像中的N 个角点.① 计算图像1(1,W 在X 和Y 两个方向的梯度L ,ly ;② 计算图像2个方向梯度的乘积;③ 使用高斯函数对和进行高斯加权(取a =l ),生成矩阵M 的元素A ,B 和C ④ 计算图像I 的F A S T 角点;⑤ 计算F A S T 角点的Harris 响应值i ?,并删除小于阈值f 的角点;⑥ 进行非极大值抑制,邻域内局部最大值点即为Harris 角点;⑦获取Harris 角点中响应值最大的N 个角点.1.3 BRIEF 图像特征描述因子传统的S I F T 与S U R F 特征采用128 b 和64 bo o o o8642爹/J U JJS莖so J C Dd1320计算机研究与发展2017, 54(6)通过在O R B算法上对特征检测区域的优化分割,以及对尺度不变性、旋转不变性的简化,形成 L-O R B图像特征提取算法,详见算法2.算法2. L-O R B图像特征提取算法.输人^幅图像;输出:P组特征描述因子.①对全部的?Z幅图像分割为™■个特征检测区域;②对™■个特征检测区域进行F A S T角点检测;③从F A S T特征点中挑选出Harris角点响应值最大的P个特征点;④把P个Harris特征点建立B R I E F图像特征描述因子.2基于L S H的特征点匹配算法特征点匹配是将2幅图片重影区域描述因子相 同的特征点进行匹配,从而确定2张图片的对应关系.在图像重合后,其相匹配的特征点相邻的概率很 大,因此通过近似最邻近查找(A N N)可以将搜索范 围由全部特征点的集合减小为相邻特征点的集合,相对于线性搜索、K临近搜索(K N N)等算法具有更 小的空间复杂度和时间复杂度.2.1局部敏感Hash(Multi-Probe LSH)特征点搜索L S H是A N N中一种比较快速的方法.原始的 L S H利用多个H a s h函数通过对向量对象进行H a s h映射对数据进行降维.通过对查询向量进行多次H a s h操作,综合多个H a s h表中的查询操作得 到最终的结果.为了保证涵盖大部分近邻数据,原始 的L S H索引需要建立很多H a s h表,空间复杂度很 高.Lii等人提出Multi-Probe L S H算法™,使用一 个经过仔细推导出的探测序列,得到和查询数据近似的多个H a s h桶,增加了查找近邻数据的机会.原始的L S H方法对查询数据g得到的H a s h 桶是 W g)=(/i i(g),(g),…,A™ (g)),定义一个 Hash 扰动向量4=(A A,…,心),可以探测到H a s h桶尽(<?)+4•在L S H函数K V)=(以广)中,相似的数据的映射差最多一个单位.Multi-Probe L S H算法可以减少H a s h表的规模以降低内存占有量,加快搜索速度.2.2 PROSAC特征点筛选在图像匹配过程中,可能会有各种原因产生匹 配错误的外点(outliers).如果在进行图像融合时引 人了外点,则会给图像融合带来很大的错误.因此必须去除外点,选择正确的内点(inliers)进行参数的估计.在这里采用改进的样本一致性(progressive sample consensus,P R O S A C)[23]算法来去除误匹配点,使得接下来求得的参数矩阵会更加接近真实值.传统的R A N S A C算法随机抽取样本,忽略了 样本之间的好坏差异,效率低下.P R O S A C算法将 样本按质量进行排序,从较高质量的数据子集中抽取样本.经过若干次的假设、验证后,得到最优解.效 率为R A N S A C的100倍且鲁棒性更高.基于L S H的特征点匹配算法由Multi-Probe L S H特征点搜索和P R O S A C特征点筛选组成,其 具体步骤如算法3所示.算法3.基于L S H的特征点匹配算法.输人:2幅图片的特征点集合;输出:筛选好的特征点对.①对特征点集合使用Multi-Probe L S H进行特征点匹配;②利用P R O S A C算法去除错误匹配.重复以下步骤直到找到满意的结果I将匹配好的特征点对按照匹配质量将数据从好到差排序,然后选取前n个较高质量的数据;n从《个数据中随机取出™■个,计算模型参 数和内点的数量;I验证模型参数.3基于CUDA的G PU并行化视频拼接算法本文提出的L-O R B和L S H算法需要对图像进 行复杂矩阵的运算,C P U的串行处理模式性能无法 满足实时性要求.统一计算架构(compute unified device architecture,C U D A)是由 N V I D I A 提出的 并由其制造的图形处理单元(G P U s)实现的一种并 行计算平台及程序设计模型,对大量并发线程的并发流架构具有很好的加速能力[2425].我们利用G P U 的众核运算特性,把本文提到的算法由串行执行转化为并行执行,利用C U D A架构对并发的矩阵运算 进行加速可以成倍提高视频拼接速度.3.1块、线程并行C UD A函数中存在块和线程2个层次的并行方式,各个块之间互相独立,但同一块中的线程可以 通过共享存储器来交换数据.C P U通过优先级和时 间片论转法实现线程调度;而G P U上线程只有等待资源和执行2种状态,如果资源满足运行条件就会立即执行.当G P U资源充裕时,所有线程都是并杜承垚等:G P U加速与L-O R B特征提取的全#:视频实时拼接1321发执行的,加速效果很接近理论加速比;而G P U资 源少于总线程个数时,有一部分线程就会等待前面执行的线程释放资源,从而变为串行化执行.对L-O R B算法进行C U D A并行加速的关键是 把算法原本串行计算的部分分割成多个子任务.对于F A S T特征提取、非极大值抑制、建宣B R I E F图像描述因子、图像的变换,均满足可拆分成多个计算 过程相同且数据互不相关子任务的条件,对全景视 频实时拼接算法的G P U并行化设计如下:算法4.全景视频实时拼接算法.输人:多个摄像头同时采集不同方向的视频;输出:全景视频.① 根据预先矫正的参数,对每个摄像头采集的视频利用G P U进行裁剪和变换;②对特征检测区域内的每个像素进行并行检测,筛选出符合F A S T特征点的像素,并计算出其Harris响应值;③ 利用G P U对每个符合F A S T特征点的像素进行非极大值抑制;④ 获取Harris角点中响应值最大的P个角点,并建立B R I E F图像特征描述因子;③把2个视频中提取的角点进行匹配及筛选,并计算出变换矩阵;©使用G P U对视频进行变换,并融合成全景视频.3.2流并行图像拼接的串行C U D A编程模式分为3步:1) 将图像从主内存上传到G P U内存;2)在G P U上顺 序执行角点检测、特征匹配、图像融合;3)将结果从 G P U内存下载到主内存,如图5(a)所示.然而图像 数据从主内存到G P U内存的传输速度依赖于P CI-E总线的带宽,数据传输过程中会导致G P U运算资 源闲置,且G P U在执行单个任务时会导致流处理器资源闲置.C UD A stream把程序的指令分为多个操作队列,可以实现队列之间的操作并行.由于不同s tream的操作是异步执行的,我们通过精心构造操 作队列,使得队列之间互相协调来充分利用G P U 资源.利用C U D A stream,在上传第2张图像的同 时可以对第1张图像进行角点检测;且可以对多副 图像同时进行角点检测、特征匹配等G P U操作,大 大节约了时间,提升了效率,如图5(b)所示,Serial[1 ] upload[2] find features[3] match[4] blend[5] download -------------------------------------------------------------------------------------------------------------------------------------------WTime(a) A sequence of operations that execute in issue-order on the GPUStream 1 Stream 2 Stream 3 Stream 4|[1] |[2][3]| [4] [5]| [l]i[2]:[3];[4] j[5]iEfficiency Improvement > U]|[2][3]|[4_][5] [1];[2];[3]: [4]N[1][2][3][4][5]|! [1][2] ;:[3][4] j[5]j[1][2] ![3][4] |[5];[1] :[2]::[3]:[4] ![5]iFrame11;Frame 2------------------------------------------------►Time(b) CUDA operations in different streamsThe solid frame represents the current frame of the image stitching, and the dashed frame represents the next frame of the image splicing.Fig. 5 C U D A stream list图5图像拼接的C U D A流并行队列4实验分析本文C U D A和C P U实验在U b u n t u14. 04 L T S环境下使用配置为Intel Core i7-6700H Q,R A M16 G B,N V I D I A GeForce G T X970M的 Terrans Force X411计算机运行;嵌人式实验使用N V I D I A T X1开发板;使用了N V I D I A C U D A Toolkit 8. 0 和 O p e n C V 3. 2. 0 等软件开发包•4.1准确性实验为验证本文提出算法的准确性,我们使用了A d o b e Panoramas Dataset等图片集进行了图片拼接测试,如图6(a)~(b)所示.图6(c)〜(e)分别为 传统的S I F T、传统的O R B和本文的L-O R B特征点 提取及匹配的结果.其中,圆圈表示算法提取的特征 点,连线表示算法匹配到的特征点对,三角形表示匹 配错误的特征点对.从图6(c)〜(e)中可看出,S I F T 算法提取了大量的特征点,但匹配的特征点对占比1322计算机研究与发展2017, 54(6)较少;传统的O R B 算法准确率不高,产生了错误匹 配;本文的L -O R B 算法在相较于S I F T 算法提取较 少特征点的前提下,匹配到大量有效的的特征点,且准确率高于传统的O R B 算法.图6(f )为2张图片拼 接后的结果.实验证明我们的算法能够有效地匹配 到有效的特征点并完成图像拼接.(c) SIFT feature detection and matching results(d) ORB feature detection and matching results(e) L-ORB feature detection and multi-probe LSH matching results(f) Image stitching resultsFig. 6Stitching sam ple m atching results and stitching results图6图像拼接的样本、特征点匹配结果及拼接结果杜承垚等:G P U加速与L-O R B特征提取的全景视频实时拼接13234.2 实时性实验为了验证本文提出算法的实时性,我们进行了一系列实验.我们用3正丁,31^卩,0尺6丄-0尺6对分辨率为 800X600,1920X I080,2 034 X I728 像素的视频进行特征点检测,如图7所示.结果证明,在Inteli7 2. 8 G H z单线程下,采用本文的L-O R B特征提取算法可将时间缩短为O R B算法的1/3,是传统S I F T算法的1/1 000.Fig. 7Com parison of feature detection algorithmefficiency图7不同算法对图像特征提取效率的对比我们使用 S I F T,S U R F,O R B,L-O R B,L-O R B+G P U分别对实时采集的2 304X1728 pixels视频进行拼接,记录每个阶段的拼接时间.实验证明,本文提出的L-O R B+G P U算法在图像拼接的特征提取、特征匹配等各个阶段均有很好的性能提升,其算法速度是传统O R B算法的11倍、传统S I F T算法的639倍,如图8所7K:SIFTSURF ORB L-ORBL-ORB + GPUFind Features Match Features Warp FeaturesStagesFig. 8 Com parison of different algorithm s in three stages of image Stitching图8不同算法在图像拼接3个阶段的时间对比为了验证C U D A S t r e a m的有效性,我们使用 N V I D I A T X-1分别对不同分辨率、不同摄像头个数、长度为1000帧的视频进行拼接,并计算出拼接 每帧图片时间的平均值.图9(a)展示了是否使用C U D A S t r e a m对2〜7个视频进行拼接的时间,实 验证明,C U D A S t r e a m对各种分辨率的视频拼接均 有明显的加速效果.图9(b)展示了拼接2〜11个视 频流时使用C U D A Stream与未使用C U D A Stream 平均每帧节约的时间,因为不同分辨率视频采集的 内容不同,提取角点数量不同,且磁盘I/O和图像的 压缩算法都会影响拼接时间,在此不对不同分辨率做比较.实验证明,在G P U资源足够时,性能随着 视频流的增多而提尚.我们使用L-O R B算法分别在BeagleBone Black,Raspberry Pi 3B,N V I D I A T X-1 C P U,N V I D I A T X-1 G P U四种嵌入式开发版中对大小为2 304 X 1728 pixels的同一组数据集进行图像拼接实验.实验结 果如图10所示,本文提出的算法在N V I D I A T X-1 G P U中的拼接速度较同类速度最快的Raspberry Pi 3B提升29. 2倍.1324计算机研究与发展2017, 54(6)BeagleBone Black^I I Raspberry Pi 3B■NVIDIA TX-1 CPUlilil NVIDIA TX-1 GPUQ __________;:;;:;:;l| ■__________800X600 1920X1080 2 304x1728Image Size/pixelsFig. 10 Com parison of image splicing tim e inembedded devices图10嵌人式设备中图像拼接时间对比5总结本文提出了 L-O R B特征提取算法,该算法减少 了特征点检测区域,简化了传统〇R B算法对尺度、旋转不变性的支持,降低了算法的时间复杂度;并利 用G P U块、线程、流并行方法对该算法进行加速优 化,进一步提升了算法的运行效率.此外还设计实现 了一种全景视频实时拼接系统,解决了传统方法不能满足全景视频拼接实时性的问题.实验结果表明,本文提出的方法可以频率为60 H z的视频进行拼接,满足实时性.我们进一步的研究工作将对利用剩余运算资源对融合算法进行优化,提高全景视频质量.参 考文献[1] Gaddam V R,Riegler M,Eg R, et al. Tiling in interactivepanoramic video. Approaches and evaluation [J]. IEEETrans on Multimedia, 2016, 18(9):1819-1831[2] Wang X,Tieti K, GrixnsQn W E L. Correspondcncc-frccmulti-camera activity analysis and scene modeling [C] //Procof 2008 IEEE Conf on Camputer Vision and PatternRecognition. Piscataway, NJ :IE E E, 2008:1-3[3] Wang XiaOgang. Intelligent multi-camera videe surveillancesA review [J]. Pattarii Recognition Letters, 2013, 34(1) :3-.19[4] Wu Yuezhou, Liu Changjiang, Lan Shiyong, et al. Real-time3D road scent' based on virtual-real fusion method IEEESensors Journal - 2015. 15(2) :750-756[5] Zeng Dan, Cfeen Jian, Zhang Qi, et al. Global t#p〇l〇gyba«t^d image stitching using hieigrEHcal triangulatioii [J].Journal Computer Research and Development? 2012,49(11s 144-151 fin Chinese)(曾丹,陈剑,张琦,等.基于全局拓扑结构的分级三角剖分图像拼接[J].计算机研究与发展•2.012, 19(1): 144-151) [.6] C-ao Shixiang, Jiang Jiei Zhang Guangjun, st al. Multi-scale image mosaic using features from edge 匸Journal ofComputer Research and Derelopment, 2011, 18(9) :17881793 (in Chinese)(曹世翔,江洁,张广平,等.边缘特征点的多分辨率图像拼接[J].计算机研究与发展,2011,48(9): 1788-1793)[7] Rublesg E, Rabaud V, Konolige K, et al. O R B:An efficientalternative to SIFT or SU RF [(T[ //Proc of 2011 Int Conf onComputer Vision. Piscataway>N J:IE E E, 20.11 ^25.0.4—2571.[8] Jiang Guiyuan, Zhang Guiling, Zhang Dakun. A distributedpffiillfil tlgorltiim for SIFT feature extraction [J]. Journal ofComputer Research and Development, 2012, 49 (5);11301141 (in Chinese)(姜桂圆,张桂玲,张大坤.S I F T特征分布式j f行提取算法[J].费算机斷究与发展,2012,19(5): 1130-1141)Cui Zhmp Meng Fsarong, Yao R u i3c t al. Multi-video fusionwith extended SU RF based ..o..n CIJDA parallel computingframework 〇]. Journal of Nanjing University C NaturalSciences), 2016, 52(4):627-637 (in Chinese)(崔哲,孟凡荣,姚睿,等.C U D A并行计算下基于扩展S U R F的多摄像机视频融合方法[J].南京大学学报:自然科学版,2016, 52(4) : 627-637)[10〇Parker 〇, Daiter M, Omar K, ft al. The CUDA LATCH binary descriptor:Because sometimes faster means better[C jQ//Proc of 2016 Computer Vision-ECCV Workshops.Berlin:Springer. 2016:685-697[11] Zhi Xiyang, Yan Junh瓶,Hang Yiqing, et al. Realization ofCUDA-based real-time registration and target localization forhigh—lesoliition irfdeo images [J]. Journal of Real-TimeImage Processing, 2Q16 *1-12[12] Brown M, Lowe D G. Aut.omalic panoramic image stitchingusing invariant features [J]. International Journal oiComputer Vision, 2007, 74(1):59-73[13] Peng Bo, He Bin. Application and realization ©f FPGA invideo rnosaicing [J]. Computer Engineering and Design,2013, 34(5):1635-1639 (in Chinese)(彭勃,何宾.F P G A在视频拼接中的应川与实现[J].计算机T程与设计•2013, 3,1(5): 1635-1639)[:1.4] Xiong Y,:Ptllli K. Fast panorama stitching for high-quality panoramic images on mobile phones [J]. IEEE Trans onConsumer Electronics, 2010, 56(2):298-306[15] Cha J H, Jeon Y S, Moon Y S s ct al. Seamless and fastpanoramic image-stitching [d〇//Proe of 2012 IEEE Int Confon Consumer Electronics (ICCE). Piseataway,.NJ: IE EE,2012:29-30[16] Anderson R, Gallup D, Barron J T, .et ;.a.L Jum p:Virtualreality video [J]. ACM Trans on Graphics, 2016, 35 ( 6):198p u o o c u sJ c u ds c u mm fe杜承垚等:G P U加速与L-O R B特征提取的全景视频实时拼接1325[17] Zhu Z, Hanson A R. Mosaic-based 3D scene representationand rendering [J]. Signal Processing:ImageCommunication, 2006, 21(9):739-754[18] Tzavidas S,Katsaggelos A K. A multicamera setup forgenerating stereo panoramic video [J]. IE EE Trans onMultimedia, 2005, 7(5):880-890[19] Rosten. E, Drummond T. Machine learning for high-speedcorner detection. [C] //Proc of European Conf on. ComputerVision. Berlin:Springer, 2006:430-443[20] Harris C, Stephens M. A combined corner and edge detector[C] //Proc of the Alvey Vision Conf. Manchester, U K:Alvey Vision Club, 1988;147-151[21] Calonder M* Lepetit V, Strecha C,et al. Brief:Binaryrobust independent elementary features [C] //Proc ofEuropean Conf on Computer Vision. Berlin:Springer, 2010:778-792[22] Lv Qin, Josephson W, Wang Zhe, et al. Multi-probe L S H:Efficient indexing for high-dimensional similarity search [C]//Proc of the 33rd Int Conf on Very Large Data Bases. NewY ork:ACM, 2007:950-961[23] Chum O, Matas J. Matching with PROS A C-progressivesample consensus [C] //Proc of 2005 IEEE Computer SocietyConf on Computer Vision and Pattern. Recognition(C V PR’05). Piscataway,N J: IE E E,2005: 220—226[24] Loncar V, Balaz A, Bogojevic A, et al. CUDA programs forsolving the time-dependent dipolar Gross-Pitaevskii equationin. an anisotropic trap [J]. Computer Physics Communications»2016, 200 (2016):406-410[25] De Angelis F, Gentile F, Mecarini F,et al. Breaking thediffusion, limit with super-hydrophobic delivery of moleculesto plasmonic nanofocusing SER S structures [J]. NaturePhotonics, 2011, 5(11):682-687Du Chengyao, born in 1992. MSc candidate.His main research interests include computerarchitecture and computer vision.Yuan Jingling, born in 1975. PhD.Professor, PhD supervisor. Senior memberof CCF. Her main research interestsinclude green computing, machine learningand data mining.I Chen Mincheng, born in 1990. PhDcandidate. His main research interests'include green computing and data mining.■'■Li Tao, born in 1972. PhD. Professor,PhD supervisor. His main researchinterests include computer architecture andgreencomputing.。