信息论习题答案

信息论与编码理论习题答案

信息论与编码理论习题答案LG GROUP system office room 【LGA16H-LGYY-LGUA8Q8-LGA162】第二章 信息量和熵八元编码系统,码长为3,第一个符号用于同步,每秒1000个码字,求它的信息速率。

解:同步信息均相同,不含信息,因此 每个码字的信息量为 2⨯8log =2⨯3=6 bit因此,信息速率为 6⨯1000=6000 bit/s掷一对无偏骰子,告诉你得到的总的点数为:(a) 7; (b) 12。

问各得到多少信息量。

解:(1) 可能的组合为 {1,6},{2,5},{3,4},{4,3},{5,2},{6,1})(a p =366=61得到的信息量 =)(1loga p =6log = bit (2) 可能的唯一,为 {6,6})(b p =361得到的信息量=)(1logb p =36log = bit 经过充分洗牌后的一副扑克(52张),问:(a) 任何一种特定的排列所给出的信息量是多少?(b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量?解:(a) )(a p =!521信息量=)(1loga p =!52log = bit (b) ⎩⎨⎧⋯⋯⋯⋯花色任选种点数任意排列13413!13)(b p =1352134!13A ⨯=1352134C 信息量=1313524log log -C = bit 随机掷3颗骰子,X 表示第一颗骰子的结果,Y 表示第一和第二颗骰子的点数之和,Z 表示3颗骰子的点数之和,试求)|(Y Z H 、)|(Y X H 、),|(Y X Z H 、)|,(Y Z X H 、)|(X Z H 。

解:令第一第二第三颗骰子的结果分别为321,,x x x ,1x ,2x ,3x 相互独立,则1x X =,21x x Y +=,321x x x Z ++=)|(Y Z H =)(3x H =log 6= bit )|(X Z H =)(32x x H +=)(Y H=2⨯(361log 36+362log 18+363log 12+364log 9+365log 536)+366log 6= bit )|(Y X H =)(X H -);(Y X I =)(X H -[)(Y H -)|(X Y H ]而)|(X Y H =)(X H ,所以)|(Y X H = 2)(X H -)(Y H = bit或)|(Y X H =)(XY H -)(Y H =)(X H +)|(X Y H -)(Y H 而)|(X Y H =)(X H ,所以)|(Y X H =2)(X H -)(Y H = bit),|(Y X Z H =)|(Y Z H =)(X H = bit )|,(Y Z X H =)|(Y X H +)|(XY Z H =+= bit设一个系统传送10个数字,0,1,…,9。

信息论部分习题及解答

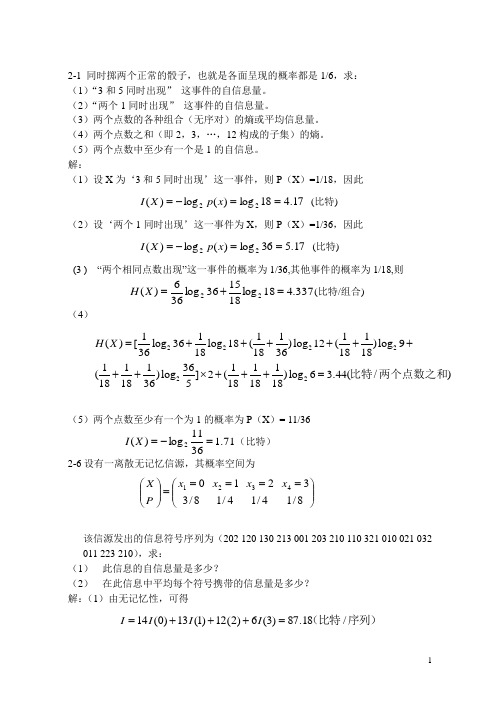

2-1 同时掷两个正常的骰子,也就是各面呈现的概率都是1/6,求: (1)“3和5同时出现” 这事件的自信息量。

(2)“两个1同时出现” 这事件的自信息量。

(3)两个点数的各种组合(无序对)的熵或平均信息量。

(4)两个点数之和(即2,3,…,12构成的子集)的熵。

(5)两个点数中至少有一个是1的自信息。

解:(1)设X 为‘3和5同时出现’这一事件,则P (X )=1/18,因此 17.418log)(log)(22==-=x p X I (比特)(2)设‘两个1同时出现’这一事件为X ,则P (X )=1/36,因此 17.536log)(log)(22==-=x p X I (比特)(3 ) “两个相同点数出现”这一事件的概率为1/36,其他事件的概率为1/18,则 337.418log181536log366)(22=+=X H (比特/组合)(4)222222111111()[log 36log 18()log 12()log 936181836181811136111()log ]2()log 6 3.44(/)1818365181818H X =++++++++⨯+++=比特两个点数之和(5)两个点数至少有一个为1的概率为P (X )= 11/36 71.13611log)(2=-=X I (比特)2-6设有一离散无记忆信源,其概率空间为⎪⎪⎭⎫⎝⎛=====⎪⎪⎭⎫⎝⎛8/134/124/118/304321x x x x PX该信源发出的信息符号序列为(202 120 130 213 001 203 210 110 321 010 021 032 011 223 210),求:(1) 此信息的自信息量是多少?(2) 在此信息中平均每个符号携带的信息量是多少? 解:(1)由无记忆性,可得序列)(比特/18.87)3(6)2(12)1(13)0(14=+++=I I I I(2)符号)(比特/91.145/==I H 2-9在一个袋中放有5个黑球、10个白球,以摸一个球为一次实验,摸出的球不再放进去。

信息论与编码理论_第3章信道容量_习题解答_071102

.. ..... . .第3章 信道容量习题解答3-1 设二进制对称信道的转移概率矩阵为2/31/31/32/3⎡⎤⎢⎥⎣⎦解: (1) 若12()3/4,()1/4P a P a ==,求(),(),(|),(|)H X H Y H X Y H Y X 和(;)I X Y 。

i i 2i=13311H(X)=p(a )log p(a )log()log()0.8113(/)4444bit -=-⨯-=∑符号111121*********j j j=132117p(b )=p(a )p(b |a )+p(a )p(b |a )=43431231125p(b )=p(a )p(b |a )+p(a )p(b |a )=4343127755H(Y)=p(b )log(b )=log()log()0.9799(/)12121212bit ⨯+⨯=⨯+⨯=---=∑符号 22i j j i j i j i ,H(Y|X)=p(a ,b )logp(b |a )p(b |a )logp(b |a )2211log()log()0.9183(/)3333i jjbit -=-=-⨯-⨯=∑∑符号I(X;Y)=H(Y)H(Y|X)=0.97990.91830.0616(/)bit --=符号 H(X|Y)=H(X)I(X;Y)=0.81130.06160.7497(/bit --=符号)(2)求该信道的信道容量及其达到信道容量时的输入概率分布。

二进制对称信息的信道容量H(P)=-plog(p)-(1-p)log(1-p)1122C =1-H(P)=1+log()+log()=0.0817(bit/)3333符 BSC 信道达到信道容量时,输入为等概率分布,即:{0.5,0.5} 注意单位3-4 设BSC 信道的转移概率矩阵为112211Q εεεε-⎡⎤=⎢⎥-⎣⎦1)写出信息熵()H Y 和条件熵(|)H Y X 的关于1()H ε和2()H ε表达式,其中()log (1)log(1)H εεεεε=----。

信息论与编码理论课后答案

信息论与编码理论课后答案【篇一:《信息论与编码》课后习题答案】式、含义和效用三个方面的因素。

2、 1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

3、按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。

4、按照信息的地位,可以把信息分成客观信息和主观信息。

5、人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。

6、信息的是建立信息论的基础。

7、8、是香农信息论最基本最重要的概念。

9、事物的不确定度是用时间统计发生概率的对数来描述的。

10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。

12、自信息量的单位一般有比特、奈特和哈特。

13、必然事件的自信息是。

14、不可能事件的自信息量是15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。

16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量趋于变小。

17、离散平稳无记忆信源x的n次扩展信源的熵等于离散信源x的熵的。

limh(xn/x1x2?xn?1)h?n???18、离散平稳有记忆信源的极限熵,。

19、对于n元m阶马尔可夫信源,其状态空间共有m个不同的状态。

20、一维连续随即变量x在[a,b] 。

1log22?ep21、平均功率为p的高斯分布的连续信源,其信源熵,hc(x)=2。

22、对于限峰值功率的n维连续信源,当概率密度均匀分布时连续信源熵具有最大值。

23、对于限平均功率的一维连续信源,当概率密度24、对于均值为0,平均功率受限的连续信源,信源的冗余度决定于平均功率的限定值p和信源的熵功率p25、若一离散无记忆信源的信源熵h(x)等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为。

2728、同时掷两个正常的骰子,各面呈现的概率都为1/6,则“3和5同时出现”这件事的自信息量是 ?mn?ki?11?mp(x)?em29、若一维随即变量x的取值区间是[0,∞],其概率密度函数为,其中:x?0,m是x的数学2期望,则x的信源熵c。

信息论与编码-曹雪虹-课后习题答案

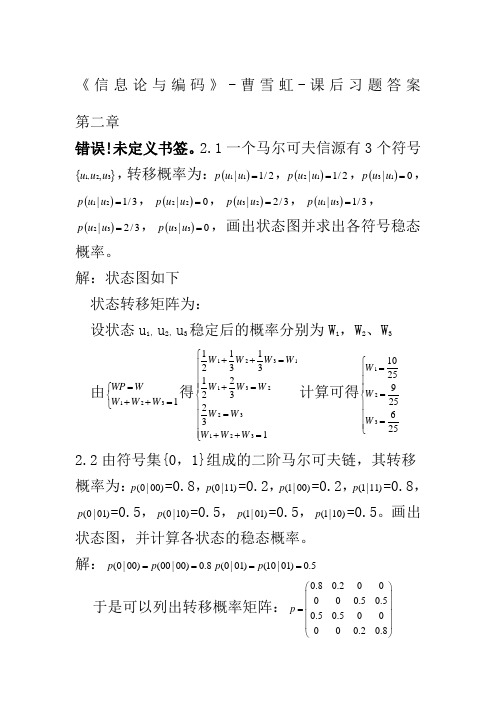

《信息论与编码》-曹雪虹-课后习题答案 第二章错误!未定义书签。

2.1一个马尔可夫信源有3个符号{}1,23,u u u ,转移概率为:()11|1/2p u u =,()21|1/2p u u =,()31|0p u u =,()12|1/3p u u =,()22|0p u u =,()32|2/3p u u =,()13|1/3p u u =,()23|2/3p u u =,()33|0p u u =,画出状态图并求出各符号稳态概率。

解:状态图如下 状态转移矩阵为:设状态u 1,u 2,u 3稳定后的概率分别为W 1,W 2、W 3由1231WP W W W W =⎧⎨++=⎩得1231132231231112331223231W W W W W W W W W W W W ⎧++=⎪⎪⎪+=⎪⎨⎪=⎪⎪⎪++=⎩计算可得1231025925625W W W ⎧=⎪⎪⎪=⎨⎪⎪=⎪⎩ 2.2由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =0.8,(0|11)p =0.2,(1|00)p =0.2,(1|11)p =0.8,(0|01)p =0.5,(0|10)p =0.5,(1|01)p =0.5,(1|10)p =0.5。

画出状态图,并计算各状态的稳态概率。

解:(0|00)(00|00)0.8p p ==(0|01)(10|01)0.5p p ==于是可以列出转移概率矩阵:0.80.200000.50.50.50.500000.20.8p ⎛⎫ ⎪⎪= ⎪ ⎪⎝⎭状态图为:设各状态00,01,10,11的稳态分布概率为W 1,W 2,W 3,W 4有411i i WP W W ==⎧⎪⎨=⎪⎩∑得13113224324412340.80.50.20.50.50.20.50.81W W W W W W W W W W W W W W W W +=⎧⎪+=⎪⎪+=⎨⎪+=⎪+++=⎪⎩计算得到12345141717514W W W W ⎧=⎪⎪⎪=⎪⎨⎪=⎪⎪⎪=⎩2.3同时掷出两个正常的骰子,也就是各面呈现的概率都为1/6,求:(1)“3和5同时出现”这事件的自信息; (2)“两个1同时出现”这事件的自信息;(3)两个点数的各种组合(无序)对的熵和平均信息量; (4)两个点数之和(即2,3,…,12构成的子集)的熵; (5)两个点数中至少有一个是1的自信息量。

信息论与编码习题答案-曹雪虹

3-14

信源 符号 xi x1 x2 x3 x4 x5 x6 x7

符号概 率 pi 1/3 1/3 1/9 1/9 1/27 1/27 1/27 1/3 1/3 1/9 1/9 2/27 1/27 1/3 1/3 1/9 1/9 1/9

编码过程

编码 1/3 1/3 1/3 2/3 1/3 00 01 100 101 111 1100 1101

得p0p1p223当p0或p1时信源熵为0第三章无失真信源编码31321因为abcd四个字母每个字母用两个码每个码为05ms所以每个字母用10ms当信源等概率分布时信源熵为hxlog42平均信息传递速率为2信源熵为hx0198bitms198bitsbitms200bits33与上题相同351hu12log2?14log4?18log8?116log16?132log32?164log64?1128log128?1128log128?1984111111112481632641281282每个信源使用3个二进制符号出现0的次数为出现1的次数为p0p134相应的香农编码信源符号xix1x2x3x4x5x6x7x8符号概率pi12141811613216411281128累加概率pi00507508750938096909840992logpxi12345677码长ki12345677码字010110111011110111110111111011111110相应的费诺码信源符号概符号xi率pix1x2x3x4x5x6x7x812141811613216411281128111第一次分组0第二次分组0第三次分组0第四次分组0第五次分组011第六次分组01第七次分组01二元码0101101110111101111101111110111111105香农码和费诺码相同平均码长为编码效率为

信息论与编码第四章课后习题答案

∫ =

− log λe−λx

∞ 0

+ log e

ln e−λx de−λx

∫ =

− log

λ

+

log

et

ln

t

0 1

−

log

e

dt

= −log λ + log e

= log e λ

(2)

h( X )

= −∫ p(x)log p(x)dx

∫ = − ∞ 1 λe−λ x log 1 λe−λ x dx

−∞ 2

2

∫ = − ∞ λe−λx log 1 λe−λxdx

0

2

∫ ∫ = − ∞ λe−λx log 1 dx − ∞ λe−λx log λe−λxdx

0

2

0

= log 2 + log e λ

= log 2e λ

注:(2)题直接借用了(1)的结论。

【4.3】设有一连续随机变量,其概率密度函数为:

sin

x

=

1 2

log

e∫

ln(1

+

sin

x)d

sin

x

+

1 2

log

e∫

ln(1

−

sin

x)d

sin

x

∫ ∫ ln(1+ sin x)d sin x

π

= (1 + sin

x) ln(1+ sin

x)

2 −π

−

2

1 + sin x d sin x 1 + sin x

= 2ln 2 − 2

∫ ln(1− sin x)d sin x

信息论与编码(陈运)习题答案

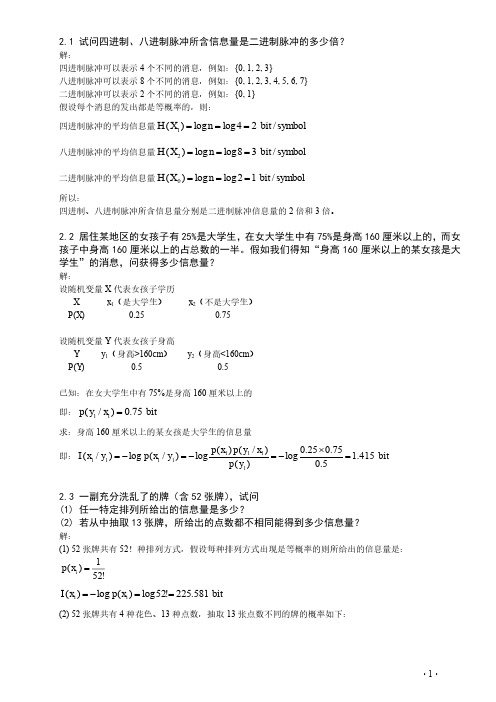

· 1 ·2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍?解:四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3}八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则:四进制脉冲的平均信息量symbol bit n X H / 24log log )(1=== 八进制脉冲的平均信息量symbol bit n X H / 38log log )(2=== 二进制脉冲的平均信息量symbol bit n X H / 12log log )(0=== 所以:四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。

2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。

假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量?解:设随机变量X 代表女孩子学历X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75设随机变量Y 代表女孩子身高Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5已知:在女大学生中有75%是身高160厘米以上的 即:bit x y p 75.0)/(11=求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15.075.025.0log )()/()(log )/(log )/(11111111=⨯-=-=-=2.3 一副充分洗乱了的牌(含52张牌),试问(1) 任一特定排列所给出的信息量是多少?(2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量?解:(1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是:!521)(=i x p bit x p x I i i 581.225!52log )(log )(==-=(2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下:· 2 ·bit C x p x I C x p i i i 208.134log)(log )(4)(135213135213=-=-==2.4 设离散无记忆信源⎭⎬⎫⎩⎨⎧=====⎥⎦⎤⎢⎣⎡8/14/1324/18/310)(4321x x x x X P X ,其发出的信息为(202120130213001203210110321010021032011223210),求 (1) 此消息的自信息量是多少?(2) 此消息中平均每符号携带的信息量是多少?解:(1) 此消息总共有14个0、13个1、12个2、6个3,因此此消息发出的概率是:62514814183⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=p此消息的信息量是:bit p I 811.87log =-=(2) 此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/==2.5 从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为0.5%,如果你问一位男士:“你是否是色盲?”他的回答可能是“是”,可能是“否”,问这两个回答中各含多少信息量,平均每个回答中含有多少信息量?如果问一位女士,则答案中含有的平均自信息量是多少?解: 男士:symbolbit x p x p X H bitx p x I x p bit x p x I x p i i i N N N Y Y Y / 366.0)93.0log 93.007.0log 07.0()(log )()( 105.093.0log )(log )(%93)( 837.307.0log )(log )(%7)(2=+-=-==-=-===-=-==∑女士:symbol bit x p x p X H ii i / 045.0)995.0log 995.0005.0log 005.0()(log )()(2=+-=-=∑2.6 设信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡17.016.017.018.019.02.0)(654321x x x x x x X P X ,求这个信源的熵,并解释为什么H(X) > log6不满足信源熵的极值性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

(2) 试求最大失真度 和 。

(3) 若最大允许失真度 ,试问信源每一个符号的平均二进制码长是多少?

答:

汉明失真函数和信道转移概率矩阵别离为

,

(1)最小失真度 和 别离为

, 。

(2)最大失真度 和 别离为

=0

9. 设一离散无经历信源 ,每秒发出个符号,通过一个二进制无噪信道传输,该信道每秒仅能传两个二进制符号,试问:

(2) 相同情况下“车”、“象”和“后”对应的熵率(“象”分为两种)。

答:

(1)由于“王”不能停在当前格上,必需走一步,因此就9个状态的稳态散布为

其中 是从第 格动身能够抵达的格子数, 。通过简单的计算可得:

, ,

再依照“随机行走”的意义可得

因此最终结果为

(2)“车”不管在哪个格子,它都有4个走向,例如它在1号格子,它能够去二、3、4、7号格子,因此状态的稳态散布为均匀散布: ,车随机行走的熵率为

能够看到:做 和 两个实验比做 一个实验可多取得的信息为

(3) ,它表示做完 实验以后,从 实验可取得关于 的信息量。

,它表示做 完实验以后,从 实验可取得关于 的信息量。

6. 设信源 通过一干扰信道,接收符号为 ,信道传递概率如图2-7所示。求:

(1) 信源 中事件 和 别离携带的自信息量。

(2) 收到消息 后,取得的关于 的信息量。

(3) 求 和 ,并说明它们的含义。

答:

(1) ,要求 和 需要先求 , , 已知。

,要求 和 需要先求 , , 已知。

由 及联合概率散布与边缘概率散布的关系可得 及 ,如表2-1所示:

表2-1

0

1

0

1

0

1/4

0

0

1/4

1

0

1/4

1

1/4

0

2

1/4

1/4

2

0

1/2

1/2

1/2

1/2

1/2

因此

一样可求出 及 ,如表2-2所示:

又因为 ,由(3-13)可得率失真函数 为

(2)当信源 , 时,

3. 设一个符号等概率输出的离散无经历信源 的失真函数矩阵为

试求:(1)率失真函数 ;(2)信道转移概率 。

答:

由失真函数可知通过的信道为对称信道,故可设对称性可设信道的转移概率

那么由信源概率散布和信道转移概率散布可取得信宿接收信号的概率散布 ,得

答:

15. 一信源产生的时不变波形信号(即信号统计特性不随时刻而变)的带宽为4kHz,幅度散布为

试求该信源的信息输出速度。

答:

该信源的绝对熵

由于此题中 ,并非趋于0,因此

(奈特/样值)

依照奈奎斯特定理,对该波形信号的抽样率至少为 。信源的输出信息率为:

(奈特/秒)

第3章

1. 假设一个二元等概率离散无经历信源 ,通过一个二进制对称信道, 表示符号传输过失,其失真函数 和信道转移概率 别离为

最小失真度为

若是信道要达到最大失真度 ,信道的转移概率矩阵为

,或 ,或 ( )

若是信道要达到最大失真度 ,信道的转移概率矩阵为

,或 ,或

7. 已知一个等概率离散无经历信源 ,信宿接收符号为 ,失真函数矩阵为

试求信源的率失真函数 。

答:

由失真函数 能够看出,信源输出消息符合为0,1,且等概率 ,信宿接收到的消息符号有3个,别离为0,1,2,由失真函数 可知: ; ; ; ; ; 。

第2章

1. 一个布袋内放100个球,其中80个球是红色的,20个球是白色的,假设随机摸取一个球,猜想其颜色,求平均摸取一次所能取得的自信息量?

答:依据题意,这一随机事件的概率空间为

其中: 表示摸出的球为红球事件, 表示摸出的球是白球事件。

a)若是摸出的是红球,那么取得的信息量是

(比特)

b)若是摸出的是白球,那么取得的信息量是

(3)因为信源是无经历信源,因此

5. 有一离散无经历信源,其输出为 ,相应的概率为 , , ,设计两个独立实验去观看它,其结果别离为 , 。

已知条件概率如表2-4所示。

表2-4 习题5表

0

1

0

1

0

1

0

0

1

0

1

0

1

1

1

0

2

1/2

1/2

2

0

1

(1) 求 和 ,并判定作哪个实验好些。

(2) 求 ,并计算作Y1和Y2两个实验比作Y1或Y2中的一个实验各可多得多少关于 的信息。

答:发送集合 接收集合 其中

因为

因此

最后得:

(比特/符号)

4. 某一无经历信源的符号集为{0,1},已知信源的概率空间为 。

(1) 求信源熵。

(2) 求由 个“0”和(100- )个“l”组成的某一特定序列的自信息量的表达式。

(3) 计算由100个符号构成的符号序列的熵。

答:

(1)信源熵为

(2)该特定序列用 表示那么

(3) 信源 和信源 的信息熵。

(4) 损失熵 和噪声熵 。

(5) 接收到消息 后取得的平均互信息。

图2-7 习题6图

答:(1)

因为

因此

(比特)

(比特)

(2)

收到消息 的概率为:

因此收到消息 后取得的关于 的信息量即 为:

(比特/符号)

(比特/符号)

(比特/符号)

(比特/符号)

(3)

(比特/符号)

(比特)

c)若是每次摸出一个球后又放回袋中,再进行下一次摸取。那么如此摸取 次,红球显现的次数为 次,白球显现的次数为 次。随机摸取 次后总共所取得信息量为

d)那么平均随机摸取一次所取得的信息量为

2. 居住某地域的女孩中有25%是大学生,在女大学生中有75%是身高以上的,而女孩中身高以上的占总数的一半。假设咱们得知“身高以上的某女孩是大学生”的消息,问取得多少信息量?

《信息理论与编码》习题参考答案

第1章

1.信息是什么?信息与消息有什么区别和联系?

答:信息是对事物存在和运动进程中的不确信性的描述。信息确实是各类消息符号所包括的具有特定意义的抽象内容,而消息是信息这一抽象内容通过语言、文字、图像和数据等的具体表现形式。

2.语法信息、语义信息和语用信息的概念是什么?三者的关系是什么?

(比特/符号)

(4)

其中

因此噪声熵:

(比特/符号)

损失熵:

(比特/符号)

(5)接收到消息 后所取得的平均互信息量为:

(比特/符号)

7. 某信源的消息符号集的概率散布和二进制代码如题表2-5所示。

表2-5 习题7表

信源符号

概率

1/2

1/4

1/8

1/8

代码

0

10

110

111

试求:

(1) 消息的符号熵。

其中

现令 ,设其概率空间为 ,并知足

因此依照詹森不等式得

因此

上式对所有 的取值都成立,因此

即

因此

因为 , 因此上式两边相乘,等号不变。有

上式对所有 都成立,因此对所有 求和下式也成立

因为

因此是平稳信源

得

只有当 (对所有 )时等式成立。

证毕

12. 在一个3×3的国际象棋棋盘上,试求:

(1)“王”随机行走的熵率。

,

试求失真矩阵 和平均失真度 。

答:

由式(3-4)的失真矩阵可得

由信道转移概率矩阵 和式(3-7) 能够取得,平均失真度 为

2. 已知一个等概率无经历信源 ,其失真函数为

试求:(1)率失真函数 ;(2)当信源 , 时的 。

答:

(1)失真函数矩阵 为

由信道对称性可设信道转移概率矩阵为

由 得, 许诺失真 为

因此信源的状态极限概率为:

因此信源的符号极限概率为:

(2)信源处在某一状态输出符号的条件熵为:

(比特/符号)

(比特/符号)

(比特/符号)

(3)马尔科夫信源熵为:

(比特/符号)

10. 一个马尔可夫进程的大体符号为0,l,2,这3个符号等概率显现,而且具有相同的转移概率。

(1) 画出一阶马尔可夫过程的状态图,并求稳定状态下的一阶马尔可夫信源熵H1。

由于失真度 为对称性, 亦为对称性,并由概率归一性,故可进一步假设转移概率矩阵:

其中,假设 为信道的转移概率。

将 代入到转移概率矩阵 ,取得:

再由概率性质 ,求得信宿端各符号的概率散布为

进而能够取得信宿接收的各消息的概率散布

由此能够取得:

最后可求得:

(比特/信源符号)

8. 设一等概率离散无经历信源 ,其失真函数为汉明失真函数,

因此

因此第二个实验好些。

(2) ,因此要求出 , 和 。由于 、 是彼此独立的实验,因此 。

(见表2-2和表2-3)

表2-2

00

01

10

11

0

1

0

0

0

1

0

0

1

0

2

0

1/2

0

1/2

表2-3

00

01

10

11

0

1/4

0

0

0

1

0

0

1/4

0

2

0

1/4

0

1/4

1/4

1/4

1/4

1/4

能够看到:做 和 两个实验比做 一个实验可多取得的信息为

答:语法信息是最大体最抽象的类型,它只是表现事物的现象而不考虑信息的内涵。语义信息是对客观现象的具体描述,不对现象本身做出好坏判定。语用信息是信息的最高层次。它以语法、语义信息为基础,不仅要考虑状态和状态之间关系和它们的含义,还要进一步考察这种关系及含义关于信息利用者的效用和价值。三者之间是内涵与外延的关系。