Hadoop Reducer中的key、value不能直接放入集合

Hadoop试题试题库

1. 以下哪一项不属于Hadoop可以运行的模式___C___。

A。

单机(本地)模式B。

伪分布式模式C. 互联模式D. 分布式模式2. Hadoop的作者是下面哪一位__B____。

A. Martin FowlerB. Doug cuttingC。

Kent BeckD. Grace Hopper3. 下列哪个程序通常与NameNode 在同一个节点启动__D___.A. TaskTrackerB. DataNodeC. SecondaryNameNodeD. Jobtracker4. HDFS 默认Block Size的大小是___B___。

A。

32MBB.64MBC.128MBD。

256M5。

下列哪项通常是集群的最主要瓶颈____C__。

A. CPUB. 网络C. 磁盘IOD。

内存6. 下列关于MapReduce说法不正确的是_____C_。

A. MapReduce是一种计算框架B. MapReduce来源于google的学术论文C. MapReduce程序只能用java语言编写D. MapReduce隐藏了并行计算的细节,方便使用8. HDFS是基于流数据模式访问和处理超大文件的需求而开发的,具有高容错、高可靠性、高可扩展性、高吞吐率等特征,适合的读写任务是__D____.A.一次写入,少次读B.多次写入,少次读C.多次写入,多次读D.一次写入,多次读9。

HBase依靠__A____存储底层数据。

A。

HDFSB。

HadoopC. MemoryD. MapReduce10. HBase依赖___D___提供强大的计算能力。

A. ZookeeperB。

ChubbyC. RPCD。

MapReduce11。

HBase依赖___A___提供消息通信机制A. ZookeeperB. ChubbyC。

RPCD. Socket12. 下面与HDFS类似的框架是___C____?A. NTFSB. FAT32C. GFSD. EXT313。

mapreduce实现reduce过程的方法

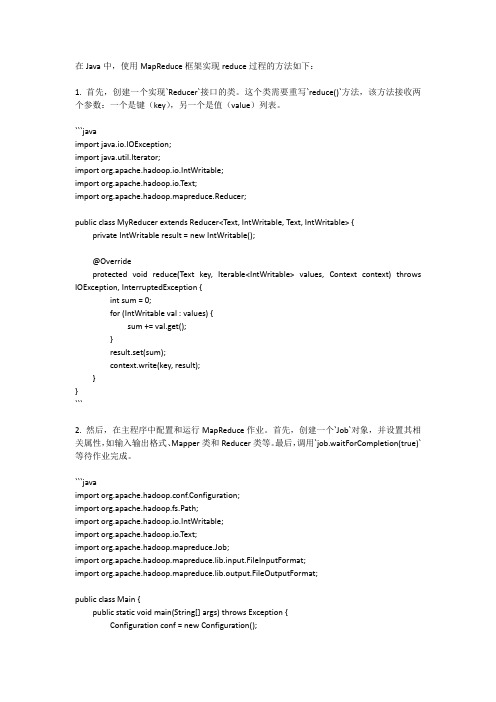

在Java中,使用MapReduce框架实现reduce过程的方法如下:1. 首先,创建一个实现`Reducer`接口的类。

这个类需要重写`reduce()`方法,该方法接收两个参数:一个是键(key),另一个是值(value)列表。

```javaimport java.io.IOException;import java.util.Iterator;import org.apache.hadoop.io.IntWritable;import org.apache.hadoop.io.Text;import org.apache.hadoop.mapreduce.Reducer;public class MyReducer extends Reducer<Text, IntWritable, Text, IntWritable> { private IntWritable result = new IntWritable();@Overrideprotected void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {int sum = 0;for (IntWritable val : values) {sum += val.get();}result.set(sum);context.write(key, result);}}```2. 然后,在主程序中配置和运行MapReduce作业。

首先,创建一个`Job`对象,并设置其相关属性,如输入输出格式、Mapper类和Reducer类等。

最后,调用`job.waitForCompletion(true)`等待作业完成。

```javaimport org.apache.hadoop.conf.Configuration;import org.apache.hadoop.fs.Path;import org.apache.hadoop.io.IntWritable;import org.apache.hadoop.io.Text;import org.apache.hadoop.mapreduce.Job;import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;public class Main {public static void main(String[] args) throws Exception {Configuration conf = new Configuration();Job job = Job.getInstance(conf, "my mapreduce job");job.setJarByClass(Main.class);job.setMapperClass(MyMapper.class);job.setCombinerClass(MyReducer.class);job.setReducerClass(MyReducer.class);job.setOutputKeyClass(Text.class);job.setOutputValueClass(IntWritable.class);FileInputFormat.addInputPath(job, new Path(args[0]));FileOutputFormat.setOutputPath(job, new Path(args[1]));System.exit(job.waitForCompletion(true) ? 0 : 1);}}```这样,就实现了使用MapReduce框架在Java中实现reduce过程的方法。

(完整版)hadoop习题册

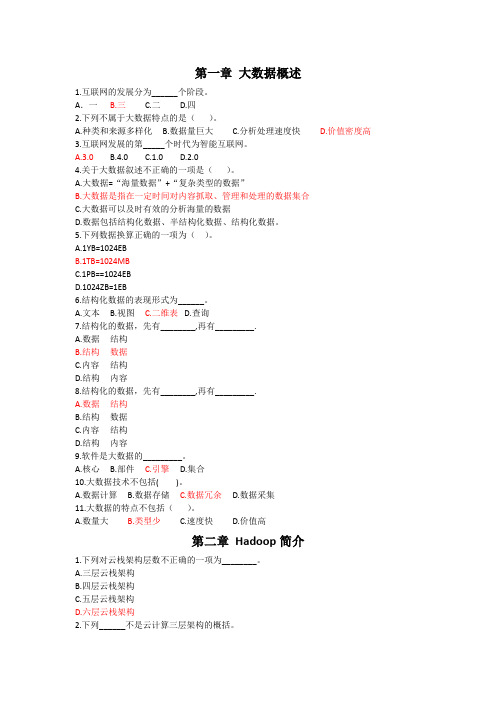

第一章大数据概述1.互联网的发展分为______个阶段。

A.一 B.三 C.二 D.四2.下列不属于大数据特点的是()。

A.种类和来源多样化B.数据量巨大C.分析处理速度快D.价值密度高3.互联网发展的第_____个时代为智能互联网。

A.3.0B.4.0C.1.0D.2.04.关于大数据叙述不正确的一项是()。

A.大数据=“海量数据”+“复杂类型的数据”B.大数据是指在一定时间对内容抓取、管理和处理的数据集合C.大数据可以及时有效的分析海量的数据D.数据包括结构化数据、半结构化数据、结构化数据。

5.下列数据换算正确的一项为()。

A.1YB=1024EBB.1TB=1024MBC.1PB==1024EBD.1024ZB=1EB6.结构化数据的表现形式为______。

A.文本B.视图C.二维表D.查询7.结构化的数据,先有________,再有_________.A.数据结构B.结构数据C.内容结构D.结构内容8.结构化的数据,先有________,再有_________.A.数据结构B.结构数据C.内容结构D.结构内容9.软件是大数据的_________。

A.核心B.部件C.引擎D.集合10.大数据技术不包括( )。

A.数据计算B.数据存储C.数据冗余D.数据采集11.大数据的特点不包括()。

A.数量大B.类型少C.速度快D.价值高第二章Hadoop简介1.下列对云栈架构层数不正确的一项为________。

A.三层云栈架构B.四层云栈架构C.五层云栈架构D.六层云栈架构2.下列______不是云计算三层架构的概括。

A.IaaSB.PaaSC.SaaPD.SaaS3.IaaS基础设施及服务可以称为______。

A.弹性计算B.效用计算C.有效计算D.随需应用4.四层云栈模式,是将三层模式中的_________进行分解,分为两层,一层为硬件层,一层为虚拟资源层。

A.硬件部分B.虚拟化部分C.基础设施D.平台5.五层云栈模式,第五层为______。

Hadoop基础(习题卷18)

Hadoop基础(习题卷18)第1部分:单项选择题,共53题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]下列不属于Python中Flask框架特点的是?A)内置开发服务器和调试器B)与Python单元测试功能无缝衔接C)使用Jinja2模板D)端口号固定为5000,且无法修改答案:D解析:2.[单选题]在Java中,方法resume( )负责重新开始▁▁线程的执行A)被stop( )方法停止B)被sleep( )方法停止C)被wait( )方法停止D)被suspend( )方法停止答案:D解析:3.[单选题]在Java中,假如电脑上E盘没有xxx目录,则下面程序功能描述正确是_x000D_File file1=new File("e:\\xxx\\yyy"); file1.mkdir()A)在当前目录下生成子目录:\xxx\yyyB)在E盘自动创建xxx/yyy目录C)在当前目录下生成文件xxx.yyyD)代码执行后E盘不会产生任何目录答案:D解析:4.[单选题]在Hadoop上提交Job时不涉及哪个实体()A)客户端B)HDFSC)SecondaryNodeD)JobTracker答案:C解析:5.[单选题]下面哪些不是引起 Spark 负载不均的原因?( )A)Spark 读入的数据源是倾斜的B)Shuffle 阶段 Key 值过于集中C)在数据过滤阶段需要处理的数据量差异D)Spark 的运行方式差异答案:D解析:6.[单选题]配置Hadoop时,JAVA_HOME包含在哪一个配置文件中?A)hadoop-default.xmlC)hadoop-site.xmlD)configuration.xml答案:B解析:7.[单选题]在 hadoop 配置中 yarn-site.xml 作用是( )A)用于定义系统级别的参数B)用于名称节点和数据节点的存放位置C)用于配置 JobHistory Server 和应用程序参数D)配置 ResourceManager,NodeManager 的通信端口答案:D解析:8.[单选题]HDFS中的block默认保存____份。

Spark基础(习题卷1)

Spark基础(习题卷1)说明:答案和解析在试卷最后第1部分:单项选择题,共72题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]在Spark中,Scala Map 的常用方法中,以下选项中哪一个是返回所有的 KeyA)def isEmptyB)defkeysC)defremoveD)defsum2.[单选题]创建一个HDFS客户端对象时,Configuration实例会自动加载HDFS的配置文件(),从中获取Hadoop集群的配置信息。

A)hadoop-default.xmlB)hadoop-env.shC)hadoop-site.xmlD)core-site.xml3.[单选题]在Scala中,以下选项中哪一个是合并数组A)def apply(x:T,xs:T*)B)def concat[T](xss:Array[T]*)C)def copy(src:AnyRef,srcPos:Int,dest:AnyRef,destPos:Int,length:Int)D)def empty[T]4.[单选题]在Spark中,first( )方法属于什么操作?A)转换操作B)行动操作C)集合操作D)以上都不是5.[单选题]以下选项中,哪个程序负责HDFS数据存储。

A)NameNodeB)DataNodeC)Secondary NameNodeD)ResourceManager6.[单选题]Hive最重视的性能是可测量性、延展性、()和对于输入格式的宽松匹配性A)较低恢复性B)容错性C)快速查询D)可处理大量数据B)libC)binD)sbin8.[单选题]客户端连接Zookeeper集群的命令是()。

A)get /zkB)delete /zkC)zkCli.shD)ls /9.[单选题]在Spark中,如果Job的某个Stage阶段计算失败,重新计算的默认次数是?A)1B)2C)3D)410.[单选题]下列语句描述错误的是()A)可以通过CLI方式、Java API方式调用SqoopB)Sqoop底层会将Sqoop命令转换为MapReduce任务,并通过Sqoop连接器进行数据的导入导出操作。

hadoop mapreduce工作原理

hadoop mapreduce工作原理

Hadoop MapReduce是一种分布式计算模型,用于处理大数据集。

它有两个主要组件:Map和Reduce。

Map阶段:在MapReduce任务中,数据被拆分成几个小块,

然后并行传输到不同的节点上。

每个节点上都运行着一个

Map任务。

在Map阶段,每个节点独立地对其分配到的数据

块进行处理。

这些数据块被输入给一个映射函数,该函数将输入数据转换成<Key, Value>对。

映射函数将生成许多中间<Key, Value>对,其中Key是一个唯一的标识符,Value是与该Key

相关联的数据。

Shuffle阶段:在Map阶段之后,中间的<Key, Value>对被分

区并按照Key进行排序。

然后,相同Key的值被分组在一起,并传输到下一个Reduce节点。

在此过程中,数据在不同的节

点之间进行移动,以便形成适合进行Reduce操作的数据分区。

Reduce阶段:在Reduce阶段,每个Reduce节点只处理与特

定Key相关联的所有Value。

Reduce节点将这些Value作为输

入传给一个归约函数。

归约函数可以对这些Value执行合并、

计算或其他操作来得到最终的输出结果。

整个MapReduce过程的主要思想是将大任务分解成更小的子

任务,然后并行执行这些子任务,并将结果进行合并以生成最终的输出。

这种计算模型能够充分利用分布式计算集群的处理能力,从而高效地处理大规模的数据集。

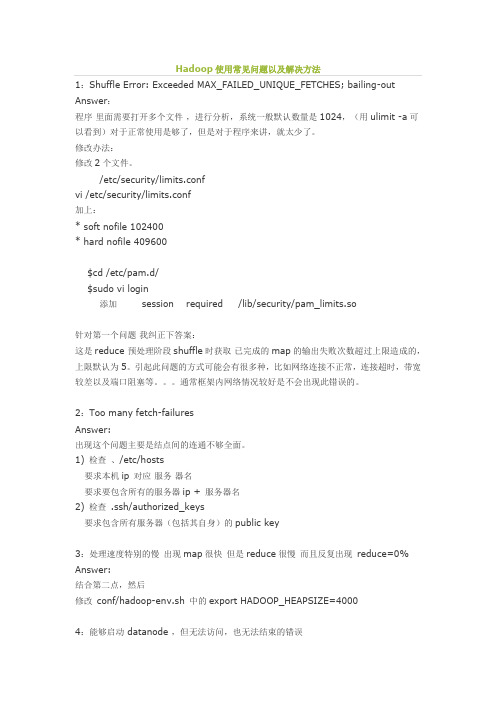

Hadoop使用常见问题以及解决方法

Hadoop使用常见问题以及解决方法1:Shuffle Error: Exceeded MAX_FAILED_UNIQUE_FETCHES; bailing-out Answer:程序里面需要打开多个文件,进行分析,系统一般默认数量是1024,(用ulimit -a可以看到)对于正常使用是够了,但是对于程序来讲,就太少了。

修改办法:修改2个文件。

/etc/security/limits.confvi /etc/security/limits.conf加上:* soft nofile 102400* hard nofile 409600$cd /etc/pam.d/$sudo vi login添加 session required /lib/security/pam_limits.so针对第一个问题我纠正下答案:这是reduce 预处理阶段shuffle时获取已完成的map的输出失败次数超过上限造成的,上限默认为5。

引起此问题的方式可能会有很多种,比如网络连接不正常,连接超时,带宽较差以及端口阻塞等。

通常框架内网络情况较好是不会出现此错误的。

2:Too many fetch-failuresAnswer:出现这个问题主要是结点间的连通不够全面。

1) 检查、/etc/hosts要求本机ip对应服务器名要求要包含所有的服务器ip + 服务器名2) 检查 .ssh/authorized_keys要求包含所有服务器(包括其自身)的public key3:处理速度特别的慢出现map很快但是reduce很慢而且反复出现reduce=0% Answer:结合第二点,然后修改conf/hadoop-env.sh 中的export HADOOP_HEAPSIZE=40004:能够启动 datanode ,但无法访问,也无法结束的错误在重新格式化一个新的分布式文件时,需要将你NameNode上所配置的.dir 这一namenode用来存放NameNode持久存储名字空间及事务日志的本地文件系统路径删除,同时将各DataNode上的dfs.data .dir的路径DataNode存放块数据的本地文件系统路径的目录也删除。

共现矩阵解题报告

共现矩阵解题报告ASSIGNMENT #2: WORD CO-OCCURRENCE MATRIX00948181 单子非1.共现矩阵问题统计文档中每两个词出现在同一个句子中的次数,统计共现矩阵对语义分析、数据挖掘都有重要意义。

本报告中,作者使用Hadoop编程,计算了莎士比亚文献集的共现矩阵。

作者采用了Stripe 的方法对数据传输格式进行了优化,将数据传输量减小了一半;并采用In-Map Combing策略和定制Combiner类,大幅减小了数据的规模。

Map的输出value格式采用了hadoop的Text类,以字符串方式传输并进行解析,方法简便。

最后,作者对得到的共现矩阵数据进行了解析,发现绝大多数词对的共现次数小于等于5,共现次数最高的单词大多是英语常用高频词;通过对非常用高频词的解析,还发现了一些有趣的现象,如:这些文献中大量使用古英语人称代词和语体,以及文献的主题多为王室相关。

2.共现矩阵问题的定义如下:在文档集合中,任意两个单词共同出现在同一句子中的次数构成一个矩阵,我们要编程求这个矩阵。

考虑到问题的大规模数据量和可扩展性,我们用hadoop 编程,使用MapReduce算法求解。

Hadoop编程中,用户可定制的部分有Mapper、Reducer、Combiner和Partition四部分。

我们这里主要关注Mapper、Reducer和Combiner的编写。

最朴素的算法是基于pair的算法。

3.3.1.PAIR方法下面简单介绍朴素的Pair方法。

Mapper:map方法处理每个句子,切词之后二重循环遍历句中每个单词a和b,将< <a, b>, 1>作为Mapper的输出发送。

输出格式中,key为二元组<a, b>,value为整数,代表出现频率。

Reducer:reduce方法收集到的数据中,key为<a, b>,代表统计的两个单词,确定了共现矩阵中的一个元素;value为list<int>,将其元素累加后,可以直接得到两个词的共现次数x。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Hadoop Reducer中的key、value不能直接放入集合我的案例是对一个IP地址文件进行统计共有多少个独立的ip地址类似这样的后面的就不显示了:第一次代码关键看reduce:package apache.ip;import java.io.IOException;import java.util.HashSet;import java.util.Set;import mac1.FlowBean;import mac1.Mac1Main;import org.apache.hadoop.conf.Configuration;import org.apache.hadoop.fs.Path;import org.apache.hadoop.io.LongWritable;import org.apache.hadoop.io.Text;import org.apache.hadoop.mapreduce.Job;import org.apache.hadoop.mapreduce.Mapper;import org.apache.hadoop.mapreduce.Reducer;import org.apache.hadoop.mapreduce.lib.input.FileInputFormat; import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;public class IPMain {public static void main(String[] args) throws IOException, InterruptedException, ClassNotFoundException {Configuration conf = new Configuration();Job job = new Job(conf,"IPMain");job.setJarByClass(IPMain.class);job.setMapperClass(IPMapper.class);job.setReducerClass(IPReducer.class);job.setOutputKeyClass(Text.class);job.setOutputValueClass(Text.class);String in = "hdfs://master:9000/ip.txt";String out = "hdfs://master:9000/outip";FileInputFormat.addInputPath(job, new Path(in));FileOutputFormat.setOutputPath(job, new Path(out));job.waitForCompletion(true);}static class IPMapper extends Mapper<LongWritable, Text, Text, Text>{private static Set<Text> set = new HashSet<Text>();protected void map(LongWritable key, Text value, Context context) throws java.io.IOException ,InterruptedException {Text text = new Text();String input = value.toString();String[] arr = input.split(" ");text.set(arr[0]);set.add(text);};protected void cleanup(Context context) throws java.io.IOException ,InterruptedException{for(Text t : set){context.write(t, new Text(""));}};}static class IPReducer extends Reducer<Text, Text, Text, Text>{ private static Set<Text> set = new HashSet<Text>();private Text text = new Text("");protected void reduce(Text key,Iterable<Text> value,Context context) throws java.io.IOException ,InterruptedException{set.add(key); //第一次代码我是直接放入集合,利用集合自身的去重功能//Text t= new Text(); //下面三行是第二次成功正确的代码//t.set(key.toString());//set.add(key);//Context.write(key,new Text(“”));//第三次代码:不要cleanup 了,直接输出key,得到的ip也是正确的,因为我没取一次就write到内存了,第二次变了Text值,再输出到一块内存中又是新的数了。

但是不能输出汇总数。

};protected void cleanup( Context context) throws java.io.IOException ,InterruptedException{for(Text tt:set){context.write(tt, text);}text.set( set.size()+"");context.write(new Text("总ip数"), text);//最后我不仅输出ip个数,还有ip的内容};}}得到的结果,总数是对的,但是IP地址全是一个:经过分析得知:为了优化性能,hadoop架构中大量的使用重用,包括对象和jvm等待,这里的reduce方法会反复执行多次,由于变量会重用,也就是说,值会被覆盖,所以只能将其中的值取出另存或者重新clone一个对象,而不能直接赋引用,因为引用从始至终都是指向同一个对象,你如果直接保存它们,那最后它们都指向最后一个输入记录。

会影响最终计算结果而出错。

结合我的情况分析如下:我的IP地址map传来的都是不同内存地址的Text对象,map是正常的没错,经过shuffle 洗牌分组排序后,根据Text字典默认排序,最大的ip地址,61.160.224.145就在内存中的最后一个了,reduce开始从内存中取数存入第一个IP地址的Text对象,然后我把对象直接就放入set,reduce取第二个Text的时候,复用了第一次创建的Text临时变量,改变值(Text.set(“ip”))而已,然后被我接收,存第二个。

存第三个。

直到最后一个最大的61.160.224.145,每取一次我存一次,到最后所有的对象的引用都是同一个内存地址,而当最后一个ip被我接受后,所有的对象的值都指向了常量池的”61.160.224.145”,所以结果都是61.160.224.145,而总数是591.那么很多会有疑问,既然是同一个地址的Text对象为什么还能放入Set集合呢。

原因如下:java8大基本类型的hashcode和equals方法比较的是值,String类型比较的是字符串。

而HashSet HashMap 很明显先比较类的hashcode,再比较equals方法Text类型属于String类型,所以hashcode方法跟String值相关,第一次放入的ip地址”61.160.224.138”肯定放进去了,hashcode假设是2323,那么hashcode mod取余后(假设是3)存入HashSet集合中,集合中有一套hash表映射关系,余数 3 --->2323,2345,2356等,第二个ip地址61.160.224.143 过来的时候,Text只是改变值,内存地址是一样的,也就是说前一个”61.160.224.138”对应Text对象的新的hashcode和现在这个ip 61.160.224.143地址Text的hashcode是一样的,这个是肯定的,但是为什么第二个ip 61.160.224.143还是能放进去,因为HashSet集合存的映射关系还是维持之前的,这个不会变,所以第二个ip地址对应的hashcode取余后只要跟3不一样就可以放进去,或者=3,但是hashcode 不是2323,就可以放进hashSet啦,神奇的是,当放完所有可以放入的ip地址后,set遍历的结果都是同一个IP地址,而且是最大的那个(hadoop-shuffle排序的结果)举个例子:大家看我重写了hashcode方法和equals方法(比较简单,实际上重写的hashcode 和equals方法比较复杂)Public class Student {public Student(int name) {=name;}private int name;@Overridepublic int hashCode() {// TODO Auto-generated method stubreturn name;}@Overridepublic boolean equals(Object obj) {// TODO Auto-generated method stubif(obj instanceof Student){Student s = (Student)obj;return == ;}return false;}}Main函数:Student s1 = new Student(1);Set<Student> set1 = new HashSet<Student>();set1.add(s1); = 2;set1.add(s1);System.out.println(set1);for(Student s :set1){System.out.println();}输出结果:[day07.Test$Student@2, day07.Test$Student@2] 22所以看到了吧,放是可以放进去的,但是值都变成2了。