第三章:信源、熵率及冗余度

信源熵

I ( y j ) I ( y j | xi ) I ( y j )

19

条件互信息量

条件互信息量: 在给定 zk 的条件下,xi 与 y j 之间的互信

I ( xi ; y j ) 0 后验概率 先验概率,X 与 Y 统计独立

I ( xi ; y j ) 0 后验概率 先验概率:由于信道受到干扰, 信宿收到 y j 后不但未使 xi 的不确定度 减少,反而增大了 xi 的不确定度 两个消息之间的互信息不大于其中任一消息的自信息 I ( xi ; y j ) I ( xi ) I ( x i | y j ) I ( x i )

符号从平均意义上表征信源总体特性的一个量对于特定的信源其熵只有一个1log?niiipxpx????1logniiipxpx????信息熵的物理含义信源输出前表征信源的平均不确定度信源输出后表征信源发出的每个消息所能提供的平均信息量是一个统计量反映了随机变量x的随机性22统计热力学中熵是表示分子混乱程度的一个物理量在孤立系统中进行的自发过程总是沿着熵增加的方向进行它是不可逆的平衡态相应于熵取最大值的状态即熵增加原理香农借用热力学中熵来描述信源的平均不确定度在信息论中有用的信息熵只会减少不会增加所以信息熵也被称为负热熵ijxyxy

2

信源的分类

信源输出以符号形式出现的具体消息,其分类如下: 按发送消息的时间和取值空间的分布 离散信源 单符号离散信源 连续信源 信源发出的 按发出符号之间的关系 消息是离散的、 无记忆信源 有限的或无限可 列的符号,且一 有记忆信源 个符号代表一条 按发送一条消息所需要的符号数 完整的消息 单个符号信源 符号序列信源

三种表达形式等效

log log p( x i y j ) p( x i ) p( y j ) p( y j | x i ) p( y j )

信源及信源熵介绍

2.2.1 自信息量

2. 不确定度 定义:随机事件的不确定度在数量上等于它的 自信息量.

说明:

a. 两者的单位相同,但含义却不相同。 b. 具有某种概率分布的随机事件不管发生与否,都存在

不确定度,不确定度表征了该事件的特性,而自信息 量是在该事件发生后给予观察者的信息量。

15

2.2.1 自信息量

22

2) 因为X中各符号xi的不确定度I(xi)为非负值,p(xi)也 是非负值,且0 p(xi)1,故信源的平均不确定度H(X) 也是非负量。

3) 平均不确定度H(X)的定义公式与热力学中熵的表示形 式相同,所以又把H(X)称为信源X的熵。熵是在平均意 义上来表征信源的总体特性的,可以表征信源的平均不确 定度。

2

p(xi ) log 2 p(xi ) i 1

= 0.72比特/次 说明:

1) 自信息量I(x1)和I(x2)只是表征信源中各个 符号的不确定度,一个信源总是包含着多个符 号消息,各个符号消息又按概率空间的先验概 率分布,因而各个符号的自信息量就不同。所 以自信息量不能作为信源总体的信息量。

=3 × 105 × 3.32 比特/画面

25

有一篇千字文章,假定每字可从万字表中任选, 则共有不同的千字文 N=100001000=104000 篇 仍按等概率1/100001000计算,平均每篇千字文 可提供的信息量为 H(X)=log2N =4 × 103 × 3.32

1.3 × 104 比特/千字文

离散消息的信源,如文字、数字、数据等符号都是

离散消息。

{ 离散信源

离散无记忆信源 离散有记忆信源

{ {

5

发出单个符号的无记忆信源 发出符号序列的无记忆信源 发出符号序列的有记忆信源 发出符号序列的马尔可夫信源

信息论基础-第三章

信息论基础-第三章

3.3.2 离散平稳有记忆信源的熵(3)

定理 3.3.1:任意离散平稳信源,若 H1(X)

1) H(XN/X1 XN1)不随N而增加 2) H N (X ) H (X N /X 1 X N 1 ) 3) HN (X)不随N而增加 4) H(X) 存在,且 H (X ) N l i H m (X N /X 1 X N 1 )

信息论基础-第三章

3.3.1 离散平稳信源(3)

例 3.3.1 一平稳信源X的符号集A={0,1},产生随机序列, 其中P(x1=0)=p, 求P(xn=1)(n >1)的概率。

解:

平稳性 P(xn0)p

P(xn1)1p

信息论基础-第三章

3.3.1 离散平稳信源(4)

例 3.3.1续 对同一信源,若P(x1=0,x2=1)=b 求P(x4=1/x3=0)。

信息论基础-第三章

3.3.2 离散平稳有记忆信源的熵(5)

2) 只要证明N个 HN (X)的和不小于 NH (XN/X 1 XN 1)

NN H (X )H (X 1 X N) H (X 1)H (X 2/X 1) H (X N/X 1 X N 1) NH (X N/X 1 X N 1)

H N ( X ) H ( X N /X 1 X N 1 )

平均符号熵不小于条件熵

信息论基础-第三章

3.3.2 离散平稳有记忆信源的熵(6)

3) 由于 NHN(X) H ( X 1 X N 1 ) H ( X N /X 1 X N 1 ) 根据平均符号熵的定义和2)的结果,有 N H N (X ) (N 1 )H N 1 (X ) H (X N /X 1 X N 1 ) (N 1 )H N 1 (X ) H N (X )

最新信息论重点-(新)

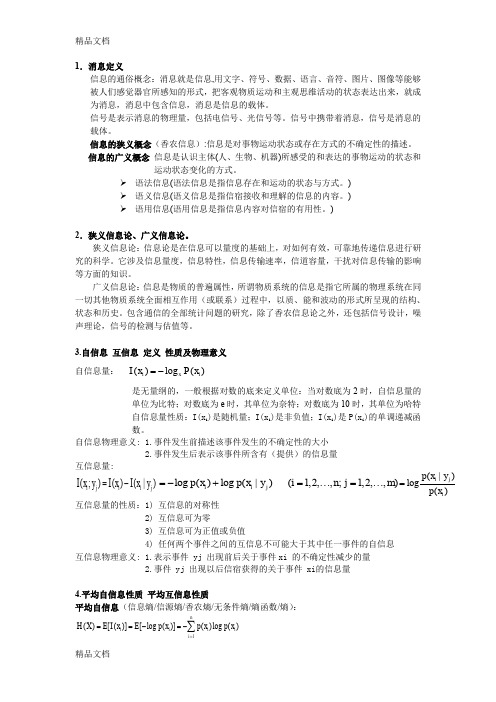

1.消息定义信息的通俗概念:消息就是信息,用文字、符号、数据、语言、音符、图片、图像等能够被人们感觉器官所感知的形式,把客观物质运动和主观思维活动的状态表达出来,就成为消息,消息中包含信息,消息是信息的载体。

信号是表示消息的物理量,包括电信号、光信号等。

信号中携带着消息,信号是消息的载体。

信息的狭义概念(香农信息):信息是对事物运动状态或存在方式的不确定性的描述。

信息的广义概念 信息是认识主体(人、生物、机器)所感受的和表达的事物运动的状态和运动状态变化的方式。

语法信息(语法信息是指信息存在和运动的状态与方式。

) 语义信息(语义信息是指信宿接收和理解的信息的内容。

) 语用信息(语用信息是指信息内容对信宿的有用性。

)2.狭义信息论、广义信息论。

狭义信息论:信息论是在信息可以量度的基础上,对如何有效,可靠地传递信息进行研究的科学。

它涉及信息量度,信息特性,信息传输速率,信道容量,干扰对信息传输的影响等方面的知识。

广义信息论:信息是物质的普遍属性,所谓物质系统的信息是指它所属的物理系统在同一切其他物质系统全面相互作用(或联系)过程中,以质、能和波动的形式所呈现的结构、状态和历史。

包含通信的全部统计问题的研究,除了香农信息论之外,还包括信号设计,噪声理论,信号的检测与估值等。

3.自信息 互信息 定义 性质及物理意义 自信息量: ()log ()i x i I x P x =-是无量纲的,一般根据对数的底来定义单位:当对数底为2时,自信息量的单位为比特;对数底为e 时,其单位为奈特;对数底为10时,其单位为哈特自信息量性质:I(x i )是随机量;I(x i )是非负值;I(x i )是P(x i )的单调递减函数。

自信息物理意义: 1.事件发生前描述该事件发生的不确定性的大小 2.事件发生后表示该事件所含有(提供)的信息量 互信息量:互信息量的性质:1) 互信息的对称性2) 互信息可为零3) 互信息可为正值或负值4) 任何两个事件之间的互信息不可能大于其中任一事件的自信息互信息物理意义: 1.表示事件 yj 出现前后关于事件xi 的不确定性减少的量 2.事件 yj 出现以后信宿获得的关于事件 xi 的信息量4.平均自信息性质 平均互信息性质平均自信息(信息熵/信源熵/香农熵/无条件熵/熵函数/熵):(;)()(|)i j i i j I x y I x I x y =-log ()log (|)(1,2,,;1,2,,)i i jp x p x y i n j m =-+=⋯=⋯(|)log ()i j i p x y p x =1()[()][log ()]()log ()ni i i i i H X E I x E p x p x p x ===-=-∑熵函数的数学特性包括:(1)对称性 p =(p1p2…pn)各分量次序可调换 (2)确定性p 中只要有为1的分量,H(p )为0(3)非负性离散信源的熵满足非负性,而连续信源的熵可能为负。

二次扩展信源的熵

二次扩展信源的熵:

H ( X ) H ( X ) p(i )log 2 p(i ) 3

2 i 1

9

2、离散平稳有记忆信源的概念及其信源熵

离散平稳有记忆信源:输出的符号序列是平稳随机序 列,并且符号之间是相关的,即不是统计独立的信源。 数学模型为:

X X1 X 2 X 3

例3.2

设有一离散无记忆信源X,其概率空间为 x1 x2 x3 X 1 1 1 P X 2 4 4 求该信源的熵率及二次扩展信源的熵。

注意:题目中的概率空间不是离散多符号无记忆信源 的概率空间,而是其对应的离散单符号信源的概率空 间。 该例题是对离散平稳无记忆信源求熵率的一个练习,

二次扩展信源的概率空间:

X 2 1 ( x1 x1 ) 2 ( x1 x2 ) 3 ( x1 x3 ) 4 ( x2 x1 ) 5 ( x2 x2 ) 2 1/ 8 1/ 8 1/ 8 1/16 P( X ) 1/ 4 6 ( x2 x3 ) 7 ( x3 x1 ) 8 ( x3 x2 ) 9 ( x3 x3 ) 1/16 1/ 8 1/16 1/16

X X1 X 2 X 3

离散单符号信源的 N 次平稳无记忆扩展信源( N 次无记忆扩展信源)

它是一种N 次扩展信源,其每次输出的是 N 长符号序 列,数学模型为 N 维离散随机变量序列(随机矢量)

X X1 X 2 X N

其中每个随机变量之间统计独立。由平稳性知,每个 随机变量统计特性相同,故该信源又可表示为:

比特/号

2) 如果不考虑符号间的相关性,则信源熵为

1 4 11 H ( X ) H ( , , ) 1.542 比特/符号 4 9 36

信源与信息熵

信源的描述

• 随机序列的概率

p(x1, x2 , x3,LxL ) = p(xL | xL−1,Lx1) p(x1, x2 ,LxL−1) = p(xL | xL−1,Lx1) p(xL−1 | xL−2 ,Lx1) p(x1, x2 ,LxL−2 ) =L

• 当信源无记忆时

p(x1x2 Lxl LxL ) = p(x1) p(x2 )Lp(xl )Lp(xL ) = ∏p(xl )

0.6 0.4 0 p(s j | si ) = 0.3 0 0.7 0.2 0 0.8

27

• 例2-2:有一个二元二阶马尔可夫信源,其信源 :

符号集为{0,1},已知符号条件概率: p(0|00) = 1/2 p(0|01) = 1/3 p(0|10) = 1/4 p(0|11) = 1/5 p(1|00)=1/2 p(1|01)=2/3 p(1|10)=3/4 p(1|11)=4/5

p ( y j | xi ) = p ( y j ),p ( xi | y j ) = p ( xi ),

⑹

p( xi | y j ) =

p( xi y j )

∑ p( x y )

i =1 i j

n

,p( y j | xi ) =

p( xi y j )

∑ p( x y )

j =1 i j

18

m

2.1.3 马尔可夫信源

s3

(1)1/2

(0)1/2

00 s1

(0)1/3

(0)1/4

s2 01

(1)2/3

j =1

17

概率论基础

• 无条件概率、条件概率、联合概率的性质和关系 ⑷ p ( x i y j ) = p ( x i ) p ( y j | xi ) = p ( y j ) p ( x i | y j ) ⑸ 当X与Y相互独立时, p ( x y ) = p ( x ) p ( y ) i j i j

2-1-信源的描述和分类解析

j

• 若处信状源态处就于变某了一,任状何态时s候i ,当信它源发处出于一什个么符状号态后完,全所 由前一时刻的状态和发出符号决定。

• 系中统 的在 任任 意一 一时 个刻 状可态处,状于态状转态移空时间,转S移={概s1率,s2矩,…阵,sQ}

P

p(s j

|

si )

p11

p1Q

pQ1 pQQ

x2 1/ 6

x3 1/ 6

x4 1/ 6

x5 1/ 6

x6 1/ 6

10

离散无记忆信源

• 发出单个符号的信源

– 指信源每次只发出一个符号代表一个消息;

• 发出符号序列的信源

– 指信源每次发出一组含二个以上符号的符号 序列代表一个消息

X 1 2 3 4 5 6

P

1/

6

1/ 6

1/ 6

1/ 6

信息

6

信源的分类

• 按照信源发出的消息在时间上和幅度上的分布 情况可将信源分成离散信源和连续信源两大类

{ 信源 离散信源: 文字、数据、电报—随机序列 连续信源: 话音、图像—随机过程

• 连续信源

– 指发出在时间或幅度上是连续分布的连续消 息(模拟消息)的信源,如语言、图像、图 形等都是连续消息。

1/ 6

1/ 6

11

信源的描述

• 一个离散信源发出的各个符号消息的集合为:

X {x1, x2,, xn}

a,b,c,…z

• 它们的概率分别为

P {p(x1), p(x2),, p(xn )}

• p(xi): xi的先验概率

• 单符号离散信源的数学模型—概率空间

X P

x1 p(x1

信息论与编码试题集与答案(新)

信息论与编码试题集与答案(新)1. 在无失真的信源中,信源输出由 H (X ) 来度量;在有失真的信源中,信源输出由 R (D ) 来度量。

2. 要使通信系统做到传输信息有效、可靠和保密,必须首先信源编码,然后_____加密____编码,再______信道_____编码,最后送入信道。

3. 带限AWGN 波形信道在平均功率受限条件下信道容量的基本公式,也就是有名的香农公式是log(1)C W SNR =+;当归一化信道容量C/W 趋近于零时,也即信道完全丧失了通信能力,此时E b /N 0为-1.6 dB ,我们将它称作香农限,是一切编码方式所能达到的理论极限。

4. 保密系统的密钥量越小,密钥熵H (K )就越小,其密文中含有的关于明文的信息量I (M ;C )就越大。

5. 已知n =7的循环码42()1g x x x x =+++,则信息位长度k 为 3 ,校验多项式 h(x)= 3 1x x ++ 。

6. 设输入符号表为X ={0,1},输出符号表为Y ={0,1}。

输入信号的概率分布为p =(1/2,1/2),失真函数为d (0,0) = d (1,1) = 0,d (0,1) =2,d (1,0) = 1,则D min = 0 ,R (D min )=1bit/symbol ,相应的编码器转移概率矩阵[p(y/x )]=1001??;D max = 0.5 ,R (D max )= 0 ,相应的编码器转移概率矩阵[p(y/x )]=1010??。

7. 已知用户A 的RSA 公开密钥(e,n )=(3,55),5,11p q ==,则()φn = 40 ,他的秘密密钥(d,n )=(27,55) 。

若用户B 向用户A 发送m =2的加密消息,则该加密后的消息为 8 。

二、判断题1. 可以用克劳夫特不等式作为唯一可译码存在的判据。

(√ )2. 线性码一定包含全零码。

(√ )3. 算术编码是一种无失真的分组信源编码,其基本思想是将一定精度数值作为序列的编码,是以另外一种形式实现的最佳统计匹配编码。

第三章:信源、熵率及冗余度

2)信源的主要特性

信源的最基本的特性是具有统计不确定性,它可用概 率统计特性来描述。

信源特性与分类

信源的描述与分类

单消息(符号)信源:

离散信源 连续变量信源

平稳信源 无/有记忆信源 马尔可夫信源 随机波形信源

实际信源

信源特性与分类

单消息(符号)信源

它是最简单也是最基本的信源,是组成实际信源 的基本单元。它可以用信源取值随机变量的范围 U 和 对 应 概 率 分 布 P(u) 共 同 组 成 的 二 元 序 对 [U,P(u)]来表示。 当信源给定,其相应的概率空间就已给定;反之, 如果概率空间给定,这就表示相应的信源已给定。 所以,概率空间能表征这离散信源的统计特性, 因此有时也把这个概率空间称为信源空间。

单消息(符号)信源--连续变 量信源

对于连续变量信源

U (a, b) = P p(u)

p(u)为 续 量 的 率 度 连 变 u 概 密

其中:

u ∈U = R1 = [0, ∞)

平稳信源

很多实际信源输出的消息往往是由一系列符号序列所组成的。可以把这种信源 输出的消息看做时间上或空间上离散的一系列随机变量,即为随机矢量。这时, 信源的输出可用N维随机矢量 随机矢量X=(X1,X2…XN)来描述,其中N可为有限正整 随机矢量 数或可数的无限值。这N维随机矢量X有时也称为随机序列。 一般来说,信源输出的随机序列的统计特性比较复杂,分析起来也比较困难。 为了便于分析,我们假设信源输出的是平稳的随机序列,也就是序列的统计性 质与时间的推移无关。很多实际信源也满足这个假设。 若信源输出的随机序列X=(X1,X2,…,XN)中,每个随机变量 Xi (i=1,2,…,N)都是取值离散的离散型随机变量,即每个随机变量Xi的可能取值是 有限的或可数的。而且随机矢量X的各维概率分布都与时间起点无关,也就是 在任意两个不同时刻随机矢量X的各维概率分布都相同。这样的信源称为离散 平稳信源。如中文自然语言文字,离散化平面灰度图像都是这种离散型平稳信 源。

信源与信息熵

16

离散平稳信源

• 对于离散平稳信源,有下列结论: ⑴ 条件熵H (XL|XL-1) 随L的增加是非递增的

– 条件较多的熵必小于或等于条件较少的熵, 而条件熵必小于或等于无条件熵。

H ( X L | X 1 X 2 X L 1 ) H ( X L | X 2 X L 1 ) H ( X L 1 | X 1 X L 2 ) H ( X L 1 | X 2 X L 2 ) H ( X L 2 | X 1 X L 3 ) H ( X 2 | X1) H ( X1)

H0(X)≥H1(X)≥H2(X)≥…≥H∞(X)

18

马尔可夫信源的信息熵

• 马尔可夫信源的极限熵

H ( X )

X L 1 ) lim H ( X L | X 1 X 2

L

p( xL | xL1 , x1 ) p( xL | xL1 , xLm )

H ( X ) lim H L ( X ) lim H ( X L | X1 X 2

i 1 l =1 nL L

7

离散无记忆信源的序列熵

• 若又满足平稳特性,即与序号l无关时,概率变 为: L

p( X ) p( xil ) p L

l 1

• 信源的序列熵

H ( X ) LH ( X )

• 平均每个符号(消息)熵为

1 HL(X ) H (X ) H (X ) L

p( X ) p( xi1 , xi2 ,, xiL ) p( xi1 ) p( xi2 | xi1 ) p( xi3 | xi1 xi2 ) p( xiL | xi1 xi2 xiL1 )

1 p( xi1 ) p( xi2 | xi1 ) p( xi3 | xi1 ) p( xiL | xiL ) 1 2

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

C

0 1 0 0 0 0 1 1

Байду номын сангаас

C

0 1 0 0 0 0 1 1

D

0 1 0 0 0 1 0 0

X 1 、X 2、…X8 ,均为单符号随机变量信源X={0,1}, P( X 1 X 2…X8 ) 与时间起点无关平稳 P( X 1 X 2…X8 ) =P(X 1)P(X 2)…P(X8 )无记忆信源

例 3- 4:

电文: 女 孩 儿 在 X CHUYJ KOIUY HSFRT NHYTF

X1 C K H N X2 H 0 S H X3 U I F Y X4 Y U R T X5 J Y T F X1,X2,X3,X4,X5均为单符号随机变量X={A、B、C…Z} P(X1X2X3X4X5)=P (X1)P(X2)P(X3)P(X4)P(X5) 且与时间起点无关, X为一无记忆平稳信源

– 2)信源的主要特性

• 信源的最基本的特性是具有统计不确定性,它可用概率 统计特性来描述。

信源的分类

• 离散信源与连续信源 • 离散信源

– 单符号信源 – 序列信源

• 平稳&非平稳 • 有记忆&无记忆

• 连续信源

– 连续信源 – 波形信源

离散信源-单符号离散信源(1)

– 它是最简单也是最基本的信源,是组成实际信源 的基本单元。 – 这类信源可能输出的消息数是有限的或可数的, 而且每次只输出其中一个消息。因此,可以用一 个离散型随机变量 X 来描述这个信源输出的消息。 这个随机变量 X的样本空间就是符号集 A;而 X的 概率分布就是各消息出现的先验概率,信源的概 率空间必定是一个完备集。

– 信源的统计特性如何? – 如何对信源分类? – 各类信源如何建模?

信源特性

• 信源的统计特性

– 1)什么是信源?

• 信源是信息的来源,实际通信中常见的信源有:语音、 文字、图像、数据 … 。在信息论中,信源是产生消息 (符号)、消息(符号)序列以及连续消息的来源,数 学上,信源是产生 随机变量 X,随机序列 X 和随机过程 X(t,ω)的源。

p(a ) p( x ) p( x

i 1 i i1 1 i2 1 i1

n2

n

n

i2

/ xi1 ) p( xi1 ) p( xi2 / xi1 ) 1

i1 1 i2 1

n

n

离散信源-离散平稳无记忆信源

• 在某些简单的离散平稳信源情况下,信源先后发出的一 个个符号彼此是统计独立的。也就是说信源输出的随机 矢量X=(X1X2…XN)中,各随机变量Xi (i=1,2,…N)之间 是无依赖的、统计独立的,则 N 维随机矢量的联合概率 分布满足P(X)=P(X1)P(X2)…P(XN)

第三章:信源、熵率及冗余度

问题一

• 信息论对信源的研究内容包括哪几个方面?

信息论对信源研究的内容

– 信源的建模:用恰当的随机过程来描述信号

• 关心角度:信号中携带的信息

– 信源输出信号中携带信息的效率的计算

• 熵率、冗余度

– 信源输出信息的有效表示

• 信源编码

问题二

• 从信息论的角度如何为信源建模?

离散信源-单符号离散信源的数学描述

• 对单符号离散信源U 有: U U u1 U ui U un

P p1 pi pn

例3-1:对于二进制数字信源:U={0,1},则有

U u1 0 u2 1 p p1 P 0

离散信源-平稳信源的数学模型(二维)

最简单的离散平稳信源:二维平稳信源 X=X1X2 每两个符号看做一组,每组代表信源X=X1X2的一个消息; 每组中的后一个符号和前一个符号有统计关联,这种概率 性的关系与时间起点无关; 假定符号序列的组与组之间是统计独立的。

设X1,X2 ∈{x1,x2,…,xn},矢量 X∈{x1x1, …x1xn,x2x1, …,x2xn, …xnx1, …,xnxn} 令

例 3- 3: A

X1 X2 X3 X4 X5 X6 X7 X8 0 1 0 0 0 0 0 1

B

0 1 0 0 0 0 1 0

D

0 1 0 0 0 1 0 0

A

0 1 0 0 0 0 0 1

C

0 1 0 0 0 0 1 1

B

0 1 0 0 0 0 1 0

B

0 1 0 0 0 0 1 0

A

0 1 0 0 0 0 0 1

信源建模

• 1. 各字母等概、字母间不相关(字符独立)

XFOML RXKHRJFFJUJ LPWCFWKCYFFJEYVKC QSGHYDQPAAMKBZAACIBZLHJQD.

•

2. 字母出现概率按照英文文本统计,字母间不相关(字符独立)

OCRO HLI RGWR NMIELWIS EU LL NBNESEBYA TH EEI ALHENHTTPA OOBTTVANAH

•

3. 字母出现概率按照英文文本统计,字母间存在二维相关性(两两 相邻字母相关 )

ON IE ANTSOUTINYS ARE T INCTORE ST BE S DEAMY ACHIN D ILONASIVETUCOOWEAT TEASONARE FUSO TIZIN ANDY TOBE SEACE CTISBE.

• 我们称由信源空间[X,P(x)]描述的信源X为离散无记 忆信源。这信源在不同时刻发出的符号之间是无依赖的, 彼此统计独立的。

离散信源-离散无记忆信源的N次扩展信源

• 离散无记忆信源X={ x1,x2,…,xn},对它的输出消息序列,可以 用一组组长度为N的序列来表示它。这时它就等效成了一个新 信源; • 新信源输出的符号是N长的消息序列,用N维离散随机矢量来 描述。ai=(xi1xi2…xiN) i=1,2, …,n 每个分量xik (k=1,2,…,N)都是随机变量,都取值于同一信源X, 并且分量之间统计独立。 • 由随机矢量X组成的新信源称为离散无记忆信源X的N次扩展信 源。 • 离散无记忆信源的N次扩展信源的数学模型是X信源空间的N重 空间。

离散信源-马尔可夫信源

• 表述有记忆信源要比表述无记忆信源困难得多。实际 上信源发出的符号往往只与前若干个符号的依赖关系 强,而与更前面的符号依赖关系弱。为此,可以限制 随机序列的记忆长度。

• 当记忆长度为 m+1 时,称这种有记忆信源为 m 阶马尔 可夫信源。也就是信源每次发出的符号只与前 m个符 号有关,与更前面的符号无关。

哭 SGTRW

S G T R W

离散信源- 二进制无记忆信源的N次扩展信源

• 把信源输出的序列看成是一组一组发出的。

电报系统中,可以认为每二个二进制数字组成一组。这样信源输出的是由二个 二进制数字组成的一组组符号。这时可以将它们等效看成一个新的信源,它由 四个符号00,01,10,11组成,把该信源称为二进制无记忆信源的二次扩展。

REPRESENTING AND SPEEDILY IS AN GOOD APT OR COME CAN DIFFERENT NATURALHERE HE THE A IN CAME THE TOOF TO EXPERT GRAY COME TO FURNISHESTHE LINE MESSAGE HAD BE THESE.

如果把每三个二进制数字组成一组,这样长度为3的二进制序列就有8种不同的 序列,可等效成一个具有8个符号的信源,把它称为二进制无记忆信源的三次扩 展信源。

• 二进制无记忆信源的N次扩展:把每N个二进制数字组成一 组,则信源等效成一个具有2N个符号的新信源,把它称为 二进制无记忆信源的N次扩展信源。

离散信源-离散平稳有记忆信源

• 一般情况下,信源在不同时刻发出的符号之间是相互依赖 的。也就是信源输出的平稳随机序列X中,各随机变量Xi之 间是有依赖的。

– 例如,在汉字组成的中文序列中,只有根据中文的语法、习惯用 语、修辞制约和表达实际意义的制约所构成的中文序列才是有意 义的中文句子或文章。所以,在汉字序列中前后文字的出现是有 依赖的,不能认为是彼此不相关的。其他如英文,德文等自然语 言都是如此。这种信源称为有记忆信源。

离散信源-时齐马尔可夫信源

• 设马 尔可夫 信源各 时刻随 机变量 X k 的取 值为 xk , xk∈Xk , k=1,2,… , i-1,i,i+1,…N ,则描述随机序列中 各随机变量之间依赖关系的条件概率为 P(xi|…xi+2 xi+1 xi-1 xi-2 xi-3 …xi-m …x1) =P(xi|…xi-1 xi-2 x-3 …xi-m) (i=1,2,…N) • 如果上述条件概率与时间起点i无关,即信源输出的符 号序列可看成为时齐马尔可夫链,则此信源称为时齐 马尔可信源。

• 我们需在N维随机矢量的联合概率分布中,引入条件概率分 布来说明它们之间的关联。

例 3- 5:

女孩儿在哭 X THIS GIRL IS

X1 T G I

CRYING

C

X2 H I S R X3 I R Y X4 S L I X5 N X6 G X1,X2,X3,X4,X5均为单符号随机变量X={A、B、C…Z} P(X1X2X3X4X5)≠P (X1)P(X2)P(X3)P(X4)P(X5) 与时间起点无关, X是一有记忆平稳信源

当p0 p1

1 2

0 1 2

1 1 2

离散信源-离散多符号信源

• 实际的信源输出的消息是时间或空间上离散的一系列随机 变量。这类信源每次输出的不是一个单个的符号,而是一 个符号序列。在信源输出的序列中,每一位出现哪个符号 都是随机的,而且一般前后符号的出现是有统计依赖关系 的。这种信源称为多符号离散信源。 • 例 3- 2: THEY ARE MY FRIENDS.