最近邻KD树

KNN算法之KD树

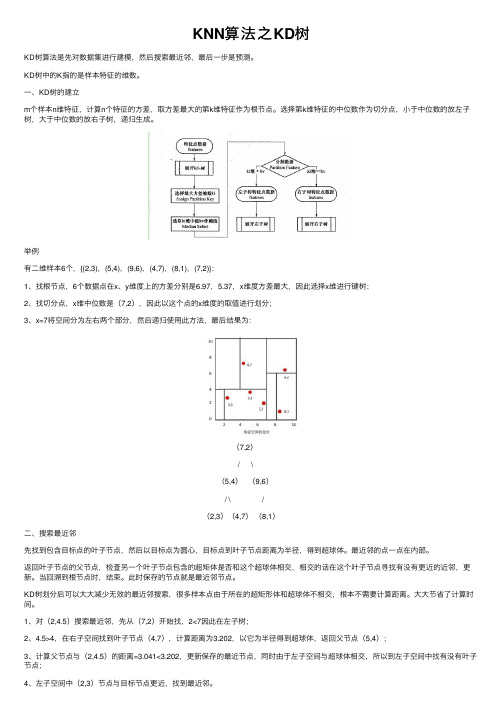

KNN算法之KD树KD树算法是先对数据集进⾏建模,然后搜索最近邻,最后⼀步是预测。

KD树中的K指的是样本特征的维数。

⼀、KD树的建⽴m个样本n维特征,计算n个特征的⽅差,取⽅差最⼤的第k维特征作为根节点。

选择第k维特征的中位数作为切分点,⼩于中位数的放左⼦树,⼤于中位数的放右⼦树,递归⽣成。

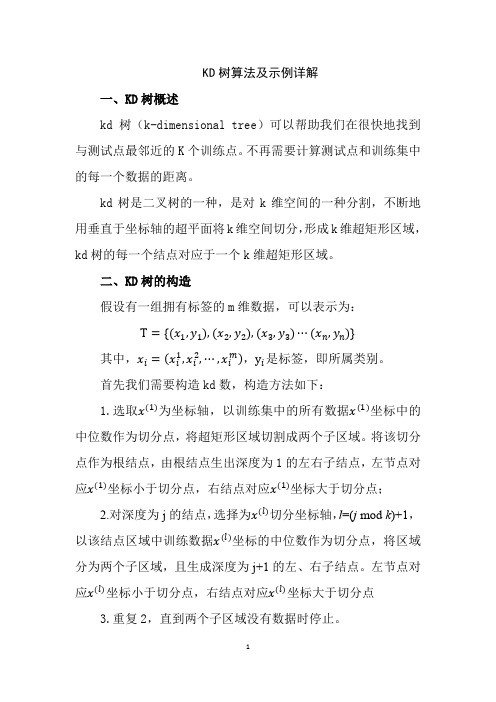

举例有⼆维样本6个,{(2,3),(5,4),(9,6),(4,7),(8,1),(7,2)}:1、找根节点,6个数据点在x、y维度上的⽅差分别是6.97,5.37,x维度⽅差最⼤,因此选择x维进⾏键树;2、找切分点,x维中位数是(7,2),因此以这个点的x维度的取值进⾏划分;3、x=7将空间分为左右两个部分,然后递归使⽤此⽅法,最后结果为: (7,2) / \ (5,4)(9,6) / \ / (2,3)(4,7)(8,1)⼆、搜索最近邻先找到包含⽬标点的叶⼦节点,然后以⽬标点为圆⼼,⽬标点到叶⼦节点距离为半径,得到超球体。

最近邻的点⼀点在内部。

返回叶⼦节点的⽗节点,检查另⼀个叶⼦节点包含的超矩体是否和这个超球体相交,相交的话在这个叶⼦节点寻找有没有更近的近邻,更新。

当回溯到根节点时,结束。

此时保存的节点就是最近邻节点。

KD树划分后可以⼤⼤减少⽆效的最近邻搜索,很多样本点由于所在的超矩形体和超球体不相交,根本不需要计算距离。

⼤⼤节省了计算时间。

1、对(2,4.5)搜索最近邻,先从(7,2)开始找,2<7因此在左⼦树;2、4.5>4,在右⼦空间找到叶⼦节点(4,7),计算距离为3.202,以它为半径得到超球体,返回⽗节点(5,4);3、计算⽗节点与(2,4.5)的距离=3.041<3.202,更新保存的最近节点,同时由于左⼦空间与超球体相交,所以到左⼦空间中找有没有叶⼦节点;4、左⼦空间中(2,3)节点与⽬标节点更近,找到最近邻。

三、KD树预测在kd树搜索最近邻的基础上,选择到了第⼀个最近邻样本,把它设置为已选,然后第⼆轮中忽略这个样本,重新找最近邻。

k最近邻分类模型

k最近邻分类模型K最近邻(K-Nearest Neighbors,KNN)分类模型是一种基于实例的学习,或者说是局部逼近和将所有的计算推迟到分类之后进行的模型。

在KNN模型中,输出是由输入实例的最近邻的K个训练实例的多数表决来确定的。

具体来说,KNN算法的工作流程如下:准备数据,对数据进行预处理。

这包括数据的清洗、特征的选取和标准化等步骤。

选用合适的数据结构存储训练数据和测试元组。

这通常使用一种称为KD树(KD-tree)的数据结构,它可以帮助我们快速找到样本点的最近邻。

设定参数,如K值。

K值的选择对KNN算法的性能有很大的影响,通常需要通过实验来确定最优的K值。

维护一个大小为K的按距离由大到小的优先级队列,用于存储最近邻训练元组。

随机从训练元组中选取K个元组作为初始的最近邻元组,分别计算测试元组到这K个元组的距离,将训练元组标号和距离存入优先级队列。

遍历训练元组集,计算当前训练元组与测试元组的距离,将所得距离L与优先级队列中的最大距离Lmax进行比较。

如果L>=Lmax,则舍弃该元组,遍历下一个元组。

否则,将新的元组及其距离加入优先级队列,并删除队列中距离最大的元组。

当所有训练元组都遍历完毕后,优先级队列中的元组就是测试元组的K个最近邻。

根据这K个最近邻的类别,通过多数表决来确定测试元组的类别。

KNN算法的优点是简单易懂,无需参数估计,无需训练。

但是,它的计算量大,尤其是当样本容量大的时候,因为对每个待分类的文本都要计算它到全体已知样本的距离,才能求得它的K个最近邻点。

此外,KNN算法对样本的依赖性很大,如果样本不平衡,可能会导致分类结果的不准确。

总的来说,K最近邻分类模型是一种简单而有效的分类方法,适用于各种类型的数据,包括文本、图像等。

但是,它的性能受到数据特性、K值选择以及距离度量方式等因素的影响,需要在实际应用中进行适当的调整和优化。

KD树算法及示例详解

KD树算法及示例详解一、KD树概述kd树(k-dimensional tree)可以帮助我们在很快地找到与测试点最邻近的K个训练点。

不再需要计算测试点和训练集中的每一个数据的距离。

kd树是二叉树的一种,是对k维空间的一种分割,不断地用垂直于坐标轴的超平面将k维空间切分,形成k维超矩形区域,kd树的每一个结点对应于一个k维超矩形区域。

二、KD树的构造假设有一组拥有标签的m维数据,可以表示为:T={(x1,y1),(x2,y2),(x3,y3)⋯(x n,y n)}其中,x i=(x i1,x i2,⋯,x i m),y i是标签,即所属类别。

首先我们需要构造kd数,构造方法如下:1.选取x(1)为坐标轴,以训练集中的所有数据x(1)坐标中的中位数作为切分点,将超矩形区域切割成两个子区域。

将该切分点作为根结点,由根结点生出深度为1的左右子结点,左节点对应x(1)坐标小于切分点,右结点对应x(1)坐标大于切分点;2.对深度为j的结点,选择为x(l)切分坐标轴,l=(j mod k)+1,以该结点区域中训练数据x(l)坐标的中位数作为切分点,将区域分为两个子区域,且生成深度为j+1的左、右子结点。

左节点对应x(l)坐标小于切分点,右结点对应x(l)坐标大于切分点3.重复2,直到两个子区域没有数据时停止。

下面举例说明。

设我们有一组二维数据集:{(6,5),(1,-3),(-6,-5),(-4,-10),(-2,-1),(-5,12),(2,1 3),(17,-12),(8,-22),(15,-13),(10,-6),(7,15),(14,1)}将它们在坐标系中表示如下:开始:选择为X坐标轴,中位数为6,即(6,5)为切分点,切分整个区域:可以得到第一层KD树:再次划分区域,以Y轴为坐标轴,选择中位数,可知左边区域为-3,右边区域为-12。

所以左边区域切分点为(1,-3),右边区域切分点坐标为(17,-12),得到如下切分区域:对应的KD树为:再次对区域进行切分,同上步,我们可以得到切分点,切分结果如下:得到如下的KD树:最后分割的小区域内只剩下一个点或者没有点。

KD树数据结构中的多维空间数据检索工具

KD树数据结构中的多维空间数据检索工具KD树(K-dimensional tree)是一种用于多维空间数据检索的数据结构,它在计算机科学领域中被广泛应用于解决各种问题,如最近邻搜索、范围搜索等。

KD树通过将空间划分为多个区域,从而实现高效的数据检索。

本文将介绍KD树数据结构的原理、构建方法以及在多维空间数据检索中的应用。

### 1. KD树数据结构简介KD树是一种二叉树,每个节点代表一个k维空间中的点,其中k 为维度的数量。

在构建KD树时,我们需要选择一个维度作为划分的依据,通常是选择数据集中方差最大的维度。

根据所选维度的中位数,将数据集划分为两部分,左子树包含小于中位数的数据点,右子树包含大于中位数的数据点。

递归地构建子树,直到每个节点只包含一个数据点或数据点为空为止。

### 2. 构建KD树的步骤构建KD树的步骤如下:1. 选择划分维度:选择一个维度作为划分的依据。

2. 选择划分点:找到所选维度的中位数作为划分点。

3. 划分数据集:根据划分点将数据集分为两部分,左子树包含小于划分点的数据点,右子树包含大于划分点的数据点。

4. 递归构建子树:对左右子集分别重复上述步骤,直到每个节点只包含一个数据点或数据点为空。

### 3. KD树的搜索算法在KD树中进行数据检索时,可以通过以下算法实现:1. 从根节点开始,根据当前节点的划分维度和划分点,确定搜索路径。

2. 沿着搜索路径向下遍历KD树,根据当前节点的划分维度和划分点,确定下一个访问的子节点。

3. 如果当前节点是叶子节点,则计算当前节点到目标点的距离,并更新最近邻点。

4. 递归地向上回溯,检查当前节点的父节点的另一子节点是否可能包含更近的点。

5. 如果存在更近的点,则继续向下遍历该子树,直到遍历完整个KD 树。

### 4. KD树在多维空间数据检索中的应用KD树在多维空间数据检索中具有广泛的应用,其中最常见的应用包括最近邻搜索和范围搜索。

1. 最近邻搜索:通过构建KD树,可以高效地找到给定点在多维空间中的最近邻点。

KD树检索的优化方案

KD树检索的优化方案KD树检索是一种非常常见的搜索算法,主要用于解决高维空间中的最邻近搜索问题。

然而,在实际的使用中,由于数据规模的增加和搜索的频繁性,KD树检索往往会面临一些性能上的问题。

本文将从多个方面来讨论如何优化KD树检索的性能,帮助读者提高程序的效率。

一、建造KD树的优化KD树的建造是搜索性能的关键因素之一,因为它会直接影响后续的检索时间。

在建造KD树的过程中,我们可以通过以下几个方面来进行优化:1. 使用随机化算法来选取分割平面在选择分割平面的时候,可以使用随机化算法来选择最佳的切分维度。

因为在实际的情况下,数据的分布往往不是很均匀的,而使用随机化算法可以降低数据分布的影响,从而提高KD树的检索性能。

2. 递归建造过程中使用指针替代数组访问在递归建造KD树的过程中,我们需要不断地访问数据,而数组的访问速度往往比指针慢。

因此,我们可以使用指针替代数组访问,从而提高建造KD树的效率。

3. 采用近似中位数算法来选取分割点在选取分割点的时候,可以使用近似中位数算法来选择最佳的分割点。

因为在高维空间中,找到真正的中位数往往是非常耗时的,而使用近似中位数算法可以大大提高数据分割的效率。

二、KD树检索过程的优化在实际的使用过程中,我们通常需要频繁地进行KD树的检索操作,因此在检索过程中进行合理的优化也是非常重要的。

以下几个方面可以帮助我们优化KD树的检索过程:1. 采用桶排序算法来选择近邻点在KD树检索中,我们经常需要寻找最近邻点,而传统的排序算法往往比较耗时。

因此,我们可以采用桶排序算法来选择近邻点。

桶排序算法可以将数据分散到多个桶里,从而避免了传统排序算法的复杂度。

2. 使用线性空间划分算法来进行区域划分在搜索KD树的过程中,我们需要不断地进行区域划分,而传统的分割算法往往比较耗时。

因此,我们可以尝试使用线性空间划分算法来进行区域划分。

线性空间划分算法可以大大提高数据分割的效率,从而加快KD树的搜索速度。

kd树和BBF算法

d ( x, y ) ( x1 y1 ) 2 ( x2 y2 ) 2 ... ( xn yn ) 2

二、什么是K-D 树

Kd-树是K-dimension tree的缩写,是对数据点在k维 空间(如二维(x,y),三维(x,y,z),k维(x1,y,z..)) 中划分的一种数据结构,主要应用于多维空间关键数据 的搜索(如:范围搜索和最近邻搜索)。本质上说, Kd-树就是一种平衡二叉树。 k-d树也可以理解为一种空间划分树,就是把整个空间 划分为特定的几个部分,然后在特定空间的部分内进行 相关搜索操作。想像一个三维(多维很难想象)空间,kd 树按照一定的划分规则把这个三维空间划分了多个空间, 如下图所示:

构建结果如下图所示:

二、查询K-D 树

输入:构造的kd树,目标点x; 输出:x 的最近邻 算法步骤如下: 1.在kd树中找出包含目标点x的叶结点:从根结点出发,递归 地向下搜索kd树。若目标点x当前维的坐标小于切分点当前维 的坐标,则移动到左子结点,否则移动到右子结点,直到子结 点为叶结点为止。在整个查询过程中一直有一个不断更新优先 级队列。 2.对查询到的叶子结点做边界重叠球测试,以判断是否还需要 继续搜索。具体做法是:判断分隔那些记录的几何边界与以查 询点为中心,以当前最近点为半径的圆或超球体是否相交,若 相交则递归的查询其兄弟结点,若不相交则回溯。 3.当回退到根结点时,搜索结束,最后的更新的最近邻即为x 的最近邻点。

举个例子如查找点为(2,4.5),具体步骤依次如下:

1.首先从根结点(7,2)开始查询,因为根结点是从第一维开始划分的, 所以拿查询点的第一维2与7比较,显然2<7,所以进入(7,2)的左子结 点(5,4)进行查询,同理因为(5,4)结点是按照第二维划分的,所 以拿查询点的第二维4.5 与4比较,显然4.5>4,所以进入(5,4)的右 子结点(4,7)查询。 2.当查询到(4,7)时发现此节点为叶子结点,进行“边界重叠球测 试”,此时是以(2,4.5)为圆心,以(2,4.5)到(5,4)的距离为 半径画圆,发现(4,7)结点与分割该子文件的边界y = 4 相交,则需 要继续对其兄弟结点(2,3)进行查询,此时则更新到最近点(2,3)。 3.按照向下查找的路径向上回溯,每个结点都进行“边界重叠球测试”, 重复上一步。

kdtree用法 -回复

kdtree用法-回复【kdtree用法】一步一步回答Kd树(K-dimensional tree)是一种数据结构,用于对k维空间中的数据进行存储和检索。

它通过将数据点递归地划分为由超平面定义的空间区域,来快速搜索最近邻点和范围查询。

在本文中,我们将一步一步地介绍kdtree的用法。

第一步:构建Kd树构建Kd树的第一步是选择一个数据点作为根节点,然后根据数据点的维度选择一个划分超平面。

通常,这样选择的方法是通过计算数据点集合的方差,选择方差最大的维度作为划分维度。

然后,我们将数据点集合划分为两个子集,左子集包含小于划分值的数据点,右子集包含大于划分值的数据点。

这样,我们可以继续递归地构建树,直到数据点集合为空或数据点维度小于等于0。

第二步:插入新数据点当我们需要插入一个新的数据点时,我们首先找到它在树中的插入位置。

我们从根节点开始,并根据划分超平面的值,将新的数据点插入到左子树或右子树。

如果新的数据点插入到左子树,我们递归调用插入函数,并使用左子树作为根节点。

如果新的数据点插入到右子树,我们递归调用插入函数,并使用右子树作为根节点。

第三步:最近邻查询最近邻查询是Kd树的一个重要应用,它用于在给定数据点集合中找到最接近给定查询点的数据点。

最近邻查询的基本思想是通过递归遍历Kd树的节点,根据给定查询点和当前节点的划分超平面的距离,选择继续遍历的方向。

当我们到达叶节点时,我们记录下当前访问的点,并将其作为当前的最近邻点。

然后,我们回溯到父节点,并继续遍历另一侧的子节点。

在回溯的过程中,我们通过计算当前访问的点和查询点之间的距离,来更新最近邻点。

如果发现当前节点的距离小于当前最近邻点与查询点的距离,我们更新最近邻点。

第四步:范围查询范围查询是Kd树的另一个重要应用,它用于在给定数据点集合中找到在给定范围内的数据点。

范围查询的基本思想是通过递归遍历Kd树的节点,根据给定范围和当前节点的划分超平面的位置,选择继续遍历的方向。

k-d树

16

K-d树的查找

1)精确的点查找

2)最近邻点的查找

3)范围查找

17

K-d树的查找

1)精确的点查找

例如查找点H(85,15)

分辨器

(5,45)

A

(35,42)

X:0

(52,10)

B D

(27,35)

C E

(90,5) (85,15)

Y:1 X: 0

F

H

(62,77)

G Y: 1 (82,65)

X: 0

k-d树

引入k-d树的目的

K-d树的定义

kd树的构造 kd树的插入

K-d树的基本操作

kd树的删除 kd树的查询

K-d树的应用

总结

1

引入k-d树的目的

常见的数据结构都是基于一维空间。不便查 询具有多个关键字索引的数据。 K-d树将搜索拓展到多维空间,大大提高了多 属性关键字的搜索效率。

2

k-d树

优点:

Kd树适用于多维空间关键数据的搜索。如最近邻搜索和 范围搜索。

缺点: 1)在最近邻搜索中,由于有大量的回溯,效率较低。 2)删除操作比较复杂,代价较高。 3)应用不太广泛

26

Thanks

27

薪水300

30,260 25,400 45,350

50,275 60,260

50,100 50,120

年龄35

25,400

45,350 35,350

24

k-d树

引入k-d树的目的

kd树的定义

kd树的构造 kd树的插入

K-d树的基本操作

kd树的删除 kd树的查询

K-d树的应用 总结

25

总结

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

最近邻K_D树——刘家锋

函数名称:CreateKDTree

参数:S--训练样本矩阵(n×d矩阵),Labels--样本的类别标号(n×1矢量),1,…,c 返回值:K-D树

函数功能:K-D树构建算法

function KDTree = CreateKDTree( S, Labels )

n = size(S,1);

KDTree(n) = struct( 'Parrent', [], 'Left', [], 'Right', [], 's', [], 'Sample', [], 'Label', [] ); global KDTree;

%根节点建树

KDTree(1).Parrent = 0;

Create( S, Labels, 1 );

%递归建树函数

function Create( D, Labels, t)

global KDTree;

n = size(D,1); %建树样本数

switch n

case 0 %建树完成

return;

case 1 %建立叶节点

KDTree(t).Sample = D(1,:);

KDTree(t).Label = Labels(1);

KDTree(t).s = 1;

KDTree(t).Left = -1;

KDTree(t).Right = -1;

otherwise %建立中间节点

sigma = var(D);

[y,s] = max(sigma);

%选择方差最大特征维的中值划分样本集

[sortedD,id] = sortrows(D,s);

median = ceil(n/2);

clear sortedD;

KDTree(t).Sample = D(id(median),:);

KDTree(t).Label = Labels(id(median));

KDTree(t).s = s;

if median == 1

KDTree(t).Left = -1;

else

KDTree(t).Left = t+1;

end

KDTree(t).Right = t+median;

KDTree(t+1).Parrent = t;

KDTree(t+median).Parrent = t;

%递归建立左子树

DL = D(id(1:median-1),:);

LabelsL = Labels(id(1:median-1));

Create( DL, LabelsL, t+1);

t = t + median;

%递归建立右子树

DR = D(id(median+1:n),:);

LabelsR = Labels(id(median+1:n));

Create( DR, LabelsR, t);

end

函数名称:KDNNClassify

参数:x--待识别样本(m×d矩阵),KDTree--已构建的K-D树返回值:对x的分类结果(m×1矢量)

函数功能:K-D树最近邻分类算法

p = 1; Head = 1;

Nearest = p; MinDist = inf;

%深度优先搜索K-D树,确定x所在子区域

while p ~= -1

Stack(Head) = p;

Head = Head + 1;

Dist = sqrt( (x-KDTree(p).Sample)*(x-KDTree(p).Sample)' );

if Dist < MinDist

Nearest = p;

MinDist = Dist;

end

s = KDTree(p).s;

if x(s) < KDTree(p).Sample(s)

p = KDTree(p).Left;

else

p = KDTree(p).Right;

end

end

%回溯寻找最近邻样本

while Head ~= 1

Head = Head - 1;

p = Stack(Head);

s = KDTree(p).s;

if abs( x(s) - KDTree(p).Sample(s) ) < MinDist

if x(s) < KDTree(p).Sample(s)

p = KDTree(p).Right;

else

p = KDTree(p).Left;

end

while p ~= -1

Stack(Head) = p;

Head = Head + 1;

Dist = sqrt( (x-KDTree(p).Sample)*(x-KDTree(p).Sample)' );

if Dist < MinDist

Nearest = p;

MinDist = Dist;

end

s = KDTree(p).s;

if x(s) < KDTree(p).Sample(s)

p = KDTree(p).Left;

else

p = KDTree(p).Right;

end

end

end

if p ~= -1

Dist = sqrt( (x-KDTree(p).Sample)*(x-KDTree(p).Sample)' );

if Dist < MinDist

Nearest = p;

MinDist = Dist;

end

end

end

L = KDTree(Nearest).Label;。