Memcached与c++的应用

memcpy函数用法,src 和dts

memcpy函数用法1. memcpy函数是C/C++语言中常用的一个内存拷贝函数,用于将指定长度的内存区域从源位置区域复制到目标位置区域。

在实际编程中,我们经常会用到这个函数来实现数据的复制和移动操作。

2. memcpy函数的用法非常简单,其基本形式为:```cvoid* memcpy(void* destination, const void* source, size_t num);```其中,destination表示目标位置区域,source表示源位置区域,num表示要复制的字节数。

函数的返回值为指向目标位置区域的指针。

3. 我们可以使用memcpy函数来将一个数组的数据复制到另一个数组中,如下所示:```cint src[5] = {1, 2, 3, 4, 5};int dst[5];memcpy(dst, src, 5 * sizeof(int));```上面的代码将src数组中的数据复制到dst数组中,实现了数组的复制操作。

4. 在使用memcpy函数时,需要特别注意源位置区域和目标位置区域之间的内存重叠情况。

如果源位置区域和目标位置区域之间存在重叠部分,那么memcpy函数的行为是未定义的。

在使用memcpy函数时,务必确保源位置区域和目标位置区域没有重叠,或者使用memmove函数来代替。

5. 另外,需要注意的是,memcpy函数并不会进行内存分配操作,它只是将源位置区域的数据按照指定的长度复制到目标位置区域中。

在使用memcpy函数时,要确保目标位置区域有足够的空间来存放复制的数据,否则会出现内存溢出的问题。

6. memcpy函数是一个非常实用的内存操作函数,可以方便地实现数据的复制和移动。

在使用时,需要注意内存重叠和足够的目标位置区域空间,以确保程序的正确性和稳定性。

memcpy函数的基本用法就是这样,希望对大家有所帮助。

7. 在实际编程中,memcpy函数的用途非常广泛。

Memcached网站应用实战

企 业 级 应 用

●

M m ahd 一个 高性 能 的 分布 式 内存 对 象缓存 系统 ,通过 在 内存 里 维护 一 个 统一 e cce 是 的 、 巨大 的 hs 表 ,用来存 储 各 种格 式的 数据 , 包括 图像 、视 频 、文 件 ,以 及 数据 库 ah

压力 。

潮

囊

-

髓;

镬 瓣^ 一 蟛

薯 瓣 痢咖 粕阀硼 一 , l 瓣 臻 驹 l u e g r

Me a h d mc c e 缓存 是 一种 分布 式 的 。也 就 是可 以允 许不 同主机 上 的多个 用 户 同时访 问这 个 缓存

这 里 必 须 c n iu e o f r ,它 会 检 g

测 系 统情 况 ,然 后生 成 c n i h of g. 等 几 个 文件 , 其 它 的 c n iu e 和 o f r g

一

系统 ,这 种方 法 不仅 解 决 了共享

内存 只 能是 单机 的 弊端 ,同时 也 解决 了数据 库 检索 的压 力 ,提 高

样 , 可 以 配 置 它 的 安 装 路 径

2 客户蛆 安装 . 根据 Me a h d协 议 ,用户 mc c e

建 议 将 M em c ached 安 装 在 Li UX 2. 以上 内 核 。 因为 1 3 6

M e a h d需 要 用 lb v n 和 mc c e ie e t

Me a h d mc c e 工作 机 制是 通 过 在 内存 中开 辟 一 块 区域 来维 持一 个大的hs ah表 , 加快 页面 访 问 来 速 度 ,它 和数 据 库 是独 立 的 。 目

供下 载和参考 。下面就 以P r客户 el

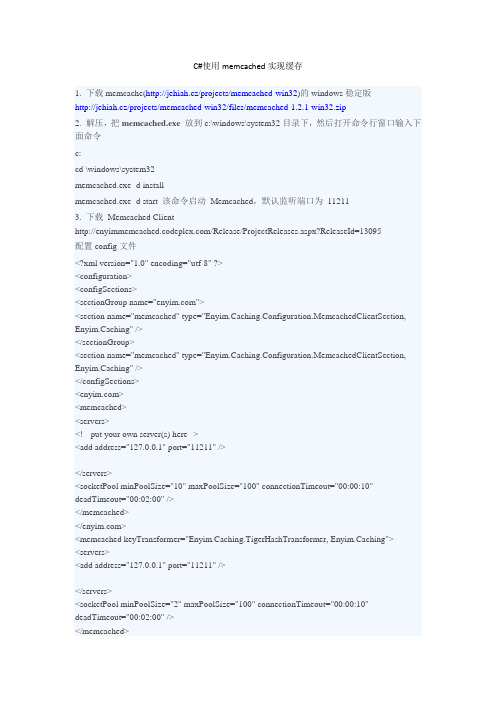

C#使用memCached实现缓存

C#使用memcached实现缓存1. 下载memcache(http://jehiah.cz/projects/memcached-win32)的windows稳定版http://jehiah.cz/projects/memcached-win32/files/memcached-1.2.1-win32.zip2. 解压,把memcached.exe放到c:\windows\system32目录下,然后打开命令行窗口输入下面命令c:cd \windows\system32memcached.exe -d installmemcached.exe -d start 该命令启动Memcached,默认监听端口为112113. 下载Memcached Client/Release/ProjectReleases.aspx?ReleaseId=13095配置config文件<?xml version="1.0" encoding="utf-8" ?><configuration><configSections><sectionGroup name=""><section name="memcached" type="Enyim.Caching.Configuration.MemcachedClientSection, Enyim.Caching" /></sectionGroup><section name="memcached" type="Enyim.Caching.Configuration.MemcachedClientSection, Enyim.Caching" /></configSections><><memcached><servers><!-- put your own server(s) here--><add address="127.0.0.1" port="11211" /></servers><socketPool minPoolSize="10" maxPoolSize="100" connectionTimeout="00:00:10" deadTimeout="00:02:00" /></memcached></><memcached keyTransformer="Enyim.Caching.TigerHashTransformer, Enyim.Caching"><servers><add address="127.0.0.1" port="11211" /></servers><socketPool minPoolSize="2" maxPoolSize="100" connectionTimeout="00:00:10" deadTimeout="00:02:00" /></memcached></configuration>这里的port:11211是, memcached-1.2.1-win32在安装时默认使用的port.当然你可以用memcached.exe -p 端口号来自行设置。

memcached参数

memcached参数Memcached是一种高性能的分布式内存对象缓存系统,常用于提高Web应用程序的性能和扩展性。

Memcached的设计目标是提供一个简单、快速、可扩展的缓存解决方案,而其参数配置则对其性能和稳定性至关重要。

以下是一些常见的Memcached参数及其作用:2. -U,--udp:启用UDP监听功能。

默认情况下,Memcached使用TCP进行通信,但也可以选择启用UDP。

使用UDP可以提高性能,但同时也可能会导致数据丢失。

3. -l,--listen:指定绑定的IP地址。

默认情况下,Memcached会绑定到所有可用的IP地址上,但可以通过此参数来指定要绑定的特定IP地址。

4. -u,--user:指定运行Memcached进程的用户。

可以使用此参数来提高服务器的安全性,限制只有指定用户才能运行Memcached。

5. -m,--memory:指定Memcached使用的内存大小(以MB为单位)。

这个参数非常重要,它决定了可以缓存的对象数量和大小。

应根据预期的负载和可用内存来调整此参数。

6. -c,--connections:指定Memcached服务器能够处理的最大并发连接数。

默认情况下,这个值是1024,但在高并发情况下,可能需要增加这个值来处理更多的连接。

7. -t,--threads:指定Memcached使用的线程数量。

默认情况下,Memcached会根据可用的处理器核心数量来自动配置线程数,但也可以通过此参数来手动设置线程数量。

9. -R,--max-reqs-per-event:指定每个事件处理器循环中处理的最大请求数。

默认情况下,Memcached每次处理一个请求,但这个参数可以用来限制每个事件处理器循环中处理的请求数,以提高其他连接的响应速度。

以上是一些常用的Memcached参数,通过对这些参数的配置,可以根据实际需求来优化Memcached的性能和稳定性。

最值得学习的10个C语言开源项目

最值得学习的10个C语⾔开源项⽬最好别下载最新版,因为代码量⽐较⼤,可以下载很早的版本搜索词:开源 CWebbenchWebbench是⼀个在linux下使⽤的⾮常简单的⽹站压测⼯具。

它使⽤fork()模拟多个客户端同时访问我们设定的URL,测试⽹站在压⼒下⼯作的性能,最多可以模拟3万个并发连接去测试⽹站的负载能⼒。

Webbench使⽤C语⾔编写, 代码实在太简洁,源码加起来不到600⾏。

CMockerycmockery是google发布的⽤于C单元测试的⼀个轻量级的框架。

它很⼩巧,对其他开源包没有依赖,对被测试代码侵⼊性⼩。

cmockery的源代码⾏数不到3K,你阅读⼀下will_return和mock的源代码就⼀⽬了然了。

主要特点:免费且开源,google提供技术⽀持;轻量级的框架,使测试更加快速简单;避免使⽤复杂的编译器特性,对⽼版本的编译器来讲,兼容性好;并不强制要求待测代码必须依赖C99标准,这⼀特性对许多嵌⼊式系统的开发很有⽤Libevlibev是⼀个开源的事件驱动库,基于epoll,kqueue等OS提供的基础设施。

其以⾼效出名,它可以将IO事件,定时器,和信号统⼀起来,统⼀放在事件处理这⼀套框架下处理。

基于Reactor模式,效率较⾼,并且代码精简(4.15版本8000多⾏),是学习事件驱动编程的很好的资源。

MemcachedMemcached 是⼀个⾼性能的分布式内存对象缓存系统,⽤于动态Web应⽤以减轻数据库负载。

它通过在内存中缓存数据和对象来减少读取数据库的次数,从⽽提供动态数据库驱动⽹站的速度。

Memcached 基于⼀个存储键/值对的 hashmap。

Memcached-1.4.7的代码量还是可以接受的,只有10K⾏左右。

LuaLua很棒,Lua是巴西⼈发明的。

Lua的源代码,百分之⼀百的ANSI C,⼀点都不掺杂。

在任何⽀持ANSI C编译器的平台上都可以轻松编译通过。

Python中的Memcached缓存

Python中的Memcached缓存Memcached是一款高性能的分布式内存对象缓存系统。

它的主要功能是将数据存储在内存中,从而提高数据访问速度。

作为一款大型网站所必不可少的缓存工具,Memcached在Python 中的应用极度广泛。

在这篇论文中,我们将深入探讨Memcached在Python中的应用,分析其优点和缺点,并提出一些最佳实践,以帮助开发人员更好地利用Memcached提升应用的性能和用户体验。

一、Memcached的优点1.高速缓存Memcached是一款基于内存的缓存系统,它可以实现非常快速的缓存访问速度。

由于数据存储在内存中,所以它的响应速度相当快,甚至可以达到微秒级别。

在大型网站前端中,常使用Memcached来缓存一些静态或不怎么变化的数据,如网站配置信息、静态页面等。

通过缓存这些数据,可以减少对数据库等后端系统的请求,从而提高网站的性能。

2.可扩展性Memcached是一款分布式缓存系统,它可以将缓存数据分散存储在多台机器的内存中,从而实现更大的存储容量和更高的并发处理能力。

在高并发的情况下,系统可以简单地通过增加或减少服务器数量来扩展缓存能力。

此外,Memcached还具有自动数据平衡和故障转移等功能,可以实现高可用性和灵活性。

3.支持多种语言Memcached支持多种语言,包括Python、Java、PHP等,可以方便地嵌入到各种应用程序中,快速提高应用程序的性能。

在Python中,Memcached是一种常见的缓存解决方案,可以通过安装对应的Python模块,轻松地集成到应用程序中。

二、Memcached的缺点1.容量限制由于Memcached是一款基于内存的缓存系统,所以它的缓存容量是有限的。

在实际应用中,需要根据业务需求和服务器硬件条件等因素综合考虑,设置合适的缓存容量,避免因容量不足而导致缓存失效。

2.数据不持久化Memcached只是一款内存缓存系统,它并不支持数据持久化。

php的Memcache方法介绍及应用实例

使用Memcache在PHP中调试方法的介绍及应用如果我们在网络开发中,特别是大访问量的web项目开发中,为了提高响应速度,减少数据查询运算,那么我们都会选用memcahce。

首先我们必须要安装,接下来如何使用memcache,在这里介绍下在linux下安装和windows下安装如下及配置:一、linux下的Memcache安装:1.下载memcache的linux版本,注意memcached 用libevent 来作事件驱动,所以要先安装有libevent。

2. 安装pecl::memcache。

用pecl 命令行工具安装:pecl install memcache或直接从源码安装:phpize./configuremakemake install二、Windows下的Memcache安装:1. 下载memcache的windows稳定版,解压放某个盘下面,比如在c:\memcached2. 在终端(也即cmd命令界面)下输入‘c:\memcached\memcached.exe -d install’安装3. 再输入:‘c:\memcached\memcached.exe -d start’启动。

NOTE: 以后memcached将作为windows的一个服务每次开机时自动启动。

这样服务器端已经安装完毕了。

4.下载/ext.php/php_memcache.dll,请自己查找对应的php版本的文件5. 在C:\winnt\php.ini 加入一行‘extension=php_memcache.dll’6.重新启动Apache,然后查看一下phpinfo,如果有memcache,那么就说明安装成功!三、memcached的基本设置:-p 监听的端口-l 连接的IP地址, 默认是本机-d start 启动memcached服务-d restart 重起memcached服务-d stop|shutdown 关闭正在运行的memcached服务-d install 安装memcached服务-d uninstall 卸载memcached服务-u 以的身份运行(仅在以root运行的时候有效)-m 最大内存使用,单位MB。

memcache 用法

memcache 用法摘要:1.简介2.Memcache的安装与配置3.Memcache的使用方法4.Memcache的数据类型5.Memcache的应用场景6.Memcache的优缺点7.总结正文:Memcache是一款高性能的分布式内存对象缓存系统,主要用于提高网站访问速度和减轻服务器负载。

它通过将热点数据存储在内存中,以减少对数据库的访问次数,从而提高网站性能。

1.简介Memcache是一个高性能的分布式内存对象缓存系统,主要用于提高网站访问速度和减轻服务器负载。

它通过将热点数据存储在内存中,以减少对数据库的访问次数,从而提高网站性能。

Memcache支持多种数据类型,包括字符串、整数、浮点数等。

2.Memcache的安装与配置要使用Memcache,首先需要在服务器上安装Memcache服务端。

安装完成后,需要对Memcache进行配置,包括设置内存大小、连接数等参数。

配置完成后,启动Memcache服务。

3.Memcache的使用方法Memcache的使用方法主要包括以下几个步骤:(1)连接Memcache服务器:使用PHP的Memcache扩展库,通过`memcache_connect()`函数连接到Memcache服务器。

(2)设置缓存数据:使用`memcache_set()`函数将数据存储到Memcache中。

(3)获取缓存数据:使用`memcache_get()`函数从Memcache中获取数据。

(4)删除缓存数据:使用`memcache_delete()`函数从Memcache中删除数据。

(5)清空缓存:使用`memcache_clear_cache()`函数清空Memcache 中的所有数据。

4.Memcache的数据类型Memcache支持多种数据类型,包括字符串、整数、浮点数等。

此外,Memcache还支持数据结构,如数组、链表等。

5.Memcache的应用场景Memcache主要应用于以下场景:(1)缓存数据库查询结果:将经常访问的数据从数据库中取出,存储到Memcache中,以减少对数据库的访问次数。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Memcached与c++的应用什么是libmemcached ?libmemcached 是一个memcached 的库,客户端库,C 和 C++ 语言实现的客户端库,具有低内存占用率、线程安全、并提供对memcached功能的全面支持。

它还采用多种命令行工具:memcat ,memflush ,memrm ,memstat ,并memslap (负载代)。

程序库一直在设计,让不同的散列方法对密钥,分割的钥匙,并使用统一的散列分配。

需要注意的是,libmemcached 不是libmemcache ,它们是两个不同的客户端库,前者现在的开发比较活跃,后者已经有很长时间没有更新了。

memcached 是一个高性能、分布式的内存对象缓存系统,通过内存的数据缓存来降低对数据库的访问,从而提高动态内容应用网站的速度。

memcached 官方开发释放出来的,只是应用的服务器端程序,它发布了服务器端的连接读写协议,客户端的实现,则根据动态内容应用网站使用的动态脚本的不同,而有多种,具体列表,可查看官方网站。

对于高并发高访问的Web应用程序来说,数据库存取瓶颈一直是个令人头疼的问题。

特别当你的程序架构还是建立在单数据库模式,而一个数据池连接数峰值已经达到500的时候,那你的程序运行离崩溃的边缘也不远了。

很多小网站的开发人员一开始都将注意力放在了产品需求设计上,缺忽视了程序整体性能,可扩展性等方面的考虑,结果眼看着访问量一天天网上爬,可突然发现有一天网站因为访问量过大而崩溃了,到时候哭都来不及。

所以我们一定要未雨绸缪,在数据库还没罢工前,想方设法给它减负,这也是这篇文章的主要议题。

大家都知道,当有一个request过来后,web服务器交给app服务器,app处理并从db中存取相关数据,但db存取的花费是相当高昂的。

特别是每次都取相同的数据,等于是让数据库每次都在做高耗费的无用功,数据库如果会说话,肯定会发牢骚,你都问了这么多遍了,难道还记不住吗?是啊,如果app拿到第一次数据并存到内存里,下次读取时直接从内存里读取,而不用麻烦数据库,这样不就给数据库减负了?而且从内存取数据必然要比从数据库媒介取快很多倍,反而提升了应用程序的性能。

因此,我们可以在web/app层与db层之间加一层cache层,主要目的:1. 减少数据库读取负担;2. 提高数据读取速度。

而且,cache存取的媒介是内存,而一台服务器的内存容量一般都是有限制的,不像硬盘容量可以做到TB级别。

所以,可以考虑采用分布式的cache 层,这样更易于破除内存容量的限制,同时又增加了灵活性。

Memcached 介绍Memcached是开源的分布式cache系统,现在很多的大型web应用程序包括facebook,youtube,wikipedia,yahoo等等都在使用memcached来支持他们每天数亿级的页面访问。

通过把cache层与他们的web架构集成,他们的应用程序在提高了性能的同时,还大大降低了数据库的负载。

具体的memcached资料大家可以直接从它的官方网站[1]上得到。

这里我就简单给大家介绍一下memcached的工作原理:Memcached处理的原子是每一个(key,value)对(以下简称kv对),key会通过一个hash 算法转化成hash-key,便于查找、对比以及做到尽可能的散列。

同时,memcached用的是一个二级散列,通过一张大hash表来维护。

Memcached有两个核心组件组成:服务端(ms)和客户端(mc),在一个memcached的查询中,mc先通过计算key的hash值来确定kv对所处在的ms位置。

当ms确定后,客户端就会发送一个查询请求给对应的ms,让它来查找确切的数据。

因为这之间没有交互以及多播协议,所以memcached交互带给网络的影响是最小化的。

举例说明:考虑以下这个场景,有三个mc分别是X,Y,Z,还有三个ms分别是A,B,C:设置kv对X想设置key=”foo”,value=”seattle”X拿到ms列表,并对key做hash转化,根据hash值确定kv对所存的ms位置B被选中了X连接上B,B收到请求,把(key=”foo”,value=”seattle”)存了起来获取kv对Z想得到key=”foo”的valueZ用相同的hash算法算出hash值,并确定key=”foo”的值存在B上Z连接上B,并从B那边得到value=”seattle”其他任何从X,Y,Z的想得到key=”foo”的值的请求都会发向BMemcached服务器(ms)内存分配默认情况下,ms是用一个内置的叫“块分配器”的组件来分配内存的。

舍弃c++标准的malloc/free的内存分配,而采用块分配器的主要目的是为了避免内存碎片,否则操作系统要花费更多时间来查找这些逻辑上连续的内存块(实际上是断开的)。

用了块分配器,ms 会轮流的对内存进行大块的分配,并不断重用。

当然由于块的大小各不相同,当数据大小和块大小不太相符的情况下,还是有可能导致内存的浪费。

同时,ms对key和data都有相应的限制,key的长度不能超过250字节,data也不能超过块大小的限制--- 1MB。

因为mc所使用的hash算法,并不会考虑到每个ms的内存大小。

理论上mc会分配概率上等量的kv对给每个ms,这样如果每个ms的内存都不太一样,那可能会导致内存使用率的降低。

所以一种替代的解决方案是,根据每个ms的内存大小,找出他们的最大公约数,然后在每个ms上开n个容量=最大公约数的instance,这样就等于拥有了多个容量大小一样的子ms,从而提供整体的内存使用率。

缓存策略当ms的hash表满了之后,新的插入数据会替代老的数据,更新的策略是LRU(最近最少使用),以及每个kv对的有效时限。

Kv对存储有效时限是在mc端由app设置并作为参数传给ms的。

同时ms采用是偷懒替代法,ms不会开额外的进程来实时监测过时的kv对并删除,而是当且仅当,新来一个插入的数据,而此时又没有多余的空间放了,才会进行清除动作。

缓存数据库查询现在memcached最流行的一种使用方式是缓存数据库查询,下面举一个简单例子说明:App需要得到userid=xxx的用户信息,对应的查询语句类似:“SELECT * FROM users WHERE userid = xxx”App先去问cache,有没有“user:userid”(key定义可预先定义约束好)的数据,如果有,返回数据;如果没有,App会从数据库中读取数据,并调用cache的add函数,把数据加入cache中。

当取的数据需要更新,app会调用cache的update函数,来保持数据库与cache的数据同步。

从上面的例子我们也可以发现,一旦数据库的数据发现变化,我们一定要及时更新cache 中的数据,来保证app读到的是同步的正确数据。

当然我们可以通过定时器方式记录下cache 中数据的失效时间,时间一过就会激发事件对cache进行更新,但这之间总会有时间上的延迟,导致app可能从cache读到脏数据,这也被称为狗洞问题。

(以后我会专门描述研究这个问题)数据冗余与故障预防从设计角度上,memcached是没有数据冗余环节的,它本身就是一个大规模的高性能cache 层,加入数据冗余所能带来的只有设计的复杂性和提高系统的开支。

当一个ms上丢失了数据之后,app还是可以从数据库中取得数据。

不过更谨慎的做法是在某些ms不能正常工作时,提供额外的ms来支持cache,这样就不会因为app从cache中取不到数据而一下子给数据库带来过大的负载。

同时为了减少某台ms故障所带来的影响,可以使用“热备份”方案,就是用一台新的ms来取代有问题的ms,当然新的ms还是要用原来ms的IP地址,大不了数据重新装载一遍。

另外一种方式,就是提高你ms的节点数,然后mc会实时侦查每个节点的状态,如果发现某个节点长时间没有响应,就会从mc的可用server列表里删除,并对server节点进行重新hash定位。

当然这样也会造成的问题是,原本key存储在B上,变成存储在C上了。

所以此方案本身也有其弱点,最好能和“热备份”方案结合使用,就可以使故障造成的影响最小化。

Memcached客户端(mc)Memcached客户端有各种语言的版本供大家使用,包括java,c,php,.net等等,具体可参见memcached api page[2]。

大家可以根据自己项目的需要,选择合适的客户端来集成。

缓存式的Web应用程序架构有了缓存的支持,我们可以在传统的app层和db层之间加入cache层,每个app服务器都可以绑定一个mc,每次数据的读取都可以从ms中取得,如果没有,再从db层读取。

而当数据要进行更新时,除了要发送update的sql给db层,同时也要将更新的数据发给mc,让mc去更新ms中的数据。

假设今后我们的数据库可以和ms进行通讯了,那可以将更新的任务统一交给db层,每次数据库更新数据的同时会自动去更新ms中的数据,这样就可以进一步减少app层的逻辑复杂度。

如下图:不过每次我们如果没有从cache读到数据,都不得不麻烦数据库。

为了最小化数据库的负载压力,我们可以部署数据库复写,用slave数据库来完成读取操作,而master数据库永远只负责三件事:1.更新数据;2.同步slave数据库;3.更新cache。

如下图:以上这些缓存式web架构在实际应用中被证明是能有效并能极大地降低数据库的负载同时又能提高web的运行性能。

当然这些架构还可以根据具体的应用环境进行变种,以达到不同硬件条件下性能的最优化。

未来的憧憬Memcached的出现可以说是革命性的,第一次让我们意识到可以用内存作为存储媒介来大规模的缓存数据以提高程序的性能。

不过它毕竟还是比较新的东西,还需要很多有待优化和改进的地方,例如:如何利用memcached实现cache数据库,让数据库跑在内存上。

这方面,tangent software 开发的memcached_engine[3]已经做了不少工作,不过现在的版本还只是处于实验室阶段。

如何能方便有效的进行批量key清理。

因为现在key是散列在不同的server上的,所以对某类key进行大批量清理是很麻烦的。

因为memcached本身是一个大hash表,是不具备key的检索功能的。

所以memcached是压根不知道某一类的key到底存了多少个,都存在哪些server上。

而这类功能在实际应用中却是经常用到。

在c++中使用memcache修改makefile,在LIBS里面加上-lmemcached,比如原来gcc test.c,现在gcc test.c-lmemcached。