Information-Theory-02-2015

信息论第2章 信道模型及信道容量资料

Information Theory

王逸林

哈尔滨工程大学 2013

Tel: 82519503 E-mail: wangyilin@

第2章 信道模型及信道容量

2.1 2.2 1.3 1.4 1.5 1.6 信道的数学模型及分类 信道传输的平均互信息 平均信息量 消息序列的熵 连续信源的信息度量 信源的相关性和剩余度

明线 对称平衡电缆(市内) 固体介质电缆小同轴(长途) 有线信道 中同轴(长途) 波导 混合介质 光缆 长波 中波 1 传输媒介类型 短波 超短波 移动 空气介质 视距接力 微波 对流层 散射 电离层 卫星 光波

b1 bs 输出 [P]

输入 a1 p(b1 / a1 ) p(bs / a1 ) ar p(b1 / ar ) p(bs / ar )

单符号信道的数学模型:

{ X , p( y / x),Y }

单维离散信道的数学模型

输入输出的联合概率为:

2.1.2 离散信道的数学模型

X

X ( X 1 , X 2 ,...X N )

信道

Y

p( y / x )

Y = (Y1 , Y2 ,...YM )

涉及输入和输出两个随机过程,其之间统计依 赖关系由条件概率 p( y / x )来描述.

包含了信道噪声与干扰的影响 反映了信道的统计特性

以太?

信道的分类

工程物理背景——传输媒介类型; 数学描述方式——信号与干扰描述方式; 信道本身的参数类型——恒参与变参; 用户类型——单用户与多用户; 输入、输出随机变量的个数 ——单符号信道与多符号信道。

Information Theory

Information is uncertainty. Information Theory tells us how to measure information, and the possibility of transmitting the information, which may be counted in bits if wanted. Quantum information offers a new intriguing possibility of information processing and computation.

Historical Notes

Claude E. Shannon (1916-2001) himself in 1948, has established almost everything we will talk about today. He was dealing with communication aspects. He first used the term “bit.”

Qubit vs. bit Measure and collapse, noncloneable property Parallel vs. sequential access

Aspects of Qபைடு நூலகம்antum Information: transmitting

Conclusion

The Channel Coding Theorem

The Channel is characterized by its input X and output Y, with its capacity C=I(X;Y). If the coding rate <C, we can transmit without error; if coding rate>C, then error is bounded to occur. limit the ability of a channel to convey information

信息论chapt1,2

信宿 (含译码、解密)

Chapter 1 Introduction

3)研究信息传输的保密性与认证性

信源 (含编码) 信道 (含信道编、译码)

信息是否只为授权者接收、 接收者能否正确判断所接受 消息→与干扰无关。

信宿 (含信源译码)

1.3.3 本课程主要讨论内容

本课程主要介绍信息论的基础内容,可概括为: 香农信息论梗概 (1)信息的度量:这是信息论建立的基础,给出了各种信息量和各种熵 的概念。 (2)无失真信源编码:最主要的结论是Shannon 第一定理以及各种信源 编码的方法。 (3)信道编码:给出了信息传输速率、信道容量等概念,最主要的结论 是Shannon 第二定理,以及基于该定理的各种信道编码,如分组码、卷 积码等

1.3 信息论研究的主要对象、目的与内容 1.3.1 主要研究对象——通信系统(communication systems)

通信系统的模型(modeling)如下图:

Chapter 1 Introduction

Noise Source Encoder Channel

Decoder

Sink

图1.1 通信系统模型

• 经济学中财富的增长率与股票市场 的熵率有对偶关系。 • 计算受制通信速度,而通信又受制 与计算速度。二者互相影响。以信 息论为基础通信理论会对计算理论 有影响。

教材

傅祖芸,信息论基础理论与应用;

Robert gallager ‘information theory and reliable communication’ 大家以后学会习惯外文教材和文献

信息论基础 Information theory

用数学方法研究信息的传输(存储)及转换处理的理论 又名: mathematic theory of Communication (关于通信的数学理论)

专业英语

• Information theory is based on probability theory and statistics. The most important quantities of information are entropy, the information in a random variable, and mutual information, the amount of information in common between two random variables

Information Theory

• Information theory is a branch of applied mathematics and engineering involving the quantification of information to find fundamental limits on compressing and reliably communicating data.

通过采用数据的统计描述,信息论确定了描述 通过采用数据的统计描述, 数据所需要的比特数即信源的信息熵。 数据所需要的比特数即信源的信息熵。

− Lossless data compression — the data must be reconstructed exactly; − Lossy data compression: allocates bits needed to reconstruct the data, within a specified fidelity level measured by a distortion function. This subset of Information theory is called rateratedistortion theory.

信息论基础第二章PPT

8

则用转移概率矩阵表示为 0.25 0.75 p 0.6 0.4

也可用状态转移图表示为

0.75

0.25

0

1

0.4

0.6

9

其n长序列的联合分布为:

Pr { X n x n } Pr {( X 1 X 2 X n ( x1 x2 xn )} ( x1 )i 1 Pr ( X i 1 xi 1 | X i xi )

Pr {( X1 , X 2 , X n ) ( x1 , x2 xn )}

( x1, x2 xn ) n , n 1, 2

p( x1 , x2 xn )

唯一决定

4

无记忆信源

当 X1, X 2 X n 为相互独立的随机变量, 且服从相同的分布:

Pr ( X i x) p( x)

P(0 | 00) 0.8, P (1|11) 0.8, P (1| 00) P (0 |11) 0.2 P(0 | 01) P(0 |10) P (1| 01) P (1|10) 0.5

用转移概率矩阵表示为

11

0 0.8 0.2 0 0 0 0.5 0.5 P 0.5 0.5 0 0 0 0.2 0.8 0

1 k

1 k

Pr {( X t1 , X t2 , , X tm ) ( x1 , x2 ,, xm )} Pr {( X t1 k , X t2 k , , X tm k ) ( x1 , x2 xm )}

14

如果一个马氏过程是平稳的,则

Pr {X m xm | X m1 xm1 , X m2 xm2 ,, X1 x1} Pr {X m xm | X m1 xm1} Pr {X 2 xm | X1 xm1}

第一章信息检索理论基础课件

第一章 信息检索理论基础

主要知识点

(一)信息检索原理 (二)信息检索技术 (三)信息检索系统 (四)信息检索语言 (五)信息检索方法 (六)信息检索评价 (七)信息检索与数字图书馆

信息检索技术—信息检索常用技术

(1)布尔检索技术:它是利用布尔逻辑算符进行检索词 或代码的逻辑组配,是现代信息检索中最常使用的一种方法 。

信息存储(标引)过程

检

原始

信息特

索

信息特

检

文献

征提取

标

征标识

检索系统

索

信息

检索提

识

检索提

结

需求

问表达

系

问标识

标识匹配

果

统

信息检索过程

信息检索原理—信息检索及其发展

(1)信息检索(Information Retrieval)是“一种时间性的 通讯形式”,“在时间上从一个时刻通往一个较晚的时刻, 而在空间上可能还在同一地点” 。这一看法,揭示了信息 存储与获取两个环节是一种延时性的通讯形式。

(3)向量空间检索模型:向量检索是以向量的方式确定检 索内容的方法,系统中的每一篇文献和每个提问均用等长的向 量表示。如:文献集合中的第i篇文献用Di = ( T1, T2, T3, …, Tm ) 表示,其中T1, T2, T3, …, Tm为系统中所有标引词集合;提问集 合中的第j个提问用Qj = ( T1, T2, T3, …, Tm )表示;Tk表示文献向 量或提问向量中的第k个分量,即文献表示或提问式中所含的第 k个标引词或检索词。

按照狭义的理解,信息 是 信用 息来是消物除质不存定在性的的一东 西 种。 方按式照、广形义态的或理运解动, 又 状有 态两,种也认是识事:物从的本一体 意 种义 普上遍说属,性信,息一泛般指指一 切 数事 据物、运消动息的中状所态包和含运 动 的的 意方义式,。可从以认使识消论息的 意 中所义描上说述,事件信的息不是定关于 事 性物 减运少动。状态和运动方 式的反映。

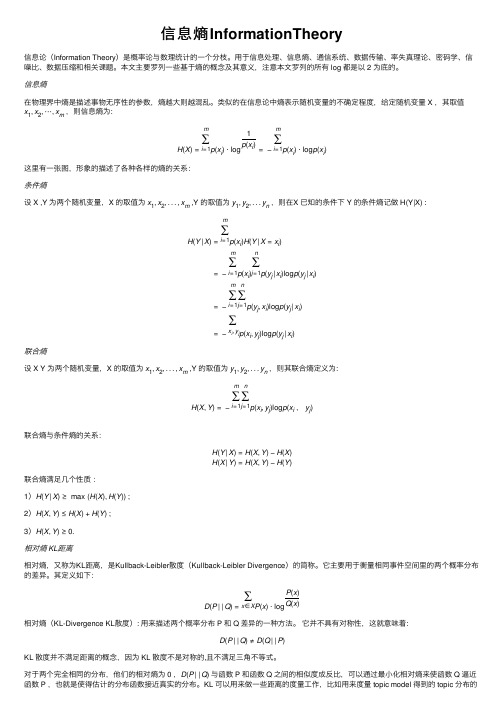

信息熵InformationTheory

信息熵InformationTheory信息论(Information Theory)是概率论与数理统计的⼀个分枝。

⽤于信息处理、信息熵、通信系统、数据传输、率失真理论、密码学、信噪⽐、数据压缩和相关课题。

本⽂主要罗列⼀些基于熵的概念及其意义,注意本⽂罗列的所有 log 都是以 2 为底的。

信息熵在物理界中熵是描述事物⽆序性的参数,熵越⼤则越混乱。

类似的在信息论中熵表⽰随机变量的不确定程度,给定随机变量 X ,其取值x1,x2,⋯,x m,则信息熵为:H(X)=m∑i=1p(x i)⋅log1p(x i)=−m∑i=1p(x i)⋅log p(x i)这⾥有⼀张图,形象的描述了各种各样的熵的关系:条件熵设 X ,Y 为两个随机变量,X 的取值为x1,x2,...,x m ,Y 的取值为y1,y2,...y n,则在X 已知的条件下 Y 的条件熵记做 H(Y|X) :H(Y|X)=m∑i=1p(x i)H(Y|X=x i)=−m∑i=1p(x i)n∑j=1p(y j|x i)log p(y j|x i)=−m∑i=1n∑j=1p(y j,x i)log p(y j|x i)=−∑x i,y j p(xi,y j)log p(y j|x i)联合熵设 X Y 为两个随机变量,X 的取值为x1,x2,...,x m ,Y 的取值为y1,y2,...y n,则其联合熵定义为:H(X,Y)=−m∑i=1n∑j=1p(x i,y j)log p(x i,y j)联合熵与条件熵的关系:H(Y|X)=H(X,Y)−H(X)H(X|Y)=H(X,Y)−H(Y)联合熵满⾜⼏个性质:1)H(Y|X)≥max(H(X),H(Y)) ;2)H(X,Y)≤H(X)+H(Y) ;3)H(X,Y)≥0.相对熵 KL距离相对熵,⼜称为KL距离,是Kullback-Leibler散度(Kullback-Leibler Divergence)的简称。

许波版《心理学史》 认知心理学

(一)早期实验心理学的影响

早期实验心理学把主体的直接经验作为心理学的研究对象,提倡实验 加内省的方法。认知心理学在批判和改造的基础上,继承了冯特的内 省法,提出了“口语报告分析法”或“出声思考法”,即要求被试通 过原始性的口头陈述来报告思考时的内部信息加工,特别是短时记忆 的内容。

2.米勒(George A. Miller,1920-)

20世纪美国心理学家,是以信息处理为基础的认知心理学 的先驱,也是因研究短期记忆提出“神秘七加减二”理论 而闻名的心理学家。

米勒(George A. Miller,1920-)

3.奈瑟(Ulric Neisser,1928- )

20世纪德国出生的美国心理学家,是以信息处理论为基础的 现代认知心理学的先驱,也是因开创性著作而被誉为“认知 心理学之父”的心理学家。

(三)行为主义心理学的影响

认知心理学在研究方法上继承和发展了行为主义研究的客观

化原则,在新行为主义的刺激-中间变量-反应的研究模式的 基础上提出了输入-内部信息加工-输出这样一个与计算机的 操作相似的研究模式,从而尽可能地使心理过程的探讨保持 操作性,以期体现出客观性。

(四)皮亚杰学派的影响

皮亚杰的发生认识论和认知心理学都不赞成行为主义,但又都表现出对

作为一种新的心理学思潮,现代认知心理学有时与其他 流行的心理学思潮是对立的:与行为主义的对立,反对它 只研究可观察的外部行为,强调研究人的内部认知结构; 与精神分析的对立,反对它过分关注潜意识,强调意识的 主导地位;与人本主义心理学的对立,反对它只关注个人 成长和人际关系,强调应以认知过程为研究对象。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

例4:计算自信息

设在一正方形棋盘上共有64个方格,如果甲将一粒 棋子随意的放在棋盘中的某方格且让乙猜测棋子所 在位置。 (1) 将方格按顺序编号,令乙猜测棋子所在的顺 序号。问猜测的难易程度。 (2)将方格按行和列编号,甲将棋子所在方格的列 编号告诉乙之后,再令乙猜测棋子所在行的位置。 问猜测的难易程度。

熵函数的性质

离散随机变量X的概率空间为

x2 xn X x1 P( X ) p( x ) p( x ) p( x ) 1 2 n

伴随一个事件发生带来信息,其信息的“量”应该有下面的 性质(公理性条件): (1) 如果p(x1) < p(x2),则I(x1) > I(x2), I(xi )是 p(xi) 的单 调递减函数; (2) 如果p(xi)=0,则I(xi ) → ∞ ; 如果p(xi)=1,则I(xi ) =0 ; (3)由两个相对独立的事件所提供的信息量,应等于它们 分别提供的信息量之和: I(xi yj)=I(xi )+I(yj)

一信源有6种输出符号,概率分别为

P(A)=0.5, P(B)=0.25,P(C)=0.125,P(D)=P(E)=0.05,P(F)=0.025

1) 计算H(X)。 2) 求符号序列ABABBA和FDDFDF的信息量,并将之与6位 符号的信息量期望值相比较。 解:

1)由信息熵定义,该信源输出的信息熵为

信息量定义

随机事件 xi 的自信息定义为该事件发生概率的对数的负值:

I ( xi )

log p( xi )

关于对数底的选取 以2为底,单位为比特(bit) 以e为底,单位为奈特(nat) 以10为底,单位为哈特莱 (Hartley)

一般都采用以2为底的对数,为了书写简洁,有时把底数2略 去不写。

n

... ...

i

p ( xq ) xq

p( x ) 1

i 1

离散平稳无记忆信源的N次扩展信源

假定信源输出的是N长符号序列,把它看成是一个 新信源,称为离散平稳无记忆信源的N次扩展信源 ,用N维离散随机矢量来表示

X X1 X 2

XN X N

N次扩展信源的概率空间为

2 i qN X N 1 p ( ) p( ) p( ) p( ) 1 2 i qN P( X )

i 是一个长为N的序列, i xi xi 1 2

xiN

例1: 计算自信息

设在甲袋中放入n个不同阻值的电阻,随意取出 一个,求当被告知“取出的电阻阻值为 i ”时所 获得的信息量。

i 1

信息熵的意义

信源的信息熵是从整个信源的统计特性来考虑的。它是从平均意义 上来表征信源的总体特性的。对于某特定的信源,其信息熵只有一 个。不同的信源因统计特性不同,其信息熵也不同。

例5 计算平Байду номын сангаас自信息-信息熵

例如掷一个六面均匀的骰子,每次出现朝上一面的点数是随 机的,以朝上一面的点数作为随机试验的结果,并把试验结 果看作一个信源的输出,试建立数学模型。 解:信源的输出:离散随机变量X X:{1,2,3,4,5,6} X: [X • P]= 1

不确定性vs.信息量

自信息可以从两个方面来理解:

自信息是事件发生前,事件发生的不确定性 自信息表示事件发生后,事件所包含的信息量

单位之间的换算关系:

1奈特= log2 e 比特=1.443比特

1哈特莱= log210 比特=3.322比特 1 r进制单位 = log2r 比特

log c b log a b log c a

信源的主要问题

信源分类

根据信源输出消息在时间和取值上是离散或连续分类

信源的分类及其数学模型

根据信源发出的消息序列中的消息,统计特性是否保持不变

信源可分为平稳信源/非平稳信源

根据信源发出的单个消息取值是离散值还是连续值, 信源可分为离散信源/连续信源 根据信源发出的消息之间是否有统计依赖关系, 信源可分为有记忆信源/无记忆信源 本书重点研究 离散平稳无记忆信源,以及较简单的有记忆信源-马尔 可夫信源

——样本空间

P(X):{P(X=1)=1/6,P(X=2)=1/6,…, P(X=6)= 1/6} 2 3 4 5 6

——概率空间

P(X): 1/6 1/6 1/6 1/6 1/6

1/6

0 p( xi ) 1i 1,2 ,6

p( x ) 1

i 1 i

6

例6 计算平均自信息-信息熵

p( x1 ) 1 1 n(n 1) 2 ... p( xn ) n 1 n(n 1) 2

1 1 I ( x1 ) log n(n 1) ... I ( xn ) log (n 1) 2 2

例3:计算自信息

设在A袋放入n个不同阻值的电阻,随意取出一个, 求当被告知“取出的电阻阻值为i”时所获得的信 息量。 在B袋中放入m种不同功率的电阻,任意取出一个 ,求被告知“取出的电阻功率为 j ”时获得的信 息量。 在C袋中放入n种不同阻值,而每种阻值又有m种 不同功率的电阻,即共有nm个电阻,随意选取一 个,被告知“取出的电阻阻值为i,功率为j”时获 得的信息量。

第1周-第16周,每周二,13:20-15:50 ,下沙校区A-201教室 信息论假说 :物质、能量与信息是组成世界的三大要素。人们已经 很深入地了解了物质与能量,而对信息的认识还相对较少。 信息论是运用概率论与数理统计的方法对信息定量化,将信息的传 递作为一种统计现象来考虑,给出了估算通信信道容量的方法。信 息传输、信息压缩以及信息保密是信息论研究中的重要领域。 研究信息论基本内容及相关应用,即信息熵、信道容量以及信源和 信道编码和保密通信等问题,为进一步学习相关课程打下基础。 出勤(15%)+平时的作业(35%)+期末考试(50%) /s/1kT1X4Jd ftp://kfchen:public@

例 3:

解:对应A,B,C三袋,随意取出一个电阻事件的概 率分别为:

1 p( xi ) n

1 p( y j ) m 1 p( xi y j ) nm

因此

I(xi)=– logp(xi )=log n 比特 I(yj)= – logp(yj )=log m 比特 I(xi yj)= – logp(xi yj ) =log (n m) = I(xi) + I(yj)比特

解: 由于是随意取出一个电阻,所以取出任意阻值 的电阻的概率相等:

1 p( xi ) n

i 1,2, ,n

比特

I ( xi ) log p( xi ) log 2 n

例2: 计算自信息

1 在乙袋中放入 nn 1 个电阻,其中阻值为1 2

的1个,2 的2个,…,n 的 n个,随意取出一 个,求被告知“取出的电阻阻值为1 ”和“取出 的电阻阻值为n ”时分别获得的信息量。 解:

例 4:

解: p(xi yj )=1/64 i=1,2,…,8; j= 1,2,…,8

(1) I(xi yj)= – logp(xi yj )= 6 比特

(2) I(xi | yj)= – logp(xi | yj ) = – log[p(xi yj )/ p(yj )]=3 比特 I(xi ) = – logp(xi)= 3 比特 I(yj) = 3 比特

log 2 b log10 b log 2 10

互信息定义

如果事件a与事件b相互有联系,知道一个结果会对预测另一 个结果有帮助 例: 某猜奖游戏, 3扇门后面分别是: iPhone6s, 200元充值卡, 100元充值卡

打开一扇门后发现是充值卡,允许你改变当初的选择 你是否会改变?

互信息定义为: I (a; b) I (a) I (a | b)

信息论基础 Elements of Information Theory

陈克非 杭州师范大学理学院 kfchen@

/s/1kT1X4Jd ftp://kfchen:public@

课程安排&课程要求

上课时间地点

离散单符号信源

离散单符号信源:输出离散取值的单个符号的信源

离散单符号信源是最简单、最基本的信源,是组成实际 信源的基本单元,可以用一个离散随机变量来表示

离散单符号信源X的概率空间

X x1 P( X ) p( x ) 1

p ( xi ) 0

x2 p ( x2 )

符号序列FDDFDF所含的信息量为 I 2 3I D 3I F 3 log PD log PF 3 log 20 log 40 28.932 bit

6位符号序列的信息量平均值为 I 6 H ( X ) 11.64 bit

I1 I I 2

互信息有两方面的含义

log p(a) log p(a | b) p ( a | b) log p(a)

表示事件b出现前后关于事件a的不确定性减少的量 事件b出现以后信宿获得的关于事件a的信息量

信源的分类及其数学模型

信源是产生

消息(符号)、 消息序列(符号序列) 时间连续的消息的来源 如何描述信源的输出(信源的建模问题)√ 怎样确定信源产生的信息量、产生信息的速率 √ 信源编码

什么是信息论

本课程的目标

考核要求

电子课件

教材及参考书

傅祖芸,赵建中,信息论与编码 (第二版),电子工业出版社, 2014 李梅, 李亦能, 信息论基础教程 (第4版), 北京邮电大学出版社, 2008 于秀兰,王永,陈前斌,信息论 与编码,人民邮电出版社2014 T. M. Cover and J. A. Thomas, Elements of Information Theory, (信息论基础, 机械工业出版社, 2012) R. Bose, Information Theory, Coding and Cryptography, (信 息论、编码与密码学, 机械工业 出版社, 2005)