JAVA 中文分词

ik分词器原理

ik分词器原理

ik分词器是一种基于Java语言开发的开源中文分词工具。

它

采用了先进的NLP技术和基于规则的分词算法,能够将一段

连续的中文文本切分成有意义的词语。

ik分词器的原理主要包括以下几个步骤:

1. 文本预处理:首先,ik分词器会对输入的文本进行预处理,包括去除空格、标点符号和特殊字符等。

2. 正向匹配:ik分词器会从文本的开头开始逐个字符进行遍历,将所有可能的词语按照最大匹配原则进行切分。

例如,对于文本“我爱自然语言处理”,先从开头的“我”开始匹配,如果“我”

是一个有效的词语,则继续匹配下一个字符。

如果不是词语,则向下一个字符进行匹配,直到找到一个合适的词语或者遍历结束。

3. 逆向匹配:正向匹配得到的结果可能存在一些不准确的情况,因此ik分词器还会进行逆向匹配,以获得更准确的切分结果。

逆向匹配是从文本的末尾开始,逐个字符进行遍历,将所有可能的词语按照最大匹配原则进行切分。

4. 歧义消除:在正向匹配和逆向匹配之后,ik分词器会对切分结果进行歧义消除。

当一个词语可以被多种方式切分时,ik分词器会根据一些规则和词典进行判断,选择最合理的切分结果。

5. 结果输出:最后,ik分词器会将切分得到的词语以字符的形

式输出,供后续的文本处理和分析使用。

综上所述,ik分词器通过正向匹配、逆向匹配和歧义消除等步骤,能够准确地将中文文本切分成有意义的词语。

它具有较高的分词准确率和较好的分词效果,在中文信息处理和文本挖掘等领域得到广泛应用。

Java的自然语言处理实现智能文本分析的关键技术

Java的自然语言处理实现智能文本分析的关键技术Java的自然语言处理(Natural Language Processing, NLP)是一种实现智能文本分析的关键技术。

随着人工智能的快速发展,NLP在各个领域中得到了广泛的应用,包括机器翻译、文本分类、情感分析等等。

本文将介绍Java中实现NLP的关键技术和方法。

一、分词技术分词是NLP中的基础任务之一,它将一段连续的文本切分成单个词语。

在Java中,我们可以使用开源库如NLPIR、HanLP等来实现中文分词。

这些库提供了各种分词算法,如正向最大匹配、逆向最大匹配、双向最大匹配等,可以根据需求选择相应的算法进行分词。

二、词性标注技术词性标注是将分词后的词语进行词类的标记,如名词、动词、形容词等。

通过词性标注可以更准确地理解句子的含义。

Java中可以使用Stanford NLP或OpenNLP等库实现词性标注任务。

这些库提供了训练好的模型,可以直接在Java中调用。

三、命名实体识别技术命名实体识别是NLP中的一个重要任务,它用于识别文本中的实体名称,如人名、地名、组织机构名等。

Java中可以使用Stanford NER等库来实现命名实体识别。

这些库提供了训练好的模型,可以直接用于识别不同类型的实体。

四、句法分析技术句法分析是对句子的结构进行分析,确定句子中各个词语之间的语法关系。

Java中可以使用Stanford Parser等库来实现句法分析。

这些库提供了多种算法,可以根据需求选择相应的算法进行分析。

五、情感分析技术情感分析是NLP中的一个应用任务,用于分析文本中表达的情感倾向,如积极、消极、中性等。

Java中可以使用Stanford CoreNLP等库来实现情感分析。

这些库提供了训练好的模型,可以直接用于情感分析任务。

六、机器学习与深度学习技术除了传统的统计方法,机器学习与深度学习技术在NLP中也得到了广泛应用。

Java中可以使用机器学习框架如Weka、TensorFlow等来实现文本分类、文本生成等任务。

java hanlp 用法

java hanlp 用法HanLP是一款中文自然语言处理工具包,提供了一系列常用的中文自然语言处理功能,包括分词、词性标注、命名实体识别等。

下面是一个简单的示例,展示如何使用HanLP进行中文分词:1. 首先,你需要将HanLP的jar包添加到你的Java项目中。

你可以在HanLP的官方网站上下载最新的jar包,或者使用Maven等依赖管理工具进行添加。

2. 接下来,你可以使用以下代码进行中文分词:```javaimport ;import ;import ;import ;public class HanLPSegDemo {public static void main(String[] args) {// 初始化分词器Segment segment = ();// 对句子进行分词String sentence = "我爱自然语言处理";List<Term> termList = (sentence);// 输出分词结果for (Term term : termList) {( + "/" + );}}}```在上面的代码中,我们首先创建了一个`Segment`对象,该对象是HanLP 中用于中文分词的核心类。

然后,我们调用`seg()`方法对输入的句子进行分词,得到一个`Term`对象的列表。

每个`Term`对象表示一个分词结果,包括分词的词和词性等信息。

最后,我们遍历`Term`对象的列表,输出每个分词的结果。

3. 运行上面的代码,你将会看到以下的输出:```bash我/r爱/v自然/a语言/n处理/v```这表示对输入的句子“我爱自然语言处理”进行了分词,并输出了每个分词的词和词性等信息。

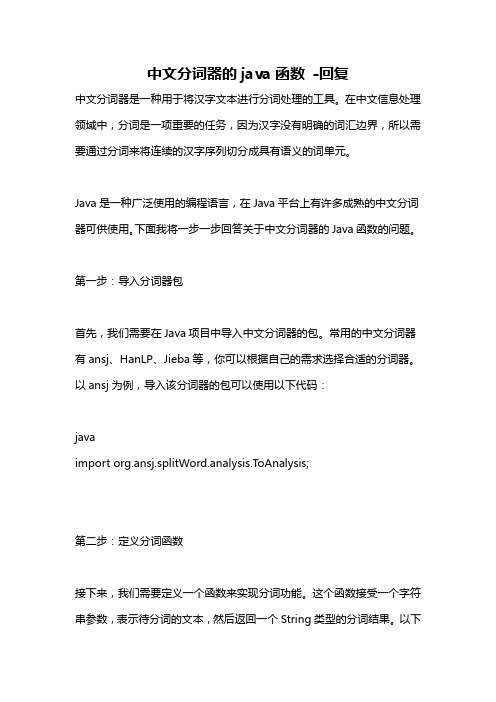

中文分词器的java函数 -回复

中文分词器的java函数-回复中文分词器是一种用于将汉字文本进行分词处理的工具。

在中文信息处理领域中,分词是一项重要的任务,因为汉字没有明确的词汇边界,所以需要通过分词来将连续的汉字序列切分成具有语义的词单元。

Java是一种广泛使用的编程语言,在Java平台上有许多成熟的中文分词器可供使用。

下面我将一步一步回答关于中文分词器的Java函数的问题。

第一步:导入分词器包首先,我们需要在Java项目中导入中文分词器的包。

常用的中文分词器有ansj、HanLP、Jieba等,你可以根据自己的需求选择合适的分词器。

以ansj为例,导入该分词器的包可以使用以下代码:javaimport org.ansj.splitWord.analysis.ToAnalysis;第二步:定义分词函数接下来,我们需要定义一个函数来实现分词功能。

这个函数接受一个字符串参数,表示待分词的文本,然后返回一个String类型的分词结果。

以下是一个简单的示例函数:javapublic String segmentText(String text) {StringBuilder result = new StringBuilder();List<Term> terms = ToAnalysis.parse(text).getTerms();for (Term term : terms) {result.append(term.getName()).append(" ");}return result.toString();}在这个函数中,我们使用ansj分词器的`ToAnalysis.parse()`方法对输入的文本进行分词,并通过遍历分词结果的方式将每个词语连接为一个字符串。

分词结果使用空格进行分隔。

第三步:调用分词函数在主程序中,我们可以通过调用上述定义的分词函数来进行分词操作。

以下是一个示例的主程序:javapublic static void main(String[] args) {String text = "我爱自然语言处理";String segmentedText = segmentText(text);System.out.println(segmentedText);}在这个示例中,我们将字符串"我爱自然语言处理"作为输入文本,然后调用`segmentText()`函数进行分词操作,并使用`System.out.println()`方法打印出分词结果。

分词算法java

分词算法java分词算法是自然语言处理中常用的一种技术,它将一段文本按照一定的规则进行切分,将文本切分为一个个独立的词语。

在Java语言中,有许多成熟的分词算法库可以使用,例如HanLP、IKAnalyzer 等。

本文将介绍分词算法的原理和在Java中的实现。

一、分词算法的原理分词算法的目标是将一段文本切分成一个个独立的词语,这需要解决两个问题:词语的界定和词语的切分。

词语的界定是指如何确定一个词语的开始和结束位置,而词语的切分是指如何将文本按照词语的界定进行切分。

在分词算法中,通常采用两种方法来确定词语的界定:基于字典和基于统计。

基于字典的方法是将文本与一个词典进行匹配,词典中包含了各种词语的信息,包括词语的开始和结束位置。

基于统计的方法则是根据词语在语料库中的出现频率来确定词语的界定。

词语的切分是指将文本按照词语的界定进行切分。

在切分过程中,通常采用正向最大匹配和逆向最大匹配两种方法。

正向最大匹配是从左到右依次匹配文本中的词语,将匹配到的词语作为一个切分结果;逆向最大匹配则是从右到左依次匹配文本中的词语,将匹配到的词语作为一个切分结果。

最后,通过比较正向最大匹配和逆向最大匹配的结果,选择其中一个结果作为最终的分词结果。

二、Java中的分词算法实现在Java语言中,有许多开源的分词算法库可以使用。

以下将介绍两种常用的分词算法库:HanLP和IKAnalyzer。

1. HanLPHanLP是一款自然语言处理工具包,其中包含了多种分词算法。

HanLP支持中文分词、词性标注、命名实体识别等多种功能。

使用HanLP进行分词只需简单几行代码即可实现。

需要下载HanLP的jar包,并将其导入到Java项目中。

然后,可以使用以下代码进行分词:```import com.hankcs.hanlp.HanLP;import mon.Term;public class Segmentation {public static void main(String[] args) {String text = "这是一段测试文本";List<Term> termList = HanLP.segment(text);for (Term term : termList) {System.out.println(term.word);}}}```上述代码中,首先创建了一个文本字符串,然后使用HanLP.segment()方法对文本进行分词,返回一个包含分词结果的列表。

java使用paoding示例代码

java使用paoding示例代码Paoding是一个中文分词库,它可以将连续的中文文本切分成一个个独立的词汇。

在Java中使用Paoding分词,需要先引入Paoding的jar包,然后在代码中使用Paoding的API进行分词。

以下是一个使用Paoding进行中文分词的Java示例代码:javaimport net.paoding.analysis.analyzer.PaodingAnalyzer;import org.apache.lucene.analysis.Analyzer;import org.apache.lucene.analysis.Token;import org.apache.lucene.analysis.TokenStream;import org.apache.lucene.analysis.tokenattributes.CharTermAttribute;public class PaodingDemo {public static void main(String[] args) throws Exception {// 创建Paoding分词器Analyzer analyzer = new PaodingAnalyzer();// 待分词的文本String text = "我爱北京天安门";// 获取分词结果TokenStream tokenStream = analyzer.tokenStream("content", text);CharTermAttribute charTermAttribute = tokenStream.addAttribute(CharTermAttribute.class);// 遍历分词结果tokenStream.reset();while (tokenStream.incrementToken()) {String term = charTermAttribute.toString();System.out.println(term);}// 关闭分词器tokenStream.end();tokenStream.close();analyzer.close();}}上述代码使用Paoding分词器对一个中文字符串进行分词,并将分词结果输出到控制台。

java生成汉语词汇

java生成汉语词汇全文共四篇示例,供读者参考第一篇示例:我们需要明确生成汉语词汇的规则。

汉语词汇通常由汉字组成,而一个汉字通常由一个或多个字母组成。

所以我们可以通过随机选择字母来生成随机的汉语词汇。

除了选择字母,我们还可以考虑加上汉字的声调和音节结构,使得生成的词汇更加真实。

我们需要考虑如何在Java中实现汉语词汇的生成。

Java提供了丰富的字符串处理类和方法,可以方便地操作和处理字符串。

我们可以通过Java的随机数生成器来生成随机的汉字,然后将这些汉字组合成汉语词汇。

我们还可以通过Java的正则表达式来验证和规范生成的汉语词汇。

下面是一个简单的Java代码示例,用于生成随机的汉语词汇:```javaimport java.util.Random;public class ChineseWordGenerator {// 汉字的Unicode编码范围private static final int START = 0x4e00;private static final int END = 0x9fa5;Random random = new Random();for (int i = 0; i < length; i++) {int code = random.nextInt(END - START + 1) + START;sb.append((char) code);}return sb.toString();}第二篇示例:在计算机编程领域中,生成汉语词汇是一项非常具有挑战性和实用性的任务。

在很多实际应用中,我们需要大量的汉语词汇来进行文本处理、自然语言处理等操作。

而手动编写这些词汇是非常耗时且容易出错的。

利用计算机程序来生成大量的汉语词汇是一个非常有意义的任务。

在计算机编程语言中,Java是一种非常常用的语言,具有广泛的应用领域和丰富的库函数。

下面我们将介绍如何利用Java生成汉语词汇。

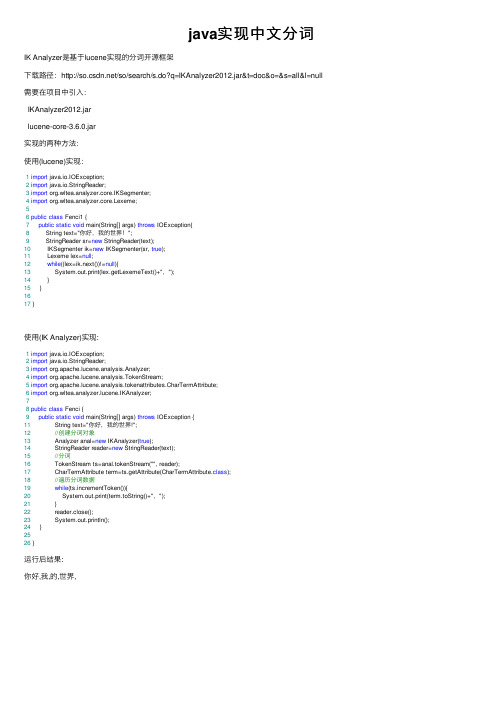

java实现中文分词

java实现中⽂分词IK Analyzer是基于lucene实现的分词开源框架下载路径:/so/search/s.do?q=IKAnalyzer2012.jar&t=doc&o=&s=all&l=null 需要在项⽬中引⼊:IKAnalyzer2012.jarlucene-core-3.6.0.jar实现的两种⽅法:使⽤(lucene)实现:1import java.io.IOException;2import java.io.StringReader;3import org.wltea.analyzer.core.IKSegmenter;4import org.wltea.analyzer.core.Lexeme;56public class Fenci1 {7public static void main(String[] args) throws IOException{8 String text="你好,我的世界!";9 StringReader sr=new StringReader(text);10 IKSegmenter ik=new IKSegmenter(sr, true);11 Lexeme lex=null;12while((lex=ik.next())!=null){13 System.out.print(lex.getLexemeText()+",");14 }15 }1617 }使⽤(IK Analyzer)实现:1import java.io.IOException;2import java.io.StringReader;3import org.apache.lucene.analysis.Analyzer;4import org.apache.lucene.analysis.TokenStream;5import org.apache.lucene.analysis.tokenattributes.CharTermAttribute;6import org.wltea.analyzer.lucene.IKAnalyzer;78public class Fenci {9public static void main(String[] args) throws IOException {11 String text="你好,我的世界!";12//创建分词对象13 Analyzer anal=new IKAnalyzer(true);14 StringReader reader=new StringReader(text);15//分词16 TokenStream ts=anal.tokenStream("", reader);17 CharTermAttribute term=ts.getAttribute(CharTermAttribute.class);18//遍历分词数据19while(ts.incrementToken()){20 System.out.print(term.toString()+",");21 }22 reader.close();23 System.out.println();24 }2526 }运⾏后结果:你好,我,的,世界,。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

//输出TreeMap的values,即分拆好的句子

System.out.println(tm.values()); }

}

中文词库文件 chinese_word.txt 昨天,星期一,我,今天,你,在,上午,个,餐厅,一顿,一,下午,部,去,晚上,他,苹果手机, 她,中午,的,买,吃饭,了,电脑,买了,在,吃,两,饭,手机,顿,吃了 (逗号为英语状态) 理论上,中文词库越详细,词条越多,分词越准确。就像表达吃饭这个意思,其 实可以包含 吃饭, 吃, 饭, 吃了, 了, 一顿, 一, 顿, 等词语。

package collection_package;

import java.util.*;

public class TestAnalysis { public static void main(String[] ary) { StringAnalysis sa = new StringAnalysis(); InsertString is = new InsertString(); is.gettext(); // System.out.println(is.s); sa.get(); String sretain; sretain = sa.sen;

import java.io.*; import java.util.*;

public class InsertString {

public static String s = new String();

public void gettext() { try { //从电脑文件夹读入‘中文词库’文件 BufferedReader input = new BufferedReader(new

JAVA 中文分词实现

中文分词,用java实现,算法主要思想是正向最大匹配。利用ArryList存放中文

分词库中的词语,要按词语长度存放,先存放四字词语,最后存放单个字。然后

将输入的语句与ArryList逐一对比词语,匹配。最后将匹配好的分词放入

TreeMap,重新按原来顺序排好,输出。

package collection_package;

// 读入语句,读取要分析的句子

Scanner scanner = new Scanner(System.in); sen = scanner.nextLine(); }

public String compare(String str, ArrayList<String> list, int n) { String stemp; String strre; String strresult;

}

package collection_package;

import java.util.*;

public class StringAnalysis { public static String sen; public ArrayList al = new ArrayList();

public void get() { System.out.println("Please input the sentence");

FileReader("./chinese_word.txt")); s = input.readLine(); input.close();

} catch (Exception e) { System.out.println("Read Fail");

} }

//将词库放入ArrayList,按词语长度放置,通常词语最长为4,最为1 public ArrayList split(String str, int l) { String[] strarray = str.split(","); ArrayList al = new ArrayList(); for (int i = 0; i < strarray.length; i++) { if (strarray[i].length() == l) // al.add(strarray[i]); } return al; }

大家可以自己扩充中文词库文件。

截图

TreeMap tm = new TreeMap(); Iterator it = sa.al.iterator(); while (it.hasNext()) {

String s = (String) it.next();

tm.put(sa.sen.indexOf(s), s); //将匹配了的ArrayList放入TreeMap

//将词库放入ArrayList,按词语长度放置,通常词语最长为4,最短长度为1

for (int i = 4; i > 0; i--) sretain = pare(sretain, is.split(is.s, i), i);

// System.out.println(sa.al);

//新建一个TreeMap,为了可以使匹配了的分词重新按原先的顺序排列பைடு நூலகம்

}

strre = al.toString();

//删去已经匹配的词语

strre = strre.replace(" ", ""); strre = strre.replace(",", "|"); strre = strre.substring(1, strre.length() - 1); // System.out.println(strre); strresult = str.replaceAll(strre, ""); // System.out.println(strresult); return strresult; } }

//将句子与ArrayList对比,匹配的add进另一个ArrayList

for (int i = 0; i < str.length() - n + 1; i++) { stemp = str.substring(i, i + n); if (list.contains(stemp)) al.add(stemp);