关于模糊聚类的程序

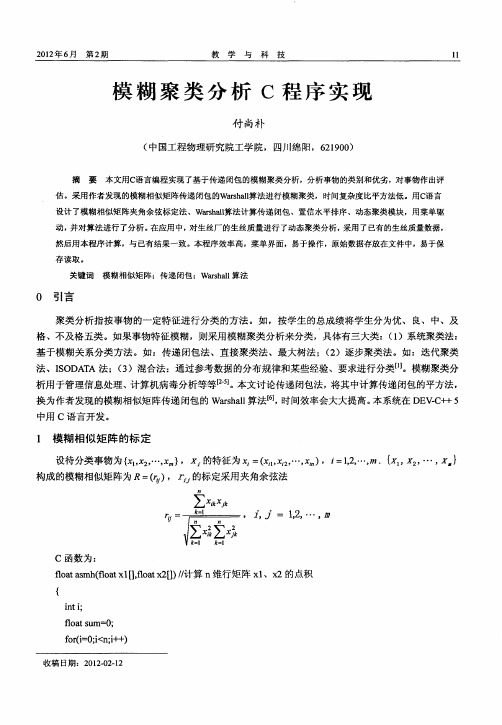

模糊聚类分析C程序实现

第2 期

教学与ຫໍສະໝຸດ 科技 模 糊 聚 类 分 析 C程 序 实 现

付 尚 朴

( 国工程物 理 研 究 院工学 院, 四川 绵阳 ,6 10 ) 中 29 0

摘

要

本文用C 语言编程实现 了基 于传递闭包 的模糊聚类 分析,分析事物的类别和优劣 ,对事物作 出评

估 。采用作者 发现的模糊相似矩 阵传递 闭包 的Wasal rhl 算法进行模糊聚类 ,时间复杂度 比平方法低 。用C 语言 设 计 了模糊相似矩 阵夹角余弦标定法 、Wasal r l h 算法计 算传递 闭包 、置信水平排序 、动态聚类模块 ,用菜单驱 动, 并对算法进行 了分析 。 在应用中 , 对生丝厂的生丝质量 进行 了动态聚类分析 , 采用 了已有的生丝质 量数 据, 然后用本程序计 算,与 已有 结果一致。本程序效率 高,菜单界面 ,易于操作 ,原始数据存放在文件中,易于保

换 为 作者 发现 的模糊 相似 矩 阵传 递 闭包 的 Wasal 法 【, r l算 引 时间效 率会 大大 提 高 。 h 本系 统在 DE -+ VC +5 中用 C语 言开 发 。

1 模糊 相似矩 阵的标 定

设待分类事物 为{l 2…, > X, , X ,X 的特征为X = X, , x ) _1, m.{l 2… , . i (i …,m ,f , …, X , , X ) l 2 2

v i (ot 【N】 ot【N】/ 夹 角余 弦标 定模糊 相似 矩 阵 r odR f aa】 , ar [ )/ l 【 f ] l 用

{

it ,; n k

fr= ; ; + o( Oi i ) i qn + fr = ; m; + 00 O < j ) j +

三类模糊聚类方法

三类模糊聚类方法三类模糊聚类方法模糊聚类是一种常用的数据聚类算法,它可以将样本点的分类问题转化为模糊集合的问题来求解。

根据模糊集合的划分方式,模糊聚类算法可以分为三类,即层次模糊聚类算法、基于相似度的模糊聚类算法和基于混合模型的模糊聚类算法。

(1)层次模糊聚类算法层次模糊聚类算法是一种简单好用的聚类算法,它的思想是通过使用不同的层次深度来划分模糊集合。

层次模糊聚类算法的典型算法有均值层次模糊聚类算法(FCM)、均方层次模糊聚类算法(SFCM)、最大化均值差层次模糊聚类算法(EMFCM)和缩放层次模糊聚类算法(SCFCM)等等。

(2)基于相似度的模糊聚类基于相似度的模糊聚类算法是一种聚类算法,它基于样本之间的相似度来划分模糊集合。

基于相似度的模糊聚类算法的常用算法有基于基础距离度量的模糊聚类算法(Fuzzy C-Means,FCM)、改进型模糊C均值算法(Modified FCM,MFCM)和改进型支持向量机算法(Modified SVM,MSVM)等。

(3)基于混合模型的模糊聚类基于混合模型的模糊聚类算法是一种基于混合模型的聚类算法,它引入了混合模型来构建模糊集合,有效地解决了其他模糊聚类算法中存在的缺陷,如局部最优性和忽略数据分布等问题。

基于混合模型的模糊聚类算法的典型算法有基于混合Normal模型的模糊聚类算法(Mixture Normal Fuzzy C-Means,MNFFCM)、基于混合Gausssian模型的模糊聚类算法(Mixture Gaussian Fuzzy C-Means,MGFCM)、基于混合Beta模型的模糊聚类算法(Mixture Beta Fuzzy C-Means,MBFCM)和基于混合Gamma模型的模糊聚类算法(Mixture Gamma Fuzzy C-Means,MGFCM)等。

试述模糊聚类的思想方法

试述模糊聚类的思想方法

模糊聚类是一种聚类分析方法,它是在模糊集合论的基础上进行的。

模糊聚类的思想方法主要有以下几点:

对于一个数据点,它不仅属于一个聚类,而且可以同时属于多个聚类。

因此,每个数据点都有一个隶属度,表示它属于每个聚类的程度。

模糊聚类的目标是最小化聚类间的差异,同时最大化聚类内部的相似度。

因此,模糊聚类的结果具有较高的联通性,能够反映数据之间的真实关系。

模糊聚类的过程一般分为两个阶段:聚类中心的初始化和聚类中心的更新。

聚类中心的初始化是指为每个聚类选取一个初始聚类中心;聚类中心的更新是指不断地调整聚类中心的位置,使得聚类内部的相似度最大化。

模糊聚类的结束条件可以是聚类中心的收敛,也可以是聚类结果的不再变化。

当聚类中心的收敛时,模糊聚类算法便结束了;当聚类结果的不再变化时,模糊聚类算法便结束了。

在模糊聚类算法结束后,每个数据点的隶属度就可以用来表示它属于每个聚类的程度。

模糊聚类的结果可以用来发现数据之间的联系,并且能够对数据进行分类。

在实际应用中,模糊聚类常常被用于市场细分、知识发现、数据挖掘等领域。

模糊聚类的原理和应用

模糊聚类的原理和应用1. 简介模糊聚类是一种聚类分析方法,它通过考虑数据点属于不同聚类的程度,使得数据点可以同时属于多个聚类。

与传统的硬聚类方法不同,模糊聚类能够更好地处理实际问题中的复杂性和不确定性。

本文将介绍模糊聚类的原理和应用。

2. 模糊聚类的原理在传统的硬聚类方法中,每个数据点只能隶属于一个聚类,而在模糊聚类中,每个数据点可以属于多个聚类,且属于不同聚类的程度可以从0到1之间的任意值。

这种程度被称为隶属度,用来表示数据点与聚类的关联程度。

模糊聚类的原理可以通过以下步骤来解释:1.初始化聚类中心:首先随机选择一些数据点作为聚类中心。

2.计算隶属度:计算每个数据点与每个聚类中心的隶属度,可以使用模糊C均值(FCM)算法来计算。

3.更新聚类中心:根据隶属度计算出每个聚类的中心点,更新聚类中心。

4.重复步骤2和3,直到聚类中心不再变化或达到预设的迭代次数。

模糊聚类的核心是通过计算隶属度来确定每个数据点对每个聚类的归属程度,从而实现多类别的聚类。

3. 模糊聚类的应用模糊聚类在许多领域中具有广泛的应用,包括数据挖掘、模式识别、图像处理和生物信息学等。

以下是几个常见的应用领域:3.1 数据挖掘在数据挖掘中,模糊聚类可以帮助找到数据集中的隐藏模式和关联规则。

通过将数据点划分到不同的聚类中,可以更好地理解数据的结构和特征。

模糊聚类还可以用作预测分析和聚类分析的基础。

3.2 模式识别在模式识别中,模糊聚类可以帮助将输入数据分类到模式类别中。

通过考虑隶属度,模糊聚类可以更好地处理模糊和不确定性的输入数据。

这在人脸识别、手写体识别等任务中非常有用。

3.3 图像处理在图像处理中,模糊聚类被广泛应用于图像分割和图像压缩等任务。

通过将图像像素划分到不同的聚类中,可以实现图像的分割和压缩。

模糊聚类还可以用于图像特征提取和图像检索等应用。

3.4 生物信息学在生物信息学中,模糊聚类被用于处理基因表达数据和蛋白质序列数据等。

模糊聚类流程

模糊聚类流程下载温馨提示:该文档是我店铺精心编制而成,希望大家下载以后,能够帮助大家解决实际的问题。

文档下载后可定制随意修改,请根据实际需要进行相应的调整和使用,谢谢!并且,本店铺为大家提供各种各样类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,如想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by the editor. I hope that after you download them, they can help yousolve practical problems. The document can be customized and modified after downloading, please adjust and use it according to actual needs, thank you!In addition, our shop provides you with various types of practical materials, such as educational essays, diary appreciation, sentence excerpts, ancient poems, classic articles, topic composition, work summary, word parsing, copy excerpts,other materials and so on, want to know different data formats and writing methods, please pay attention!模糊聚类流程是一种用于处理具有模糊性质的数据的聚类方法,它能够有效地识别出不同数据之间的模糊关系,从而实现数据的分组和分类。

matlab、lingo程序代码14-模糊聚类(聚类分析)

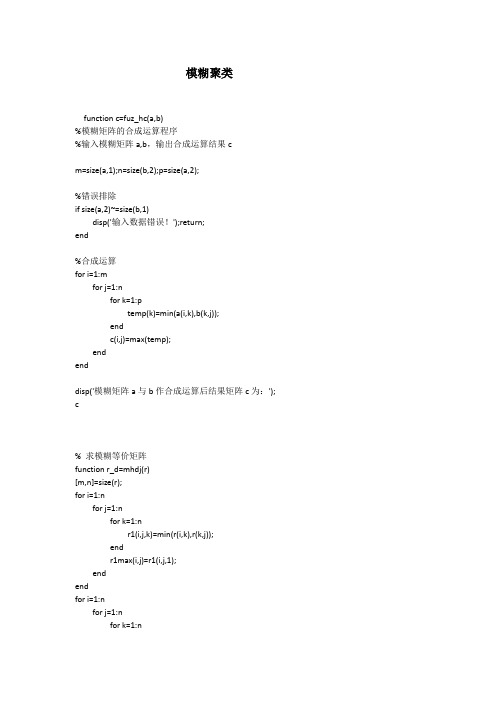

模糊聚类function c=fuz_hc(a,b)%模糊矩阵的合成运算程序%输入模糊矩阵a,b,输出合成运算结果cm=size(a,1);n=size(b,2);p=size(a,2);%错误排除if size(a,2)~=size(b,1)disp('输入数据错误!');return;end%合成运算for i=1:mfor j=1:nfor k=1:ptemp(k)=min(a(i,k),b(k,j));endc(i,j)=max(temp);endenddisp('模糊矩阵a与b作合成运算后结果矩阵c为:'); c% 求模糊等价矩阵function r_d=mhdj(r)[m,n]=size(r);for i=1:nfor j=1:nfor k=1:nr1(i,j,k)=min(r(i,k),r(k,j));endr1max(i,j)=r1(i,j,1);endendfor i=1:nfor j=1:nfor k=1:nif r1(i,j,k)>r1max(i,j)r1max(i,j)=r1(i,j,k);endendr_d(i,j)=r1max(i,j);endend%模糊聚类程序function f=mujl(x,lamda)%输入原始数据以及lamda的值if lamda>1disp('error!') %错误处理end[n,m]=size(x);y=pdist(x);disp('欧式距离矩阵:');dist=squareform(y) %欧氏距离矩阵dmax=dist(1,1);for i=1:nfor j=1:nif dist(i,j)>dmaxdmax=dist(i,j);endendenddisp('处理后的欧氏距离矩阵,其特点为每项元素均不超过1:');sdist=dist/dmax %使距离值不超过1disp('模糊关系矩阵:');r=ones(n,n)-sdist %计算对应的模糊关系矩阵t=mhdj(r);le=t-r;while all(all(le==0)==0)==1 %如果t与r相等,则继续求r乘以r r=t;t=mhdj(r);le=t-r;enddisp('模糊等价矩阵为:')tfor i=1:nk=1;for j=1:nif t(i,j)>=lamdagroup(i,k)=j;k=k+1;endendenddisp('聚类结果如下(数字0为自动填充数据,不是样本序号):') group(1,:)for i=2:nk=0;for j=1:i-1if all(group(i,:)==group(j,:))==1 %两行值完全相等,不输出k=1;break;endendif k==0disp(group(i,:)) %仅输出不重复的分类endend%模糊聚类程序function f=mujl(x,lamda)%输入原始数据以及lamda的值if lamda>1disp('error!') %错误处理end[n,m]=size(x);xmax=max(x);xmin=min(x);x=(x-xmin(ones(n,1),:))./(xmax(ones(n,1),:)-xmin(ones(n,1),:))y=pdist(x);disp('欧式距离矩阵:');dist=squareform(y) %欧氏距离矩阵dmax=dist(1,1);for i=1:nfor j=1:nif dist(i,j)>dmaxdmax=dist(i,j);endendenddisp('处理后的欧氏距离矩阵,其特点为每项元素均不超过1:');sdist=dist/dmax %使距离值不超过1disp('模糊关系矩阵:');r=ones(n,n)-sdist %计算对应的模糊关系矩阵t=mhdj(r);le=t-r;while all(all(le==0)==0)==1 %如果t与r相等,则继续求r乘以r r=t;t=mhdj(r);le=t-r;enddisp('模糊等价矩阵为:')tfor i=1:nk=1;for j=1:nif t(i,j)>=lamdagroup(i,k)=j;k=k+1;endendenddisp('聚类结果如下(数字0为自动填充数据,不是样本序号):') group(1,:)gru_val=1;for i=2:nk=0;for j=1:i-1if all(group(i,:)==group(j,:))==1 %两行值完全相等,不输出k=1;break;endendif k==0disp('第i类样本序号:'),igru_val=gru_val+1;disp(group(i,:)) %仅输出不重复的分类endendgru_val。

python投影寻踪模糊聚类法

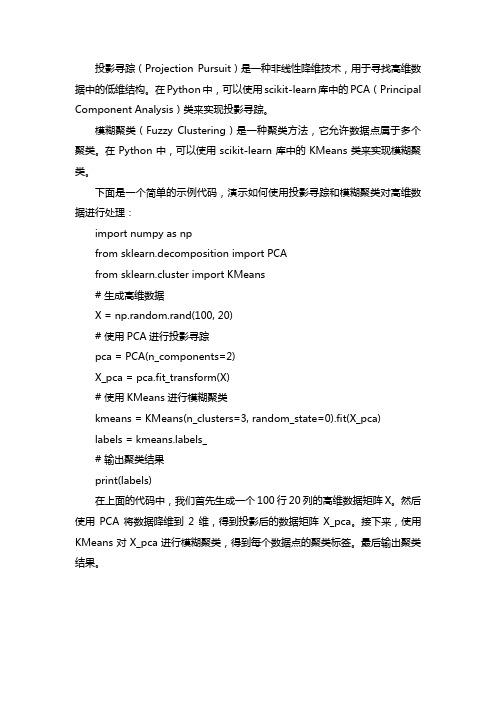

投影寻踪(Projection Pursuit)是一种非线性降维技术,用于寻找高维数据中的低维结构。

在Python中,可以使用scikit-learn库中的PCA(Principal Component Analysis)类来实现投影寻踪。

模糊聚类(Fuzzy Clustering)是一种聚类方法,它允许数据点属于多个聚类。

在Python中,可以使用scikit-learn库中的KMeans类来实现模糊聚类。

下面是一个简单的示例代码,演示如何使用投影寻踪和模糊聚类对高维数据进行处理:

import numpy as np

from sklearn.decomposition import PCA

from sklearn.cluster import KMeans

# 生成高维数据

X = np.random.rand(100, 20)

# 使用PCA进行投影寻踪

pca = PCA(n_components=2)

X_pca = pca.fit_transform(X)

# 使用KMeans进行模糊聚类

kmeans = KMeans(n_clusters=3, random_state=0).fit(X_pca)

labels = bels_

# 输出聚类结果

print(labels)

在上面的代码中,我们首先生成一个100行20列的高维数据矩阵X。

然后使用PCA将数据降维到2维,得到投影后的数据矩阵X_pca。

接下来,使用KMeans对X_pca进行模糊聚类,得到每个数据点的聚类标签。

最后输出聚类结果。

模糊c均值聚类算法

模糊c均值聚类算法

模糊c均值聚类算法(Fuzzy C-Means Algorithm,简称FCM)是一种基于模糊集理论的聚类分析算法,它是由Dubes 和Jain于1973年提出的,也是用于聚类数据最常用的算法之

一。

fcm算法假设数据点属于某个聚类的程度是一个模糊

的值而不是一个确定的值。

模糊C均值聚类算法的基本原理是:将数据划分为k个

类别,每个类别有c个聚类中心,每个类别的聚类中心的模糊程度由模糊矩阵描述。

模糊矩阵是每个样本点与每个聚类中心的距离的倒数,它描述了每个样本点属于每个聚类中心的程度。

模糊C均值聚类算法的步骤如下:

1、初始化模糊矩阵U,其中每一行表示一个样本点,每

一列表示一个聚类中心,每一行的每一列的值表示该样本点属于该聚类中心的程度,U的每一行的和为

1.

2、计算聚类中心。

对每一个聚类中心,根据模糊矩阵U

计算它的坐标,即每一维特征值的均值。

3、更新模糊矩阵U。

根据每一个样本点与该聚类中心的距离,计算每一行的每一列的值,其中值越大,说明该样本点属于该聚类中心的程度就越大。

4、重复步骤2和步骤

3,直到模糊矩阵U不再变化,即收敛为最优解。

模糊C均值聚类算法的优点在于它可以在每一个样本点属于每一类的程度上,提供详细的信息,并且能够处理噪声数据,因此在聚类分析中应用十分广泛。

然而,其缺点在于计算量较大,而且它对初始聚类中心的选取非常敏感。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

%The dataset is obtained from the data file 'iris.dat'. This dataset was collected by

% botanist Anderson and contains random samples of flowers

% belonging to three species of iris flowers setosa , versicolor , and virginica. For each of the species,

% 50 observations for sepal length, sepal width, petal length, and petal width are recorded.

% The dataset is partitioned into three groups named setosa , versicolor , and virginica. This is shown in the following code snippet.

load iris.dat

setosa = iris((iris(:,5)==1),:); % data for setosa

versicolor = iris((iris(:,5)==2),:); % data for versicolor

virginica = iris((iris(:,5)==3),:); % data for virginica

obsv_n = size(iris, 1); % total number of observations

% The data to be clustered is 4-dimensional data and represents sepal length, sepal width, petal length, and petal width.

% From each of the three groups(setosa, versicolor and virginica), two characteristics (for example, sepal length vs. sepal width) of

% the flowers are plotted in a 2-dimensional plot. This is done using the following code snippet.

%plot data in 2D

Characteristics = {'sepal length','sepal width','petal length','petal width'};

pairs = [1 2; 1 3; 1 4; 2 3; 2 4; 3 4];

h = figure;

for j = 1:6,

x = pairs(j, 1);

y = pairs(j, 2);

subplot(2,3,j);

plot([setosa(:,x) versicolor(:,x) virginica(:,x)],...

[setosa(:,y) versicolor(:,y) virginica(:,y)], '.');

xlabel(Characteristics{x},'FontSize',10);

ylabel(Characteristics{y},'FontSize',10);

end

% Next, the parameters required for Fuzzy C-Means clustering such as number of clusters, exponent for

% the partition matrix, maximum number of iterations and minimum improvement are defined and set.

% This are shown in the following code snippet.

%Setup Parameters

cluster_n = 3; % Number of clusters

expo = 2.0; % Exponent for U

max_iter = 100; % Max. iteration

min_impro = 1e-6; % Min. improvement

%compute clusters

% Fuzzy C-Means clustering is an iterative process. First, the initial fuzzy partition matrix is generated and

% the initial fuzzy cluster centers are calculated. In each step of the iteration, the cluster centers and the membership grade point are updated

% and the objective function is minimized to find the best location for the clusters.

% The process stops when the maximum number of iterations is reached, or when the objective function improvement

% between two consecutive iterations is less than the minimum amount of improvement specified. T

% his is shown in the following code snippet.

% initialize fuzzy partition

U = initfcm(cluster_n, obsv_n);

% plot the data if the figure window is closed

if ishghandle(h)

figure(h);

else

for j = 1:6,

x = pairs(j, 1);

y = pairs(j, 2);

subplot(2,3,j);

plot([setosa(:,x) versicolor(:,x) virginica(:,x)],...

[setosa(:,y) versicolor(:,y) virginica(:,y)], '.');

xlabel(Characteristics{x},'FontSize',10);

ylabel(Characteristics{y},'FontSize',10);

end

end

% iteration

for i = 1:max_iter,

[U, center, obj] = stepfcm(iris, U, cluster_n, expo);

fprintf('Iteration count = %d, obj. fcn = %f\n', i, obj);

% refresh centers

if i>1 && (abs(obj - lastobj) < min_impro)

for j = 1:6,

subplot(2,3,j);

for k = 1:cluster_n,

text(center(k, pairs(j,1)), center(k,pairs(j,2)), int2str(k), 'FontWeight', 'bold');

end

end

break;

elseif i==

for j = 1:6,

subplot(2,3,j);

for k = 1:cluster_n,

text(center(k, pairs(j,1)), center(k,pairs(j,2)), int2str(k), 'color', [0.5 0.5 0.5]);

end

end

end

lastobj = obj;

end。