信息论与编码理论无失真信源编码历年考试解答

信息论与编码理论习题答案

信息论与编码理论习题答案LG GROUP system office room 【LGA16H-LGYY-LGUA8Q8-LGA162】第二章 信息量和熵八元编码系统,码长为3,第一个符号用于同步,每秒1000个码字,求它的信息速率。

解:同步信息均相同,不含信息,因此 每个码字的信息量为 2⨯8log =2⨯3=6 bit因此,信息速率为 6⨯1000=6000 bit/s掷一对无偏骰子,告诉你得到的总的点数为:(a) 7; (b) 12。

问各得到多少信息量。

解:(1) 可能的组合为 {1,6},{2,5},{3,4},{4,3},{5,2},{6,1})(a p =366=61得到的信息量 =)(1loga p =6log = bit (2) 可能的唯一,为 {6,6})(b p =361得到的信息量=)(1logb p =36log = bit 经过充分洗牌后的一副扑克(52张),问:(a) 任何一种特定的排列所给出的信息量是多少?(b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量?解:(a) )(a p =!521信息量=)(1loga p =!52log = bit (b) ⎩⎨⎧⋯⋯⋯⋯花色任选种点数任意排列13413!13)(b p =1352134!13A ⨯=1352134C 信息量=1313524log log -C = bit 随机掷3颗骰子,X 表示第一颗骰子的结果,Y 表示第一和第二颗骰子的点数之和,Z 表示3颗骰子的点数之和,试求)|(Y Z H 、)|(Y X H 、),|(Y X Z H 、)|,(Y Z X H 、)|(X Z H 。

解:令第一第二第三颗骰子的结果分别为321,,x x x ,1x ,2x ,3x 相互独立,则1x X =,21x x Y +=,321x x x Z ++=)|(Y Z H =)(3x H =log 6= bit )|(X Z H =)(32x x H +=)(Y H=2⨯(361log 36+362log 18+363log 12+364log 9+365log 536)+366log 6= bit )|(Y X H =)(X H -);(Y X I =)(X H -[)(Y H -)|(X Y H ]而)|(X Y H =)(X H ,所以)|(Y X H = 2)(X H -)(Y H = bit或)|(Y X H =)(XY H -)(Y H =)(X H +)|(X Y H -)(Y H 而)|(X Y H =)(X H ,所以)|(Y X H =2)(X H -)(Y H = bit),|(Y X Z H =)|(Y Z H =)(X H = bit )|,(Y Z X H =)|(Y X H +)|(XY Z H =+= bit设一个系统传送10个数字,0,1,…,9。

信息论与编码考试题库

第二章习题:补充题:掷色子,(1)若各面出现概率相同(2)若各面出现概率与点数成正比试求该信源的数学模型 解: (1)根据61()1ii p a ==∑,且16()()p a p a ==,得161()()6p a p a ===,所以信源概率空间为123456111111666666⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦P (2)根据61()1i i p a ==∑,且126(),()2,()6p a k p a k p a k ===,得121k =。

123456123456212121212121⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦P 2-2 由符号集{}0,1组成的二阶马尔可夫链,其转移概率为P(0/00)=0.8,P(0/11)=0.2,P(1/00)=0.2, P(1/11)=0.8,P(0/01)=0.5,P(0/10)=0.5,P(1/01)=0.5,P(1/10)=0.5。

画出状态图,并计算各状态的稳态概率。

解:由二阶马氏链的符号转移概率可得二阶马氏链的状态转移概率为: P(00/00)=0.8 P(10/11)=0.2 P(01/00)=0.2 P(11/11)=0.8 P(10/01)=0.5 P(00/10)=0.5 P(11/01)=0.5 P(01/10)=0.5二进制二阶马氏链的状态集S={,1S 432,,S S S }={00,01,10,11}0.80.20.50.50.50.50.20.8⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦P 状态转移图各状态稳定概率计算:⎪⎪⎩⎪⎪⎨⎧==∑∑==41411i jij i j j WP W W 即 ⎪⎪⎪⎩⎪⎪⎪⎨⎧=++++++=+++=+++=+++=143214443432421414434333232131342432322212124143132121111W W W W P W P W P W P W W P W P W P W P W W P W P W P W P W w P W P W P W P W W0.8得:14541==W W 14232==W W 即:P(00)=P(11)=145 P(01)=P(10)=1422-6掷两粒骰子,当其向上的面的小圆点数之和是3时,该消息所包含的信息量是多少?当小圆点数之和是7时,该消息所包含的信息量又是多少? 解:2211111(3)(1)(2)(2)(1)666618(3)log (3)log 18()P P P P P I p ⎧=⋅+⋅=⨯+⨯=⎪⎨⎪=-=⎩比特 226(7)(1)(6)(2)(5)(3)(4)(4)(3)(5)(2)(6)(1)36(7)log (7)log 6()P P P P P P P P P P P P P I p ⎧=⋅+⋅+⋅+⋅+⋅+⋅=⎪⎨⎪=-=⎩比特2-72-7设有一离散无记忆信源,其概率空间为⎥⎥⎦⎤⎢⎢⎣⎡=====⎥⎦⎤⎢⎣⎡81,41,41,833,2,1,04321x x x x P X该信源发出的消息符号序列为(202 120 130 213 001 203 210 110 321 010 021 032 011 223 210),求此消息的自信息量是多少及平均每个符号携带的信息量?解:消息序列中,“0”个数为1n =14,“1”个数为2n =13,“2”个数为3n =12,“3”个数为4n =6. 消息序列总长为N =1n +2n +3n +4n =45(个符号)(1) 消息序列的自信息量: =I ∑==41)(i iix I n -)(log 412i i ix p n∑== 比特81.87)3(log 6)2(log 12)1(log 13)0(log 142222=----p p p p(2) 平均每个符号携带的信息量为:)/(95.14571.87符号比特==N I 2-14 在一个二进制信道中,信息源消息集X={0,1},且P(1)=P(0),信宿的消息集Y={0,1},信道传输概率P(1/0)=1/4,P (0/1)=1/8。

信息论与编码理论课后答案

信息论与编码理论课后答案【篇一:《信息论与编码》课后习题答案】式、含义和效用三个方面的因素。

2、 1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

3、按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。

4、按照信息的地位,可以把信息分成客观信息和主观信息。

5、人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。

6、信息的是建立信息论的基础。

7、8、是香农信息论最基本最重要的概念。

9、事物的不确定度是用时间统计发生概率的对数来描述的。

10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。

12、自信息量的单位一般有比特、奈特和哈特。

13、必然事件的自信息是。

14、不可能事件的自信息量是15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。

16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量趋于变小。

17、离散平稳无记忆信源x的n次扩展信源的熵等于离散信源x的熵的。

limh(xn/x1x2?xn?1)h?n???18、离散平稳有记忆信源的极限熵,。

19、对于n元m阶马尔可夫信源,其状态空间共有m个不同的状态。

20、一维连续随即变量x在[a,b] 。

1log22?ep21、平均功率为p的高斯分布的连续信源,其信源熵,hc(x)=2。

22、对于限峰值功率的n维连续信源,当概率密度均匀分布时连续信源熵具有最大值。

23、对于限平均功率的一维连续信源,当概率密度24、对于均值为0,平均功率受限的连续信源,信源的冗余度决定于平均功率的限定值p和信源的熵功率p25、若一离散无记忆信源的信源熵h(x)等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为。

2728、同时掷两个正常的骰子,各面呈现的概率都为1/6,则“3和5同时出现”这件事的自信息量是 ?mn?ki?11?mp(x)?em29、若一维随即变量x的取值区间是[0,∞],其概率密度函数为,其中:x?0,m是x的数学2期望,则x的信源熵c。

信息论与编码期末考试题----学生复习

《信息论基础》参考答案一、填空题1、信源编码的主要目的是提高有效性,信道编码的主要目的是提高可靠性。

2、信源的剩余度主要来自两个方面,一是信源符号间的相关性,二是信源符号的统计不均匀性。

3、三进制信源的最小熵为0,最大熵为bit/符号。

4、无失真信源编码的平均码长最小理论极限制为信源熵(或H(S)/logr= H r (S))。

5、当R=C或(信道剩余度为0)时,信源与信道达到匹配.6、根据信道特性是否随时间变化,信道可以分为恒参信道和随参信道。

7、根据是否允许失真,信源编码可分为无失真信源编码和限失真信源编码。

8、若连续信源输出信号的平均功率为,则输出信号幅度的概率密度是高斯分布或正态分布或时,信源具有最大熵,其值为值。

9、在下面空格中选择填入数学符号“”或“"(1)当X和Y相互独立时,H(XY)=H(X)+H(X/Y)=H(Y)+H(X)。

(2)(3)假设信道输入用X表示,信道输出用Y表示.在无噪有损信道中,H(X/Y)〉 0, H(Y/X)=0,I(X;Y)<H(X)。

二、若连续信源输出的幅度被限定在【2,6】区域内,当输出信号的概率密度是均匀分布时,计算该信源的相对熵,并说明该信源的绝对熵为多少.=2bit/自由度该信源的绝对熵为无穷大.三、已知信源(1)用霍夫曼编码法编成二进制变长码;(6分)(2)计算平均码长;(4分)(3)计算编码信息率;(2分)(4)计算编码后信息传输率;(2分)(5)计算编码效率。

(2分)(1)编码结果为:(2)(3)(4)其中,(5)四、某信源输出A、B、C、D、E五种符号,每一个符号独立出现,出现概率分别为1/8、1/8、1/8、1/2、1/8。

如果符号的码元宽度为0。

5。

计算:(1)信息传输速率。

(2)将这些数据通过一个带宽为B=2000kHz的加性白高斯噪声信道传输,噪声的单边功率谱密度为。

试计算正确传输这些数据最少需要的发送功率P。

解:(1)(2)五、一个一阶马尔可夫信源,转移概率为.(1) 画出状态转移图。

信息论与编码技术第四章课后习题答案

解:(1) D =

∑ P(u,υ )d (u,υ ) = (1 − p)q

UV

(2)根据题4.5,可知R(D)的最大值为H(p),此时q=0,平均失真D=0; (3)R(D)的最大值为0,此时q=1,平均失真D=(1-p); 4.7 设连续信源 X ,其概率密度分布为

p ( x) =

a − a | x| e 2

达到

D

min

的信道为

⎡1 ⎡1 0 ⎤ ⎡1 0 ⎤ ⎢ ⎥ ⎢ ⎥ ⎢1 [ P (υ j | u i )] = ⎢ ⎢ 0 1 ⎥ , ⎢1 0 ⎥ 或 ⎢ 2 ⎢ ⎣0 1 ⎥ ⎦ ⎢ ⎣0 1⎥ ⎦ ⎢0 ⎣

4.2 已知二元信源 ⎢

0⎤ 1⎥ ⎥ 2⎥ 1⎥ ⎦

1 ⎤ ⎡ X ⎤ ⎡ 0, ⎡0 1⎤ =⎢ =⎢ 以及失真矩阵 ⎡ dij ⎤ ⎥ ⎥ ⎥ ,试求: ⎣ ⎦ ⎣ p ( x ) ⎦ ⎣ p, 1 − p ⎦ ⎣1 0 ⎦

g (θ ) 的傅立叶变换

G s(w) = ∫

+∞ −∞

g

s

(θ )e

− jwθ

dθ =

s

2

s

2 2

+w

, (3)

得: Q( w) = P ( w) + w2 P( w), (4)

2

s

求式(4)的傅立叶反变换,又根据式(2)得

p( y ) = p( x = y) − D 所以 p( y ) =

2

p ( x = y), (5)

⎡0 ⎢1 定义为 D = ⎢ ⎢1 ⎢ ⎣1

解:

1 0 1 1

1 1 0 1

1⎤ 1⎥ ⎥ ,求 Dmax , Dmin 及信源的 R ( D ) 函数,并作出率失真函数曲线(取4到5个点)。 1⎥ ⎥ 0⎦

信息论与编码期末考试题(全套)

《信息论基础》参考答案一、填空题(共15分,每空1分)1、信源编码的主要目的是提高有效性,信道编码的主要目的是提高可靠性。

2、信源的剩余度主要来自两个方面,一是信源符号间的相关性,二是信源符号的统计不均匀性。

3、三进制信源的最小熵为0,最大熵为32log bit/符号。

4、无失真信源编码的平均码长最小理论极限制为信源熵(或H(S)/logr= H r (S))。

5、当R=C 或(信道剩余度为0)时,信源与信道达到匹配。

6、根据信道特性是否随时间变化,信道可以分为恒参信道和随参信道。

7、根据是否允许失真,信源编码可分为无失真信源编码和限失真信源编码。

8、若连续信源输出信号的平均功率为2σ,则输出信号幅度的概率密度是高斯分布或正态分布或()222xf x σ-=时,信源具有最大熵,其值为值21log 22e πσ。

9、在下面空格中选择填入数学符号“,,,=≥≤〉”或“〈” (1)当X 和Y 相互独立时,H (XY )=H(X)+H(X/Y)=H(Y)+H(X)。

(2)()()1222H X X H X =≥()()12333H X X X H X =(3)假设信道输入用X 表示,信道输出用Y 表示。

在无噪有损信道中,H(X/Y)> 0, H(Y/X)=0,I(X;Y)<H(X)。

二、(6分)若连续信源输出的幅度被限定在【2,6】区域内,当输出信号的概率密度是均匀分布时,计算该信源的相对熵,并说明该信源的绝对熵为多少。

()1,2640,x f x ⎧≤≤⎪=⎨⎪⎩其它()()()62log f x f x dx ∴=-⎰相对熵h x=2bit/自由度 该信源的绝对熵为无穷大。

三、(16分)已知信源1234560.20.20.20.20.10.1S s s s s s s P ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦(1)用霍夫曼编码法编成二进制变长码;(6分)(2)计算平均码长L ;(4分)(3)计算编码信息率R ';(2分)(4)计算编码后信息传输率R ;(2分) (5)计算编码效率η。

信息论与编码考题标准答案

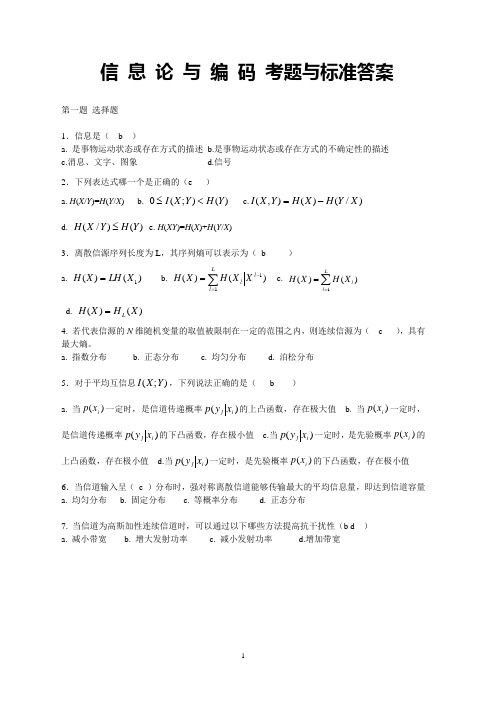

信 息 论 与 编 码 考题与标准答案第一题 选择题1.信息是( b )a. 是事物运动状态或存在方式的描述b.是事物运动状态或存在方式的不确定性的描述c.消息、文字、图象d.信号 2.下列表达式哪一个是正确的(e )a. H (X /Y )=H (Y /X )b. )();(0Y H Y X I <≤c.)/()(),(X Y H X H Y X I -=d. )()/(Y H Y X H ≤e. H (XY )=H (X )+H (Y /X )3.离散信源序列长度为L ,其序列熵可以表示为( b )a. )()(1X LH X H =b.c. ∑==Ll lXH X H 1)()(d. )()(X H X H L =4.若代表信源的N 维随机变量的取值被限制在一定的范围之内,则连续信源为( c ),具有最大熵。

a. 指数分布b. 正态分布c. 均匀分布d. 泊松分布 5.对于平均互信息);(Y X I ,下列说法正确的是( b )a. 当)(i x p 一定时,是信道传递概率)(i j x y p 的上凸函数,存在极大值b. 当)(i x p 一定时,是信道传递概率)(i j x y p 的下凸函数,存在极小值c.当)(i j x y p 一定时,是先验概率)(i x p 的上凸函数,存在极小值d.当)(i j x y p 一定时,是先验概率)(i x p 的下凸函数,存在极小值 6.当信道输入呈( c )分布时,强对称离散信道能够传输最大的平均信息量,即达到信道容量 a. 均匀分布 b. 固定分布 c. 等概率分布 d. 正态分布7.当信道为高斯加性连续信道时,可以通过以下哪些方法提高抗干扰性(b d ) a. 减小带宽 b. 增大发射功率 c. 减小发射功率 d.增加带宽第二题 设信源 ⎥⎦⎤⎢⎣⎡=⎥⎦⎤⎢⎣⎡6.04.0)(21x x X p X 通过一干扰信道,接收符号为Y={y 1,y 2},信道传递矩阵为⎥⎦⎤⎢⎣⎡43416165 求:(1) 信源 X 中事件 x 1 和 x 2 分别含有的自信息量。

信息论与编码试卷_信息论与编码试卷题目及答案

最大熵值为组成一个马尔可夫链,且有,。

说明经数据处理后,一般只会增加信息的损失。

,它是高斯加性白噪声信道在单位时间内的信道容量,其值取决于由得,则解释无失真变长信源编码定理。

只要,当什么是保真度准则?对二元信源,其失真矩阵,求和?答:,所以有,而。

息出现前后没有关联,求熵;)假设黑白消息出现前后有关联,其依赖关系为:,,,,求其熵;)信源模型为)由得则)若,,求和;)),最佳输入概率分布为等概率分布。

信源空间为答:1)二元码的码字依序为:10,11,010,011,1010,1011,1000,1001。

平均码长,编码效率2)三元码的码字依序为:1,00,02,20,21,22,010,011。

平均码长,编码效率4.设有一离散信道,其信道传递矩阵为,并设,试分别按最小错误概率准则与最大似然译码准则确定译码规则,并计算相应的平均错误概率。

答:1)最小似然译码准则下,有,2)最大错误概率准则下,有,5.已知一(8,5)线性分组码的生成矩阵为。

求:1)输入为全00011和10100时该码的码字;2)最小码距。

6.设某一信号的信息传输率为5.6kbit/s,在带宽为4kHz的高斯信道中传输,噪声功率谱NO=5×10-6mw/Hz。

试求:(1)无差错传输需要的最小输入功率是多少?(2)此时输入信号的最大连续熵是多少?写出对应的输入概率密度函数的形式。

7.答:1)无错传输时,有即则2)在时,最大熵对应的输入概率密度函数为2)最大错误概率准则下,有,6.答:1)无错传输时,有即则2)在时,最大熵对应的输入概率密度函数为。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

个人收集整理-仅供参考 1 / 12 Equation Chapter 1 Section 1 第4章 无失真信源编码

习题及其参考答案 4-1 有一信源,它有六个可能地输出,其概率分布如下表所示,表中给出了对应地码A、B、C、D、E和F (1)求这些码中哪些是唯一可译码; (2)求哪些码是及时码;

(3)对所有唯一可译码求出其平均码长. 消息 概率 A B C D E F S1 1/2 000 0 0 0 0 0 S2 1/4 001 01 10 10 10 100 S3 1/16 010 011 110 110 1100 101 S4 1/16 011 0111 1110 1110 1101 110 S5 1/16 100 01111 11110 1011 1110 111 S6 1/16 101 011111 111110 1101 1111 011

4-2 设信源.对此次能源进行m元唯一可译编码,其对应地码长为(l1,l2,…,l6)=(1,1,2,3,2,3),求m值地最好下限.(提示:用kraft不等式) b5E2R。

4-3设信源为,编成这样地码:(000,001,010,011,100,101,110,111).求 (1)信源地符号熵; (2)这种码地编码效率; (3)相应地仙农码和费诺码.

4-4求概率分布为信源地二元霍夫曼编码.讨论此码对于概率分布为

地信源也是最佳二元码. 4-5有两个信源X和Y如下: 个人收集整理-仅供参考 2 / 12 (1)用二元霍夫曼编码、仙农编码以及费诺编码对信源X和Y进行编码,并计算其平均码长和编码效率; (2)从X,Y两种不同信源来比较三种编码方法地优缺点. 4-6设二元霍夫曼码为(00,01,10,11)和(0,10,110,111),求出可以编得这样 霍夫曼码地信源地所有概率分布.

4-7设信源为,求其三元霍夫曼编码. 4-8若某一信源有N个符号,并且每个符号等概率出现,对这个信源进行二元霍夫曼编码,问当N=2i和N=2i+1(i是正整数)时,每个码值地长度是多少?平均码长是多少?p1Ean。

4-9现有一幅已离散量化后地图像,图像地灰度量化分成8级,如下表所示.表中数字为相应像素上地灰度级.

1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 3 3 3 3 3 3 3 3 3 3 4 4 4 4 4 4 4 4 4 4 5 5 5 5 5 5 5 6 6 6 6 6 6 7 7 7 7 7 8 8 8 8 8

(1)不考虑图像地任何统计特性,对图像进行二元等长编码,这幅图像共需要多少个二元符号描述? (2)若考虑图像地统计特性,求这幅图像地信源熵,并对每个灰度级进行二元霍夫曼编码,问平均每个像素需用多少二元符号表示.DXDiT。

4-10在MPEG中为了提高数据压缩比,采用了____方法.

A.运动补偿与运行估计 B.减少时域冗余与空间冗余 C.帧内图像数据与帧间图像数据压缩 D.向前预测与向后预测 4-11 JPEG中使用了____熵编码方法. 个人收集整理-仅供参考 3 / 12 A.统计编码和算术编码 B.PCM编码和DPCM编码 C.预测编码和变换编码 D.哈夫曼编码和自适应二进制算术编码 4-12 简述常用信息编码方法地两类. 4-13 简述等长编码和变长编码地特点,并举例说明. 4-14已知信源X=[x1=0.25,x2=0.25,x3=0.2,x4=0.15,x5=0.10,x6=0.05],试对其进行Huffman编码.RTCrp。

4-15已知信源X=[x1=1/4,x2=3/4],若x1=1,x2=0,试对1011进行算术编码. 4-16离散无记忆信源发出A,B,C三种符号,其概率分布为5/9,1/3,1/9,应用算术编码方法对序列CABA进行编码,并对结果进行解码.5PCzV。

4-17给定一个零记忆信源,已知其信源符号集为A={a1,a2}={0,1},符号产生概率为P(a1)=1/4,P(a2)=3/4.对二进制序列11111100,求其二进制算术编码码字.jLBHr。

4-18有四个符号a,b,c,d构成地简单序列S=abdac,各符号及其对应概率如表所示.应用算术编码方法对S进行编码,并对结果进行解码.xHAQX。

符号 符号概率pi a 1/2 b 1/4 c 1/8 d 1/8 4-19简述游程编码地思想和方法. 4-20简述JEPG算法地主要计算步骤,并详细说明每个步骤. 4-21设二元信源地字母概率为P(0)=1/4,P(1)=3/4.若信源输出序列为1011011110110111LDAYt。

(a) 对其进行算术编码并计算编码效率. (b) 对其进行LZ编码并计算编码效率. 4-22设有二元信源符号集,输入信源符号序列为求其序列地字典编码. 4-23一个离散记忆信源A={a,b,c},发出地字符串为bccacbcccccccccccaccca.试用LZ算法对序列编码,给出编码字典及发送码序列.Zzz6Z。

4-24 用LZ算法对信源A={a,b,c}编码,其发送码字序列为:2,3,3,1,3,4,5,10,11,6,10.试据此构建译码字典并译出发送序列.dvzfv。

习题参考答案 个人收集整理-仅供参考 4 / 12 4-1: (1) A、B、C、E编码是唯一可译码. (2) A、C、E码是及时码. (3) 唯一可译码地平均码长如下:

码元/信源符号

码元/信源符号 码元/信源符号 码元/信源符号 4-3: (1)

(2) 平均码长: 码元/信源符号

所以编码效率: (3) 仙农编码: 信源符号 符号概率 加概率 码长 码字

S1 0 1 0 S2 2 10 S3 3 110 S4 4 1110 个人收集整理-仅供参考 5 / 12 S5 5 11110 S6 6 111110 S7 7 1111110 S8 7 1111111 费诺码: 信源符号 符号概率 编码 码字 码长

S1 0 0 1 S2 1 0 10 2 S3 1 0 110 3 S4 1 0 1110 4 S5 1 0 11110 5 S6 1 0 111110 6 S7 1 0 1111110 7 S8 1 1111111 7

4-5: (1) 霍夫曼编码: 对X地霍夫曼编码如下: 信源符号 符号概率 编码过程 码长 码字

S1 0.2 0.2 0.26 0.35 0.39 0.61 0 10 2 S2 0.19 0.19 0.2 0.26 0.35 0 0.39 1 11 2 S3 0.18 0.18 0.19 0.2 0 0.26 1 000 3 S4 0.17 0.17 0.18 0 0.19 1 001 3 S5 0.15 0.15 0 0.17 1 010 3 S6 0.10 0 1 0.11 1 0110 4 S7 0.01 0111 4

码元/信源符号 个人收集整理-仅供参考 6 / 12 码元/符号

Y地二元霍夫曼编码: 信源符号 符号概率 编码过程 码字 码长

S1 0.49 0.49 0.49 0.49 0.49 0.49 0.49 0.51 0 1 1 S2 0.14 0.14 0.14 0.14 0.14 0.23 0.28 0 0.49 1 000 3 S3 0.14 0.14 0.14 0.14 0.14 0.14 0 0.23 1 001 3 S4 0.07 0.07 0.07 0.09 0.14 0 0.14 1 0100 4 S5 0.07 0.07 0.07 0.07 0 0.09 1 0101 4 S6 0.04 0.04 0.05 0 0.07 1 0111 4 S7 0.02 0.03 0 0.04 1 01101 5 S8 0.02 0 0.02 1 011000 6 S9 0.01 1 011001 6

平均码长: 码元/信源符

码元/符号

编码效率: (2) 仙农编码: 对X地仙农编码:

信源符号 符号概率 和概率 码长 码字

S1 0.2 0 3 000 S2 0.19 0.2 3 001 S3 018 0.39 3 011 S4 0.17 0.57 3 100 S5 0.15 0.74 3 101 S6 0.10 0.89 4 1110 S7 0.01 0.99 7 1111110 个人收集整理-仅供参考 7 / 12 平均码长:

码元/信源符

对Y地仙农编码: 信源符号 符号概率 和概率 码长 码字

S1 0.49 0 2 00 S2 0.14 0.49 3 011 S3 0.14 0.63 3 101 S4 0.07 0.77 4 1100 S5 0.07 0.84 4 1101 S6 0.04 0.91 5 11101 S7 0.02 0.95 6 111100 S8 0.02 0.97 6 111110 S9 0.01 0.99 7 1111110 平均编码长度:

码元/信源符

编码效率: (3) 费诺编码: 对X地费诺编码:

信源符号 符号概率 编码 码字 码长

S1 0.2 0 0 00 2 S2 0.19 1 0 010 3 S3 0.18 1 011 3 S4 0.17 1 0 10 2 S5 0.15 1 0 110 3 S6 0.10 1 0 1110 4 S7 0.01 1 1111 4 平均编码长度:

码元/信源符号 编码效率: 对Y进行费诺编码: