第三章回归诊断(3)

医用数据挖掘案例与实践 第3章 Logistic回归分析

➢在医学研究中,Logistic回归是分析疾病与致病因子间联系的重要统计方法, 它是以疾病发生概率为因变量,影响疾病发生的因子为自变量的一种回归方法。 ➢医学研究中的因变量有时并不是呈正态分布的连续型随机变量,其取值可能 只有两个:如发病与未发病,阳性与阴性,暴露与未暴露等。此时,线性回归 不再适用,而Logistic回归模型成功的解决了这一问题。 ➢根据响应变量(因变量)的类型,Logistic回归可分为二分类响应变量的 Logistic回归和多分类响应变量的Logistic回归。

P)

ln

P 1P

Logistic回归的模型结构:设二分类因变量 (Y =1

或Y =0),令Y =1的概率为 ,则 Y =0的概率为1-。

令

n

1

logit( )

,则以 logit( )

为因变量建立回归

方程:

logit( ) 0 1X1 .... p X p

进一步可推导出概率预报模型:

exp(0 1X1 ... p X p ) 1exp( 0 1X1 ... p X p )

Step 1

Step Block Model

Chi- sq uare 11.804 11.804 11.804

df 5 5 5

Sig . .038 .038 .038

图3.5 Logistic回归分析结果(全局检验)

如图3.5所示的输出表输出的是模型总的全局检验,即似然比卡方检验,三 个结果分别为:Step统计量为每一步与前一步相比的似然比检验结果;Block统 计量是指将block1与block0相比的似然比检验结果;而model统计量则是上一个 模型与现在方程中变量有变化后模型的似然比检验结果。

在多元线性回归:Yˆ 0 1x1 ... 中,Y 可

回归诊断

2

据的散点图和相应的回归直线,如图 6.1.1 所示。从图形来看,这四组数据完全不同。

3

1

F-statistic: 7.378e+06 on 2 and 8 DF, p-value: < 2.2e-16 因此,回归方程为 y 5.9957343 2.7808392 x 0.1267133 x 2 时更合理(其拟合曲线 见图 6.1.2(a))。

图 6.1.1(c)表示,简单回归的描述对于大部分数据正确,但有一个观测点(第 3 个点)距离拟合直 线太远,这实际上就是异常值问题。如果从数据集合中删去这个数据重新作回归分析,即

i<-1:11; Y31<-Anscombe$Y3[i!=3]; X3<-Anscombe$X[i!=3] lm3.sol<-lm(Y31~X3); summary(lm3.sol)

输出如下: Call: lm(formula = Y31 ~ X3) Residuals: Min 1Q Median 3Q Max -0.0060173 -0.0012121 -0.0010173 -0.0008225 0.0140693 Coefficients: Estimate Std. Error t value Pr(>|t|) (Intercept) 4.0106277 0.0057115 702.2 <2e-16 *** X3 0.3450433 0.0006262 551.0 <2e-16 *** --Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1 Residual standard error: 0.006019 on 8 degrees of freedom Multiple R-Squared: 1, Adjusted R-squared: 1 F-statistic: 3.036e+05 on 1 and 8 DF, p-value: < 2.2e-16 由计算结果和图 6.1.2(b)给出的修正后的拟合直线,容易看出,新的曲线效果相当不错,回归 曲线方程为: y 4.0106277 0.3450433x. 图 6.1.1(d)所对应的数据集合与前述几个都不同,没有足够的信息来对拟合模型作出判断。斜 率参数的估计值很大程度上是由第 8 个数据点的值决定。如果第 8 个数据点被删除,则不能估计斜 率参数。由于它对单个观测点如此依赖,我们无法相信这是一个综合分析。 总之,回归诊断是—个很复杂的问题,实施起来很有点像医生给病人诊病,有时一个症状往往 是多种不同疾病的征兆.必须从多方面做检查分析,才能断言毛病出在什么地方.在这方面,理论

回归分析回归诊断

• 对于由第三种成因引起的异常点,发现 之后可以进行删除,以免影响参数估计 等以后的工作效果。

• 另外一种方法就是对于异常点采取容忍 的态度,把整个数据集作为研究的基础, 对于一定比例的坏数据或者远离数据中 心的数据采取一定的容忍或适应政策

• 回归系数一般采用“最小二乘估计”(least squares estimator,LS estimator)求解,但是在应用中容易忽 视的问题是LS估计只有在数据满足相应条件的情况 下才会具有统计描述和推断的优良性质,如要求误 差服从正态分布、总体方差相同且相互独立等。

30

x 40

存在一个有影响观测值的散点图

• 强影响观测或者其影响变量取值异常, 或者其预测变量取值异常。

• 响应变量取值异常

标准化残差大的观测其响应变量的取值 异常,因为在Y方向上他们远离拟合的回 归方程。由于各标准化残差近似服从标 准正态分布,那么标准化的残差之绝对 值大于2或3的点称为异常点。

异常点的成因与处理

• 为什么会出现异常点?对这个问题的回答大致可以 归结为以下三种情况:整体模型变化、局部模型变 化和自然变异。

• 在前两种情况下,异常点出现的多而且连续,往往 蕴涵着机制的变化、新事物的出现或者新局面的形 成,大量而且连续的异常点可以用新的模型来拟合。 对于整个数据集,实质上已经成为一个混合模型。

我们还需要相关的度量指标

影响的各种度量

影响的各种度量

• 如果有些数据的C比其余点突出,那么该对此点打上标 记

影响点

通过图显示强影响点

25

20

15

y

10

5

0

0

20

40

x 60

存在高杆率观测值的散点图

回归诊断

l2 0 于是 l2 ( x2 i + X 2 ) + l3 ( x3 i + X 3 ) + vi 0 l3 l3 1 x2 i x3 i ( X 2 + X 3 + vi ) l2 l2 l2 l3 1 l3 vi ( X 2 + X 3 + vi ) l 令 l2 l2 l2

性越严重。反过来,方差膨胀因子越接近于1,

多重共线性越弱。

●经验表明,方差膨胀因子≥10时,说明解释变量

与其余解释变量之间有严重的多重共线性,且这 种多重共线性可能会过度地影响最小二乘估计。

20

三、逐步回归检验法

逐步回归的基本思想 将变量逐个的引入模型,每引入一个解释变量 后,都要进行F检验,并对已经选入的解释变量逐 个进行 t 检验,当原来引入的解释变量由于后面解 释变量的引入而变得不再显著时,则将其剔除。以 确保每次引入新的变量之前回归方程中只包含显著 的变量。在逐步回归中,高度相关的解释变量,在 引入时会被剔除。因而也是一种检测多重共线性的 有效方法。

1 X 21 1 X 22 X 1 X 2 n

n X X X 2 i X 3 i

2 x 2 3i ˆ ) Var( 2 2 2 2 ( x2 ) ( x ) ( x x ) i 3i 2i 3i

X 31 X 32 X 3n

21

多重共线性的补救措施

一、修正多重共线性的经验方法 1. 剔除变量法

把方差扩大因子最大者所对应的自变量首先

剔除再重新建立回归方程,直至回归方程中

不再存在严重的多重共线性。

注意: 若剔除了重要变量,可能引起模型的设

定误差。

回归诊断与多重共线性问题

回归诊断与多重共线性问题回归分析是统计学中常用的一种分析方法,用于研究自变量与因变量之间的关系。

在进行回归分析时,我们常常会遇到一些问题,其中包括回归诊断和多重共线性问题。

本文将分别介绍回归诊断和多重共线性问题,并探讨如何应对这些问题。

回归诊断回归诊断是指对回归模型进行检验和评估,以确定模型是否符合统计假设的过程。

在进行回归分析时,我们通常需要对回归模型进行诊断,以确保模型的准确性和可靠性。

回归诊断主要包括残差分析、异常值检测、异方差性检验和多重共线性检验等内容。

残差分析是回归诊断的重要内容之一。

残差是因变量的观测值与回归模型预测值之间的差异,残差分析可以帮助我们检验回归模型的拟合程度。

通过检查残差的分布情况,我们可以判断回归模型是否存在偏差或者模型是否符合线性假设。

通常情况下,残差应该呈现出随机分布的特征,如果残差呈现出一定的规律性,就说明回归模型存在问题,需要进行修正。

异常值检测也是回归诊断的重要环节。

异常值是指在数据集中与其他观测值明显不同的数值,异常值可能会对回归模型的拟合产生影响。

通过绘制残差图、杠杆图和敏感性分析等方法,我们可以检测异常值并对其进行处理,以提高回归模型的准确性。

异方差性检验是回归诊断的另一个重要方面。

异方差性是指回归模型的误差项方差不是常数的情况,这会导致回归系数估计值的不准确性。

通过绘制残差图、方差齐性检验等方法,我们可以检验回归模型是否存在异方差性,并采取相应的修正措施,以确保回归模型的可靠性。

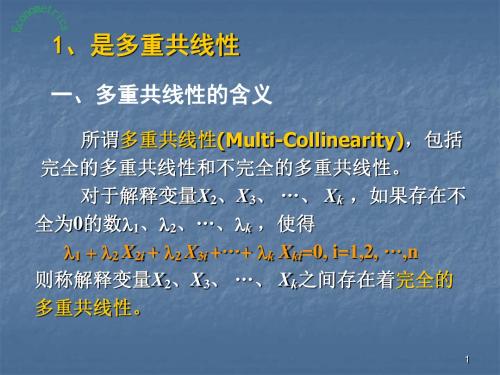

多重共线性问题多重共线性是指在回归模型中自变量之间存在高度相关性的情况。

多重共线性会导致回归系数估计值不稳定,增加模型的误差,降低模型的解释力。

因此,我们需要对多重共线性问题进行诊断和处理,以提高回归模型的准确性和可靠性。

多重共线性问题的存在会导致回归系数的估计值变得不准确甚至失去解释意义。

为了解决多重共线性问题,我们可以采取以下几种方法:1. 增加样本量:增加样本量可以减少多重共线性对回归模型的影响,提高模型的稳定性和准确性。

回归诊断

-1.05

3

140

5.3

4.27143 1.02857

4

120

4

3.40179 0.59821

5

180

6.55

6.01071 0.53929

6

100

2.15

2.53214 -0.38214

7

200

6.6

6.88036 -0.28036

8

160

5.75

5.14107 0.60893

由上述数据,可得 y 关于 x 的一元线性回归方程

n

hii hi2j hi2i hi2j hi2j 0

j 1

ji

ji

故有: hii hi2i ,由此可得。

n

(2) hii tr(I H ) tr( X ( X X )1 X ) tr(( X X )1 X X ) t 1

i 1

一般情况下:

hii

1 n

(xi

x)' L1(xi

• 其次,必须确定“度量影响的尺度是什么?”为了定量 地刻划影响的大小,迄今为止已提出多种尺度,基于置 信域的尺度,基于似然函数的尺度等等。在每一种类型 中又可能有不同的统计量,例如基于影响函数就已提出 多种“距离”来度量影响,有Cook距离、Welsch Kuh距离、Welsch距离等等。每一种度量都是着眼于某 一方面的影响,并在某种具体场合下较为有效。这一方 面反映了度量影响问题的复杂性,另一方面也说明了影 响分析的研究在统计诊断中是一个甚为活跃的方向,还 有大量有待解决的问题。

置。

M,c 常用的选择: M X X , c (t 1)s 2 ,此时,有:

Di

(M ,c)

ri2

第三章 回归诊断(2)(计量经济模型课件-中科院,许健)

本期GDP高于期望,有理由预测下一期也会 高;某个家庭的消费偏低,有理由推测另一 个家庭消费也偏低(正相关)

(一)自相关的经济背景

遗漏关键变量 如果这些关键变量在时间顺序上的影响 正相关,就会出现序列正相关 经济周期 不正确的函数形式 蛛网现象

(一)自相关的经济背景

数据处理导致自相关

1

广义差分法

Yt 0 1 X t ut

Yt 1 0 1 X t 1 ut 1 Yt Yt 1 0 1 1 X t X t 1 vt

广义差分法实现的关键就在于对自相关 系数的估计

自相关系数的估计

自相关系数的估计

如果样本量过小,那么第一个观测值也 不能损失,此时可以采用Prais-Winsten 变换:

Y1 1 2 X1 1

2

自相关系数的估计

Durbin两步法

Yt Yt 1 0 1 1 X t X t 1 vt Yt 0 1 1 X t 1 X t 1 Yt 1 vt 作Yt 对X t,X t 1和Yt 1的回归 将得到的Yt 1之前的系数作为对 的估计 ˆ 获得后,按一般方法将变量 作广义差分进行回归

(二)自相关的影响

14 y = 0.7528x + 4.0004 12 10 8 6 4 2 0 0 2 4 6 8 10 12 R2 = 0.8176

拟合回归线

(二)自相关的影响

真实回归线

12 10 8 6 4 2 0 0 2 4 6 8 10 12

(二)自相关的影响

真实残差平方和:130.7

回归诊断与模型优化

回归诊断与模型优化回归分析是统计学中一种重要的数据分析方法,用于研究自变量与因变量之间的关系。

在实际应用中,我们常常需要对回归模型进行诊断和优化,以确保模型的准确性和稳健性。

本文将介绍回归诊断的方法和模型优化的技巧,帮助读者更好地理解和运用回归分析。

一、回归诊断1.残差分析残差是指观测值与回归模型预测值之间的差异。

残差分析是回归诊断的重要方法之一,通过对残差的分布、模式和相关性进行分析,可以检验回归模型的假设是否成立。

常用的残差分析方法包括残差散点图、残差QQ图、残差-拟合值图等。

2.异常值检测异常值是指与其他观测值显著不同的数值,可能会对回归模型的拟合效果产生影响。

通过观察残差图和杠杆值等指标,可以识别出异常值并进行处理,以提高模型的准确性。

3.多重共线性诊断多重共线性是指自变量之间存在高度相关性的情况,会导致回归系数估计不准确甚至不稳定。

通过计算自变量之间的相关系数或方差膨胀因子(VIF),可以诊断多重共线性并采取相应措施,如删除相关性较高的自变量或进行主成分分析。

4.异方差性检验异方差性是指残差的方差随着自变量的变化而发生变化的情况,会导致回归系数的显著性检验产生偏误。

通过残差平方与拟合值的关系图或残差的离散性检验,可以判断是否存在异方差性并进行修正,如进行加权最小二乘法回归。

二、模型优化1.变量选择在建立回归模型时,选择合适的自变量对模型的准确性至关重要。

常用的变量选择方法包括前向逐步回归、后向逐步回归和逐步回归等,可以根据模型的拟合效果和解释性选择最优的自变量组合。

2.模型评估模型评估是指对建立的回归模型进行性能评估,以确定模型的拟合度和预测能力。

常用的模型评估指标包括R方值、调整R方值、均方误差(MSE)和残差标准差等,可以通过这些指标对模型进行比较和选择。

3.交叉验证交叉验证是一种常用的模型验证方法,通过将数据集划分为训练集和测试集,反复训练模型并评估性能,以避免过拟合和提高模型的泛化能力。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

X i1 X i 2 2 X i2

1

X i1Yi X Y i2 i 2 2 2 X i1 X i 2 2 X i1 X i 2 X i1Yi X Y X i1 i2 i 2 X i21 X i22 X i1 X i 2 X i1 X i 2

共线性的影响

如果X 1与X 2 存在完全线性相关关系:X 2 k X1,k 0,代入下式: X i22 X i1Yi X i1 X i 2 X i 2Yi 2 2 2 ˆ 1 X i1 X i 2 X i1 X i 2 ˆ X i2 X i 2Yi X i1 X i 2 X i1Yi 2 1 2 X i2 X i22 X i1 X i 2 1 0 0 00

三、共线性问题及其处理方法

何为共线性问题 共线性的影响 共线性的诊断 共线性的处理

何为共线性问题

所谓共线性,是指自变量之间存在线性 关系,所谓“之间”,不仅限于两个变 量,还指某个变量与某些变量。总之, 任一变量是或近似为其它变量的某种线 性组合的现象,就是共线性。

共线性的影响

1.如果自变量完全线性相关,解是不唯一 的,相应回归系数无法估计

2、主成分回归

判断应选择几个主成分,主要依据贡献率:

第i个主成分的贡献率:i / i 前S个主成分累计贡献率: varFi i

/

i 1 i i 1

S

p

i

一般要求累计贡献率在85%以上

2、主成分回归

主成分回归的基本步骤

1)进行主成分分析,得到主成分 2)以主成分为自变量进行建模

ˆ X X 1 X Y

要获得估计,必须能够求逆

共线性的影响

假定数据已经中心化 ˆ ˆ ˆ Y X X

1 1 2 2

ˆ X X 1 X Y ˆ 1 X i2 1 X X ˆ 2 i1 i 2

2、主成分回归

主成分分析是一种常用的降维方法,它 在信息损失最小的原则下,往往可以将 变量数大大减少,而且可以在理论上保 证所获得的新变量(主成分)之间不相 关

2、主成分回归

基本思想

X2

X1

2、主成分回归

X2

X1

主成分分析过程的实质就是对原坐标系进行平 移和旋转变换

2、主成分回归

第一主成分就对应数据变异的第一大方 向,对原始数据的变异最具解释力; 第二主成分就对应数据变异的第二大方 向; …… 不同主成分之间不相关 主成分是自变量的线性组合

共线性的影响

为考察回归系数的符号问题,而 肯定大于0,故可以去掉

1 X 1Y rX 2Y 2 X 2Y rX 1Y 不妨设r 0,X 1Y X 2Y, ~ ~

1 n 1 r2

则可得到相关系数与系数估计值的关系图

共线性的影响

i

1、岭回归

用岭迹图判断k值的基本原则是:

回归系数的岭估计基本稳定 回归系数符号要合理 回归系数没有明显不合经济意义的绝对值 误差增大不多

1、岭回归

岭回归的基本性质

ˆ 性质1: k 是的有偏估计 ˆ ˆ 性质2: k 是的一个线性变换 ˆ ˆ 性质3:存在k 0,使得 k 的均方误差小于

经验法则 CI在10到30之间,存在中等强度共线性 CI大于30,存在严重共线性

共线性的处理方法

比较系统的方法 岭回归 主成分回归 偏最小二乘 时序横截面模型

共线性的处理方法

其他方法: 增加数据量 删除变量 变量替换 变量组合

1、岭回归(ridge regression)

共线性的诊断

方差膨胀因子(VIF,Variance Inflation Factor)

自变量X j的方差膨胀因子记为: VIF j 1 1 R 2 j

R 2 是以X j 为因变量对其他自变量 回归的拟合优度 j 一般认为: 最大的VIF j 大于10,存在严重共线性

共线性的诊断

方差膨胀因子可以度量回归系数的标准误 相对于不存在线性相关时,增加了多少

共线性的影响

2.如果并非完全线性相关,回归系数虽可 估计,但回归系数标准误将随相关程度 的增强而迅速加大

1 ˆ cov 2 X X

以中心化两变量模型为例: ˆ var 1 2 2

X X

2 i1

X i22

2 i2

X i1 X i 2

两变量模型,不妨假设X均是中心化变量: 1 ˆ cov 2 X X

ˆ var

1

2

1 2 X i2 1 r12 1

Βιβλιοθήκη 1 X i2 1 R 2 1 j

2

共线性的诊断

condition indices(CI)

最大特征值 CI 最小特征值

2 i1 1

X X

1

X X X

i1 2 i2

i2

1

n nr 1 r 1 nr n n 1 r 2 r 1 ˆ 1 1 r X 1 1 n 1 r 2 r 1 X Y ˆ 2 2 X 1Y rX 2Y 1 2 n 1 r X 2Y rX 1Y

2

1 2 X i2 1 r12 1

共线性的影响

r12

0 0.5 0.7 0.8 0.9 0.95

ˆ var 1

X

2 i1

2

1.33 2

1.96 2

X

X

2 i1

2 i1

2.78 2

5.26 2

X X

2 i1

2 i1

10 .26 2

X

2 i1

1

∞

共线性的影响

k 2 X i2 X i1Yi k 2 X i1 X i1 X i1Yi 1 2 ˆ 1 k 2 X i2 X i2 k 2 X i1 X i1 1 1 ˆ k X i2 X i1Yi k X i1 X i1 X i1Yi 1 2 2 2 2 2 2 k X i1 X i1 k X i1 X i1

~

1

1 r

~

2

~

共线性的影响

4.如果存在共线性,则对回归系数的解释 一般不再适用

共线性的诊断

经验式的诊断 1、简单相关系数、散点图(矩阵图) 2、回归系数符号出现异常 3、F检验很显著,t检验却都不显著 4、增加或删除一个变量或观测值,回归系数估 计值发生很大变化 5、重要自变量回归系数的置信区间过大 6、样本点过少,一般都存在共线性

主成分方法本身也会受到共线性的干扰

基本思想

当出现严重共线性问题时, X 0 X 可以设想增加一个正常数矩阵k I,

X X k I 接近奇异的可能性会小很多

ˆ k X X k I 1 X Y作为的估计 应该比最小二乘估计稳定

1、岭回归

对于岭回归的实际应用而言,k(偏倚系数) 的估计是关键,需要结合岭迹图进行判断

X i22 X i1 X i 2 2 X i2 X i22 1 X i1 X i 2 X i1 X i 2 2 X i21 X i22

X i22 X i1Yi X i1 X i 2 X i 2Yi 2 X i2 X i22 X i1 X i 2 1 2 X i1 X i 2Yi X i1 X i 2 X i1Yi 2 X i2 X i22 X i1 X i 2 1

标准误过大,将使得回归系数的波动性 很大,对样本值非常敏感,因此也降低 了回归方程的价值

t检验是建立在标准误基础上的,因此存 在共线性问题时,t值将减小,经常无法 通过检验

共线性的影响

3.经常出现回归系数符号反常现象

以两个自变量,标准化后的情况为例: X X X i1 i 2