横截面数据分类:机器学习方法

03FZ横截面分类

分类

分类(classification)

• 分类(classification)就是经典统计中所说的判别 (discrimination).

– 当只有两个水平时, 可以采用logistic回归及probit回归

– 在自变量全部为数量变量时可以用经典多元分析中的判别分 析.

• 目的是使得每一点群内部的点尽量接近, 同时使各 群之间尽量分开. 不同的准则造就了不同的判别或 分类方法.

关于column.2C.dat数据

library(MASS) w2=read.table("column.2C.dat") a=lda(V7~.,data=w2)#数据column.2C.dat b=predict(a,w2)$class#对训练集的预测(类) (zz=table(w2[,7],b));(sum(zz)-sum(diag(zz)))/sum(zz)#0.1419355

– 多项分布对数线性模型和多项logit模型. – 机器学习的方法也可以应用于频数问题.

回顾经典logistic回归, probit回归和仅 适用于数量自变量的判别分析

该数据有两个版本, 其区别仅仅在于一个版本的因变量有2 个水平, 另一个有3个水平. 而两个版本的自变量是相同的, 都是定量变量. 可以尝试用经典的logistic回归, probit回归 和判别分析来拟合这个数据. 当然, 经典的logistic回归及 probit回归并不要求自变量一定是数量变量, 完全可以包含 定性变量. 但经典判别分析只能用数量型自变量.

library(adabag) set.seed(4410) a=boosting(NSP~.,w) #或adaboost.M1(NSP~.,w) z0=table(w[,23],predict(a,w)$class) z0=z0[order(as.numeric(dimnames(z0)[[1]])),

第四章 横截面数据分类

或者

注意:伯努利分布均值 p ,这里的连接函数为 ( ) ( p) ln[ p /(1 p)] X T 在简单回归的期望表达式 E(Y ) X T 中,左边不是观测变量,而是 均值参数 ,方程(4.1)左边也不是可观测变量,而是假定背景分布(伯 努利分布)一个参数的函数,因为函数 ln[ p /(1 p)] 被称为Logit函数,所以 这个模型叫做logistic回归模型,为广义模型的一个特例. 显然,logistic回归试图把取值范围为整个实数轴 X T 和取值区间[0,1]的P 联系起来:logistic模型(4.1)左边的 ln[ p /(1 p)] 和右边的 X T 取值范围一 样,都是整个实数轴。

1)逐步回归结果:

step的缺省是backward,所以最开始是那个最大的model.可以看出,变量V4 在逐步回归中被淘汰,此时AIC=190.98 通过逐步回归筛选变量之后,得到的logistic回归输出结果如下表:

表4.2

逐步回归筛选变量之后的logistic回归输出结果输出

所以可知训练出来的模型为:

-1 ( ) 或者 ( ) m( )

而且Y服从(正态分布也在其中的)指数族分布,则我们就有 了广义线性模型(GLM),() 称为连接函数,其逆函数 m() 称 为均值函数.

如果因变量观测值Y来自指数族分布,那么它的密度函数的形式为

fY ( y; , ) a( y, ) exp

E(Y ) , ( );Var(Y ) ,, ( )

连接函数 称为典则连接函数,它使得数学推导简单很多,即便如此 但没有任何证据说明点则连接函数在你和实际数据时比其他连接函数好, 由于R中的glm()函数对某分布的默认连接函数是其点则连接函数,下面列 出某些属于指数族的分布典则连接函数

stata截面数据定义

stata截面数据定义Stata截面数据分析简介概述Stata是一种常用的统计软件,广泛应用于经济学、社会科学和医学等领域。

截面数据是一种在特定时间点对多个个体进行观测的数据集,也称为横截面数据。

本文将以Stata截面数据为标题,介绍截面数据的基本特点和常见分析方法。

截面数据的特点截面数据是在某一特定时间点对多个个体进行测量的数据集。

与时间序列数据相比,截面数据没有时间维度,只有一个观测点。

截面数据的特点有以下几个方面:1. 多个个体:截面数据通常包含多个个体的观测值,这些个体可以是人、公司、国家等。

个体之间具有独立性,每个个体都有自己的属性和特征。

2. 同一时间点:截面数据是在同一时间点对个体进行观测的,因此数据中不包含时间序列信息。

这使得截面数据适用于研究个体之间的横向差异和相关关系。

3. 多个变量:截面数据通常包含多个变量,用于描述个体的属性和特征。

这些变量可以是定量变量(如年龄、收入)或定性变量(如性别、教育程度)。

截面数据的分析方法Stata提供了丰富的功能和命令,用于对截面数据进行分析。

下面介绍几种常见的截面数据分析方法:1. 描述统计分析:描述统计分析是对截面数据进行基本的统计描述,包括计算均值、中位数、标准差等统计指标。

Stata提供了多种命令,如summarize、tabulate等,可以方便地进行描述统计分析。

2. 单变量分析:单变量分析是对截面数据中的单个变量进行分析,主要目的是了解该变量的分布情况和基本特征。

Stata提供了多种命令,如histogram、boxplot等,可以绘制直方图、箱线图等图形进行单变量分析。

3. 双变量分析:双变量分析是对截面数据中的两个变量之间的关系进行分析,常用的方法包括相关分析和回归分析。

Stata提供了命令如correlate、regress等,可以计算变量之间的相关系数和进行回归分析。

4. 多变量分析:多变量分析是对截面数据中多个变量之间的关系进行分析,常用的方法包括主成分分析和聚类分析。

横截面大数据、时间序列大数据、面板大数据

横截面数据、时间序列数据、面板数据横截面数据:(时间固定)横截面数据是在同一时间,不同统计单位相同统计指标组成的数据列。

横截面 数据是按照统计单位排列的。

因此,横截面数据不要求统计对象及其范围相同,但要 求统计的时间相同。

也就是说必须是同一时间截面上的数据。

如:涨幅超-2.72-1.00 144 -0.98 -1.33 -2.92 -0.56 -1.18 -1.94时间序列数据:(横坐标为t,纵坐标为y )在不同时间点上收集到的数据,这类数据反映某一事物、现象等随时间的变化状态或程度面板数据:(横坐标为t,斜坐标为y,纵坐标为z )是截面数据与时间序列数据综合起来的一种数据类型。

其有时间序列和截面两 个维度,当这类数据按两个维度排列时,是排在一个平面上,与只有一个维度的数据 排在一条线上有着明显的不同,整个表格像是一个面板,所以把panel data 译作”面 板数据”。

举例:如:城市名:北京、上海、重庆、天津的GDP 分别为10、11、9、8 (单位亿 元)。

这就是截面数据,在一个时间点处切开,看各个城市的不同就是截面数据。

精彩文档行场份车贸份场份际称银机股汽国股机股国名度云钢风国创海钢能浦S-S-东申苜上包华如:如:2000、2001、2002、2003、2004 各年的北京市GDP 分别为8、9、10、11、12 (单位亿元)。

这就是时间序列,选一个城市,看各个样本时间点的不同就是时间序列。

如:2000、2001、2002、2003、2004各年中国所有直辖市的GDP分别为:北京市分别为8、9、10、11、12;上海市分别为9、10、11、12、13;天津市分别为5、6、7、8、9;重庆市分别为7、8、9、10、11 (单位亿元)。

这就是面板数据。

2000200120022003北京1453上海2436重庆2135天津4537关于面板数据的统计分析在写论文时经常碰见一些即是时间序列又是截面的数据,比如分析1999-2010的公司盈余管理影响因素,而影响盈余管理的因素有6个,那么会形成如下图的数据公司1公司2公司100因素1因素6盈余管理程度因素1因素6盈余管理程度因素1因素6盈余管理程度199920002010精彩文档如上图所示的数据即为面板数据。

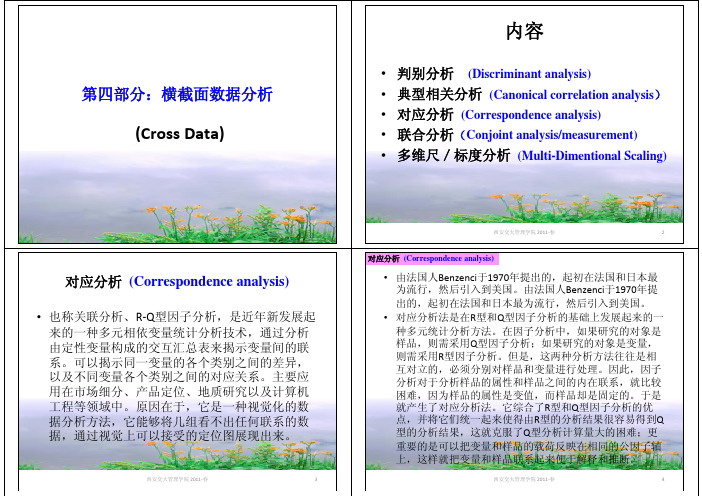

第四部分:横截面数据分析

第四部分:横截面数据分析(Cross Data)西安交大管理学院2011‐春2内容•判别分析(Discriminant analysis)•典型相关分析(Canonical correlation analysis )•对应分析(Correspondence analysis)•联合分析(Conjoint analysis/measurement)•多维尺/标度分析(Multi-Dimentional Scaling)对应分析(Correspondence analysis)•也称关联分析、R ‐Q 型因子分析,是近年新发展起来的一种多元相依变量统计分析技术,通过分析由定性变量构成的交互汇总表来揭示变量间的联系。

可以揭示同一变量的各个类别之间的差异,以及不同变量各个类别之间的对应关系。

主要应用在市场细分、产品定位、地质研究以及计算机工程等领域中。

原因在于,它是一种视觉化的数据分析方法,它能够将几组看不出任何联系的数据,通过视觉上可以接受的定位图展现出来。

•由法国人Benzenci 于1970年提出的,起初在法国和日本最为流行,然后引入到美国。

由法国人Benzenci 于1970年提出的,起初在法国和日本最为流行,然后引入到美国。

•对应分析法是在R 型和Q 型因子分析的基础上发展起来的一种多元统计分析方法。

在因子分析中,如果研究的对象是样品,则需采用Q 型因子分析;如果研究的对象是变量,则需采用R 型因子分析。

但是,这两种分析方法往往是相互对立的,必须分别对样品和变量进行处理。

因此,因子分析对于分析样品的属性和样品之间的内在联系,就比较困难,因为样品的属性是变值,而样品却是固定的。

于是就产生了对应分析法。

它综合了R 型和Q 型因子分析的优点,并将它们统一起来使得由R 型的分析结果很容易得到Q 型的分析结果,这就克服了Q 型分析计算量大的困难;更重要的是可以把变量和样品的载荷反映在相同的公因子轴上,这样就把变量和样品联系起来便于解释和推断。

横截面数据分类——基于R

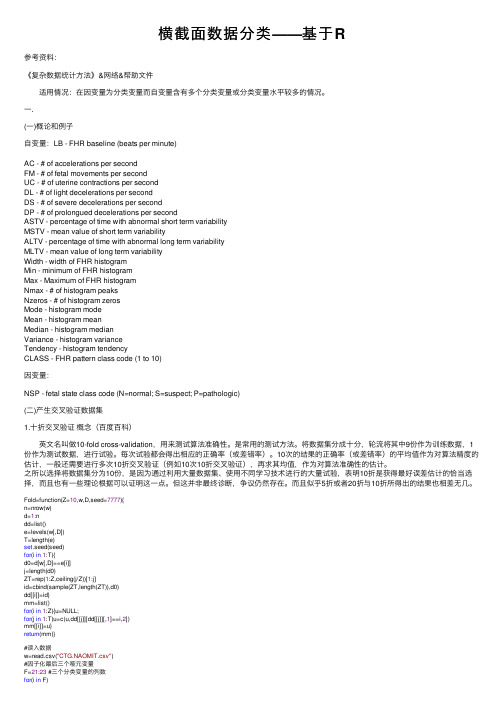

横截⾯数据分类——基于R参考资料:《复杂数据统计⽅法》&⽹络&帮助⽂件 适⽤情况:在因变量为分类变量⽽⾃变量含有多个分类变量或分类变量⽔平较多的情况。

⼀.(⼀)概论和例⼦⾃变量:LB - FHR baseline (beats per minute)AC - # of accelerations per secondFM - # of fetal movements per secondUC - # of uterine contractions per secondDL - # of light decelerations per secondDS - # of severe decelerations per secondDP - # of prolongued decelerations per secondASTV - percentage of time with abnormal short term variabilityMSTV - mean value of short term variabilityALTV - percentage of time with abnormal long term variabilityMLTV - mean value of long term variabilityWidth - width of FHR histogramMin - minimum of FHR histogramMax - Maximum of FHR histogramNmax - # of histogram peaksNzeros - # of histogram zerosMode - histogram modeMean - histogram meanMedian - histogram medianVariance - histogram varianceTendency - histogram tendencyCLASS - FHR pattern class code (1 to 10)因变量:NSP - fetal state class code (N=normal; S=suspect; P=pathologic)(⼆)产⽣交叉验证数据集1.⼗折交叉验证概念(百度百科) 英⽂名叫做10-fold cross-validation,⽤来测试算法准确性。

计量经济学横截面数据模型下标

计量经济学横截面数据模型: 理论基础与应用引言计量经济学是经济学领域中的重要分支,旨在通过利用数理统计方法来研究和解释经济现象。

计量经济学的数据来源多种多样,其中之一便是横截面数据。

横截面数据指的是在一定时间点上收集的多个经济单元的相关变量。

本文将重点讨论计量经济学中横截面数据模型的下标表示以及其应用。

横截面数据模型下标: 变量与经济单元在横截面数据模型中,我们通常用不同的下标来表示不同的变量和经济单元。

下面是一些常用的下标及其含义:•i: 表示第i个经济单元,通常是个体或者行为者。

•t: 表示在第t个时间点上采集的数据。

•y it: 表示第i个经济单元在t时间点上的被解释变量,也可以称为因变量或观测变量。

•x it: 表示第i个经济单元在t时间点上的解释变量,也可以称为自变量或控制变量。

在横截面数据模型中,我们通常考虑的是多个经济单元在同一时间点上的数据。

因此,对于变量的下标,我们通常会同时考虑到经济单元和时间点的信息。

横截面数据模型下标的应用在应用计量经济学中的横截面数据模型时,我们需要结合具体问题来选择和使用适当的下标。

下面将介绍一些常见的应用场景。

线性回归模型线性回归模型是计量经济学中应用最广泛的横截面数据模型之一,可以用来研究因变量和解释变量之间的关系。

在线性回归模型中,通常使用下面的下标表示:y it=β0+β1x it1+β2x it2+⋯+βk x itk+u it其中,y it表示第i个经济单元在t时间点上的被解释变量,x it1,x it2,…,x itk表示第i个经济单元在t时间点上的k个解释变量,β0,β1,…,βk表示模型的参数,u it表示误差项。

检验经济假设横截面数据模型还常常被用来检验经济理论和假设。

例如,我们想要检验收入对教育水平的影响。

在这种情况下,我们可以建立下面的模型:y it=β0+β1x it1+u it其中,y it表示第i个经济单元在t时间点上的教育水平,x it1表示第i个经济单元在t时间点上的收入,β0表示模型的截距,β1表示收入对教育的影响,u it表示误差项。

横截面数据分类:机器学习方法

▪ 缺点:计算成本高,因为需要建立的模型数量与原始数据样本数量相同, 当原始数据样本数量相当多时,LOO-CV在实作上便有困难几乎就是不 显示,除非每次训练分类器得到模型的速度很快,或是可以用并行化计算 减少计算所需的时间.

5.8神经网络分类

▪ 对于拟合全部数据,代码如下: • library(nnet) • a=nnet(NSP~.,data=w,subset=1:n, • size=2,rang=0.01,decay=5e-4,maxit=200) • wp=predict(a,w[m,],type="class") • sum(w[m,D]!=wp)/length(m) 得到误判率为0.2180095.

▪ 下面用同样的参数做10折交叉验证:

▪ library(nnet)

▪ E=rep(0,Z)

▪ for(i in 1:Z){

▪ m=mm[[i]];mc=setdiff(1:n,m)

▪ a=nnet(NSP~.,data=w,subset=mc,size=2,

▪

rang=0.1,decay=0.01,maxit=200)

5.6支持向量机分类

5.6.1拟合全部数据

5.6.2交叉验证

5.7最近邻分类

▪ K最近邻(k-Nearest Neighbor,KNN)分类算法,是一个理 论上比较成熟的方法,也是最简单的机器学习算法之一。 该方法的思路是:如果一个样本在特征空间中的k个最相似 (即特征空间中最邻近)的样本中的大多数属于某一个类别 ,则该样本也属于这个类别。KNN算法中,所选择的邻居都 是已经正确分类的对象。该方法在定类决策上只依据最邻 近的一个或者几个样本的类别来决定待分样本所属的类别 。 KNN方法虽然从原理上也依赖于极限定理,但在类别决 策时,只与极少量的相邻样本有关。由于KNN方法主要靠周 围有限的邻近的样本,而不是靠判别类域的方法来确定所 属类别的,因此对于类域的交叉或重叠较多的待分样本集 来说,KNN方法较其他方法更为适合。