12第十二章 回归分析

第12章-多重线性回归分析

6 因变量总变异的分解

P

(X,Y)

Y

(Y Y) (Y Y)

(Y Y)

Y X

Y

Y

9

Y的总变异分解

Y Y Yˆ Y Y Yˆ

Y Y 2 Yˆ Y 2 Y Yˆ 2

总变异 SS总

回归平方和 剩余平方和

SS回

SS剩

10

Y的总变异分解

病程 (X2)

10.0 3.0 15.0 3.0 4.0 6.0 2.9 9.0 5.0 2.0 8.0 20.0

表 12-1 脂联素水平与相关因素的测量数据

空腹

回归模空型腹 ?

瘦素

脂联 BMI 病程 瘦素

脂联

(X3)

血糖 (X4)

素(Y)

(X1)

(X2)

(X3)

血糖 素(Y) (X4)

5.75 13.6 29.36 21.11 9.0 4.90 6.0 17.28

H 0: 1 2 3 4 0 ,即总体中各偏回归系数均为0; H 1:总体中各偏回归系数不为0或不全为0;

= 0.05。

2 计算检验统计量: 3 确定P值,作出推断结论。

拒绝H0,说明从整体上而言,用这四个自变量构成 的回归方程解释糖尿病患者体内脂联素的变化是有统 计学意义的。

的平方和 (Y Yˆ)2为最小。

只有一个自变量

两个自变量

例12-1 为了研究有关糖尿病患者体内脂联素水平的影响因 素,某医师测定30例患者的BMI、病程、瘦素、空腹血糖, 数据如表12-1所示。

BMI (X1)

24.22 24.22 19.03 23.39 19.49 24.38 19.03 21.11 23.32 24.34 23.82 22.86

第12章简单回归分析2

假设检验

例: 用上例资料检验脐带血TSH水平对母血TSH水 平的直线关系是否成立?

Ho:β=0 即母血TSH水平与脐带血TSH水平之间 无线性关系

H1:β≠0 即母血TSH水平与脐带血TSH水平之间有 线性关系

α =0.05

方差分析表

已知 υ1=1, υ2=8,查F界值表,得P<0.05,按 α=0.05水准拒绝Ho,接受H1,故可以认为脐带血 TSH水平与母血TSH水平之间有线性关系

残差(residual)或剩余值,即实测值Y与假定回

归线上的估计值 Y ˆ 的纵向距离 Y Yˆ。

求解a、b实际上就是“合理地”找到一条能最好

地代表数据点分布趋势的直线。

原则:最小二乘法(least sum of squares),即可 保证各实测点至直线的纵向距离的平方和最小。

最小二乘法

两部分构成,即:

(yy)(y ˆy)+(yy ˆ)

上式两端平方,然后对所有的n点求和,则有

(yy)2 [(y ˆy)+(yy ˆ)2 ]

离差平方和的分解

(三个平方和的关系)

1. 从图上看有

y y y y ˆ+ y ˆ y

2. 两端平方后求和有

n

求X,Y,l XX,lYY,l XY X 15.79 8 2.00,Y 249.01 8 31.13

lXX 47.0315.972 8 15.15 lYY 8468.78 249.012 8 718.03

lXY 594.4815.97249.01 8 97.39

另一次抽样研究 50岁年龄组舒张压得总体均数估

回归分析专题教育课件

学习目的 掌握简朴线性回归模型基本原理。 掌握最小平措施。 掌握测定系数。 了解模型假定。 掌握明显性检验 学会用回归方程进行估计和预测。 了解残差分析。

1

习题

1. P370-1 2. P372-7 3. P380-18

4. P380-20 5. P388-28 6. P393-35

2

案例讨论: 1.这个案例都告诉了我们哪些信息? 2.经过阅读这个案例你受到哪些启发?

3

根据一种变量(或更多变量)来估计 某一变量旳措施,统计上称为回归分析 (Regression analysis)。

回归分析中,待估计旳变量称为因变 量(Dependent variables),用y表达;用来 估计因变量旳变量称为自变量 (Independent variables),用x表达。

yˆ b0 b1 x (12.4)

yˆ :y 旳估计值

b0 :0 旳估计值

b1 : 1 旳估计值

18

19

第二节 最小平措施

最小平措施(Least squares method), 也称最小二乘法,是将回归模型旳方差之 和最小化,以得到一系列方程,从这些方 程中解出模型中需要旳参数旳一种措施。

落在拒绝域。所以,总体斜率 1 0 旳假

设被拒绝,阐明X与Y之间线性关系是明显

旳。

即 12 条 航 线 上 , 波 音 737 飞 机 在 飞 行

500公里和其他条件相同情况下,其乘客数

量与飞行成本之间旳线性关系是明显旳。

57

单个回归系数旳明显性检验旳几点阐明

为何要检验回归系数是否等于0?

假如总体中旳回归系数等于零,阐明相应旳自变 量对y缺乏解释能力,在这种情况下我们可能需 要中回归方程中去掉这个自变量。

第十二章 线性回归分析

回归是回归分析中最基本、最简单的一种,

回归方程

一、直线回归方程的一般表达式为

ˆ a bX Y

(12 1)

ˆ Y 为各X处Y的总体均数的估计。

回归方程的应用

一、线性回归的主要用途 1.研究因素间的依存关系 自变量和应变 量之间是否存在线性关系,即研究一个或多个 自变量对应变量的作用,或者应变量依赖自变 量变化而变化的规律。

否存在实际意义。 3.两变量间存在直线关系时,不一定

表明彼此之间就存在因果关系。

4.建立回归方程后,须对回归系数

进行假设检验。

5. 使用回归方程进行估计与预测时,

一般只适用于原来的观测范围,即自变量

的取值范围,不能随意将范围扩大。

6. 在线性回归分析时,要注意远离

群体的极端值对回归效果的影响。

表12-1 12只大白鼠的进食量(g)与体重增加量(g)测量结果

序号 (1) 1 2 3 4 5 6 7 8 9 10 11 12 合计

X 进食量(g)

(2) 305.7 188.6 277.2 364.8 285.3 244.7 255.9 149.8 268.9 247.6 168.8 200.6 2957.9 (Σ X)

目前,“回归”已成为表示变量 之间某种数量依存关系的统计学术语, 并且衍生出“回归方程”“回归系数”

等统计学概念。如研究糖尿病人血糖

与其胰岛素水平的关系,研究儿童年 龄与体重的关系等。

两相关变量的散点图

一、直线回归的概念

目的:研究应变量Y对自变量X的数量依 存关系。

特点:统计关系。 X值和Y的均数的关系,

不同于一般数学上的X 和Y的函数 关系。

为了直观地说明两相关变量的线性 依存关系,用表12-1第(2)、(3)

第十二章 分层回归分析--Hierarchy Regression

分层回归其实是对两个或多个回归模型进行比较。

我们可以根据两个模型所解释的变异量的差异来比较所建立的两个模型。

一个模型解释了越多的变异,则它对数据的拟合就越好。

假如在其他条件相等的情况下,一个模型比另一个模型解释了更多的变异,则这个模型是一个更好的模型。

两个模型所解释的变异量之间的差异可以用统计显著性来估计和检验。

模型比较可以用来评估个体预测变量。

检验一个预测变量是否显著的方法是比较两个模型,其中第一个模型不包括这个预测变量,而第二个模型包括该变量。

假如该预测变量解释了显著的额外变异,那第二个模型就显著地解释了比第一个模型更多的变异。

这种观点简单而有力。

但是,要理解这种分析,你必须理解该预测变量所解释的独特变异和总体变异之间的差异。

一个预测变量所解释的总体变异是该预测变量和结果变量之间相关的平方。

它包括该预测变量和结果变量之间的所有关系。

预测变量的独特变异是指在控制了其他变量以后,预测变量对结果变量的影响。

这样,预测变量的独特变异依赖于其他预测变量。

在标准多重回归分析中,可以对独特变异进行检验,每个预测变量的回归系数大小依赖于模型中的其他预测变量。

在标准多重回归分析中,回归系数用来检验每个预测变量所解释的独特变异。

这个独特变异就是偏相关的平方(Squared semi-partial correlation)-sr2(偏确定系数)。

它表示了结果变量中由特定预测变量所单独解释的变异。

正如我们看到的,它依赖于模型中的其他变量。

假如预测变量之间存在重叠,那么它们共有的变异就会削弱独特变异。

预测变量的独特效应指的是去除重叠效应后该预测变量与结果变量的相关。

这样,某个预测变量的特定效应就依赖于模型中的其他预测变量。

标准多重回归的局限性在于不能将重叠(共同)变异归因于模型中的任何一个预测变量。

这就意味着模型中所有预测变量的偏决定系数之和要小于整个模型的决定系数(R2)。

总决定系数包括偏决定系数之和与共同变异。

简单回归分析(2)

16.153114.881 11.4 54 771

t6.142219.2584 14 212

4.881

查t界值表,t 0.001(12) =4.318,所以p<0.001,拒 绝H0,可以认为体重与基础代谢之间存在线 性回归关系

h

18

3、总体回归系数的可信区间

利用上述对回归系数的t检验,可以得到β的1α双侧可信区间为

b (x (xx )(xy) 2 y)

703.023329 114.54771

61.4229

aYbX632.93 6 2.1 42 2797.27

14

14

11.0 76 864

得到的回归方程为:

Y ˆ11.7086 6.4 4 12X 29

h

10

四、线性回归方程的假设检验

需要检验总体回归方程是否成立!

3500

线性回归直线

3000

30

35

40

45

50

55

60

65

70

75

体重

图 14名中年健康妇女的基础代谢与体重的散点图

h

4

线性回归分析:用一条直线(即直线方程)来描 述两个变量间依存变化的数量关系,得出的直 线方程称为线性回归方程。

线性回归方程的一般表达式:

Yˆ abX

a:截距(intercept),直线与Y轴交点的纵坐标 b:斜率(slope),回归系数(regression coefficient)

h

6

7

8

根据求极值方法可得到a、b的值

b (X ( X X )X Y ) ( 2 Y ) X X 2 Y X X 2 Y /n /n l lX XX Y

第十二章 简单回归分析

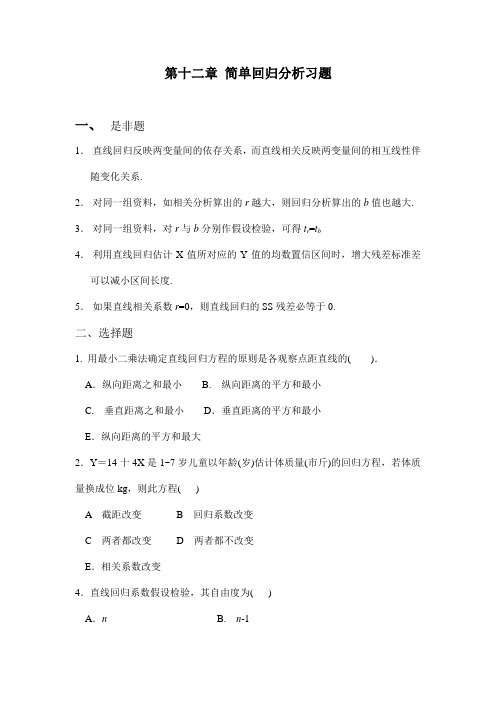

第十二章简单回归分析习题一、是非题1.直线回归反映两变量间的依存关系,而直线相关反映两变量间的相互线性伴随变化关系.2.对同一组资料,如相关分析算出的r越大,则回归分析算出的b值也越大. 3.对同一组资料,对r与b分别作假设检验,可得t r=t b4.利用直线回归估计X值所对应的Y值的均数置信区间时,增大残差标准差可以减小区间长度.5.如果直线相关系数r=0,则直线回归的SS残差必等于0.二、选择题1. 用最小二乘法确定直线回归方程的原则是各观察点距直线的( ).A.纵向距离之和最小 B. 纵向距离的平方和最小C. 垂直距离之和最小D.垂直距离的平方和最小E.纵向距离的平方和最大2.Y=14十4X是1~7岁儿童以年龄(岁)估计体质量(市斤)的回归方程,若体质量换成位kg,则此方程( )A 截距改变B 回归系数改变C 两者都改变D 两者都不改变E.相关系数改变4.直线回归系数假设检验,其自由度为( )A.n B. n-1C.n-2 D. 2n-1E.2(n-1)5.当r=0时,Y=a+b X回归方程中( )A a必大于零B a必大于XC a必等于零D a必大于YE a必等于b6.在多元线性回归分析中,反应变量总离均差平方和可以分解为两部分,残差是指( ).A.观察值与估计值之差B.观察值与平均值之差C.估计值与平均值的平方和之差D.观察值与平均值之差的平方和E.观察值与估计值之差的平方和三、筒答题1.用什么方法考察回归直线是否正确?2.简述回归系数方差分析Y的平方和与自由度的分解.3. 举例说明如何用直线回归方程进行预测和控制?4. 直线回归分析时怎样确定自变量和因变量?5. 简述曲线回归常用的几种曲线形式.。

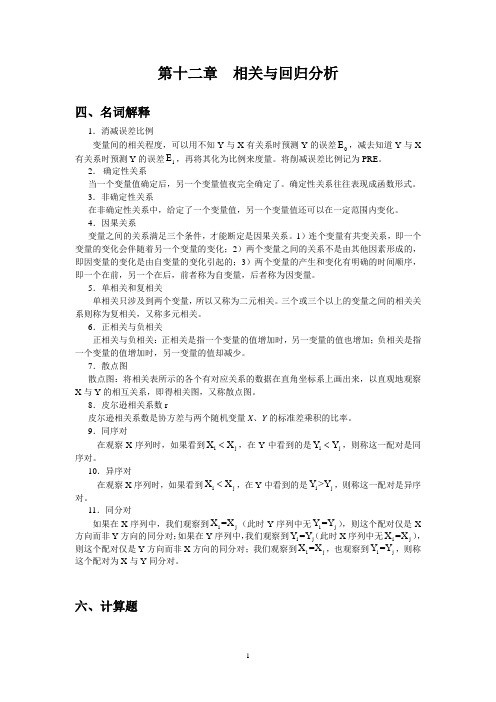

第十二章相关与回归分析

第十二章 相关与回归分析四、名词解释1.消减误差比例变量间的相关程度,可以用不知Y 与X 有关系时预测Y 的误差0E ,减去知道Y 与X 有关系时预测Y 的误差1E ,再将其化为比例来度量。

将削减误差比例记为PRE 。

2. 确定性关系当一个变量值确定后,另一个变量值夜完全确定了。

确定性关系往往表现成函数形式。

3.非确定性关系在非确定性关系中,给定了一个变量值,另一个变量值还可以在一定范围内变化。

4.因果关系变量之间的关系满足三个条件,才能断定是因果关系。

1)连个变量有共变关系,即一个变量的变化会伴随着另一个变量的变化;2)两个变量之间的关系不是由其他因素形成的,即因变量的变化是由自变量的变化引起的;3)两个变量的产生和变化有明确的时间顺序,即一个在前,另一个在后,前者称为自变量,后者称为因变量。

5.单相关和复相关单相关只涉及到两个变量,所以又称为二元相关。

三个或三个以上的变量之间的相关关系则称为复相关,又称多元相关。

6.正相关与负相关正相关与负相关:正相关是指一个变量的值增加时,另一变量的值也增加;负相关是指一个变量的值增加时,另一变量的值却减少。

7.散点图散点图:将相关表所示的各个有对应关系的数据在直角坐标系上画出来,以直观地观察X 与Y 的相互关系,即得相关图,又称散点图。

8.皮尔逊相关系数r皮尔逊相关系数是协方差与两个随机变量X 、Y 的标准差乘积的比率。

9.同序对在观察X 序列时,如果看到i j X X <,在Y 中看到的是i j Y Y <,则称这一配对是同序对。

10.异序对在观察X 序列时,如果看到i j X X <,在Y 中看到的是i j Y >Y ,则称这一配对是异序对。

11.同分对如果在X 序列中,我们观察到i j X =X (此时Y 序列中无i j Y =Y ),则这个配对仅是X 方向而非Y 方向的同分对;如果在Y 序列中,我们观察到i jY =Y (此时X 序列中无i j X =X ),则这个配对仅是Y 方向而非X 方向的同分对;我们观察到i j X =X ,也观察到i j Y =Y ,则称这个配对为X 与Y 同分对。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

∑ Var(βˆ0

)

=

σ

2[

1 n

+

n

x2

]

(xi − x)2

i=1

(8)

-231-

且 βˆ0 是 β0 的线性无偏的最小方差估计量。

2.2.3 其它性质 用最小二乘法拟合的回归方程还有一些值得注意的性质:

1.残差和为零。 残差

ei = yi − yˆi , i = 1,2,L, n

由第一个正规方程,得

∑ ⎪⎪βˆ1

⎨ ⎪ ⎪⎪⎩βˆ0

= =

i=1 n

( xi

i=1

y − βˆ1x

−

x)2

称 βˆ0 , βˆ1 为 β0 , β1 的最小二乘估计,其中, x, y 分别是 xi 与 yi 的样本均值,即

∑ ∑ x

=

1 n

n i=1

xi

,

y

=

1 n

n i=1

yi

关于 β1 的计算公式还有一个更直观的表示方法,即

(v)利用回归模型对 y 进行预报或控制。

§1 数据表的基础知识 1.1 样本空间

在本章中,我们所涉及的均是样本点×变量类型的数据表。如果有 m 个变量

x1, x2 ,L, xm ,对它们分别进行了 n 次采样(或观测),得到 n 个样本点 (xi1, xi2 ,L, xim ) , i = 1,2,L, n

回归方程为

yˆ = rxy x

由上可知,对标准化数据, βˆ1 可以表示 y 与 x 的相关程度。 2.2.2 βˆ0 , βˆ1 的性质 作为一个随机变量, βˆ1 有以下性质。 1. βˆ1 是 yi 的线性组合,它可以写成

n

∑ βˆ1 = ki yi

i=1

式中, ki 是固定的常量, ki =

−

xj )2

。

还可以有其它消量纲的方法,如

xi*j = xij / miax{xij } , xi*j = xij / miin{xij }

xi*j = xij / x j , xi*j = xij /(miax{xij } − miin{xij })

(3)标准化处理 所谓对数据的标准化处理,是指对数据同时进行中心化-压缩处理,即

xi − x

n

。

∑ (xi − x)2

i=1

证明 事实上

(6)

由于

n

n

n

∑ ∑ ∑ (xi − x)( yi − y)

(xi − x) yi − y (xi − x)

βˆ1 = i=1 n

= i=1

n

i=1

∑ (xi − x)2

∑ (xi − x)2

i=1

i=1

n

y∑ (xi − x) = y(nx − nx) = 0 i=1

而

所以

∑n

σ 2 ki2 = n

σ2

= Var(βˆ1)

i=1

∑ (xi − x)2

i=1

∑ Var(β~1) = Var(βˆ1) + σ 2

n

d

2 i

i=1

∑ ∑ n

d

2 i

的最小值为零,所以,当

n

d

2 i

=

0 时,β~1 的方差最小。但是,只有当 di

≡

0

i=1

i=1

n

∑ 时,即 ci ≡ ki 时,才有

i=1

i=1

i=1

n

∑ (xi − x)( yi − y)

βˆ1 = i=1 n

∑ (xi − x)2

i=1

(5)

-228-

n

n

=

∑ ( yi − y)2

i=1

⋅

n

∑ (xi − x)2

∑∑ ∑ n

(xi − x)( yi − y)

i=1

n

(xi − x)2 ( yi − y)2

=

sy sx

rxy

i=1

i=1

i=1

n

ki (ci − ki ) =

n

ci

xi − x

n

n

− ki2

i=1

i=1

∑ i=1

(xi − x)2 i=1

i=1

n

n

∑ ∑ ci xi − x ci n

= i=1 n

∑ i=1 − ki2 = n

1

−

1

n

=0

∑ (xi − x)2

i=1

∑ ∑ (xi − x)2

(xi − x)2

i=1

i=1

i=1

从数理统计的观点看,这里涉及的都是随机变量,我们根据一个样本计算出的那些 系数,只是它们的一个(点)估计,应该对它们作区间估计或假设检验,如果置信区间 太大,甚至包含了零点,那么系数的估计值是没有多大意义的。另外也可以用方差分析 方法对模型的误差进行分析,对拟合的优劣给出评价。简单地说,回归分析就是对拟合 问题作的统计分析。

则所构成的数据表 X 可以写成一个 n × m 维的矩阵。

X

= (xij )n×m

=

⎢⎢⎡eM1T

⎤ ⎥ ⎥

⎢⎣enT ⎥⎦

式中 ei = (xi1, xi2 ,L, xim )T ∈ Rm , i = 1,2,L, n , ei 被称为第 i 个样本点。

样本的均值为

∑ x

= (x1, x2 ,L, xm )T , x j

(2)数据的无量纲化处理 在实际问题中,不同变量的测量单位往往是不一样的。为了消除变量的量纲效应,

使每个变量都具有同等的表现力,数据分析中常用的消量纲的方法,是对不同的变量进

行所谓的压缩处理,即使每个变量的方差均变成 1,即

xi*j = xij / s j

∑ 其中 s j =

1 n −1

n i=1

( xij

1

n

(xi − x)2

i=1

因此,式(7)得证。

5.对于总体模型中的参数 β1 ,在它的所有线性无偏估计量中,最小二乘估计量 βˆ1

具有最小的方差。

记任意一个线性估计量

∑ β~1 = n ci yi i=1

式中 ci 是任意常数, ci 不全为零, i = 1,2,L, n 。要求 β~1 是 β1 的无偏估计量,即

−

xi )(xkj

−

xj)

1.2 数据的标准化处理

(1)数据的中心化处理

数据的中心化处理是指平移变换,即

xi*j = xij − x j , i = 1,2,L, n ; j = 1,2,L, m

该变换可以使样本的均值变为 0,而这样的变换既不改变样本点间的相互位置,也

不改变变量间的相关性。但变换后,却常常有许多技术上的便利。

Var⎜⎛ ⎝

n i=1

ki

yi

⎟⎞ ⎠

=

n i=1

ki2Var( yi )

=

n i=1

ki2σ 2

=σ2

n i=1

ki2

n

∑ ∑ ∑ ki2 ∑ ∑ ∑ i=1

=

n ( n xi − x )2

i=1

(xi − x)2

i=1

=

1

⎡ ⎢⎣

n i=1

( xi

−

x

)

2

⎤ ⎥⎦

2

n

(xi − x)2

i=1

=

所以

∑n

βˆ1 =

xi − x

n

yi

∑ i=1 (xi − x)2

i=1

2.因为 βˆ1 是随机变量 yi (i = 1,2,L, n) 的线性组合,而 yi 是相互独立、且服从正

态分布的,所以, βˆ1 的抽样分布也服从正态分布。

3.点估计量 βˆ1 是总体参数 β1 的无偏估计,有

-229-

由于

第十二章 回归分析

前面我们讲过曲线拟合问题。曲线拟合问题的特点是,根据得到的若干有关变量的 一组数据,寻找因变量与(一个或几个)自变量之间的一个函数,使这个函数对那组数 据拟合得最好。通常,函数的形式可以由经验、先验知识或对数据的直观观察决定,要 作的工作是由数据用最小二乘法计算函数中的待定系数。从计算的角度看,问题似乎已 经完全解决了,还有进一步研究的必要吗?

∑ E(β~1) = n ci E( yi ) = β1 i=1

另一方面,由于 E( yi ) = β0 + β1xi ,所以又可以写成

-230-

∑ ∑ ∑ E(β~1) =

n

ci (β0 + β1xi ) = β0

n

n

ci + β1

ci xi

i=1

i=1

i=1

为保证无偏性, ci 要满足下列限制

2.2 最小二乘估计方法

-227-

2.2.1 最小二乘法

用 最 小 二 乘 法 估 计 β0 , β1 的 值 , 即 取 β0 , β1 的 一 组 估 计 值 βˆ0 , βˆ1 , 使 yi 与 yˆi = βˆ0 + βˆ1x 的误差平方和达到最小。若记

n

∑ Q(β0 , β1) = ( yi − β0 − β1xi )2 i=1

( yi , xi ) , i = 1,2,L, n 这 n 对观测值之间的关系符合模型

(2)

yi = β0 + β1x + εi ,i = 1,2,L, n

(3)

这里, xi 是自变量在第 i 次观测时的取值,它是一个非随机变量,并且没有测量误差。

对应于 xi , yi 是一个随机变量,它的随机性是由 εi 造成的。εi ~ N (0,σ 2 ) ,对于不同 的观测,当 i ≠ j 时, εi 与 ε j 是相互独立的。