TLD分解

lmdi加法分解法

lmdi加法分解法lmdi加法分解法是一种用于解决线性回归问题的统计方法。

它是根据最小二乘法和加法分解的思想发展而来的。

在这篇文章中,我们将详细介绍lmdi加法分解法的原理、步骤和应用。

1. 原理lmdi加法分解法的原理是将线性回归问题分解成多个部分,分别进行建模和分析,最后将这些部分的结果进行加法合并,得到最终的回归模型。

它的基本思想是将自变量拆分成一组分量,每个分量分别对应一个因变量。

通过分别对每个分量进行回归分析,得到各个分量的回归系数,然后将这些分量的回归系数加权合并,得到最终的回归模型。

2. 步骤lmdi加法分解法的步骤如下:步骤一:将原始数据进行加法分解。

将自变量分解成多个分量,每个分量分别对应一个因变量。

分解的原则可以根据实际问题进行选择,一般可以基于变量的相关性、重要性等进行划分。

步骤二:对每个分量进行回归分析。

对每个分量和对应的因变量进行简单线性回归分析,得到各个分量的回归系数。

步骤三:加权合并回归系数。

根据各个分量的重要性或权重,将各个分量的回归系数进行加权合并,得到最终的回归模型。

步骤四:模型评估和验证。

对最终的回归模型进行评估和验证,包括检验回归系数的显著性、模型的拟合优度等。

3. 应用lmdi加法分解法在实际问题中有广泛的应用。

它可以用于解决多变量回归问题,特别适用于自变量之间存在相关性的情况。

它的优点是可以对回归模型进行分解和解释,得到各个分量的回归系数,进而分析各个分量对因变量的影响。

同时,通过加权合并,可以得到整体的回归模型,综合考虑各个分量的影响。

例如,在经济学中,lmdi加法分解法可以用于解释经济增长的影响因素。

将经济增长分解成多个分量,如人口增长、资本积累、技术进步等,然后对每个分量进行回归分析,得到各个分量的回归系数,最终得到整体的经济增长模型。

通过这种方法,可以量化各个因素对经济增长的贡献,并进行政策分析和预测。

总之,lmdi加法分解法是一种用于解决线性回归问题的统计方法,它通过将自变量分解成多个分量,分别进行回归分析,最后将结果进行加权合并,得到最终的回归模型。

TLD算法原理及应用实例

2.3 P-N学习

• P-N学习的主要思想就是检测器的错误能够被 两种类型的约束标识出。 • P-expert的作用是发现目标的新的外观(形 变),并以此来增加正样本的数量,从而使得 检测模块更具鲁棒性。 • N-expert的作用是生成负的训练样本。N-expert 的前提假设是:(被跟踪的)前景目标仅可能 出现在视频帧中的一个位置,因此,如果前景 目标的位置时确定的,那么其周围必然是负样 本。

1 TLD概述

TLD可以解决的问题:

极其复杂的视频,比如跟踪失败的情况经常发 生的视频,目标经常丢失的视频 如果前后的视频帧中没有包含很相关的信息, 比如说目标物体发生了严重形变,检测器的效 果也从不会被弱化 实时运作

1 TLD概述

tra jec tor y

学习 (Learning)

2.3 P-N LEARNING

• 这一部分介绍TLD算法的学习模块,学习模块(learning)通过对视频 的在线处理来提升检测器(detector )的性能。在每一帧里,我们希 望评估当前的检测器,发现它产生的错误(identify its errors),不断 更新检测器以避免将来它再次犯错。PN学习的关键思想是检测器产生 的错误结果可以被“P专家”和“N专家”发现和识别。P专家识别假 的负样本,N专家识别假的正样本。当然P专家和N专家本身也会犯错。 然而,P专家和N专家是相互独立的,它们可以相互弥补对方发生的错 误。P专家发生的错误,N专家纠正,反之亦然。

s ion ect det

fra gm ent s

of

n ini tra gd ata

跟踪 (Tracking)

re-initialization

检测 (Detection)

TLD目标跟踪算法

TLD目标跟踪算法TLD(Track Learning Detection)是一种目标跟踪算法,它结合了目标跟踪和目标检测的方法,能够在复杂环境中跟踪目标并检测目标的丢失。

TLD算法的核心思想是结合在线学习和离线学习的方法,通过检测器(detector)来检测目标,并通过跟踪器(tracker)来跟踪目标。

在在线学习阶段,检测器会进行训练,学习目标的外观特征和形状信息。

而在跟踪阶段,跟踪器会根据检测器的输出来进行目标的跟踪,同时根据跟踪结果反馈给检测器,进行修正。

TLD算法的具体步骤如下:1. 首先,通过一个强分类器进行目标检测。

这个强分类器使用了Haar特征和Adaboost算法进行训练,能够在图像中快速定位目标。

2.检测到目标后,根据目标的位置和尺度信息,将目标裁剪出来作为正样本,并提取其外观特征,包括颜色、纹理等。

3.同时,从目标附近随机选择一些负样本,并提取其外观特征。

这些负样本一般是与目标外观相似的背景区域。

4. 然后,使用一个在线集成学习器(Online Ensemble Learning)来学习目标的外观特征。

这个学习器使用了随机决策的方法,通过多个弱分类器的投票来进行目标的分类。

5.在跟踪阶段,通过跟踪器来进行目标的跟踪。

跟踪器使用了一个模板,通过计算目标与模板的相似度来判断目标的位置。

6.如果跟踪器发生目标丢失,即目标与模板的相似度低于一个阈值,那么就需要重新进行目标检测。

7.在进行目标检测时,使用之前训练得到的检测器,来对图像进行目标检测。

同时,根据跟踪器的输出结果,对检测器进行修正,从而提高检测的准确率。

TLD算法的优点是能够在复杂环境中进行目标跟踪,并且能够适应目标的外观变化。

它通过结合目标检测和目标跟踪的方法,能够在目标丢失时及时进行目标检测,从而提高了跟踪的准确率和稳定性。

然而,TLD算法也有一些缺点。

首先,由于在跟踪阶段是基于目标检测结果来进行跟踪的,所以在目标遮挡或者快速移动时容易出现跟踪失败。

杜立特尔三角分解法

杜立特尔三角分解法杜立特尔三角分解法- 全面评估、深度探讨与个人观点解读1. 引言杜立特尔三角分解法是线性代数中一种重要的数值方法,用于解决线性方程组。

它的广泛应用于科学计算、工程学和金融建模等领域中,具有高精度、快速稳定的特点。

本文将对杜立特尔三角分解法进行全面评估、深度探讨,并分享个人对该方法的理解与观点。

2. 杜立特尔三角分解法的基本原理杜立特尔三角分解法是一种将矩阵分解为下三角矩阵和上三角矩阵之乘积的方法。

它的基本原理是通过高斯消元法将线性方程组转化为上三角矩阵的形式,再通过前向、后向代替求解出线性方程组的解。

3. 杜立特尔三角分解法的步骤3.1 高斯消元法在杜立特尔三角分解法中,首先需要使用高斯消元法将线性方程组转化为上三角矩阵的形式。

高斯消元法通过消元和回代的操作,将方程组变换为上三角矩阵形式,即将主元以下的元素全部消为0。

3.2 前向代替在杜立特尔三角分解法的前向代替步骤中,从上到下,逐行将下三角矩阵的元素表示为主线元素与其他元素的线性组合,以求得下三角矩阵L。

3.3 后向代替在杜立特尔三角分解法的后向代替步骤中,从下到上,逐行将上三角矩阵的元素表示为主线元素与其他元素的线性组合,以求得上三角矩阵U。

3.4 解线性方程组通过前向代替和后向代替的步骤,我们可以求解出上三角矩阵和下三角矩阵。

我们可以通过反向代替的方式,将线性方程组表示为矩阵形式进行求解,即解出线性方程组的解向量。

4. 杜立特尔三角分解法的优势与应用杜立特尔三角分解法相较于其他解线性方程组的方法,具有以下优势: - 高精度:杜立特尔三角分解法在求解线性方程组时能够提供高精度的解。

- 快速稳定:该方法的时间复杂度较低,求解效率高,且对数值误差具有较高的容忍度。

4.1 科学计算应用杜立特尔三角分解法在科学计算领域中应用广泛,特别是在数值模拟和计算物理学等领域。

它可以在矩阵形式下求解微分方程、计算特征值和特征向量等。

4.2 工程学应用在工程学中,杜立特尔三角分解法常用于求解稀疏矩阵的线性方程组。

微分方程解的结构总结

微分方程解的结构总结微分方程是数学中重要的一门分支,它在物理学、工程学、经济学等领域中有着广泛的应用。

解微分方程的过程可以总结为以下几个结构。

1. 初值问题的解析解:对于一些简单的微分方程,我们可以通过一些数学方法求得其解析解。

例如,一阶线性常微分方程和二阶常系数齐次线性微分方程等。

这些解析解通常是一些基本函数的组合形式,如指数函数、三角函数等。

通过求解初值问题,我们可以得到具体的解。

2. 数值解的求解:对于一些复杂的微分方程,往往很难找到其解析解。

这时我们可以利用数值方法求解微分方程。

常见的数值方法包括欧拉法、龙格-库塔法(RK方法)等。

通过离散化微分方程,我们可以得到一系列近似解。

这些数值解可以通过计算机程序实现,对于一些无法使用解析解求解的问题提供了有效的工具。

3. 特解和通解的求解:对于一些非齐次线性微分方程,我们可以通过特解和通解的方法求解。

特解是非齐次项的一个特殊解,而通解则是齐次方程的解和特解的线性组合。

通过求解特解和通解,我们可以得到微分方程的所有解。

4. 线性微分方程的叠加原理:对于一些复杂的微分方程,我们可以将其分解为一系列简单的微分方程的叠加。

这是因为线性微分方程具有叠加原理,即线性微分方程的解可以通过每个分量的解的线性组合得到。

这种叠加原理使得我们可以将复杂的微分方程简化为一系列简单的微分方程的求解。

5. 边界值问题的求解:除了初值问题,还有一类微分方程称为边界值问题。

边界值问题是在给定的边界条件下求解微分方程的解。

这些边界条件可以是函数值在一些点上的给定,也可以是函数的导数在一些点上的给定。

对于边界值问题,我们通常使用分离变量法、变分法等方法求解。

通过以上几个结构,我们可以解决许多实际问题。

微分方程作为数学的一个重要分支,不仅有着丰富的理论基础,而且在实际应用中具有广泛的应用价值。

无论是物理学中的运动学问题、电路中的电流电压问题,还是经济学中的增长模型,都可以通过微分方程来描述和求解。

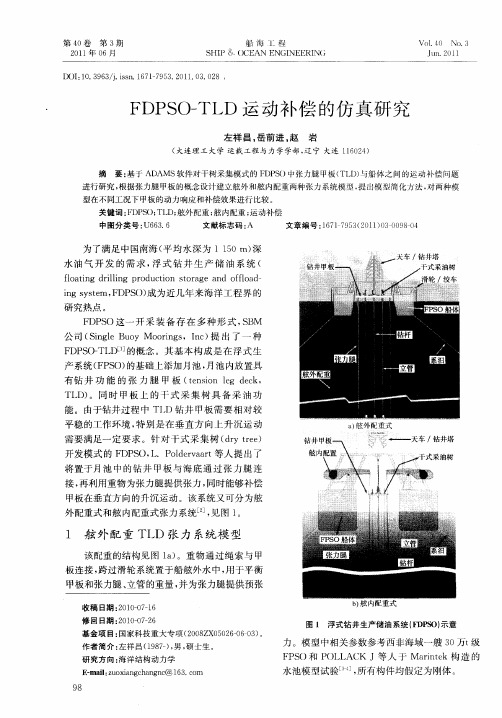

FDPSO-TLD运动补偿的仿真研究

岩

1 1 模 型简 化 .

惩 罚参 数施 加 了单 面 约束 , 回归 系数 决 定 接 触 时的 能量损 失 ; ②基 于 碰 撞 函数 的接 触 算法 (M— I

P T— n t nb s dcn at , 模 型 采 用 基 于 AC f ci - ae o tc) 本 u o 碰 撞 函数 的三 维接触 算 法 。

甲板 的下端 通 过 张 力腿 将 其 连 接 于 海 底 , 当 只考 虑升 沉效 果 时 , 以将 张力 腿 ( 管 ) 可 立 简化 为

杆件 与地 面用 弹 簧 连 接 , 簧 刚 度 与 张 力腿 刚度 弹 相 同 。这 样 , 变形 部分 完全 由弹簧伸 长量 来表 示 。 使用 弹簧 质点 模 型模拟 线 或绳 子必 须使 用小 质量 质点 和 高 弹性 刚度 的弹 簧 i 。在 本模 型 中 ,

fo t g d i i g p o u t n s o a e a d o fo d l a i rl n r d c i t r g n fl a — n l o

igs se F P () 为近几 年 来海 洋 工程 界 的 n ytm, D S )成 研 究热点 。

F S DP O这 一 开 采 装 备 存 在 多 种 形 式 ,B S M

公 司 ( ige B o o ig ,I c 提 出 了一 种 Sn l u y Mo r s n ) n

F P O— D 的概 念 。其 基 本 构成 是 在 浮 式 生 D S TL E

产系统 ( P O) F S 的基 础上 添加月 池 , 池 内放置 具 月 有 钻 井 功 能 的 张 力 腿 甲 板 (e s n l ek tn i e d c , o g T 。 同 时 甲板 上 的 干 式 采 集 树 具 备 采 油 功 I D) 能 。由于钻 井过 程 中 TI 钻井 甲板 需 要 相对 较 D

乳糖酶介绍PPT课件

• Colief® Infant Drops are added to the baby’s usual milk, whether it is formula or breast milk.

是一种婴儿滴剂,添加到婴儿的乳品(母乳或配方奶)中服用。

• Colief® contains: Glycerol, water and lactase enzyme.

奶类(乳品,或乳制品)中含有一种特有的碳水化合物,叫做乳糖。乳糖须经由人 体小肠内的乳糖酶( β-半乳糖苷酶)水解为单糖后消化吸收,乳糖对于人类正常的 生长发育起着重要作用。

当人体内缺乏足够多的乳糖酶时,乳品或乳制品中的乳糖不能在小肠消化和吸收

而直接进入大肠,在大肠菌丛的作用下引起发酵、水解从而出现一系列症状如腹胀、 肠鸣、气多、或腹泻等,称为乳糖不耐受。

成分是:甘油、水和乳糖酶。

• Active ingredient is lactase, an enzyme which occurs naturally within the small intestine.

活性成分是乳糖酶,一种可以在人体小肠中自然生成的酶。

• Colief® reduces the lactose (milk sugar) content.

我们认为,乳糖不耐受不是一种病!

And,

such LACTOSE INTOLERANCE might be temporary !

这样的乳糖不耐受可能只是阶段性的!

第6页/共26页

3 TEMPORARY LACTASE DEFICIENCY 阶段性乳糖酶缺乏

• Temporary Lactase Deficiency (TLD) occurs when a baby is not producing

TLD目标跟踪算法

Zdenek Kalal

一、TLD算法简介

长时间跟踪的一个关键的问题:

目标重新出现

重新检测

重新跟踪

TLD与传统跟踪算法的显著区别:

将传统的跟踪算法和传统的检测算法相结合,来解决被跟踪目标在被跟踪过程中发生的形变、部分遮挡、消失等问题。同时,通过一种改进的在线学习机制不断更新检测模块的目标模型及相关参数,从而使得跟踪效果更加稳定、鲁棒、可靠。

P-N experts 的产生样本的例子:

目标是下面深色的车黑色框是检测器检测到的正样本黄色框是跟踪器产生的正样本红星标记的是每一帧最后的跟踪结果跟踪器代表产生正样本的P专家

在第t帧,检测器没有发现深色车,P专家认为深色车是正样本,N专家经过比较,认为深色车的样本更可信,所以把浅色车输出为负样本。

Z. Kalal, K. Mikolajczyk, and J. Matas, “Tracking-Learning-Detection,” Pattern Analysis and Machine Intelligence 2011.Z. Kalal, K. Mikolajczyk, and J. Matas, “Face-TLD: Tracking-Learning-Detection Applied to Faces,”International Conference on Image Processing, 2010. Z. Kalal, K. Mikolajczyk, and J. Matas, “Forward-Backward Error: Automatic Detection of Tracking Failures,” International Conference on Pattern Recognition, 2010, pp. 23-26. Z. Kalal, J. Matas, and K. Mikolajczyk, “P-N Learning: Bootstrapping Binary Classifiers by Structural Constraints,” Conference on Computer Vision and Pattern Recognition, 2010.

ldlt分解法求解方程组

ldlt分解法求解方程组概述:ldlt分解法是一种常用的线性方程组求解法,通过将方程组的系数矩阵进行分解,将原问题转化为两个简化的子问题,从而提高求解效率。

算法步骤:1. 输入方程组的系数矩阵A和右侧常数向量b。

2. 对系数矩阵A进行ldlt分解,得到L矩阵和D矩阵。

3. 解Ly=b的方程组,得到中间变量向量y。

4. 解Dz=y的方程组,得到中间变量向量z。

5. 解Lt*x=z的方程组,得到最终解向量x。

步骤解析:1. 输入方程组的系数矩阵A和右侧常数向量b。

将方程组表示为Ax=b的形式,其中A是一个n×n的系数矩阵,b是一个n×1的右侧常数向量。

2. 进行ldlt分解。

ldlt分解将系数矩阵A分解为L矩阵、D矩阵和L转置矩阵的乘积,即A=L×D×Lt。

L是一个n×n的下三角矩阵,D是一个n×n的对角矩阵。

分解的过程中,需要判断系数矩阵A是否可分解成L×D×Lt,若不可分解,则无解。

在ldlt分解过程中,要保证分解后的矩阵L非奇异(即行列式不为0),而D矩阵的对角线元素必须非零。

如果系数矩阵A满足条件,进行ldlt分解。

3. 解Ly=b的方程组。

将方程组表示为Ly=b的形式,其中L是一个下三角矩阵。

通过前向代入法(或称为前代法),从上到下依次求解y的每个分量。

具体求解的步骤是:首先令y1=b1/L11,然后用y1代入到第2个方程中,求解y2=y2/L22,以此类推,直到求解yn。

4. 解Dz=y的方程组。

将方程组表示为Dz=y的形式,其中D是一个对角矩阵。

由于D是对角矩阵,因此可以通过逐个分量的乘法逆运算求解z的每个分量。

具体求解的步骤是:首先令z1=y1/D11,然后用z1代入到第2个方程中,求解z2=y2/D22,以此类推,直到求解zn。

5. 解Lt*x=z的方程组。

将方程组表示为Lt*x=z的形式,其中Lt是L的转置矩阵。

杜立特尔三角分解法

杜立特尔三角分解法摘要:1.杜立特尔三角分解法简介2.杜立特尔三角分解法的原理3.杜立特尔三角分解法的应用实例4.杜立特尔三角分解法的优缺点5.杜立特尔三角分解法在我国的发展现状和前景正文:一、杜立特尔三角分解法简介杜立特尔三角分解法,是一种将复数分解为三角形式的方法,由美国数学家杜立特尔(Charles W.Trigg)于20 世纪初提出。

该方法主要应用于复数的解析、函数的解析以及微分方程的解等方面,为复分析提供了一种有效的工具。

二、杜立特尔三角分解法的原理杜立特尔三角分解法的基本原理是将复数表示为一个三角形的三个顶点的坐标,这三个顶点分别是原点、复数在实轴上的投影点和复数在虚轴上的投影点。

通过这种方式,可以将复数的模长、幅角和相位等参数直观地展现出来,从而方便进行分析和计算。

三、杜立特尔三角分解法的应用实例1.在复分析中的应用:通过杜立特尔三角分解法,可以将复数的乘积、除法、幂运算等简化为三角形的运算,从而简化复分析的计算过程。

2.在微分方程中的应用:利用杜立特尔三角分解法可以将某些微分方程转化为三角方程,从而求解微分方程。

3.在信号处理中的应用:在信号处理领域,杜立特尔三角分解法可以用于分析信号的频谱,从而对信号进行滤波等处理。

四、杜立特尔三角分解法的优缺点优点:1.直观地展现复数的参数,便于分析和计算。

2.可以简化复分析和微分方程的计算过程。

缺点:1.某些情况下,计算过程可能较为繁琐。

2.对于非纯虚数的情况,其三角分解可能不唯一。

五、杜立特尔三角分解法在我国的发展现状和前景在我国,杜立特尔三角分解法在复分析、信号处理等领域已经得到广泛应用。

随着科学技术的不断发展,该方法在各个领域的应用将更加广泛,为我国的科技发展做出更大的贡献。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

从main()函数切入,分析整个TLD运行过程如下:(这里只是分析工作过程,全部注释的代码见博客的更新)1、分析程序运行的命令行参数;./run_tld -p ../parameters.yml -s ../datasets/06_car/car.mpg -b ../datasets/06_car/init.txt –r2、读入初始化参数(程序中变量)的文件parameters.yml;3、通过文件或者用户鼠标框选的方式指定要跟踪的目标的Bounding Box;4、用上面得到的包含要跟踪目标的Bounding Box和第一帧图像去初始化TLD系统,tld.init(last_gray, box, bb_file); 初始化包含的工作如下:4.1、buildGrid(frame1, box);检测器采用扫描窗口的策略:扫描窗口步长为宽高的10%,尺度缩放系数为1.2;此函数构建全部的扫描窗口grid,并计算每一个扫描窗口与输入的目标box的重叠度;重叠度定义为两个box的交集与它们的并集的比;4.2、为各种变量或者容器分配内存空间;4.3、getOverlappingBoxes(box, num_closest_init);此函数根据传入的box(目标边界框),在整帧图像中的全部扫描窗口中(由上面4.1得到)寻找与该box距离最小(即最相似,重叠度最大)的num_closest_init(10)个窗口,然后把这些窗口归入good_boxes容器。

同时,把重叠度小于0.2的,归入bad_boxes容器;相当于对全部的扫描窗口进行筛选。

并通过BBhull函数得到这些扫描窗口的最大边界。

4.5、classifier.prepare(scales);准备分类器,scales容器里是所有扫描窗口的尺度,由上面的buildGrid()函数初始化;TLD的分类器有三部分:方差分类器模块、集合分类器模块和最近邻分类器模块;这三个分类器是级联的,每一个扫描窗口依次全部通过上面三个分类器,才被认为含有前景目标。

这里prepare这个函数主要是初始化集合分类器模块;集合分类器(随机森林)基于n个基本分类器(共10棵树),每个分类器(树)都是基于一个pixel comparisons(共13个像素比较集)的,也就是说每棵树有13个判断节点(组成一个pixel comparisons),输入的图像片与每一个判断节点(相应像素点)进行比较,产生0或者1,然后将这13个0或者1连成一个13位的二进制码x(有2^13种可能),每一个x对应一个后验概率P(y|x)= #p/(#p+#n) (也有2^13种可能),#p 和#n分别是正和负图像片的数目。

那么整一个集合分类器(共10个基本分类器)就有10个后验概率了,将10个后验概率进行平均,如果大于阈值(一开始设经验值0.65,后面再训练优化)的话,就认为该图像片含有前景目标;后验概率P(y|x)= #p/(#p+#n)的产生方法:初始化时,每个后验概率都得初始化为0;运行时候以下面方式更新:将已知类别标签的样本(训练样本)通过n个分类器进行分类,如果分类结果错误,那么相应的#p和#n 就会更新,这样P(y|x)也相应更新了。

pixel comparisons的产生方法:先用一个归一化的patch去离散化像素空间,产生所有可能的垂直和水平的pixel comparisons,然后我们把这些pixel comparisons随机分配给n个分类器,每个分类器得到完全不同的pixel comparisons(特征集合),这样,所有分类器的特征组统一起来就可以覆盖整个patch了。

特征是相对于一种尺度的矩形框而言的,TLD中第s种尺度的第i个特征features[s][i] = Feature(x1, y1, x2, y2);是两个随机分配的像素点坐标(就是由这两个像素点比较得到0或者1的)。

每一种尺度的扫描窗口都含有totalFeatures = nstructs * structSize个特征;nstructs为树木(由一个特征组构建,每组特征代表图像块的不同视图表示)的个数;structSize为每棵树的特征个数,也即每棵树的判断节点个数;树上每一个特征都作为一个决策节点;prepare函数的工作就是先给每一个扫描窗口初始化了对应的pixel comparisons(两个随机分配的像素点坐标);然后初始化后验概率为0;4.6、generatePositiveData(frame1, num_warps_init);此函数通过对第一帧图像的目标框box(用户指定的要跟踪的目标)进行仿射变换来合成训练初始分类器的正样本集。

具体方法如下:先在距离初始的目标框最近的扫描窗口内选择10个bounding box(已经由上面的getOverlappingBoxes函数得到,存于good_boxes里面了,还记得不?),然后在每个bounding box的内部,进行±1%范围的偏移,±1%范围的尺度变化,±10%范围的平面内旋转,并且在每个像素上增加方差为5的高斯噪声(确切的大小是在指定的范围内随机选择的),那么每个box都进行20次这种几何变换,那么10个box将产生200个仿射变换的bounding box,作为正样本。

具体实现如下:getPattern(frame(best_box), pEx, mean, stdev);此函数将frame图像best_box区域的图像片归一化为均值为0的15*15大小的patch,存于pEx(用于最近邻分类器的正样本)正样本中(最近邻的box的Pattern),该正样本只有一个。

generator(frame, pt, warped, bbhull.size(), rng);此函数属于PatchGenerator类的构造函数,用来对图像区域进行仿射变换,先RNG 一个随机因子,再调用()运算符产生一个变换后的正样本。

classifier.getFeatures(patch, grid[idx].sidx, fern);函数得到输入的patch 的特征fern(13位的二进制代码);pX.push_back(make_pair(fern, 1)); //positive ferns <features, labels=1>然后标记为正样本,存入pX(用于集合分类器的正样本)正样本库;以上的操作会循环num_warps * good_boxes.size()即20 * 10 次,这样,pEx就有了一个正样本,而pX有了200个正样本了;4.7、meanStdDev(frame1(best_box), mean, stdev);统计best_box的均值和标准差,var = pow(stdev.val[0],2) * 0.5;作为方差分类器的阈值。

4.8、generateNegativeData(frame1);由于TLD仅跟踪一个目标,所以我们确定了目标框了,故除目标框外的其他图像都是负样本,无需仿射变换;具体实现如下:由于之前重叠度小于0.2的,都归入bad_boxes了,所以数量挺多,把方差大于var*0.5f的bad_boxes都加入负样本,同上面一样,需要classifier.getFeatures(patch, grid[idx].sidx, fern);和nX.push_back(make_pair(fern, 0));得到对应的fern特征和标签的nX负样本(用于集合分类器的负样本);然后随机在上面的bad_boxes中取bad_patches(100个)个box,然后用getPattern函数将frame图像bad_box区域的图像片归一化到15*15大小的patch,存在nEx(用于最近邻分类器的负样本)负样本中。

这样nEx和nX都有负样本了;(box的方差通过积分图像计算)4.9、然后将nEx的一半作为训练集nEx,另一半作为测试集nExT;同样,nX也拆分为训练集nX和测试集nXT;4.10、将负样本nX和正样本pX合并到ferns_data[]中,用于集合分类器的训练;4.11、将上面得到的一个正样本pEx和nEx合并到nn_data[]中,用于最近邻分类器的训练;4.12、用上面的样本训练集训练集合分类器(森林)和最近邻分类器:classifier.trainF(ferns_data, 2); //bootstrap = 2对每一个样本ferns_data[i] ,如果样本是正样本标签,先用measure_forest函数返回该样本所有树的所有特征值对应的后验概率累加值,该累加值如果小于正样本阈值(0.6* nstructs,这就表示平均值需要大于0.6(0.6* nstructs / nstructs),0.6是程序初始化时定的集合分类器的阈值,为经验值,后面会用测试集来评估修改,找到最优),也就是输入的是正样本,却被分类成负样本了,出现了分类错误,所以就把该样本添加到正样本库,同时用update函数更新后验概率。

对于负样本,同样,如果出现负样本分类错误,就添加到负样本库。

classifier.trainNN(nn_data);对每一个样本nn_data,如果标签是正样本,通过NNConf(nn_examples[i], isin, conf, dummy);计算输入图像片与在线模型之间的相关相似度conf,如果相关相似度小于0.65 ,则认为其不含有前景目标,也就是分类错误了;这时候就把它加到正样本库。

然后就通过pEx.push_back(nn_examples[i]);将该样本添加到pEx正样本库中;同样,如果出现负样本分类错误,就添加到负样本库。

4.13、用测试集在上面得到的集合分类器(森林)和最近邻分类器中分类,评价并修改得到最好的分类器阈值。

classifier.evaluateTh(nXT, nExT);对集合分类器,对每一个测试集nXT,所有基本分类器的后验概率的平均值如果大于thr_fern(0.6),则认为含有前景目标,然后取最大的平均值(大于thr_fern)作为该集合分类器的新的阈值。

对最近邻分类器,对每一个测试集nExT,最大相关相似度如果大于nn_fern(0.65),则认为含有前景目标,然后取最大的最大相关相似度(大于nn_fern)作为该最近邻分类器的新的阈值。

5、进入一个循环:读入新的一帧,然后转换为灰度图像,然后再处理每一帧processFrame;6、processFrame(last_gray, current_gray, pts1, pts2, pbox, status, tl, bb_file);逐帧读入图片序列,进行算法处理。