从线性分类器到人工神经网络

人工神经网络方法

人工神经网络方法人工神经网络是一种类似于生物神经系统的计算模型,它由多个节点(神经元)和连接这些节点之间的权重组成。

这些节点和连接可以模拟人类大脑的工作原理,从而实现复杂的计算任务。

以下是人工神经网络常用的几种方法:1.前馈神经网络(Feedforward neural network)前馈神经网络是最常用的神经网络类型之一,它的数据流仅向前流动,没有回流。

该网络由多个层组成,其中输入层接受数据,输出层产生输出,中间层包含多个带有权重的神经元。

每个神经元的输出都可以通过权重连接到下一层神经元的输入。

通过调整权重,前馈神经网络可以进行监督学习,用于分类或回归问题。

2.循环神经网络(Recurrent neural network)循环神经网络是一种形式化的神经网络,它可以对序列数据进行处理,如语音识别、自然语言处理等。

循环神经网络的节点之间可以相互连接,形成一个循环,输入数据会在整个网络中进行传递和加工,输出也会受到之前状态的影响。

循环神经网络还可以使用长短时记忆(LSTM)单元或门控循环单元(GRU)单元来处理长序列数据。

3.卷积神经网络(Convolutional neural network)卷积神经网络是一种针对图像识别和视觉处理任务的神经网络。

它由多个卷积层、池化层和全连接层组成。

在输入层之后的每一层都是由若干个卷积核组成的,并对输入数据进行卷积处理。

卷积操作可以有效地提取图像特征,池化层可以对输出信号进行降采样处理。

通过卷积和池化操作,卷积神经网络可以自动学习特征,并具有很高的图像识别准确率。

4.自编码器(Autoencoder)自编码器是一种非监督学习方法,它可以有效地进行数据的压缩和重建。

自编码器通过输入数据,将其表示为低维的潜在表示,然后通过解码器将其转换回原始维度。

自编码器主要由编码器和解码器组成。

编码器将输入数据转换成低维度的潜在表示,解码器将潜在表示转换成原始数据。

在训练过程中,自编码器可以调整权重和偏置,以最小化重建误差。

logit替代方法

logit替代方法逻辑斯蒂回归(Logistic Regression)是一种二分类的机器学习算法,主要用于预测一个事物属于其中一类的概率。

在一些情况下,我们可能需要找到替代Logit回归的方法。

下面将介绍几种常见的替代方法。

1. 线性判别分析(Linear Discriminant Analysis)线性判别分析是一种经典的分类方法,它试图找到一个线性判别函数,能够最大程度地将不同类别的样本分开。

和Logit回归一样,线性判别分析也是基于线性预测函数的。

它的一个优点是,当类别分布假设满足时,它可以通过最小化类别内离散度和最大化类别间距离的方式,得到一个最优的线性判别函数。

2. 支持向量机(Support Vector Machine)支持向量机是一种强大的分类器,它试图找到一个最优的超平面,将不同类别的样本分开。

支持向量机可以通过选择合适的核函数,将数据从低维映射到高维空间,从而使得在高维空间中是线性可分的。

相比Logit回归,支持向量机不仅可以处理线性可分的情况,还可以处理非线性可分的情况。

3. 决策树(Decision Tree)决策树是一种基于树结构的分类器,它通过一系列的二分判定,将样本逐步分成不同的类别。

决策树具有可解释性强的优点,它可以通过分支节点的判定条件,直观地解释分类的原因。

相对于Logit回归,决策树对于非线性关系的建模能力更强。

4. 随机森林(Random Forest)随机森林是基于决策树的一种集成学习方法,它通过构建多个决策树,并对它们的结果进行整合,从而提高了分类的准确性和鲁棒性。

相比于单个决策树,随机森林能够处理更复杂的分类问题,并且具有良好的抗噪能力。

5. 神经网络(Neural Network)神经网络是一种强大的机器学习模型,它模拟了生物神经元之间的连接和信息传递过程。

神经网络通过多个神经元层之间的连接,将输入映射到输出。

相比Logit回归,神经网络能够建模更复杂的非线性关系,并且具有更好的泛化能力。

机器学习的基本认识

机器学习的基本认识机器学习(Machine Learning,ML)是一种通过计算机程序进行无需明确编程的人工智能(Artificial Intelligence,AI)学习的方法。

它通过对大量数据进行分析和处理,从中学习规律和模式,以便做出预测和决策。

机器学习已经成为现代科学和技术研究的重要领域,广泛应用于图像和语音识别、自然语言处理、推荐系统等诸多领域。

机器学习的基本原理是利用统计学和优化理论的方法,通过对样本数据的学习来推断输入和输出之间的关系,并将学习到的模型用于未知数据的预测和分类。

其中,输入数据称为特征,输出数据称为标签或目标变量。

在机器学习中,我们常用的任务可以分为监督学习、无监督学习和强化学习。

监督学习(Supervised Learning)是指在训练样本中,除了输入特征外,还给出了对应的标签或目标变量,如分类和回归问题。

分类问题是指将输入样本分为预先定义的类别,如垃圾邮件识别和图像分类;而回归问题则是建立输入和输出之间的连续关系,如房价预测和股票价格预测。

无监督学习(Unsupervised Learning)与监督学习相反,它只给出输入数据的特征,没有给出输出数据的标签或目标变量。

无监督学习主要用于聚类和降维。

聚类是一种将样本划分到不同组别的方法,如市场用户分群、图像分割和推荐系统;降维则是减少数据特征维度的方法,以便更好地可视化和理解数据。

强化学习(Reinforcement Learning)是指智能体通过与环境进行交互,根据环境的反馈调整自己的行为以获得最大化的奖励。

强化学习常用于游戏策略、机器人控制和搜索优化等领域。

其中,智能体通过学习、规划和执行三个步骤来梳理与环境的交互。

机器学习的方法有很多,其中最常用的方法包括决策树、逻辑回归、支持向量机、人工神经网络和集成学习等。

决策树是一种根据特征逐步判断目标变量的方法;逻辑回归是一种线性分类方法,用于解决二分类问题;支持向量机则是非线性分类的方法,它通过引入核函数将数据映射到高维空间,以便更好地分割不同类别;人工神经网络则是一种模拟大脑神经元的计算模型,通过多个神经元的相互连接来实现复杂的模式识别。

《人工神经网络》课件

拟牛顿法

改进牛顿法的不足,使用正定矩阵近 似Hessian矩阵,提高优化效率。

共轭梯度法

结合梯度下降法和共轭方向的思想, 在每一步迭代中选择合适的共轭方向 进行搜索。

遗传算法

模拟生物进化过程的优化算法,通过 选择、交叉、变异等操作寻找最优解 。

正则化技术

L1正则化

对权重参数的绝对值进行惩罚总结词

自然语言处理是利用人工神经网络对自然语言文本进行分析和处理的技术。

详细描述

自然语言处理是实现人机文本交互的关键技术之一,通过训练神经网络对大量文本数据进 行学习,可以实现对文本的自动分类、情感分析、机器翻译等功能。

具体应用

在社交媒体领域,自然语言处理技术可以用于情感分析和舆情监控;在新闻媒体领域,可 以用于新闻分类和摘要生成;在机器翻译领域,可以用于实现多语言之间的自动翻译。

06

人工神经网络的未 来展望

新型神经网络模型的研究

持续探索新型神经网络模型

随着技术的不断发展,新型神经网络模型的研究将不断涌现,以解决传统模型无法处理 的复杂问题。这些新型模型可能包括更复杂的拓扑结构、更高效的参数优化方法等。

结合领域知识进行模型设计

未来的神经网络模型将更加注重与领域知识的结合,以提高模型的针对性和实用性。例 如,在医疗领域,结合医学影像和病理学知识的神经网络模型能够更准确地辅助医生进

THANKS

感谢您的观看

文字、人脸等目标的技术。

02 03

详细描述

图像识别是人工神经网络应用的重要领域之一,通过训练神经网络对大 量图像数据进行学习,可以实现对图像的自动分类、目标检测、人脸识 别等功能。

具体应用

在安防领域,图像识别技术可以用于人脸识别和视频监控;在医疗领域 ,可以用于医学影像分析;在电商领域,可以用于商品图片的自动分类 和检索。

神经网络控制基础人工神经网络课件ppt课件

其他工业领域应用案例

电力系统

神经网络控制可以应用于电力系统的负荷预测、故障诊断和稳定性 分析等方面,提高电力系统的运行效率和安全性。

化工过程控制

神经网络控制可以对化工过程中的各种参数进行实时监测和调整, 确保生产过程的稳定性和产品质量。

航空航天

神经网络控制在航空航天领域的应用包括飞行器的姿态控制、导航控 制和故障诊断等,提高飞行器的安全性和性能。

05 神经网络控制性能评估与优化

性能评估指标及方法

均方误差(MSE)

衡量神经网络输出与真实值之间的误差,值越小表示性能越好。

准确率(Accuracy)

分类问题中正确分类的样本占总样本的比例,值越高表示性能越好。

交叉验证(Cross-Validation)

将数据集分成多份,轮流作为测试集和训练集来评估模型性能。

强化学习在神经网络控制中应用

强化学习原理

通过与环境进行交互并根据反馈信号进行学习的方法,使神经网络能够自主学习 到最优控制策略。

强化学习算法

包括Q-learning、策略梯度等算法,用于求解神经网络控制中的优化问题,实现 自适应控制。

04 神经网络控制系统设计与实现

系统需求分析

功能性需求

明确系统需要实现的功能,如 数据输入、处理、输出等。

非监督学习

无需已知输出数据,通过挖掘输入数 据中的内在结构和特征进行学习,常 用于聚类、降维等任务。

深度学习在神经网络控制中应用

深度学习模型

通过构建深层神经网络模型,实现对复杂非线性系统的建模与控制,提高控制 精度和性能。

深度学习优化算法

采用梯度下降等优化算法对深度学习模型进行训练,提高训练效率和模型泛化 能力。

《人工神经网络:模型、算法及应用》习题参考答案

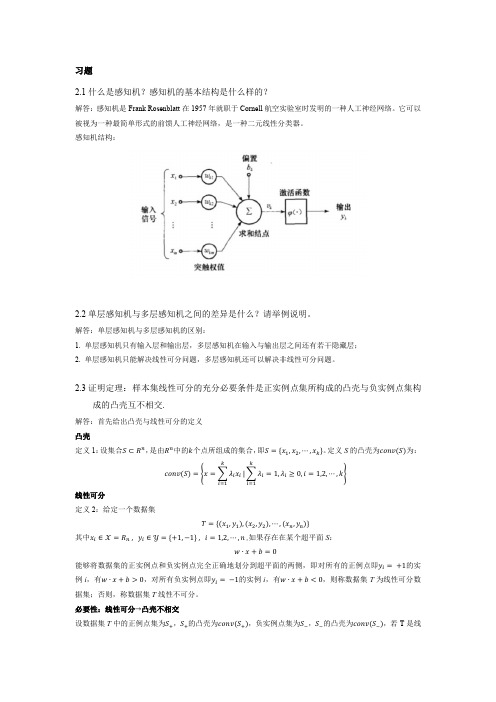

习题2.1什么是感知机?感知机的基本结构是什么样的?解答:感知机是Frank Rosenblatt在1957年就职于Cornell航空实验室时发明的一种人工神经网络。

它可以被视为一种最简单形式的前馈人工神经网络,是一种二元线性分类器。

感知机结构:2.2单层感知机与多层感知机之间的差异是什么?请举例说明。

解答:单层感知机与多层感知机的区别:1. 单层感知机只有输入层和输出层,多层感知机在输入与输出层之间还有若干隐藏层;2. 单层感知机只能解决线性可分问题,多层感知机还可以解决非线性可分问题。

2.3证明定理:样本集线性可分的充分必要条件是正实例点集所构成的凸壳与负实例点集构成的凸壳互不相交.解答:首先给出凸壳与线性可分的定义凸壳定义1:设集合S⊂R n,是由R n中的k个点所组成的集合,即S={x1,x2,⋯,x k}。

定义S的凸壳为conv(S)为:conv(S)={x=∑λi x iki=1|∑λi=1,λi≥0,i=1,2,⋯,k ki=1}线性可分定义2:给定一个数据集T={(x1,y1),(x2,y2),⋯,(x n,y n)}其中x i∈X=R n , y i∈Y={+1,−1} , i=1,2,⋯,n ,如果存在在某个超平面S:w∙x+b=0能够将数据集的正实例点和负实例点完全正确地划分到超平面的两侧,即对所有的正例点即y i=+1的实例i,有w∙x+b>0,对所有负实例点即y i=−1的实例i,有w∙x+b<0,则称数据集T为线性可分数据集;否则,称数据集T线性不可分。

必要性:线性可分→凸壳不相交设数据集T中的正例点集为S+,S+的凸壳为conv(S+),负实例点集为S−,S−的凸壳为conv(S−),若T是线性可分的,则存在一个超平面:w ∙x +b =0能够将S +和S −完全分离。

假设对于所有的正例点x i ,有:w ∙x i +b =εi易知εi >0,i =1,2,⋯,|S +|。

人工神经网络的应用领域介绍

人工神经网络的应用领域介绍人工神经网络(Artificial Neural Network,ANN)是一种模板化的计算模型,通过模拟神经元之间的讯息传递来完成信息处理任务,模型类似于人类神经系统。

自从ANN的提出以来,已经发展出了多种神经网络模型,被广泛应用于各种领域。

本文将介绍人工神经网络的应用,以及其在不同领域的效果。

1. 计算机视觉计算机视觉领域可以使用人工神经网络来进行图像分类、识别以及目标检测等任务。

现在的神经网络可以完成人脸识别、图像分割以及文本识别等高级任务,通过深层次的学习,达到人类相似的表现。

在此领域中,最流行的是卷积神经网络(Convolutional Neural Network,CNN)模型,它可以有效地识别图像中的特征,例如边缘、形状、颜色等,使得神经网络可以快速地准确地识别图片中的物体。

2. 语音处理人工神经网络在语音处理领域也有广泛的应用,例如语音识别、语音合成、语音信号分析等。

在这个领域中,反向传播神经网络(Backpropagation Neural Network,BNN)和长短时记忆网络(Long-short term memory,LSTM)等模型都被广泛应用。

这些模型可以学习语音信号的不同特征,并将语音信号转化为文本,以帮助人们快速地理解口语交流。

3. 金融领域人工神经网络在金融领域中也有广泛的应用,例如预测股票价格、信用评级以及风险控制等。

神经网络可以通过学习大量的历史数据,并根据这些数据来预测未来的趋势。

往往人工神经网络到所产生的预测结果会比传统的统计预测准确度更高。

4. 工业控制工业控制是人工神经网络的另一种应用领域。

神经网络可以帮助系统自动控制,例如自动化生产线上的物品分类、质量检测等任务。

神经网络能够通过学习各种现有系统的运作方式,并从海量数据中提取规律和关系,进而优化生产流程和控制系统。

5. 医疗行业在医疗行业中,人工神经网络可以用于病理判断、癌症筛查以及模拟手术等领域,从而实现更准确的诊断、治疗以及手术操作。

人工神经网络知识概述

人工神经网络知识概述人工神经网络(Artificial Neural Networks,ANN)系统是20世纪40年代后出现的。

它是由众多的神经元可调的连接权值连接而成,具有大规模并行处理、分布式信息存储、良好的自组织自学习能力等特点。

BP(Back Propagation)算法又称为误差反向传播算法,是人工神经网络中的一种监督式的学习算法。

BP 神经网络算法在理论上可以逼近任意函数,基本的结构由非线性变化单元组成,具有很强的非线性映射能力。

而且网络的中间层数、各层的处理单元数及网络的学习系数等参数可根据具体情况设定,灵活性很大,在优化、信号处理与模式识别、智能控制、故障诊断等许多领域都有着广泛的应用前景。

人工神经元的研究起源于脑神经元学说。

19世纪末,在生物、生理学领域,Waldeger等人创建了神经元学说。

人们认识到复杂的神经系统是由数目繁多的神经元组合而成。

大脑皮层包括有100亿个以上的神经元,每立方毫米约有数万个,它们互相联结形成神经网络,通过感觉器官和神经接受来自身体内外的各种信息,传递至中枢神经系统内,经过对信息的分析和综合,再通过运动神经发出控制信息,以此来实现机体与内外环境的联系,协调全身的各种机能活动。

神经元也和其他类型的细胞一样,包括有细胞膜、细胞质和细胞核。

但是神经细胞的形态比较特殊,具有许多突起,因此又分为细胞体、轴突和树突三部分。

细胞体内有细胞核,突起的作用是传递信息。

树突是作为引入输入信号的突起,而轴突是作为输出端的突起,它只有一个。

树突是细胞体的延伸部分,它由细胞体发出后逐渐变细,全长各部位都可与其他神经元的轴突末梢相互联系,形成所谓“突触”。

在突触处两神经元并未连通,它只是发生信息传递功能的结合部,联系界面之间间隙约为(15~50)×10米。

突触可分为兴奋性与抑制性两种类型,它相应于神经元之间耦合的极性。

每个神经元的突触数目正常,最高可达10个。

各神经元之间的连接强度和极性有所不同,并且都可调整、基于这一特性,人脑具有存储信息的功能。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

11月深度学习班

53/54

神经网络之 示例

11月深度学习班

54/54

神经网络之 示例

11月深度学习班

55/54

多层神经网络与图像识别

详见ipython notebook 与 GPU云平台案例

39/54

11月深度学习班

神经网络表达力与过拟合

o 提升隐层层数或者隐层神经元个数,神经网络“容量”会变 大,空间表达力会变强。

o 过多的隐层和神经元节点,会带来过拟合问题。 o 不要试图通过降低神经网络参数量来减缓过拟合,用正则化 或者dropout。

11月深度学习班 40/54

11月深度学习班

12/54

一点基础:线性分类器

o 线性分类器得分函数

11月深度学习班

13/54

一点基础:线性分类器

o 线性分类器的理解(1):空间划分

o Wx+b是空间的点

11月深度学习班

14/54

一点基础:线性分类器

o 2种损失函数的理解

11月深度学习班

22/54

神经网络之 从哪来

一个学习算法的假设

Auditory Cortex

听觉皮质学习去“看”

11月深度学习班 23/54

[Roe et al., 1992]

神经网络之 从哪来

一个学习算法的假设

Somatosensory Cortex

11月深度学习班

18/54

一点基础:线性分类器

o 损失函数1:hinge loss/支持向量机损失

Ø 因为是线性模型,因此可以简化成

Ø 加正则化项

11月深度学习班

19/54

一点基础:线性分类器

o 线性分类器得分函数

11月深度学习班

20/54

神经网络 结构

11月深度学习班

41/54

神经网络之 传递函数

o S函数(sigmoid) VS 双S函数

11月深度学习班

42/54

神经网络之 BP算法

o “正向传播”求损失,“反向传播”回传误差 o 根据误差信号修正每层的权重

11月深度学习班

43/54

神经网络之 BP算法

o BP算法,也叫δ算法 o 以3层的感知器为例

11月深度学习班

44/54

神经网络之 BP算法

o 输出层 o 误差展开至至隐层

o 展开至至输入入层

11月深度学习班

45/54

神经网络之 SGD

狗

青蛙

马

船

卡车

11月深度学习班

16/54

一点基础:线性分类器

o 损失函数

Ø 给定W,可以由像素映射到类目得分 Ø 可以调整参数/权重W,使得映射的结果和实际类别吻合 Ø 损失函数是用来衡量吻合度的 Ø 别的称呼 l 『代价函数/cost function』 l 『客观度/objective』

深度学习背景与人工神经网络

主要内容

n 背景介绍

1.深度学习应用

n 神经网络

1.起源 2.基本结构

n 神奇的分类能力与背后的原理

1.感知器与逻辑门 2.强大的空间非线性切分能力 3.网络表达力与过拟合问题 4.BP算法与SGD

n 代码与示例

1.Tensorflow多层感知器非线性切分 2.神经网络分类(非线性)示例 3.CIFAR-10多层感知器切分

11月深度学习班

56/54

感谢大家! 恳请大家批评指正!

11月深度学习班

57/54

深度学习与应用

o 综合应用

11月深度学习班

10/54

一点基础:线性分类器

o 线性分类器得分函数 o o o o

CIFAR-10中 的10个类别 的得分向量

11月深度学习班

11/54

一点基础:线性分类器

o 线性分类器得分函数

11月深度学习班

17/54

一点基础:线性分类器

o 损失函数1:hinge loss/支持向量机损失

Ø Ø Ø Ø 对于训练集中的第i张图片数据xi 在W下会有一个得分结果向量f(xi,W) 第j类的得分为我们记作f(xi,W)j 则在该样本上的损失我们由下列公式计算得到

一点基础:线性分类器

o 损失函数2:交叉熵损失(softmax分类器)

Ø 对于训练集中的第i张图片数据xi Ø 在W下会有一个得分结果向量fyi Ø 则损失函数记作

或者

实际工程中一般这么算:

11月深度学习班

21/54

一点基础:线性分类器

o 图像上的应用

11月深度学习班

6/54

深度学习与应用

o NLP上的应用

l 模仿小四的文笔

11月深度学习班

7/54

深度学习与应用

o NLP上的应用

11月深度学习班

8/54

深度学习与应用

o 综合应用

11月深度学习班

9/54

37/54

神经网络之 为什么

11月深度学习班

38/54

神经网络表达力与过拟合

o 理论上说单隐层神经网络可以逼近任何连续函数(只要隐层 的神经元个数足够多)。 o 虽然从数学上看表达能力一致,但是多隐藏层的神经网络比 单隐藏层的神经网络工程效果好很多。 o 对于一些分类数据(比如CTR预估里),3层神经网络效果优 于2层神经网络,但是如果把层数再不断增加(4,5,6层),对 最后结果的帮助就没有那么大的跳变了。 o 图像数据比较特殊,是一种深层(多层次)的结构化数据,深 层次的卷积神经网络,能够更充分和准确地把这些层级信息 表达出来。

49/54

反向传播与参数更新

11月深度学习班

50/54

反向传播与参数更新

11月深度学习班

51/54

神经网络之 示例

o Tensorflow与多层感知器完成样本分类

11月深度学习班

52/54

神经网络之 示例

o 线性分类器得分函数

11月深度学习班

15/54

一点基础:线性分类器

o 线性分类器的理解(2):模板匹配

Ø W的每一行可以看做是其中一个类别的模板。 Ø 每类得分,实际上是像素点和模板匹配度。 Ø 模板匹配的方式是内积计算。 模板示例:

飞机 小汽车 鸟 猫 鹿

通用的学习框架

11月深度学习班

26/54

神经网络之 是什么

神经网络结构大概如下…

11月深度学习班

27/54

神经网络之 是什么

从逻辑回归到神经元『感知器』

11月深度学习班

28/54

神经网络之 是什么

添加少量隐层 => 浅层神经网络

11月深度学习班 2/54

深度学习与应用

o 图像上的应用

11月深度学习班

3/54

深度学习与应用

o 图像上的应用

11月深度学习班

4/54

深度学习与应用

o 图像上的应用

11月深度学习班

5/54

深度学习与应用

11月深度学习班

29/54

神经网络之 是什么

增多中间层 => 深度神经网络(DNN)

11月深度学习班

30/54

神经网络之 为什么

o 神经网络应用在分类问题中效果好 o LR或者linear SVM,线性分割

11月深度学习班

31/54

o 误差E有了,怎么调整权重让误差不断减小? o E是权重w的函数,我们需要找到使得函数值最小的w

11月深度学习班

46/54

BP算法例子

11月深度学习班

47/54

前向运算

11月深度学习班

48/54

反向传播

11月深度学习班

神经网络之 为什么

o LR和SVM对于非线性可分,怎么处理的? o 为什么不用它们?

11月深度学习班

32/54

神经网络之 为什么

o 非线性可分,怎么办?

11月深度学习班

33/54

神经网络之 为什么

o 神经元完成『逻辑与』

11月深度学习班

34/54

神经网络之 为什么

11月深度学习班

35/54

神经网络之 为什么

o 神经元完成『逻辑或』

11月深度学习班

36/54

神经网络之 为什么

o 对线性分类器的『与』和『或』的组合 o 完美对平面样本点分布进行分类

11月深度学习班

感知皮层学习去“看”

11月深度学习班 24/54

[Roe et al., 1992]

神经网络之 从哪来

一个学习算法的假设

[BrainPort; Welsh & Blasch, 1997 etc]

用舌头看

人体声呐

方向识别带 11月深度学习班

25/54

植入第三只眼