神经网络一个简单实例

神经网络的实际应用举例

神经网络的实际应用举例神经网络是模拟人类神经系统机制的计算模型。

它可以从大量数据中自主学习,分析和识别复杂的模式,被应用到许多领域,包括计算机视觉、语音识别、自然语言处理等。

下面介绍神经网络在实际应用中的几个典型案例:一、机器翻译机器翻译是指将一种语言的文本转换成另一种语言的文本。

以Google Translate为例,通过神经网络,将大量的双语数据进行学习和模型的训练,实现了高质量的机器翻译。

神经网络通过提取出源语言文本中的特征,转换成语义空间的向量,在目标语言中寻找最相似的向量,并根据这些向量生成目标语句。

同时,还可以实现实时的语音翻译功能。

二、人脸识别人脸识别技术在安全监控、智能家居等领域广泛使用。

以人脸识别门禁为例,首先通过摄像头捕捉到人脸图像,然后提取特征,将人脸图像转换成向量。

接着,将向量输入神经网络,通过模型识别出人脸的身份信息,最后与数据库中保存的人脸信息进行比对,从而判断身份是否匹配。

三、自动驾驶自动驾驶技术是当前人工智能技术最具代表性的一个领域。

以谷歌无人驾驶汽车为例,通过激光雷达、相机、雷达和GPS等传感器收集周围环境信息,并通过神经网络进行深度学习,实现对环境信息的感知和处理。

然后,结合交通规则和路况等条件,进行行驶决策,开展自主驾驶。

四、医疗影像分析医疗影像分析需要对大量医学图像进行处理和分析,如CT、MRI等。

因此,对于快速准确地分析疾病信息非常重要。

以肺癌识别为例,通过神经网络可以对肺部影像进行分割和预处理,提取肺结节的特征,进而诊断是否为恶性肿瘤。

综上,神经网络的实际应用非常广泛,除了上面所提到的应用领域外,还可以应用在音视频处理、推荐系统等领域,为我们带来越来越多的便捷和效率。

BP人工神经网络的基本原理模型与实例

BP人工神经网络的基本原理模型与实例BP(Back Propagation)人工神经网络是一种常见的人工神经网络模型,其基本原理是模拟人脑神经元之间的连接和信息传递过程,通过学习和调整权重,来实现输入和输出之间的映射关系。

BP神经网络模型基本上由三层神经元组成:输入层、隐藏层和输出层。

每个神经元都与下一层的所有神经元连接,并通过带有权重的连接传递信息。

BP神经网络的训练基于误差的反向传播,即首先通过前向传播计算输出值,然后通过计算输出误差来更新连接权重,最后通过反向传播调整隐藏层和输入层的权重。

具体来说,BP神经网络的训练过程包括以下步骤:1.初始化连接权重:随机初始化输入层与隐藏层、隐藏层与输出层之间的连接权重。

2.前向传播:将输入向量喂给输入层,通过带有权重的连接传递到隐藏层和输出层,计算得到输出值。

3.计算输出误差:将期望输出值与实际输出值进行比较,计算得到输出误差。

4.反向传播:从输出层开始,将输出误差逆向传播到隐藏层和输入层,根据误差的贡献程度,调整连接权重。

5.更新权重:根据反向传播得到的误差梯度,使用梯度下降法或其他优化算法更新连接权重。

6.重复步骤2-5直到达到停止条件,如达到最大迭代次数或误差小于一些阈值。

BP神经网络的训练过程是一个迭代的过程,通过不断调整连接权重,逐渐减小输出误差,使网络能够更好地拟合输入与输出之间的映射关系。

下面以一个简单的实例来说明BP神经网络的应用:假设我们要建立一个三层BP神经网络来预测房价,输入为房屋面积和房间数,输出为价格。

我们训练集中包含一些房屋信息和对应的价格。

1.初始化连接权重:随机初始化输入层与隐藏层、隐藏层与输出层之间的连接权重。

2.前向传播:将输入的房屋面积和房间数喂给输入层,通过带有权重的连接传递到隐藏层和输出层,计算得到价格的预测值。

3.计算输出误差:将预测的价格与实际价格进行比较,计算得到输出误差。

4.反向传播:从输出层开始,将输出误差逆向传播到隐藏层和输入层,根据误差的贡献程度,调整连接权重。

机器学习技术中的循环神经网络应用案例

机器学习技术中的循环神经网络应用案例循环神经网络(Recurrent Neural Network,RNN)是一种重要的机器学习技术,它在语言处理、时间序列分析、图像生成和预测等领域中发挥着重要作用。

它的独特之处在于能够处理可变长度的输入序列,并且能够通过时间传递信息,使得前面的输入能够影响后面的输出。

本文将介绍几个循环神经网络应用案例,并讨论其在实际中的应用和效果。

首先,一个典型的循环神经网络应用案例是自然语言处理(Natural Language Processing,NLP)。

在自然语言处理任务中,往往需要处理变长的文本序列,如文本分类、情感分析和机器翻译等。

传统的基于特征工程的方法往往需要手动提取文本特征,而循环神经网络可以直接处理原始文本序列,无需进行特征工程。

例如,在文本分类任务中,循环神经网络可以通过学习文本序列中的长期依赖关系,有效地捕捉到文本的语义信息,提高分类性能。

另一个重要的应用领域是时间序列分析。

时间序列是一系列按时间顺序排列的数据点,如股票价格、天气数据等。

循环神经网络可以通过时间传递信息的机制,对时间序列数据进行建模和预测。

例如,可以使用循环神经网络来预测未来的股票价格。

通过训练模型来学习历史股票价格的模式和趋势,循环神经网络可以预测未来的股票价格走势,帮助投资者做出更明智的投资决策。

图像生成也是循环神经网络的重要应用之一。

循环神经网络可以通过学习图像之间的语义关系,生成逼真的图像。

这个过程通常被称为图像生成。

其中一个经典的案例是图像描述生成。

通过输入一张图像,循环神经网络可以学习图像中的语义信息,并生成相应的文字描述。

这对于图像检索、自动驾驶和虚拟现实等领域都具有重要意义。

除了上述应用案例,循环神经网络还在许多其他领域得到广泛应用,如语音识别、推荐系统和机器人控制等。

例如,在语音识别任务中,循环神经网络可以通过时间传递信息的机制,对音频中的语音信号进行建模,从而识别出语音中的文字内容。

人工神经网络入门(1)——单层人工神经网络应用示例

⼈⼯神经⽹络⼊门(1)——单层⼈⼯神经⽹络应⽤⽰例范例程序下载:如果您有疑问,可以先参考如果您未找到满意的答案,可以在下⾯留⾔:)1 介绍还记得在2年前刚刚接触RoboCup的时候,从学长⼝中听说了ANN(⼈⼯神经⽹络),这个东西可神奇了,他能通过学会从⽽对⼀些问题进⾏⾜够好处理。

就像咱们⼈⼀样,可以通过学习,了解新的知识。

但是2年了,⼀直想学习ANN,但是⼀直没有成功。

原因很多,其中主要的原因是咱们国内的教程中关于这个技术的介绍过于理论化,以⾄于我们基础差和⾃学者望⽽却步。

现在,我希望通过⼀个简单的⽰例,让⼤家先有⼀个感性的认识,然后再了解⼀些相应的理论,从⽽达到更好的学习效果。

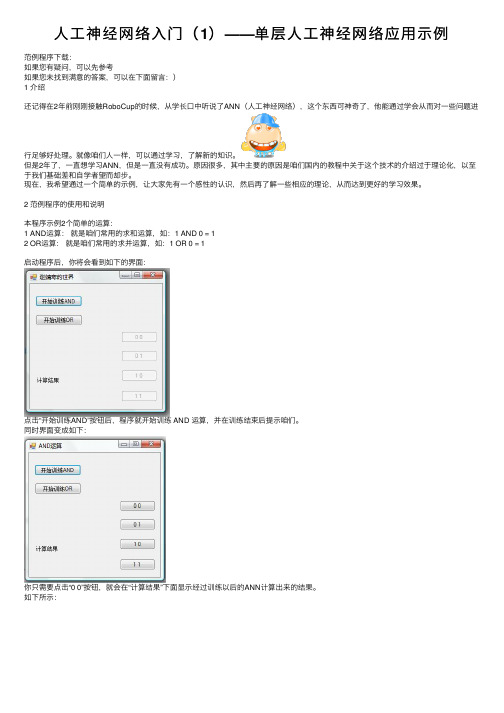

2 范例程序的使⽤和说明本程序⽰例2个简单的运算:1 AND运算:就是咱们常⽤的求和运算,如:1 AND 0 = 12 OR运算:就是咱们常⽤的求并运算,如:1 OR 0 = 1启动程序后,你将会看到如下的界⾯:点击“开始训练AND”按钮后,程序就开始训练 AND 运算,并在训练结束后提⽰咱们。

同时界⾯变成如下:你只需要点击“0 0”按钮,就会在“计算结果”下⾯显⽰经过训练以后的ANN计算出来的结果。

如下所⽰:“计算结果”显⽰为“1.74E-10”,说明 0 AND 0 = 0.这个结果就是我们想要的。

训练成功其他的按钮使⽤⽅法类似:)3 计算过程咱们可以参考⼀下AND计算的总体运⾏过程://初始化训练集合TrainSet[] sets = new TrainSet[]{new TrainSet(0, 0, 0), new TrainSet(0, 1, 0),new TrainSet(1, 0, 0), new TrainSet(1, 1, 1)};//构造单层神经⽹络 2 个输⼊节点 1个输出节点NeuralNetwork nn = new NeuralNetwork(2, 1);slnn = new SingleLayerNeuralNetworks(nn, sets);//训练slnn.Train();MessageBox.Show("AND运算训练结束");this.button2.Enabled = true;this.button3.Enabled = true;this.button4.Enabled = true;this.button1.Enabled = true;this.Text = "AND运算";OK,通过上⾯的代码可以看出,咱们的神经⽹络有2个输⼊节点,⽤于输⼊AND运算的2个参数。

径向基概率神经网络的实例(实现预测分类)

径向基概率神经网络的实例(实现预测分类)径向基概率神经网络(Radial Basis Probabilistic Neural Network)是一种基于径向基函数的概率神经网络模型,可以用于预测和分类任务。

它在概率神经网络的基础上引入了径向基函数的概念,并对输出层进行了改进,使得网络具备了更好的非线性表达能力和泛化性能。

下面,我将以一个实例来介绍径向基概率神经网络的应用,包括实现预测和分类任务。

首先,假设我们有一个数据集,包含了一些人的身高和体重信息,以及他们的性别(男或女)。

我们的目标是根据人的身高和体重预测他们的性别,同时进行性别分类。

1.数据集准备:我们需要将数据集分为训练集和测试集。

假设我们有1000个样本,我们可以将800个样本作为训练集,剩下的200个样本作为测试集。

每个样本包含两个输入特征(身高和体重)和一个输出类别(性别)。

2.网络结构搭建:输入层:包含两个神经元,对应身高和体重这两个特征。

隐藏层:包含若干个径向基函数神经元,用于提取特征。

输出层:包含两个神经元,对应男性和女性两个类别。

3.网络训练:首先,我们需要对输入特征进行归一化处理,以提高模型训练的收敛速度和准确性。

然后,使用训练集对网络进行训练。

训练的过程包括以下几个步骤:-使用径向基函数对隐藏层进行初始化,初始化方法可以选用均匀分布或高斯分布。

-使用前向传播计算每个神经元的输出值。

-使用最小化损失函数的方法(如交叉熵损失函数)进行反向传播,更新网络参数。

-重复以上步骤直至达到预定的停止条件(如达到最大迭代次数或误差小于一些阈值)。

4.预测和分类:训练完成后,我们可以使用测试集对网络进行预测和分类。

对于预测任务,给定一个人的身高和体重,我们可以输入这些特征到网络中,通过前向传播计算得到网络的输出,即性别的概率。

我们可以根据输出概率选择概率值较大的性别作为预测结果。

对于分类任务,给定一个人的身高和体重,我们可以输入这些特征到网络中,通过前向传播计算得到网络的输出向量。

bp神经网络算法步骤结合实例

bp神经网络算法步骤结合实例

BP神经网络算法步骤包括以下几个步骤:

1.输入层:将输入数据输入到神经网络中。

2.隐层:在输入层和输出层之间,通过一系列权值和偏置将输入数据进行处理,得到输出

数据。

3.输出层:将隐层的输出数据输出到输出层。

4.反向传播:通过反向传播算法来计算误差,并使用梯度下降法对权值和偏置进行调整,

以最小化误差。

5.训练:通过不断地进行输入、隐层处理、输出和反向传播的过程,来训练神经网络,使

其达到最优状态。

实例:

假设我们有一个BP神经网络,它的输入层有两个输入节点,隐层有三个节点,输出层有一个节点。

经过训练,我们得到了权值矩阵和偏置向量。

当我们给它输入一组数据时,它的工作流程如下:

1.输入层:将输入数据输入到神经网络中。

2.隐层:将输入数据与权值矩阵相乘,再加上偏置向量,得到输出数据。

3.输出层:将隐层的输出数据输出到输出层。

4.反向传播:使用反向传播算法计算误差,并使用梯度下降法调整权值和偏置向量,以最

小化误差。

5.训练:通过不断地输入、处理、输出和反向传播的过程,来训练神经网络,使其达到最

优状态。

这就是BP神经网络算法的基本流程。

在实际应用中,还需要考虑许多细节问题,如权值和偏置的初始值、学习率、激活函数等。

但是,上述流程是BP神经网络算法的基本框架。

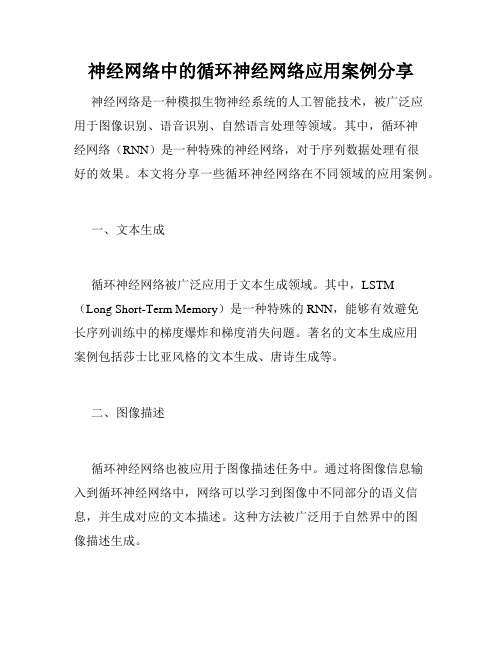

神经网络中的循环神经网络应用案例分享

神经网络中的循环神经网络应用案例分享神经网络是一种模拟生物神经系统的人工智能技术,被广泛应用于图像识别、语音识别、自然语言处理等领域。

其中,循环神经网络(RNN)是一种特殊的神经网络,对于序列数据处理有很好的效果。

本文将分享一些循环神经网络在不同领域的应用案例。

一、文本生成循环神经网络被广泛应用于文本生成领域。

其中,LSTM(Long Short-Term Memory)是一种特殊的RNN,能够有效避免长序列训练中的梯度爆炸和梯度消失问题。

著名的文本生成应用案例包括莎士比亚风格的文本生成、唐诗生成等。

二、图像描述循环神经网络也被应用于图像描述任务中。

通过将图像信息输入到循环神经网络中,网络可以学习到图像中不同部分的语义信息,并生成对应的文本描述。

这种方法被广泛用于自然界中的图像描述生成。

三、自动摘要循环神经网络还可以用于自动摘要的任务中。

利用Encoder-Decoder模型,将原始文本序列输入到LSTM中,将其转换为向量表示,并将其作为Decoder模型的初始状态。

最终,Decoder输出的序列即为摘要的内容。

四、音乐生成循环神经网络也被应用于音乐生成领域。

通过将音乐序列输入到LSTM网络中,可以生成具有和弦和旋律的音乐序列。

这种方法被广泛应用于游戏中的背景音乐生成、音乐智能创作等领域。

五、情感分析循环神经网络还可以用于情感分析。

通过将文本序列输入到LSTM网络中,网络可以学习到文本中的情感信息,从而实现对文本的情感分析任务。

此方法被广泛用于社交媒体数据分析、舆情分析等领域。

总结:本文列举了循环神经网络在文本生成、图像描述、自动摘要、音乐生成、情感分析等领域的应用案例。

循环神经网络具有记忆能力,可以很好地处理序列数据,并在上述领域取得了不错的效果。

未来,循环神经网络将会在更多的领域被广泛应用。

神经网络BP算法案例

的记录是被我们所忽略的。

所有满足最小支持度3的1项频繁集如下 (其中巧克力、 香蕉、葡萄的支持度为1,不满足条件)

支持度

销售内容

3

4 4 5 7

冰淇淋

咖啡 果酱 牛奶 面包

所有满足最小支持度3的2项频繁集 如下 :

支持度 3 销售内容 面包 咖啡 面包 冰淇淋 面包 牛奶 面包 果酱

递 归 执 行

的,比如在一个超市中会存在这样的概念 层次:蒙牛牌牛奶是牛奶,伊利牌牛奶是 牛奶,王子牌饼干是饼干,康师傅牌饼干 是饼干等。

• 可以用有向无环图 (directed acyclic graph ) 表示概念层次,如下:

从有向无环图 (directed acyclic graph )可以 看出—— 如果我们只是在数据基本层发掘关系, {蒙牛牌牛奶,王子牌饼干},{蒙牛牌牛 奶,康师傅牌饼干},{伊利牌牛奶,王子 牌饼干},{伊利牌牛奶,康师傅牌饼干} 都不符合最小支持度。不过如果我们上升一 个层级,可能会发现{牛奶,饼干} 的关 联规则是有一定支持度的。这样我们就可以 在较高的概念层次上发现关联规则。

w14 4 w46 6 5 w35

. . ..

w34

w56

. . .

3

图1 两层前馈神经网络

2

神经网络BP算法案例

• 首先算出单元4、5、6的输入、输出,具体结果见 表1,然后计算4、5、6的误差,见表2;NT中每条 有向加权边的新权重、每个隐藏层与输出层单元 的新偏置见表3。

图2 两层前馈神经网络

W35

0.2+0.9×(-0.0065)×1=0.194

0.1+0.9×0.1311=0.218 0.2+0.9×(-0.0065)=0.194

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

OpenCV的ml模块实现了人工神经网络(Artificial Neural Networks,ANN)最典型的多层感知器(multi-layer perceptrons, MLP)模型。

由于ml模型实现的算法都继承自统一的CvStatModel基类,其训练和预测的接口都是train(),predict(),非常简单。

下面来看神经网络CvANN_MLP 的使用~定义神经网络及参数:[cpp]view plain copy1.//Setup the BPNetwork2. CvANN_MLP bp;3.// Set up BPNetwork's parameters4. CvANN_MLP_TrainParams params;5. params.train_method=CvANN_MLP_TrainParams::BACKPROP;6. params.bp_dw_scale=0.1;7. params.bp_moment_scale=0.1;8.//params.train_method=CvANN_MLP_TrainParams::RPROP;9.//params.rp_dw0 = 0.1;10.//params.rp_dw_plus = 1.2;11.//params.rp_dw_minus = 0.5;12.//params.rp_dw_min = FLT_EPSILON;13.//params.rp_dw_max = 50.;可以直接定义CvANN_MLP神经网络,并设置其参数。

BACKPROP表示使用back-propagation的训练方法,RPROP即最简单的propagation训练方法。

使用BACKPROP有两个相关参数:bp_dw_scale即bp_moment_scale:使用PRPOP有四个相关参数:rp_dw0, rp_dw_plus, rp_dw_minus, rp_dw_min,rp_dw_max:上述代码中为其默认值。

设置网络层数,训练数据:[cpp]view plain copy1.// Set up training data2.float labels[3][5] = {{0,0,0,0,0},{1,1,1,1,1},{0,0,0,0,0}};3. Mat labelsMat(3, 5, CV_32FC1, labels);4.5.float trainingData[3][5] = { {1,2,3,4,5},{111,112,113,114,115}, {21,22,23,24,25} };6. Mat trainingDataMat(3, 5, CV_32FC1, trainingData);7. Mat layerSizes=(Mat_<int>(1,5) << 5,2,2,2,5);8. bp.create(layerSizes,CvANN_MLP::SIGMOID_SYM);//CvANN_MLP::SIGMOID_SYM9.//CvANN_MLP::GAUSSIAN10.//CvANN_MLP::IDENTITY11. bp.train(trainingDataMat, labelsMat, Mat(),Mat(), params);layerSizes设置了有三个隐含层的网络结构:输入层,三个隐含层,输出层。

输入层和输出层节点数均为5,中间隐含层每层有两个节点。

create第二个参数可以设置每个神经节点的激活函数,默认为CvANN_MLP::SIGMOID_SYM,即Sigmoid函数,同时提供的其他激活函数有Gauss和阶跃函数。

使用训练好的网络结构分类新的数据:然后直接使用predict函数,就可以预测新的节点:[cpp]view plain copy1.Mat sampleMat = (Mat_<float>(1,5) << i,j,0,0,0);2. Mat responseMat;3. bp.predict(sampleMat,responseMat);完整程序代码:[cpp]view plain copy1.//The example of using BPNetwork in OpenCV2.//Coded by L. Wei3.#include <opencv2/core/core.hpp>4.#include <opencv2/highgui/highgui.hpp>5.#include <opencv2/ml/ml.hpp>6.#include <iostream>7.#include <string>8.ing namespace std;ing namespace cv;11.12.int main()13.{14.//Setup the BPNetwork15. CvANN_MLP bp;16.// Set up BPNetwork's parameters17. CvANN_MLP_TrainParams params;18. params.train_method=CvANN_MLP_TrainParams::BACKPROP;19. params.bp_dw_scale=0.1;20. params.bp_moment_scale=0.1;21.//params.train_method=CvANN_MLP_TrainParams::RPROP;22.//params.rp_dw0 = 0.1;23.//params.rp_dw_plus = 1.2;24.//params.rp_dw_minus = 0.5;25.//params.rp_dw_min = FLT_EPSILON;26.//params.rp_dw_max = 50.;27.28.// Set up training data29.float labels[3][5] = {{0,0,0,0,0},{1,1,1,1,1},{0,0,0,0,0}};30. Mat labelsMat(3, 5, CV_32FC1, labels);31.32.float trainingData[3][5] = { {1,2,3,4,5},{111,112,113,114,115}, {21,22,23,24,25} };33. Mat trainingDataMat(3, 5, CV_32FC1, trainingData);34. Mat layerSizes=(Mat_<int>(1,5) << 5,2,2,2,5);35. bp.create(layerSizes,CvANN_MLP::SIGMOID_SYM);//CvANN_MLP::SIGMOID_SYM36.//CvANN_MLP::GAUSSIAN37.//CvANN_MLP::IDENTITY38. bp.train(trainingDataMat, labelsMat, Mat(),Mat(), params);39.40.41.// Data for visual representation42.int width = 512, height = 512;43. Mat image = Mat::zeros(height, width, CV_8UC3);44. Vec3b green(0,255,0), blue (255,0,0);45.// Show the decision regions given by the SVM46.for (int i = 0; i < image.rows; ++i)47.for (int j = 0; j < image.cols; ++j)48. {49. Mat sampleMat = (Mat_<float>(1,5) << i,j,0,0,0);50. Mat responseMat;51. bp.predict(sampleMat,responseMat);52.float* p=responseMat.ptr<float>(0);53.float response=0.0f;54.for(int k=0;k<5;i++){55.// cout<<p[k]<<" ";56. response+=p[k];57. }58.if (response >2)59. image.at<Vec3b>(j, i) = green;60.else61. image.at<Vec3b>(j, i) = blue;62. }63.64.// Show the training data65.int thickness = -1;66.int lineType = 8;67. circle( image, Point(501, 10), 5, Scalar( 0, 0, 0), thickness,lineType);68. circle( image, Point(255, 10), 5, Scalar(255, 255, 255), thickness,lineType);69. circle( image, Point(501, 255), 5, Scalar(255, 255, 255), thickness,lineType);70. circle( image, Point( 10, 501), 5, Scalar(255, 255, 255), thickness,lineType);71.72. imwrite("result.png", image); // save the image73.74. imshow("BP Simple Example", image); // show it to the user75. waitKey(0);76.77.}结果:。