文本分类入门(十一)特征选择方法之信息增益

文本分类中信息增益特征选择方法的研究

文本分类中信息增益特征选择方法的研究文本分类是自然语言处理领域的一个重要应用,可以利用机器学习技术来解决文本分类问题。

在文本分类中,特征选择是一个很重要的部分,在提高分类器性能和减少计算量方面具有重要作用。

本文将从信息增益的角度探讨文本分类中的特征选择方法。

文本分类是将文本文档分为不同类别的过程,它可以识别文档中的信息,并将文档归类到指定的类别中。

文本分类技术有很多应用,如新闻分类、垃圾短信识别、文本挖掘等,都可以使用文本分类技术。

文本分类是一个从原始文本中提取特征的过程。

它将原始文本中的特征抽取出来,以便对文档进行分类。

文本特征抽取是文本分类的关键步骤,需要提取文本中具有区分度的特征,以便更准确地对文本进行分类。

在文本特征抽取过程中,信息增益特征选择是最常使用的特征选择方法。

信息增益特征选择是基于信息论中的信息增益概念,用于提取文本特征。

它充分利用文档之间的相关性,从而提取出文本中具有区分度的特征。

信息增益特征选择是一种基于熵的特征选择方法,它根据文档的互信息来提取特征,充分利用文本的相关性,以最大程度地降低熵的方式来提取特征。

首先,信息增益在计算时基于特征之间的相信度,需要将文档分成特征区间,来表征文档内容之间的相关性。

然后,通过计算这些特征区间的信息熵,来表征文档内容的混乱程度。

其次,根据上述分析,以特定的信息增益值为标准,选择出具有较大信息增益的特征。

最后,产生的结果是从原始特征中选择出最有特征的特征序列,作为文档分类的特征。

信息增益特征选择的优点在于,可以选出最有分类性的特征,使分类器的性能得到提高。

信息增益特征选择法在文本分类中有着广泛的应用,但其也存在一些问题。

例如,它选出的特征不一定是最适合分类的特征;它需要计算特征之间的相关性,因此计算量较大;它的特征选择规则可能会因数据变化而导致选取的特征和结果不稳定。

为了解决这些问题,学术界提出了许多改进性的特征选择方法,如基于系统论的特征选择方法、基于共现矩阵的特征选择方法、基于支持向量机的特征选择方法等。

文本分类特征选择方法

●特征选择目的:选出能够很好反映文本内容的词,以降低文本向量空间维数,提高分类器的分类效率和分类精度。

●特征选择方法:1、基于独立评估的:构造一个评估函数,利用评估函数对特征集合的每个特征进行独立评估,每个特征获得一个评估值,然后按照评估值从大到小的顺序对特征集合的特征进行排序,最后按照预先设定的阀值或预先设定的特征选择的个数选取最佳特征子集作为特征选择的结果。

2、基于综合评估的:从特征集合中找出较少的描述这些特征的综合指标,然后利用该综合指标对特征集合进行特征选择操作。

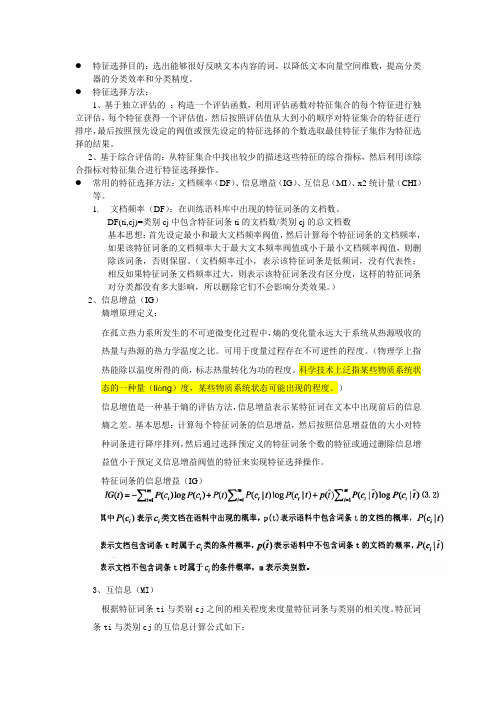

●常用的特征选择方法:文档频率(DF)、信息增益(IG)、互信息(MI)、x2统计量(CHI)等。

1.文档频率(DF):在训练语料库中出现的特征词条的文档数。

DF(ti,cj)=类别cj中包含特征词条ti的文档数/类别cj的总文档数基本思想:首先设定最小和最大文档频率阀值,然后计算每个特征词条的文档频率,如果该特征词条的文档频率大于最大文本频率阀值或小于最小文档频率阀值,则删除该词条,否则保留。

(文档频率过小,表示该特征词条是低频词,没有代表性;相反如果特征词条文档频率过大,则表示该特征词条没有区分度,这样的特征词条对分类都没有多大影响,所以删除它们不会影响分类效果。

)2、信息增益(IG)熵增原理定义:在孤立热力系所发生的不可逆微变化过程中,熵的变化量永远大于系统从热源吸收的热量与热源的热力学温度之比。

可用于度量过程存在不可逆性的程度。

(物理学上指热能除以温度所得的商,标志热量转化为功的程度。

科学技术上泛指某些物质系统状态的一种量(liàng)度,某些物质系统状态可能出现的程度。

)信息增值是一种基于熵的评估方法,信息增益表示某特征词在文本中出现前后的信息熵之差。

基本思想:计算每个特征词条的信息增益,然后按照信息增益值的大小对特种词条进行降序排列,然后通过选择预定义的特征词条个数的特征或通过删除信息增益值小于预定义信息增益阀值的特征来实现特征选择操作。

文本分类特征选择方法

文本分类特征选择方法在文本分类任务中,特征选择是一个关键的步骤,它能够帮助我们从原始文本数据中提取出最具有代表性和区分性的特征,从而提高分类模型的性能和效果。

本文将介绍几种常见的文本分类特征选择方法。

词频特征是最常见的文本特征表示,它表示每个词在文本中出现的频率。

在文本分类中,可以使用词频特征选择方法来选择最具有区分性的特征词,常见的方法有:1. 互信息(Mutual Information)互信息是用来衡量两个随机变量之间的相关性的度量。

在文本分类中,互信息可以用来衡量一个词和分类之间的相关性。

相关性越高,互信息值越大,表示该词对分类起到了更大的区分作用。

因此,可以根据互信息值来选择最具有代表性和区分性的特征词。

2. 卡方检验(Chi-Square Test)卡方检验是用来检测两个分类变量之间的独立性的统计方法。

在文本分类中,可以使用卡方检验来衡量一个词和分类之间的独立性。

如果一个词在一些分类中出现的频率远高于其他分类,那么该词对于该分类就有更强的区分能力,可以选择作为特征词。

3. 信息增益(Information Gain)信息增益是一种用来衡量特征对于分类任务的重要性的指标。

在文本分类中,信息增益可以用来衡量一个词在整个文本集合中的分布情况和在一些特定分类中的分布情况之间的差异。

信息增益越大,表示该词对于分类起到了更大的区分作用。

除了词频特征之外,文档频率也是一种常用的文本特征表示方法。

文档频率表示一个词在多少个不同的文本中出现过,可以用来衡量一个词的普遍性和独特性。

在文本分类中,可以使用文档频率特征选择方法来选择最具有代表性和区分性的特征词,常见的方法有:1. 逆文档频率(Inverse Document Frequency)逆文档频率是一种用来衡量一个词的独特性和代表性的指标。

逆文档频率越高,表示该词在文本中的普遍性越低,具有更强的区分能力。

因此,可以根据逆文档频率来选择最具有代表性和区分性的特征词。

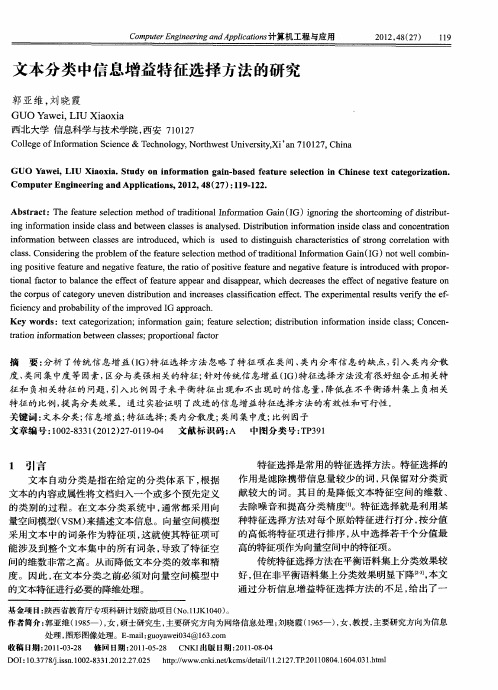

文本分类中信息增益特征选择方法的研究

c s. o s eigte rbe o e e tr l t nmeh do a io a fr t nG i(G) o lc mbn l s C n i r o lm fh aue ee i to f dt n lnoma o a I n t l o i— a d n hp t f s co r t i I i n we

C m ue n i ei d p lai s o p t E gn r ga A pi t n 计算机工程与应用 r e n n c o

文本 分类 中信息增益特征选择 方法 的研 究

郭亚维 , 晓霞 刘

GUO we. U a x a Ya i LI Xi o i

西北大学 信息科学与技术学院 , 西安 7 02 1 17

摘

要 : 析 了传 统信 息 增 益 (G) 征 选 择 方 法 忽略 了特 征 项 在 类 间 、 内分布 信 息 的缺 点 , 分 I 特 类 引入 类 内分散

度 、 间集中度等因素 , 类 区分与类强相关的特征 ; 针对传统信息增益 ( 特征选择 方法没有很好组合正相 关特 I G) 征和 负相 关特征的 问题 , 引入 比例 因子来平衡特征 出现和 不出现 时的信 息量 , 降低在不平衡语料集上 负相关 特征的比例 , 高分类效果。通过实验证明了改进的信息增益特征选择 方法的有效性和可行性。 提 关键 词 : 文本 分 类 ; 息增 益 ; 信 特征 选择 ; 内分 散度 ; 间集 中度 ; 类 类 比例 因子 文章 编 号 : 0 28 3 ( 0 2 2 — 190 文献 标识 码 : 中图分 类号 : P 9 1 0 —3 12 1 ) 70 1—4 A T 31

i stv e t ea d n gai e f au e t a i fpo ii e f au e a e a i e t r si to u e t r p r ng po ii e f aur n e tv e tr , her to o stv e t r nd n g tvef au ei n r d c d wi p o o — h to lf c o o baa c h fe to e tr p a nd dia pe r i na a t rt l n e t e e c ff a u e a pe ra s p a ,wh c e r a e hee e to e a i e f a r n ih d cห้องสมุดไป่ตู้e s st f c fn g tv e t e o u t o p fc t g r ne n d srb ton a d i r a e l s i c to fe t Th xp rme t lr s lsv rf t e e - hec r uso a e o y u ve iti u i n nc e s sc a sf ai n e c . e e e i n a e u t e y h f i i i inc n r b bi y o i r ve G p oa h. fce y a d p o a lt ft mp o d I a pr c i he K e r :tx a e o i ai n;i o a in an;f a r e e to y wo ds e tc t g rz to nf r to g i e t e s lc i n;d s iuto nf r a i n i i e c a s m u it b i n i o r m to nsd l s ;Co c n— ne r to nf r to e tai n i o ma i n b t e n ca s s pr po i a a t r w e ls e ; o r on l c o t f

文本分类中的特征选择方法评估比较

文本分类中的特征选择方法评估比较特征选择是文本分类中的一个重要步骤,它对于改善分类模型的性能和降低计算成本具有关键作用。

在文本分类领域,有许多不同的特征选择方法可供选择。

本文将评估和比较几种常用的特征选择方法,以帮助研究者和从业者选择适合自己任务的方法。

1. 互信息(MI):互信息是一种常用的特征选择方法,它用来度量特征与类别之间的相关性。

互信息越大,表示特征与类别之间的相关性越强。

互信息具有简单直观的计算方式,但它没有考虑特征与其他特征之间的相关性。

2. 卡方检验(CHI):卡方检验也是一种常见的特征选择方法,它用来度量特征与类别之间的独立性。

卡方值越大,表示特征与类别之间的独立性越低,即特征更有用。

卡方检验能够考虑特征与其他特征之间的相关性,但它对特征出现次数较少的情况较为敏感。

3. 信息增益(IG):信息增益是一种基于信息熵的特征选择方法,它用来度量特征对类别的分类能力。

信息增益越大,表示特征对类别的分类能力越强。

信息增益能够有效地考虑特征与类别之间的相关性,但它对特征的取值个数较敏感。

4. 方差选择(VAR):方差选择是一种基于方差的特征选择方法,它用来度量特征在样本集中的变化程度。

方差越大,表示特征的取值在样本集中的变化越大,即特征更有用。

方差选择方法简单易用,但它忽略了特征与类别之间的相关性。

以上是几种常用的特征选择方法,它们各自有着不同的特点和适用场景。

在实际应用中,我们需要根据任务的具体需求和数据的特点选择合适的特征选择方法。

对于互信息、卡方检验和信息增益这三种方法,它们都可以用于评估特征与类别之间的相关性。

在使用这些方法时,我们需要注意特征与类别之间的关联关系。

如果特征与类别之间的关联关系较强,那么这些方法会给出较高的评估分数,反之则会给出较低的评估分数。

因此,在选择特征选择方法时,我们需要综合考虑特征与类别之间的相关性以及任务的具体需求。

方差选择方法适用于对特征的变异程度较为敏感的任务。

文本分类中的信息增益

Jasper's Java Jacal嘉士伯的Java小屋聚合 |前文提到过,除了开方检验(CHI)以外,信息增益(IG,Information Gain)也是很有效的特征选择方法。

但凡是特征选择,总是在将特征的重要程度量化之后再进行选择,而如何量化特征的重要性,就成了各种方法间最大的不同。

开方检验中使用特征与类别间的关联性来进行这个量化,关联性越强,特征得分越高,该特征越应该被保留。

在信息增益中,重要性的衡量标准就是看特征能够为分类系统带来多少信息,带来的信息越多,该特征越重要。

因此先回忆一下信息论中有关信息量(就是“熵”)的定义。

说有这么一个变量X,它可能的取值有n多种,分别是x1x n,每一种取到的概率分别是P1,P2,……,P n,那么X的熵就定义为:意思就是一个变量可能的变化越多(反而跟变量具体的取值没有任何关系,只和值的种类多少以及发生概率有关),它携带的信息量就越大(因此我一直觉得我们的政策法规信息量非常大,因为它变化很多,基本朝令夕改,笑)。

搜索”,出现)和出现的概率,就是*提交[使用Ctrl+Enter 每天10Java Certification UpdateSun Cert now integrated w / Oracle Certification Program - Learn more!JavaSearch for Java postings - Find your new job today. Indeed™Natuzzi Java60,000+ Natuzzi Leather Products Shop, Compare and Save at Pronto.SFTP for JavaFTP , SFTP and FTPS for Java. Fast, robust and easy to use.PowerBuilder to JavaProven Application Transformation. Minimize Project Time, Cost & Risk.Swing Java browser SDK100% pure Swing FF support! HTML 4.01, CSS, XSL, XML, SSL +more。

文本分类中信息增益特征选择方法的研究

文本分类中信息增益特征选择方法的研究文本分类是一种重要的自然语言处理技术,它能够有效地划分字符串文本,并将它们划分为多个有意义的类别,以便以合理的方式对文本进行处理。

当进行文本分类时,需要一种有效的特征选择方法来提取文本中的有效信息,从而帮助开发出更准确的分类器。

近年来,基于信息增益的特征选择方法得到了广泛的应用,但其长处也有一些缺点。

因此,本文的主要目的是研究信息增益特征选择在文本分类任务中的应用,以及如何更好地使用这种方法来提高分类器的性能。

首先,本文介绍了信息增益特征选择方法的基本原理,并阐述了特征选择的重要性和作用。

然后,采用特征选择算法,以文本作为输入,进行定量分析,从文本中提取有关特征,包括词语、句子、篇章结构等内容,从而构建文本分类模型。

研究还展示了将信息增益特征选择方法应用于文本分类的过程,包括特征向量构建以及特征选择等步骤,以及特征之间的相关性分析,以便从特征的多维特性中挑选有用的特征。

本文还介绍了如何使用信息增益特征选择方法来提高文本分类器的性能,提出了基于改进信息增益特征选择方法的文本分类器设计,并详细介绍了其工作原理。

本文还比较了传统信息增益特征选择方法和改进信息增益特征选择方法在文本分类任务中的准确率。

实验结果表明,改进的信息增益特征选择方法在许多数据集上表现出比传统方法更好的性能。

最后,文章总结了本文的研究成果,并对未来的研究方向提出了建议。

此外,文章还讨论了信息增益特征选择方法在文本分类领域中的未来发展,将指导未来特征选择研究,以帮助文本分类任务得到更好的实现。

总之,本文研究了信息增益特征选择方法在文本分类中的应用,提出了基于改进信息增益特征选择方法的文本分类器设计,并通过实验证明了该方法的有效性,为文本分类提供了新的探索。

文本分类中信息增益特征选择方法的研究

文本分类中信息增益特征选择方法的研究近年来,随着网络技术的迅速发展,文本分类技术得到越来越多的重视。

文本分类是以文本为基础的数据挖掘技术,它的目的是将一批文本文档分割为不同的类别,以支持后续的知识发现和决策分析。

为实现自动文本分类,文本分类系统需要一系列有助于区分不同类别的语义特征,其中特征选择是一个重要的环节。

信息增益特征选择方法是一种常用的特征选择方法,是基于信息论和概率理论。

信息增益是一种信息量的量度,它表示在加入一个新特征后,目标变量的不确定性的降低情况。

它最大程度地减少了特征与特征之间的相关性,从而获得最佳的分类效果。

本文将就信息增益特征选择方法在文本分类中的应用进行深入探讨。

第一,本文就信息增益特征选择方法在文本分类中的应用进行简要阐述。

首先,关于信息增益特征选择方法的基本原理:先计算实例的信息熵,度量实例的不确定性,然后计算当前特征的信息熵,度量特征的信息量,最后计算出新的信息熵,来比较特征的信息增益,从而选择出最佳的特征。

其次,根据不同的文本分类任务,对信息增益特征选择方法进行更进一步的研究。

例如,对于情感分析任务,可以采用信息增益和关联规则方法来挖掘特征,重点挖掘文本中的词语组合、关键词组合等;对于分类任务,可以采用bp神经网络结合信息增益特征选择方法来进行分类,来提高文本分类的准确性。

第二,对近年来信息增益特征选择方法在文本分类中的应用进行总结。

在近几年里,信息增益特征选择法已被广泛应用于文本分类任务中,取得了良好的效果。

例如,Xurongshu et al.(2020)提出了一个新的召回模型,将结构化和非结构化数据相结合,采用Chi-square 信息增益特征选择方法和bp神经网络算法来实现文本分类任务,取得了非常不错的效果。

此外,Chen et al.(2020)基于语义关系,构建了一种新的多级文本分类模型,采用信息增益算法来识别最重要的特征,从而实现文本的高精度分类。

综上所述,信息增益特征选择方法是一种在文本分类中常见的有效的特征选择方法,它能有效提高文本分类的准确性和精度,同时也能最大限度地减少特征和特征之间的相关性,从而获得最佳的分类效果。

文本分类中一种特征选择方法研究

文本分类中一种特征选择方法研究特征选择是文本分类中的一个重要步骤,它的目的是从大量的特征中选出最有区分性的特征,以提高分类器的性能。

在本文中,我们将介绍一种常用的特征选择方法,信息增益和互信息,并探讨它们在文本分类中的应用。

信息增益是一种常见的特征选择方法,它基于信息论的概念。

信息增益的思想是通过计算特征对分类结果的影响程度,从而选择出最能区分不同类别的特征。

信息增益的计算公式如下:$$\text{信息增益} = \text{H}(D) - \text{H}(D,A)$$其中,H(D)表示数据集D中的信息熵,H(D,A)表示在特征A给定的条件下,数据集D中的信息熵。

信息熵的计算公式如下:$$\text{H}(D) = -\sum_{i=1}^{n} p(c_i) \log_2 p(c_i)$$其中,p(c_i)表示类别$c_i$在数据集D中出现的概率。

通过计算不同特征的信息增益,我们可以选择具有最大信息增益的特征作为最终的特征。

这样可以确保选择出的特征能够最大程度地区分不同类别,从而提高分类器的性能。

信息增益的优点是简单易实现,但它存在一个问题,就是它更倾向于选择具有较多取值的特征。

为了克服信息增益方法的不足,互信息被提出作为一种优化的特征选择方法。

互信息的计算公式如下:$$\text{MI}(A, C) = \sum_{a \in A} \sum_{c \in C} P(a, c)\log_2 \left(\frac{P(a, c)}{P(a)P(c)}\right)$$其中,A表示特征集合,C表示类别集合,P(a,c)表示特征$a$和类别$c$的联合概率分布,P(a)和P(c)分别表示特征$a$和类别$c$的边缘概率分布。

互信息的计算方法考虑了特征和类别之间的关联程度,从而能够更准确地选择出最有用的特征。

与信息增益相比,互信息方法更加稳定,能够克服信息增益方法中较多取值特征的偏好。

在文本分类中,信息增益和互信息都可以作为特征选择方法来使用。

文本分类中信息增益特征选择方法的研究

文本分类中信息增益特征选择方法的研究

文本分类是自然语言处理中最火热的应用之一,它主要用于将给定的文本文档(如新

闻文章、电子邮件等)分类到预定的类别中。

传统的文本分类方法经常会用到特征提取和

遴选以形成有效的分类模型,而特征选择对文本分类模型的分类准确率影响极为重大,具

有重要的理论和应用价值。

其中,基于信息增益的特征选择方法是文本分类领域中较为常用且较为具有效果的特

征选策方法。

基于信息增益技术,可以根据特征和类别之间的关系预先计算出每个特征的

信息增益,根据计算结果来决定特征的优先级,从而选择出最有用的特征信息,从而最大

化降低模型的复杂度和增强分类模型的准确率。

值得注意的是,信息增益方法不是一种完美的特征选择方法,有时信息增益也并不是

消除噪声和提高分类准确率的最佳选择。

因此,对于信息增益方法,可以采用其他特征选

择方法,如基于信息增益比(IGR)、熵差、特征权重平均偏差(FWDR)和小波变换熵(WTE)等方法,以提高特征选择的准确性。

此外,还可以通过分析特征的偏置和方差,

以估计特征的稳定性,并根据特征的稳定性来有效地选择特征,以实现更准确的文本分类。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

前文提到过,除了开方检验(CHI)以外,信息增益(IG,Information Gain)也是很有效的特征选择方法。

但凡是特征选择,总是在将特征的重要程度量化之后再进行选择,而如何量化特征的重要性,就成了各种方法间最大的不同。

开方检验中使用特征与类别间的关联性来进行这个量化,关联性越强,特征得分越高,该特征越应该被保留。

在信息增益中,重要性的衡量标准就是看特征能够为分类系统带来多少信息,带来的信息越多,该特征越重要。

才因此先回忆一下信息论中有关信息量(就是“熵”)的定义。

说有这么一个变量X,它可能的取值有n 多种,分别是x1,x2,……,x n,每一种取到的概率分别是P1,P2,……,P n,那么X的熵就定义为:

意思就是一个变量可能的变化越多(反而跟变量具体的取值没有任何关系,只和值的种类多少以及发生概率有关),它携带的信息量就越大(因此我一直觉得我们的政策法规信息量非常大,因为它变化很多,基本朝令夕改,笑)。

对分类系统来说,类别C是变量,它可能的取值是C1,C2,……,C n,而每一个类别出现的概率是P (C1),P(C2),……,P(C n),因此n就是类别的总数。

此时分类系统的熵就可以表示为:

有同学说不好理解呀,这样想就好了,文本分类系统的作用就是输出一个表示文本属于哪个类别的值,而这个值可能是C1,C2,……,C n,因此这个值所携带的信息量就是上式中的这么多。

信息增益是针对一个一个的特征而言的,就是看一个特征t,系统有它和没它的时候信息量各是多少,两者的差值就是这个特征给系统带来的信息量,即增益。

系统含有特征t的时候信息量很好计算,就是刚才的式子,它表示的是包含所有特征时系统的信息量。

问题是当系统不包含t时,信息量如何计算?我们换个角度想问题,把系统要做的事情想象成这样:说教室里有很多座位,学生们每次上课进来的时候可以随便坐,因而变化是很大的(无数种可能的座次情

况);但是现在有一个座位,看黑板很清楚,听老师讲也很清楚,于是校长的小舅子的姐姐的女儿托关系(真辗转啊),把这个座位定下来了,每次只能给她坐,别人不行,此时情况怎样?对于座次的可能情况来说,我们很容易看出以下两种情况是等价的:(1)教室里没有这个座位;(2)教室里虽然有这个座位,但其他人不能坐(因为反正它也不能参与到变化中来,它是不变的)。

对应到我们的系统中,就是下面的等价:(1)系统不包含特征t;(2)系统虽然包含特征t,但是t 已经固定了,不能变化。

我们计算分类系统不包含特征t的时候,就使用情况(2)来代替,就是计算当一个特征t不能变化时,系统的信息量是多少。

这个信息量其实也有专门的名称,就叫做“条件熵”,条件嘛,自然就是指“t已经固定“这个条件。

但是问题接踵而至,例如一个特征X,它可能的取值有n多种(x1,x2,……,x n),当计算条件熵而需要把它固定的时候,要把它固定在哪一个值上呢?答案是每一种可能都要固定一下,计算n个值,然后取均值才是条件熵。

而取均值也不是简单的加一加然后除以n,而是要用每个值出现的概率来算平均(简单理解,就是一个值出现的可能性比较大,固定在它上面时算出来的信息量占的比重就要多一些)。

因此有这样两个条件熵的表达式:

这是指特征X被固定为值x i时的条件熵,

这是指特征X被固定时的条件熵,注意与上式在意义上的区别。

从刚才计算均值的讨论可以看出来,第二个式子与第一个式子的关系就是:

图片看不清楚?请点击这里查看原图(大图)。

具体到我们文本分类系统中的特征t,t有几个可能的值呢?注意t是指一个固定的特征,比如他就是指关键词“经济”或者“体育”,当我们说特征“经济”可能的取值时,实际上只有两个,“经济”要么出现,要么不出现。

一般的,t的取值只有t(代表t出现)和(代表t不出现),注意系统包含t但t 不出现与系统根本不包含t可是两回事。

因此固定t时系统的条件熵就有了,为了区别t出现时的符号与特征t本身的符号,我们用T代表特征,而用t代表T出现,那么:

与刚才的式子对照一下,含义很清楚对吧,P(t)就是T出现的概率,就是T不出现的概率。

这个式子可以进一步展开,其中的

另一半就可以展开为:

因此特征T给系统带来的信息增益就可以写成系统原本的熵与固定特征T后的条件熵之差:

图片看不清楚?请点击这里查看原图(大图)。

公式中的东西看上去很多,其实也都很好计算。

比如P(C i),表示类别C i出现的概率,其实只要用1除以类别总数就得到了(这是说你平等的看待每个类别而忽略它们的大小时这样算,如果考虑了大小就要把大小的影响加进去)。

再比如P(t),就是特征T出现的概率,只要用出现过T的文档数除以总文档数就可以了,再比如P(C i|t)表示出现T的时候,类别C i出现的概率,只要用出现了T并且属于类别C i的文档数除以出现了T的文档数就可以了。

从以上讨论中可以看出,信息增益也是考虑了特征出现和不出现两种情况,与开方检验一样,是比较全面的,因而效果不错。

但信息增益最大的问题还在于它只能考察特征对整个系统的贡献,而不能具体到某个类别上,这就使得它只适合用来做所谓“全局”的特征选择(指所有的类都使用相同的特征集合),而无法做“本地”的特征选择(每个类别有自己的特征集合,因为有的词,对这个类别很有区分度,对另一个类别则无足轻重)。

看看,导出的过程其实很简单,没有什么神秘的对不对。

可有的学术论文里就喜欢把这种本来很直白的东西写得很晦涩,仿佛只有读者看不懂才是作者的真正成功。

咱们是新一代的学者,咱们没有知识不怕被别人看出来,咱们有知识也不怕教给别人。

所以咱都把事情说简单点,说明白点,大家好,才是真的好。

系列文章:

文本分类入门(一)文本分类问题的定义

文本分类入门(二)文本分类的方法

文本分类入门(三)统计学习方法

文本分类入门(四)训练Part 1

文本分类入门(五)训练Part 2

文本分类入门(六)训练Part 3

文本分类入门(七)相关概念总结

文本分类入门(八)中英文文本分类的异同

文本分类入门(九)文本分类问题的分类

文本分类入门(十)特征选择算法之开方检验。