AdaBoost算法及应用

数据挖掘领域十大经典算法以及适用领域

数据挖掘领域⼗⼤经典算法以及适⽤领域1.AdaboostAdaboost算法是⼀种提升⽅法,将多个弱分类器,组合成强分类器。

AdaBoost,是英⽂”Adaptive Boosting“(⾃适应增强)的缩写,由Yoav Freund和Robert Schapire在1995年提出。

它的⾃适应在于:前⼀个弱分类器分错的样本的权值(样本对应的权值)会得到加强,权值更新后的样本再次被⽤来训练下⼀个新的弱分类器。

在每轮训练中,⽤总体(样本总体)训练新的弱分类器,产⽣新的样本权值、该弱分类器的话语权,⼀直迭代直到达到预定的错误率或达到指定的最⼤迭代次数。

总体——样本——个体三者间的关系需要搞清除总体N。

样本:{ni}i从1到M。

个体:如n1=(1,2),样本n1中有两个个体。

算法原理(1)初始化训练数据(每个样本)的权值分布:如果有N个样本,则每⼀个训练的样本点最开始时都被赋予相同的权重:1/N。

(2)训练弱分类器。

具体训练过程中,如果某个样本已经被准确地分类,那么在构造下⼀个训练集中,它的权重就被降低;相反,如果某个样本点没有被准确地分类,那么它的权重就得到提⾼。

同时,得到弱分类器对应的话语权。

然后,更新权值后的样本集被⽤于训练下⼀个分类器,整个训练过程如此迭代地进⾏下去。

(3)将各个训练得到的弱分类器组合成强分类器。

各个弱分类器的训练过程结束后,分类误差率⼩的弱分类器的话语权较⼤,其在最终的分类函数中起着较⼤的决定作⽤,⽽分类误差率⼤的弱分类器的话语权较⼩,其在最终的分类函数中起着较⼩的决定作⽤。

换⾔之,误差率低的弱分类器在最终分类器中占的⽐例较⼤,反之较⼩。

优点(1)精度很⾼的分类器(2)提供的是框架,可以使⽤各种⽅法构建弱分类器(3)简单,不需要做特征筛选(4)不⽤担⼼过度拟合实际应⽤(1)⽤于⼆分类或多分类(2)特征选择(3)分类⼈物的baseline2.C4.5C4.5是决策树算法的⼀种。

决策树算法作为⼀种分类算法,⽬标就是将具有p维特征的n个样本分到c个类别中去。

adaboost违约概率公式

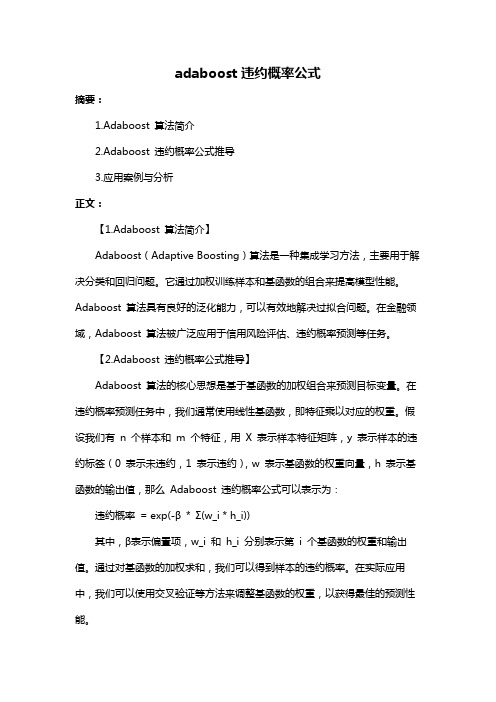

adaboost违约概率公式摘要:1.Adaboost 算法简介2.Adaboost 违约概率公式推导3.应用案例与分析正文:【1.Adaboost 算法简介】Adaboost(Adaptive Boosting)算法是一种集成学习方法,主要用于解决分类和回归问题。

它通过加权训练样本和基函数的组合来提高模型性能。

Adaboost 算法具有良好的泛化能力,可以有效地解决过拟合问题。

在金融领域,Adaboost 算法被广泛应用于信用风险评估、违约概率预测等任务。

【2.Adaboost 违约概率公式推导】Adaboost 算法的核心思想是基于基函数的加权组合来预测目标变量。

在违约概率预测任务中,我们通常使用线性基函数,即特征乘以对应的权重。

假设我们有n 个样本和m 个特征,用X 表示样本特征矩阵,y 表示样本的违约标签(0 表示未违约,1 表示违约),w 表示基函数的权重向量,h 表示基函数的输出值,那么Adaboost 违约概率公式可以表示为:违约概率= exp(-β* Σ(w_i * h_i))其中,β表示偏置项,w_i 和h_i 分别表示第i 个基函数的权重和输出值。

通过对基函数的加权求和,我们可以得到样本的违约概率。

在实际应用中,我们可以使用交叉验证等方法来调整基函数的权重,以获得最佳的预测性能。

【3.应用案例与分析】为了验证Adaboost 算法在违约概率预测任务中的性能,我们可以选取某银行的信用卡客户数据作为样本。

首先,我们需要对数据进行预处理,包括缺失值填充、特征缩放等。

然后,我们可以将数据分为训练集和测试集,使用训练集来训练Adaboost 模型,并使用测试集来评估模型的预测性能。

在训练模型时,我们可以选取线性基函数作为特征映射函数,并使用梯度下降法来调整基函数的权重。

在测试模型时,我们可以使用Adaboost 违约概率公式来计算样本的违约概率,并与实际违约情况进行对比,以评估模型的预测准确性。

adaboostclassifier()介绍

adaboostclassifier()介绍摘要:1.AdaBoost 简介2.AdaBoost 算法原理3.AdaBoost 应用实例4.AdaBoost 优缺点正文:1.AdaBoost 简介AdaBoost(Adaptive Boosting)是一种自适应的集成学习算法,主要用于解决分类和回归问题。

它通过组合多个基本分类器(弱学习器)来提高预测性能,可以有效地解决单个分类器准确率不高的问题。

AdaBoost 算法在机器学习领域被广泛应用,尤其是在图像识别、文本分类等任务中取得了很好的效果。

2.AdaBoost 算法原理AdaBoost 算法的核心思想是加权训练样本和加权弱学习器。

在每一轮迭代过程中,算法会根据样本的权重来调整训练样本,使得错误分类的样本在下一轮中拥有更高的权重。

同时,算法会根据弱学习器的权重来调整弱学习器的重要性,使得表现更好的弱学习器在下一轮中拥有更高的权重。

这个过程会一直进行,直到达到预设的迭代次数。

具体来说,AdaBoost 算法包括以下步骤:(1) 初始化:设置初始权重,通常为等权重。

(2) 迭代:a.根据样本权重,对训练样本进行加权抽样。

b.训练弱学习器,得到弱学习器的预测结果。

c.更新样本权重,将错误分类的样本权重增加,正确分类的样本权重减小。

d.更新弱学习器权重,将表现更好的弱学习器权重增加,表现较差的弱学习器权重减小。

(3) 终止条件:达到预设的迭代次数或满足其他终止条件。

(4) 集成:将多个弱学习器进行集成,得到最终的预测结果。

3.AdaBoost 应用实例AdaBoost 算法在许多领域都有广泛应用,例如:(1) 图像识别:在计算机视觉领域,AdaBoost 算法被广泛应用于图像识别任务,尤其是人脸识别、车牌识别等。

(2) 文本分类:在自然语言处理领域,AdaBoost 算法可以用于文本分类任务,例如情感分析、垃圾邮件过滤等。

(3) 语音识别:在语音识别领域,AdaBoost 算法可以用于声学模型的训练,提高语音识别的准确率。

r语言adaboost的shap模型解释

“R语言Adaboost的SHAP模型解释”一、介绍Adaboost是一种经典的集成学习算法,旨在通过串行训练多个弱分类器来提升整体分类性能。

而SHAP(SHapley Additive exPlanations)模型解释则是一种用于解释机器学习模型预测的方法,它基于博弈论中的Shapley值理论,可以帮助我们理解模型预测结果背后的因果关系。

本文将围绕R语言中Adaboost算法与SHAP模型解释的结合,从深度和广度兼具的角度展开全面评估,并撰写一篇有价值的文章。

二、从简到繁:Adaboost算法的基本原理和应用1. Adaboost的基本原理Adaboost算法通过迭代训练多个弱分类器,并加权组合它们的预测结果来增强整体分类性能。

在每一轮迭代中,样本的权重会根据前一轮分类器的表现进行调整,以便更加聚焦于被错误分类的样本。

这种串行训练的方式可以在保持高效性的同时提升分类器的准确性。

2. Adaboost的应用场景Adaboost算法在实际应用中广泛用于人脸检测、目标识别和文本分类等领域。

由于其对弱分类器的要求相对较低,使得Adaboost算法在处理大规模数据时具有较高的计算效率。

三、由浅入深:SHAP模型解释的原理与应用3. SHAP模型解释的原理SHAP模型解释的核心理论是Shapley值,它通过博弈论中的合作博弈概念来对每个特征对模型预测结果的贡献进行量化。

通过计算每个特征值对应的Shapley值,我们可以清晰地了解每个特征对模型预测的影响程度。

4. SHAP模型解释的应用场景SHAP模型解释在解释机器学习模型预测结果时具有重要意义,特别是对于具有较高复杂性的模型,如集成学习算法和深度学习模型。

它可以帮助我们理解模型对于不同特征的敏感度,从而为进一步优化模型提供有力的参考。

四、Adaboost与SHAP模型解释的结合与个人观点5. Adaboost与SHAP模型解释的结合将Adaboost算法与SHAP模型解释相结合,可以帮助我们更全面地理解模型预测结果。

adaboostclassifier()介绍

adaboostclassifier()介绍摘要:1.介绍Adaboost 分类器2.Adaboost 的工作原理3.Adaboost 的优势和应用领域4.如何在Python 中使用Adaboost 分类器正文:Adaboost 分类器是一种非常强大的机器学习算法,它可以用来解决分类问题。

它的全称是"Adaptive Boosting",是一种自适应增强技术。

Adaboost 的工作原理是通过组合多个弱分类器来构建一个更强大的分类器。

这些弱分类器是通过训练数据集的子集得到的,而每个子集的样本都是通过随机抽样得到的。

在训练过程中,Adaboost 算法会根据每个弱分类器的性能来调整它们的权重,从而使分类器能够更好地拟合数据集。

Adaboost 的优势在于它可以处理数据集中存在的噪声和异常值,而且对于数据集中不同类别的样本,它可以自动调整分类器的权重,从而提高分类器的性能。

因此,Adaboost 分类器在文本分类、垃圾邮件分类、图像分类等领域都取得了很好的效果。

在Python 中,我们可以使用scikit-learn 库中的AdaboostClassifier 类来创建和使用Adaboost 分类器。

首先,需要导入所需的库,然后使用fit 方法来训练分类器,最后使用predict 方法来对新的数据进行分类。

例如,以下代码展示了如何使用scikit-learn 库中的AdaboostClassifier类来创建一个Adaboost 分类器,并对Iris 数据集进行分类:```pythonfrom sklearn.datasets import load_irisfrom sklearn.ensemble import AdaboostClassifierfrom sklearn.model_selection import train_test_split# 加载Iris 数据集iris = load_iris()X = iris.datay = iris.target# 将数据集划分为训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)# 创建Adaboost 分类器adaboost = AdaboostClassifier()# 使用训练集训练分类器adaboost.fit(X_train, y_train)# 使用测试集进行预测y_pred = adaboost.predict(X_test)# 计算分类器的准确率accuracy = adaboost.score(X_test, y_test)print("Accuracy: {:.2f}".format(accuracy * 100))```总之,Adaboost 分类器是一种非常有用的机器学习算法,它通过组合多个弱分类器来构建一个更强大的分类器,可以有效地处理数据集中的噪声和异常值,提高分类器的性能。

adaboost算法参数

adaboost算法参数【原创版】目录1.AdaBoost 算法概述2.AdaBoost 算法的参数3.参数的作用及对算法性能的影响4.实际应用中的参数选择正文一、AdaBoost 算法概述AdaBoost(Adaptive Boosting)算法是一种自适应的集成学习算法,它可以将多个基本分类器(如决策树、SVM 等)组合成一个更强的集成分类器。

AdaBoost 算法的主要思想是加权训练样本和加权弱学习器,以提高分类准确率。

它具有较强的泛化能力,可以有效地解决数据不平衡和过拟合问题。

二、AdaBoost 算法的参数AdaBoost 算法有两个主要的参数:正则化参数α和迭代次数 T。

1.正则化参数α:α是一个超参数,用于控制弱学习器的权重。

它决定了每个训练样本对应的弱学习器的权重,从而影响到最终集成分类器的性能。

较小的α值会使得弱学习器更关注误分类的训练样本,提高模型的泛化能力;较大的α值则会使得弱学习器更关注分类准确的训练样本,提高模型在训练集上的准确率。

2.迭代次数 T:T 表示 AdaBoost 算法迭代训练的次数。

每次迭代都会根据当前弱学习器的预测错误率来生成一个新的训练样本分布,使得后续的弱学习器更加关注误分类的训练样本。

增加迭代次数 T 可以提高模型的准确率,但也会增加计算复杂度。

三、参数的作用及对算法性能的影响AdaBoost 算法的参数对模型的性能具有重要影响。

合适的参数设置可以使得模型在训练集和测试集上都取得较好的性能,而过度调参则可能导致模型过拟合或欠拟合。

正则化参数α的取值影响着弱学习器的权重分配,从而影响到模型的泛化能力。

较小的α值会使得弱学习器更关注误分类的训练样本,提高模型的泛化能力;较大的α值则会使得弱学习器更关注分类准确的训练样本,提高模型在训练集上的准确率。

迭代次数 T 的取值影响着模型的训练过程。

增加迭代次数可以使得模型更加关注误分类的训练样本,提高模型的准确率;但过多的迭代次数会增加计算复杂度,可能导致模型过拟合。

AdaBoost算法分析及简单应用

机器学习课程结课论文学号、专业:姓名: yan** 论文题目: Adaboost算法分析及简单应用指导教师:杨** 所属学院:电子工程与自动化学院成绩评定教师签名桂林电子科技大学研究生院年月日Adaboost算法分析及简单应用Yan**(桂林电子科技大学电子工程与自动化学院广西桂林 541004)摘要:本文主要阐述了在数据挖掘领域中十个主要的分类算法之一——Adaboost的来源、发展,以及开发应用,然后介绍了在该算法的训练过程中一个简单的应用,最后对该算法进行了简单评价。

关键词:Adaboost算法;发展背景;训练过程;性能改进;分类算法Analysis of the algorithm and its simple applicationYan**School of electronic engineering and automation of Guilin University of Electronic Technology, Guilin 541004, China Abstract:This paper mainly describes one of the ten main classification algorithm in datea mining ——Adaboost. Firstly, it introduces the origin, development and application, then introduces the main training process of the algorithm, simple application and finally discusses the algorithm simply.Keywords: Adaboost algorithm; development background; training process; performance improvement; classification algorithm1 引言在1990年,Schapire提出了Boosting算法,次年Freund改进Boosting 算法,这两种算法存在共同的实践上的缺陷,那就是都要求事先知道弱学习算法学习正确率的下限。

adaboost分类算法

adaboost分类算法Adaboost(Adaptive Boosting)是一种机器学习中常用的集成学习算法。

它通过迭代训练多个弱分类器来构建一个强分类器,每个弱分类器都专注于被前一个分类器分错的样本,从而提高整体分类的准确率。

本文将详细介绍Adaboost 算法的原理、步骤以及应用场景。

一、Adaboost算法原理Adaboost通过迭代训练多个弱分类器,并根据每个分类器的分类错误率来调整样本的权重,从而构建出一个强分类器。

其基本思想是将若干个分类器进行组合,每个分类器按照一定的权重进行加权求和,最终得到分类结果。

具体来说,Adaboost算法通过以下几个步骤完成分类过程:1. 初始化样本权重:对于给定的训练数据集,给每个样本分配一个初始的权重,初始时可以将每个样本的权重设置为相等。

2. 训练弱分类器:选择一个弱分类器作为基分类器,并根据当前样本的权重进行训练。

训练过程中,会根据分类结果的准确性更新样本权重。

3. 更新样本权重:根据上一步训练得到的弱分类器,计算误差率,并根据误差率调整每个样本的权重。

分类正确的样本权重会减小,分类错误的样本权重会增大。

这样,下一轮迭代时,分类器会更加关注被错误分类的样本。

4. 更新分类器权重:根据误差率计算当前分类器的权重,权重与误差率成负相关,误差率越低,分类器权重越高。

5. 归一化分类器权重:对分类器权重进行归一化处理,使得所有分类器的权重之和为1。

6. 终止条件:根据事先设定的迭代次数或错误率阈值,判断是否满足终止条件。

如果不满足,返回第2步,继续训练新的弱分类器;如果满足,则将所有弱分类器组合成一个强分类器。

二、Adaboost算法步骤详解1. 初始化样本权重在Adaboost算法中,每个样本都有一个对应的权重,初始时可以将每个样本的权重设置为相等。

这样做的目的是保证每个样本在开始的时候都有相同的重要性,不会因为某些样本的权重过大而引起偏差。

2. 训练弱分类器在Adaboost算法中,弱分类器可以选择多种,如决策树、神经网络等。

AdaBoost算法原理与使用场景

AdaBoost算法原理与使用场景AdaBoost(Adaptive Boosting)算法是一种常见的集成学习算法,它通过结合多个弱学习器来构建一个强学习器,被广泛应用于各种机器学习领域。

本文将介绍AdaBoost算法的原理和使用场景。

一、原理1.1 弱学习器的构建在AdaBoost算法中,我们需要使用多个弱学习器,这些弱学习器可以是任何能够做出有意义的预测的模型,比如决策树、朴素贝叶斯等。

我们一般选择使用决策树作为弱学习器,因为决策树容易生成并且训练快。

为了让每个弱学习器能够有不同的预测能力,我们需要对训练集进行加权。

初始时,所有样本的权重都是相同的。

在每一轮迭代中,我们根据上一轮的分类结果来调整每个样本的权重。

被错误分类的样本权重会增加,而被正确分类的样本权重则会减小。

1.2 加权平均法在构建多个决策树后,我们需要将所有的弱学习器进行加权平均。

对于每个训练样本,我们根据各个弱学习器的权重对样本进行分类,然后对所有弱学习器的分类结果进行加权平均,得到最终的预测结果。

1.3 重要性加权法由于AdaBoost算法使用加权平均法来构建分类器,所以在每个弱学习器中,我们需要为每个样本赋予一个重要性权重。

重要性权重是根据样本在前一轮中被错误分类的次数来确定的。

被错误分类的样本会得到一个较大的权重,而被正确分类的样本会得到一个较小的权重。

二、使用场景AdaBoost算法在各种机器学习场景中都有着广泛的应用。

比如在图像分割中,我们可以使用AdaBoost算法来识别和分割不同的图像区域。

在文本分类中,我们可以使用AdaBoost算法来对不同文本的内容进行分类。

此外,AdaBoost算法还可以被用于各种预测领域,如股票趋势分析、信用评估等。

三、总结AdaBoost算法是一种高效的集成学习算法,它的原理简单、易于理解,并且在各种机器学习场景中都有着广泛的应用。

通过使用AdaBoost算法,我们可以结合多个弱学习器来构建一个强学习器,从而提高分类的准确性和稳定性。

adaboost算法公式

adaboost算法公式Adaboost算法是一种常用的集成学习方法,它通过结合多个弱分类器来构建一个强分类器。

该算法在机器学习领域有着广泛的应用,本文将介绍Adaboost算法的原理和应用。

Adaboost算法的基本思想是通过迭代训练一系列弱分类器,并根据分类器的性能对训练样本进行加权,使得分类器对分类错误的样本有更高的关注度。

在每一轮迭代中,Adaboost算法会根据上一轮分类器的性能调整样本的权重,使得分类错误的样本在下一轮训练中更有可能被正确分类。

最终,将所有弱分类器的结果进行加权组合,得到一个强分类器。

Adaboost算法的具体步骤如下:Step1:初始化样本权重。

将每个样本的权重初始化为相等值,表示对每个样本的关注度相同。

Step2:迭代训练弱分类器。

在每一轮迭代中,Adaboost算法会根据上一轮分类器的性能调整样本的权重,并使用调整后的样本训练一个新的弱分类器。

具体来说,对于分类错误的样本,其权重会增加,而对于分类正确的样本,其权重会减小。

Step3:计算弱分类器权重。

根据每个弱分类器的分类错误率,计算其权重,错误率越低的分类器权重越高。

Step4:组合弱分类器。

将所有弱分类器的结果进行加权组合,得到一个强分类器。

加权的方式可以根据弱分类器的权重进行。

Adaboost算法的优点在于可以有效地提高分类器的性能,尤其在处理复杂的分类问题时表现出色。

其原理基于对样本的加权处理,能够更加关注分类错误的样本,从而提高分类的准确率。

此外,Adaboost算法还具有较强的泛化能力,能够很好地适应新的样本数据。

Adaboost算法的应用非常广泛,尤其在人脸识别、目标检测和文本分类等领域取得了很好的效果。

在人脸识别中,Adaboost算法可以通过训练一系列弱分类器来检测人脸的关键特征点,从而实现人脸的准确识别。

在目标检测中,Adaboost算法可以通过训练一系列弱分类器来检测目标物体的存在与否,从而实现目标的自动识别。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

i 1

• Update distribution: Dt 1 (i )

T Output final classifier: sign H ( x) t ht ( x) t 1

ATTENTIONAL CASCADE

单独一个AdaBoost分类器即使很强,在误检率和检测时间上根本满足不 了真正的实时人脸检测系统的需要。采用级联检测策略能很好地解决这 个问题。Adaboost算法引入了一种瀑布型的分类器---级联分类器。 在级联分类器中,每一个待检测窗口只有通过了当前层的强分类器 (AdaBoost分类器)才能进入下一层。这样大量的待检测窗口只需要最 初几层简单的判断就可以被迅速淘汰,使得平均检测成本大大降低。多 层级联结构中,每一层的强分类器都是由AdaBoost算法训练来的。

f1 , d1

IMAGE SUB-WINDOW

Classifier 1 T

f2 , d2

Classifier 2 T

f3 , d3

Classifier 3 T

F, D

FACE

F NON-FACE

F NON-FACE

Weights Increased

BOOSTING ILLUSTRATION

Weak Classifier 2

BOOSTING ILLUSTRATION

Weights Increased

BOOSTING ILLUSTRATION

Weak Classifier 3

BOOSTING ILLUSTRATION

IMAGE SUB-WINDOW

Classifier 1

T

Classifier 2

T

Classifier 3

T

FACE

F NON-FACE

F NON-FACE

F NON-FACE

ATTENTIONAL CASCADE

ROC Curve

% Detection

Chain classifiers that are progressively more complex and have lower false positive rates

. . .

H T ( x) sign t ht ( x) t 1

训练一个弱分类器(特征f)就 是在当前权重分布的情况下,确定f 的最优阈值以及不等号的方向,使 得这个弱分类器(特征f)对所有训 strong classifier 练样本的分类误差最低。

1 pf ( x ) p h ( x, f , p , ) 0其他 T

. . .

T H T ( x) sign t ht ( x) t 1

hT ( x) {1, 1}

weak classifiers

slightly better than random

strong classifier

WEAKER CLASSIFIERS

h1 ( x) {1, 1} h2 ( x) {1, 1}

Given: ( x1 , y1 ),, ( xm , ym ) where xi X , yi {1, 1}

1 Initialization: D1 (i) m , i 1,, m

Dt (i):probability distribution of xi 's at time t

For t 1,, T :

• Find classifier ht : X {1, 1} which minimizes error wrt Dt ,i.e.,

ht arg min j where j Dt (i )[ yi h j ( xi )]

hj

m

minimize weighted error

Final classifier is a combination of weak classifiers

AdaBoost for Face Detection

ADABOOST & ITS APPLICATIONS

THE TASK OF FACE DETECTION

Many slides adapted from P. Viola

THE VIOLA/JONES FACE DETECTOR

2001年,Viola和Jones利用类Haar特征构造弱分类器,使 用AdaBoost算法把弱分类器组合成强分类器,采用 Cascade结构把强分类器串联组合成级联分类器,实现了 准实时的人脸检测。

P. Viola and M. Jones. Rapid object detection using a boosted cascade of simple features. CVPR 2001. P. Viola and M. Jones. Robust real-time face detection. IJCV 57(2), 2004.

THE ADABOOST ALGORITHM

Given: ( x1 , y1 ),, ( xm , ym ) where xi X , yi {1, 1}

1 Initialization: D1 (i) m , i 1,, m

For t 1,, T :

• Find classifier ht : X {1, 1} which minimizes error wrt Dt ,i.e.,

i 1

• Update distribution: Dt 1 (i )

T Output final classifier: sign H ( x) t ht ( x) t 1

BOOSTING ILLUSTRATION

Weak Classifier 1

BOOSTING ILLUSTRATION

ht arg min j where j Dt (i )[ yi h j ( xi )]

hj

m

• Weight classifier: t

1 1 t ln 2 t Dt (i ) exp[ t yi ht ( xi )] , Z t is for normalization Zt

hT ( x) {1, 1}

weak classifiers

slightly better than random

THE STRONG CLASSIFIERS

h1 ( x) {1, 1} h2 ( x) {1, 1}

. . .

T H T ( x) sign t ht ( x) t 1

特征3

1 1 1 分布 0.35 0.15 0.25 0.25 1 1

排序

结果 -1 1 错误率 0

错误率 0.15

标记

1

1

-1

1

“好中取最好” 最终选定特征3及其阈值构 成弱分类器

分布 0.15 0.25 排序 结果 1 1

0.35 0.25 -1 -1

错误率 0.25

特征2

THE ADABOOST ALGORITHM

hT ( x) {1, 1}

weak classifiers

slightly better than random

strong classifier

The AdaBoost Algorithm

ADABOOST & ITS APPLICATIONS

THE ADABOOSTRES

Feature Value (Pixel in white area)

(Pixel in black area) 将任意一个矩形放到人脸区域上,然后将

白色区域的像素和减去黑色区域的像素和, 得到的值我们暂且称之为人脸特征值。

Rectangle filters

Given: ( x1 , y1 ),, ( xm , ym ) where xi X , yi {1, 1}

1 Initialization: D1 (i) m , i 1,, m

For t 1,, T :

• Find classifier ht : X {1, 1} which minimizes error wrt Dt ,i.e.,

2×2 image

ADABOOST 在人脸检测中的应用

+1

1类

-1

…

-1类

计算特征值

特征值排序

1类 考虑方向 -1类 or

-1类

1类

穷举找到最佳阈值

发挥出每个Haar特征的最好效果

特征1

标记 1 -1 1 1 标记 -1 分布 0.15 0.35 排序 结果 -1 -1 0.25 0.25 1 1

• Weight classifier: t

1 1 t ln 2 t

i 1

for minimize exponential loss

• Update distribution: Dt 1 (i )

Dt (i ) exp[ t yi ht ( xi )] , Z t is for normalization Zt Give error classified patterns more chance for learning.

F f i , D di

i 1 i 1

K

K

The detection rate and the false positive rate of the cascade are found by multiplying the respective rates of the individual stages A detection rate of 0.9 and a false positive rate on the order of 106 can be achieved by a 10-stage cascade if each stage has a detection rate of 0.99 (0.9910 ≈ 0.9) and a false positive rate of about 0.30 (0.310 ≈ 6106 )