信息论测试题及答案

信息论试卷含答案资料讲解

《信息论基础》参考答案一、填空题(共15分,每空1分)1、信源编码的主要目的是提高有效性,信道编码的主要目的是提高可靠性。

2、信源的剩余度主要来自两个方面,一是信源符号间的相关性,二是信源符号的统计不均匀性。

3、三进制信源的最小熵为0,最大熵为32log bit/符号。

4、无失真信源编码的平均码长最小理论极限制为信源熵(或H(S)/logr= H r (S))。

5、当R=C 或(信道剩余度为0)时,信源与信道达到匹配。

6、根据信道特性是否随时间变化,信道可以分为恒参信道和随参信道。

7、根据是否允许失真,信源编码可分为无失真信源编码和限失真信源编码。

8、若连续信源输出信号的平均功率为2σ,则输出信号幅度的概率密度是高斯分布或正态分布或()222x f x σ-=时,信源具有最大熵,其值为值21log 22e πσ。

9、在下面空格中选择填入数学符号“,,,=≥≤〉”或“〈”(1)当X 和Y 相互独立时,H (XY )=H(X)+H(X/Y)=H(Y)+H(X)。

(2)()()1222H X X H X =≥()()12333H X X X H X = (3)假设信道输入用X 表示,信道输出用Y 表示。

在无噪有损信道中,H(X/Y)> 0, H(Y/X)=0,I(X;Y)<H(X)。

二、(6分)若连续信源输出的幅度被限定在【2,6】区域内,当输出信号的概率密度是均匀分布时,计算该信源的相对熵,并说明该信源的绝对熵为多少。

()1,2640,x f x ⎧≤≤⎪=⎨⎪⎩Q 其它()()()62log f x f x dx ∴=-⎰相对熵h x=2bit/自由度该信源的绝对熵为无穷大。

三、(16分)已知信源1234560.20.20.20.20.10.1S s s s s s s P ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦(1)用霍夫曼编码法编成二进制变长码;(6分) (2)计算平均码长L ;(4分)(3)计算编码信息率R ';(2分)(4)计算编码后信息传输率R ;(2分) (5)计算编码效率η。

《信息论》试题及答案

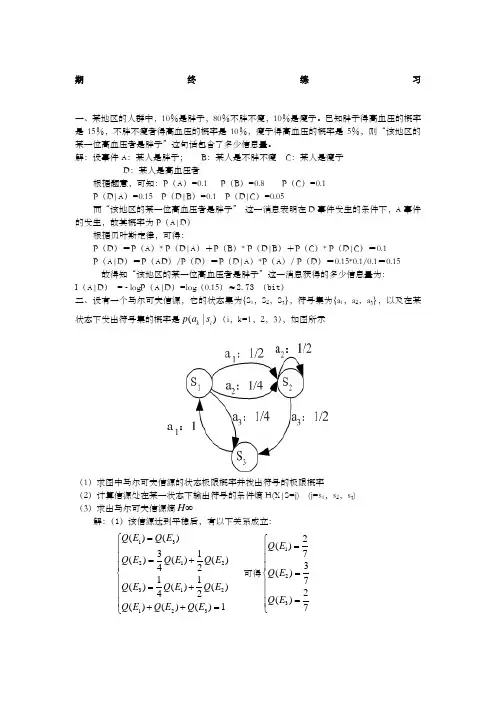

期终练习一、某地区的人群中,10%是胖子,80%不胖不瘦,10%是瘦子。

已知胖子得高血压的概率是15%,不胖不瘦者得高血压的概率是10%,瘦子得高血压的概率是5%,则“该地区的某一位高血压者是胖子”这句话包含了多少信息量。

解:设事件A :某人是胖子; B :某人是不胖不瘦 C :某人是瘦子 D :某人是高血压者根据题意,可知:P (A )=0.1 P (B )=0.8 P (C )=0.1 P (D|A )=0.15 P (D|B )=0.1 P (D|C )=0.05而“该地区的某一位高血压者是胖子” 这一消息表明在D 事件发生的条件下,A 事件的发生,故其概率为P (A|D )根据贝叶斯定律,可得:P (D )=P (A )* P (D|A )+P (B )* P (D|B )+P (C )* P (D|C )=0.1 P (A|D )=P (AD )/P (D )=P (D|A )*P (A )/ P (D )=0.15*0.1/0.1=0.15 故得知“该地区的某一位高血压者是胖子”这一消息获得的多少信息量为: I (A|D ) = - logP (A|D )=log (0.15)≈2.73 (bit ) 二、设有一个马尔可夫信源,它的状态集为{S 1,S 2,S 3},符号集为{a 1,a 2,a 3},以及在某状态下发出符号集的概率是(|)k i p a s (i ,k=1,2,3),如图所示(1)求图中马尔可夫信源的状态极限概率并找出符号的极限概率(2)计算信源处在某一状态下输出符号的条件熵H(X|S=j) (j=s 1,s 2,s 3) (3)求出马尔可夫信源熵H ∞解:(1)该信源达到平稳后,有以下关系成立:13212312123()()31()()()4211()()()42()()()1Q E Q E Q E Q E Q E Q E Q E Q E Q E Q E Q E =⎧⎪⎪=+⎪⎨⎪=+⎪⎪++=⎩可得1232()73()72()7Q E Q E Q E ⎧=⎪⎪⎪=⎨⎪⎪=⎪⎩3111322133313()()(|)72()()(|)73()()(|)7i i i i i i i i i p a Q E p a E p a Q E p a E p a Q E p a E =========∑∑∑(2)311113222133331(|)(|)log (|) 1.5bit/(|)(|)log (|)1bit/(|)(|)log (|)0bit/k k k kk k k k k H X S p a S p a S H X S p aS p a S H X S p a S p a S ====-==-==-=∑∑∑(符号)(符号)(符号)(3)31()(|)2/7*3/23/7*12/7*06/7iii H Q E H X E ∞==⨯=++=∑(比特/符号)三、二元对称信道的传递矩阵为0.60.40.40.6⎡⎤⎢⎥⎣⎦(1)若P(0)=3/4,P(1)=1/4,求H (X ),H (X|Y )和I (X ;Y )(2)求该信道的信道容量及其最大信道容量对应的最佳输入分布 解:⑴()H X =21()log ()iii p x p x ==-∑=0.75log 750.25log 25--≈0.811(比特/符号)1111212()()(|)()(|)p y p x p y x p x p y x =+=0.75*0.6+0.25*0.4=0.55 2121222()()(|)()(|)p y p x p y x p x p y x =+=0.75*0.4+0.25*0.6=0.45()0.55log0.550.45log0.45H Y =--=≈0.992(比特/符号)122(|)()(|)()(|)0.75(0.6,0.4)0.25(0.4,0.6)(0.6log 0.60.4log 0.4)0.971/H Y X p x H Y x p x H Y x H H =+=⨯+⨯=-+≈(比特符号)(|)()()()(|)()H X Y H XY H Y H X H Y X H Y =-=+-≈0.811+0.971-0.992=0.79 (比特/符号)I(X;Y)=H(X)-H(X|Y)=0.811-0.79=0.021(比特/符号) (2)此信道为二元对称信道,所以信道容量为C=1-H(p)=1-H(0.6)=1-0.971=0.029(比特/符号) 当输入等概分布时达到信道容量四、求信道22042240 p pp pεεεεεε⎡⎤--⎢⎥--⎢⎥⎣⎦的信道容量,其中1p p=-。

《信息论》期末考试试题( 卷)标准答案

。

4) R(D)是满足 D 准则下平均传送每信源符号的所需的最少比特数,它是定义域 上的严格递减函数。

5) AWGN 信道下实现可靠通信的信噪比下界为-1.59dB,此时对应的频谱利用率 为 0。

6)若某离散无记忆信源有 N 个符号,并且每个符号等概出现,对这个信源进行 二元 Huffman 编码,当 N = 2i (i 是正整数)时,每个码字的长度是 i ,平 均码长是 i 。

2 1) 求此马氏源的平稳分布;(4 分) 2) 求此马氏源的熵;(3 分) 3)求平稳马氏源的二次扩展源的所有符号概率;(3 分) 4)对此二次扩展源进行二元 Huffman 编码并求编码后平均码长和编码效率。 (3+2 分)

解:

1) 此马氏源的平稳分布: (π1

π2

π3

) =(1 3

1 3

1 3

)

3 × 1 × (− 1 log 1 − 1 log 1 − 1 log 1) = 1.5比特/信源符号 2) 此马氏源的熵: 3 2 2 4 4 4 4

3)平稳马氏源的二次扩展源的所有符号及概率为: p(x1x2 ) = p(x1 ) p(x2 x1)

1 00: 6

1 11: 6

1 22: 6

编码效率为: l 19

2.(共 10 分)有两枚硬币,第一枚是正常的硬币,它的一面是国徽,另一面是 面值;第二枚是不正常的硬币,它的两面都是面值。现随机地抽取一枚硬币,进 行 2 次抛掷试验,观察硬币朝上的一面,其结果为:面值、面值。

1)求该试验结果与事件“取出的是第一枚硬币”之间的互信息;(4 分)

1) 求该信道的信道容量;(2 分)

2) 当传输速率达到容量时,确定 M 与 n 的关系。(2 分)

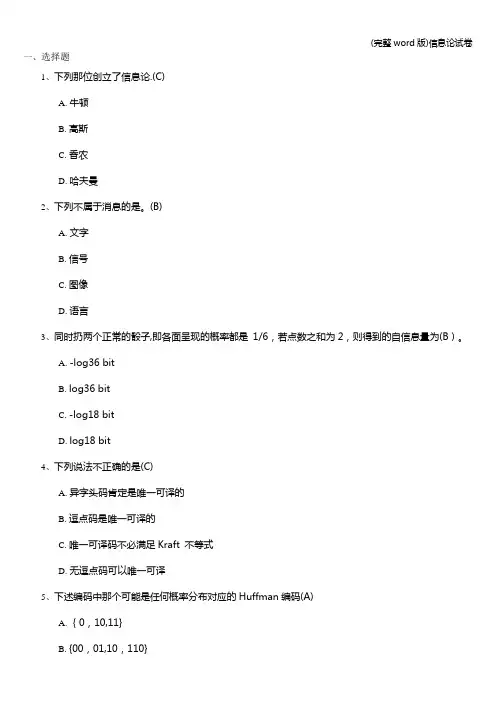

(完整word版)信息论试卷

一、选择题1、下列那位创立了信息论.(C)A.牛顿B.高斯C.香农D.哈夫曼2、下列不属于消息的是。

(B)A.文字B.信号C.图像D.语言3、同时扔两个正常的骰子,即各面呈现的概率都是1/6,若点数之和为2,则得到的自信息量为(B)。

A.-log36 bitB.log36 bitC.-log18 bitD.log18 bit4、下列说法不正确的是(C)A.异字头码肯定是唯一可译的B.逗点码是唯一可译的C.唯一可译码不必满足Kraft 不等式D.无逗点码可以唯一可译5、下述编码中那个可能是任何概率分布对应的Huffman编码(A)A.{0,10,11}B.{00,01,10,110}C.{01,10}D.{001,011,100,101}6、下列物理量不满足非负性的是(D)A.H(X)B.I(X;Y)C.H(Y|X)D.I(x j;y j)7、信源的输出与信道的输入匹配的目的不包括(D)A.符号匹配B.信息匹配C.降低信道剩余度D.功率匹配8、在串联系统中,有效信息量的值(B)A.趋于变大B.趋于变小C.不变D.不确定二、判断题1、信息论研究的主要问题是在通信系统设计中如何实现信息传输、存储和处理的有效性和可靠性。

(T)2、信息是先验概率和后验概率的函数,信息量是事件数目的指数函数。

(F)提示:对数函数3、两个事件之间的互信息量可正,可负,也可能为0。

(T)4、在通讯系统中,无论对接收到的信息怎样处理,信息只会减少,绝不可能增加。

(T )5、Huffman 编码是唯一的.(F)提示:不唯一6、概率大的事件自信息量大。

(F )提示:小7、在事件个数相同条件下,事件等概率出现情况下的熵值最大。

(T)8、平稳的离散无记忆信道不可用一维概率描述。

(F)提示:可以三、填空题1、必然事件的自信息是 0 .2、根据码字所含的码元的个数,编码可分为 等长 编码和 不等长 编码。

3、不等长D 元码,码字最长限定为N,则至多有 D(D N - 1)/(D — 1) 个码字。

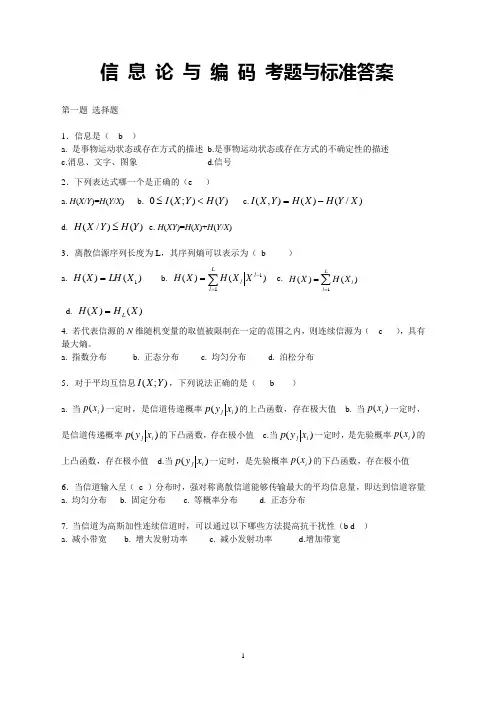

信息论与编码考题标准答案

信 息 论 与 编 码 考题与标准答案第一题 选择题1.信息是( b )a. 是事物运动状态或存在方式的描述b.是事物运动状态或存在方式的不确定性的描述c.消息、文字、图象d.信号 2.下列表达式哪一个是正确的(e )a. H (X /Y )=H (Y /X )b. )();(0Y H Y X I <≤c.)/()(),(X Y H X H Y X I -=d. )()/(Y H Y X H ≤e. H (XY )=H (X )+H (Y /X )3.离散信源序列长度为L ,其序列熵可以表示为( b )a. )()(1X LH X H =b.c. ∑==Ll lXH X H 1)()(d. )()(X H X H L =4.若代表信源的N 维随机变量的取值被限制在一定的范围之内,则连续信源为( c ),具有最大熵。

a. 指数分布b. 正态分布c. 均匀分布d. 泊松分布 5.对于平均互信息);(Y X I ,下列说法正确的是( b )a. 当)(i x p 一定时,是信道传递概率)(i j x y p 的上凸函数,存在极大值b. 当)(i x p 一定时,是信道传递概率)(i j x y p 的下凸函数,存在极小值c.当)(i j x y p 一定时,是先验概率)(i x p 的上凸函数,存在极小值d.当)(i j x y p 一定时,是先验概率)(i x p 的下凸函数,存在极小值 6.当信道输入呈( c )分布时,强对称离散信道能够传输最大的平均信息量,即达到信道容量 a. 均匀分布 b. 固定分布 c. 等概率分布 d. 正态分布7.当信道为高斯加性连续信道时,可以通过以下哪些方法提高抗干扰性(b d ) a. 减小带宽 b. 增大发射功率 c. 减小发射功率 d.增加带宽第二题 设信源 ⎥⎦⎤⎢⎣⎡=⎥⎦⎤⎢⎣⎡6.04.0)(21x x X p X 通过一干扰信道,接收符号为Y={y 1,y 2},信道传递矩阵为⎥⎦⎤⎢⎣⎡43416165 求:(1) 信源 X 中事件 x 1 和 x 2 分别含有的自信息量。

信息论测试题及答案

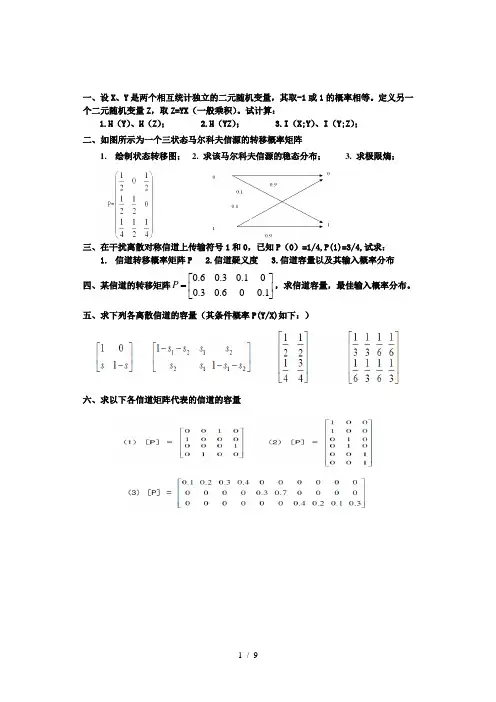

一、设X 、Y 是两个相互统计独立的二元随机变量,其取-1或1的概率相等。

定义另一个二元随机变量Z ,取Z=YX (一般乘积)。

试计算:1.H (Y )、H (Z );2.H (YZ );3.I (X;Y )、I (Y;Z ); 二、如图所示为一个三状态马尔科夫信源的转移概率矩阵1. 绘制状态转移图;2. 求该马尔科夫信源的稳态分布;3. 求极限熵;三、在干扰离散对称信道上传输符号1和0,已知P (0)=1/4,P(1)=3/4,试求:1. 信道转移概率矩阵P2.信道疑义度3.信道容量以及其输入概率分布 四、某信道的转移矩阵⎥⎦⎤⎢⎣⎡=1.006.03.001.03.06.0P ,求信道容量,最佳输入概率分布。

五、求下列各离散信道的容量(其条件概率P(Y/X)如下:)六、求以下各信道矩阵代表的信道的容量答案一、设X 、Y 是两个相互统计独立的二元随机变量,其取-1或1的概率相等。

定义另一个二元随机变量Z ,取Z=YX (一般乘积)。

试计算:1.H (Y )、H (Z );2.H (XY )、H (YZ );3.I (X;Y )、I (Y;Z ); 解:1. 2i 11111H Y P y logP y log log 2222i i =⎡⎤=-+⎢⎥⎣⎦∑()=-()()=1bit/符号 Z=YX 而且X 和Y 相互独立∴ 1(1)(1)(1)PP X P Y P X ⋅=+=-⋅=-(Z =1)=P(Y=1)= 1111122222⨯+⨯= 2(1)(1)(1)P P X P Y P X ⋅=-+=-⋅=(Z =-1)=P(Y=1)= 1111122222⨯+⨯=故H(Z)= i2i1(z )log (z )i P P =-∑=1bit/符号2.从上式可以看出:Y 与X 的联合概率分布为:H(YZ)=H(X)+H(Y)=1+1=2bit/符号 3.X 与Y 相互独立,故H(X|Y)=H(X)=1bit/符号∴I (X;Y )=H(X)-H(X|Y)=1-1=0bit/符号I(Y;Z)=H(Y)-H(Y|Z)=H(Y)-[H(YZ)-H(Z)]=0 bit/符号二、如图所示为一个三状态马尔科夫信源的转移概率矩阵2. 绘制状态转移图; 2. 求该马尔科夫信源的稳态分布;3. 求极限熵;解:1.状态转移图如右图 2.由公式31()()(|)j iji i p E P E P EE ==∑,可得其三个状态的稳态概率为:1123223313123111()()()()22411()()()2211()()()24()()()1P E P E P E P E P E P E P E P E P E P E P E P E P E ⎧=++⎪⎪⎪=+⎪⎨⎪=+⎪⎪⎪++=⎩1233()72()72()7P E P E P E ⎧=⎪⎪⎪⇒=⎨⎪⎪=⎪⎩3.其极限熵:3i i 13112112111H = -|E =0+0+72272274243228=1+1+ 1.5=bit/7777i P H H H H ∞=⨯⨯⨯⨯⨯⨯∑(E )(X )(,,)(,,)(,,)符号三、在干扰离散对称信道上传输符号1和0,已知P (0)=1/4,P(1)=3/4,试求:2. 信道转移概率矩阵P 2.信道疑义度3.信道容量以及其输入概率分布解:1.该转移概率矩阵为 P=0.90.10.10.9⎡⎤⎢⎥⎣⎦2.根据P (XY )=P (Y|X )⋅P (X ),可得联合概率由P (X|Y )=P(X|Y)/P(Y)可得H(X|Y)=-i jiji j(x y )log x |y =0.09+0.12+0.15+0.035=0.4bit/P P∑,()符号 3.该信道是对称信道,其容量为:C=logs-H=log2-H (0.9,0.1)=1-0.469=0.531bit/符号这时,输入符号服从等概率分布,即01 11()22XP X⎡⎤⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦⎣⎦四、某信道的转移矩阵⎥⎦⎤⎢⎣⎡=1.06.03.01.03.06.0P,求信道容量,最佳输入概率分布。

信息论典型试题及答案

3.1设有一个信源,它产生0,1序列的信息。它在任意时间而且不论以前发生过什么符号,均按P(0) = 0.4,P(1) = 0.6的概率发出符号。

(1)试问这个信源是否是平稳的?

(2)试计算H(X2),H(X3/X1X2)及H∞;

(3)试计算H(X4)并写出X4信源中可能有的所有符号。

解:

(1)这个信源是平稳无记忆信源。因为有这些词语:“它在任意时间而且不论以前发生过什么符号……”

(1)计算接收端的平均不确定性;

(2)计算由于噪声产生的不确定性H(Y/X);

解:(1)

(2)

(3)两个点数的排列如下:

11

12

13

14

15

16

21

22

23

24

25

26

31

32

33

34

35

36

41

42

43

44

45

46

51

52

53

54

55

56

61

62

63

64

65

66

共有21种组合:

其中11,22,33,44,55,66的概率是

其他15个组合的概率是

(4)

参考上面的两个点数的排列,可以得出两个点数求和的概 Nhomakorabea分布如下:

解:

(1)

(2)黑白气象传真图的消息前后有关联时,由其前后的依赖关系可知,黑色白色同时出现的联合概率为:

则信源的联合熵为:

H(X1X2)=1.426bit/symbol

H2(X)=1/2*H(X1X2)=0.713 bit/symbol

(3)上述两种信源的剩余度分别为:

信息论典型试题及答案

同时掷出两个正常的骰子,也就是各面呈现的概率都为1/6,求:(1) “3和5同时出现”这事件的自信息;(2) “两个1同时出现”这事件的自信息;(3) 两个点数的各种组合(无序)对的熵和平均信息量;(4) 两个点数之和(即2, 3, … , 12构成的子集)的熵;(5) 两个点数中至少有一个是1的自信息量。

解:(1)bitx p x I x p i i i 170.4181log )(log )(18161616161)(=-=-==⨯+⨯=(2) bit x p x I x p i i i 170.5361log)(log )(3616161)(=-=-==⨯=(3)两个点数的排列如下: 11 12 13 14 15 16 21 22 23 24 25 26 31 32 33 34 35 36 41 42 43 44 45 46 51 52 53 54 55 56 61 62 63 64 65 66共有21种组合:其中11,22,33,44,55,66的概率是3616161=⨯其他15个组合的概率是18161612=⨯⨯symbol bit x p x p X H ii i / 337.4181log 18115361log 3616)(log )()(=⎪⎭⎫ ⎝⎛⨯+⨯-=-=∑(4)参考上面的两个点数的排列,可以得出两个点数求和的概率分布如下:symbolbit x p x p X H X P X ii i / 274.3 61log 61365log 365291log 912121log 1212181log 1812361log 3612 )(log )()(36112181111211091936586173656915121418133612)(=⎪⎭⎫ ⎝⎛+⨯+⨯+⨯+⨯+⨯-=-=⎪⎭⎪⎬⎫⎪⎩⎪⎨⎧=⎥⎦⎤⎢⎣⎡∑(5)bitx p x I x p i i i 710.13611log )(log )(3611116161)(=-=-==⨯⨯=设离散无记忆信源⎭⎬⎫⎩⎨⎧=====⎥⎦⎤⎢⎣⎡8/14/1324/18/310)(4321x x x x X P X ,其发出的信息为(202032),求 (1) 此消息的自信息量是多少?(2) 此消息中平均每符号携带的信息量是多少? 解:(1) 此消息总共有14个0、13个1、12个2、6个3,因此此消息发出的概率是:62514814183⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=p 此消息的信息量是:bit p I 811.87log =-=(2) 此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/==设信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡17.016.017.018.019.02.0)(654321x x x x x x X P X ,求这个信源的熵,并解释为什么H(X) > log6不满足信源熵的极值性。

信息论考题及答案

一、(25分)如果X 和Y 相互独立,证明X 和Y 的熵满足可加性,即 H(Y)H(X)Y)H(X,+= 证明:设P(x,y)=P(x)P(y),则有1H(X,Y)()()logP()()11()()log()()log ()()11()log()log ()()()()xyxyxy xy P x P y x P y P x P y P x P y P x P y P x P y P x P y H X H Y ==+=+=+∑∑∑∑∑二、(50分)联合总体X ,Y 具有如下联合分布。

XY分别计算(1) 联合熵H(X,Y)是多少? (2)边缘熵H(X)和H(Y)是多少?(3)对于每一个y 值,条件熵H(X ︱y)是多少? (4)条件熵H(X ︱Y)是多少? (5)X 和Y 之间的互信息是多少? 解答:(1) H(X,Y)=3.375(2) H(X)=2, H(Y)=1.75(3) H(X|y=1)=2,H(X|y=1)=1.875,H(X|y=1)=1.875, H(X|y=4)=0.5(4)H(X|Y)=1.1264(5)I(X;Y)=H(X)-H(X|Y)=2-1.1264=0.8736 三、(25分)考虑一个差错概率为f=0.15的二进制对称信道。

输入总体为x Ω:{0P =0.9,1p =0.1},假设观察到y=1,请计算(1|1)P x y ==? 解:(1|1)P x y ===(1|1)(1)(1|)()xP y x P x P y x P x ===∑==9.015.01.085.01.085.0⨯+⨯⨯=22.0085.0=0.39一、(25分)如果X 和Y 相互独立,证明X 和Y 的熵满足可加性,即 H(Y)H(X)Y)H(X,+=二、(50分)联合总体X ,Y 具有如下联合分布。

XY分别计算(1) 联合熵H(X,Y)是多少? (2)边缘熵H(X)和H(Y)是多少?(3)对于每一个y 值,条件熵H(X ︱y)是多少? (4)条件熵H(X ︱Y)是多少? (5)X 和Y 之间的互信息是多少?三、(25分)考虑一个差错概率为f=0.15的二进制对称信道。

信息论基础及答案

《信息论基础》试卷第1页《信息论基础》试卷答案一、填空题(共25分,每空1分)1、连续信源的绝对熵为无穷大。

(或()()lg lim lg p x p x dx +¥-¥D ®¥--D ò)2、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到 1 1 1 。

3、无记忆信源是指信源先后发生的符号彼此统计独立。

4、离散无记忆信源在进行无失真变长编码时,码字长度是变化的。

根据信源符号的统计特性,对概率大的符号用短码,对概率小的符号用长码,这样平均码长就可以降低,从而提高有效性有效性((传输速率或编码效率传输速率或编码效率) ) ) 。

5、为了提高系统的有效性可以采用信源编码,为了提高系统的可靠性可以采用信道编码。

6、八进制信源的最小熵为、八进制信源的最小熵为 0 0 0 ,最大熵为,最大熵为,最大熵为 3bit/ 3bit/ 3bit/符号符号。

7、若连续信源输出信号的平均功率为1瓦特,则输出信号幅度的概率密度函数为高斯分布高斯分布((或()0,1x N 或2212x ep-)时,信源具有最大熵,其值为其值为 0.6155hart( 0.6155hart( 0.6155hart(或或1.625bit 或1lg 22e p )。

8、即时码是指任一码字都不是其它码字的前缀。

9、无失真信源编码定理指出平均码长的理论极限值为信源熵信源熵((或H r (S)(S)或或()lg H s r),此时编码效率为时编码效率为 1 1 1 ,编码后的信息传输率为,编码后的信息传输率为,编码后的信息传输率为 lg lg r bit/ bit/码元码元。

1010、一个事件发生的概率为、一个事件发生的概率为0.1250.125,则自信息量为,则自信息量为,则自信息量为 3bit/ 3bit/ 3bit/符号符号。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

一、设X 、Y 是两个相互统计独立的二元随机变量,其取-1或1的概率相等。

定义另一个二元随机变量Z ,取Z=YX (一般乘积)。

试计算:

1.H (Y )、H (Z );

2.H (YZ );

3.I (X;Y )、I (Y;Z ); 二、如图所示为一个三状态马尔科夫信源的转移概率矩阵

1. 绘制状态转移图;

2. 求该马尔科夫信源的稳态分布;

3. 求极限熵;

三、在干扰离散对称信道上传输符号1和0,已知P (0)=1/4,P(1)=3/4,试求:

1. 信道转移概率矩阵P

2.信道疑义度

3.信道容量以及其输入概率分布 四、某信道的转移矩阵⎥

⎦

⎤

⎢

⎣⎡=1.006.03.001.03.06.0P ,求信道容量,最佳输入概率分布。

五、求下列各离散信道的容量(其条件概率P(Y/X)如下:)

六、求以下各信道矩阵代表的信道的容量

答案

一、设X 、Y 是两个相互统计独立的二元随机变量,其取-1或1的概率相等。

定义另一个二元随机变量Z ,取Z=YX (一般乘积)。

试计算:

1.H (Y )、H (Z );

2.H (XY )、H (YZ );

3.I (X;Y )、I (Y;Z ); 解:1. 2

i 1

1

111H Y P y logP y log log 2222i i =⎡⎤=-+⎢⎥⎣⎦∑()=-

()()=1bit/符号 Z=YX 而且X 和Y 相互独立

∴ 1(1)(1)(1)P

P X P Y P X ⋅=+=-⋅=-(Z =1)=P(Y=1)= 11111

22222⨯+⨯= 2(1)(1)(1)P P X P Y P X ⋅=-+=-⋅=(Z =-1)=P(Y=1)= 11111

22222

⨯+⨯=

故H(Z)= i

2

i

1

(z )log (z )i P P =-∑=1bit/符号

2.从上式可以看出:Y 与X 的联合概率分布为:

H(YZ)=H(X)+H(Y)=1+1=2bit/符号 3.

X 与Y 相互独立,故H(X|Y)=H(X)=1bit/符号

∴I (X;Y )=H(X)-H(X|Y)=1-1=0bit/符号

I(Y;Z)=H(Y)-H(Y|Z)=H(Y)-[H(YZ)-H(Z)]=0 bit/符号

二、如图所示为一个三状态马尔科夫信源的转移概率矩阵

2. 绘制状态转移图; 2. 求该马尔科夫信源的稳态分布;

3. 求极限熵;

解:1.状态转移图如右图 2.由公式3

1

()()(|)j i

j

i i p E P E P E

E ==

∑,可得其三个状态的稳态概率为:

1123223313123111()()()()22411()()()2211

()()()24()()()1P E P E P E P E P E P E P E P E P E P E P E P E P E ⎧

=++⎪⎪⎪=+⎪⎨

⎪=+⎪⎪⎪++=⎩

1233()7

2()72()7P E P E P E ⎧=⎪⎪⎪

⇒=⎨⎪⎪

=⎪⎩

3.其极限熵:

3

i i 1

3112112111

H = -|E =0+0+72272274243228

=1+1+ 1.5=bit/7777

i P H H H H ∞=⨯⨯⨯⨯⨯⨯∑(E )(X )(,,)(,,)(,,)

符号

三、在干扰离散对称信道上传输符号1和0,已知P (0)=1/4,P(1)=3/4,试求:

2. 信道转移概率矩阵P 2.信道疑义度

3.信道容量以及其输入概率分布

解:1.该转移概率矩阵为 P=0.90.10.10.9⎡⎤

⎢

⎥

⎣⎦

2.根据P (XY )=P (Y|X )⋅P (X ),可得联合概率

由P (X|Y )=P(X|Y)/P(Y)可得

H(X|Y)=-

i j

i

j

i j

(x y )log x |y =0.09+0.12+0.15+0.035=0.4bit/P P

∑,()符号 3.该信道是对称信道,其容量为:

C=logs-H=log2-H (0.9,0.1)=1-0.469=0.531bit/符号

这时,输入符号服从等概率分布,即0111()22X P X ⎡⎤

⎡⎤⎢

⎥=⎢⎥⎢⎥⎣⎦⎣⎦

四、某信道的转移矩阵⎥⎦

⎤

⎢

⎣⎡=1.006.03.001.03.06.0P ,求信道容量,最佳输入概率分布。

解:该信道是准对称信道,分解为两个互不相交的子信道矩阵 0.60.30.30.6⎡⎤

⎢

⎥

⎣⎦ 0.1000.1⎡⎤⎢⎥⎣⎦

这里110.90.9N M == 22 0.10.1N M == ∴C=logr-H(P 的行矢量)

-

2

k 1

log 1(0.6.3.1)0.9log 0.9-0.1log 0.1K

K N

M H ==--⨯⨯∑,0,0

=0.174bit/符号

这时,输入端符号服从等概率分布,即()X P X ⎡⎤⎢⎥⎣⎦=011122⎡⎤

⎢

⎥⎢

⎥⎣⎦

五、求下列各离散信道的容量(其条件概率P(Y/X)如下:)

六、求以下各信道矩阵代表的信道的容量。