dell服务器双网卡绑定与端口聚合

双网卡绑定方法

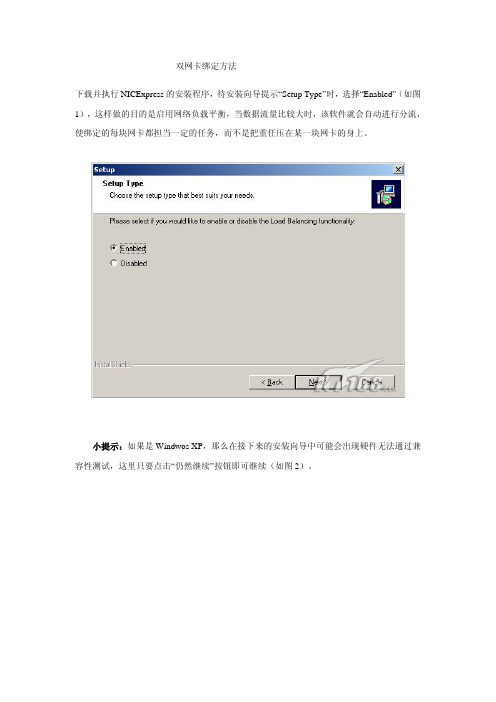

双网卡绑定方法下载并执行NICExpress的安装程序,待安装向导提示“Setup Type”时,选择“Enabled”(如图1),这样做的目的是启用网络负载平衡,当数据流量比较大时,该软件就会自动进行分流,使绑定的每块网卡都担当一定的任务,而不是把重任压在某一块网卡的身上。

小提示:如果是Windwos XP,那么在接下来的安装向导中可能会出现硬件无法通过兼容性测试,这里只要点击“仍然继续”按钮即可继续(如图2)。

根据安装向导的操作,待文件复制完毕即会进入绑定网卡设置窗口,可以看到窗口上方是计算机上已经安装的网卡,中间是设置组的名称,可以直接输入。

现在我们要做的就是在上方已经安装好的网卡列表中选中要绑定抽多卡,单击“Add”按钮,将其添加到“Assigned Adapters”框中去,被添加的网卡就是被绑定的网卡(如图3),添加好之后单击“OK”按钮,稍候片刻还会弹出一个参数设置窗口,在这里我们建议使用程序的默认参数即可。

三、应用设置现在我们绑定的网卡即可在工作了。

打开“网上邻居”的属性窗口,我们可以看到在原来物理网卡的基础上又多功能出一块虚拟的网卡(如图4)。

右击该网卡,选择“属性”命令打开网卡的设置窗口,我们可以看到在已安装的组件中多出一个“NIC Express Transport for Ethernet”,选中该项并单击“属性”按钮即可打开网卡绑定窗口,在这里我们可以增加其它绑定的网卡,也可以将绑定的网卡删除;如果打开“Internet协议(TCP/IP)”的属性窗口,那么还可以像普通网卡一样设置该虚拟网卡的IP地址等参数。

小提示:如果被绑定的网卡在绑定之前已经设置了IP地址,那么在绑定过程中程序会提示是否使用已经设置的IP地址。

四、综合应用现在我们就可以将两根网线连接到绑定的两块网卡,然后通过虚拟网卡的IP地址访问服务器,并进行操作,你就可以在网卡的指示灯上看到两个网卡都在进行数据交换。

关于双网卡绑定与端口聚合

关于双网卡绑定与端口聚合.txt14热情是一种巨大的力量,从心灵内部迸发而出,激励我们发挥出无穷的智慧和活力;热情是一根强大的支柱,无论面临怎样的困境,总能催生我们乐观的斗志和顽强的毅力……没有热情,生命的天空就没的色彩。

关于双网卡绑定与端口聚合端口聚合(IEEE802.3ad Port Trunking)可将2至8个10/100Base-TX端口聚合成一条干路,在全双工工作模式下达到400Mbps-1.6Gbps的带宽。

端口聚合技术能充分利用现有设备实现高速数据传递,也可以通过千兆端口聚合技术实现千兆位链路的聚合,最多可以聚合4Gbps的链路带宽。

Linux双网卡绑定的实现就是使用两块网卡虚拟成为一块网卡,这个聚合起来的设备看起来是一个单独的以太网接口设备,通俗点讲就是两块网卡具有相同的 IP地址而并行链接聚合成一个逻辑链路工作。

其实这项技术在Sun和Cisco中早已存在,被称为Trunking和Etherchannel技术,在 Linux的2.4.x的内核中也采用这这种技术,被称为bonding。

bonding 技术的最早应用是在集群——beowulf上,为了提高集群节点间的数据传输而设计的。

下面我们讨论一下bonding 的原理,什么是bonding需要从网卡的混杂(promisc)模式说起。

我们知道,在正常情况下,网卡只接收目的硬件地址(MAC Address)是自身Mac的以太网帧,对于别的数据帧都滤掉,以减轻驱动程序的负担。

但是网卡也支持另外一种被称为混杂promisc 的模式,可以接收网络上所有的帧,比如说tcpdump,就是运行在这个模式下。

bonding也运行在这个模式下,而且修改了驱动程序中的mac地址,将两块网卡的 Mac地址改成相同,可以接收特定mac的数据帧。

然后把相应的数据帧传送给bond驱动程序处理。

方案一具体配置示例如下:1、[root@storage6 network-scripts]# cat ifcfg-bond0# Intel Corporation 80003ES2LAN Gigabit Ethernet Controller (Copper)DEVICE=bond0BOOTPROTO=staticIPADDR=172.16.100.35NETMASK=255.255.255.0ONBOOT=yesGATEWAY=172.16.100.1BONDING_MASTER=yesTYPE=EthernetUSERCTL=no[root@storage6 network-scripts]# cat ifcfg-eth0# Intel Corporation 80003ES2LAN Gigabit Ethernet Controller (Copper)DEVICE=eth0BOOTPROTO=noneONBOOT=yesTYPE=EthernetMASTER=bond0SLAVE=yesUSERCTL=no[root@storage6 network-scripts]# cat ifcfg-eth1#IntelCorporation80003ES2LANGigabitEthernetController(Copper)DEVICE=eth1BOOTPROTO=noneONBOOT=yesTYPE=EthernetMASTER=bond0SLAVE=yesUSERCTL=no2、编辑 /etc/modprobe.conf 文件,加入如下一行内容,以使系统在启动时加载bonding 模块,对外虚拟网络接口设备为 bond0加入下列两行alias bond0 bondingoptions bond0 miimon=100 mode=0说明:miimon是用来进行链路监测的。

服务器双网卡捆绑与交换机链路聚合排障1例

不管 具 体 是 哪一 块 真 实 网卡 。

双 网 卡绑 定 后 .通 过 服 务 器系 统 软 件 把 2 网卡 绑定 在 同一 个 I 个 P地址 上 , 可

双 方 可 以 对 端 口处 于 S l td 态 达 成 ee e 状 c

一

网卡 捆 绑 , 与 盒 式 ቤተ መጻሕፍቲ ባይዱ兆 3 交换 机 H C 并 层 3

・

1 0 ・ 2

OP R TI E A ON & MAI T N N 使 用 维 修 N E A CE j

服务器 双 网卡捆绑与交换机链路聚合排 障 l 例

熊 虹 [ 国图 书 资料 分 类 号】 T 305 【 献 标识 码 ] C 【 中 P6. 文 文章 编 号] 1 0— 88 2 1 )3 02 — 2 0 3 8 6 (0 0 0 — 10 0

Ma u l 定 而非 静 态Sai绑定 。Ma u l n a绑 tt c n a

路 与 交 换机 端 E手工 物 理 切 断后 ,则 剩 2 1 服 务 器 双 网卡 绑 定 l . 余 的 一 条 链 路 又 可 以 正 常 与 交 换 机 通

链 路 同 时负 载 分担 的效果 。

况 下 服 务 器 双 网卡 工 作 在 负 载 均 衡 模 式 , 任 意单 网卡 出 现故 障 情 况下 . 在 能够

() 击N U 标 , 1双 C 图 运行 工 具 。

模 式 与 S t 模 式 两 者 的 不 同 之 处 就 是 ti ac

( ) 中 网卡 ,T A 绑 定 ,Y” 2选 “ E M” “ 确 使 用 手 工模 式绑 定 时 不 进 行I C 协 商 。 J P A

1 故 障 现象

DL 8 L 务 器 集 成 的 双 网 卡 进 行 双 千兆 3 0I  ̄

windows服务器双网卡链路聚合

windows服务器双网卡链路聚合

1、重命名网卡名

win10左下角LOGO->设置->网络和internet->(左侧)以太网->(右侧)网络和共享中心->(左侧)更改适配器设置,默认情况下两个网卡名称改为“nic1”,“nic2”。

2、Power Shell

打开Win10的power shell使用命令行设置,在win10左下角LOGO输入powershell,右键点击“Windows PowerShell”,以管理员身份运行,会有弹出对话框,选择“是”。

3、命令行

在弹出的窗口中输入new-netLbfoteam “teamingname” -teamingmode switchindependent接下来会提示输入需要绑定的网卡名,如图:

4、效果

回到电脑的网络适配器,网卡已经绑定成功,此时原来的两个独立的网卡已经不见了,显示的是绑定的网卡聚合的名称,如图:

5、删除网卡聚合

若想恢复原来的网卡配置,可输入命令remove-netLbfoteam -name teamingname删除指定网卡组,get-netLbfoteam | remove-netLbfoteam删除所有网卡组。

标签:windows

分类:WIN系统

| 发布:wanglei | 评论:0条 | 发表时间:2020-1-15 9:01 Wednesday。

DELL-M1000e刀箱的M6220网络交换机模块配置端口聚合实施方案

DELL M1000e刀箱M6220网络交换机配置端口聚合实施方案一、实施前查看机房环境1、“宁夏一体化缴费平台应用推广项目”现场环境如下:在宁夏电力信通公司22楼机房A16机柜有2台DELL M1000e刀箱,每台刀箱配置16把DELL M610刀片服务器。

上面1台DELL刀箱的CMC管理口登陆不了,报正在寻找IP的错误,刀箱上亮红灯,需要报dell 800。

下面一台刀箱的CMC管理口可以正常登陆,刀箱亮蓝灯,是正常的。

两台DELL刀箱各启用了A网络交换模块的第一个网口,上联到一台H3C交换机上。

B 网络交换模块没有使用,没有连网线上联到H3C交换机。

2、客户需求:两台DELL刀箱各启用了一个网络交换模块的第一个网口,上联到一台H3C交换机上。

为了防止网线被拔掉或者松滑,希望对32台DELL M610刀片服务器和2台DELL刀箱,配置刀箱上的网络交换机模块做双网卡绑定、链路聚合,防止单点故障。

3、首先确保要操作的这些设备没有硬件及操作系统方面的故障问题。

如果有故障,建议先解决现有的故障问题后再实施操作。

二、需要解决的问题1、问题一、1台DELL刀箱(SN号:CJ625W1)的CMC管理口登陆不了,报正在寻找IP 的错误,刀箱上亮红灯。

我已经帮客户张工寻求DELL 800提供电话支持技术,结果如下:解决方案:A、DELL 800提供电话支持技术服务,可以尝试在刀箱前液晶面板上去手工设置CMC的管理口的默认IP 192.168.0.120。

B、DELL 800提供电话支持技术服务,在停业务的前提下,尝试插拔CMC管理模块,使其恢复正常,能寻找到默认IP 192.168.0.120。

C、DELL 800提供电话支持技术服务,刀箱M1000E上CMC的管理口都必须接到同一个网段,接上网线,有问题可以现场收集一下日志,反馈DELL 800。

开启CMC的Telnet功能:在Chassis Overview - > Network -> Service 下的Telnet,把那个勾勾起来。

dell服务器双网卡绑定与端口聚合

端口聚合( Port Trunking ) 可将2至8个10/100Base-TX 端口聚合成一条干路,在全双工工作模式下达到的带宽。

端口聚合技术能充分利用现有设备实现高速数据传递,也可以通过千兆端口聚合技术实现千兆位链路的聚合,最多可以聚合4Gbps的链路带宽。

Broadcom Gigabit Ethernet Adapter Teaming任何可用的千兆BRODCO网卡都可以配置为TEAM勺一部分.TEAMING是一种将多块千兆BRODCC网卡绑定作为一个虚拟网卡. 好处就是负载均衡.通过选择每一个可用的千兆BRODCC网卡并添加它们到负载均衡成员栏来创建TEAM对于用户和应用程序只看到一个虚的网卡.负载均衡组中的成员共享绑定的数据流.在一个基本的成员区域中,任一个千兆BRODCOM卡都可以被指定为主成员负责数据流的控制,而指定为备用成员的网卡只有在所有的主成员网卡都失败时,才开始接管数据流.一旦任一个主成员网卡恢复,数据马上由该主成员控制.创建teaming 包含下列几个步骤:* 打开BASP属性窗口* 创建teams* 添加网卡到teams* 分配一个IP 地址给teamss* 重启机器BASP是适用于windows2003,windows2000,windowsNT,Redhat Liunx,NetWare 的一个broadcom 的中介型驱动程序, 需要先安装对应的broadcom 网卡驱动程序.目前它提供了负载均衡;错误冗余;VLAN高级功能,都通过创建teaming来实现.注意:一个team可以包含1到8个网卡,每个网卡都可以指定为主成员或备用成员. BASP的负载均衡;错误冗余功能支持与第三方厂商网卡在同一个team中协同工作. BASP FOR Windows 2000 & 20003 & NT提供以下选项:- 支持下列网卡作为故障应急(failover)Alteon AceNic,3COM 10/100 Server adapters;intel 10/1000 serveradapters;intel 1000baseSX server adapter;intel 82559 板载网卡- 智能负载均衡, 交换机不需设置.- 普通链路聚合(GEC/FEC,Open Trunk), 需要在交换机上启用trunking- 链路聚合( 静态配置), 需要交换机支持- 通过,每个网卡最多支持64个VLANS只支持braodcom或Alteon网卡BASP FOR RH Linux 提供以下几种team 的模式:- 智能负载均衡普通链路聚合(GEC/FEC,Open Trunk), 需要在交换机上启用trunking链路聚合( 静态配置), 需要交换机支持- VLAN Pachket taggingSmart Load Balancing (SLB) ?Broadcom 的负载均衡使用IP 流。

双网卡汇聚详细图文教程

双网卡汇聚详细图文教程双网卡汇聚详细图文教程首先先看下我汇聚好的设备管理器图集成的两块网卡都是INTEL 82574L的安装最新的网卡驱动会自动把INTEL分组的功能集成进去因为服务器正在带机运行所以不能为大家做各个步骤的详细图1、安装INTEL的网卡驱动(我安装的是14.4)2、驱动完毕后在设备管理器里右键点INTEL的网卡,选属性3、属性里选分组4、选与其他适配器分区,选新组5、组名随便添,例如:易游无盘分组,下一步6、钩选你要搭建负载的网卡,下一步7、选择组模式,模式选适应性负载平衡,如果你的交换机支持链路聚合,选静态链路聚合也可以(我的交换机支持所以我选择的是静态交换机型号H3C S5024P)8、设置你的组,选择主、从卡有些朋友汇聚好后问为什么汇聚好的是1G而不是2G 别急交换机那里还需要设置的不过首先你的交换机要支持聚合功能下面来看看交换机注:新建端口汇聚时,汇聚端口类型应设为一致,而且端口的工作速率不能设为自协商,且不同速率的端口不能配置为同一个汇聚组,聚合组中的所有端口必须为全双工(FULL)。

开始我就犯了这个错误没有调整结果百试不成功我的服务器在交换机上接口为6 and 23在端口设置里设置如图两个端口都设置好后转到端口汇聚功能页勾选你刚才设置的两个端口到汇聚组1 如图H3C有4种汇聚算法:1:SA(源MAC地址)2:D A(目的MAC地址)3:SA+DA4:SA+DA+IP每中汇聚方法适应不同类型网络,需要根据实际情况做出选择。

否则将会导致严重的网络问题。

端口名:对应端口的名称普通组:设置该端口为非汇聚组汇聚组:设置该端口为汇聚组我这里使用的是第三种算法SA+DA 也就是源MAC地址+目的MAC地址这样我们就完成了交换机的汇聚功能配置在选择组类型时候会出现很多类型下面给大家列出各种类型的说明高级网络服务(ANS) 组类型适配器容错适应性负载平衡静态链接聚合IEEE 802.3ad 动态链接聚合交换器容错注意:每一类ANS 组需要至少一个英特尔? 服务器适配器或英特尔集成连接。

服务器端端口汇聚

提醒以下几点,1、交换机支持端口汇聚,双网卡汇聚才有效果2、本例以2块INTEL网为例,保证型号相同3、交换机必须要保证汇聚的端口为双全工且速率一致,比如1000M,FULL(全双工)4、如果没有以下图1的分组选项,则要下载INTEL网卡最新驱动程序,100多M的。

效果:服务器双网卡(如果是1G)汇聚后为2G,网络吞吐量为原来的2倍,可实现包括负载均衡等功能网卡端口汇聚是双向的,如果仅仅是服务器网卡做了汇聚而交换机没有在相应端口设置汇聚的话下行数据无法分流的。

首先是服务器端的设置,本例以INTEL网卡为例,INTEL网卡本身带有管理软件路由器设置。

1、随便选择一个网卡,在网卡属性里先择“分组”——点击“新组”2、选择需要参加聚合的网卡。

3、在组类型里选择“静态链路聚合”。

(IEEE 802.3ad动态链接聚合如果交换机支持的话这个也可以)4、绑定后的效果如下图。

二、交换机侧的聚合设置,本例以H3C系列交换机为例。

其他交换机查看相关说明书就可。

理论是一样参与端口汇聚的端口必须工作在全双工模式,端口工作速率必须一致。

1.创建静态汇聚组1[SwitchA] link-aggregation group 1 mode static2.将以太网端口Ethernet1/0/1至Ethernet1/0/3加入汇聚组1(连接服务器的2个端口)[SwitchA] interface Ethernet1/0/1[SwitchA-Ethernet1/0/1] port link-aggregation group 1[SwitchA-Ethernet1/0/1] interface Ethernet1/0/2[SwitchA-Ethernet1/0/2] port link-aggregation group 1[SwitchA-Ethernet1/0/2] interface Ethernet1/0/3[SwitchA-Ethernet1/0/3] port link-aggregation group 1补充说明:汇聚组中各成员端口对出端口方向的数据流进行负荷分担,如果数据流是IP报文,负荷分担基于源IP和目的IP,如果数据流不是IP报文,负荷分担基于源MAC和目的MAC。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Broadcom Gigabit Ethernet Adapter Teaming

任何可用的千兆BRODCOM网卡都可以配置为TEAM的一部分.TEAMING是一种将多块千兆BRODCOM网卡绑定作为一个虚拟网卡.好处就是负载均衡.

通过选择每一个可用的千兆BRODCOM网卡并添加它们到负载均衡成员栏来创建TEAM.对于用户和应用程序,只看到一个虚的网卡.

负载均衡组中的成员共享绑定的数据流.

在一个基本的成员区域中,任一个千兆BRODCOM网卡都可以被指定为主成员负责数据流的控制,而指定为备用成员的网卡只有在所有的主

成员网卡都失败时,才开始接管数据流.一旦任一个主成员网卡恢复,数据马上由该主成员控制.

创建teaming包含下列几个步骤:

* 打开BASP属性窗口

* 创建teams

* 添加网卡到teams

* 分配一个IP地址给teamss

* 重启机器

BASP是适用于windows2003,windows2000,windowsNT,Redhat Liunx,NetWare的一个broadcom的中介型驱动程

序,需要先安装对应的broadcom网卡驱动程序.

目前它提供了负载均衡;错误冗余;VLAN高级功能,都通过创建teaming来实现.

注意: 一个team可以包含1到8个网卡,每个网卡都可以指定为主成员或备用成员.

BASP的负载均衡;错误冗余功能支持与第三方厂商网卡在同一个team中协同工作.

BASP FOR Windows 2000 & 20003 & NT提供以下选项:

- 支持下列网卡作为故障应急(failover)

Alteon AceNic,3COM 10/100 Server adapters;intel 10/1000 server

adapters;intel 1000baseSX server adapter;

intel 82559 板载网卡

- 智能负载均衡,交换机不需设置.

- 普通链路聚合(GEC/FEC,Open Trunk),需要在交换机上启用trunking

- 链路聚合(静态配置),需要交换机支持

- 通过,每个网卡最多支持64个VLANS,只支持braodcom或Alteon网卡

BASP FOR RH Linux 提供以下几种team的模式:

- 智能负载均衡

- 普通链路聚合(GEC/FEC,Open Trunk),需要在交换机上启用trunking

- 链路聚合(静态配置),需要交换机支持

- VLAN Pachket tagging

Smart Load Balancing (SLB)™

Broadcom 的负载均衡使用IP流。

该属性通过在多个网卡上以双向方式均衡网络IP流量。

当处于这种模式下,所有的在同一个队中的网卡使用物理网卡的MAC地址。

提供错误监测和在成员网卡或备用成员网卡中的动态冗余切换,该工作机制通过第3层协议来实现,可以在2层或3层交换机中工作。

对于负载均衡的TEAM, 交换机上不需要做相关配置.

Link Aggregation

链路聚合模式基于IEEE (LACP)规范。

该模式允许客户动态的修改队列中网卡的属性。

如果链路双方没有正确的按照配置,那末系统会标志出错误。

所有的成员网卡通过相同的MAC地址接受数据包。

链路聚合模式中链路必须有一方处于活动状态。

Generic Link Aggregation (Trunking)

Trunking模式跟十分相同,不提供LACP等协议的支持。

该模式只能静态的修改链路一端来适应不同的网络环境,比如说朗讯的'OpenTrunk'或者CISCO的'Fast EtherConnect(FEC).换句话说,Trunking 是的简易版。

-------------------------------------------

问题如下:

DELL的双网卡绑定的带宽扩展是基于端口聚合得以实现的,如果交换设备不支持,则双网卡绑定仅能实现(主/备用端口)模式,而如需双网卡同时以双工方式工作,则必须交换设备对的支持,不知我的如上理解是否正确?。