如何做性能测试报告

测试报告范文

测试报告范文一个好的测试报告应该清晰、简洁、有序地展示测试的结果和结论。

在软件测试过程中,编写测试报告是必不可少的一步。

通过测试报告,可以向项目中的各个相关人员展示软件的质量和进展情况,以及确定下一步的改进计划。

在这里,我们将介绍测试报告的结构和范例,同时列举三个案例,以便更好地理解怎样写一份有效的测试报告。

测试报告结构1. 概述:简短的开头,描述测试是针对哪个产品版本、测试类型等。

这里还可以介绍一下实施的测试方法和测试策略。

2. 测试环境:描述测试的软硬件环境,包括操作系统、硬件配置、浏览器和网络环境等等。

3. 测试类型:介绍测试分为哪些类型,比如功能测试、性能测试和安全测试。

4. 测试执行:记录测试计划和测试执行的情况,包括测试用例的数量、得到的测试结果和bug的数量等信息。

5. 测试结论:向相关人员展示测试结论和所得到的数据,需要结合测试计划和测试执行情况来做出最终的结论。

6. 附录:在测试报告的末尾附上详细的测试数据、测试用例和bug报告等信息,帮助阅读者理解测试的过程和结果。

测试报告范例以下是三个实际的测试报告范例,供参考。

范例1:应用程序的功能测试以下测试报告是对某应用程序的功能测试,其中包括测试计划、测试结果和结论,还有一些截图和附件。

概述:该测试旨在对客户端的功能进行测试,并为客户提供完成测试的报告。

测试环境:- 操作系统:Windows 10- 浏览器:Chrome, Firefox, IE11, Edge- 硬件:PC,Intel Core i7, 16GB RAM,120GB SSD- 网络环境:WIFI,Ethernet测试类型:- 应用程序的功能测试测试计划:使用测试用例对应用程序进行测试。

测试执行:测试用例中的所有测试均已执行,并记录测试日志。

在测试中发现了3个错误。

详见附件。

测试报告的结论:- 其中有3个错误需要解决。

- 测试结果表明,应用程序的基本功能正常运行。

附录:- 测试日志:(附件A)- 发现的错误详情:(附件B)范例 2:Web应用程序的性能测试以下测试报告是对某个Web应用程序进行的性能测试,包括测试环境、测试执行步骤,和性能测试结论和附件.概述:该测试旨在评估Web应用程序的性能,并为开发人员提供改进建议。

差动变压器性能测试实验报告

差动变压器性能测试实验报告实训项目:差动变压器的性能实验实训目的:了解差动变压器的工作原理和特性。

基本原理:差动变压器由一只初级线圈和两只次级线圈及一个铁芯组成,根据内外层排列不同,有二段式和三段式,本实验采用三段式结构。

当差动变压器随着被测体移动时差动变压器的铁芯也随着轴向位移,从而使初级线圈和次级线圈之间的互感发生变化,促使次级线圈感应电势产生变化,一只次级线圈感应电势增加,另一只感应电势则减少,将两只次级线圈反向串接(同名端连接),就引出差动电势输出。

其输出电势反映出被测体的移动量。

实训器材:主机箱、差动变压器、差动变压器实验模板、测微头、双踪示波器。

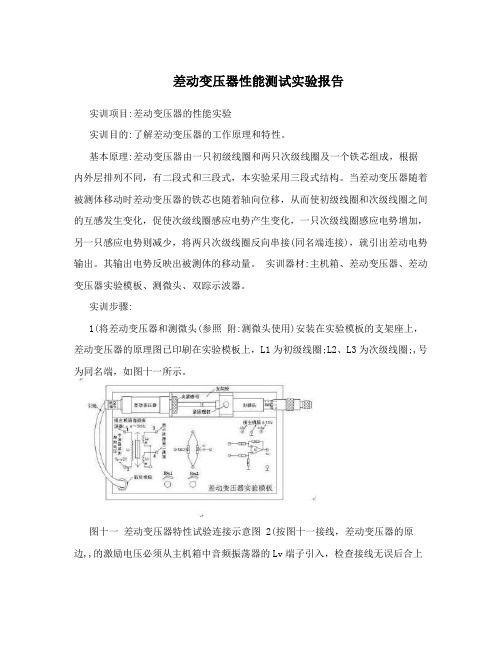

实训步骤:1(将差动变压器和测微头(参照附:测微头使用)安装在实验模板的支架座上,差动变压器的原理图已印刷在实验模板上,L1为初级线圈;L2、L3为次级线圈;,号为同名端,如图十一所示。

图十一差动变压器特性试验连接示意图 2(按图十一接线,差动变压器的原边,,的激励电压必须从主机箱中音频振荡器的Lv端子引入,检查接线无误后合上总电源开关,调节音频振荡器的频率为4 KHz,5KHz(可用主机箱的频率表输入Fin 来监测);调节输出幅度峰峰值为Vp-p,2V(可用示波器监测:X轴为0.2ms/div)。

3(松开测微头的安装紧固螺钉,移动测微头的安装套使示波器第二通道显示的波形Vp-p为较小值(变压器铁芯大约处在中间位置),拧紧紧固螺钉,仔细调节测微头的微分筒使示波器第二通道显示的波形Vp-p为最小值(零点残余电压)并定为位移的相对零点。

这时可以左右位移,假设其中一个方向为正位移,另一个方向位移为负,从Vp-p最小开始旋动测微头的微分筒,每隔2mm(可取10—25点)从示波器上读出输出电压Vp-p值,填入表7,再将测微头退回到Vp-p最小处开始反方向做相同的位移实验。

在实验过程中应注意:?从Vp-p最小处决定位移方向后,测微头只能按所定方向调节位移,中途不允许回调,否则,由于测微头存在机械回差而引起位移误差;所以,实验时每点位移量须仔细调节,绝对不能调节过量,如过量则只好剔除这一点继续做下一点实验或者回到零点重新做实验。

服务器性能测试报告

服务器性能测试报告服务器性能测试报告1、引言1.1 编写目的本文档旨在对服务器的性能进行全面测试,并对测试结果进行综合分析和评估,以便帮助确定服务器的性能状况及改进措施。

1.2 范围本文档适用于服务器性能测试过程和结果的记录和分析。

2、测试准备2.1 测试目标明确服务器性能测试的目标,例如测试服务器的吞吐量、响应时间、并发处理能力等。

2.2 测试环境描述测试所使用的服务器硬件配置和操作系统环境,并说明测试使用的工具和设备。

2.3 测试数据准备测试数据集,包括正常情况下的使用数据以及峰值期间的数据。

3、测试方法3.1 负载测试通过模拟用户并发访问服务器,验证服务器在不同负载下的性能表现。

3.2 压力测试以逐渐增大的负载来测试服务器的极限性能,以确定服务器能承受的最大负载。

3.3 稳定性测试在持续高负载下测试服务器的稳定性和可靠性,以评估服务器在长时间运行的情况下的性能表现。

3.4 安全性测试对服务器的安全性进行测试,以验证服务器对恶意攻击和非法访问的防护能力。

4、测试结果4.1 性能指标对服务器的吞吐量、响应时间、并发处理能力等性能指标进行记录和分析。

4.2 负载测试结果根据不同负载下的测试结果,绘制图表或表格进行数据展示,并进行性能分析和评估。

4.3 压力测试结果记录服务器在不同负载下的极限性能表现,并给出评估意见和建议。

4.4 稳定性测试结果测试服务器在持续高负载下的稳定性和可靠性表现,并记录异常情况和故障事件。

4.5 安全性测试结果评估服务器对恶意攻击和非法访问的防护能力,并提出安全性改进建议。

5、结论与建议根据测试结果和分析,对服务器的性能和安全性进行总结和评估,并给出改进建议。

6、附件本文档涉及的附件包括测试数据集、测试报告和测试日志等。

7、法律名词及注释7.1 法律名词1:注释1:是指的含义和解释。

7.2 法律名词2:注释2:是指的含义和解释。

性能测试分析报告

性能测试分析报告

这是一个性能测试分析报告的模板,您可以根据实际的测试结果填写相关内容。

性能测试分析报告

1. 引言

介绍测试的目的、范围、测试环境等基本信息。

2. 测试过程

描述测试的步骤和方法,例如使用的工具、测试时间、测试数据等。

3. 测试结果概要

总结测试结果的主要指标和结论,例如响应时间、吞吐量、并发用户数等。

4. 响应时间分析

分析系统在不同负载情况下的响应时间,包括最大、最小和平均响应时间,并绘制相应的图表。

5. 吞吐量分析

分析系统在不同负载情况下的吞吐量,包括每秒请求数和每秒传输数据量,并绘制相应的图表。

6. 并发用户数分析

分析系统在不同负载情况下的并发用户数,包括最大并发用户数和各个时间点的并发用户数,并绘制相应的图表。

7. 资源消耗分析

分析系统在不同负载情况下的资源消耗情况,包括CPU占用率、内存使用量等,并绘制相应的图表。

8. 瓶颈分析

根据测试结果和系统性能指标,分析系统存在的瓶颈和薄弱环节,并提出优化建议。

9. 结论

总结性能测试的结果和分析,指出系统的性能状况,评估系统的稳定性和可扩展性,并给出进一步优化的建议。

10. 附录

在需要时,可以提供详细的测试数据、配置信息、测试脚本等补充资料。

以上是一个性能测试分析报告的基本内容,根据实际情况可以进行适当的调整和补充。

希望对您有所帮助!。

性能测试报告模板

性能测试报告模板一、测试概述。

性能测试是软件测试的一种,其目的是评估系统的性能,包括响应时间、吞吐量、并发用户数等指标。

本次性能测试报告旨在对系统进行全面的性能测试,并提供详细的测试结果和分析,以便于开发团队和管理团队了解系统的性能状况,及时发现和解决问题。

二、测试环境。

1. 测试对象,XXX系统(版本号)。

2. 测试工具,LoadRunner。

3. 测试环境,生产环境模拟环境。

4. 测试时间,2022年1月1日-2022年1月7日。

三、测试指标。

1. 响应时间,用户请求系统后,系统响应的时间。

2. 吞吐量,系统单位时间内处理的请求数量。

3. 并发用户数,同时在线的用户数量。

4. CPU、内存、磁盘等资源利用率。

四、测试过程。

1. 测试准备,梳理系统功能模块,确定测试场景和测试用例。

2. 测试执行,根据测试计划,执行性能测试,记录测试数据。

3. 测试分析,对测试结果进行分析,找出性能瓶颈和问题点。

4. 测试报告,编写性能测试报告,总结测试结果和分析结论。

五、测试结果。

1. 响应时间,系统响应时间稳定在2-3秒之间,符合用户预期。

2. 吞吐量,系统吞吐量在高峰时段能够达到每秒处理1000个请求。

3. 并发用户数,系统能够支持1000个并发用户同时在线。

4. 资源利用率,系统资源利用率在合理范围内,未出现明显的性能瓶颈。

六、测试分析。

1. 性能瓶颈,系统在高并发情况下,部分功能模块响应时间略有增加,需要进一步优化。

2. 优化建议,对系统关键功能模块进行性能优化,提高系统的并发处理能力。

3. 测试总结,本次性能测试结果较为理想,系统整体性能良好,但仍需持续关注和优化。

七、测试结论。

经过本次性能测试,系统在响应时间、吞吐量、并发用户数等方面表现良好,但仍存在一些性能瓶颈,需要进一步优化。

建议开发团队根据测试分析结果,对系统进行性能优化,以确保系统在高负载情况下依然能够稳定运行。

八、附录。

1. 测试用例。

CPU性能测试实验报告

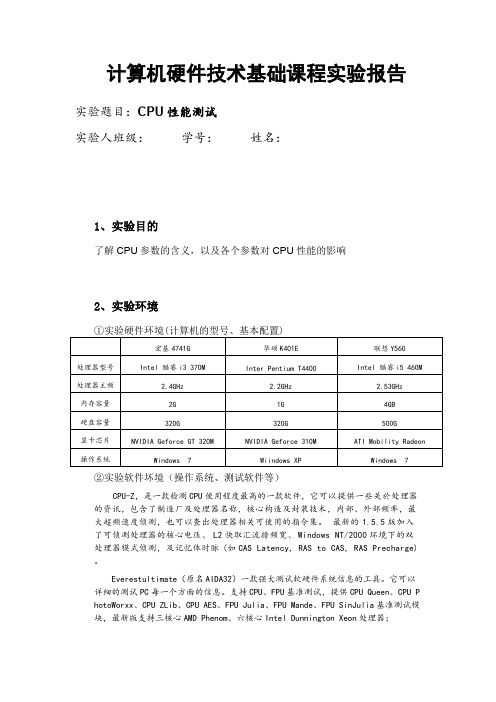

计算机硬件技术基础课程实验报告实验题目:CPU性能测试实验人班级:学号:姓名:1、实验目的了解CPU参数的含义,以及各个参数对CPU性能的影响2、实验环境①实验硬件环境(计算机的型号、基本配置)宏基4741G华硕K401E联想Y560处理器型号Intel 酷睿i3 370M Inter Pentium T4400Intel 酷睿i5 460M 处理器主频 2.4GHz 2.2GHz 2.53GHz内存容量2G1G4GB硬盘容量320G320G500G显卡芯片NVIDIA Geforce GT 320M NVIDIA Geforce 310M ATI Mobility Radeon 操作系统Windows 7Wiindows XP Windows 7②实验软件坏境(操作系统、测试软件等)CPU-Z,是一款检测CPU使用程度最高的一款软件,它可以提供一些关於处理器的资讯,包含了制造厂及处理器名称,核心构造及封装技术,内部、外部频率,最大超频速度侦测,也可以查出处理器相关可使用的指令集。

最新的1.5.5版加入了可侦测处理器的核心电压、L2快取汇流排频宽、Windows NT/2000环境下的双处理器模式侦测,及记忆体时脉(如CAS Latency, RAS to CAS, RAS Precharge)。

Everestultimate(原名AIDA32)一款强大测试软硬件系统信息的工具。

它可以详细的测试PC每一个方面的信息。

支持CPU、FPU基准测试,提供CPU Queen、CPU P hotoWorxx、CPU ZLib、CPU AES、FPU Julia、FPU Mande、FPU SinJulia基准测试模块,最新版支持三核心AMD Phenom、六核心Intel Dunnington Xeon处理器;SuperPi cpu性能测试软件原理是计算圆周率小数点的位数SuperPi是一个测试C PU性能的计算软件;它的工作原理是计算圆周率小数点的位数.例如:SuperPi 100万位就是CPU计算到圆周率小数点后100万的意思,时间越短表示CPU的计算能力越强!Fritz Chess Benchmark是一款国际象棋测试软件,是国际象棋软件Fritz自带的电脑棋力测试程序,由于支持多线程,而且它做的是大量科学计算,所有经常被用来测试电脑的科学运算能力。

常用的性能测试方法和测试要点

常用的性能测试方法和测试要点2008-12-16 13:58:04 / 个人分类:转载好东西常用的性能测试方法和测试要点1、明确用户的性能需求(显示的和隐式的),性能测试点,找出瓶颈1)用户直接需求的和使用过程中(行业经验)可能遇到的性能瓶颈点必须测试和分析到。

当然,客户不需要的,也没有必要去花时间和精力。

2)从中获取相应的性能测试参数,峰值和平均值。

3)客户的性能容忍度和系统所能承受的容忍度同样重要。

4)确认系统运行的最低硬件环境要求(虽然硬件便宜的多了,但客户能不能改造自己的环境还得客户说了算)5)如果可以的话,将系统的容错性做为性能测试的一部分进行测试2、测试对象和性能负载分布1)基本的3个对对像:C/S、B/S中的客户端和服务器,其中还有网络进行连接或中间件。

2)服务端可能分为数据端、业务端和服务容器。

3)跟据实际的测试结果合理的进行相应的性能负载分布。

3、负载、容量和压力测试逐一进行(如果需要)1)更多的情况下,性能测试中出现的问题是最初的设计时应存在的问题。

如果可能,建议对相应的性能提前做测试和优化。

2)够用就好,不是所有的系统都要进行性能测试,一切以客户需求和实际需要为准。

4、测试点1)CPU和内存使用(系统自身的原因)。

是否可以正常的使用和释放,是否存在内存溢出。

2)访问的速度(客户需求或是实际的应用要求说了算)3)网络。

网络传输速度,网络传输丢包率。

(找些工具,有免费的)4)服务器。

指令、服务应答响应时间,服务器对信息处理的时效性,服务器对峰值的处理(建议进行服务器优化或是进行服务负载均衡,有大量的文档对此进行描述)5)中间件。

中间件在信息传递中的处理性能及信息处理的正确性。

5、测试和监控数据1)均值下的持续运行(通过分析对整体的性能进行预测和评估)2)短时间的峰值运行(分析系统的处理能力)3)最低配置和最佳配置下的性能对比4)多用户。

同时访问,同时提交。

5)对4 中的数据进行记录和监控6、选择测试工具现有的测试工具太多了,不在一一列举。

性能测试报告

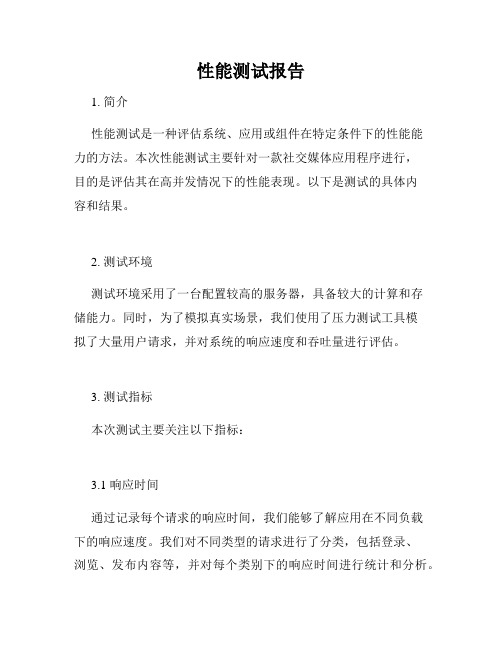

性能测试报告1. 简介性能测试是一种评估系统、应用或组件在特定条件下的性能能力的方法。

本次性能测试主要针对一款社交媒体应用程序进行,目的是评估其在高并发情况下的性能表现。

以下是测试的具体内容和结果。

2. 测试环境测试环境采用了一台配置较高的服务器,具备较大的计算和存储能力。

同时,为了模拟真实场景,我们使用了压力测试工具模拟了大量用户请求,并对系统的响应速度和吞吐量进行评估。

3. 测试指标本次测试主要关注以下指标:3.1 响应时间通过记录每个请求的响应时间,我们能够了解应用在不同负载下的响应速度。

我们对不同类型的请求进行了分类,包括登录、浏览、发布内容等,并对每个类别下的响应时间进行统计和分析。

3.2 吞吐量吞吐量反映了系统在单位时间内能够处理的请求数量。

我们通过逐渐增加并发用户数,观察系统对请求数量的处理情况,并绘制了吞吐量曲线。

3.3 资源利用率资源利用率是评估系统性能的重要指标之一。

我们对服务器的CPU、内存、磁盘等各项资源进行监控,并记录了每种资源的使用情况。

通过对比不同负载下的资源利用率,我们可以判断系统运行过程中是否存在瓶颈。

4. 测试结果4.1 响应时间在低负载情况下,系统的平均响应时间为300毫秒,当负载逐渐增加时,响应时间也随之增加。

在高负载情况下,系统的平均响应时间可达到600毫秒。

通过分析得知,响应时间增加的主要原因是数据库操作的瓶颈,随着并发请求数量的增加,数据库的读写效率逐渐下降。

4.2 吞吐量在并发用户数小于100的情况下,系统的吞吐量稳定在60个请求/秒左右。

当并发用户数超过100时,吞吐量开始下降,最终在200个请求/秒时触达系统的峰值。

通过压力测试工具的监控数据,我们发现系统在达到最大吞吐量时,开始出现请求超时和错误响应。

4.3 资源利用率在整个测试过程中,我们对服务器的资源利用情况进行了详细监控。

在低负载情况下,CPU利用率保持在30%左右,内存利用率大约为40%,磁盘读写速度也在可接受范围内。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

性能测试报告编写说明2013年5月目录1.概述 (1)1.1 编写目的 (1)1.2 参考资料 (1)1.3 注意事项 (1)2.测试相关准备 (2)2.1 系统相关参数配置说明 (2)2.2 测试报告环境准备 (2)2.3 JMeter测试举例 (2)2.3.1 准备测试脚本 (2)2.3.2 启动NMON监听 (3)2.3.3 执行测试用例 (4)2.3.4 查看测试结果 (5)2.3.5 编写测试报告 (6)2.4 LoadRunner测试举例 (13)2.4.1 准备测试脚本 (13)2.4.2 启动NMON监听 (16)2.4.3 执行测试用例 (17)2.4.4 查看测试结果 (20)2.4.5 LoadRunner相关参数配置说明 (21)2.4.6 编写测试报告 (21)1.概述1.1编写目的说明XXX系统进行压力测试时的一些前提条件及具体操作,以及如何在工具报告中提取哪些相应信息填写在报告内容中,为以后新增交易压力测试报告编写提供参考等。

1.2参考资料《XXX系统项目性能测试方案.doc》《XXX系统项目性能测试报告.doc》1.3注意事项压力测试报告中的数据与具体部署运行环境硬件配置、应用服务器、数据库服务器参数配置相关。

2.测试相关准备2.1系统相关参数配置说明1、调整应用程序日志打印级别全部为ERROR级,同时不打印交易日志信息;2、调整App服务器单个Server的线程池数(WebContener)为100至200;3、保证应用程序使用JNDI数据库连接池方式访问数据库,连接池数量为100至200;4、保证连接安全子系统TCPIP通讯缓冲池初始值为100,最大值为300;5、保证连接短信发送平台的TCPIP(NATP报文)通讯缓冲池初始值为100,最大值为300;6、App服务器JVM内存堆设置(测试环境单个server:256至512),负载测试时,最好取消监控垃圾回收监控项。

2.2测试报告环境准备1、启动App服务器(测试环境:10.10.0.100)NMON监听,每10秒获取一次CPU、IO资源信息,取15分钟内的数据大约100执行次左右,具体命令为:nmon -f -t -s 10 -c 100;2、启动DB2服务器(测试环境:10.10.2.100)NMON监听,每10秒获取一次CPU、IO资源信息,取15分钟内的数据大约100执行次左右,具体命令为:nmon -f -t -s 10 -c 100;3、启动JMeter监听器中的“用表格察看结果”、“聚合报告”、“察看结果树”至少三项。

2.3JMeter测试举例2.3.1准备测试脚本1.打开JMeter安装路径下的bin目录,运行jmeter.bat命令,出现下图所示:2.右击“测试计划”,新建线程组,右击“线程组”,选择“SOAP/XML-RPC Request”3.填写名称、URL及SOAP/XML-RPC Data,如下图所示:4.添加监听器,用于统计性能测试结果,如下图所示:至此,测试脚本准备完毕,接下来可以进行压力测试。

2.3.2启动NMON监听1、telnet到测试环境App服务器10.10.0.100,进入nmon目录,执行“nmon -f -t -s 10 -c 100”命令,将自动在nmon目录下以当前时间命名的监听文件,如下图所示:2、telnet到测试环境数据库服务器10.10.2.100,进入nmon目录,执行“nmon -f -t -s 10 -c 100”命令,将自动在nmon目录下以当前时间命名的监听文件,如下图所示:3、nmon -f -t -s 10 -c 100命令说明:-s 每隔多少秒统计一次,以秒为单位;如20,则每20秒统计一次;-c 统计多少次之后即停止。

2.3.3执行测试用例1.点击线程组,设置线程属性中的线程数、Ramp-Up Period、循环次数,如下图所示:2.点击“运行”—“启动”2.3.4查看测试结果监听器中可以添加“用表格查看结果”、“查看结果树”、“聚合报告”、“图形结果”、“Summary Report”等,如下图所示:查看结果树:聚合报告:2.3.5编写测试报告测试报告中包含了测试模型的介绍描述及测试结果分析,测试结果分析中需要包含不同并发情况下,事务平均响应时间、吞吐量、交易成功率、应用服务器和数据库CPU资源、IO使用率等数据的统计信息。

2.3.5.1统计JMeter测试结果从JMeter测试的聚合报告中,我们可以获取“事务平均响应时间”、“吞吐量”、“交易成功率”等参数,如下图所示:Average:事务平均响应时间;Thoughtoup:吞吐量;Error:错误率。

根据上述统计数据,填写测试报告如下:2.3.5.2统计nmon测试结果使用nmon analyser.xls打开各服务器上统计的nmon信息,如下图所示打开“CPU_ALL”工作表,可查看到任意时刻CPU的使用情况分析,根据时间点统计该时间段中CPU的平均使用率,如下图所示:同理,打开“DISK_SUMM”工作表,可查看到任意时刻IO的使用情况分析,根据时间点统计该时间段中IO的平均使用率,如下图所示:根据上述统计数据,填写测试报告如下:2.3.5.3根据测试数据画图例如统计不同并发情况下的事务平均响应时间数据如下:不同并发情况下,事务平均响应时间统计:单位(ms)使用Excel对数据进行图表绘制操作,步骤如下:1.选择需要统计的数据区域(A3-E8),在工具栏中点击“插入” “柱形图”,选择“三维柱形图”,如下图所示:2.点击“设计”→“布局1”,出现如下图:3.选择图表的图形区域,点击工具栏“设计”→“选择数据”4.选择图例项,点击“编辑”可对图表的图例项进行修改5.修改后的图形如下:6.修改图表标题,并添加横纵坐标对应说明与单位,得到最终的“平均响应时间统计”图:2.4LoadRunner测试举例2.4.1准备测试脚本1.在“开始”菜单中启动Mercury LoadRunner—LoadRunner,如下图所示:2.点击“Create/Edit Scripts”,打开新建测试脚本页面,如图所示:3.点击“OK”,打开编写测试脚本页面,点击“Start Record”按钮开始录制脚本:4.输入URL,如:“C:\Documents and Settings\hzy\桌面\ccgw测试页面.htm”5.LoadRunner会自动打开桌面的“ccgw测试页面.htm”,如图所示6.在XML报文输入框中输入发送的测试报文,创建一个“事物()”,点击“提交”7.收到返回报文后,点击“事物”结束按钮,并点击“结束脚本”按钮,如下图所示:8.此时脚本录制完成,保存录制下来的脚本。

2.4.2启动NMON监听1、telnet到测试环境App服务器10.10.0.100,进入nmon目录,执行“nmon -f -t -s 10 -c 100”命令,将自动在nmon目录下以当前时间命名的监听文件,如下图所示:2、telnet到测试环境数据库服务器10.10.2.100,进入nmon目录,执行“nmon -f -t -s 10 -c 100”命令,将自动在nmon目录下以当前时间命名的监听文件,如下图所示:3、nmon -f -t -s 10 -c 100命令说明:-s 每隔多少秒统计一次,以秒为单位;如20,则每20秒统计一次;-c 统计多少次之后即停止。

2.4.3执行测试用例1.在“开始”菜单中启动Mercury LoadRunner—LoadRunner,点击“Run Load Test”:2.打开运行测试脚本页面,将要运行的脚步添加到右边的场景中,点击“OK”,如下图所示:3.在打开的运行场景页面,可如图指定测试人数及设置运行场景:4.“Edit Schedule”编辑器设置介绍如下:指定逐渐开始:在“RampUp(加压)”选项卡中,可设置加压规则,如:每15 秒开始 2 个Vuser计划持续时间:在“Duration(持续时间)”选项卡中,可设置运行时间,如:在加压完成之后持续运行30分钟。

计划逐渐关闭:在“Ramp Down(减压)”选项卡中,可设置减压规则,如:每30 秒停止 5 个Vuser。

5.设置好运行场景后,点击“Start Scenario”,运行测试,点击“RUN”选项卡,如下图所示:6.实时查看脚本运行情况,如下图所示:2.4.4查看测试结果1.测试结束后,在测试场景中点击如下图所示的2.LoadRunner会根据测试场景自动生成测试报告,如下图所示:2.4.5LoadRunner相关参数配置说明Vuser-->Run-time Settings1、Think Time,设置是否忽略;2、Preferences-->Options2.1、设置连接超时时间等参数;2.4.6编写测试报告我们在编写性能测试报告中需要添加测试模型的介绍描述及测试结果分析,测试结果分析中需要包含不同并发情况下,事务平均响应时间、吞吐量、交易成功率、应用服务器和数据库CPU资源、IO使用率等数据的统计信息。

2.4.6.1统计LoadRunner测试结果从LoadRunner测试的报告中,我们可以获取“最大运行用户数”、“事务平均响应时间”、“平均点击率”、“吞吐量”、“交易成功率”等参数,如下图所示:Average:事务平均响应时间;Average Thoughtoup:平均吞吐量;Average Hits per Second:平均点击率。

根据上述统计数据,填写测试报告如下:2.4.6.2统计nmon测试结果使用nmon analyser.xls打开各服务器上统计的nmon信息,如下图所示打开“CPU_ALL”工作表,可查看到任意时刻CPU的使用情况分析,根据时间点统计该时间段中CPU的平均使用率,如下图所示:同理,打开“DISK_SUMM”工作表,可查看到任意时刻IO的使用情况分析,根据时间点统计该时间段中IO的平均使用率,如下图所示:根据上述统计数据,填写测试报告如下:2.4.6.3根据测试数据画图例如统计不同并发情况下的事务平均响应时间数据如下:不同并发情况下,事务平均响应时间统计:单位(ms)使用Excel对数据进行图表绘制操作,步骤如下:7.选择需要统计的数据区域(A3-E8),在工具栏中点击“插入” “柱形图”,选择“三维柱形图”,如下图所示:8.点击“设计”→“布局1”,出现如下图:9.选择图表的图形区域,点击工具栏“设计”→“选择数据”10.选择图例项,点击“编辑”可对图表的图例项进行修改11.修改后的图形如下:12.修改图表标题,并添加横纵坐标对应说明与单位,得到最终的“平均响应时间统计”图:。