信息论与编码-概述-思维导图

(完整版)信息论与编码概念总结

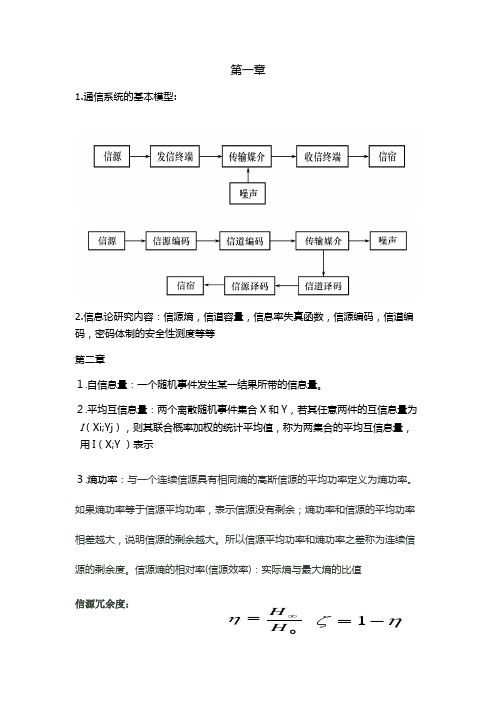

第一章1.通信系统的基本模型:2.信息论研究内容:信源熵,信道容量,信息率失真函数,信源编码,信道编码,密码体制的安全性测度等等第二章1.自信息量:一个随机事件发生某一结果所带的信息量。

2.平均互信息量:两个离散随机事件集合X 和Y ,若其任意两件的互信息量为 I (Xi;Yj ),则其联合概率加权的统计平均值,称为两集合的平均互信息量,用I (X;Y )表示3.熵功率:与一个连续信源具有相同熵的高斯信源的平均功率定义为熵功率。

如果熵功率等于信源平均功率,表示信源没有剩余;熵功率和信源的平均功率相差越大,说明信源的剩余越大。

所以信源平均功率和熵功率之差称为连续信源的剩余度。

信源熵的相对率(信源效率):实际熵与最大熵的比值信源冗余度:0H H ∞=ηηζ-=1意义:针对最大熵而言,无用信息在其中所占的比例。

3.极限熵:平均符号熵的N 取极限值,即原始信源不断发符号,符号间的统计关系延伸到无穷。

4.5.离散信源和连续信源的最大熵定理。

离散无记忆信源,等概率分布时熵最大。

连续信源,峰值功率受限时,均匀分布的熵最大。

平均功率受限时,高斯分布的熵最大。

均值受限时,指数分布的熵最大6.限平均功率的连续信源的最大熵功率:称为平均符号熵。

定义:即无记忆有记忆N X H H X H N X H X NH X H X H X H N N N N N N )()()()()()()(=≤∴≤≤若一个连续信源输出信号的平均功率被限定为p ,则其输出信号幅度的概率密度分布是高斯分布时,信源有最大的熵,其值为1log 22ep π.对于N 维连续平稳信源来说,若其输出的N 维随机序列的协方差矩阵C 被限定,则N 维随机矢量为正态分布时信源的熵最大,也就是N 维高斯信源的熵最大,其值为1log ||log 222N C e π+ 7.离散信源的无失真定长编码定理:离散信源无失真编码的基本原理原理图说明: (1) 信源发出的消息:是多符号离散信源消息,长度为L,可以用L 次扩展信源表示为: X L =(X 1X 2……X L )其中,每一位X i 都取自同一个原始信源符号集合(n 种符号): X={x 1,x 2,…x n } 则最多可以对应n L 条消息。

信息论与编码原理第7章信道编码的基本概念PPT课件

二进制:每个码元的信息含量为 1 比特,二进制的波特率与比特 率在数值上是相等的。

M进制:每一个码元的信息含量为 log2M。如果码元传输速率为 rs

波特,相应的比特率 rb 为:rb = rs log2M (bit/s)

05.08.2020

Department of Electronics and Information, NCUT Song Peng

▼ 在电报传送时,允许的比特差错率约为 10-4~10-5; ▼ 计算机数据传输,一般要求比特差错率小于 10-8~10-9; ▼ 遥控指令和武器系统指令中,要求误比特率更小。

05.08.2020

Department of Electronics and Information, NCUT Song Peng

第8页

7.1 信道编码在数字通信系统中的地位和作用

(2) 通信系统的主要技术指标

差错率:差错率是衡量传输质量的重要指标之一,有几种不同的定义 码元差错率:指在传输的码元总数中发生差错的码元数所占的比例 (平均值),简称误码率。 比特差错率(比特误码率):指在传输的比特总数中发生差错的比 特数所占的比例(平均值)。在二进制传输系统中,码元差错率就是 比特差错率。 码组差错率:指在传输的码组总数中发生差错的码组数所占的比例 (平均值)。 根据不同的应用场合对差错率有不同的要求。

信息论与编码原理

(第七章)

──────────────

信道编码的基本概念

05.08.2020

Department of Electronics and Information, NCUT So点击此处输入相关文本内容 点击此处输入相关文本内容

概况二

点击此处输入相关文本内容 点击此处输入相关文本内容

信息论与编码第三版 第3章

(2)增强通信的可靠性: 综上所述,提高抗干扰能力往往是以降低信息传输效率为代价

信息论与编码

信源编码的概念:对信源的原始符号按一定的数学规则进行变换的一种

代码。

信源编码包括两个功能:

(1)将信源符号变换成适合信道传输的符号; {b1, b2,…, bD}是适合 编码输出码字cm = cm1 cm2 … {a1, a2, …, (2)压缩信源冗余度,提高传输效率。 ak}为信 信道传输的D个符号, cmn, c mk∈{b1, b2,…, bD}, 源符号集,序列中 用作信源编码器的 k = 1, 2 , …, n ,n表示码字 每一个符号uml都取 信源编码模型: 编码符号。 长度,简称码长。 自信源符号集。

1 1 1 n 2 2 2 3 4 4 2.75 (码元/符号) 4 8 16

RD

H X n

2.75 1 (比特/码元时间) 2.75

信息论与编码

§3.2 等长码及等长编码定理

一.等长编码定理

考虑对一简单信源S进行等长编码,信源符号集有K个符号,码符号集 含D个符号,码字长度记为n。对信源作等长无差错编码,要得到惟一可译 码,必须满足下式:

扩展信源

信源编码器

信道符号(码符号)集{b1,b2,...bD}

信源符号集{a1,a2,...ak}

原码的N次扩展码是将信源作N次扩展得到的新信源符号序列u(N) =u1 …uN = (u11 u12 … u1L) … (uN1 uN2 … uNL),对应码符号序列c(N) =c1 …cN = (c11 c12 … c1n) … (cN1 cN2 … cNn) ,记集合C (N) = {c1(N), c2(N), …},C (N) 即原码C的N次扩展码。

《信息论与编码全部》课件

信息论与编码全部PPT课件

汇报人:PPT

目录

CONTENTS

01 添加目录标题 03 信息度量与熵

02 信息论与编码的基 本概念

04 信源编码

05 信道编码

06 加密与解密技术

07 信息安全与认证技 术

添加章节标题

信息论与编码的基本概 念

信息论的发展历程

1948年,香农提出信 息论,奠定了信息论

提高安全性

优点:安全性 高,速度快,

易于实现

应用:广泛应 用于电子商务、 网络通信等领

域

发展趋势:随 着技术的发展, 混合加密技术 将更加成熟和

完善

信息安全与认证技术

数字签名技术

数字签名:一种用于验证信息来源和完整性的技术 数字签名算法:RSA、DSA、ECDSA等 数字证书:用于存储数字签名和公钥的文件 数字签名的应用:电子邮件、电子商务、网络银行等

汇报人:PPT

熵越小,表示信息量越小,不确 定性越小

熵是概率分布的函数,与概率分 布有关

信源编码

定义:无损信源编码是指在编码过 程中不丢失任何信息,保持原始信 息的完整性。

无损信源编码

应用:无损信源编码广泛应用于音 频、视频、图像等媒体数据的压缩 和传输。

添加标题

添加标题

添加标题

添加标题

特点:无损信源编码可以保证解码 后的信息与原始信息完全一致,但 编码和解码过程通常比较复杂。

古典密码学:公元前400年,古希腊人使用替换密码 近代密码学:19世纪,维吉尼亚密码和Playfair密码出现 现代密码学:20世纪,公钥密码体制和数字签名技术出现 当代密码学:21世纪,量子密码学和后量子密码学成为研究热点

信息论与编码第一章绪论

形成和发展

1. 信息论研究的主要问题(续2)

4)无失真信源编码,所需要的最少码符号数是多少?

香农第一定理: 如果编码后的信源序列的

编码信息率不小于信源的熵,那么一定存

在一种无失真信源编码方法;否则,不存

在这样的一种无失真信源编码方法。

第一章:绪论

什么是信息 通信系统模型 研究内容

形成和发展

1. 信息论研究的主要问题(续3)

形成和发展

3. 信息的狭义概念(香农信息) (续6)

香农信息的优点:

➢ 有明确的数学表达式,定量化

➢ 与人们直观理解的信息含义一致

➢ 不考虑收信者主观感受的不同,认为同一消息对

任何收信者,所得信息量相同。

第一章:绪论

什么是信息 通信系统模型 研究内容

形成和发展

3. 信息的狭义概念(香农信息) (续7)

3)信道

狭义信道

广义信道

形成和发展

第一章:绪论

什么是信息 通信系统模型 研究内容

1. 通信系统模型(续10)

研究内容:

信道的统计特性

➢

无噪声信道、有噪声信道

➢

离散信道、连续信道、波形信道

➢

有记忆信道和无记忆信道

➢

恒参信道(平稳信道)和随参信道(非平稳信道)

➢

单用户信道和多用户信道

信道传输信息的最高速率

(Carson,1922)、电视(1925-1927)、调频广播

提高可靠性: (可靠传输)

➢ 信道编码

第一章:绪论

一、什么是信息

二、通信系统模型

1. 信息论研究的主要问题

三、信息论的研究内容

信息论与编码第一章信息论基础新

都是交流和通信的一方要告诉另一方的消 息。日常生活中人们常称之为“信息”。

如何理解信息和消息呢?

2020/3/31

5

信息与消息的区别与联系

以文字、语声、图象等载体把客观物质运 动和主观思维活动的状态表达出来就成为 消息,

消息是表达信息的工具

从通信的观点出发,构成消息的各种物理 现象具有两个条件:

生物如不能从外部感知信息,就不可能适当地调 整自己的状态,改善与外部世界的关系来适应这 种变化,不能避免被淘汰的厄运。

从外界摄取信息和利用信息的能力是一切生物得 以生存的必要条件,生物越高级,摄取和利用信 息的本领越高超。

2020/3/31

10

小结

信息与人类的关系密切

作为通信的消息,我们通过书信、电话、电报、电视、音 乐等与之接触,与人交往。

第一章 绪论

2020/3/31

1

提纲

信息的概念 信息论的研究思路、目的和内容 概率回顾

2020/3/31

2

1.1 信息的概念

世人谈及信息,远非今日起。 据《新辞海》考证,一千多年前唐代诗人李中《暮春怀故人》中

有“梦断美人沉信息,日空长路倚楼台”的诗句,这恐怕是最早关于 信息的文字记载。

人们与信息打交道的历史与自身一样悠久,人类从诞生起, 一直与信息打交道。

2020/3/31

7

(2)“信息”是作为运算的内容而明确起 来

在此意义下,“信息”是进行运算和处理 所需要的条件、内容和结果,并常常表现 为数字、数据、图表和曲线等形式。例如:

➢ 价目表反映商品价值信息; ➢ 车速表反映行驶速度信息, ➢ 万用表, ➢ 示波器等。

2020/3/31

第6章信息论与编码课件

增大E(R)的途径

25

6.2.1 纠错编码的基本思路

增大信道容量C

扩展带宽 加大功率 降低噪声

减小码率R

Q、N不变而减小K Q、K不变而增大N N、K不变而减小Q

增大码长N

26

6.2.2 最优译码与最大似然译码

译码器的任务是从受损的信息序列中尽 可能正确地恢复出原信息。 译码算法的已知条件是:

实际接收到的码字序列{r}, r=(r1,r2,…,rN) 发端所采用的编码算法和该算法产生的码 集XN, 满足 c i = ( c i1 , c i 2 , L , c iN ) ∈ X N 信道模型及信道参数。

则称集合V是数域F上的n维矢量空间,或称n维线性空间, n维矢量又称n重(n-tuples)。

9

矢量空间中矢量的关系

对于域F上的若干矢量 V 1 , V 2 , L , V i 及 V k 线性组合:

V k = a1V1 + a 2V 2 + L a iVi , ( a i ∈ F )

线性相关:

a1V1 + a 2V 2 + L a iVi = 0, ( a i ∈ F且不全为零)

从功能角度:检错码 、纠错码 对信息序列的处理方法:分组码、卷积码 码元与原始信息位的关系:线性码、非线 性码 差错类型:纠随机差错码、纠突发差错 码、介于中间的纠随机/突发差错码。 构码理论:代数码、几何码、算术码、组 合码等

7

差错控制系统分类

前向纠错(FEC):发端信息经纠错编码 后传送,收端通过纠错译码自动纠正传递 过程中的差错 反馈重发(ARQ):收端通过检测接收码 是否符合编码规律来判断,如判定码组有 错,则通过反向信道通知发端重发该码 混合纠错(HEC):前向纠错和反馈重发 的结合,发端发送的码兼有检错和纠错两 种能力

信息论与编码

信息论与编码第⼀章1、信息,信号,消息的区别信息:是事物运动状态或存在⽅式的不确定性的描述消息是信息的载体,信号是消息的运载⼯具。

2、1948年以“通信的数学理论”(A mathematical theory of communication )为题公开发表,标志着信息论的正式诞⽣。

信息论创始⼈:C.E.Shannon(⾹农)第⼆章1、⾃信息量:⼀个随机事件发⽣某⼀结果后所带来的信息量称为⾃信息量,简称⾃信息。

单位:⽐特(2为底)、奈特、笛特(哈特)2、⾃信息量的性质(1)是⾮负值(2) =1时, =0, =1说明该事件是必然事件。

(3) =0时, = , =0说明该事件是不可能事件。

(4)是的单调递减函数。

3、信源熵:各离散消息⾃信息量的数学期望,即信源的平均信息量。

)(log )(])(1[log )]([)( 212i ni i i i a p a p a p E a I E X H ∑=-===单位:⽐特/符号。

(底数不同,单位不同)信源的信息熵;⾹农熵;⽆条件熵;熵函数;熵。

4、信源熵与信息量的⽐较(书14页例2.2.2)()log () 2.1.3 i i I a p a =-()5、信源熵的意义(含义):(1)信源熵H(X)表⽰信源输出后,离散消息所提供的平均信息量。

(2)信源熵H(X)表⽰信源输出前,信源的平均不确定度。

(3)信源熵H(X)反映了变量X 的随机性。

6、条件熵:(书15页例2.2.3) 7、联合熵:8、信源熵,条件熵,联合熵三者之间的关系:H(XY)= H(X)+H(Y/X) H(XY)= H(Y)+H(X/Y)条件熵⼩于⽆条件熵,H(Y/X)≤H(Y)。

当且仅当y 和x 相互独⽴p(y/x)=p(y),H(Y/X)=H(Y)。

两个条件下的条件熵⼩于⼀个条件下的条件熵H(Z/X,Y)≤H(Z/Y)。

当且仅当p(z/x,y)=p(z/y)时取等号。

联合熵⼩于信源熵之和, H(YX)≤H(Y)+H(X)当两个集合相互独⽴时得联合熵的最⼤值 H(XY)max =H(X)+H(Y) 9、信息熵的基本性质:(1)⾮负性;(2)确定性;(3)对称性;(4)扩展性(5)可加性 ( H(XY) = H(X)+ H(Y) X 和Y 独⽴ H (XY )=H (X )+ H (Y/X )H (XY )=H (Y )+ H (X/Y ) )(6)(重点)极值性(最⼤离散熵定理):信源中包含n 个不同离散消息时,信源熵H(X)有当且仅当X 中各个消息出现的概率全相等时,上式取等号。

信息论与编码教学课件(全)

目录

• 课程介绍与背景 • 信息论基础 • 编码理论基础 • 信道编码技术 • 数据压缩技术 • 多媒体信息编码技术 • 课程总结与展望

01

课程介绍与背景

Chapter

信息论与编码概述

信息论的基本概念

01

信息、信息量、信息熵等

编码的基本概念

02

信源编码、信道编码、加密编码等

02

极化码(Polar Codes)

一种新型信道编码方式,通过信道极化现象实现高效可靠的信息传输。

03

深度学习在信道编码中的应用

利用深度学习技术优化传统信道编码算法,提高编码性能和效率。

05

数据压缩技术

Chapter

数据压缩概述与分类

数据压缩定义

通过去除冗余信息或使用更高效的编码方式,减小数据表示所需存储空间的过 程。

线性分组码原理:线性分组码是一 种将信息序列划分为等长的组,然 后对每组信息进行线性变换得到相 应监督位的编码方式。

具有严谨的代数结构,易于分析和 设计;

具有一定的检错和纠错能力,适用 于各种通信和存储系统。

循环码原理及特点

循环码原理:循环码是一种特殊的线 性分组码,其任意两个码字循环移位

后仍为该码的码字。

03

编码理论基础

Chapter

编码的基本概念与分类

编码的基本概念

编码是将信息从一种形式或格式转换为另一种形式的过程,以 满足传输、存储或处理的需要。

编码的分类

根据编码的目的和原理,可分为信源编码、信道编码、加密编 码等。

线性分组码原理及特点

线性分组码特点

监督位与信息位之间呈线性关系, 编码和解码电路简单;

信息论与编码(伴随式译码) (1)概述

1 G 0

0 1

0 0

1 0

1 1

1 1

0 1

0 0 1 1 1 0 1

1.试由该矩阵指出(n,k)码的信息位k=?和监督元位数 r=?及码长n=? 2.求对应的校验矩阵H。

3.若接收到一个7位码 ,R1 (0 1 0 0 1 1 0)它是否码字?若不是,

判断所发的码字。

4.问其伴随式有多少个?写出该分组码对应一半伴随式数目的译码表。 5.该(n,k)码的许用码集中包含多少个码字?用列表的方式写出这些码

1 1

1 1

0 1

0 0 1 1 1 0 1

1.试由该矩阵指出(n,k)码的信息位k=?和监督元位数 r=?及码长n=? 2.求对应的校验矩阵H。

3.若接收到一个7位码 ,R1 (0 1 0 0 1 1 0)它是否码字?若不是,

判断所发的码字。

解:1. 信息位k=3,监督元位数 r=n-k=4,码长n=7。

信息论与编码

2022年3月23日

曹雪虹 张宗橙 编

北京邮电大学出版社

北京工商大学信息工程学院 信息论与编码

1

本次课主要内容

5.4.3 线性分组码的生成矩阵、校验矩阵、伴 随式译码

举例说明信道编译码在实际应用中的实现方法

第五章内容总结

www.sysmk120.co m /dx / /dx/150527/4630604.ht ml /dx/150526/4630038.ht ml /dx/150509/4621414.ht ml /dx/150526/4630001.ht ml /dx/150526/4629997.ht ml /dx/150517/4624817.ht ml /dx/150517/4624816.ht ml /dx/150513/4623087.ht ml /dx/150513/4623086.ht ml /dx/150525/4629500.ht ml /dx/150525/4629498.ht ml /dx/150525/4629496.ht ml /dx/150525/4629488.ht ml /dx/150515/4624389.ht ml /dx/150515/4624384.ht ml /dx/150515/4624378.ht ml /dx/150523/4628925.ht ml /dx/150523/4628922.ht ml /dx/150519/4625738.ht ml /dx/150517/4624823.ht ml