非线性回归

《非线性回归分析》课件

封装式

• 基于模型的错误率和复 杂性进行特征选择。

• 常用的封装方法包括递 归特征消除法和遗传算 法等。

嵌入式

• 特征选择和模型训练同 时进行。

• 与算法结合在一起的特 征选择方法,例如正则 化(Lasso、Ridge)。

数据处理方法:缺失值填充、异常值 处理等

1

网格搜索

通过预定义的参数空间中的方格进行搜

随机搜索

2

索。

在预定义的参数空间中进行随机搜索。

3

贝叶斯调参

使用贝叶斯优化方法对超参数进行优化。

集成学习在非线性回归中的应用

集成学习是一种将若干个基学习器集成在一起以获得更好分类效果的方法,也可以用于非线性回归建模中。

1 堆叠

使用多层模型来组成一个 超级学习器,每个模型继 承前一模型的输出做为自 己的输入。

不可避免地存在数据缺失、异常值等问题,需要使用相应的方法对其进行处理。这是非线性回归 分析中至关重要的一环。

1 缺失值填充

常见的方法包括插值法、代入法和主成分分析等。

2 异常值处理

常见的方法包括删除、截尾、平滑等。

3 特征缩放和标准化

为了提高模型的计算速度和准确性,需要对特征进行缩放和标准化。

偏差-方差平衡与模型复杂度

一种广泛用于图像识别和计算机 视觉领域的神经网络。

循环神经网络

一种用于处理序列数据的神经网 络,如自然语言处理。

sklearn库在非线性回归中的应用

scikit-learn是Python中最受欢迎的机器学习库之一,可以用于非线性回归的建模、评估和调参。

1 模型建立

scikit-learn提供各种非线 性回归算法的实现,如 KNN回归、决策树回归和 支持向量机回归等。

非线性回归分析的入门知识

非线性回归分析的入门知识在统计学和机器学习领域,回归分析是一种重要的数据分析方法,用于研究自变量和因变量之间的关系。

在实际问题中,很多情况下自变量和因变量之间的关系并不是简单的线性关系,而是呈现出一种复杂的非线性关系。

因此,非线性回归分析就应运而生,用于描述和预测这种非线性关系。

本文将介绍非线性回归分析的入门知识,包括非线性回归模型的基本概念、常见的非线性回归模型以及参数估计方法等内容。

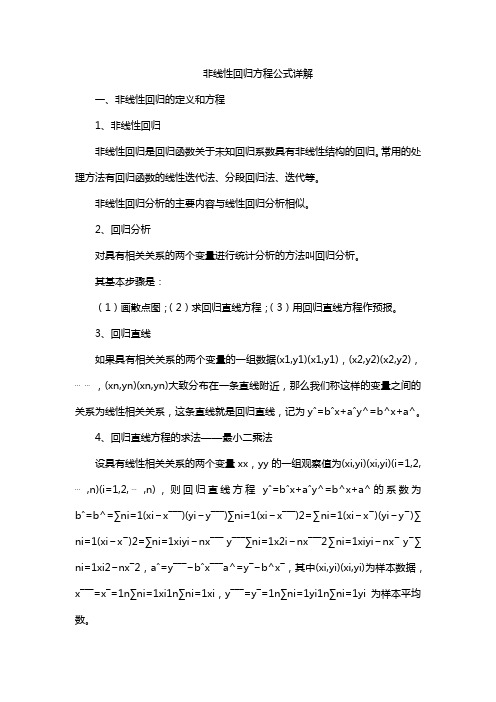

一、非线性回归模型的基本概念在回归分析中,线性回归模型是最简单和最常用的模型之一,其数学表达式为:$$Y = \beta_0 + \beta_1X_1 + \beta_2X_2 + ... + \beta_pX_p +\varepsilon$$其中,$Y$表示因变量,$X_1, X_2, ..., X_p$表示自变量,$\beta_0, \beta_1, \beta_2, ..., \beta_p$表示模型的参数,$\varepsilon$表示误差项。

线性回归模型的关键特点是因变量$Y$与自变量$X$之间呈线性关系。

而非线性回归模型则允许因变量$Y$与自变量$X$之间呈现非线性关系,其数学表达式可以是各种形式的非线性函数,例如指数函数、对数函数、多项式函数等。

一般来说,非线性回归模型可以表示为:$$Y = f(X, \beta) + \varepsilon$$其中,$f(X, \beta)$表示非线性函数,$\beta$表示模型的参数。

非线性回归模型的关键在于确定合适的非线性函数形式$f(X,\beta)$以及估计参数$\beta$。

二、常见的非线性回归模型1. 多项式回归模型多项式回归模型是一种简单且常见的非线性回归模型,其形式为: $$Y = \beta_0 + \beta_1X + \beta_2X^2 + ... + \beta_nX^n +\varepsilon$$其中,$X^2, X^3, ..., X^n$表示自变量$X$的高次项,$\beta_0, \beta_1, \beta_2, ..., \beta_n$表示模型的参数。

非线性回归 方法

非线性回归方法非线性回归是机器学习中的一种重要方法,用于建立输入和输出之间的非线性关系模型。

线性回归假设输入和输出之间存在线性关系,而非线性回归则允许更复杂的模型形式,可以更好地适应现实世界中的复杂数据。

下面将介绍几种常见的非线性回归方法,并说明它们的原理、应用场景和优缺点。

1. 多项式回归多项式回归通过引入高次多项式来拟合数据。

例如,在一元情况下,一阶多项式即为线性回归,二阶多项式即为二次曲线拟合,三阶多项式即为三次曲线拟合,依此类推。

多项式回归在数据不规则变化的情况下能够提供相对灵活的拟合能力,但随着多项式次数的增加,模型的复杂度也会增加,容易出现过拟合问题。

2. 非参数回归非参数回归方法直接从数据中学习模型的形式,并不对模型的形式做出先验假设。

常见的非参数回归方法包括局部加权回归(LWLR)、核回归(Kernel Regression)等。

局部加权回归通过给予离目标点较近的样本更大的权重来进行回归,从而更注重对于特定区域的拟合能力。

核回归使用核函数对每个样本进行加权,相当于在每个样本周围放置一个核函数,并将它们叠加起来作为最终的拟合函数。

非参数回归方法的优点是具有较强的灵活性,可以适应各种不同形状的数据分布,但计算复杂度较高。

3. 支持向量回归(SVR)支持向量回归是一种基于支持向量机的非线性回归方法。

它通过寻找一个超平面,使得样本点离该超平面的距离最小,并且在一定的松弛度下允许一些样本点离超平面的距离在一定范围内。

SVR通过引入核函数,能够有效地处理高维特征空间和非线性关系。

SVR的优点是对异常点的鲁棒性较好,并且可以很好地处理小样本问题,但在处理大规模数据集时计算开销较大。

4. 决策树回归决策树回归使用决策树来进行回归问题的建模。

决策树将输入空间划分为多个子空间,并在每个子空间上拟合一个线性模型。

决策树能够处理离散特征和连续特征,并且对异常点相对较鲁棒。

决策树回归的缺点是容易过拟合,因此需要采取剪枝等策略进行降低模型复杂度。

计量经济学_詹姆斯斯托克_第8章_非线性的回归模型

Ln(TestScore) = 6.336 + 0.0554 ln(Incomei) (0.006) (0.0021)

假设 Income 从$10,000 增加到$11,000(或者 10%)。

则 TestScore 增加大约 0.0554 10% = 0.554%。

如果 TestScore = 650, 意味着测试成绩预计会增加

非线性的回归模型

非线性的回归函数

“非线性”的含义:

(1)非线性的函数 自变量与解释变量之间的非线性

函 数形式。

(2)非线性的回归 参数与随机项的非线性形式。

非线性的回归函数

一、多项式回归 二、对数回归 三、自变量的交互作用 四、其他非线性形式的回归 五*、非线性回归(参数非线性)

一、多项式回归

1、指数函数曲线

指数函数方程有两种形式:

yˆ aebx yˆ abx

y a>0,b>0

a>0,b<0

x

图11.1方yˆ 程 aebx 的图象

二、对数函数曲线

对数函数方程的一般表达式为:

yˆ a b ln x

y

b>0

b<0

x

图11.2 方程yˆ =a+blnx 的图象

(2)根据拟合程度的好坏来确定(如,利用spss 的相关功能) 在社会科学领域里,阶数不会太高!

一、多项式回归

形式: Y 0 1X 2 X 2 ...r X r u

(2)多项式的本质 泰勒展开

一、多项式回归

形式: Y 0 1X 2 X 2 ...r X r u

Y——收入; D1——性别(1——男;0——女) D2——学历(1——大学学历;0——没有)

非线性回归方程公式详解

非线性回归方程公式详解一、非线性回归的定义和方程1、非线性回归非线性回归是回归函数关于未知回归系数具有非线性结构的回归。

常用的处理方法有回归函数的线性迭代法、分段回归法、迭代等。

非线性回归分析的主要内容与线性回归分析相似。

2、回归分析对具有相关关系的两个变量进行统计分析的方法叫回归分析。

其基本步骤是:(1)画散点图;(2)求回归直线方程;(3)用回归直线方程作预报。

3、回归直线如果具有相关关系的两个变量的一组数据(x1,y1)(x1,y1),(x2,y2)(x2,y2),⋯⋯,(xn,yn)(xn,yn)大致分布在一条直线附近,那么我们称这样的变量之间的关系为线性相关关系,这条直线就是回归直线,记为yˆ=bˆx+aˆy^=b^x+a^。

4、回归直线方程的求法——最小二乘法设具有线性相关关系的两个变量xx,yy的一组观察值为(xi,yi)(xi,yi)(i=1,2,⋯,n)(i=1,2,⋯,n),则回归直线方程yˆ=bˆx+aˆy^=b^x+a^的系数为bˆ=b^=∑ni=1(xi−x¯¯¯)(yi−y¯¯¯)∑ni=1(xi−x¯¯¯)2=∑ni=1(xi−x¯)(yi−y¯)∑ni=1(xi−x¯)2=∑ni=1xiyi−nx¯¯¯y¯¯¯∑ni=1x2i−nx¯¯¯2∑ni=1xiyi−nx¯ y¯∑ni=1xi2−nx¯2,aˆ=y¯¯¯−bˆx¯¯¯a^=y¯−b^x¯,其中(xi,yi)(xi,yi)为样本数据,x¯¯¯=x¯=1n∑ni=1xi1n∑ni=1xi,y¯¯¯=y¯=1n∑ni=1yi1n∑ni=1yi为样本平均数。

数据建模—非线性回归

数据建模—非线性回归

什么是非线性回归

一般线性回归假设因变量与自变量呈线性关系,但现实中有很

多问题并非是线性相关的。

而非线性回归可以用来拟合非线性关系。

非线性模型示例

下面以一些示例来介绍非线性回归:

1. 多项式回归

多项式回归就是一种非线性回归,它将线性模型中的自变量的

各次幂作为回归系数,即将 $y=a_0+a_1x+a_2x^2+...+a_nx^n$ 作为

模型进行回归。

这种方法适用于自变量$x$与因变量$y$之间的关系

大致呈多项式分布。

2. 对数函数回归

对数函数回归是一类将对数函数作为函数形式的非线性回归方法,它们适用于特定类型的数据。

如指数增长、充分增长、衰减等类型的数据。

3. Sigmoid函数回归

Sigmoid函数(S型函数)经常用于二分类问题,由于其形状为S型,经过合适的处理可以用来拟合非线性关系。

Sigmoid函数的形式为: $y=\frac{1}{1+e^{-ax+b}}$

非线性回归方法

与线性回归不同,非线性模型中的回归系数无法直接求解,需要使用非线性优化算法对其进行拟合。

非线性优化算法有很多种,常见的有:梯度下降法、拟牛顿法、Levenberg-Marquardt算法等。

总结

非线性回归适用于许多实际问题,可以通过多项式回归、对数函数回归、Sigmoid函数回归等方法进行建模。

然后,我们可以使用非线性优化算法对模型进行优化拟合以得到最优参数。

非线性回归分析

非线性回归分析随着数据科学和机器学习的发展,回归分析成为了数据分析领域中一种常用的统计分析方法。

线性回归和非线性回归是回归分析的两种主要方法,本文将重点探讨非线性回归分析的原理、应用以及实现方法。

一、非线性回归分析原理非线性回归是指因变量和自变量之间的关系不能用线性方程来描述的情况。

在非线性回归分析中,自变量可以是任意类型的变量,包括数值型变量和分类变量。

而因变量的关系通常通过非线性函数来建模,例如指数函数、对数函数、幂函数等。

非线性回归模型的一般形式如下:Y = f(X, β) + ε其中,Y表示因变量,X表示自变量,β表示回归系数,f表示非线性函数,ε表示误差。

二、非线性回归分析的应用非线性回归分析在实际应用中非常广泛,以下是几个常见的应用领域:1. 生物科学领域:非线性回归可用于研究生物学中的生长过程、药物剂量与效应之间的关系等。

2. 经济学领域:非线性回归可用于经济学中的生产函数、消费函数等的建模与分析。

3. 医学领域:非线性回归可用于医学中的病理学研究、药物研发等方面。

4. 金融领域:非线性回归可用于金融学中的股票价格预测、风险控制等问题。

三、非线性回归分析的实现方法非线性回归分析的实现通常涉及到模型选择、参数估计和模型诊断等步骤。

1. 模型选择:在进行非线性回归分析前,首先需选择适合的非线性模型来拟合数据。

可以根据领域知识或者采用试错法进行模型选择。

2. 参数估计:参数估计是非线性回归分析的核心步骤。

常用的参数估计方法有最小二乘法、最大似然估计法等。

3. 模型诊断:模型诊断主要用于评估拟合模型的质量。

通过分析残差、偏差、方差等指标来评估模型的拟合程度,进而判断模型是否适合。

四、总结非线性回归分析是一种常用的统计分析方法,可应用于各个领域的数据分析任务中。

通过选择适合的非线性模型,进行参数估计和模型诊断,可以有效地拟合和分析非线性关系。

在实际应用中,需要根据具体领域和问题的特点来选择合适的非线性回归方法,以提高分析结果的准确性和可解释性。

第四章 非线性回归与非线性约束

具体检验时,用来对原假设进行检验的似然比统 用来对原假设进行检验的似然比统 具体检验 计量定义为: 计量定义为: L( β R ) LR = −2(ln L( β R ) − ln L( βUR )) = −2 ln L( βUR )

LR ~ χ , m为限制条件的个数。

2 m 2 若LR大于给定显著性水平下的χ m临界值,

2

exp[−

1 2σ

2

(Yi − f ( X 1i , X 2i , L X ki , β1 , β 2 ,L β p )) 2 ]

则N个观测值的对数似然函数为 LnL = ∑ p (Yi , X i β ) = − ( N / 2) ln(2π ) − ( N / 2) ln(σ )

2

− (σ / 2)∑ (Yi − f ( X 1i , X 2i , L X ki , β1 , β 2 , L β p ))

L( β R ) 则似然比定义为λ = . L( βUR )

L( β R ) 则似然比定义为λ = . L( βUR )

L越大表明对数据的拟合程度越好,分母来自无条 越大表明对数据的拟合程度越好, 越大表明对数据的拟合程度越好 件模型,变量个数越多,拟合越好, 件模型,变量个数越多,拟合越好,因此分子小于分 似然比在0到 间 母,似然比在 到1间。分子是在原假设成立下参数的 极大似然函数值,是零假设的最佳表示。 极大似然函数值,是零假设的最佳表示。而分母则表 示在在任意情况下参数的极大似然函数值。 示在在任意情况下参数的极大似然函数值。比值的最 大极限值为1,其值靠近1, 大极限值为 ,其值靠近 ,说明局部的最大和全局最 大近似,零假设成立可能性就越大。 大近似,零假设成立可能性就越大。

设L( βUR )代表没有限制条件时似然函数 的极大值, L( β R )代表有限制条件时似然函数的极大值,

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

非线性回归

一、可化为线性回归的曲线回归

在实际问题当中,有许多回归模型的被解释变量y 与解释变量x 之间的关系都不是线性的,其中一些回归模型通过对自变量或因变量的函数变换可以转化为线性关系,利用线性回归求解未知参数,并作回归诊断。

如下列模型。

εββ++=x e y 10-------(1) εββββ+++++=p p x x x y 2210--------(2)

εe ae y bx =--------------------(3) ε+=bx ae y -------------(4)

对于(1)式,只需令x e x ='即可化为y 对x '是线性的形式εββ+'+=x y 10,需要指出的是,新引进的自变量只能依赖于原始变量,而不能与未知参数有关。

对于(2)式,可以令1x =x ,2x =2x ,…, p x =p x ,于是得到y 关于1x ,2x ,…, p x 的线性表达式εββββ+++++=p p x x x y 22110

对与(3)式,对等式两边同时去自然数对数,得ε++=bx a y ln ln ,令 y y ln =',a ln 0=β,b =1β,于是得到y '关于x 的一元线性回归模型: εββ++='x y 10。

对于(4)式,当b 未知时,不能通过对等式两边同时取自然数对数的方法将回归模型线性化,只能用非线性最小二乘方法求解。

回归模型(3)可以线性化,而(4)不可以线性化,两个回归模型有相同的回归函数bx ae ,只是误差项ε的形式不同。

(3)式的误差项称为乘性误差项,(4)式的误差项称为加性误差项。

因而一个非线性回归模型是否可以线性化,不仅与回归函数的形式有关,而且与误差项的形式有关,误差项的形式还可以有其他多种形式。

乘性误差项模型和加性误差项模型所得的结果有一定差异,其中乘性误差项模型认为t y 本身是异方差的,而t y ln 是等方差的。

加性误差项模型认为t y 是等方差的。

从统计性质看两者的差异,前者淡化了t y 值大的项(近期数据)的作用,强化了t y 值小的项(早期数据)的作用,对早起数据拟合得效果较好,而后者则对近期数据拟合得效果较好。

影响模型拟合效果的统计性质主要是异方差、自相关和共线性这三个方面。

异方差可以同构选择乘性误差项模型和加性误差项模型解决,必要时还可以使用加权最小二乘。

二、多项式回归

多项式回归模型是一种重要的曲线回归模型,这种模型通常容易转化为一般的多元线性回归来做处理。

1、常见的多项式回归模型

回归模型i i i i x x y εβββ+++=2210称为一元二阶多项式模型。

通常将回归模型中的系数表示成:i i i i x x y εβββ+++=21110,回归函数21110i i i x x y βββ++=是一条抛物线方程,通常称为二项式回归函数。

回归系数1β为线性效应系数,11β为二次效应系数。

当自变量的幂次超过3时,回归系数的解释变得困难起来,回归函数也变得很不稳定,对回归模型的应用会收到影响。

因而,幂次超过 3 的多项式回归模型不常使用。

在实际应用当中,常遇到含两个或两个以上自变量的情况,称回归

模型:i i i i i i i i x x x x x x y εββββββ++++++=21122222222111110为二元二阶多项式回

归模型。

它的回归系数中分别含有两个自变量的线性项系数1β和2β,二次项系数11β和22β,并含有交叉乘积项系数12β,交叉乘积项表示1x 与2x 的交互作用,系数12β通常称为交互影响系数。

三、非线性模型

在非线性回归中,平方和分解式SST=SSR+SSE 不在成立,类似于线性回归中的复决定系数,定义非线性回归的相关指数:R^2=1-SSE/SST

用非线性最小二乘法求解非线性回归方程,非线性最小二乘是使残差平方和达到最小,这种平方损失函数的优点是数学性质好,在一定条件下具有统计学的一些优良性质,但其最大的缺点是缺乏稳健性。

当数据存在异常值时,参数的估计效果变得很差。

因而在一些场合,可以用一些更稳健的残差损失函数代替平方和损失函数,例如绝对值损失函数。

绝对值残差损失函数为:∑=-=n

i i i x f y Q 1)

,()(θθ有时候用最小绝对值法的最大残差比普通最小二乘法的最大残差更大,这是否与最小绝对值法的稳健性相矛盾?其实这正说明了最小绝对值法的稳健性。

这是因为最小绝对值法受异常值的影响程度小,回归线向异常值靠拢的程度也小,因而异常值的残差反而大。

四、非线性回归的一些问题

根据实际观测数据配以合适的曲线模型一般有两个重要的步骤。

一是确定曲线类型。

对一个自变量的情况,确定曲线类型一般是把样本观测值画成散点图,由散点图的形状来大体确定曲线类型。

再就是根据专业知识来确定曲线类型,如商品的销售量与广告费之间的关系,一般用S 形曲线来描述;在农业生产中,粮食的产量与种植密度之间的关系往往服从抛物线关系。

对于由专业知识可以确定的曲线类型,就用相应的模型去试着拟合,如果拟合的效果可以,问题就解决了。

二是参数估计问题。

如果可将曲线模型转化为线性模型,就可用普通最小二乘法去估计未知参数,如果不能用某种变换把它转化成线性模型,则参数的估计就要用非线性最小二乘法进行。

非线性最小二乘法比普通最小二乘法要复杂得

多,一般都是用迭代方法。

由于任一连续函数都可用分段多项式来逼近,所以在实际问题中,不论变量y与其他变量的关系如何,在相当宽的范围内总可以用多项式来拟合。

例如在一元回归关系中,如果变量y与x的关系可以假定为p次多项式,就可以转化为多元线性回归模型来处理。

利用多项式回归模型可能会把已有的数据拟合得十分漂亮,但是,如果对较大的x作外推预测,这种多项式回归函数就可能会得到很差的结果,预测值可能会朝着意想不到的方向转折,可能会与实际情况严重不符。

所有类型的多项式回归函数,尤其是高阶多项式回归都具有外推风险。

特别的,对于一元回归,只要用一元n-1次多项式就可以把n对数据完全拟合,多项式曲线通过所有n-1个点,残差平方和为零,但是这种的回归拟合却没有任何实际意义。

因此,必须谨慎地使用高阶多项式回归模型,因为得到的回归函数只是数据的良好拟合,而并不能如实地表明x与y之间回归关系的基本特征,并会导致不规则的外推。

所以在应用多项式回归时,阶数一般不要超过三阶。

一般地说,当非线性回归模型选择正确,回归拟合效果好时,相关指数2R能够如实反映回归拟合效果;而当回归拟合效果差时,相关指数2R则不能够如实反映回归拟合效果,甚至可能取为负值。

出师表

两汉:诸葛亮

先帝创业未半而中道崩殂,今天下三分,益州疲弊,此诚危急存亡之秋也。

然侍卫之臣不懈于内,忠志之士忘身于外者,盖追先帝之殊遇,欲报之于陛下也。

诚宜开张圣听,以光先帝遗德,恢弘志士之气,不宜妄自菲薄,引喻失义,以塞忠谏之路也。

宫中府中,俱为一体;陟罚臧否,不宜异同。

若有作奸犯科及为忠善者,宜付有司论其刑赏,以昭陛下平明之理;不宜偏私,使内外异法也。

侍中、侍郎郭攸之、费祎、董允等,此皆良实,志虑忠纯,是以先帝简拔以遗陛下:愚以为宫中之事,事无大小,悉以咨之,然后施行,必能裨补阙漏,有所广益。

将军向宠,性行淑均,晓畅军事,试用于昔日,先帝称之曰“能”,是以众议举宠为督:愚以为营中之事,悉以咨之,必能使行阵和睦,优劣得所。

亲贤臣,远小人,此先汉所以兴隆也;亲小人,远贤臣,此后汉所以倾颓也。

先帝在时,每与臣论此事,未尝不叹息痛恨于桓、灵也。

侍中、尚书、长史、参军,此悉贞良死节之臣,愿陛下亲之、信之,则汉室之隆,可计日而待也。

臣本布衣,躬耕于南阳,苟全性命于乱世,不求闻达于诸侯。

先帝不以臣卑鄙,猥自枉屈,三顾臣于草庐之中,咨臣以当世之事,由是感激,遂许先帝以驱驰。

后值倾覆,受任于败军之际,奉命于危难之间,尔来二十有一年矣。

先帝知臣谨慎,故临崩寄臣以大事也。

受命以来,夙夜忧叹,恐托付不效,以伤先帝之明;故五月渡泸,深入不毛。

今南方已定,兵甲已足,当奖率三军,北定中原,庶竭驽钝,攘除奸凶,兴复汉室,还于旧都。

此臣所以报先帝而忠陛下之职分也。

至于斟酌损益,进尽忠言,则攸之、祎、允之任也。

愿陛下托臣以讨贼兴复之效,不效,则治臣之罪,以告先帝之灵。

若无兴德之言,则责攸之、祎、允等之慢,以彰其咎;陛下亦宜自谋,以咨诹善道,察纳雅言,深追先帝遗诏。

臣不胜受恩感激。

今当远离,临表涕零,不知所言。