数据挖掘中的距离度量和相似度度量及Python实现

完整版数据挖掘中的聚类分析方法

完整版数据挖掘中的聚类分析方法聚类分析方法是数据挖掘领域中常用的一种数据分析方法,它通过将数据样本分组成具有相似特征的子集,并将相似的样本归为一类,从而揭示数据中隐藏的模式和结构信息。

下面将从聚类分析的基本原理、常用算法以及应用领域等方面进行详细介绍。

聚类分析的基本原理聚类分析的基本原理是将数据样本分为多个类别或群组,使得同一类别内的样本具有相似的特征,而不同类别之间的样本具有较大的差异性。

基本原理可以总结为以下三个步骤:1.相似性度量:通过定义距离度量或相似性度量来计算数据样本之间的距离或相似度。

2.类别划分:根据相似性度量,将样本分组成不同的类别,使得同一类别内的样本之间的距离较小,不同类别之间的距离较大。

3.聚类评估:评估聚类结果的好坏,常用的评估指标包括紧密度、分离度和一致性等。

常用的聚类算法聚类算法有很多种,下面将介绍常用的几种聚类算法:1. K-means算法:是一种基于划分的聚类算法,首先通过用户指定的k值确定聚类的类别数,然后随机选择k个样本作为初始聚类中心,通过迭代计算样本到各个聚类中心的距离,然后将样本划分到距离最近的聚类中心对应的类别中,最后更新聚类中心,直至达到收敛条件。

2.层次聚类算法:是一种基于树状结构的聚类算法,将样本逐步合并到一个大的类别中,直至所有样本都属于同一个类别。

层次聚类算法可分为凝聚式(自底向上)和分裂式(自顶向下)两种。

凝聚式算法首先将每个样本作为一个初始的类别,然后通过计算样本之间的距离来逐步合并最近的两个类别,直至达到停止准则。

分裂式算法则是从一个包含所有样本的初始类别开始,然后逐步将类别分裂成更小的子类别,直至达到停止准则。

3. 密度聚类算法:是一种基于样本密度的聚类算法,通过在数据空间中寻找具有足够高密度的区域,并将其作为一个聚类。

DBSCAN (Density-Based Spatial Clustering of Applications with Noise)算法是密度聚类算法的代表,它通过定义距离和邻域半径来确定样本的核心点、边界点和噪声点,并通过将核心点连接起来形成聚类。

数据挖掘中聚类算法研究综述

数据挖掘中聚类算法研究综述随着数据量的不断增加,数据挖掘成为了探索数据背后规律的一种重要方法。

而聚类算法作为数据挖掘中的一种基本技术,其在数据分析、模式识别、生物信息学、社交网络分析等领域都有着广泛的应用。

本文就对数据挖掘中的聚类算法进行了研究和总结,旨在对聚类算法的原理、特点、应用等方面进行探讨。

一、聚类算法的基本原理聚类算法是指将一组对象划分为若干个组或类,使得组内对象之间的相似度尽可能大,组间对象之间的相似度尽可能小,从而达到数据分类和分析的目的。

聚类算法的基本原理包括以下三个方面:1. 相似度度量:聚类算法的基础在于相似度度量,即将每个对象之间的相似度进行计算。

相似度度量可以采用欧几里得距离、曼哈顿距离、余弦相似度等多种方法。

2. 聚类分配:聚类分配是指将每个对象划分到合适的聚类中。

聚类分配可以通过最近邻法、k-means算法等实现。

3. 聚类更新:聚类更新是指对各个聚类进行调整,使得聚类内对象之间的相似度尽可能大,聚类间对象之间的相似度尽可能小。

聚类更新可以采用层次聚类法、DBSCAN算法等。

二、聚类算法的分类根据聚类算法的不同特点和应用场景,可以将聚类算法分为以下几种类型:1. 基于距离的聚类算法:包括最近邻法、k-means算法、k-medoid 算法等。

2. 基于密度的聚类算法:包括DBSCAN算法、OPTICS算法等。

3. 基于层次的聚类算法:包括凝聚层次聚类法、分裂层次聚类法等。

4. 基于模型的聚类算法:包括高斯混合模型聚类、EM算法等。

三、聚类算法的应用聚类算法在各种领域中都有着广泛的应用,包括数据分析、模式识别、社交网络分析、生物信息学等。

下面简单介绍一下聚类算法在这些领域中的应用:1. 数据分析:聚类算法可以对数据进行分类和分组,从而提取出数据中的规律和趋势,帮助人们更好地理解和利用数据。

2. 模式识别:聚类算法可以对图像、声音、文本等数据进行分类和分组,从而实现对数据的自动识别和分类。

数据挖掘算法及其解析

数据挖掘算法及其解析随着大数据时代的到来,数据挖掘算法成为了一种非常重要的技术和工具。

通过合理的数据挖掘算法,可以从数据中挖掘出有用的信息,并据此进行一系列分析和决策。

在本文中,我们将分析几种常见的数据挖掘算法,并谈谈它们的应用场景和实现原理。

1. 关联规则挖掘算法关联规则挖掘算法是一种基于统计方法的数据挖掘算法。

它的主要思想是,在数据集中寻找出现频率高的项集,并找到它们之间的关联关系。

常见的应用场景包括购物篮分析、协同过滤等。

例如,在购物篮分析中,可以通过分析每个客户购买的商品,找到频繁共同出现的商品组合,以此帮助店家设计更优秀的促销策略。

关联规则挖掘算法的实现原理较为简单,其基本流程包括:先对数据集进行预处理,例如去重、排序等;然后通过扫描数据集,找到频繁项集;最后,利用频繁项集,构建关联规则,并计算其置信度和支持度。

在实现时,需要注意对大规模数据的优化处理。

例如,可以采用Apriori算法等频繁项集挖掘算法,进行高效的路径查找。

2. 决策树算法决策树算法是一种基于非参数模型的机器学习算法。

它的主要思想是利用训练数据集中的特征,通过一系列的规则判断,对未知数据进行分类或回归分析。

常见的应用场景包括欺诈检测、客户细分等。

决策树算法的实现原理也比较简单,其基本流程包括:先将数据集分成多个子集;然后对每个子集,选取最佳划分特征,并生成一个子节点;最后,对每个子节点,递归重复上述过程,直至满足停止条件。

在实现时,需要考虑对过拟合和欠拟合的处理。

例如,可以采用剪枝策略和属性选择策略,提高决策树模型的泛化性能。

3. 聚类算法聚类算法是一种基于距离度量的数据挖掘算法。

它的主要思想是将数据集中的样本划分成若干个互不相交的簇,使得簇内的样本相似度高,而簇间的相似度低。

常见的应用场景包括用户分群、图像分割等。

聚类算法的实现原理也较为简单,其基本流程包括:先选定初始聚类中心;然后通过距离度量,将样本分配到最近的聚类中心中;最后,对每个聚类中心,重新计算其位置,并重复上述过程,直至满足停止条件。

数据挖掘中的六类度量方法

数据挖掘中的度量方法在数据挖掘中,我们经常需要知道个体间差异的大小,进而进行分类或聚类。

相似度是描述两个个体数据的相似性,在数据挖掘中常用距离进行度量:距离近代表相似度高,相反距离远表示相似度低。

相似性是主观的而且十分依赖具体的领域和应用。

例如,两个人是因为他们姓氏相同而相似还是因为他们居住在同一座城市里而相似?相似性度量方法众多,但是没有任何一种方法能够度量所有数据,因此,根据不同的数据特性选择不同的度量方法显得尤为重要,对发掘出的数据内在联系影响极大。

接下来我们将列举一些数据挖掘中用距离度量的相似性度量方法,一般定义一个距离函数d(x, y),需要满足以下四个基本原则:到自己的距离为0:d(x, x) = 0。

距离非负:d(x, y) >= 0。

对称性:d(x, y) = d(y, x)。

三角形法则:d(x, z) + d(z, y) >= d(x, y)。

1. 闵可夫斯基距离(Minkowski distance )闵可夫斯基距离(Minkowski distance )是衡量数值点之间距离的一种非常常见的方法,假设数值点 P 和 Q 坐标如下:1212(,,...,),(,,...,)n n n P x x x Q y y y ==∈则P 和Q 之间的闵可夫斯基距离为:1/1p n p md i i i D x y =⎛⎫=- ⎪⎝⎭∑其中p=2时表示欧几里得距离(Euclidean distance ),p=1时表示曼哈顿距离(Manhattan distance )。

如图1所示,假设在曼哈顿街区乘坐出租车从 P 点到 Q 点,白色表示高楼大厦,灰色表示街道,绿色的斜线表示欧几里得距离,在现实中是不可能的。

其他三条折线表示了曼哈顿距离,这三条折线的长度是相等的。

而当p 趋近于无穷大时,上式则转化为切比雪夫距离(Chebyshev distance ),取极限有:1/11lim max p n np i i i i p i i x y x y →∞==⎛⎫-=- ⎪⎝⎭∑图1 欧几里得距离与曼哈顿距离示例闵可夫斯基距离比较直观,但是它与数据的分布无关,具有一定的局限性,如果 x 方向的幅值远远大于 y 方向的值,这个距离公式就会过度放大 x 维度的作用。

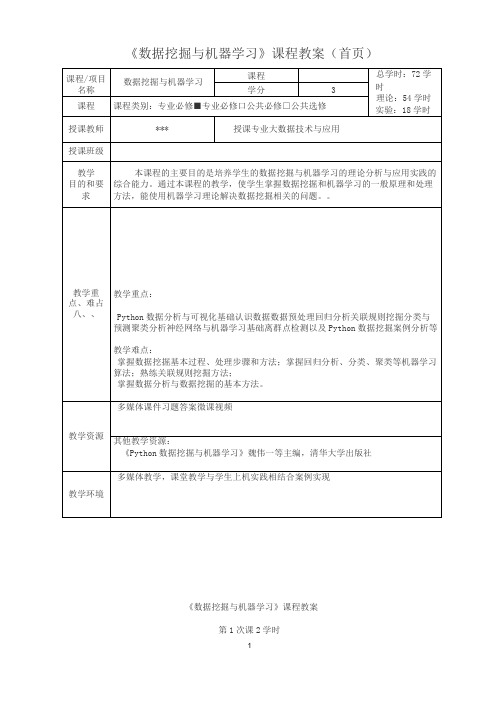

《数据挖掘与机器学习》课程教案

通过本课的学习,学生应该掌握如下知识:

3)掌握Matplotlib参数设置方法

4)掌握Matplotlib常用类型的绘图方法

5)了解Scikit-learn基本内容

重点难点

1)熟练Matplotlib常用类型的绘图方法

教学进程安排

授课内容:

一、Matplotlib图表绘制基础

实验内容:

利用Python实现数据分关联规则挖掘与分析

课后学习任务布置

熟悉Matplotlib常用绘图方法、教材习题练习

主要参考资料

《数据挖掘与机器学习》魏伟一等主编,清华大学出版社

第18次课2学时

授课内容

关联规则挖掘1

教学目的与要求

介绍关联规则挖掘方法。

要求学生应该熟练掌握如下知识的运用:

1)了解频繁项集、闭项集和关联规则的概念,理解模式评估方法

2)掌握Aoriori算法

重点难点

1)Aoriori算法

教学进程安排

授课内容:

一、关联规则分析概述

1)频繁项集、闭项集和关联规则

二、Apriori算法

一、数据集成

1)掌握集成中的主要问题

2)利用Pandas进行数据合并

二、数据标准化

三、数据归约

1)维归约

2)数量归约和压缩

四、数据变换与离散化

1)数据变换策略

2)利用sklearn进行数据预处理

课后学习

任务布置

熟悉Pandas统计分析方法

主要

参考资料

《Python数据挖掘与机器学习》魏伟一等主编,清华大学出版社

主要参考资料

《数据挖掘与机器学习》魏伟一等主编,清华大学出版社

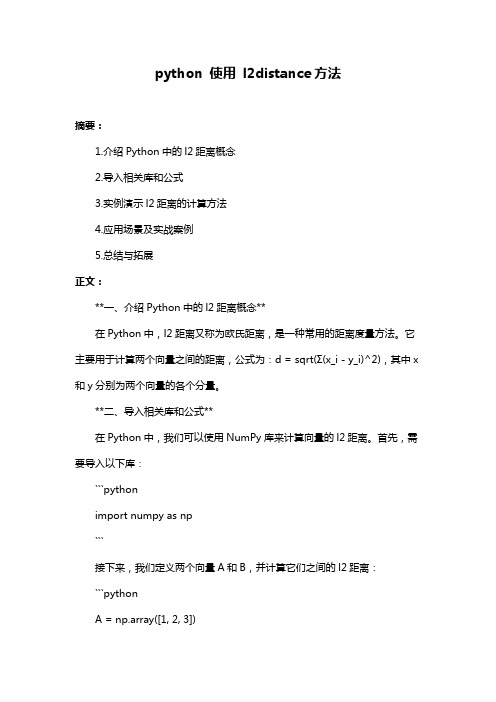

python 使用 l2distance方法

python 使用l2distance方法摘要:1.介绍Python中的l2距离概念2.导入相关库和公式3.实例演示l2距离的计算方法4.应用场景及实战案例5.总结与拓展正文:**一、介绍Python中的l2距离概念**在Python中,l2距离又称为欧氏距离,是一种常用的距离度量方法。

它主要用于计算两个向量之间的距离,公式为:d = sqrt(Σ(x_i - y_i)^2),其中x 和y分别为两个向量的各个分量。

**二、导入相关库和公式**在Python中,我们可以使用NumPy库来计算向量的l2距离。

首先,需要导入以下库:```pythonimport numpy as np```接下来,我们定义两个向量A和B,并计算它们之间的l2距离:```pythonA = np.array([1, 2, 3])B = np.array([4, 5, 6])distance = np.linalg.norm(A - B)print("l2距离:", distance)```**三、实例演示l2距离的计算方法**在上面的例子中,我们使用了NumPy提供的`linalg.norm()`函数来计算向量之间的l2距离。

下面,我们用一个简单的例子来演示如何手动计算l2距离:```pythondef manual_l2_distance(vec1, vec2):diff = vec1 - vec2distance = np.sum(diff ** 2) ** 0.5return distancevec1 = np.array([1, 2, 3])vec2 = np.array([4, 5, 6])distance = manual_l2_distance(vec1, vec2)print("手动计算的l2距离:", distance)```**四、应用场景及实战案例**l2距离在机器学习和数据挖掘领域有着广泛的应用,如聚类分析、分类算法等。

常见的距离算法和相似度(相关系数)计算方法

常见的距离算法和相似度(相关系数)计算方法在统计学和机器学习中,距离算法和相似度计算是常用的工具。

它们用于测量样本之间的差异或相似程度,从而用于聚类、分类、回归等任务。

本文将介绍几种常见的距离算法和相似度计算方法。

一、距离算法1.闵可夫斯基距离:闵可夫斯基距离是一种广义的距离度量方法,包括欧几里德距离和曼哈顿距离作为特例。

对于两个n维样本x和y,闵可夫斯基距离的定义为:D(x,y) = √(Σ(xi-yi)^p)^1/p其中p是一个可调参数,当p=1时,闵可夫斯基距离等同于曼哈顿距离;当p=2时,闵可夫斯基距离等同于欧几里德距离。

2.曼哈顿距离:曼哈顿距离又称为城市街区距离,是指在笛卡尔坐标系中两点之间的水平方向和垂直方向的距离总和。

对于两个二维样本(x1,y1)和(x2,y2),曼哈顿距离的定义为:D(x,y)=,x1-x2,+,y1-y23.欧几里德距离:欧几里德距离是最常见的距离度量方法,也称为直线距离。

对于两个n维样本x和y,欧几里德距离的定义为:D(x,y) = √(Σ(xi-yi)^2)4.切比雪夫距离:切比雪夫距离是指两个样本在每个维度上差值的最大绝对值。

对于两个n维样本x和y,切比雪夫距离的定义为:D(x,y) = max(,xi-yi,)5.杰卡德距离:杰卡德距离主要用于比较两个集合的相似度,特别适用于处理二元变量或稀疏数据。

对于两个集合A和B,杰卡德距离的定义为:D(A,B)=1-,A∩B,/,A∪B1.皮尔逊相关系数:皮尔逊相关系数是一种常用的方法,用于测量两个变量之间的线性关系程度。

对于两个n维向量x和y,皮尔逊相关系数的定义为:ρ(x,y) = Σ((xi-μx)(yi-μy))/(√(Σ(xi-μx)^2)√(Σ(yi-μy)^2))其中,μx和μy分别是向量x和y的均值。

2.余弦相似度:余弦相似度是一种常用的方法,用于测量两个向量之间的夹角余弦值。

对于两个n维向量x和y,余弦相似度的定义为:cosθ = (x·y)/(∥x∥∥y∥)其中,·表示向量的点积,∥x∥和∥y∥表示向量的模。

多媒体数据挖掘中数据间的相似性度量研究

来处理这些高维的特征数据 , 将得不到理想 的结果 , 这就是所谓的“ 维度灾难” …。

为克服维 度灾难 的影 响 , 目前在 高维数 据 的索 引结 构方 面有 很多研 究者 提 出了很 多经典 的算法 , 但

0 I s aai f h dme in ldme in p c s x r mss o h tte n w m to rs ne se e t e f y d t n tg i i n o a s i n o a s a e .E p i s l e me h w ta h e e d p e e td i f ci . h v

Ke rs mut dad t nn ;ul o dm nin l ;i lr aue n y wod : lme a m ig c . f e o at s ai mesrme t i i ai r  ̄ i s i y mi t y

在多媒体 数据 挖掘 的研究 中 , 聚类分 析 的应 用最 为广泛 。所 谓 聚类 , 是把一 组个 体按 照相似性 归 就

成若干类别 , 使得同一类的个体之间的相似度尽可能大 、 不同类个体之 间的相似度可能小。由此可见 , 数据 之间 的相 似性度 量是 聚类 的重要 依据 。多媒 体数据 聚类所 处理 的 目标 数据通 常是媒 体数 据对应 的

特征 向量 , 这些 特征 向量 往往是 数 十维甚 至数百 维 的。如 果仍然 用适 用 于低 维 数据 的相 似性 度 量方 式

c aatr t so a rsne nhg me s nl pcs rpssanw s lr e srme to lt dadt nn tue hrce sc f t pee td i ihd ni a ae ,p oe e i ai m aue n rmui ii da i o s o mi t y f me i amii a g,I sd asei t tg osl eo gnldt p c fr o uigtesm l i mo gd t pit,tu fc n yaodn h f e c p ca saeyt pi t r ia a sael oecmp t i i r a n aao n h sef i t vi gtei u n e l r t h i a  ̄ n h at y s i el i n l

时间序列数据挖掘中相似性和趋势预测的研究

时间序列数据挖掘中相似性和趋势预测的研究时间序列数据挖掘中相似性和趋势预测的研究摘要:时间序列数据在各个领域中广泛使用,如金融、交通、气象等。

本文旨在探讨时间序列数据挖掘中的相似性和趋势预测方法,从而提供基于数据挖掘的决策支持。

1. 引言随着技术的快速发展,我们正面临着大量的时间序列数据,如股票价格、气温、销售记录等。

利用这些数据进行相似性分析和趋势预测对于提高决策过程的准确性和效率至关重要。

因此,时间序列数据挖掘的研究变得越来越重要。

2. 相似性分析2.1 相似度度量相似度度量是相似性分析的基础。

常见的相似度度量方法包括欧氏距离、曼哈顿距离、皮尔逊相关系数等。

根据具体的需求和数据特点,选择合适的相似度度量方法可以得到更准确的结果。

2.2 时间序列相似性时间序列数据的相似性分析是指在时间上比较两个或多个时间序列的趋势和结构。

其中,主要方法包括动态时间规整(DTW)和自相似性分析。

2.2.1 动态时间规整(DTW)动态时间规整是一种基于序列对齐的方法。

它通过比较时间序列中各个时间点之间的距离和相似性,将两个时间序列规整成同样的长度。

DTW方法已经广泛用于语音识别、基因序列分析等领域。

2.2.2 自相似性分析自相似性分析是指寻找时间序列中的自相似模式。

通过计算时间序列的局部相似性,可以发现周期性、趋势性和重复性等模式。

其中常用的方法包括小波变换和自回归模型。

3. 趋势预测趋势预测是时间序列数据挖掘中的一项重要任务。

根据时间序列数据的特点和背景知识,我们可以采用不同的预测方法。

3.1 统计模型统计模型是常用的趋势预测方法之一。

它基于时间序列数据的历史数据,通过时间序列模型建立数学模型,并进行预测。

常见的统计模型有ARIMA模型、指数平滑模型等。

3.2 机器学习方法随着机器学习技术的发展,越来越多的方法被应用于趋势预测中。

例如,支持向量回归(SVR)、随机森林(Random Forest)、深度学习等。

python 计算字符串的相似度的算法原理

python 计算字符串的相似度的算法原理字符串相似度的算法原理是一种用于比较两个字符串之间相似程度的方法。

在Python编程语言中,我们可以使用多种算法来计算字符串的相似度。

下面我将介绍两种常用的算法原理:编辑距离算法和余弦相似度算法。

1. 编辑距离算法:编辑距离算法(Levenshtein Distance)是一种用于量化两个字符串之间的差异的算法。

它通过计算两个字符串之间的最小编辑操作数(插入、删除、替换)来衡量字符串的相似度。

编辑距离算法的原理是通过递归的方式计算两个字符串的编辑距离。

假设我们有两个字符串s和t,记为s[1...i]和t[1...j],其中s[i]和t[j]分别表示字符串的第i和第j个字符。

通过以下三种操作可以将字符串s转换为t:a) 插入操作:在字符串s中插入一个字符,将字符串s[i]变为t[j];b) 删除操作:删除字符串s中的一个字符,将字符串s[i]删除;c) 替换操作:将字符串s中的一个字符s[i]替换为t[j]。

基于上述操作,我们可以定义编辑距离的递归函数D(i,j):D(i, j) = min(D(i-1, j) + 1, D(i, j-1) + 1, D(i-1, j-1) + cost)其中,D(i-1, j)表示在字符串s中执行删除操作,D(i, j-1)表示在字符串s中执行插入操作,D(i-1, j-1)表示在字符串s中执行替换操作,cost表示s[i]是否等于t[j],如果相等则cost为0,否则为1。

通过递归计算D(i, j)可以得到字符串s和t的编辑距离,最终编辑距离除以字符串的最大长度,即可得到字符串的相似度。

2. 余弦相似度算法:余弦相似度算法(Cosine Similarity)是一种用于计算文本相似度的方法。

它将两个字符串看作是向量,通过计算向量之间的夹角余弦值来衡量两个字符串的相似度。

余弦相似度算法的原理是通过将字符串转化为词袋模型,计算两个字符串在词袋模型上的向量表示,并计算向量之间的余弦相似度。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

14

#皮尔逊相关系数计算用户相似度 1.0 #通用的方法,下面一种只是本方法在某些情况下的特例 def sim_stdpearson(prefs,person1,person2): si = {} for it in prefs[person1]: if it in prefs[person2]: si[it] = 1 lensi = len(si) if lensi == 0: return 0 sum1 = sum(prefs[person1][it] for it in prefs[person1]) sum2 = sum(prefs[person2][it] for it in prefs[person2]) avg1 = float(sum1)/len(prefs[person1]) avg2 = float(sum2)/len(prefs[person2]) sum1Sq = sum([pow(prefs[person1][it]-avg1,2) for it in si]) sum2Sq = sum([pow(prefs[person2][it]-avg2,2) for it in si]) pSum = sum([(prefs[person1][it]-avg1)*(prefs[person2][it]-avg2) for it in si]) den = math.sqrt(sum1Sq*sum2Sq) if den == 0: return 0 r = pSum/den return r

2013-06-01 Saturday

16

4.

Jaccard相似系数:Jaccard Coefficient

主要用于计算符号度量或布尔值度量的个体间的相似度;因为个体的特性主要由 符号度量或布尔值度量标识,因此无法衡量差异的具体值有多大,只能获得个体 间共同具有的特征是否一致的结论,故只比较相同特征的数目。

2013-06-01 Saturday

17

#Jaccard计算用户相似度 0.3333333333333333 #Jaccard=|AnB|/|AuB| def sim_jaccard(prefs,person1,person2): si_union = {}#并集 si_inter = {}#交集 si_union = dict(prefs[person1],**prefs[person2]) for it in prefs[person1]: if it in prefs[person2]: si_inter[it] = min(prefs[person1][it],prefs[person2][it]) sum1 = sum(si_inter[it] for it in si_inter) sum2 = sum(si_union[it] for it in si_union) if sum2 == 0: return 0 1.0 r = float(sum1)/sum2 return r sum1 = len(si_inter) sum2 = len(si_union)

2013-06-01 Saturday

0.9778024140774094

11

2.

调整余弦相似度:Adjusted Cosine Similarity

相当于计算向量夹角的余弦值,以此作为两个个体间相似度大小的衡量,由于余弦 相似度对数值不敏感,如个体X、Y对两个条目的评分分别为(1,2)、(4,5),其余弦相 似度为0.98,调整后需要减去各自的均值,计算相似度为-0.8.通过求出每位用户的 平均打分,调整评分向量为评分偏差向量,再求解余弦相似度。

2013-06-01 Saturday

15

#皮尔逊相关系数计算用户相似度 1.0 #并不是通用的,只有在特定条件下才能用 def sim_pearson(prefs,person1,person2): si = {} for it in prefs[person1]: if it in prefs[person2]: si[it] = 1 if len(si) == 0: return 0 sum1 = sum(prefs[person1][it] for it in prefs[person1]) sum2 = sum(prefs[person2][it] for it in prefs[person2]) sum1Sq = sum([pow(prefs[person1][it],2) for it in si]) sum2Sq = sum([pow(prefs[person2][it],2) for it in si]) pSum = sum([prefs[person1][it]*prefs[person2][it] for it in si]) num = pSum - (sum1 * sum2)/len(si) den = math.sqrt((sum1Sq-pow(sum1,2)/len(si))*(sum2Sq-pow(sum2,2)/len(si))) if den == 0: return 0 r = num/den return r

说明:

相似度是样本间相似程度的度量,亦称相似测度、近似系数,如 余弦相似度,夹角越小,相似度越大; 相异度,亦称相异测度、相异系数,如距离,距离越大,相异度 越大。

3

2013-06-01 Saturday

1.

欧氏距离:Euclidean Distance

用于衡量各点间的绝对距离

X、Y必须是同一特征的不同值,如同是身高或同时体重 n=1,直线上两点的距离 n=2,二维坐标系中两点的距离 n=3,三维坐标系中两点的距离……

0.1907435698305462

2013-06-01 Saturday

5

2.

曼哈顿距离:Manhattan Distance

将多个维度上的距离求和后的结果

如左图所示,绿线代表欧氏距离, 红线代表曼哈顿距离,蓝、黄线 代表等价的曼哈顿距离

2013-06-01 Saturday 6

#曼哈顿距离计算用户相似度 0.14285714285714285 #曼哈顿距离=sum|xi-yi| #相似度=1/1+曼哈顿距离 def sim_manhattan(prefs,person1,person2): si = {} for it in prefs[person1]: if it in prefs[person2]: si[it] = 1 if len(si) == 0: return 0 pSum = sum(math.fabs(prefs[person1][it]-prefs[person2][it])for it in si) return 1.0/(1+pSum)

2013-06-01 Saturday 13

3.

皮尔逊相关系数:Pearson Correlation Coefficient

即为相关分析中的相关系数r,分别对X和Y基于自身总体标准化后计算两个向量夹 角的余弦值。相当于对数据进行中心化处理,即数据移动了一个样本平均值以使 其均值为零。

2013-06-01 Saturday

2013-06-01 Saturday

4

#欧氏距离计算用户相似度 #欧氏距离=sqrt(sum(pow(xs-ys,2))) #相似度=1/(1+欧氏距离) def sim_distance(prefs,person1,person2): si = {} for it in prefs[person1]: if it in prefs[person2]: si[it] = 1 if len(si) == 0: return 0 pSum = math.sqrt(sum(pow(prefs[person1][it]-prefs[person2][it],2)for it in si)) return 1.0/(1+pSum)

2013-06-01 Saturday

12

#调整余弦系数计算用户相似度 #其中s属于AnB,i属于A,j属于B;和皮尔逊的差异在分母 1.0 def sim_ajcos(prefs,person1,person2): si = {} for it in prefs[person1]: if it in prefs[person2]: si[it] = 1 if len(si) == 0: return 0 avg1 = float(sum(prefs[person1][it] for it in prefs[person1]))/len(prefs[person1]) avg2 = float(sum(prefs[person2][it] for it in prefs[person2]))/len(prefs[person2]) pSum = sum([(prefs[person1][it]-avg1)*(prefs[person2][it]-avg2) for it in si]) sum1Sq = sum([pow(prefs[person1][it]-avg1,2) for it in prefs[person1]]) sum2Sq = sum([pow(prefs[person2][it]-avg2,2) for it in prefs[person2]]) den = math.sqrt(sum1Sq * sum2Sq) if den == 0: return 0 r = float(pSum)/den return r

Jaccard (P),说明

四.比较:结果,适用场景

注:P代表Python源码实现,测试字典为prefs = {'a':{1:1,2:2},'b':{1:4,2:5}}

2013-06-01 Saturday 2

目的: