深度学习基础地的知识整理

深度学习教学大纲

深度学习教学大纲深度学习教学大纲深度学习作为人工智能领域的一个重要分支,已经在各个领域展现出了巨大的应用潜力。

为了培养更多的深度学习人才,许多高校和培训机构开始开设相关的课程。

本文将探讨一个完整的深度学习教学大纲,以帮助学习者系统地掌握这一领域的知识和技能。

第一部分:基础知识在深度学习的教学大纲中,首先需要介绍深度学习的基础知识。

这包括神经网络的基本概念和结构,以及常用的深度学习框架和工具。

学习者需要了解神经网络的基本组成部分,如神经元、层和权重,并且能够使用深度学习框架来构建和训练自己的神经网络模型。

第二部分:深度学习算法在深度学习教学大纲的第二部分,需要详细介绍深度学习的核心算法。

这包括卷积神经网络(CNN)、循环神经网络(RNN)和生成对抗网络(GAN)等。

学习者需要理解这些算法的原理和应用场景,并且能够使用相应的算法解决实际问题。

第三部分:深度学习应用深度学习的应用领域非常广泛,包括图像识别、语音识别、自然语言处理等。

在深度学习教学大纲的第三部分,需要介绍深度学习在不同领域的应用案例,并且引导学习者独立完成相关的实践项目。

通过实际应用的学习,学习者可以更好地理解深度学习的实际价值和应用方法。

第四部分:深度学习理论与研究深度学习作为一个不断发展的领域,其中的理论和研究也非常重要。

在深度学习教学大纲的第四部分,需要介绍深度学习的一些重要理论和研究方向,如梯度下降、优化算法和迁移学习等。

学习者需要了解这些理论的原理和应用,并且能够阅读和理解相关的研究论文。

第五部分:深度学习实践与项目在深度学习教学大纲的最后一部分,需要引导学习者进行深度学习的实践和项目。

学习者可以选择一个感兴趣的领域或问题,设计并实现一个深度学习模型来解决。

通过实践项目,学习者可以将前面学到的知识和技能应用到实际情境中,加深对深度学习的理解和掌握。

总结:深度学习教学大纲应该从基础知识开始,逐步深入,涵盖算法、应用、理论和实践等方面。

神经网络与深度学习知识点整理

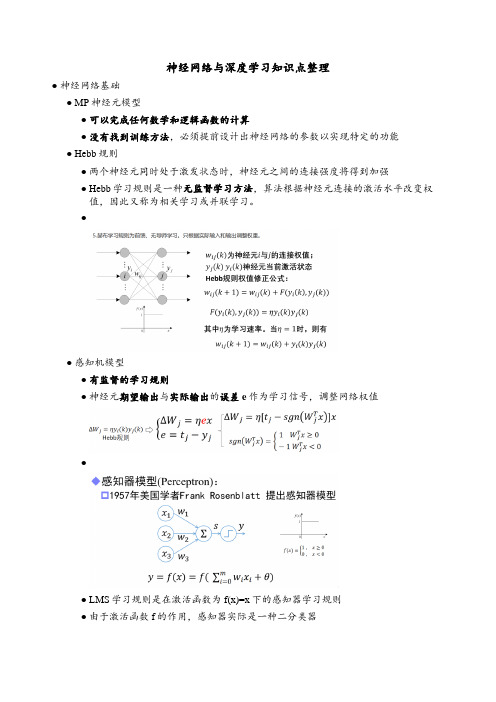

神经网络与深度学习知识点整理●神经网络基础●MP神经元模型●可以完成任何数学和逻辑函数的计算●没有找到训练方法,必须提前设计出神经网络的参数以实现特定的功能●Hebb规则●两个神经元同时处于激发状态时,神经元之间的连接强度将得到加强●Hebb学习规则是一种无监督学习方法,算法根据神经元连接的激活水平改变权值,因此又称为相关学习或并联学习。

●●感知机模型●有监督的学习规则●神经元期望输出与实际输出的误差e作为学习信号,调整网络权值●●LMS学习规则是在激活函数为f(x)=x下的感知器学习规则●由于激活函数f的作用,感知器实际是一种二分类器●感知器调整权值步骤●单层感知器不能解决异或问题●BP网络●特点:●同层神经网络无连接●不允许跨层连接●无反馈连接●BP学习算法由正向传播和反向传播组成●BP网络的激活函数必须处处可导——BP权值的调整采用 Gradient Descent 公式ΔW=-η(偏E/偏w),这个公式要求网络期望输出和单次训练差值(误差E)求导。

所以要求输出值处处可导。

s函数正好满足处处可导。

●运算实例(ppt)●Delta( δ )学习规则●误差纠正式学习——神经元的有监督δ学习规则,用于解决输入输出已知情况下神经元权值学习问题●δ学习规则又称误差修正规则,根据E/w负梯度方向调整神经元间的连接权值,能够使误差函数E达到最小值。

●δ学习规则通过输出与期望值的平方误差最小化,实现权值调整●●1●自动微分●BP神经网络原理:看书●超参数的确定,并没有理论方法指导,根据经验来选择●BP算法已提出,已可实现多隐含层的神经网络,但实际只使用单隐层节点的浅层模型●计算能力的限制●梯度弥散问题●自编码器●●自编码器(Auto-Encoder)作为一种无监督学习方法网络●将输入“编码”为一个中间代码●然后从中间表示“译码”出输入●通过重构误差和误差反传算法训练网络参数●编码器不关心输出(只复现输入),只关心中间层的编码————ℎ=σ(WX+b)●编码ℎ已经承载原始数据信息,但以一种不同的形式表达!●1●正则编码器——损失函数中加入正则项,常用的正则化有L1正则和L2正则●稀疏自编码器——在能量函数中增加对隐含神经元激活的稀疏性约束,以使大部分隐含神经元处于非激活状态●去噪自编码器——训练数据加入噪声,自动编码器学习去除噪声获得无噪声污染的输入,迫使编码器学习输入信号更加鲁棒的表达●堆叠自编码器●自编码器训练结束后,输出层即可去掉,网络关心的是x到ℎ的变换●将ℎ作为原始信息,训练新的自编码器,得到新的特征表达.●逐层贪婪预训练●1●深度神经网络初始化●●卷积神经网络●全连接不适合图像任务●参数数量太多●没有利用像素之间的位置信息●全连接很难传递超过三层●卷积神经网络是一种前馈神经网络,其输出神经元可以响应部分区域内的输入信息,适宜处理图像类信息●1●1●Zero Padding:在原始图像周围补0数量●卷积尺寸缩小,边缘像素点在卷积中被计算的次数少,边缘信息容易丢失●●卷积神经网络架构发展●1●深度发展●LeNet●具备卷积、激活、池化和全连接等基本组件●但GPU未出现,CPU的性能又极其低下●LetNet只使用在手写识别等简单场景,未得到重视●LeNet主要有2个卷积层(5*5)、2个下抽样层(池化层)、3个全连接层●通过sigmoid激活●全连接层输出:共有10个节点分别代表数字0到9,采用径向基函数作为分类器●AlexNet●第一次采用了ReLU,dropout,GPU加速等技巧●AlexNet网络共有:卷积层 5个(1111,55,3*3),池化层 3个,全连接层3个●首次采用了双GPU并行计算加速模式●第一卷积模块:96通道的特征图被分配到2个GPU中,每个GPU上48个特征图;2组48通道的特征图分别在对应的GPU中进行ReLU激活●第一层全连接:同时采用了概率为0.5的Dropout策略●VGG●通过反复堆叠3x3卷积和2x2的池化,得到了最大19层的深度●卷积-ReLU-池化的基本结构●串联多个小卷积,相当于一个大卷积的思想●使用两个串联的3x3卷积,达到5x5的效果,但参数量却只有之前的18/25●串联多个小卷积,增加ReLU非线性激活使用概率,从而增加模型的非线性特征●VGG16网络包含了13个卷积层,5个池化层和3个全连接层。

深度学习技术基础知识文档

深度学习技术基础知识文档第一章:深度学习概述1.1 什么是深度学习•深度学习是一种基于人工神经网络的机器学习方法,通过使用多层神经网络来实现复杂的数据处理和分析。

它可以学习数据的高级抽象特征和模式,实现对数据的精确识别和预测。

1.2 深度学习的核心原理•深度学习的核心原理包括:反向传播算法、激活函数、优化算法等。

这些原理使得深度学习网络可以学习数据的高级抽象特征和模式。

第二章:主要方法介绍2.1 卷积神经网络(CNN)•CNN是一种基于卷积和池化操作的神经网络,主要用于图像识别和分类。

它可以学习图像的局部特征和全局特征,实现对图像的精确识别和分类。

2.2 循环神经网络(RNN)•RNN是一种基于递归和循环连接的神经网络,主要用于序列数据的处理和分析。

它可以学习序列数据的时序特征和依赖关系,实现对序列数据的精确识别和预测。

2.3 长短时记忆网络(LSTM)•LSTM是一种基于门控循环单元的神经网络,主要用于序列数据的处理和分析。

它可以学习序列数据的长期依赖关系和时序特征,实现对序列数据的精确识别和预测。

第三章:应用领域3.1 自然语言处理(NLP)•NLP是人工智能的一个分支,主要研究如何使计算机理解和处理人类语言。

深度学习在NLP中的应用包括:文本分类、情感分析、机器翻译等。

3.2 计算机视觉(CV)•CV是人工智能的一个分支,主要研究如何使计算机理解和处理图像和视频。

深度学习在CV中的应用包括:图像识别、目标检测、图像生成等。

第四章:伦理考量4.1 数据隐私保护•数据隐私保护是深度学习应用中的一个重要伦理问题。

我们需要确保数据的隐私和安全,避免数据的滥用和泄露。

4.2 AI偏见和公平性•AI偏见和公平性是深度学习应用中的一个重要伦理问题。

我们需要确保AI系统的公平性和无偏见,避免AI系统的歧视和偏见。

第五章:结论•深度学习是一种强大的机器学习方法,可以实现对数据的精确识别和预测。

通过了解深度学习的核心原理和主要方法,我们可以更好地应用深度学习技术来解决实际问题。

深度学习面试基本知识

深度学习面试基本知识深度学习是机器学习的一个分支,它通过建立多层神经网络模型来模拟人类的神经系统,从而实现对数据的学习和分析。

在深度学习领域,掌握一些基本知识是进行面试的必备条件。

本文将介绍一些深度学习面试中常见的基本知识点。

1. 神经网络基础神经网络是深度学习的核心模型,它由多个神经元组成,每个神经元接收来自上一层神经元的输入,并将输入通过激活函数处理后传递给下一层神经元。

常见的神经网络结构包括前馈神经网络(Feedforward Neural Network)和循环神经网络(Recurrent Neural Network)等。

在面试中,你可能需要了解以下几个与神经网络相关的知识点:1.1 激活函数激活函数是神经网络中的一种非线性函数,它的作用是引入非线性因素,增加网络的表示能力。

常见的激活函数有Sigmoid函数、ReLU函数和Tanh函数等。

你需要理解这些激活函数的定义、特点以及适用场景。

1.2 损失函数损失函数用于衡量神经网络输出与真实值之间的差异,是深度学习中的一个重要概念。

常见的损失函数有均方误差(Mean Squared Error)和交叉熵(Cross Entropy)等。

你需要了解这些损失函数的定义、优缺点以及适用场景。

1.3 反向传播算法反向传播算法是训练神经网络的核心算法,它通过计算损失函数对网络参数的导数,从而根据梯度下降的原理进行参数更新。

你需要了解反向传播算法的基本原理,包括链式法则和梯度计算方法。

2. 卷积神经网络(CNN)卷积神经网络是深度学习中用于处理图像和语音等二维数据的重要模型。

它通过卷积、池化和全连接等操作来提取输入数据的特征,并进行分类或回归预测。

在面试中,你可能需要了解以下几个与卷积神经网络相关的知识点:2.1 卷积层卷积层是卷积神经网络的核心组件,它通过滑动窗口的方式对输入数据进行卷积操作,从而提取特征信息。

你需要了解卷积层的基本原理、参数设置以及卷积核的作用。

基于“深度学习”理念的高中数学教学策略

基于“深度学习”理念的高中数学教学策略一、深度学习的理念深度学习是一种建立在多层次结构上的机器学习算法,它模仿人类大脑神经元之间的连接方式,通过多层次的信息传递和提取,实现对复杂数据的识别、处理和学习。

深度学习的核心思想包括分层表达、分层特征和分层学习,它通过层层递进的学习过程,将抽象的高级特征逐步提取出来,最终完成对复杂问题的建模和解决。

在教育领域,深度学习的理念可以被借鉴和应用到教学实践中,以帮助学生更好地理解和掌握知识,培养他们的综合素养和创新能力。

1. 强调基础知识的扎实性深度学习注重分层表达和分层学习,对基础知识的扎实性要求较高。

在高中数学教学中,教师应该通过适当的知识层层递进的方式,帮助学生系统地掌握数学的基础知识,包括代数、几何、函数、概率与统计等方面的知识,并强调其在数学学科中的重要性和应用价值。

可以通过适当的案例分析和综合训练等方式,引导学生将这些基础知识融会贯通,形成系统的数学知识结构。

2. 注重知识的深度理解和应用在深度学习中,知识的深度理解和应用是至关重要的。

在高中数学教学中,教师可以引导学生通过分析问题、归纳总结和实际应用等方式,深入理解数学知识的本质和内在规律,培养学生发现问题、解决问题的能力。

教师可以设计一些开放性的问题和探究性的任务,激发学生的思维和创造力,帮助他们将数学知识运用到实际问题中去解决。

3. 打破学科间的壁垒,促进跨学科的综合应用在深度学习中,不同层次的特征需要进行综合,才能完成对复杂问题的整体理解和解决。

在高中数学教学中,教师可以引导学生将数学知识与其他学科的知识相结合,应用于跨学科的综合性问题中。

在物理、化学、生物等学科中,经常会涉及到与数学相关的问题,教师可以借助这些跨学科的问题,让学生将数学知识与其他学科的知识相融合,从而提升他们的学科综合能力。

4. 提倡自主学习和合作学习深度学习强调学习者的自主性和合作性,在高中数学教学中,教师可以为学生创设一个积极向上的学习氛围,引导学生积极参与思维碰撞、观点交流和问题探究。

深度学习的理论基础

深度学习的理论基础作者:周雪婷吉慧来源:《卷宗》2017年第23期摘要:在现如今的教育发展趋势下,深度学习已经成为了一种不可阻挡的趋势。

深度学习提倡主动性、批判性的有意义学习,其产生与发展有着悠久的思想渊源和丰厚的理论基础。

本文着重分析了建构主义、情境认知理论对深度学习的解释和影响,以及分布式认知理论和元认知理论对深度学习引导与调节的理论意义。

关键字:建构主义;情景认知;分布式认知;元认知1 建构主义建构主义之于深度学习的意义在于它不同于行为主义和认知主义的学习观、知识观以及学习者的地位。

在学习观上,建构主义认为“学习依赖于个体的意义建构,同时意义的建构过程是镶嵌在一个特定的的社会场景之中”,也就是说学习是一个个体层面的意义制定过程以及共同体层面的社会文化参与的过程。

在知识观上,建构主义认为知识是一种非“惰性知识”,它与现实世界相关联,并能够有效地解决现实中的问题。

在学习者的地位上,建构主义注重知识的建构性,这就意味着学习者需要积极探索周围世界和解决问题,去理解和获得新知识,换句话说,学习者在学习上扮演着积极主动的建构者的身份。

深度学习的产生是建立在自己对世界、对现实生活已有理解和经验的基础上,在实践中积极创设与建构新的知识,并将之整合到原有的认知框架中,形成新的认知结构,而深度学习下的认知结构是围绕“大概念”建构起来的认知结构,在“大概念”的统领下形成一个复杂的认知网络,学习者在该认知网络下能够跟随情景提取相应的信息,解决一定的问题。

学习者在这一问题解决的过程中,逐渐积累经验,获取某一领域的技能,即适应性专长。

建构主义为深度学习的发展提供了认识论基础,在该理论的指导下,深度学习较为关注学习者的先前知识,注重学习者“大观点”统筹下的复杂知识结构的形成,强调学习者的适应性专长。

2 情景认知自20世纪80年代末以来,情景认知(situated cognition)逐渐受到研究者的关注,并成为一种能够提供有意义学习、同时能够促进知识向真实情景转化的重要理论。

学习深度学习需要掌握的基础知识

学习深度学习需要掌握的基础知识

1.数学基础:矩阵运算、线性变换、奇异值分解等线性代数知识;导数、微分、积分等高等数学知识;概率分布、期望、方差、协方差、卡方分布等概率论和数理统计知识。

2.训练数据、特征、目标、模型、激活函数、损失函数、优化算法等机器学习基础知识;BP神经网络的基本原理。

3.卷积、池化、dropout、Batch Normalization、全连接、epoch、batch_size、iterration等卷积神经网络的概念和原理;LeNet、AlexNet、VGG、ResNet、LSTM、GAN、Attention机制、Transformer等经典模型和算法的基本原理。

4.Python的基础语法;深度学习框架的基本使用方法,例如用PyTorch 搭建一个CNN模型,对MNIST数据集进行训练和测试。

深度学习的基础知识

深度学习的基础知识深度学习(Deep Learning)是一种基于人工神经网络的机器学习方法,它模拟人类大脑的结构和功能,通过多层次的非线性处理单元对数据进行特征提取和建模,从而实现对复杂问题的学习和推断。

深度学习在语音识别、图像识别、自然语言处理和推荐系统等领域取得了广泛的应用和突破,成为了当今人工智能领域的热点之一。

本文将从深度学习的基本原理、常见模型和应用实例等方面介绍深度学习的基础知识,帮助读者深入了解深度学习的相关内容。

一、深度学习的基本原理深度学习模型的核心是人工神经网络(Artificial Neural Networks,ANNs),它由大量的神经元(Neurons)和连接它们的权重(Weights)组成,每个神经元接收来自前一层神经元的输入,并对其进行加权和非线性变换后输出给下一层神经元。

整个网络通过多层次的非线性处理单元逐层组合,形成了深度结构,从而能够学习到更加复杂的特征和模式。

1.神经元的工作原理神经元是人工神经网络的基本组成单元,它模拟了生物神经元的工作原理。

每个神经元接收来自前一层神经元的多个输入信号,通过加权和非线性变换后输出给下一层神经元。

具体来说,神经元的输入经过加权和求和后,再经过一个激活函数(Activation Function)进行非线性变换,最终输出给下一层神经元。

常用的激活函数包括Sigmoid函数、ReLU函数和tanh函数等。

2.神经网络的训练人工神经网络通过学习来调整连接权重,使得网络能够适应输入数据的特征和模式。

网络的训练通常采用梯度下降法(Gradient Descent)。

具体来说,网络先进行前向传播,将输入数据通过每层神经元的加权和非线性变换后输出给输出层,然后计算输出层的预测值与真实标签值的误差,最后通过反向传播算法将误差逐层传递回去,调整每个神经元的权重。

3.深度学习的优化深度学习模型通常会面临的问题包括梯度消失和梯度爆炸等。

为了解决这些问题,人们提出了许多优化方法,如Batch Normalization、Dropout和Residual Network等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

深度学习基础知识整理

Without deviation from the norm,progress is not possible(不偏离常规,就无法取得进步-Frank Zappa)

第一课:数学分析与概率论

Taylor展式及其应用、凸函数、jensen不等式、常见分布与共轭分布

第二课:数理统计与参数估计

Chebyshev不等式、大数定理、小数定理、中心极值定理、矩阵计算、最大似然估计

第三课:矩阵和线性代数

从马尔克夫模型看矩阵、特征向量、对称矩阵、线性方程

第四课:凸优化

凸函数、共轭函数、凸优化、Lagrange对偶函数

第五课:回归

高斯分布、Logistic回归、梯度下降、特征选择与过拟合欠拟合关系

应用方向:线性回归、Logistic回归实现和分析

第六课:梯度下降与拟牛顿法

梯度下降算法、自适应学习率、拟牛顿、LBFGS

应用方向:自适应学习率代码实现和参数调试分析

第七课:最大熵模型

熵、相对熵、信息增益、最大熵模型、Softmax回归

应用方向:独立成分分析ICA求解盲源分离BBS问题

第八课:决策树和随机森林(蒙特卡罗)ID3、C4.5、CART、Bagging

研究方向:使用随机森林进行数据分类(蒙特卡洛)

第九课:SVM

线性可分支持向量机、软间隔、核函数、SMO

研究方向:使用SVM进行数据分类

第十课:聚类

K-means/K-Medoids、密度聚类、谱聚类、

应用方向:K-means、谱聚类代码实现和参数调试分析

第十一课:推荐系统

相似度量方案、协同过滤(User-based/ltem-based)、PCA/SVD、随机游走

应用方向:协同过滤用于商品推荐、SVD隐变量的推荐

第十二课:提升

梯度提升决策树GBDT、Adaboost、前向分步算法

应用方向:Adaboost与随机森林(蒙特卡洛)结合、用于数据分类

第十三课:EM算法和GMM

EMM算法、GMM、主题模型pLSA

应用方向:分解部分观测数据的男女身高、图像分解

第十四课:普斯贝叶斯和贝叶斯网络初步

有向分离、(隐)马尔科夫模型HMM

第十五课:主题模型用EM算法计算pLSA、Dirichiet分布、LDA、Gibbs采样

应用方向:使用Gibbs采样计算给语料的主题

第十六课:采样

MCMC(Markov chain Monte Carlo)、Metropolis-Hastings 算法、Gibbs采样

第十七课:变分

KL(pllq)与KL(qllp)分析、平均场理论

第十八课:隐马尔科夫模型HMM

概率计算问题、HMM参数学习问题、状态预测问题

应用方向:使用HMM进行中文分词

第十九课:条件随机场CRF

无向图模型、MRF、前向-后向算法

第二十课:深度学习

全连接网络、链式法则与BP算法、卷积网络、残差网络、应用方向:使用BP网络对样本分类

第十三课:深度学习总体介绍

1.神经网络;传统到现代

2.深度学习应用特定

3.深度学习发展方向

4.深度学习框架比较:用Tensorflow进行课程学习

第十四课:传统神经网络

1. 线性回归

2. 非线性激励函数

3. loss 函数,常见问题:过拟合,正则化,dropout

实例:传统神经网络络实现

第十五课反向反馈:深度学习模型优化基础

1. SGD 梯度下降介绍

2. 神经网络的梯度优化

3. 神经网络训练

实例:反向梯度优化对比

第十六课卷积神经网络

1. 卷积核以及卷积层

2. AlexNet 最早的现代神经网络

3. VGG,GoogleNet,,ResNet. 近期的高级网络LeNet

实例:利用已有模型进行物体分类/特征提取

第十七课迁移学习

1. 理论分析

2. 迁移模型&原始训练模型

3. 如何设计新的的网络

实例:表情识别/人脸识别/动物识别

第十八课与时域信息相关的深度学习

1. RNN

2. LSTM

3. 图片标题生成

4. 视频处理

实例:LSTM用于图片标题生成

第十九课自然语言处理

1. 处理之前:speech to text

2. 词语表达,word2vect

3. 语句生成LSTM

实例:根据上下文回答问题

第二十课给予深度学习的目标检测

1. 传统的目标检测方法

2. 初代算法: Region CNN

3. 升级: SPP Net, Fast RCNN, Faster RCNN

4. 深度学习另辟蹊径: YoLo 和SSD

实例:自动驾驶的核心:实时目标检测

第二十一课深度卷积神经偶的重要应用

1. 图片问答

2. 图像模式转换

3. 图像高清化

4. 围棋程序, Alpha go

5. 自动游戏机器人,DeepMind Atari

实例:图片艺术风格转化

第二十二课无监督学习:对抗网络GAN

1. 传统无监督学习 Autoencode,K Means,Sparse Coding

2. RBM 限制博斯曼机,深度学习的另一支

3. 生成对抗网络 GAN

实例:机器生成图片,以假乱真

第二十三课:迁移学习

第二十四课:增强学习

记忆模型,远超过RNN的GTMM

第二十五课:二值神经网络

普通二值神经网络,YodaNN,

XLA如何让机器学习在TensorFlow上提升速度

第二十六课:对偶学习

纳米神经网络NanoNet

A solution to the single-question crowd wisdom problem(选自自然杂志意味流行算法解决群体智慧中缺陷)

语义理解(目前自然语言界最大难关)使用LSTM+Attion解决

像素卷积神经网络(PixelCNN++)可将图像生成速度提高183倍

WaveNet

RLSS schedule to be posted soon(深度学习与强化学习暑期学校)机器与大脑学习项目课程计划

CNNs

RNNs

Generative Models 2

Computational Neuroscience 1

Learning to learn

Coffe Break

Neural Networks

Structured Models /Advanced Vision

Probabillstic Numerics

Natural Language Understanding

Computational

常见问题:

Q:会有实际上机演示和动手操作吗?

A:有,几乎每节课,老师均会准备上机演示部分,学员可以学习老师的实践经验。

Q:参加本门课程有什么要求?

A:有一定Python编程能力,有几本大学数学基础。

Q:本课程怎么答疑?

A:会有专门的QQ班级群,同学们可以针对课上知识的问题,或者自己学习与

动手实践中的问题,向老师提问,老师会进行相应解答。

也推荐大家到小象问答社区提问,方便知识的沉淀,老师会集中回答,不会因为QQ群信息刷屏而被老师错过。

Q:本课程需要什么环境?

A:开发环境主要以Ubuntu为主,深度学习训练需要有可以支持的显卡,基本要求GTX 960,有条件的尽量 GTX 1080, GTX Titan X 更好(显卡的内核数以及显存数尽量多一点)。