神经网络论文,

神经网络模型的研究毕业论文

神经网络模型的研究毕业论文简介本文旨在研究神经网络模型在机器研究中的应用。

神经网络是一种模仿人类神经系统工作的数学模型,能够研究输入和输出之间的复杂关系,并通过调整模型参数来提高预测准确度。

本文将探讨神经网络的基本原理、常见的网络结构和训练方法。

神经网络的基本原理神经网络由许多神经元组成,每个神经元接收来自其他神经元的输入,并通过激活函数进行处理,最终产生输出。

神经网络通过不断调整神经元之间的连接权重来研究输入和输出之间的关系。

常见的神经网络结构本文将介绍几种常见的神经网络结构,包括前馈神经网络、卷积神经网络和循环神经网络。

前馈神经网络是最基本的神经网络结构,信息只在一个方向传递。

卷积神经网络在图像处理中有广泛应用,能够从原始像素中提取特征。

循环神经网络则可以处理具有时序关系的数据,如文本和语音。

神经网络的训练方法神经网络的训练是通过优化算法来调整网络参数以减小预测误差。

本文将介绍几种常用的优化算法,包括梯度下降法和反向传播算法。

梯度下降法通过计算损失函数的梯度来更新网络参数,以使预测结果与实际输出更接近。

反向传播算法则是一种高效计算梯度的方法。

实验与结果分析本文将设计并实施几个实验来验证神经网络模型的性能。

通过使用公开的数据集和适当的评估指标,我们将对不同网络结构和训练方法进行比较,并对实验结果进行分析和讨论。

结论神经网络模型在机器研究中有着广泛的应用前景。

本文通过对神经网络的基本原理、常见的网络结构和训练方法的介绍,以及实验结果的分析,为研究和应用神经网络模型提供了有效的参考。

以上为《神经网络模型的研究毕业论文》的大纲。

神经网络的应用论文

神经网络的原理及应用摘要:通过阅读相关文献,总结了神经网络方面的基本原理和应用。

首先介绍了Hopfield神经网络中的离散型网络,并介绍其实现交通标志的步骤。

随着神经网络的发展,其局限性日益凸显。

为此,科学家们提出了与其它方法结合的神经网络。

本文介绍了遗传算法优化BP神经网络的原理及在在坝基岩体渗透系数识别中的应用,还介绍了模糊神经网络的原理及在预测地基沉降量中的应用,最后介绍了小波神经网络的原理及在电力负荷预测中的应用。

关键字:神经网络、Hopfield、遗传算法、模糊神经网络、小波神经网络绪论Hopfield网络及学习算法最初是由美国物理学家J.J Hopfield于1982年首先提出的,曾经为人工神经网络的发展进程开辟了新的研究途径。

它利用与阶层型神经网络不同的结构特征和学习方法,模拟生物神经网络的记忆机理,获得了令人满意的结果。

Hopfield最早提出的网络是二值神经网络,神经元的输出只取1和0,所以,也称离散Hopfield神经网络(Discrete Hopfield Neural Network,DHNN)。

在离散Hopfield网络中,所采用的神经元是二值神经元,因此,所输出的离散值1和0分别表示神经元处于激活和抑制状态。

Hopfield神经网络是递归神经网络的一种,在函数优化和联想记忆等方面有大量的应用。

其运行机理与反馈神经网络有本质的区别,运行规律更加复杂。

神经网络由于高度复杂的非线性结构导致其内部存在大量的局部极值点,而传统的梯度下降法训练神经网络有可能收敛于局部极值点,造成神经网络性能变差,甚至无法使用。

随着现代非线性优化方法异军突起,特别是赫赫有名的遗传算法,具有极强的全局搜索能力,其收敛的有效性得到了理论和实践的充分检验。

因此,遗传神经网络是解决高复杂性情况下全局收敛问题的有效途径。

系统的复杂性与所要求的精确性之间存在着尖锐矛盾,模糊逻辑、神经网络和专家控制等智能系统为缓解这种矛盾提供了有效途径,但是这些系统单个运用时常常存在多种问题,因此人们便根据它们的优缺点提出了融合使用的新思路,如本文的模糊神经网络。

深度图神经网络(GNN)论文

深度图神经⽹络(GNN)论⽂part1/经典款论⽂1. KDD 2016,Node2vec 经典必读第⼀篇,平衡同质性和结构性《node2vec: Scalable Feature Learning for Networks》2. WWW2015,LINE 1阶+2阶相似度《Line: Large-scale information network embedding》3. KDD 2016,SDNE 多层⾃编码器《Structural deep network embedding》4. KDD 2017,metapath2vec 异构图⽹络《metapath2vec: Scalable representation learning for heterogeneous networks》5. NIPS 2013,TransE 知识图谱奠基《Translating Embeddings for Modeling Multi-relational Data》6. ICLR 2018,GAT attention机制《Graph Attention Network》7. NIPS 2017,GraphSAGE 归纳式学习框架《Inductive Representation Learning on Large Graphs 》8. ICLR 2017,GCN 图神经开⼭之作《SEMI-SUPERVISED CLASSIFICATION WITH GRAPH CONVOLUTIONAL NETWORKS》9. ICLR 2016,GGNN 门控图神经⽹络《Gated Graph Sequence Neural Networks》10. ICML 2017,MPNN 空域卷积消息传递框架《Neural Message Passing for Quantum Chemistry》part2/热门款论⽂2020年之前11.[arXiv 2019]Revisiting Graph Neural Networks: All We Have is Low-Pass Filters重温图神经⽹络:我们只有低通滤波器[论⽂]12.[NeurIPS 2019]Break the Ceiling: Stronger Multi-scale Deep Graph Convolutional Networks 打破天花板:更强的多尺度深度图卷积⽹络[论⽂]13.[ICLR 2019] Predict then Propagate: Graph Neural Networks meet Personalized PageRank先预测后传播:图神经⽹络满⾜个性化 PageRank[论⽂][代码]14.[ICCV 2019]DeepGCNs: Can GCNs Go as Deep as CNNs?DeepGCN:GCN能像CNN⼀样深⼊吗?[论⽂][代码(Pytorch)][代码(TensorFlow)]15.[ICML 2018]Representation Learning on Graphs with Jumping Knowledge Networks基于跳跃知识⽹络的图表征学习[论⽂]16.[AAAI 2018]Deeper Insights into Graph Convolutional Networks for Semi-Supervised Learning深⼊了解⽤于半监督学习的图卷积⽹络[论⽂]2020年17.[arXiv 2020]Deep Graph Neural Networks with Shallow Subgraph Samplers具有浅⼦图采样器的深图神经⽹络[论⽂]18.[arXiv 2020]Revisiting Graph Convolutional Network on Semi-Supervised Node Classification from an Optimization Perspective从优化的⾓度重新审视半监督节点分类的图卷积⽹络[论⽂]19.[arXiv 2020]Tackling Over-Smoothing for General Graph Convolutional Networks解决通⽤图卷积⽹络的过度平滑[论⽂]20.[arXiv 2020]DeeperGCN: All You Need to Train Deeper GCNsDeeperGCN:训练更深的 GCN 所需的⼀切[论⽂][代码]21.[arXiv 2020]Effective Training Strategies for Deep Graph Neural Networks深度图神经⽹络的有效训练策略[论⽂][代码]22.[arXiv 2020]Revisiting Over-smoothing in Deep GCNs重新审视深度GCN中的过度平滑[论⽂]23.[NeurIPS 2020]Graph Random Neural Networks for Semi-Supervised Learning on Graphs⽤于图上半监督学习的图随机神经⽹络[论⽂][代码]24.[NeurIPS 2020]Scattering GCN: Overcoming Oversmoothness in Graph Convolutional Networks 散射GCN:克服图卷积⽹络中的过度平滑[论⽂][代码]25.[NeurIPS 2020]Optimization and Generalization Analysis of Transduction through Gradient Boosting and Application to Multi-scale Graph Neural NetworksTransduction through Gradient Boosting 的优化和泛化分析及其在多尺度图神经⽹络中的应⽤[论⽂][代码]26.[NeurIPS 2020]Towards Deeper Graph Neural Networks with Differentiable Group Normalization 迈向具有可微组归⼀化的更深图神经⽹络[论⽂]27.[ICML 2020 Workshop GRL+]A Note on Over-Smoothing for Graph Neural Networks关于图神经⽹络过度平滑的说明[论⽂]28.[ICML 2020]Bayesian Graph Neural Networks with Adaptive Connection Sampling具有⾃适应连接采样的贝叶斯图神经⽹络[论⽂]29.[ICML 2020]Continuous Graph Neural Networks连续图神经⽹络[论⽂]30.[ICML 2020]Simple and Deep Graph Convolutional Networks简单和深度图卷积⽹络[论⽂] [代码]31.[KDD 2020] Towards Deeper Graph Neural Networks⾛向更深的图神经⽹络[论⽂] [代码]32.[ICLR 2020]Graph Neural Networks Exponentially Lose Expressive Power for Node Classification 图神经⽹络对节点分类的表达能⼒呈指数级 下降[论⽂][代码]33.[ICLR 2020] DropEdge: Towards Deep Graph Convolutional Networks on Node Classification DropEdge:迈向节点分类的深度图卷积⽹络[Paper][Code]34.[ICLR 2020] PairNorm: Tackling Oversmoothing in GNNsPairNorm:解决GNN中的过度平滑问题[论⽂][代码]35.[ICLR 2020]Measuring and Improving the Use of Graph Information in Graph Neural Networks测量和改进图神经⽹络中图信息的使⽤[论⽂] [代码]36.[AAAI 2020]Measuring and Relieving the Over-smoothing Problem for Graph Neural Networks from the Topological View从拓扑⾓度测量和缓解图神经⽹络的过度平滑问题[论⽂]同学们是不是发现有些论⽂有代码,有些论⽂没有代码?学姐建议学概念读没代码的,然后再读有代码的,原因的话上周的⽂章有写,花⼏分钟看⼀下【学姐带你玩AI】公众号的——《图像识别深度学习研究⽅向没有导师带该怎么学习》part3/最新款论⽂37.[arXiv 2021]Two Sides of the Same Coin: Heterophily and Oversmoothing in Graph Convolutional Neural Networks同⼀枚硬币的两⾯:图卷积神经⽹络中的异质性和过度平滑[论⽂]38.[arXiv 2021]Graph Neural Networks Inspired by Classical Iterative Algorithms受经典迭代算法启发的图神经⽹络[论⽂]39.[ICML 2021]Training Graph Neural Networks with 1000 Layers训练 1000 层图神经⽹络[论⽂][代码]40.[ICML 2021] Directional Graph Networks ⽅向图⽹络[论⽂][代码]41.[ICLR 2021]On the Bottleneck of Graph Neural Networks and its Practical Implications 关于图神经⽹络的瓶颈及其实际意义[论⽂]42.[ICLR 2021] Adaptive Universal Generalized PageRank Graph Neural Network[论⽂][代码]43.[ICLR 2021]Simple Spectral Graph Convolution简单的谱图卷积[论⽂]。

神经网络经典论文

神经网络经典论文神经网络经典论文神经网络可以指向两种,一个是生物神经网络,一个是人工神经网络。

那么关于人工的神经网络的论文应该怎么写呢?下面就和小编一起来看看吧。

摘要:软件需求分析不仅仅是为了让开发者满足用户要求,而且还可以帮助用户了解软件的性能和功能,具有一举两得的效果,但是如果软件需求不符合实际需求,就会出现风险,导致返工。

在BP神经网络的基础上,我们建立了软件需求分析风险评估模型,以减少软件开发的失败率,规避因软件需求分析失误而带来的实际存在的或潜在的风险。

关键词:风险;软件需求;BP神经网络;研究;分析软件开发过程中,需求分析是一个关键性的阶段。

导致它失败的原因有很多,例如开发者和用户之间的沟通障碍、软件本身的隐含性、需求信息的不对称等等。

这些问题导致的返工,增加了开发的成本,也损坏了企业形象,更可能流失掉部分用户。

因此,我们必须对软件需求分析进行风险评估管理,把负面影响降到最低。

现代商业发展中,各企业和企业之间的竞争日趋激烈,掌握最新的技术,对技术进行创新,才是企业在行业内立足脚跟,获得更加长远发展的方法,因此要想牢牢地把握企业的运命就需要我们保持对技术创新的热情,并在这条道路上乐此不疲。

21世纪,只有掌握了最新和最具有创造性的技术,才能赢的最后的胜利,本文把BP网络与软件需求分析风险评估模型相结合,具有十分重要的意义。

1BP神经网络BP神经网络是开发者使用最多的神经网络之一,它具有算法简单、极强的鲁棒性、收敛速度极快等优点。

最重要的一点是能够最大限度的接近其真实系统,非常适合于线性的、不确定的、模糊的软件风险数据。

BP算法是一种用于前向多层神经网络的的反传学习算法。

采用BP算法的数层感知器神经网络模型,它的基本思想是,学习过程由信号的正向传播和误差的反向传播两个过程组成。

模糊理论采用模糊数学的方法,通过抽象思维,对处于多种因素作用下的事物做出总体评价。

它的两大主要特征是:第一,结果清晰;第二,系统性强,这非常适合于各种非确定性问题的解决。

人工智能神经网络论文

人工智能神经网络论文随着科学技术的发展,人工神经网络技术得到了空前的发展,并且在诸多领域得到了广泛的应用,为人工智能化的发展提供了强大的动力。

以下是店铺整理分享的人工智能神经网络论文的相关资料,欢迎阅读!人工智能神经网络论文篇一人工神经网络的发展及应用摘要随着科学技术的发展,人工神经网络技术得到了空前的发展,并且在诸多领域得到了广泛的应用,为人工智能化的发展提供了强大的动力。

人工神经网络的发展经历了不同的阶段,是人工智能的重要组成部分,并且在发展过程中形成了自身独特的特点。

文章对人工神经网络的发展历程进行回顾,并对其在各个领域的应用情况进行探讨。

关键词人工神经网络;发展;应用随着科学技术的发展,各个行业和领域都在进行人工智能化的研究工作,已经成为专家学者研究的热点。

人工神经网络就是在人工智能基础上发展而来的重要分支,对人工智能的发展具有重要的促进作用。

人工神经网络从形成之初发展至今,经历了不同的发展阶段,并且在经济、生物、医学等领域得到了广泛的应用,解决了许多技术上的难题。

1人工神经网络概述关于人工神经网络,到目前为止还没有一个得到广泛认可的统一定义,综合各专家学者的观点可以将人工神经网络简单的概括为是模仿人脑的结构和功能的计算机信息处理系统[1]。

人工神经网络具有自身的发展特性,其具有很强的并行结构以及并行处理的能力,在实时和动态控制时能够起到很好的作用;人工神经网络具有非线性映射的特性,对处理非线性控制的问题时能给予一定的帮助;人工神经网络可以通过训练掌握数据归纳和处理的能力,因此在数学模型等难以处理时对问题进行解决;人工神经网络的适应性和集成性很强,能够适应不同规模的信息处理和大规模集成数据的处理与控制;人工神经网络不但在软件技术上比较成熟,而且近年来在硬件方面也得到了较大发展,提高了人工神经网络系统的信息处理能力。

2人工神经网络的发展历程2.1 萌芽时期在20世纪40年代,生物学家McCulloch与数学家Pitts共同发表文章,第一次提出了关于神经元的模型M-P模型,这一理论的提出为神经网络模型的研究和开发奠定了基础,在此基础上人工神经网络研究逐渐展开。

mlp神经网络3篇

mlp神经网络第一篇:MLP神经网络的基本原理与结构MLP神经网络是一种常见的前馈式人工神经网络模型,它由输入层、中间层、输出层三层神经元节点组成。

该模型的本质是一种非线性映射函数,可以通过训练数据来学习输入和输出之间的映射关系,从而实现分类、回归等任务。

输入层是对外部数据进行输入的地方,每个输入层节点对应一个特征变量,其输入值通常为实数。

中间层则是对输入数据的非线性变换,它由众多神经元节点组成,每个节点的值是由上一层节点的权重与偏置项线性组合后再经过一个激活函数得到。

输出层是将中间层的结果映射到目标值上,通常为分类问题中各类别的概率输出。

不同的激活函数和输出层形式可以应对不同的任务需求,如常用的sigmoid、tanh、ReLU和softmax等。

MLP神经网络可通过误差反向传递算法进行训练,即通过最小化损失函数来优化神经网络各节点的权重和偏置项。

通常采用随机梯度下降法求解优化问题,即依次针对每个训练样本计算误差和梯度,然后更新模型参数,不断迭代直至收敛。

该算法不仅可用于单层神经网络,还可以扩展到多层神经网络中,即全连接神经网络。

MLP神经网络的优点包括强大的表达能力、良好的泛化能力和灵活可调性等,适用于众多领域,如自然语言处理、计算机视觉、语音识别等。

其缺点则包括不能处理序列化数据和容易陷入局部最优等问题。

在实际应用中,需要根据具体情况灵活设计网络结构和算法参数,并加以调参和正则化等手段来提高模型性能和鲁棒性。

第二篇:MLP神经网络的进展和应用现状近年来,随着深度学习技术的发展和优化,MLP神经网络在各领域的应用也日益广泛。

特别是在计算机视觉、自然语言处理、语音识别等领域,已成为众多问题的首选方法之一。

在计算机视觉领域,MLP神经网络可用于图像分类、目标检测、人脸识别等任务。

通过使用深度卷积神经网络,可在大规模图像数据集上进行有监督学习,从而实现高精度的分类和检测效果。

同时,还可以将MLP网络与生成对抗网络(GAN)结合,实现图像风格转换、超分辨率等应用。

神经网络论文1

基于倒立摆的PID神经元网络的控制系统的研究摘要摆系统是一个典型的强耦合、非线性、高阶次的不稳定系统。

由于摆系统的数学模型是在忽略了次要因素的基础上得出来的,而实际上是一个非线性的系统,当系统受到外部的干扰时,这些次要因素的影响比较突出。

实验采用PID神经元,设计一个神经网络间接自适应控制系统,首先用一个神经网络对摆系统模型进行辨识,辨识完成后,辨识模型的权值与隐层积分元的数值传递给具有同样结构的PID神经元的神经网络控制器,对倒立摆进行自适应控制。

最后根据以上算法,采用6.0编写控制程序,实现对平面一级摆系统的实时控制。

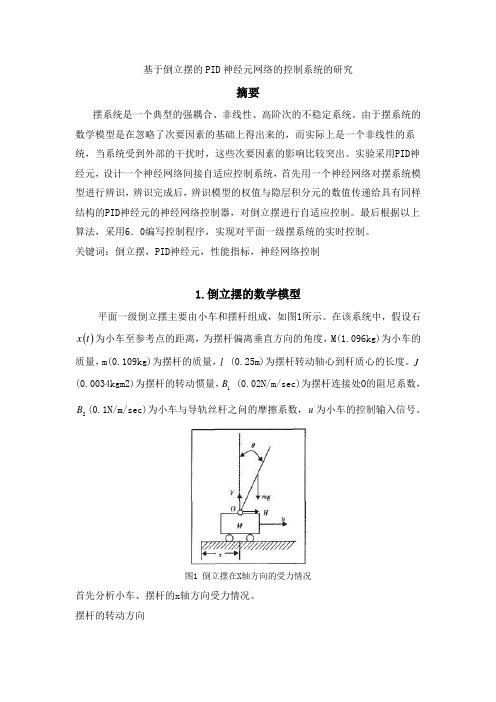

关键词:倒立摆,PID神经元,性能指标,神经网络控制1.倒立摆的数学模型平面一级倒立摆主要由小车和摆杆组成,如图1所示。

在该系统中,假设石()x t为小车至参考点的距离,为摆杆偏离垂直方向的角度,M(1.096kg)为小车的质量,m(0.109kg)为摆杆的质量,l (0.25m)为摆杆转动轴心到杆质心的长度。

J(0.0034kgm2)为摆杆的转动惯量,B (0.02N/m/sec)为摆杆连接处O的阻尼系数,1B(0.1N/m/sec)为小车与导轨丝杆之问的摩擦系数,u为小车的控制输入信号。

2图1 倒立摆在X轴方向的受力情况首先分析小车、摆杆的x轴方向受力情况。

摆杆的转动方向212sin cos d d J B Vl Hl dt dtθθθθ+=- (1) 摆杆的垂直方向22(cos )d l m V mg dtθ=- (2) 摆杆的水平方向,22(cos )d x l m H dt θ+= (3)小车的水平方向222d x dx M B u H dt dt+=- (4) 式中:J —摆杆的转动惯量,2/3J ml =;H 、V —摆杆和小车铰链处的水平与垂直方向的反作用力;12B B 、—小车与导轨之间、摆杆与小车之间的摩擦系数。

消除式(1)、(2)、(3)与(4)中的V 与H ,当θ趋于0时,可以进行线性化处理,即令sin θθ≈,cos 1θ≈,0θ∙≈,整理后得到系统的状态空间方程为[4]2222221222221222010()0()()()()0001()()0()()()x x J ml B mlB m l g J ml x x M J ml mJM J ml mJM J ml mJ M J ml B mlB M m mg M m M J ml mJM J ml mJM J ml mJ θθθθ∙∙∙∙∙∙∙∙⎡⎤⎡⎤⎡⎤⎢⎥⎢⎥-++⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥++++++++⎢⎥=+⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥-++⎢⎥⎢⎥⎣⎦⎢⎥⎢⎥⎣⎦++++++⎣⎦20()mJ u ml M J ml mJ ⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥++⎣⎦将参数代人方程之中,可得0100000.08830.62930.04710.88320001000.235727.8285 2.0841 2.3566x x x x θθθθ∙∙∙∙∙∙∙∙⎡⎤⎡⎤⎢⎥⎡⎤⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥=+⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥-⎢⎥⎣⎦⎣⎦⎢⎥⎣⎦⎢⎥⎣⎦(6)简化为:X AX Bu ∙=+(7)同样可得到摆系统在轴方向的数学模型。

对于神经网络技术论文

对于神经网络技术的探究多年以来,科学家们不断从医学、生物学、生理学、哲学、信息学、计算机科学、认知学、组织协同学等各个角度探索人脑工作的秘密,希望能制作模拟人脑的人工神经元。

在研究过程中,近年来逐渐形成了一个新兴的多学科交叉技术领域,称之为”人工神经网络”。

神经网络的研究涉及众多学科领域,这些领域互相结合、相互渗透并相互推动。

人工神经网络是由大量的简单基本元件-神经元相互联接而成的自适应非线性动态系统。

每个神经元的结构和功能比较简单,但大量神经元组合产生的系统行为却非常复杂。

人工神经网络的基本结构模仿人脑,反映了人脑功能的若干基本特性,能够自身适应环境、总结规律、完成某种运算、识别或过程控制。

人工神经网络具有并行处理特征,可以大大提高工作速度。

人工神经网络的特点和优越性,主要表现在三个方面:第一,具有自学习功能。

第二,具有联想存储功能。

第三,具有高速寻找优化解的能力。

1 神经网络的学习方法神经网络的学习也称为训练,指的是神经网络在外界环境的刺激作用下调整网络自由参数,并以新的方式来响应外部环境的过程。

能够从环境中学习并在学习中提高自身性能是神经网络最有意义的性质。

理想情况下,神经网络在每一次重复学习后,对它的环境有了更多的了解。

(1)监督学习(有教师学习)在学习时需要由教师提供期望输出,通常神经网络对于周围的环境未知而教师具有周围环境的知识,输入学习样本,教师可以根据自身的知识为训练样本提供最佳逼近结果,神经网络的自由参数在误差信号的影响下进行调整,其最终目的是让神经网络模拟教师。

(2)非监督学习(无教师学习)它也称为自组织学习,系统在学习过程中,没有外部教师信号,而是提供给一个关于网络学习性质的度量,它独立于学习任务,以此尺度来逐步优化网络,一旦网络与输入数据的统计规律达成一致,那么它将发展形成用于输入数据编码特征的内部表示能力,从而自动创造新的类别。

(3)强化学习(激励学习)在强化学习系统中,对输入输出映射的学习是通过与外部环境的不断交互作用来完成学习,目的是网络标量函数值最小,即外部环境对系统输出结果只给出评价信息(奖或罚)而不是给出正确答案,学习通过强化那些受奖的动作来改善自身性能。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于神经网络的离婚率方面的预测摘要:在各种全球化力量的推动下,世界经济、政治发生了惊人的变化,由之产生的社会问题日益影响着我们的生活。

其中家庭关系日益紧张引人注目。

本文通过对我国离婚状况的分析, 可以看出我国的离婚率自近几年以来呈现逐年上升的趋势, 主要是多元因素综合作用的结果。

本文力图从社会经济,教育水平和就业率三个方面,使用神经网络的方法预测将来离婚率的发展趋势,来要求人们客观看待离婚, 重视婚姻质量, 提高婚姻素质, 共筑和谐家庭。

1.引言中国正处于社会大变革、经济大发展时期,在全球化的背景下,以婚姻为纽带联接起来的家庭关系承受越来越多的冲击,许多家庭已离婚告终。

由图一可以看出离婚率日益上升,由此也引发了各种问题,且这些问题不容我们逃避和忽视,所以有必要针对这一问题进行研究。

根据离婚率逐渐上升这一问题,本文从人均生产总值,国家教育水平和国家就业水平三个方面与离婚率的关系,利用神经网络预测的方法进行深入探究,从而预测我国未来的离婚率。

(图一)离婚率折线图2.数据来源(1)影响家庭离婚的主要因素一、社会经济因素的影响,如人均GDP等,经济基础决定上层建筑,同样家庭的经济因素也决定了一个家庭的稳定。

二、国家教育水平的影响,如普通高等学校毕业生人数等,一个家庭的教育水平的高低对于处理矛盾的理性会有不同,从而影响着家庭的稳定。

三、国家就业水平的影响。

国家就业水平的高低直接影响着人们将来的经济状况,从而影响着将来家庭的稳定。

(2)输出量与输入量输出量:预测离婚人数(万人);输入量:实际离婚人数(万人)、人均GDP、普通高等学校毕业生人数(万人)、就业人员(万人)。

2001年到2011年我国离婚人数、人均GDP、普通高等毕业生人数以及就业人员数据来源于《中国统计年鉴》。

2001年到2011年我国离婚人数、人均GDP、普通高等毕业生人数以及就业人员情况的统计如表一所示。

表一年份离婚人数/万人人均GDP 普通高校毕业人数/万人就业人员/万人2001 125.05 8621.71 103.63 727972002 117.7 9398.05 133.73 732802003 133 10541.97 187.7 737362004 166.5 12335.58 239.1152 742642005 178.5 14185.36 306.7956 746472006 191.3 16499.7 377.5 749782007 209.8 20169.46 447.7907 753212008 226.9 23707.71 511.9498 755642009 246.8 25607.53 531.1023 758282010 267.8 30015.05 575.4245 761052011 287.4 35197.79 608.1565 76720因为样本数较少,所以训练样本数应大于测试样本数,根据11年数据变化的特点进行抽样。

选取了2001、2002、2004、2005、2007、2009年的数据作为一组进行训练,其余数据作为一组进行测试。

(3)参数设置一、系统结构M⨯P⨯N参数设置根据上述的数据划分,该神经网络输入层元素取3,分别为人均GDP、普通高等学校毕业生人数(万人)、就业人员(万人);输出层元素取1,为预测离婚人数(万人),采用单隐含层神经网络设计,然后分别对隐含层神经元数目采用试差法进行对比确定,来找到最合适的隐含层神经元数目。

二、系统参数设置对学习速率、平滑因子、学习误差、分级迭代级数等系统参数进行设置,从而求得不同系统参数设置下的预测结果,对不同预测结果进行对比以找到最合适的那一组系统参数设置。

3.离婚率预测如表二所示,1.1,1.2,1.3,1.4表示学习误差E的改变对预测结果的影响;2.1,2.2,2.3表示训练样本顺序的改变对预测结果的影响;3.1表示学习样本数量的增加对预测结果的影响;4.1,4.2,4.3,4.4,4.5,4.6表示隐含层神经元数目P的改变对预测结果的影响;5.1,5.2,5.3表示学习速率h和学习误差E同时改变对预测结果的影响。

为方便接下来对结果进行分析对比,分别算出了每一种方法预测结果所对应的相对误差、训练值平均相对误差、测试值平均相对误差、测试值最小相对误差和测试值最大相对误差。

在具体应用中,各输入量不能直接输入到网络中,需先将各输入量进行归一化,将它们归化为0~1之间的值。

表二(1.1)网络结3⨯15⨯1,h=1.5、a=0.7、E=0.03、s=14 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差2001 125.05 124.2186 0.831357 0.006652002 117.7 133.0971 -15.39708 0.130822004 166.5 160.5293 5.970711 0.035862005 178.5 175.8828 2.61715 0.014662007 209.8 208.6829 1.117133 0.005322009 246.8 228.4093 18.39066 0.074522010 267.8 238.8817 28.91834 0.107982011 287.4 249.3842 38.01576 0.132272003 133 145.3262 -12.32617 0.092682006 191.3 191.4814 -0.181436 0.000952008 226.9 221.9832 4.916783 0.02167训练值平均相对误差0.04464 测试值平均相对误差0.07111测试值最小相对误差0.00095 测试值最大相对误差0.13227(1.2)网络结3⨯15⨯1,h=1.2、a=0.7、E=0.01、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差2001 125.05 119.6854 5.364566 0.042902002 117.7 123.0682 -5.368173 0.045612004 166.5 161.3349 5.165131 0.031022005 178.5 179.642 -1.142009 0.006402007 209.8 214.7577 -4.957715 0.023632009 246.8 241.7786 5.02138 0.020352010 267.8 262.1139 5.686145 0.021232011 287.4 277.5782 9.82175 0.034172003 133 139.3523 -6.352308 0.047762006 191.3 193.0003 -1.700264 0.008892008 226.9 230.5062 -3.606157 0.01589训练值平均相对误差0.02832 测试值平均相对误差0.02559测试值最小相对误差0.00889 测试值最大相对误差0.04776(1.3)网络结3⨯15⨯1,h=1.2、a=0.7、E=0.001、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差2001 125.05 124.513 0.537006 0.004292002 117.7 118.2376 -0.537645 0.004572004 166.5 165.9866 0.513357 0.003082005 178.5 179.0271 -0.527141 0.002952007 209.8 209.3491 0.450909 0.002152009 246.8 247.3335 -0.533516 0.002162010 267.8 274.9467 -7.146734 0.026692011 287.4 286.24 1.160023 0.004042003 133 135.4601 -2.460134 0.018502006 191.3 185.1443 6.155674 0.032182008 226.9 230.5303 -3.63029 0.01600训练值平均相对误差0.00320 测试值平均相对误差0.01948测试值最小相对误差0.00404 测试值最大相对误差0.03218(1.4)网络结3⨯15⨯1,h=1.2、a=0.7、E=0.0001、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差2001 125.05 124.5162 0.533804 0.004272002 117.7 118.2305 -0.530491 0.004512004 166.5 165.963 0.537028 0.003232005 178.5 179.0325 -0.532552 0.002982007 209.8 209.2992 0.500767 0.002392009 246.8 247.3107 -0.510667 0.002072010 267.8 282.7186 -14.9186 0.055712011 287.4 289.3612 -1.961172 0.006822003 133 136.9196 -3.919635 0.029472006 191.3 187.7746 3.525425 0.018432008 226.9 233.8195 -6.919536 0.03050训练值平均相对误差0.00324 测试值平均相对误差0.02819测试值最小相对误差0.00682 测试值最大相对误差0.05571(2.1)网络结3⨯15⨯1,h=1.2、a=0.7、E=0.01、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差2001 125.05 119.8214 5.228563 0.041812004 166.5 161.1375 5.362451 0.032212007 209.8 215.1668 -5.366836 0.025582002 117.7 123.0397 -5.339735 0.045372005 178.5 179.2905 -0.790536 0.004432009 246.8 242.1548 4.64522 0.018822010 267.8 269.834 -2.033945 0.007602011 287.4 283.7746 3.625405 0.012612003 133 138.5918 -5.591849 0.042042006 191.3 194.1856 -2.885619 0.015082008 226.9 233.8609 -6.960898 0.03068训练值平均相对误差0.02804 测试值平均相对误差0.02160测试值最小相对误差0.00760 测试值最大相对误差0.04204(2.2)网络结3⨯15⨯1,h=1.2、a=0.7、E=0.001、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差2001 125.05 124.6278 0.422228 0.003382004 166.5 165.9771 0.522878 0.003142007 209.8 209.2646 0.535445 0.002552002 117.7 118.2255 -0.525494 0.004462005 178.5 179.0374 -0.537365 0.003012009 246.8 246.514 0.285961 0.001162010 267.8 276.764 -8.963987 0.033472011 287.4 286.0209 1.379106 0.004802003 133 141.3788 -8.378844 0.063002006 191.3 188.2255 3.074533 0.016072008 226.9 236.776 -9.87596 0.04353训练值平均相对误差0.00295 测试值平均相对误差0.03217测试值最小相对误差0.00480 测试值最大相对误差0.06300(2.3)网络结3⨯15⨯1,h=0.5、a=0.7、E=0.001、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差(%)2001 125.05 124.2186 0.831357 0.006652002 117.7 133.0971 -15.39708 0.130822004 166.5 160.5293 5.970711 0.035862005 178.5 175.8828 2.61715 0.014662007 209.8 208.6829 1.117133 0.005322009 246.8 228.4093 18.39066 0.074522010 267.8 238.8817 28.91834 0.107982011 287.4 249.3842 38.01576 0.132272003 133 145.3262 -12.32617 0.092682006 191.3 191.4814 -0.181436 0.000952008 226.9 221.9832 4.916783 0.02167训练值平均相对误差0.00309 测试值平均相对误差0.02933测试值最小相对误差0.00252 测试值最大相对误差0.04837(3.1)网络结3⨯15⨯1,h=1.2、a=0.7、E=0.01、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差2001 125.05 117.6146 7.435375 0.059462004 166.5 159.0061 7.493851 0.045012007 209.8 216.8716 -7.07158 0.033712002 117.7 125.1359 -7.435942 0.063182005 178.5 176.8495 1.650476 0.009252009 246.8 242.2345 4.565491 0.018502010 267.8 262.1255 5.674502 0.021192003 133 139.9743 -6.974285 0.052442006 191.3 193.8041 -2.504109 0.013092008 226.9 233.9926 -7.092588 0.031262011 287.4 279.5982 7.801836 0.02715训练值平均相对误差0.03818 测试值平均相对误差0.02902测试值最小相对误差0.01309 测试值最大相对误差0.05244(4.1)网络结3⨯30⨯1,h=1.2、a=0.7、E=0.001、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差(%)2001 125.05 124.5139 0.536146 0.004292002 117.7 118.2311 -0.531131 0.004512004 166.5 165.9626 0.5374 0.003232005 178.5 179.0092 -0.509233 0.002852007 209.8 209.9215 -0.121545 0.000582009 246.8 246.336 0.464035 0.001882010 267.8 273.8834 -6.083415 0.022722011 287.4 285.9097 1.490331 0.005192003 133 133.2789 -0.278889 0.002102006 191.3 186.2906 5.009425 0.026192008 226.9 229.8614 -2.961426 0.01305训练值平均相对误差0.00289 测试值平均相对误差0.01385测试值最小相对误差0.00210 测试值最大相对误差0.02619(4.2)网络结3⨯20⨯1,h=1.2、a=0.7、E=0.001、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差2001 125.05 124.545 0.504956 0.004042002 117.7 118.2376 -0.537615 0.004572004 166.5 165.9624 0.537553 0.003232005 178.5 179.0371 -0.53714 0.003012007 209.8 209.2922 0.507785 0.002422009 246.8 247.3057 -0.505747 0.002052010 267.8 274.3694 -6.569418 0.024532011 287.4 285.8474 1.552558 0.005402003 133 133.5036 -0.503588 0.003792006 191.3 185.3849 5.915139 0.030922008 226.9 228.733 -1.832979 0.00808训练值平均相对误差0.00322 测试值平均相对误差0.01454测试值最小相对误差0.00379 测试值最大相对误差0.03092(4.3)网络结3⨯25⨯1,h=1.2、a=0.7、E=0.001、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差2001 125.05 124.5174 0.532614 0.004262002 117.7 118.2352 -0.535189 0.004552004 166.5 165.9675 0.532523 0.003202005 178.5 179.0271 -0.527047 0.002952007 209.8 209.8193 -0.019326 0.000092009 246.8 246.346 0.45397 0.001842010 267.8 276.0602 -8.260179 0.030842011 287.4 287.4978 -0.097819 0.000342003 133 134.0248 -1.024822 0.007712006 191.3 186.6484 4.651568 0.024322008 226.9 230.6001 -3.700123 0.01631训练值平均相对误差0.00281 测试值平均相对误差0.01590测试值最小相对误差0.00034 测试值最大相对误差0.03084(4.4)网络结3⨯35⨯1,h=1.2、a=0.7、E=0.001、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差2001 125.05 124.5137 0.536315 0.004292002 117.7 118.2357 -0.535716 0.004552004 166.5 165.9624 0.537593 0.003232005 178.5 178.994 -0.49401 0.002772007 209.8 210.2987 -0.498707 0.002382009 246.8 246.6416 0.15835 0.000642010 267.8 273.5656 -5.765609 0.021532011 287.4 286.0635 1.336491 0.004652003 133 132.2156 0.784421 0.005902006 191.3 186.3657 4.93426 0.025792008 226.9 228.2593 -1.359326 0.00599训练值平均相对误差0.00298 测试值平均相对误差0.01277测试值最小相对误差0.00465 测试值最大相对误差0.02579(4.5)网络结3⨯40⨯1,h=1.2、a=0.7、E=0.001、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差2001 125.05 124.517 0.532992 0.004262002 117.7 118.2362 -0.536187 0.004562004 166.5 165.9879 0.51209 0.003082005 178.5 179.0195 -0.519493 0.002912007 209.8 210.3208 -0.520851 0.002482009 246.8 247.3154 -0.5154 0.002092010 267.8 272.5688 -4.76877 0.017812011 287.4 285.4366 1.963374 0.006832003 133 130.5756 2.42437 0.018232006 191.3 185.8538 5.446176 0.028472008 226.9 227.0737 -0.17374 0.00077训练值平均相对误差0.00323 测试值平均相对误差0.01442测试值最小相对误差0.00077 测试值最大相对误差0.02847(4.6)网络结3⨯45⨯1,h=1.2、a=0.7、E=0.001、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差2001 125.05 124.513 0.537047 0.004292002 117.7 118.2368 -0.536832 0.004562004 166.5 165.9824 0.517575 0.003112005 178.5 179.0079 -0.507903 0.002852007 209.8 210.1992 -0.399253 0.001902009 246.8 247.2998 -0.499809 0.002032010 267.8 272.3746 -4.574586 0.017082011 287.4 285.4823 1.917668 0.006672003 133 129.6274 3.372558 0.025362006 191.3 185.6321 5.6679 0.029632008 226.9 226.0807 0.819295 0.00361训练值平均相对误差0.00312 测试值平均相对误差0.01647测试值最小相对误差0.00361 测试值最大相对误差0.02963(5.1)网络结3⨯40⨯1,h=0.5、a=0.7、E=0.001、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差(%)2001 125.05 124.5132 0.536776 0.004292002 117.7 118.2375 -0.537488 0.004572004 166.5 165.9641 0.535863 0.003222005 178.5 179.0003 -0.500278 0.002802007 209.8 209.2841 0.515942 0.002462009 246.8 247.3039 -0.503945 0.002042010 267.8 274.3203 -6.520326 0.024352011 287.4 286.0307 1.369283 0.004762003 133 135.0314 -2.031447 0.015272006 191.3 183.5317 7.768282 0.040612008 226.9 229.3161 -2.416087 0.01065训练值平均相对误差0.00323 测试值平均相对误差(%)0.01913(%)测试值最小相对误差0.00476 测试值最大相对误差(%)0.04061(%)(5.2)网络结3⨯40⨯1,h=1.2、a=0.7、E=0.0001、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差(%)2001 125.05 125.0003 0.049676 0.000402002 117.7 117.7533 -0.053307 0.000452004 166.5 166.4464 0.053593 0.000322005 178.5 178.5529 -0.052936 0.000302007 209.8 209.7466 0.053405 0.000252009 246.8 246.8522 -0.052239 0.000212010 267.8 276.3095 -8.509476 0.031782011 287.4 287.7038 -0.303764 0.001062003 133 132.1967 0.803339 0.006042006 191.3 186.6439 4.656112 0.024342008 226.9 229.7273 -2.827286 0.01246训练值平均相对误差0.00032 测试值平均相对误差(%)0.01513(%)测试值最小相对误差0.00106 测试值最大相对误差(%)0.03178(%)(5.3)网络结3⨯40⨯1,h=1.2、a=0.7、E=0.00001、s=15 构年份实际离婚人数(万人)预测值(万人)误差(万人)相对误差(%)2001 125.05 125.0452 0.004814 0.000042002 117.7 117.7053 -0.005313 0.000052004 166.5 166.4946 0.005373 0.000032005 178.5 178.5054 -0.005376 0.000032007 209.8 209.7948 0.005242 0.000022009 246.8 246.8052 -0.005215 0.000022010 267.8 282.8378 -15.0378 0.056152011 287.4 289.662 -2.261953 0.007872003 133 129.4153 3.584687 0.026952006 191.3 187.5255 3.77454 0.019732008 226.9 229.8497 -2.949667 0.01300训练值平均相对误差(%)0.00003 测试值平均相对误差(%)0.02474测试值最小相对误差(%)0.00787 测试值最大相对误差(%)0.056154.预测结果分析为方便对结果进行分析对比,上面分别算出了每一种方法预测结果所对应的相对误差、训练值平均相对误差、测试值平均相对误差、测试值最小相对误差和测试值最大相对误差。