hanlp中文分词器解读

自然语言分析工具Hanlp依存文法分析python使用总结(附带依存关系英文简写的中文解释)

⾃然语⾔分析⼯具Hanlp依存⽂法分析python使⽤总结(附带依存关系英⽂简写的中⽂解释)最近在做⼀个应⽤依存⽂法分析来提取⽂本中各种关系的词语的任务。

例如:text=‘新中国在马克思的思想和恩格斯的理论阔步向前’:我需要提取这个text中的并列的两个关系,从⽂中分析可知,“马克思的思想”和“恩格斯的理论”是两个并列关系的短语,所以想要将其提取出来;⾸先⼤致了解⼀下依存⽂法分析的前提条件,将句⼦分词并进⾏词性标注,这⼀步⾮常关键,直接决定分析结果的好坏。

看⼀下不修改分词字典情况下直接进⾏并列关系提取的结果:text= "新中国在马克思的思想和恩格斯的理论指导下阔步向前"java = JClass('com.hankcs.hanlp.dependency.nnparser.NeuralNetworkDependencyParser') # 调⽤原始类接⼝进⾏句法分析dp_result = pute(seg_result1)print('java提取结果:'+'\n',dp_result)word_array = dp_result.getWordArray()final= []for word in word_array:result = [word.LEMMA, word.DEPREL, word.HEAD.LEMMA]print("%s --(%s)--> %s" % (word.LEMMA, word.DEPREL, word.HEAD.LEMMA)) # 输出依存关系if result[1]=='COO': # 提取并列关系COOfinal.append(word.LEMMA)final.append(word.HEAD.LEMMA)final_set = set(final)print(final_set)结果:{'思想','理论'}虽然提取出来的结果也算合理,但是还是不够准确,我希望的结果是{'马克思的思想','恩格斯的理论'}接下来我将需要⽬标词动态添加到分词字典中,然后再来进⾏依存⽂法分析text= "新中国在马克思的思想和恩格斯的理论指导下阔步向前"segment =HanLP.newSegment('viterbi')CustomDictionary.insert('马克思的思想', 'n 1024') # insert会覆盖字典中已经存在的词,add会跳过已经存在的词CustomDictionary.insert('恩格斯的理论', 'n 1024')segment.enableCustomDictionaryForcing(True) # 强制执⾏seg_result1 = segment.seg(text) # 分词结果print('分词结果:',seg_result1)java = JClass('com.hankcs.hanlp.dependency.nnparser.NeuralNetworkDependencyParser') # 调⽤原始类接⼝进⾏句法分析dp_result = pute(seg_result1)print('java提取结果:'+'\n',dp_result)word_array = dp_result.getWordArray()final= []for word in word_array:result = [word.LEMMA, word.DEPREL, word.HEAD.LEMMA]print("%s --(%s)--> %s" % (word.LEMMA, word.DEPREL, word.HEAD.LEMMA)) # 输出依存关系if result[1]=='COO':final.append(word.LEMMA)final.append(word.HEAD.LEMMA)final_set = set(final)print(final_set)结果:{'马克思的思想','恩格斯的理论'}以上实现了正确的并列关系提取。

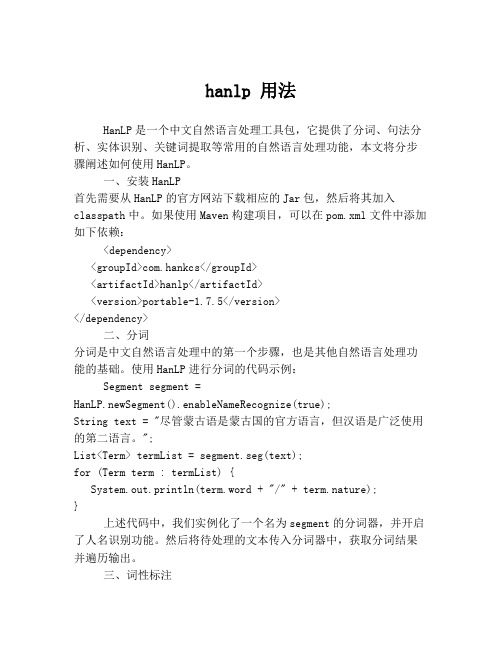

hanlp 用法

hanlp 用法HanLP是一个中文自然语言处理工具包,它提供了分词、句法分析、实体识别、关键词提取等常用的自然语言处理功能,本文将分步骤阐述如何使用HanLP。

一、安装HanLP首先需要从HanLP的官方网站下载相应的Jar包,然后将其加入classpath中。

如果使用Maven构建项目,可以在pom.xml文件中添加如下依赖:<dependency><groupId>com.hankcs</groupId><artifactId>hanlp</artifactId><version>portable-1.7.5</version></dependency>二、分词分词是中文自然语言处理中的第一个步骤,也是其他自然语言处理功能的基础。

使用HanLP进行分词的代码示例:Segment segment =HanLP.newSegment().enableNameRecognize(true);String text = "尽管蒙古语是蒙古国的官方语言,但汉语是广泛使用的第二语言。

";List<Term> termList = segment.seg(text);for (Term term : termList) {System.out.println(term.word + "/" + term.nature);}上述代码中,我们实例化了一个名为segment的分词器,并开启了人名识别功能。

然后将待处理的文本传入分词器中,获取分词结果并遍历输出。

三、词性标注词性标注是将分词结果中的每个词元标注上其词性的过程,词性标注结果对于后续的句法分析和实体识别等任务都具有重要意义。

使用HanLP进行词性标注的代码示例:String[] testCase = new String[]{"商品和服务","结婚的和尚未结婚的确实在干扰分词啊","买水果然后来世博园最后去世博会","中国的首都是北京","欢迎新老师生前来就餐",};for (String sentence : testCase) {List<Term> termList = HanLP.segment(sentence);System.out.println(termList);List<String> posList = HanLP.extractPhrase(sentence);System.out.println(posList);}上述代码中,我们给出了一组待处理的测试用例,然后分别获取了分词结果和词性标注结果,并输出到控制台。

java hanlp 用法

java hanlp 用法HanLP是一款中文自然语言处理工具包,提供了一系列常用的中文自然语言处理功能,包括分词、词性标注、命名实体识别等。

下面是一个简单的示例,展示如何使用HanLP进行中文分词:1. 首先,你需要将HanLP的jar包添加到你的Java项目中。

你可以在HanLP的官方网站上下载最新的jar包,或者使用Maven等依赖管理工具进行添加。

2. 接下来,你可以使用以下代码进行中文分词:```javaimport ;import ;import ;import ;public class HanLPSegDemo {public static void main(String[] args) {// 初始化分词器Segment segment = ();// 对句子进行分词String sentence = "我爱自然语言处理";List<Term> termList = (sentence);// 输出分词结果for (Term term : termList) {( + "/" + );}}}```在上面的代码中,我们首先创建了一个`Segment`对象,该对象是HanLP 中用于中文分词的核心类。

然后,我们调用`seg()`方法对输入的句子进行分词,得到一个`Term`对象的列表。

每个`Term`对象表示一个分词结果,包括分词的词和词性等信息。

最后,我们遍历`Term`对象的列表,输出每个分词的结果。

3. 运行上面的代码,你将会看到以下的输出:```bash我/r爱/v自然/a语言/n处理/v```这表示对输入的句子“我爱自然语言处理”进行了分词,并输出了每个分词的词和词性等信息。

hanlp的作用-解释说明

hanlp的作用-概述说明以及解释1.引言1.1 概述HanLP(即“Han Language Processing”)是一个开源的自然语言处理(NLP)工具包,最初由人民日报社自然语言处理实验室开发,并已经在众多大型项目和企业中被广泛应用。

自然语言处理是人工智能领域中一个重要的研究方向,涉及到对人类语言的理解和处理。

HanLP作为一款功能强大的NLP工具包,集成了一系列中文文本的处理和分析功能,能够帮助开发者快速、准确地处理中文文本数据。

HanLP具备多项核心功能,包括分词、词性标注、命名实体识别、依存句法分析、关键词提取等。

这些功能能够协助用户完成诸如文本分析、信息提取、机器翻译、情感分析、智能问答等各种任务。

HanLP具有以下几个显著特点:1. 智能高效:HanLP采用了深度学习和统计机器学习等先进的技术,能够实现高效、准确的文本处理。

它精心训练的模型和优化算法确保了在不同场景下的稳定性和效果。

2. 针对中文:HanLP是专门为中文设计的工具包,充分考虑了中文的特殊性。

它支持繁简体转换、拼音转换等特殊处理,并基于大规模中文语料库进行训练,以获得更好的中文处理效果。

3. 可定制性:HanLP提供了丰富的功能和参数设置,允许用户根据自己的需求进行个性化定制。

用户可以选择不同的模型、配置和插件,以满足特定场景下的需求。

4. 强大的生态系统:HanLP的社区活跃,拥有众多用户和开发者参与其中。

在HanLP的基础上,还衍生出了丰富的周边工具和应用,形成了一个庞大的生态系统。

总之,HanLP作为一款功能全面、性能出色的中文NLP工具包,为中文文本处理和分析提供了便捷、高效的解决方案。

无论是学术研究还是商业应用,HanLP都是一个不可或缺的利器。

它的出现大大降低了中文自然语言处理的门槛,为中文信息处理领域的发展做出了重要贡献。

1.2 文章结构文章结构部分的内容如下:2. 正文在这一部分,我们将详细介绍HanLP的作用和功能。

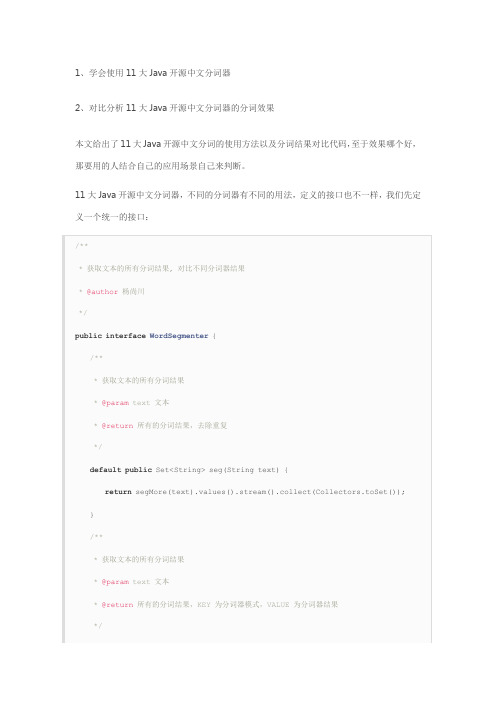

11个Java开源中文分词器使用方法和分词效果对比

1、学会使用11大Java开源中文分词器

2、对比分析11大Java开源中文分词器的分词效果

本文给出了11大Java开源中文分词的使用方法以及分词结果对比代码,至于效果哪个好,那要用的人结合自己的应用场景自己来判断。

11大Java开源中文分词器,不同的分词器有不同的用法,定义的接口也不一样,我们先定义一个统一的接口:

从上面的定义我们知道,在Java中,同样的方法名称和参数,但是返回值不同,这种情况不可以使用重载。

这两个方法的区别在于返回值,每一个分词器都可能有多种分词模式,每种模式的分词结果都可能不相同,第一个方法忽略分词器模式,返回所有模式的所有不重复分词结果,第二个方法返回每一种分词器模式及其对应的分词结果。

在这里,需要注意的是我们使用了Java8中的新特性默认方法,并使用stream把一个map 的value转换为不重复的集合。

下面我们利用这11大分词器来实现这个接口:

1、word分词器

2、Ansj分词器

3、Stanford分词器

4、FudanNLP分词器

5、Jieba分词器

6、Jcseg分词器

7、MMSeg4j分词器

8、IKAnalyzer分词器

9、Paoding分词器

10、smartcn分词器

11、HanLP分词器

现在我们已经实现了本文的第一个目的:学会使用11大Java开源中文分词器。

最后我们来实现本文的第二个目的:对比分析11大Java开源中文分词器的分词效果,程序如下:。

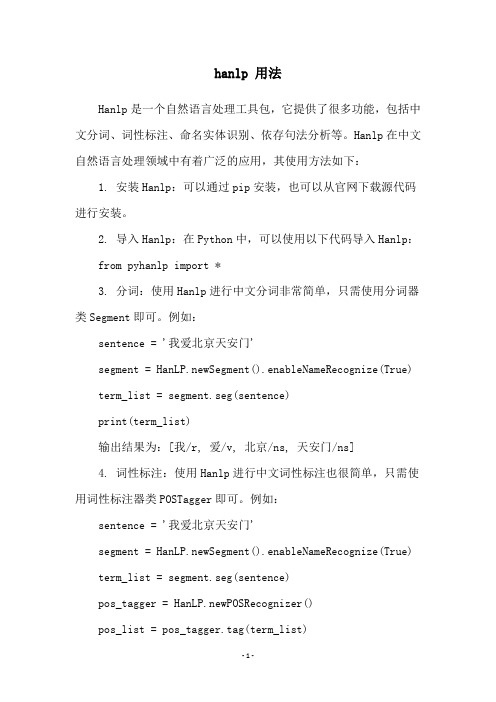

hanlp 用法

hanlp 用法Hanlp是一个自然语言处理工具包,它提供了很多功能,包括中文分词、词性标注、命名实体识别、依存句法分析等。

Hanlp在中文自然语言处理领域中有着广泛的应用,其使用方法如下:1. 安装Hanlp:可以通过pip安装,也可以从官网下载源代码进行安装。

2. 导入Hanlp:在Python中,可以使用以下代码导入Hanlp: from pyhanlp import *3. 分词:使用Hanlp进行中文分词非常简单,只需使用分词器类Segment即可。

例如:sentence = '我爱北京天安门'segment = HanLP.newSegment().enableNameRecognize(True) term_list = segment.seg(sentence)print(term_list)输出结果为:[我/r, 爱/v, 北京/ns, 天安门/ns]4. 词性标注:使用Hanlp进行中文词性标注也很简单,只需使用词性标注器类POSTagger即可。

例如:sentence = '我爱北京天安门'segment = HanLP.newSegment().enableNameRecognize(True) term_list = segment.seg(sentence)pos_tagger = HanLP.newPOSRecognizer()pos_list = pos_tagger.tag(term_list)print(pos_list)输出结果为:[r, v, ns, ns]5. 命名实体识别:使用Hanlp进行中文命名实体识别同样很简单,只需使用命名实体识别器类NERecognizer即可。

例如:sentence = '欧阳建国是南京市长'segment = HanLP.newSegment().enableNameRecognize(True) term_list = segment.seg(sentence)ner_recognizer =HanLP.newSegment().enableNameRecognize(True)ner_list = ner_recognizer.recognize(term_list)print(ner_list)输出结果为:[欧阳建国/nr, 南京/ns]6. 依存句法分析:使用Hanlp进行中文依存句法分析也很简单,只需使用依存句法分析器类DependencyParser即可。

hanlp分词流程

hanlp分词流程

HanLP是一款开源的自然语言处理工具包,可以实现中文分词、词性标注、命名实体识别等功能。

下面将详细介绍HanLP的分词流程。

一、HanLP分词流程概览

HanLP的分词流程可以分为以下几个步骤:文本预处理、分词、词性标注、命名实体识别等。

二、文本预处理

在进行分词之前,需要对待处理的文本进行预处理。

预处理的目的是将文本转化为HanLP可以处理的格式,包括去除空格、标点符号等。

三、分词

分词是HanLP的核心功能之一。

HanLP采用了基于条件随机场(CRF)模型的分词方法,该方法能够在不依赖词典的情况下进行分词,具有较好的鲁棒性和泛化能力。

四、词性标注

词性标注是为分词结果中的每个词语标注其词性。

HanLP提供了预训练好的词性标注模型,可以自动为分词结果进行词性标注。

五、命名实体识别

命名实体识别是指识别文本中的人名、地名、组织机构名等实体。

HanLP采用了基于条件随机场(CRF)模型的命名实体识别方法,

能够较准确地识别出文本中的命名实体。

六、其他功能

除了上述功能外,HanLP还提供了其他一些功能,如关键词提取、摘要生成、文本分类等。

这些功能可以根据具体需求进行选择和使用。

HanLP的分词流程包括文本预处理、分词、词性标注、命名实体识别等步骤。

通过这些步骤,可以对中文文本进行有效的处理和分析,为后续的自然语言处理任务提供基础支持。

HanLP的功能强大且易于使用,是中文文本处理的重要工具之一。

hanlp中文自然语言处理的几种分词方法

hanlp中⽂⾃然语⾔处理的⼏种分词⽅法⾃然语⾔处理在⼤数据以及近年来⼤⽕的⼈⼯智能⽅⾯都有着⾮同寻常的意义。

那么,什么是⾃然语⾔处理呢?在没有接触到⼤数据这⽅⾯的时候,也只是以前在学习计算机⽅⾯知识时听说过⾃然语⾔处理。

书本上对于⾃然语⾔处理的定义或者是描述太多专业化。

换⼀个通俗的说法,⾃然语⾔处理就是把我们⼈类的语⾔通过⼀些⽅式或者技术翻译成机器可以读懂的语⾔。

⼈类的语⾔太多,计算机技术起源于外国,所以⼀直以来⾃然语⾔处理基本都是围绕英语的。

中⽂⾃然语⾔处理当然就是将我们的中⽂翻译成机器可以识别读懂的指令。

中⽂的博⼤精深相信每⼀个⼈都是⾮常清楚,也正是这种博⼤精深的特性,在将中⽂翻译成机器指令时难度还是相当⼤的!⾄少在很长⼀段时间⾥中⽂⾃然语⾔的处理都⾯临这样的问题。

Hanlp中⽂⾃然语⾔处理相信很多从事程序开发的朋友都应该知道或者是⽐较熟悉的。

Hanlp中⽂⾃然语⾔处理是⼤快搜索在主持开发的,是⼤快DKhadoop⼤数据⼀体化开发框架中的重要组成部分。

下⾯就hanlp中⽂⾃然语⾔处理分词⽅法做简单介绍。

Hanlp中⽂⾃然语⾔处理中的分词⽅法有标准分词、NLP分词、索引分词、N-最短路径分词、CRF分词以及极速词典分词等。

下⾯就这⼏种分词⽅法进⾏说明。

标准分词:Hanlp中有⼀系列“开箱即⽤”的静态分词器,以Tokenizer结尾。

HanLP.segment其实是对StandardTokenizer.segment的包装NLP分词:1. List<Term> termList = NLPTokenizer.segment("中国科学院计算技术研究所的宗成庆教授正在教授⾃然语⾔处理课程");2. System.out.println(termList);NLP分词NLPTokenizer会执⾏全部命名实体识别和词性标注。

索引分词:索引分词IndexTokenizer是⾯向搜索引擎的分词器,能够对长词全切分,另外通过term.offset可以获取单词在⽂本中的偏移量。

分词工具Hanlp基于感知机的中文分词框架

分词⼯具Hanlp基于感知机的中⽂分词框架结构化感知机标注框架是⼀套利⽤感知机做序列标注任务,并且应⽤到中⽂分词、词性标注与命名实体识别这三个问题的完整在线学习框架,该框架利⽤1个算法解决3个问题,时⾃治同意的系统,同时三个任务顺序渐进,构成流⽔线式的系统。

本⽂先介绍中⽂分词框架部分内容。

中⽂分词训练只需指定输⼊语料的路径(单⽂档时为⽂件路径,多⽂档时为⽂件夹路径,灵活处理),以及模型保存位置即可:命令⾏java -cp hanlp.jar com.hankcs.hanlp.model.perceptron.Main -task CWS -train -reference data/test/pku98/199801.txt -model data/test/perceptron/cws.binAPIpublic void testTrain() throws Exception{PerceptronTrainer trainer = new CWSTrainer();PerceptronTrainer.Result result = trainer.train("data/test/pku98/199801.txt",Config.CWS_MODEL_FILE);// System.out.printf("准确率F1:%.2f\n", result.prf[2]);}事实上,视语料与任务的不同,迭代数、压缩⽐和线程数都可以⾃由调整,以保证最佳结果:/*** 训练** @param trainingFile 训练集* @param developFile 开发集* @param modelFile 模型保存路径* @param compressRatio 压缩⽐* @param maxIteration 最⼤迭代次数* @param threadNum 线程数* @return ⼀个包含模型和精度的结构* @throws IOException*/public Result train(String trainingFile, String developFile,String modelFile, final double compressRatio,final int maxIteration, final int threadNum) throws IOException单线程时使⽤AveragedPerceptron算法,收敛较好;多线程时使⽤StructuredPerceptron,波动较⼤。

hanlp 中文分词

hanlp 中文分词

摘要:

一、引言

1.介绍hanlp

2.中文分词的重要性

二、hanlp 的中文分词功能

1.什么是中文分词

2.hanlp 分词原理

3.hanlp 分词算法优势

三、hanlp 在中文分词领域的应用

1.搜索引擎

2.文本挖掘

3.语音识别

四、中文分词的未来发展

1.人工智能技术的发展

2.中文分词技术的挑战与机遇

正文:

一、引言

随着互联网的普及,大量的中文文本需要进行处理和分析。

然而,中文文本没有明确的词语边界,导致计算机难以直接理解。

为了解决这个问题,中文分词技术应运而生。

HanLP 是一款强大的中文自然语言处理工具,其中包含的

中文分词功能尤为突出。

二、hanlp 的中文分词功能

1.什么是中文分词

中文分词是将连续的中文文本切分成有意义的独立词汇的过程。

这些词汇可以是名词、动词、形容词等,具备一定的语义信息。

中文分词是自然语言处理的基础任务,对于后续的文本分析、检索、翻译等功能至关重要。

2.hanlp 分词原理

HanLP 采用基于词性标注的分词算法,结合隐马尔可夫模型(HMM)和最大熵模型(MaxEnt)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

中文分词器解析hanlp分词器接口设计:提供外部接口:分词器封装为静态工具类,并提供了简单的接口标准分词是最常用的分词器,基于HMM-Viterbi实现,开启了中国人名识别和音译人名识别,调用方法如下:HanLP.segment其实是对StandardTokenizer.segment的包装。

/*** 分词** @param text 文本* @return切分后的单词*/publicstatic List<Term>segment(String text){return StandardTokenizer.segment(text.toCharArray());}/*** 创建一个分词器<br>* 这是一个工厂方法<br>* 与直接new一个分词器相比,使用本方法的好处是,以后HanLP升级了,总能用上最合适的分词器* @return一个分词器*/publicstatic Segment newSegment()}publicclass StandardTokenizer{/*** 预置分词器*/publicstaticfinalSegment SEGMENT = HanLP.newSegment();/*** 分词* @param text 文本* @return分词结果*/publicstatic List<Term>segment(String text){return SEGMENT.seg(text.toCharArray());}/*** 分词* @param text 文本* @return分词结果*/publicstatic List<Term>segment(char[]text){return SEGMENT.seg(text);}/*** 切分为句子形式* @param text 文本* @return句子列表*/publicstatic List<List<Term>>seg2sentence(String text){return SEGMENT.seg2sentence(text);}}publicstatic Segment newSegment(){returnnew ViterbiSegment();// Viterbi分词器是目前效率和效果的最佳平衡}/*** Viterbi分词器<br>* 也是最短路分词,最短路求解采用Viterbi算法** @author hankcs*/publicclass ViterbiSegment extends WordBasedGenerativeModelSegmentNLP分词NLPTokenizer会执行全部命名实体识别和词性标注。

,调用方法如下:∙NLP分词NLPTokenizer会执行全部命名实体识别和词性标注。

∙所以速度比标准分词慢,并且有误识别的情况。

publicclass NLPTokenizer{/*** 预置分词器*/publicstaticfinalSegment SEGMENT =HanLP.newSegment().enableNameRecognize(true).enableTranslatedNameRecognize( true).enableJapaneseNameRecognize(true).enablePlaceRecognize(true).enableOr ganizationRecognize(true).enablePartOfSpeechTagging(true);publicstatic List<Term>segment(String text){return SEGMENT.seg(text);}/*** 分词* @param text 文本* @return分词结果*/publicstatic List<Term>segment(char[]text){return SEGMENT.seg(text);}/*** 切分为句子形式* @param text 文本* @return句子列表*/publicstatic List<List<Term>>seg2sentence(String text){return SEGMENT.seg2sentence(text);}}索引分词IndexTokenizer是面向搜索引擎的分词器,能够对长词全切分,另外通过term.offset可以获取单词在文本中的偏移量。

调用方法如下:List<Term>termList=IndexTokenizer.segment("主副食品");for(Termterm:termList){System.out.println(term+"["+term.offset+":"+(term.offset+term.word.length())+"]");}publicclass IndexTokenizer{/*** 预置分词器*/publicstaticfinalSegment SEGMENT = HanLP.newSegment().enableIndexMode(true); publicstatic List<Term>segment(String text){return SEGMENT.seg(text);}/*** 分词* @param text 文本* @return分词结果*/publicstatic List<Term>segment(char[]text){return SEGMENT.seg(text);}/*** 切分为句子形式* @param text 文本* @return句子列表*/publicstatic List<List<Term>>seg2sentence(String text){return SEGMENT.seg2sentence(text);}}繁体分词TraditionalChineseTokenizer可以直接对繁体进行分词,输出切分后的繁体词语。

调用方法如下:List<Term>termList=TraditionalChineseTokenizer.segment("大衛貝克漢不僅僅是名著名球員,球場以外,其妻為前辣妹合唱團成員維多利亞·碧咸,亦由於他擁有突出外表、百變髮型及正面的形象,以至自己品牌的男士香水等商品,及長期擔任運動品牌Adidas的代言人,因此對大眾傳播媒介和時尚界等方面都具很大的影響力,在足球圈外所獲得的認受程度可謂前所未見。

");System.out.println(termList);* 繁体中文分词器** @author hankcs*/publicclass TraditionalChineseTokenizer{/*** 预置分词器*/publicstaticSegment SEGMENT = HanLP.newSegment();privatestatic List<Term>segSentence(String text){if(text.length()==0)return Collections.emptyList();LinkedList<ResultTerm<String>>tsList=CommonAhoCorasickSegmentUtil.segment(t ext,TraditionalChineseDictionary.trie);StringBuilder sbSimplifiedChinese=new StringBuilder(text.length());boolean equal=true;for(ResultTerm<String>term:tsList){if(bel==null)bel=term.word;elseif(bel.length()!=term.word.length())equal=false; sbSimplifiedChinese.append(bel);}String simplifiedChinese=sbSimplifiedChinese.toString();List<Term>termList=SEGMENT.seg(simplifiedChinese);if(equal){int offset=0;for(Term term:termList){term.word=text.substring(offset,offset+term.length());term.offset=offset;offset+=term.length();}}else{Iterator<Term>termIterator=termList.iterator();Iterator<ResultTerm<String>>tsIterator=tsList.iterator();ResultTerm<String>tsTerm=tsIterator.next();int offset=0;while(termIterator.hasNext())Term term=termIterator.next();term.offset=offset;if(offset>tsTerm.offset+tsTerm.word.length())tsTerm=tsIterator.next();if(offset==tsTerm.offset&&term.length()==bel.length()){term.word=tsTerm.word;}else term.word=SimplifiedChineseDictionary.convertToTraditionalChinese(term. word);offset+=term.length();}}return termList;}publicstatic List<Term>segment(String text){List<Term>termList=new LinkedList<Term>();for(String sentence:SentencesUtil.toSentenceList(text)){termList.addAll(segSentence(sentence));}return termList;}/*** 分词** @param text 文本* @return分词结果*/publicstatic List<Term>segment(char[]text){return segment(CharTable.convert(text));}/*** 切分为句子形式** @param text 文本* @return句子列表*/publicstatic List<List<Term>>seg2sentence(String text){List<List<Term>>resultList=new LinkedList<List<Term>>();{for(String sentence:SentencesUtil.toSentenceList(text)){resultList.add(segment(sentence));}}return resultList;}}极速分词是词典最长分词,速度极其快,精度一般。