11大Java开源中文分词器的分词效果对比

JAVA使用es不分词_谈谈Elasticsearch分词和自定义分词

JAVA使用es不分词_谈谈Elasticsearch分词和自定义分词Elasticsearch是一个基于Lucene的开源引擎,它提供了强大的分布式和分析能力。

在Elasticsearch中,分词(Tokenization)是将文本数据划分成一个个独立的词条(Token),以便于和分析。

默认情况下,Elasticsearch会根据语言的不同使用不同的分词器进行分词。

例如,对于英文文本,Elasticsearch会使用Standard分词器,该分词器会根据空格和标点符号将文本拆分成独立的词条。

而对于中文文本,Elasticsearch会使用IK分词器或者SmartCN分词器,这些分词器会根据中文的特点进行分词,比如根据中文字符之间的逻辑关系进行切分。

然而,有些情况下我们并不想对文本进行分词,比如处理特定的领域术语或者编程代码。

这时,我们可以使用ES的Keyword分词器来实现不分词的效果。

Keyword分词器会将整个文本作为一个独立的词条处理,不做任何拆分。

我们可以在定义字段的Mapping中指定该字段的分词器为"keyword",例如:```json"mappings":"properties":"title":"type": "text","analyzer": "keyword"}}}```将上述Mapping应用到索引中后,对于字段"tittle"的文本将被当作一个整体进行处理,而不会进行任何分词。

这样可以保持原始的文本结构,适用于不希望文本被分割的场景,比如存储领域专有名词或者编程代码。

除了使用ES内置的分词器之外,我们还可以自定义分词器来满足特定的需求。

自定义分词器通过配置字符过滤器(Character Filter)、分词器(Tokenizer)和标记过滤器(Token Filter)来实现自己的分词逻辑。

中文分词组件比较

1、收费 2、无.NET接口

1、提供的字典包括17万个中文常用单词,但这个字 典依然不够完整,如果要分词更准确,需要适当维 护一下这个字典。 2、开源免费(c#)

1、这只是个轻量级的组件,和专业分词系统相比, 功能和准确性都不是很完善 2、免费版具备所有基本功能,但分词算法和分词库 无法定制,而且不提供升级和技术支持服务。另 外,仅供个人免费试用,不要应用于商业环境。

雨痕中文分词组件

CSW中文分词组件

主要用于:数据挖掘、文档分类、自然语言理解以及凡是涉及到 信息/数据检索的各个领域 1、基于.NET平台开发,采用DLL动态链接库,提供编程接口,可 适用于网站或应用软件的数据检索 2、内置10万条汉语词库 3、词组拆分识别率高(在对数十GB的文档资料进行折分时,所 其识别率均大于90%) 4、采用倒序分词技术 5、特殊字符过滤及无意义字及敏感词过滤功能

免费版的功能受到一些限制,某些功能在企业 版或标准版中才有

中文分词组件

技术特点 1、目前被认为是国内最好的中文分词技术,其分词准确度超过99%, 目前国内的一些搜索网站如:中国搜索 是用的它的分词 2、以《现代汉语词典》为基础建立的知识库 3、在北大语料库中的评测结果显示,“海量中文智能分词”的准确率 达99.7% 4、分词效率高 5、分词效率达每分钟2000万字 提供 C/C++、Java 接口 盘古分词和KTDicSeg中文分词作者为同一人,盘古分词是KTDicSeg的 改进版 1、中文未登录词识别(对一些不在字典中的未登录词自动识别) 2、可以根据词频来解决分词的歧义问题 3、中文人名识别 4、繁体中文分词 5、全角字符支持 6、英文分词 7、停用词过滤(提供一个 StopWord.txt 文件,用户只要将需要过滤 的词加入到这个文件中,并将停用词过滤开发打开,就可以过滤掉这 些词) 8、对如下特性设置自定义权值(未登录词权值、最匹配词权值、次匹 配词权值、再次匹配词权值、强行输出的单字的权值、数字的权值、 英文词汇权值、符号的权值、强制同时输出简繁汉字时,非原来文本 的汉字输出权值) 9、提供一个字典管理工具 DictManage 通过这个工具,你可以增加, 修改,和删除字典中的单词 10、关键词高亮 11、为 提供了 接口

Java 程序员必备的10款开源工具

Java世界中存在许多工具,从Eclipse,NetBeans和IntelliJ IDEA等著名的IDE开始到Java开发人员应该知道的JVM分析和监视工具,如JConsole,VisualVM,Eclipse Memory Analyzer 等。

如果你是一位经验丰富的Java开发人员,你可能对这些工具很熟悉,但如果不是,现在就是是开始学习这些工具的好时机。

在本文中,我将重点介绍适用于各种Java开发人员的通用工具,例如核心Java 开发人员和Web开发人员。

1. JIRAAtlassian的JIRA是当前敏捷开发领域最重要的工具之一。

它用于错误跟踪,问题跟踪和项目管理。

如果你遵循敏捷开发方法,例如Sprint和Scrum,那么你必须了解JIRA。

它允许您创建Spring循环并跟踪软件开发的进度。

JIRA 是目前比较流行的基于Java架构的管理系统,由于Atlassian公司对很多开源项目实行免费提供缺陷跟踪服务,因此在开源领域,其认知度比其他的产品要高得多,而且易用性也好一些。

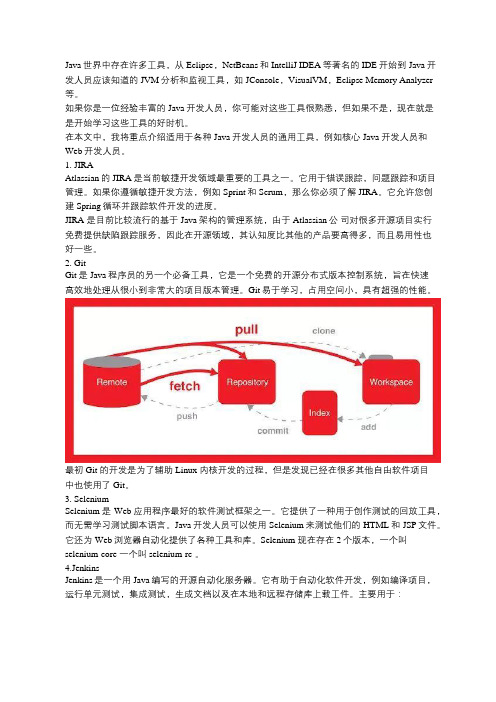

2. GitGit是Java程序员的另一个必备工具,它是一个免费的开源分布式版本控制系统,旨在快速高效地处理从很小到非常大的项目版本管理。

Git易于学习,占用空间小,具有超强的性能。

最初 Git 的开发是为了辅助 Linux 内核开发的过程,但是发现已经在很多其他自由软件项目中也使用了 Git。

3. SeleniumSelenium是Web应用程序最好的软件测试框架之一。

它提供了一种用于创作测试的回放工具,而无需学习测试脚本语言。

Java开发人员可以使用Selenium来测试他们的HTML和JSP文件。

它还为Web浏览器自动化提供了各种工具和库。

Selenium 现在存在2个版本,一个叫selenium-core 一个叫selenium-rc 。

4.JenkinsJenkins是一个用Java编写的开源自动化服务器。

它有助于自动化软件开发,例如编译项目,运行单元测试,集成测试,生成文档以及在本地和远程存储库上载工件。

云计算平台上两种中文分词算法的实现对比研究

人工智能及识别技术本栏目责任编辑:唐一东云计算平台上两种中文分词算法的实现对比研究周寅,龙广富(武汉船舶职业技术学院,湖北武汉430050)摘要:现如今,常用的中文分词算法为IKAnalyzer (简称为:IK )和ICTCLAS (简称为:IC )两种,这两种算法也可以说是如今的主流中文分词算法,为了能够更好的研究两种算法的性能,本文首先利用理论对两种算法在单机环境下的性能进行分析,而后通过Hadoop 分布式文件管理系统(简称为:HDFS )、Hadoop 集群和并行处理大数据集的MapReduce 所共同组成的系统框架,并将算法优化后,通过开展大量的实践性实验对两种不同算法在分布式环境下对大数据集进行处理后的表现进行比较,而后得出具体的分析结果,希望能够为相关人士带来帮助。

关键词:云计算;IKAnalyzer ;ICTCLAS ;Hadoop ;比较中图分类号:TP3文献标识码:A文章编号:1009-3044(2021)09-0191-02开放科学(资源服务)标识码(OSID ):对于中文分词法来说,该方法最初被北京航空航天大学的梁南元教授所提出,属于一种在查字典分析方法基础上的分词方法,近些年来,由于我国经济水平和社会发展的速度越来越快,中文在整个世界舞台中所占据的地位也越来越重要,并且吸引了更多学者加入中文分词法的研究中,现如今已经实现了基于多种词典和概率统计的中文分词算法,而在面对这些大量的中文信息时,必须要确保文本分词结果,在满足本身词义的基础上,尽可能延长词组长度,而现如今的中文分词算法种类非常多,但是可以将其大致分为三种,分别为基于字符串匹配的分词、基于理解的分词以及基于统计的分词,在这种情况下也出现了多种分词算法产品,比如SCWS 、HTTPCWS.IKAnalyz⁃er 2012、FudanNLP 、ICTCLAS 等,而这些分词算法均不能算作为开源,而考虑到虽然IKAnalyzer 2012、ICTCLAS 等算法属于开源,但是这些算法却大多应用在单机环境下,考虑这一前提条件,可以将这两种算法引入到云计算平台上,进而使其能够与更多应用进行结合。

11个Java开源中文分词器使用方法和分词效果对比

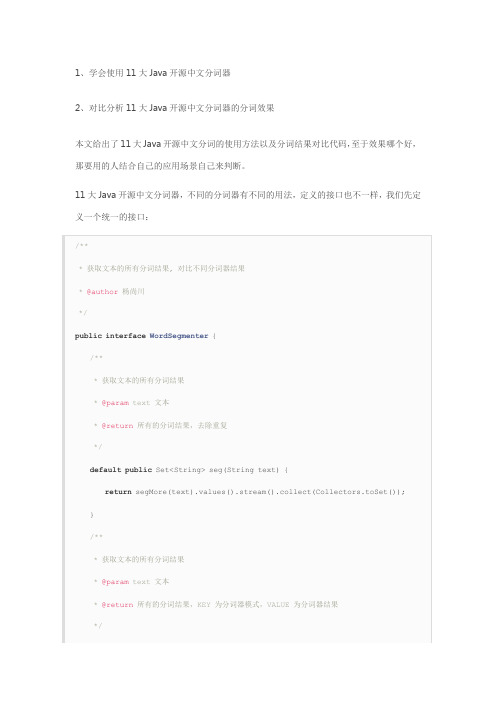

1、学会使用11大Java开源中文分词器

2、对比分析11大Java开源中文分词器的分词效果

本文给出了11大Java开源中文分词的使用方法以及分词结果对比代码,至于效果哪个好,那要用的人结合自己的应用场景自己来判断。

11大Java开源中文分词器,不同的分词器有不同的用法,定义的接口也不一样,我们先定义一个统一的接口:

从上面的定义我们知道,在Java中,同样的方法名称和参数,但是返回值不同,这种情况不可以使用重载。

这两个方法的区别在于返回值,每一个分词器都可能有多种分词模式,每种模式的分词结果都可能不相同,第一个方法忽略分词器模式,返回所有模式的所有不重复分词结果,第二个方法返回每一种分词器模式及其对应的分词结果。

在这里,需要注意的是我们使用了Java8中的新特性默认方法,并使用stream把一个map 的value转换为不重复的集合。

下面我们利用这11大分词器来实现这个接口:

1、word分词器

2、Ansj分词器

3、Stanford分词器

4、FudanNLP分词器

5、Jieba分词器

6、Jcseg分词器

7、MMSeg4j分词器

8、IKAnalyzer分词器

9、Paoding分词器

10、smartcn分词器

11、HanLP分词器

现在我们已经实现了本文的第一个目的:学会使用11大Java开源中文分词器。

最后我们来实现本文的第二个目的:对比分析11大Java开源中文分词器的分词效果,程序如下:。

分词算法java

分词算法java分词算法是自然语言处理中常用的一种技术,它将一段文本按照一定的规则进行切分,将文本切分为一个个独立的词语。

在Java语言中,有许多成熟的分词算法库可以使用,例如HanLP、IKAnalyzer 等。

本文将介绍分词算法的原理和在Java中的实现。

一、分词算法的原理分词算法的目标是将一段文本切分成一个个独立的词语,这需要解决两个问题:词语的界定和词语的切分。

词语的界定是指如何确定一个词语的开始和结束位置,而词语的切分是指如何将文本按照词语的界定进行切分。

在分词算法中,通常采用两种方法来确定词语的界定:基于字典和基于统计。

基于字典的方法是将文本与一个词典进行匹配,词典中包含了各种词语的信息,包括词语的开始和结束位置。

基于统计的方法则是根据词语在语料库中的出现频率来确定词语的界定。

词语的切分是指将文本按照词语的界定进行切分。

在切分过程中,通常采用正向最大匹配和逆向最大匹配两种方法。

正向最大匹配是从左到右依次匹配文本中的词语,将匹配到的词语作为一个切分结果;逆向最大匹配则是从右到左依次匹配文本中的词语,将匹配到的词语作为一个切分结果。

最后,通过比较正向最大匹配和逆向最大匹配的结果,选择其中一个结果作为最终的分词结果。

二、Java中的分词算法实现在Java语言中,有许多开源的分词算法库可以使用。

以下将介绍两种常用的分词算法库:HanLP和IKAnalyzer。

1. HanLPHanLP是一款自然语言处理工具包,其中包含了多种分词算法。

HanLP支持中文分词、词性标注、命名实体识别等多种功能。

使用HanLP进行分词只需简单几行代码即可实现。

需要下载HanLP的jar包,并将其导入到Java项目中。

然后,可以使用以下代码进行分词:```import com.hankcs.hanlp.HanLP;import mon.Term;public class Segmentation {public static void main(String[] args) {String text = "这是一段测试文本";List<Term> termList = HanLP.segment(text);for (Term term : termList) {System.out.println(term.word);}}}```上述代码中,首先创建了一个文本字符串,然后使用HanLP.segment()方法对文本进行分词,返回一个包含分词结果的列表。

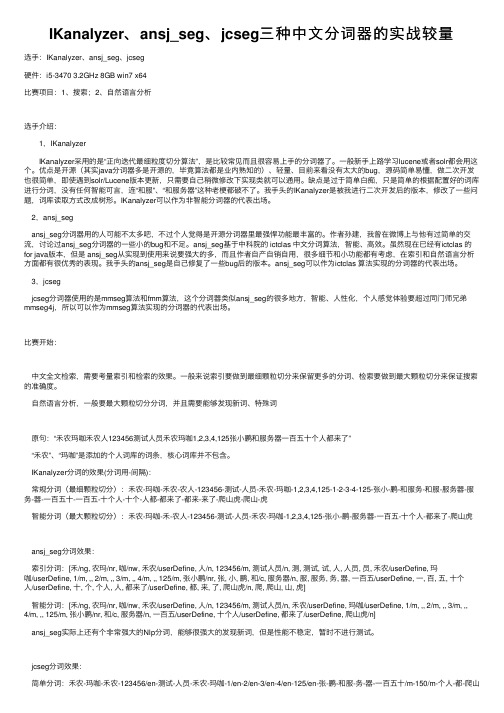

IKanalyzer、ansj_seg、jcseg三种中文分词器的实战较量

IKanalyzer、ansj_seg、jcseg三种中⽂分词器的实战较量选⼿:IKanalyzer、ansj_seg、jcseg硬件:i5-3470 3.2GHz 8GB win7 x64⽐赛项⽬:1、搜索;2、⾃然语⾔分析选⼿介绍: 1,IKanalyzer IKanalyzer采⽤的是“正向迭代最细粒度切分算法”,是⽐较常见⽽且很容易上⼿的分词器了。

⼀般新⼿上路学习lucene或者solr都会⽤这个。

优点是开源(其实java分词器多是开源的,毕竟算法都是业内熟知的)、轻量、⽬前来看没有太⼤的bug,源码简单易懂,做⼆次开发也很简单,即使遇到solr/Lucene版本更新,只需要⾃⼰稍微修改下实现类就可以通⽤。

缺点是过于简单⽩痴,只是简单的根据配置好的词库进⾏分词,没有任何智能可⾔,连“和服”、“和服务器”这种⽼梗都破不了。

我⼿头的IKanalyzer是被我进⾏⼆次开发后的版本,修改了⼀些问题,词库读取⽅式改成树形。

IKanalyzer可以作为⾮智能分词器的代表出场。

2,ansj_segansj_seg分词器⽤的⼈可能不太多吧,不过个⼈觉得是开源分词器⾥最强悍功能最丰富的。

作者孙建,我曾在微博上与他有过简单的交流,讨论过ansj_seg分词器的⼀些⼩的bug和不⾜。

ansj_seg基于中科院的 ictclas 中⽂分词算法,智能、⾼效。

虽然现在已经有ictclas 的for java版本,但是 ansj_seg从实现到使⽤来说要强⼤的多,⽽且作者⾃产⾃销⾃⽤,很多细节和⼩功能都有考虑,在索引和⾃然语⾔分析⽅⾯都有很优秀的表现。

我⼿头的ansj_seg是⾃⼰修复了⼀些bug后的版本。

ansj_seg可以作为ictclas 算法实现的分词器的代表出场。

3,jcsegjcseg分词器使⽤的是mmseg算法和fmm算法,这个分词器类似ansj_seg的很多地⽅,智能、⼈性化,个⼈感觉体验要超过同门师兄弟mmseg4j,所以可以作为mmseg算法实现的分词器的代表出场。

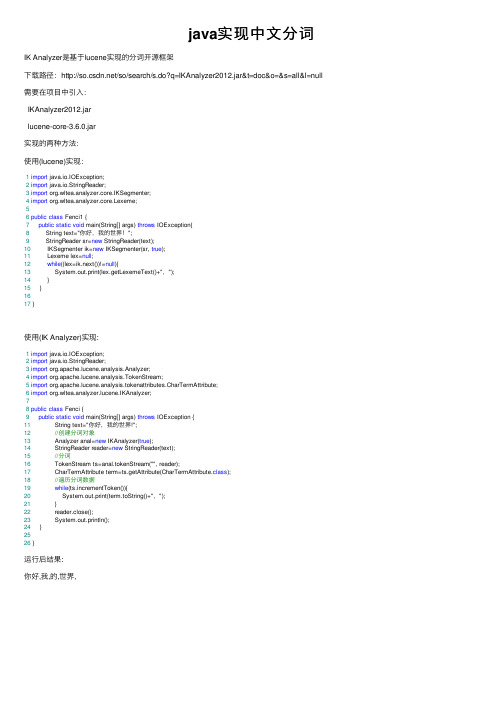

java实现中文分词

java实现中⽂分词IK Analyzer是基于lucene实现的分词开源框架下载路径:/so/search/s.do?q=IKAnalyzer2012.jar&t=doc&o=&s=all&l=null 需要在项⽬中引⼊:IKAnalyzer2012.jarlucene-core-3.6.0.jar实现的两种⽅法:使⽤(lucene)实现:1import java.io.IOException;2import java.io.StringReader;3import org.wltea.analyzer.core.IKSegmenter;4import org.wltea.analyzer.core.Lexeme;56public class Fenci1 {7public static void main(String[] args) throws IOException{8 String text="你好,我的世界!";9 StringReader sr=new StringReader(text);10 IKSegmenter ik=new IKSegmenter(sr, true);11 Lexeme lex=null;12while((lex=ik.next())!=null){13 System.out.print(lex.getLexemeText()+",");14 }15 }1617 }使⽤(IK Analyzer)实现:1import java.io.IOException;2import java.io.StringReader;3import org.apache.lucene.analysis.Analyzer;4import org.apache.lucene.analysis.TokenStream;5import org.apache.lucene.analysis.tokenattributes.CharTermAttribute;6import org.wltea.analyzer.lucene.IKAnalyzer;78public class Fenci {9public static void main(String[] args) throws IOException {11 String text="你好,我的世界!";12//创建分词对象13 Analyzer anal=new IKAnalyzer(true);14 StringReader reader=new StringReader(text);15//分词16 TokenStream ts=anal.tokenStream("", reader);17 CharTermAttribute term=ts.getAttribute(CharTermAttribute.class);18//遍历分词数据19while(ts.incrementToken()){20 System.out.print(term.toString()+",");21 }22 reader.close();23 System.out.println();24 }2526 }运⾏后结果:你好,我,的,世界,。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1、我爱楚离陌

Stanford分词器的分词结果:

1、我爱楚离陌

2、我爱楚离陌

Ansj分词器的分词结果:

1、我爱楚离陌

2、我爱楚离陌

HanLP分词器的分词结果:

1、我爱楚离陌

smartcn分词器的分词结果:

1、我爱楚离陌

FudanNLP分词器的分词结果:

1、我爱楚离陌

Jieba分词器的分词结果:

map.put("Jcseg分词器",newJcsegEvaluation().segMore(text));

map.put("MMSeg4j分词器",newMMSeg4jEvaluation().segMore(text));

map.put("IKAnalyzer分词器",newIKAnalyzerEvaluation().segMore(text));

map.put("HanLP分词器",newHanLPEvaluation().segMore(text));

map.put("FudanNLP分词器",newFudanNLPEvaluation().segMore(text));

map.put("Jieba分词器",newJiebaEvaluation().segMore(text));

map.put("smartcn分词器",newSmartCNEvaluation().seg(text));

returnmap;

}

publicstaticMap<String, Map<String, String>> contrastMore(String text){

Map<String, Map<String, String>>map=newLinkedHashMap<>();

AtomicInteger i =newAtomicInteger();

map.get(k).forEach(v -> {

System.out.println("\t"+ i.incrementAndGet() +"、"+ v);

});

});

}

publicstaticvoidshowMore(Map<String, Map<String, String>>map){

word分词器的分词结果:

1、【全切分算法】我爱楚离陌

2、【双向最大最小匹配算法】我爱楚离陌

3、【正向最大匹配算法】我爱楚离陌

4、【双向最大匹配算法】我爱楚离陌

5、【逆向最大匹配算法】我爱楚离陌

6、【正向最小匹配算法】我爱楚离陌

7、【双向最小匹配算法】我爱楚离陌

8、【逆向最小匹配算法】我爱楚离陌

Stanford分词器的分词结果:

map.keySet().forEach(k->{

System.out.println(k +"的分词结果:");

AtomicInteger i =newAtomicInteger();

map.get(k).keySet().forEach(a -> {

System.out.println("\t"+ i.incrementAndGet()+"、【"+ a +"】\t"+map.get(k).get(a));

3、【ToAnalysis】我爱楚离陌

4、【NlpAnalysis】我爱楚离陌

HanLP分词Leabharlann 的分词结果:1、【NLP分词】我爱楚离陌

2、【标准分词】我爱楚离陌

3、【N-最短路径分词】我爱楚离陌

4、【索引分词】我爱楚离陌

5、【最短路径分词】我爱楚离陌

6、【极速词典分词】我爱楚离陌

smartcn分词器的分词结果:

2、【ComplexSeg】我爱楚离陌

3、【MaxWordSeg】我爱楚离陌

IKAnalyzer分词器的分词结果:

1、【智能切分】我爱楚离陌

2、【细粒度切分】我爱楚离陌

********************************************

map.put("Jcseg分词器",newJcsegEvaluation().seg(text));

map.put("MMSeg4j分词器",newMMSeg4jEvaluation().seg(text));

map.put("IKAnalyzer分词器",newIKAnalyzerEvaluation().seg(text));

map.put("word分词器",newWordEvaluation().segMore(text));

map.put("Stanford分词器",newStanfordEvaluation().segMore(text));

map.put("Ansj分词器",newAnsjEvaluation().segMore(text));

1、【Stanford Chinese Treebank segmentation】我爱楚离陌

2、【Stanford Beijing University segmentation】我爱楚离陌

Ansj分词器的分词结果:

1、【BaseAnalysis】我爱楚离陌

2、【IndexAnalysis】我爱楚离陌

map.put("HanLP分词器",newHanLPEvaluation().seg(text));

map.put("FudanNLP分词器",newFudanNLPEvaluation().seg(text));

map.put("Jieba分词器",newJiebaEvaluation().seg(text));

1、【smartcn】我爱楚离陌

FudanNLP分词器的分词结果:

1、【FudanNLP】我爱楚离陌

Jieba分词器的分词结果:

1、【SEARCH】我爱楚离陌

2、【INDEX】我爱楚离陌

Jcseg分词器的分词结果:

1、【简易模式】我爱楚离陌

2、【复杂模式】我爱楚离陌

MMSeg4j分词器的分词结果:

1、【SimpleSeg】我爱楚离陌

});

});

}

publicstaticvoidmain(String[] args){

show(contrast("我爱楚离陌"));

showMore(contrastMore("我爱楚离陌"));

}

运行结果如下:

********************************************

map.put("smartcn分词器",newSmartCNEvaluation().segMore(text));

returnmap;

}

publicstaticvoidshow(Map<String, Set<String>>map){

map.keySet().forEach(k -> {

System.out.println(k +"的分词结果:");

1、我爱楚离陌

Jcseg分词器的分词结果:

1、我爱楚离陌

MMSeg4j分词器的分词结果:

1、我爱楚离陌

IKAnalyzer分词器的分词结果:

1、我爱楚离陌

********************************************

********************************************

11大Java开源中文分词器的分词效果对比

——动力节点java

在上一篇讲了11个Java开源中文分词器使用方法,这篇就来讲讲Java开源中文分词器的分词效果对比。

publicstaticMap<String, Set<String>> contrast(String text){

Map<String, Set<String>>map=newLinkedHashMap<>();

map.put("word分词器",newWordEvaluation().seg(text));

map.put("Stanford分词器",newStanfordEvaluation().seg(text));

map.put("Ansj分词器",newAnsjEvaluation().seg(text));