Hive简易操作入门

(3)hive的基本操作

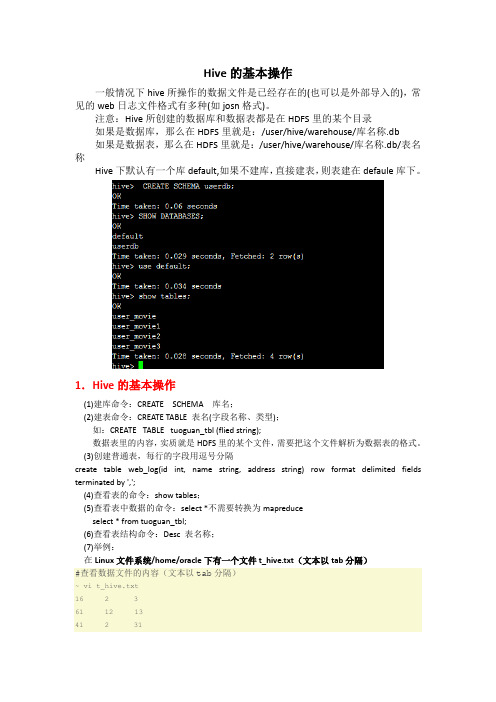

Hive的基本操作一般情况下hive所操作的数据文件是已经存在的(也可以是外部导入的),常见的web日志文件格式有多种(如josn格式)。

注意:Hive所创建的数据库和数据表都是在HDFS里的某个目录如果是数据库,那么在HDFS里就是:/user/hive/warehouse/库名称.db如果是数据表,那么在HDFS里就是:/user/hive/warehouse/库名称.db/表名称Hive下默认有一个库default,如果不建库,直接建表,则表建在defaule库下。

1.Hive的基本操作(1)建库命令:CREATE SCHEMA 库名;(2)建表命令:CREATE TABLE 表名(字段名称、类型);如:CREATE TABLE tuoguan_tbl (flied string);数据表里的内容,实质就是HDFS里的某个文件,需要把这个文件解析为数据表的格式。

(3)创建普通表,每行的字段用逗号分隔create table web_log(id int, name string, address string) row format delimited fields terminated by ',';(4)查看表的命令:show tables;(5)查看表中数据的命令:select *不需要转换为mapreduceselect * from tuoguan_tbl;(6)查看表结构命令:Desc 表名称;(7)举例:在Linux文件系统/home/oracle下有一个文件t_hive.txt(文本以tab分隔)#查看数据文件的内容(文本以tab分隔)~ vi t_hive.txt16 2 361 12 1341 2 3117 21 371 2 311 12 3411 2 34#创建新表hive> CREATE TABLE t_hive (a int, b int, c int) ROW FORMAT DELIMITED FIELDS TERMINATED BY '\t';OKTime taken: 0.489 seconds#导入数据t_hive.txt到t_hive表hive> LOAD DATA LOCAL INPATH '/home/cos/demo/t_hive.txt' OVERWRITE INTO TABLE t_hive ; Copying data from file:/home/cos/demo/t_hive.txtCopying file: file:/home/cos/demo/t_hive.txtLoading data to table default.t_hiveDeleted hdfs://:9000/user/hive/warehouse/t_hiveOKTime taken: 0.397 seconds#查看表hive> show tables;OKt_hiveTime taken: 0.099 seconds#查看表数据hive> select * from t_hive;OK16 2 361 12 1341 2 3117 21 371 2 311 12 3411 2 34Time taken: 0.264 seconds#查看表结构hive> desc t_hive;OKa intb intc intTime taken: 0.1 seconds#修改表,增加一个字段hive> ALTER TABLE t_hive ADD COLUMNS (new_col String);OKTime taken: 0.186 secondshive> desc t_hive;OKa intb intc intnew_col stringTime taken: 0.086 seconds#重命名表名~ ALTER TABLE t_hive RENAME TO t_hadoop;OKTime taken: 0.45 secondshive> show tables;OKt_hadoopTime taken: 0.07 seconds#删除表hive> DROP TABLE t_hadoop;OKTime taken: 0.767 seconds#查看表hive> show tables;OKTime taken: 0.064 seconds(8)如果不想把HDFS里的文件进行移动,则可以创建外部表:create external table web_log2 (id int, name string, address string) Location ‘/user/weblog/’; 2.将json格式的web日志文件user_movie.json导入到Hive的某个表中方法一:使用第三方jar包(1)使用一个第三方的jar包json-serde-1.3.6-SNAPSHOT-jar-with-dependencies.jar(老师给的),将其复制到HIVE_HOME/lib目录下(2)创建表user_moviecreate table user_movie(custid string, sno string, genreid string, movieid string) ROW FORMAT SERDE 'org.openx.data.jsonserde.JsonSerDe' STORED AS TEXTFILE;(3)将json文件user_movie.json导入到表user_movie中首先将json文件上传到Linux文件系统/home/oracle目录下面,然后在Linux命令下执行如下命令:(本地的文件直接导入到HDFS相应的目录里)或者在hive命令中执行:(从HDFS里直接导入数据,这个会把HDFS里的文件移动到HIVE 表的相应目录里)方法二:使用hive自带的jar包hive-hcatalog-core-1.2.1.jar需要把HIVE_HOME/hcatalog/share/hcatalog/hive-hcatalog-core-1.2.1.jar复制到HIVE_HOME/lib,然后在hive命令下用下面方法建表。

hive的基本用法

hive的基本用法(原创版)目录一、Hive 简介二、Hive 基本用法1.查看数据库/表及其表结构2.创建表3.创建索引4.查询语句5.只输出几条正文Hive 是一个基于 Hadoop 的数据仓库工具,可以用来存储、查询和分析大规模的结构化数据。

它类似于传统的关系型数据库,可以通过 SQL 语句进行查询和操作,但 Hive 是构建在 Hadoop 之上的,因此可以充分利用 Hadoop 的分布式计算能力来处理大规模数据。

一、Hive 简介Hive 是由 Facebook 开发的一个数据仓库工具,它可以用来存储、查询和分析大规模的结构化数据。

Hive 本身是一个基于 Java 的程序,可以通过 MapReduce 进行并行计算,以快速处理海量数据。

二、Hive 基本用法1.查看数据库/表及其表结构要查看 Hive 中的数据库和表,可以使用以下命令:```show databases;show tables;```如果需要查看表的详细结构,可以使用以下命令:```desc formatted table_name;```2.创建表在 Hive 中创建表可以使用以下命令:```create table table_name (column1 data_type1,column2 data_type2,...);```其中,`data_type`可以是 int、float、string 等数据类型,`table_name`为你自定义的表名。

例如,创建一个名为`students`的表,包含`id`、`name`和`age`三个字段,其中`id`为整数类型,`name`为字符串类型,`age`为整数类型:```create table students (id int,name string,age int);```3.创建索引在 Hive 中,可以通过创建索引来提高查询效率。

创建索引的命令如下:```create index index_name on table_name (column_name);```其中,`index_name`为你自定义的索引名,`table_name`为表名,`column_name`为要创建索引的字段。

hive的用法

hive的用法一、Hive简介Hive是一个基于Hadoop的数据仓库工具,它能够将结构化数据映射到Hadoop的分布式文件系统上,并且提供了一个SQL-like的查询语言——HiveQL。

通过使用Hive,用户可以方便地处理大规模的数据,并且可以使用熟悉的SQL语言进行查询和分析。

二、Hive的安装1. 前置条件在安装Hive之前,需要先安装好Java和Hadoop。

另外还需要确保系统中已经安装好了MySQL或Derby等数据库管理系统。

2. 下载和解压缩从Apache官网上下载最新版本的Hive,然后解压缩到本地目录中。

3. 配置环境变量在.bashrc或者.bash_profile文件中添加以下内容:export HIVE_HOME=/usr/local/hiveexport PATH=$PATH:$HIVE_HOME/bin4. 修改配置文件进入$HIVE_HOME/conf目录,修改hive-env.sh文件,将其中的JAVA_HOME设置为本地JDK路径。

5. 启动Metastore服务在$HIVE_HOME/bin目录下执行以下命令启动Metastore服务:./hive --service metastore6. 启动CLI客户端在$HIVE_HOME/bin目录下执行以下命令启动CLI客户端:./hive三、创建表格1. 创建数据库在CLI客户端中执行以下命令创建数据库:create database mydb;2. 创建表格在CLI客户端中执行以下命令创建表格:create table mytable (id int, name string);四、导入数据1. 从本地文件系统导入数据在CLI客户端中执行以下命令将本地文件系统中的数据导入到Hive中:load data local inpath '/path/to/local/file' into table mytable;2. 从HDFS导入数据在CLI客户端中执行以下命令将HDFS中的数据导入到Hive中:load data inpath '/path/to/hdfs/file' into table mytable;五、查询数据在CLI客户端中执行以下命令查询数据:select * from mytable;六、常用操作1. 查看表格结构desc mytable;2. 查看数据库列表show databases;3. 查看表格列表show tables;4. 删除表格drop table mytable;5. 删除数据库drop database mydb;七、总结通过以上步骤,我们可以完成对Hive的安装和基本用法的学习。

Hive 基础操作

Hive 基础(2):库、表、字段、交互式查询的基本操作•1、命令行操作•2、表操作•3、列操作•4、查看变量•5、一个完整的建库、表例子•6、常用语句示例•7、Refer:1、命令行操作(1)打印查询头,需要显示设置:set hive.cli.print.header=true;(2)加"--",其后的都被认为是注释,但CLI 不解析注释。

带有注释的文件只能通过这种方式执行:hive -f script_name(3)-e后跟带引号的hive指令或者查询,-S去掉多余的输出:hive -S -e "select * FROM mytable LIMIT 3" > /tmp/myquery (4)遍历所有分区的查询将产生一个巨大的MapReduce作业,如果你的数据集和目录非常多,因此建议你使用strict模型,也就是你存在分区时,必须指定where语句hive> set hive.mapred.mode=strict;(5)显示当前使用数据库set hive.cli.print.current.db=true;(6)设置Hive Job 优先级set mapred.job.priority=VERY_HIGH | HIGH | NORMAL | LOW | VERY_LOW(VERY_LOW=1,LOW=2500,NORMAL=5000,HIGH=7500,VERY _HIGH=10000)set mapred.job.map.capacity=M设置同时最多运行M个map 任务set mapred.job.reduce.capacity=N设置同时最多运行N个red uce任务(7)Hive 中的Mapper个数的是由以下几个参数确定的:mapred.min.split.size ,mapred.max.split.size ,dfs.block.siz esplitSize = Math.max(minSize, Math.min(maxSize, blockSiz e));map个数还与inputfilles的个数有关,如果有2个输入文件,即使总大小小于blocksize,也会产生2个mapmapred.reduce.tasks用来设置reduce个数。

Hive(二)hive的基本操作

Hive(⼆)hive的基本操作⼀、DDL操作(定义操作)1、创建表(1)建表语法结构CREATE [EXTERNAL] TABLE [IF NOT EXISTS] table_name[(col_name data_type [COMMENT col_comment], ...)] //字段注释[COMMENT table_comment] //表的注释[PARTITIONED BY (col_name data_type [COMMENT col_comment], ...)] //分区,前⾯没有出现的字段[CLUSTERED BY (col_name, col_name, ...) //分桶,前⾯出现的字段[SORTED BY (col_name [ASC|DESC], ...)] INTO num_buckets BUCKETS][ROW FORMAT row_format][STORED AS file_format][LOCATION hdfs_path]分区:不⽤关注数据的具体类型,放⼊每⼀个分区⾥;分桶:调⽤哈希函数取模的⽅式进⾏分桶(2)建表语句相关解释create table:创建⼀个指定名字的表。

如果相同名字的表已经存在,则抛出异常;⽤户可以⽤ IF NOT EXISTS 选项来忽略这个异常。

external :关键字可以让⽤户创建⼀个外部表,在建表的同时指定⼀个指向实际数据的路径( LOCATION), Hive 创建内部表时,会将数据移动到数据仓库指向的路径;若创建外部表,仅记录数据所在的路径,不对数据的位置做任何改变。

在删除表的时候,内部表的元数据和数据会被⼀起删除,⽽外部表只删除元数据,不删除数据。

(经典⾯试问题)partitioned :在 Hive Select 查询中⼀般会扫描整个表内容,会消耗很多时间做没必要的⼯作。

有时候只需要扫描表中关⼼的⼀部分数据,因此建表时引⼊了 partition 概念。

hive基本的操作语句(实例简单易懂,createtableXXasselectXX)

hive基本的操作语句(实例简单易懂,createtableXXasselectXX)创建表:hive> CREATE TABLE pokes (foo INT, bar STRING);Creates a table called pokes with two columns, the first being an integer and the other a string创建⼀个新表,结构与其他⼀样hive> create table new_table like records;直接将select的结果存成表:create table XX as selectINSERT OVERWRITE TABLE ..SELECT:新表预先存在hive> FROM records2> INSERT OVERWRITE TABLE stations_by_year SELECT year, COUNT(DISTINCT station) GROUP BY year> INSERT OVERWRITE TABLE records_by_year SELECT year, COUNT(1) GROUP BY year> INSERT OVERWRITE TABLE good_records_by_year SELECT year, COUNT(1) WHERE temperature != 9999 AND (quality = 0 OR quality = 1 OR quality = 4 OR quality = 5 OR quality = 9) GROUP BY year;CREATE TABLE ... AS SELECT:新表表预先不存在hive>CREATE TABLE target AS SELECT col1,col2 FROM source;创建视图:hive> CREATE VIEW valid_records AS SELECT * FROM records2 WHERE temperature !=9999;查看视图详细信息:hive> DESCRIBE EXTENDED valid_records;创建分区表:hive> create table logs(ts bigint,line string) partitioned by (dt String,country String);加载分区表数据:hive> load data local inpath '/home/hadoop/input/hive/partitions/file1' into table logs partition (dt='2001-01-01',country='GB');展⽰表中有多少分区:hive> show partitions logs;展⽰所有表:hive> SHOW TABLES;lists all the tableshive> SHOW TABLES '.*s';lists all the table that end with 's'. The pattern matching follows Java regularexpressions. Check out this link for documentation显⽰表的结构信息hive> DESCRIBE invites;shows the list of columns更新表的名称:hive> ALTER TABLE source RENAME TO target;添加新⼀列hive> ALTER TABLE invites ADD COLUMNS (new_col2 INT COMMENT 'a comment');删除表:hive> DROP TABLE records;删除表中数据,但要保持表的结构定义hive> dfs -rmr /user/hive/warehouse/records;从本地⽂件加载数据:hive> LOAD DATA LOCAL INPATH '/home/hadoop/input/ncdc/micro-tab/sample.txt' OVERWRITE INTO TABLE records;显⽰所有函数:hive> show functions;查看函数⽤法:hive> describe function substr;查看数组、map、结构hive> select col1[0],col2['b'],col3.c from complex;内连接:hive> SELECT sales.*, things.* FROM sales JOIN things ON (sales.id = things.id);查看hive为某个查询使⽤多少个MapReduce作业hive> Explain SELECT sales.*, things.* FROM sales JOIN things ON (sales.id = things.id);外连接:hive> SELECT sales.*, things.* FROM sales LEFT OUTER JOIN things ON (sales.id = things.id);hive> SELECT sales.*, things.* FROM sales RIGHT OUTER JOIN things ON (sales.id = things.id);hive> SELECT sales.*, things.* FROM sales FULL OUTER JOIN things ON (sales.id = things.id);in查询:Hive不⽀持,但可以使⽤LEFT SEMI JOINhive> SELECT * FROM things LEFT SEMI JOIN sales ON (sales.id = things.id);Map连接:Hive可以把较⼩的表放⼊每个Mapper的内存来执⾏连接操作hive> SELECT /*+ MAPJOIN(things) */ sales.*, things.* FROM sales JOIN things ON (sales.id = things.id);。

hive命令操作(一)

(转)Hive命令操作(一)1、准备文本文件,启动hadoop[root@hadoop0 ~]# cat /opt/test.txtJieJieMengMengNingNingJingJingFengJie[root@hadoop0 ~]# start-all.shWarning: $HADOOP_HOME is deprecated.starting namenode, logging to/opt/hadoop/libexec/../logs/hadoop-root-namenode-hadoo p0.outlocalhost: starting datanode, logging to/opt/hadoop/libexec/../logs/hadoop-root-datanode-hadoop 0.outlocalhost: starting secondarynamenode, logging to/opt/hadoop/libexec/../logs/hadoop-root-secondarynameno de-hadoop0.outstarting jobtracker, logging to/opt/hadoop/libexec/../logs/hadoop-root-jobtracker-hadoop 0.outlocalhost: starting tasktracker, logging to/opt/hadoop/libexec/../logs/hadoop-root-tasktracker-hadoo p0.out2、进入命令行[root@hadoop0 ~]# hiveWARNING: org.apache.hadoop.metrics.jvm.EventCounter is deprecated.Please use org.apache.hadoop.log.metrics.EventCounterin all thelog4j.properties files.Logging initialized using configuration injar:file:/opt/hive/lib/hive-common-0.9.0.jar!/hive-log4j.prope rtiesHive historyfile=/tmp/root/hive_job_log_root_201509252001_16742684 19.txt3、查询昨天的表hive> select * from stu;OKJieJie 26 NULLMM 24 NULLTime taken: 17.05 seconds4、显示数据库hive> show databases;OKdefaultTime taken: 0.237 seconds5、创建数据库hive> create database test; OKTime taken: 0.259 secondshive> show databases;OKdefaulttest6、使用数据库Time taken: 0.119 secondshive> use test;OKTime taken: 0.03 seconds7、创建表textfile 默认格式,数据不做压缩,磁盘开销大,数据解析开销大。

非常详细地Hive操作指南–码农网

非常详细地Hive操作指南–码农网1.概述本文主要介绍了Hive的基本操作和一些注意事项,非常详细。

2.基本操作2.1Create Table2.1.1介绍•CREATE TABLE 创建一个指定名字的表。

如果相同名字的表已经存在,则抛出异常;用户可以用 IF NOT EXIST 选项来忽略这个异常。

•EXTERNAL 关键字可以让用户创建一个外部表,在建表的同时指定一个指向实际数据的路径(LOCATION),Hive 创建内部表时,会将数据移动到数据仓库指向的路径;若创建外部表,仅记录数据所在的路径,不对数据的位置做任何改变。

在删除表的时候,内部表的元数据和数据会被一起删除,而外部表只删除元数据,不删除数据。

•LIKE 允许用户复制现有的表结构,但是不复制数据。

•用户在建表的时候可以自定义SerDe 或者使用自带的SerDe。

如果没有指定 ROW FORMAT 或者 ROW FORMAT DELIMITED,将会使用自带的SerDe。

在建表的时候,用户还需要为表指定列,用户在指定表的列的同时也会指定自定义的SerDe,Hive 通过SerDe 确定表的具体的列的数据。

•如果文件数据是纯文本,可以使用 STORED AS TEXTFILE。

如果数据需要压缩,使用 STORED AS SEQUENCE 。

•有分区的表可以在创建的时候使用PARTITIONED BY 语句。

一个表可以拥有一个或者多个分区,每一个分区单独存在一个目录下。

而且,表和分区都可以对某个列进行 CLUSTERED BY 操作,将若干个列放入一个桶(bucket)中。

也可以利用SORT BY 对数据进行排序。

这样可以为特定应用提高性能。

•表名和列名不区分大小写,SerDe 和属性名区分大小写。

表和列的注释是字符串注:•SerDe是Serialize/Deserilize的简称,目的是用于序列化和反序列化•STORED AS TEXTFILE:默认格式,数据不做压缩,磁盘开销大,数据解析开销大。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1Hive使用入门:

主要流程为:

1.运行putty等ssh客户端连接hive服务器;

2.运行hive命令进入hive shell环境;

3.执行HQL语句进行查询;

本流程中以putty为例,如果使用别的SSH客户端,界面上会不同,基本过程相似。

我们当前使用的hive版本为0.9.0。

由于hive本身还在不断开发、升级中,不同版本的hive对各种语句、命令行参数等的支持均不同,请大家注意某个特性从哪一个版本开始支持。

Hive官方网站上的教材中有些命令需要到0.10.0等更高版本才支持!

1.1安装ssh 客户端Putty

软件位置:

\\cn1\ctrip\商业智能部\部门公用\SoftWare\putty.zip

解压所可以得到文件

Putty ssh客户端

1.2登录安装hive的机器

1.2.1运行putty

输入ip地址192.168.83.96 和端口号信息1022,如下图:注:一般默认的SSH端口是22,此处必须修改!

1.2.2登录linux

单击open按钮,按提示输入用户名,并回车,然后按提示输入密码,并回车,例如:

用户名为ppj 密码为HgeeGxR5

提示:可选中复制到剪贴板后,用鼠标右键粘贴

如果用户名、密码正确,则登录成功,顺利进入linux 的bash 环境。

注:此环境类似于运行windows的cmd进入的dos环境。

1.2.3输入hive,进入hive 的shell 环境:

1.2.4查询

执行如下查询语句:

Use test_wqd;

Select * from pageview limit 5;

屏幕输出即为查询语句的结果。

注意:hive的查询语句以分号作为各条命令的分隔符,结尾的分号不能省略。

这一点和SQL Server的T-SQL差异比较大!

2Hive简介:

Hive shell环境和mysql的客户端比较相似,而且hive的某些语法与mysql比较相似,例如:show databases, show tables, desc 等。

Hive支持两种模式:交互模式和批模式。

2.1Hive命令行参数

-e <quoted-query-string> 执行所指定查询字符串,并退出,与mysql的-e类似。

-f <filename> 执行指定的文件中内容并退出。

-H,--help 显示帮助

-S,--silent 安静模式,不输出hive提示符等2.2Hive交互模式

下面简单介绍一下hive交互模式下可以运行的常用命令:

quit 退出hive交互式shell

exit 与quit相同

source 读入hQL文件并执行查询,与mysql的source命令相似。

Set 打印所有配置变量信息

Set<key>=<value> 设置特定配置变量key的值为value。

注:如果拼写错误,将不会报错。

Set –v 打印hadoop和hive相关配置变量信息

! 执行外部的shell命令,例如:

!date; 显示当前系统时间

2.3批处理模式

-e或者-f参数

例1:

hive -e "use ubt; select * from s_ubt_pageview where d='2013-04-01' limit 100;"

例2:

假设query.sql文件的内容:

use ubt;

select * from s_ubt_pageview where d=’2013-04-01’;

则

hive –f query.sql

2.4配置文件

此部分为高级功能。

在账户的home目录下有个.hiverc文件,可以配置hive的一些参数,例如:set hive.cli.print.current.db=true; #在命令行中显示当前数据库名

set press.intermediate=true; #压缩hive的中间结果

set pression.codec=press.BZip2Codec; #对map输出端内容使用BZip2 编码/解码器

set press.output=true; #压缩hive输出

set pression.codec=press.BZip2Codec; #对hive中的MR输出内容使用BZip2 编码/解码器

set mapred.reduce.tasks=7; #设置mapreduce中reduce数目为7

2.5将查询结果导出为文件

2.5.1方法1:INSERT

采用INSERT OVERWRITE LOCAL DIRECTORY 方法。

例如:

在hive shell中执行查询语句:

use ubt;

INSERT OVERWRITE LOCAL DIRECTORY '/home/ppj/pageview'

select * from s_ubt_pageview where d='2013-04-01' limit 100;

则会在/home/ppj目录下自动创建pageview子目录,浏览目录,发现有如下文件:ls -al pageview/

其中:

主要的内容在000000_0中。

而.00000_0.crc为linux下的隐藏文件,只保存对应文件000000_0的CRC校验和,可忽略之。

000000_0文件的格式为【与hive建表语句中指定的行、列、复杂类型的分隔符有关】。

默认如下:

\n 文本文件中记录与记录之间的分隔符

For text files, each line is a record, so the line feed character separates records.

^A Ctrl+A,也就是\001,列和列之间的分隔符

Separates all fields (columns). Written using the octal code \001 when explicitly specified in CREATE TABLE statements.

^B Separate the elements in an ARRAY or STRUCT, or the key-value pairs in a MAP. Written using the octal code \002 when explicitly specified in CREATE TABLE statements.

^C Separate the key from the corresponding value in MAP key-value pairs. Written using the octal code \003 when explicitly specified in CREATE TABLE statements.

2.5.2方法2:查询结果重定向

Linux支持标准输出和标准错误的重定向,可以把原先输出到标准输出流的内容重定向到文件。

默认情况下,hive的查询结果输出内容以\t作为分隔符。

以上述query.sql为例:

hive -f query.sql > query.tsv

查看query.tsv的内容,发现头部为:

注意:头部多了一行,即标题行。

如果某列中本身有\t,需要在查询语句中特殊处理。

3使用SFTP工具下载文件

如果文件比较大,则建议在linux下用gzip命令先进行压缩,再下载,输入如下命令即可压缩:

gzip 000000_0

则压缩后的文件为

000000_0.gz

推荐使用winscp通过sftp协议下载文件。

3.1安装WinSCP

软件安装包的目录在

\\cn1\ctrip\商业智能部\部门公用\SoftWare\winscp514setup.zip 解压缩出来就是WinSCP的安装程序

3.2下载文件

3.2.1新建连接

单击“新建”按钮,进入新建对话框:

3.2.2登录

输入

ip地址192.168.83.96

端口号信息1022

用户名、密码:

如果配置正确,则可以进入类似于window explorer的图形界面。

3.2.3下载文件

在左边窗口可以设置本地的当前目录,而右边窗口则可以设置主机的当前目录。

采用类似拖拽操作,即可以从SSH服务器下载至本地。