一维搜索--牛顿法

一维牛顿法

一维牛顿法也称为一维牛顿-拉夫逊方法,是一种迭代的优化算法,用于求解一维非线性函数的极值点。

这种方法通过利用函数的二阶导数信息来逼近极值点,并在每次迭代中更新搜索方向,以快速收敛到最优解。

一维牛顿法的具体步骤如下:

初始化:选择初始点x0,并设定迭代终止条件,如迭代次数或函数值的收敛阈值。

计算一阶和二阶导数:计算函数f(x)在当前点xk处的一阶导数f'(xk)和二阶导数f''(xk)。

更新搜索方向和步长:根据二阶导数的信息,计算搜索方向dk和步长αk。

更新当前点:计算新的点xk+1 = xk + αk * dk。

判断终止条件:检查是否满足终止条件,如果满足则停止迭代,否则返回步骤2。

例如,对于函数f ( x ) = x 3 −2 sin ( x ) f(x) = x^3 - 2\sin(x)f(x)=x3−2sin(x),在A AA点处对函数f ( x ) f(x)f(x)展开,得到近似的二次函数φ( x ) \varphi(x)φ(x),φ( x ) \varphi(x)φ(x)的最小值在B BB点处取得,高斯牛顿法的下一步迭代点即为与B BB点横坐标相等的C CC点。

如此,只需数次,迭代能够达到很高的精度,可见牛顿法收敛速度快。

第二章一维搜素解析

不存在极值点

当x x0时,f x 0,当x x0时,f x 0,则x0为极小值

当x x0时,f x 0,当x x0时,f x 0,则x0为极大值

又 f x lim f x f x0

xx0 0

x x0

0,极小值

一维函数极值条件: f x0 0,且f x 0,极大值

0,非极值

(1) 如 果 f1

f

,

2

则

留

下

的

区

间

为[a,x2

]

(2) 如 果 f1

f

,

2

则

留

下

的

区

间

为[ x1,b]

(3) 如 果 f1

f

,

2

则

留

下

的

区

间

为[ x1,x2

]

a) f a1 f b1

b) f a1 f b1

迭代

迭代是重复反馈过程的活动,

其目的通常是为了逼近所需目标或结果。

每一次对过程的重复称为一次“迭代”,

B. 当 f1> f2 时,极小点必在[x1, b]中,则

x1 a, x2 x1, f2 f1, x2 a 0.618(b a), f2 f (x2 )

(4)判断是否满足精度要求。若新区间已缩短至预 定精度要求,即 b a ,则转第5)步;否则 转第3)步,进行下一次迭代计算。

迭代

• %求第十个斐波那契数

• a0=0

• a1=1

• for i=2:10

•

a2=a0+a1

•

a0=a1;a1=a2;

• end

•

• %求不大于100的最大斐波那契数

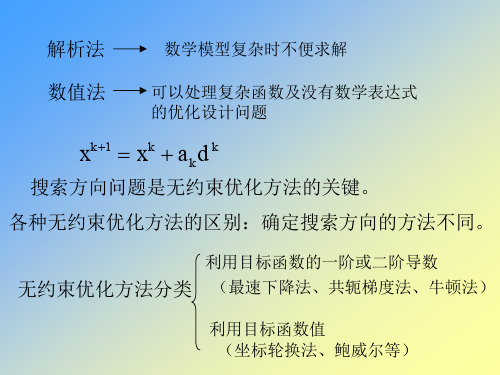

最优化问题的算法迭代格式

最优化问题的算法迭代格式最优化问题的算法迭代格式最优化问题是指在一定的条件下,寻找使某个目标函数取得极值(最大值或最小值)的变量取值。

解决最优化问题的方法有很多种,其中较为常见的是迭代法。

本文将介绍几种常用的最优化问题迭代算法及其格式。

一、梯度下降法梯度下降法是一种基于负梯度方向进行搜索的迭代算法,它通过不断地沿着目标函数的负梯度方向进行搜索,逐步接近极值点。

该方法具有收敛速度快、易于实现等优点,在许多应用领域中被广泛使用。

1. 算法描述对于目标函数 $f(x)$,初始点 $x_0$ 和学习率 $\alpha$,梯度下降算法可以描述为以下步骤:- 计算当前点 $x_k$ 的梯度 $\nabla f(x_k)$;- 更新当前点 $x_k$ 为 $x_{k+1}=x_k-\alpha\nabla f(x_k)$;- 如果满足停止条件,则输出结果;否则返回第 1 步。

2. 算法特点- 沿着负梯度方向进行搜索,能够快速收敛;- 学习率的选择对算法效果有重要影响;- 可能会陷入局部极小值。

二、共轭梯度法共轭梯度法是一种基于线性方程组求解的迭代算法,它通过不断地搜索与当前搜索方向共轭的新搜索方向,并在该方向上进行一维搜索,逐步接近极值点。

该方法具有收敛速度快、内存占用少等优点,在大规模问题中被广泛使用。

1. 算法描述对于目标函数 $f(x)$,初始点 $x_0$ 和初始搜索方向 $d_0$,共轭梯度算法可以描述为以下步骤:- 计算当前点 $x_k$ 的梯度 $\nabla f(x_k)$;- 如果满足停止条件,则输出结果;否则进行下一步;- 计算当前搜索方向 $d_k$;- 在当前搜索方向上进行一维搜索,得到最优步长 $\alpha_k$;- 更新当前点为 $x_{k+1}=x_k+\alpha_k d_k$;- 计算新的搜索方向 $d_{k+1}$;- 返回第 2 步。

2. 算法特点- 搜索方向与前面所有搜索方向都正交,能够快速收敛;- 需要存储和计算大量中间变量,内存占用较大;- 可以用于非线性问题的求解。

-一维搜索示意图

xk 1

xk

f xk f xk

对于多元函数,在 xk 泰勒展开,得

f x x

f xk f xk T x xk 1 x xk T 2 f xk x xk 2 设 xk1 为函数的极小点,根据极值的必要条件

0

d k1 T d k 0

由此可知,在最速下降法中,相邻两个迭代点上的函数 梯度相互垂直。而搜索方向就是负梯度方向,因此相邻 两个搜索方向互相垂直。

例4-1 求目标函数 f x x12 25x22 的极小点。

第三节牛顿型方法

在第三章中,我们已经讨论了一维搜索的牛顿方法。 得出一维情况下的牛顿迭代公式

3、判断 f xk1 是否满足,若满足则打印 xk1

否则转4。

4、提供新的共轭方向 d k 1 ,使 d j T Gd k1 0

5、置 k k 1 ,转2。

第五节 共轭梯度法

共轭梯度法是共轭方向法的一种,共轭向量有迭代点 的负梯度构造出来,所以称共轭梯度法。

由于对称矩阵H在迭代过程中是不断修正改变的,它对于一 般尺度的梯度起到改变尺度的作用,因此H又称变尺度矩阵。

一、尺度矩阵的概念 变量的尺度变换是放大或缩小各个坐标。 通过尺度变换可以把函数的偏心程度降低到最低限度。

对于一般二次函数

f x 1 xTGx bT x c

2 如果进行尺度变换

x1 x0 a0d 0

f f x1 T d 0 0

d x1

x* x1 a1d1

d1 应满足什么条件?

对于二次函数 f x 在 x* 处取得极小点的必要条件

f x* Gx* b 0

牛顿法

如前面所提到的,最速下降法在最初几步迭代中函数值下降很快外,总的说来下降的并不快,且愈接近极值点下降的愈慢。

因此,应寻找使目标函数下降更快的方法。

牛顿法就是一种收敛很快的方法,其基本思路是利用二次曲线来逐点近似原目标函数,以二次曲线的极小值点来近似原目标函数的极小值点并逐渐逼近改点。

一维目标函数()f x 在()k x 点逼近用的二次曲线(即泰勒二次多项式)为()()()()()()21()()()()()()2k k k k k k x f x f x x x f x x x ϕ'''=+-+- 此二次函数的极小点可由()()0k xϕ'=求得。

对于n 维问题,n 为目标函数()f X 在()k X 点逼近用的二次曲线为:()()()()()2()()1()()().[][].().[]2k k k k k T k k X f x f X X X X X f X X X ϕ⎡⎤=+∇-+-∇-⎣⎦令式中的Hessian 2()()()()k k f XH X ∇=,则上式可改写为:()()()()()()()1()()().[][].().[]2()k k k k k T k k X f x f X X X X X H X X X f X ϕ⎡⎤=+∇-+--⎣⎦≈当()0X ϕ∇=时可求得二次曲线()X ϕ的极值点,且当且仅当改点处的Hessian 矩阵为正定时有极小值点。

由上式得:()()()()()()[]k k k X f X H X X X ϕ∇=∇+-令()0X ϕ∇=,则()()()()()[]0k k k f X H X X X ∇+-=若()()k H X为可逆矩阵,将上式等号两边左乘1()()k H X -⎡⎤⎣⎦,则得1()()()()()[]0k k k n H X f X I X X -⎡⎤∇+-=⎣⎦整理后得1()()()()()k k k X X H X f X -⎡⎤=-∇⎣⎦当目标函数()f X 是二次函数时,牛顿法变得极为简单、有效,这时()()k H X 是一个常数矩阵,式()()()()()()()1()()().[][].().[]2()k k k k k T k k X f x f X X X X X H X X X f X ϕ⎡⎤=+∇-+--⎣⎦≈变成精确表达式,而利用式1()()()()()k k k X XH X f X -⎡⎤=-∇⎣⎦作一次迭代计算所得的X 就是最优点*X 。

最优化理论与方法——牛顿法

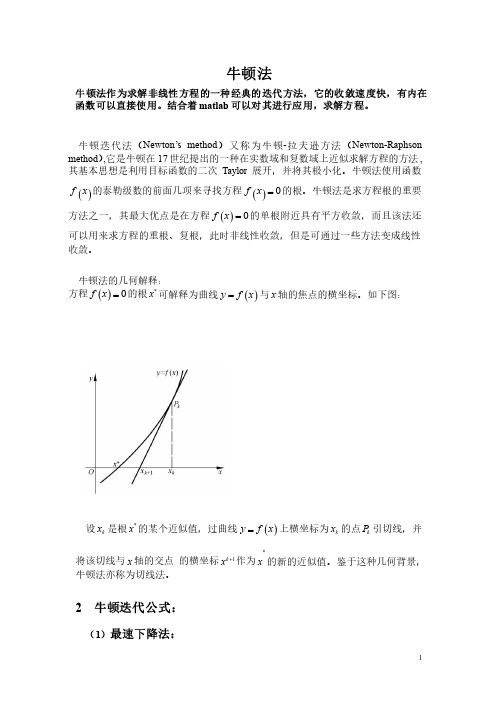

牛顿法牛顿法作为求解非线性方程的一种经典的迭代方法,它的收敛速度快,有内在函数可以直接使用。

结合着matlab 可以对其进行应用,求解方程。

牛顿迭代法(Newton Newton’’s s method method )又称为牛顿-拉夫逊方法(Newton-Raphson method ),它是牛顿在17世纪提出的一种在实数域和复数域上近似求解方程的方法,其基本思想是利用目标函数的二次Taylor 展开,并将其极小化。

牛顿法使用函数()f x 的泰勒级数的前面几项来寻找方程()0f x =的根。

牛顿法是求方程根的重要方法之一,其最大优点是在方程()0f x =的单根附近具有平方收敛,而且该法还可以用来求方程的重根、复根,此时非线性收敛,但是可通过一些方法变成线性收敛。

收敛。

牛顿法的几何解释:牛顿法的几何解释:方程()0f x =的根*x 可解释为曲线()y f x =与x 轴的焦点的横坐标。

如下图:轴的焦点的横坐标。

如下图:设k x 是根*x 的某个近似值,过曲线()y f x =上横坐标为k x 的点k P 引切线,并将该切线与x 轴的交点轴的交点 的横坐标1k x +作为*x 的新的近似值。

鉴于这种几何背景,牛顿法亦称为切线法。

牛顿法亦称为切线法。

2 牛顿迭代公式:(1)最速下降法:x-d gk k×Gg sks×GGd 101x x x -(1)令k k G v I k G -=+,其中:,其中:0k v =,如果k G 正定;0,k v >否则。

否则。

(2)计算_k G 的Cholesky 分解,_T k k k k G L D L =。

(3)解_k k G d g =-得k d 。

(4)令1k k k x x d +=+牛顿法的优点是收敛快,缺点一是每步迭代要计算()()'k k f x f x 及,计算量较大且有时()'k fx 计算较困难,二是初始近似值0x 只在根*x附近才能保证收敛,如0x 给的不合适可能不收敛。

凸优化之无约束优化(一维搜索方法:二分法、牛顿法、割线法)

凸优化之⽆约束优化(⼀维搜索⽅法:⼆分法、⽜顿法、割线法)1、⼆分法(⼀阶导)⼆分法是利⽤⽬标函数的⼀阶导数来连续压缩区间的⽅法,因此这⾥除了要求 f 在 [a0,b0] 为单峰函数外,还要去 f(x) 连续可微。

(1)确定初始区间的中点 x(0)=(a0+b0)/2 。

然后计算 f(x) 在 x(0) 处的⼀阶导数 f'(x(0)),如果 f'(x(0)) >0 , 说明极⼩点位于 x(0)的左侧,也就是所,极⼩点所在的区间压缩为[a0,x(0)];反之,如果 f'(x(0)) <0,说明极⼩点位于x(0)的右侧,极⼩点所在的区间压缩为[x(0),b0];如果f'(x(0)) = 0,说明就是函数 f(x) 的极⼩点。

(2)根据新的区间构造x(1),以此来推,直到f'(x(k)) = 0,停⽌。

可见经过N步迭代之后,整个区间的总压缩⽐为(1/2)N,这⽐黄⾦分割法和斐波那契数列法的总压缩⽐要⼩。

1 #ifndef _BINARYSECTION_H_2#define _BINARYSECTION_H_34 typedef float (* PtrOneVarFunc)(float x);5void BinarySectionMethod(float a, float b, PtrOneVarFunc fi, float epsilon);67#endif1 #include<iostream>2 #include<cmath>3 #include "BinarySection.h"45using namespace std;67void BinarySectionMethod(float a, float b, PtrOneVarFunc tangent, float epsilon)8 {9float a0,b0,middle;10int k;11 k = 1;12 a0 = a;13 b0 = b;14 middle = ( a0 + b0 )/2;1516while( abs(tangent(middle)) - epsilon > 0 )17 {18 #ifdef _DEBUG19 cout<<k++<<"th iteration:x="<<middle<<",f'("<<middle<<")="<<tangent(middle)<<endl;20#endif2122if( tangent(middle) > 0)23 {24 b0 = middle;25 }26else27 {28 a0 = middle;29 }30 middle =( a0+b0)/2;31 }3233 cout<<k<<"th iteration:x="<<middle<<",f'("<<middle<<")="<<tangent(middle)<<endl;34 }1 #include<iostream>2 #include "BinarySection.h"345float TangentFunctionofOneVariable(float x)6 {7return14*x-5;//7*x*x-5*x+2;8 }910int main()11 {12 BinarySectionMethod(-50, 50, TangentFunctionofOneVariable, 0.001);13return0;14 }1th iteration:x=0,f'(0)=-52th iteration:x=25,f'(25)=3453th iteration:x=12.5,f'(12.5)=1704th iteration:x=6.25,f'(6.25)=82.55th iteration:x=3.125,f'(3.125)=38.756th iteration:x=1.5625,f'(1.5625)=16.8757th iteration:x=0.78125,f'(0.78125)=5.93758th iteration:x=0.390625,f'(0.390625)=0.468759th iteration:x=0.195312,f'(0.195312)=-2.2656210th iteration:x=0.292969,f'(0.292969)=-0.89843811th iteration:x=0.341797,f'(0.341797)=-0.21484412th iteration:x=0.366211,f'(0.366211)=0.12695313th iteration:x=0.354004,f'(0.354004)=-0.043945314th iteration:x=0.360107,f'(0.360107)=0.041503915th iteration:x=0.357056,f'(0.357056)=-0.001220716th iteration:x=0.358582,f'(0.358582)=0.020141617th iteration:x=0.357819,f'(0.357819)=0.0094604518th iteration:x=0.357437,f'(0.357437)=0.0041198719th iteration:x=0.357246,f'(0.357246)=0.0014495820th iteration:x=0.357151,f'(0.357151)=0.0001144412、⽜顿法(⼆阶导)前提:f 在 [a0,b0] 为单峰函数,且[a0,b0] 在极⼩点附近,不能离的太远否则可能⽆法收敛。

黄金分割法 二次插值 牛顿 matlab 程序一维搜索方法比较

一维搜索方法应用比较一、黄金分割法(1)黄金分割法的起源黄金分割在文艺复兴前后,经过阿拉伯人传入欧洲,受到了欧洲人的欢迎,他们称之为"金法",17世纪欧洲的一位数学家,甚至称它为"各种算法中最可宝贵的算法"。

这种算法在印度称之为"三率法"或"三数法则",也就是我们现在常说的比例方法。

其实有关"黄金分割",我国也有记载。

虽然没有古希腊的早,但它是我国古代数学家独立创造的,后来传入了印度。

经考证。

欧洲的比例算法是源于我国而经过印度由阿拉伯传入欧洲的,而不是直接从古希腊传入的。

因为它在造型艺术中具有美学价值,在工艺美术和日用品的长宽设计中,采用这一比值能够引起人们的美感,在实际生活中的应用也非常广泛,建筑物中某些线段的比就科学采用了黄金分割,舞台上的报幕员并不是站在舞台的正中央,而是偏在台上一侧,以站在舞台长度的黄金分割点的位置最美观,声音传播的最好。

就连植物界也有采用黄金分割的地方,如果从一棵嫩枝的顶端向下看,就会看到叶子是按照黄金分割的规律排列着的。

在很多科学实验中,选取方案常用一种0.618法,即优选法,它可以使我们合理地安排较少的试验次数找到合理的西方和合适的工艺条件。

正因为它在建筑、文艺、工农业生产和科学实验中有着广泛而重要的应用,所以人们才珍贵地称它为"黄金分割"。

我国数学家华罗庚曾致力于推广优选法中的"0.618法",把黄金分割应用于生活实际及科学应用中。

黄金分割〔Golden Section〕是一种数学上的比例关系。

黄金分割具有严格的比例性、艺术性、和谐性,蕴藏着丰富的美学价值。

应用时一般取0.618 ,就像圆周率在应用时取3.14一样。

由于公元前6世纪古希腊的毕达哥拉斯学派研究过正五边形和正十边形的作图,因此现代数学家们推断当时毕达哥拉斯学派已经触及甚至掌握了黄金分割。