各种聚类算法的比较

各种聚类算法的比较

各种聚类算法的比较聚类算法是一种将数据按照相似性分组的无监督学习方法。

在数据分析和机器学习中,聚类算法被广泛应用于数据挖掘、模式识别、图像处理等领域。

本文将介绍几种常见的聚类算法,并对它们进行比较。

1. K-means算法K-means算法是最常见的聚类算法之一,它将数据划分为K个集群,每个集群包含最接近其均值的数据点。

该算法迭代地更新集群的均值,直到满足收敛条件。

K-means算法简单、高效,适用于大型数据集。

然而,它对异常值和噪声敏感,并且对初始聚类中心的选择非常敏感。

2.层次聚类算法层次聚类算法是一种自底向上或自顶向下的聚类方法,它通过计算数据点之间的相似性构建一个聚类层次结构。

这种层次结构可以以树状图的形式表示,称为树状图聚类。

层次聚类算法的优点是不需要指定聚类个数,且能够处理任意形状的聚类。

然而,该算法的计算复杂度较高,并且对输入数据的规模和噪声敏感。

3.密度聚类算法密度聚类算法通过计算数据点周围的密度来确定聚类结构。

DBSCAN是最常见的密度聚类算法之一,它通过指定半径和邻域密度来定义聚类。

DBSCAN能够识别任意形状的聚类,并且对噪声和异常值具有较高的鲁棒性。

然而,密度聚类算法对参数的选择非常敏感,并且对高维数据和不同密度的聚类效果较差。

4.基于概率的聚类算法基于概率的聚类算法假设数据服从其中一种概率分布,并通过最大化似然函数来进行聚类。

GMM (Gaussian Mixture Model) 是一种常见的基于概率的聚类算法,它假设数据由多个高斯分布组成。

GMM算法能够分离具有不同协方差的聚类,适用于高维数据和非球状的聚类。

然而,该算法对初始参数的选择敏感,并且计算复杂度较高。

5.划分聚类算法划分聚类算法将数据划分为互斥的聚类,然后通过迭代地重新分配数据点来优化聚类质量。

PAM (Partitioning Around Medoids) 和CLARA (Clustering Large Applications)是常见的划分聚类算法。

k-means聚类和fcm聚类的原理概念

k-means聚类和fcm聚类的原理概念摘要:一、聚类分析概述1.定义与作用2.常用的聚类算法二、K-means 聚类原理1.算法基本思想2.计算过程3.特点与优缺点三、FCM 聚类原理1.算法基本思想2.计算过程3.特点与优缺点四、K-means 与FCM 聚类的比较1.相似之处2.不同之处3.适用场景正文:一、聚类分析概述聚类分析是一种无监督学习方法,通过将相似的数据对象归为一类,从而挖掘数据集的潜在结构和模式。

聚类分析在数据挖掘、模式识别、图像处理、生物学研究等领域具有广泛应用。

常用的聚类算法有K-means 聚类和FCM 聚类等。

二、K-means 聚类原理1.算法基本思想K-means 聚类是一种基于划分的聚类方法,通过迭代计算数据点与当前中心点的距离,将数据点分配到距离最近的中心点所属的簇,然后更新中心点。

这个过程持续进行,直到满足停止条件。

2.计算过程(1)随机选择k 个数据点作为初始中心点。

(2)计算其他数据点与初始中心点的距离,将数据点分配到距离最近的簇。

(3)计算每个簇的中心点。

(4)重复步骤2 和3,直到中心点不再发生变化或达到最大迭代次数。

3.特点与优缺点特点:简单、易于实现,适用于大规模数据集。

优点:可以处理大规模数据集,对噪声数据具有一定的鲁棒性。

缺点:对初始中心点敏感,可能导致局部最优解;计算过程中需要反复计算距离,计算量较大。

三、FCM 聚类原理1.算法基本思想FCM 聚类是一种基于模糊划分的聚类方法,通过计算数据点与当前中心点的模糊距离,将数据点分配到距离最近的簇。

模糊距离是基于隶属度函数计算的,可以反映数据点对簇的隶属程度。

2.计算过程(1)随机选择k 个数据点作为初始中心点。

(2)计算其他数据点与初始中心点的模糊距离,将数据点分配到距离最近的簇。

(3)计算每个簇的中心点。

(4)重复步骤2 和3,直到中心点不再发生变化或达到最大迭代次数。

3.特点与优缺点特点:考虑了数据点对簇的隶属程度,具有更好的全局优化性能。

各种聚类算法的优缺点

各种聚类算法的优缺点在机器学习领域中,聚类(cluster)是最基本的无监督学习问题之一。

聚类算法是指把具有相似性质的数据对象分组的算法,被广泛应用于数据挖掘、模式识别等领域。

本文将介绍几种常见的聚类算法、它们的优缺点,并与之间做出比较。

一、K-Means聚类算法K-Means算法又称为K均值算法,是最为普及的一种聚类算法。

该算法通过将 n 个对象分到 k 个类的方法来使每个数据对象都与所属类的均值最为接近。

K-Means聚类算法有以下优缺点:优点:1.简单、易于实现。

2.计算速度快。

缺点:1.需要预先设定数据类别数量,且对初始化比较敏感。

2.数据集分布不均匀或聚类类别的数量差别较大时,聚类效果较差。

二、层次聚类算法层次聚类算法是一种基于树形结构的聚类方法,可以得到不同类别的层次结构。

该算法的核心思想就是通过计算每个数据对象间的距离并逐步将他们聚合成层次结构。

层次聚类算法的优缺点如下:优点:1.可以帮助我们发现数据对象之间的内部关系和层次结构。

2.不需要预先设定聚类类别数量。

缺点:1.计算复杂度较高,不适合大规模数据集。

2.聚类的结果可能会很大,难以在可视化方面得到较好的展示效果。

三、DBSCAN聚类算法DBSCAN是基于密度的聚类算法。

该算法将具有密度连接的数据点视为一组,并且可以在其它密度较低的区域中选择单个数据点。

DBSCAN聚类算法的优缺点如下:优点:1.不需要预设聚类类别数量。

2.能够发现任意形态的聚类。

缺点:1.初始化比较敏感,对参数设置等因素较为敏感。

2.难以解决密度分布不均一、噪音点分布不规律的问题。

四、BIRCH聚类算法BIRCH算法是基于描述的聚类方法,是聚类中的层次算法。

BIRCH的全称是Balanced Iterative Reducing and Clustering using Hierarchies,它采用一种合并聚类方式,通过类的层次结构来简化聚类过程。

BIRCH聚类算法的优缺点如下:优点:1.该算法能够处理海量数据。

聚类算法和分类算法总结

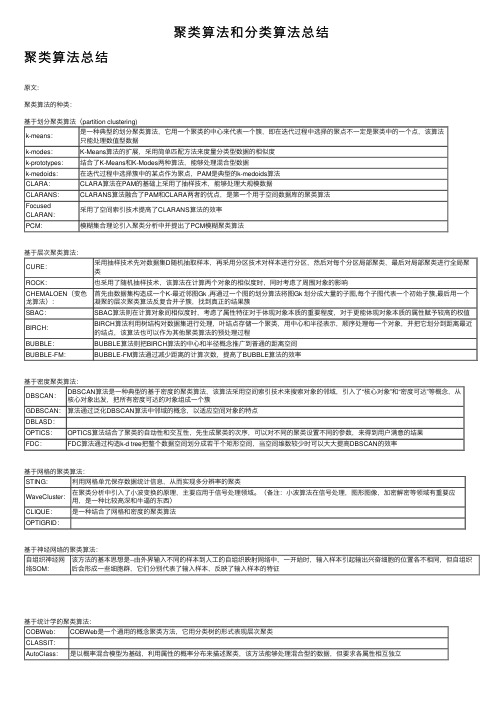

聚类算法和分类算法总结聚类算法总结原⽂:聚类算法的种类:基于划分聚类算法(partition clustering)k-means:是⼀种典型的划分聚类算法,它⽤⼀个聚类的中⼼来代表⼀个簇,即在迭代过程中选择的聚点不⼀定是聚类中的⼀个点,该算法只能处理数值型数据k-modes:K-Means算法的扩展,采⽤简单匹配⽅法来度量分类型数据的相似度k-prototypes:结合了K-Means和K-Modes两种算法,能够处理混合型数据k-medoids:在迭代过程中选择簇中的某点作为聚点,PAM是典型的k-medoids算法CLARA:CLARA算法在PAM的基础上采⽤了抽样技术,能够处理⼤规模数据CLARANS:CLARANS算法融合了PAM和CLARA两者的优点,是第⼀个⽤于空间数据库的聚类算法FocusedCLARAN:采⽤了空间索引技术提⾼了CLARANS算法的效率PCM:模糊集合理论引⼊聚类分析中并提出了PCM模糊聚类算法基于层次聚类算法:CURE:采⽤抽样技术先对数据集D随机抽取样本,再采⽤分区技术对样本进⾏分区,然后对每个分区局部聚类,最后对局部聚类进⾏全局聚类ROCK:也采⽤了随机抽样技术,该算法在计算两个对象的相似度时,同时考虑了周围对象的影响CHEMALOEN(变⾊龙算法):⾸先由数据集构造成⼀个K-最近邻图Gk ,再通过⼀个图的划分算法将图Gk 划分成⼤量的⼦图,每个⼦图代表⼀个初始⼦簇,最后⽤⼀个凝聚的层次聚类算法反复合并⼦簇,找到真正的结果簇SBAC:SBAC算法则在计算对象间相似度时,考虑了属性特征对于体现对象本质的重要程度,对于更能体现对象本质的属性赋予较⾼的权值BIRCH:BIRCH算法利⽤树结构对数据集进⾏处理,叶结点存储⼀个聚类,⽤中⼼和半径表⽰,顺序处理每⼀个对象,并把它划分到距离最近的结点,该算法也可以作为其他聚类算法的预处理过程BUBBLE:BUBBLE算法则把BIRCH算法的中⼼和半径概念推⼴到普通的距离空间BUBBLE-FM:BUBBLE-FM算法通过减少距离的计算次数,提⾼了BUBBLE算法的效率基于密度聚类算法:DBSCAN:DBSCAN算法是⼀种典型的基于密度的聚类算法,该算法采⽤空间索引技术来搜索对象的邻域,引⼊了“核⼼对象”和“密度可达”等概念,从核⼼对象出发,把所有密度可达的对象组成⼀个簇GDBSCAN:算法通过泛化DBSCAN算法中邻域的概念,以适应空间对象的特点DBLASD:OPTICS:OPTICS算法结合了聚类的⾃动性和交互性,先⽣成聚类的次序,可以对不同的聚类设置不同的参数,来得到⽤户满意的结果FDC:FDC算法通过构造k-d tree把整个数据空间划分成若⼲个矩形空间,当空间维数较少时可以⼤⼤提⾼DBSCAN的效率基于⽹格的聚类算法:STING:利⽤⽹格单元保存数据统计信息,从⽽实现多分辨率的聚类WaveCluster:在聚类分析中引⼊了⼩波变换的原理,主要应⽤于信号处理领域。

(完整版)聚类算法总结

1.聚类定义“聚类是把相似的对象通过静态分类的方法分成不同的组别或者更多的子集(subset),这样让在同一个子集中的成员对象都有一些相似的属性”——wikipedia“聚类分析指将物理或抽象对象的集合分组成为由类似的对象组成的多个类的分析过程。

它是一种重要的人类行为。

聚类是将数据分类到不同的类或者簇这样的一个过程,所以同一个簇中的对象有很大的相似性,而不同簇间的对象有很大的相异性。

”——百度百科说白了,聚类(clustering)是完全可以按字面意思来理解的——将相同、相似、相近、相关的对象实例聚成一类的过程。

简单理解,如果一个数据集合包含N个实例,根据某种准则可以将这N 个实例划分为m个类别,每个类别中的实例都是相关的,而不同类别之间是区别的也就是不相关的,这个过程就叫聚类了。

2.聚类过程:1) 数据准备:包括特征标准化和降维.2) 特征选择:从最初的特征中选择最有效的特征,并将其存储于向量中.3) 特征提取:通过对所选择的特征进行转换形成新的突出特征.4) 聚类(或分组):首先选择合适特征类型的某种距离函数(或构造新的距离函数)进行接近程度的度量;而后执行聚类或分组.5) 聚类结果评估:是指对聚类结果进行评估.评估主要有3 种:外部有效性评估、内部有效性评估和相关性测试评估.3聚类算法的类别没有任何一种聚类技术(聚类算法)可以普遍适用于揭示各种多维数据集所呈现出来的多种多样的结构,根据数据在聚类中的积聚规则以及应用这些规则的方法,有多种聚类算法.聚类算法有多种分类方法将聚类算法大致分成层次化聚类算法、划分式聚类算法、基于密度和网格的聚类算法和其他聚类算法,如图1 所示的4 个类别.3.聚类算法基于层次聚类算法:基于划分聚类算法(partition clustering)基于密度聚类算法:基于网格的聚类算法:STING :利用网格单元保存数据统计信息,从而实现多分辨率的聚类WaveCluster:在聚类分析中引入了小波变换的原理,主要应用于信号处理领域。

各种密度聚类算法

一,什么是聚类?聚类: - 将一个对象的集合分割成几个类,每个类内的对象之间是相似的,但与其他类的对象是不相似的。

评判聚类好坏的标准: 1 ,能够适用于大数据量。

2 ,能应付不同的数据类型。

3 ,能够发现不同类型的聚类。

4 ,使对专业知识的要求降到最低。

5 ,能应付脏数据。

6 ,对于数据不同的顺序不敏感。

7 ,能应付很多类型的数据。

8 ,模型可解释,可使用。

二,聚类所基于的数据类型。

聚类算法通常基于“数据矩阵”和“ Dissimilarity矩阵”。

怎么样计算不同对象之间的距离?1 ,数值连续的变量(体重,身高等):度量单位的选取对于聚类的结果的很重要的。

例如将身高的单位从米变为尺,将体重的单位从公斤变为磅将对聚类的结果产生很大的影响。

为了避免出现这种情况,我们必须将数据标准化:将数据中的单位“去掉”。

A, 计算绝对背离度。

B, 计算标准量度。

下面我们考虑怎样来计算两个对象之间的差异。

1 ,欧几里得距离。

2 ,曼哈顿距离。

这两种算法有共同之处: d(i,j)>=0,d(i,i)=0,d(i,j)=d(j,i),d(i,j)=<d(i,h)+d(h,j) 。

3 , Minkowski 距离。

这是上述两种算法的通式。

并且对于不同的变量,我们可以给它赋于不同的 weight.2 ,二元数据变量:如果还是用上面的方法来计算的话,肯定会出现错误。

这儿分两种情况,对称的与非对称的。

3 , Nominal 变量: ( 例如红,黄,绿,蓝….)4 , ordinal 变量(例如科长,处长,局长…. )5 , ratio-scaled 变量:6, 以上几种混合的变量(多数情况是这样的):三,分割的的方法。

1,K 均值算法:给定类的个数 K ,将 n 个对象分到 K 个类中去,使得类内对象之间的相似性最大,而类之间的相似性最小。

缺点:产生类的大小相差不会很大,对于脏数据很敏感。

改进的算法: k—medoids 方法。

数据挖掘中的聚类分析方法

数据挖掘中的聚类分析方法数据挖掘是一种通过智能计算和算法挖掘数据价值的技术。

而数据挖掘中的聚类分析方法则是其中的一个重要分支。

聚类分析是指将相似的数据组合在一起,不同的数据分开,形成不同的类别。

聚类分析在机器学习、数据分析、数据挖掘、图像处理等领域有广泛的应用。

本文将从聚类分析的定义、算法、分类等方面进行讲解。

一、聚类分析的定义聚类分析是一种无监督学习算法,它主要用于将样本根据各自的相似性分成若干类别。

聚类分析主要有两种方法:层次聚类和划分聚类。

层次聚类是一种自下而上的聚类方法,将每个样本视为一个初始聚类,然后将聚类依次合并,形成更大的聚类,直到所有样本都组成一个聚类。

层次聚类的结果是一个聚类树状结构,通过剪枝可以获得不同的聚类结果。

划分聚类是一种自上而下的聚类方法,将所有样本看作一个大的聚类,然后逐渐将其划分成更小的聚类,最终得到所需的聚类数目。

划分聚类主要有K均值聚类和高斯混合模型聚类二、聚类分析的算法(一) 层次聚类算法层次聚类常用的算法是自底向上的聚合算法和自顶向下的分裂算法。

自底向上的聚合算法是指先构造n个初始聚类,然后迭代合并最接近的两个聚类,直到达到某个停止条件。

这个停止条件可以是达到了所需的聚类数目,也可以是聚类之间距离的最大值。

自顶向下的分裂算法则是从所有样本开始,将其划分成两个聚类,然后逐步分裂聚类,得到所需的聚类数目。

(二) K均值聚类K均值聚类是一种划分聚类算法,它需要先指定K个聚类中心,然后根据距离来将样本点分配给不同的聚类中心。

然后将每个聚类内部的样本的均值作为该聚类的新中心,重新计算每个样本点和聚类中心的距离,直到聚类中心不再改变或达到一定的迭代次数。

K均值聚类的优势在于简单快速,具有很好的可扩展性和聚类效果。

但是这种算法需要预先确定聚类中心数,且对初始聚类中心的选择比较敏感。

(三) 高斯混合模型聚类高斯混合模型聚类是一种基于概率密度估计的算法,它假设每个聚类的密度函数是一个高斯分布。

复杂网络中聚类算法总结

复杂⽹络中聚类算法总结⽹络,数学上称为图,最早研究始于1736年欧拉的哥尼斯堡七桥问题,但是之后关于图的研究发展缓慢,直到1936年,才有了第⼀本关于图论研究的著作。

20世纪60年代,两位匈⽛利数学家Erdos和Renyi建⽴了随机图理论,被公认为是在数学上开创了复杂⽹络理论的系统性研究。

之后的40年⾥,⼈们⼀直讲随机图理论作为复杂⽹络研究的基本理论。

然⽽,绝⼤多数的实际⽹络并不是完全随机的。

1998年,Watts及其导师Strogatz在Nature上的⽂章《Collective Dynamics of Small-world Networks》揭⽰了复杂⽹络的⼩世界性质。

随后,1999年,Barabasi及其博⼠⽣Albert在Science上的⽂章《Emergence of Scaling in Random Networks》⼜揭⽰了复杂⽹络的⽆标度性质(度分布为幂律分布),从此开启了复杂⽹络研究的新纪元。

随着研究的深⼊,越来越多关于复杂⽹络的性质被发掘出来,其中很重要的⼀项研究是2002年Girvan和Newman在PNAS上的⼀篇⽂章《Community structure in social and biological networks》,指出复杂⽹络中普遍存在着聚类特性,每⼀个类称之为⼀个社团(community),并提出了⼀个发现这些社团的算法。

从此,热门对复杂⽹络中的社团发现问题进⾏了⼤量研究,产⽣了⼤量的算法,本⽂试图简单整理⼀下复杂⽹络中聚类算法,希望对希望快速了解这⼀部分的⼈有所帮助。

本⽂中所谓的社团跟通常我们将的聚类算法中类(cluster)的概念是⼀致的。

0. 预备知识为了本⽂的完整性,我们⾸先给出⼀些基本概念。

⼀个图通常表⽰为G=(V,E),其中V表⽰点集合,E表⽰边集合,通常我们⽤n表⽰图的节点数,m表⽰边数。

⼀个图中,与⼀个点的相关联的边的数量称为该点的度。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

各种聚类算法的比较

聚类的目标是使同一类对象的相似度尽可能地小;不同类对象之间的相似度尽可能地大。

目前聚类的方法很多,根据基本思想的不同,大致可以将聚类算法分为五大类:层次聚类算法、分割聚类算法、基于约束的聚类算法、机器学习中的聚类算法和用于高维度的聚类算法。

摘自数据挖掘中的聚类分析研究综述这篇论文。

1、层次聚类算法

1.1聚合聚类

1.1.1相似度依据距离不同:Single-Link:最近距离、Complete-Link:最远距离、Average-Link:平均距离

1.1.2最具代表性算法

1)CURE算法

特点:固定数目有代表性的点共同代表类

优点:识别形状复杂,大小不一的聚类,过滤孤立点

2)ROCK算法

特点:对CURE算法的改进

优点:同上,并适用于类别属性的数据

3)CHAMELEON算法

特点:利用了动态建模技术

1.2分解聚类

1.3优缺点

优点:适用于任意形状和任意属性的数据集;灵活控制不同层次的聚类粒度,强聚类能力

缺点:大大延长了算法的执行时间,不能回溯处理

2、分割聚类算法

2.1基于密度的聚类

2.1.1特点

将密度足够大的相邻区域连接,能有效处理异常数据,主要用于对空间数据的聚类

1)DBSCAN:不断生长足够高密度的区域

2)DENCLUE:根据数据点在属性空间中的密度进行聚类,密度和网格与处理的结合

3)OPTICS、DBCLASD、CURD:均针对数据在空间中呈现的不同密度分不对DBSCAN作了改进

2.2基于网格的聚类

2.2.1特点

利用属性空间的多维网格数据结构,将空间划分为有限数目的单元以构成网格结构;

1)优点:处理时间与数据对象的数目无关,与数据的输入顺序无关,可以处理任意类型的数据

2)缺点:处理时间与每维空间所划分的单元数相关,一定程度上降低了聚类的质量和准确性

2.2.2典型算法

1)STING:基于网格多分辨率,将空间划分为方形单元,对应不同分辨率2)STING+:改进STING,用于处理动态进化的空间数据

3)CLIQUE:结合网格和密度聚类的思想,能处理大规模高维度数据4)WaveCluster:以信号处理思想为基础

2.3基于图论的聚类

2.3.1特点

转换为组合优化问题,并利用图论和相关启发式算法来解决,构造数据集的最小生成数,再逐步删除最长边

1)优点:不需要进行相似度的计算

2.3.2两个主要的应用形式

1)基于超图的划分

2)基于光谱的图划分

2.4基于平方误差的迭代重分配聚类

2.4.1思想

逐步对聚类结果进行优化、不断将目标数据集向各个聚类中心进行重新分配以获最优解

1)概率聚类算法

期望最大化、能够处理异构数据、能够处理具有复杂结构的记录、能够连续处理成批的数据、具有在线处理能力、产生的聚类结果易于解释

2)最近邻聚类算法——共享最近邻算法SNN

特点:结合基于密度方法和ROCK思想,保留K最近邻简化相似矩阵和个数

不足:时间复杂度提高到了O(N^2)

3)K-Medioids算法

特点:用类中的某个点来代表该聚类

优点:能处理任意类型的属性;对异常数据不敏感

4)K-Means算法

1》特点:聚类中心用各类别中所有数据的平均值表示

2》原始K-Means算法的缺陷:结果好坏依赖于对初始聚类中心的选择、容易陷入局部最优解、对K值的选择没有准则可依循、对异常数据较为敏感、只能处理数值属性的数据、聚类结构可能不平衡

3》K-Means的变体

Bradley和Fayyad等:降低对中心的依赖,能适用于大规模数据集

Dhillon等:调整迭代过程中重新计算中心方法,提高性能

Zhang等:权值软分配调整迭代优化过程

Sarafis:将遗传算法应用于目标函数构建中

Berkh in等:应用扩展到了分布式聚类

还有:采用图论的划分思想,平衡聚类结果,将原始算法中的目标函数对应于一个各向同性的高斯混合模型

5)优缺点

优点:应用最为广泛;收敛速度快;能扩展以用于大规模的数据集

缺点:倾向于识别凸形分布、大小相近、密度相近的聚类;中心选择和噪声聚类对结果影响大

3、基于约束的聚类算法

3.1约束

对个体对象的约束、对聚类参数的约束;均来自相关领域的经验知识

3.2重要应用

对存在障碍数据的二维空间按数据进行聚类,如COD(Clustering with Obstructed Distance):用两点之间的障碍距离取代了一般的欧式距离

3.3不足

通常只能处理特定应用领域中的特定需求

4、用于高维数据的聚类算法

4.1困难来源因素

1)无关属性的出现使数据失去了聚类的趋势

2)区分界限变得模糊

4.2解决方法

1)对原始数据降维

2)子空间聚类

CACTUS:对原始空间在二维平面上的投影

CLIQUE:结合基于密度和网格的聚类思想,借鉴Apriori算法

3)联合聚类技术

特点:对数据点和属性同时进行聚类

文本:基于双向划分图及其最小分割的代数学方法

4.3不足:不可避免地带来了原始数据信息的损失和聚类准确性的降低

5、机器学习中的聚类算法

5.1两个方法

1)人工神经网络方法

自组织映射:向量化方法,递增逐一处理;映射至二维平面,实现可视化基于投影自适应谐振理论的人工神经网络聚类

2)基于进化理论的方法

缺陷:依赖于一些经验参数的选取,并具有较高的计算复杂度

模拟退火:微扰因子;遗传算法(选择、交叉、变异)

5.2优缺点

优点:利用相应的启发式算法获得较高质量的聚类结果

缺点:计算复杂度较高,结果依赖于对某些经验参数的选择。