模式识别实验报告

模式识别 实验报告一

402

132

识别正确率

73.36

84.87

99.71

70.31

82.89

86.84

结果分析:

实验中图像3的识别率最高,图像1和图像2的识别率次之。图像1和图像2的分辨率相对图像3更低,同时图像2有折痕影响而图像1则有大量噪声。通过阈值处理能较好的处理掉图像1的噪声和图像2的折痕,从而使得图像1的识别率有所提升,而图像2的识别率变化不大。从而可以得出结论,图像3和图像2识别率不同的原因主要在于图像分辨率,而图像2和图像1识别率的不同则在于噪声干扰。

实验报告

题目

模式识别系列实验——实验一字符识别实验

内容:

1.利用OCR软件对文字图像进行识别,了解图像处理与模式识别的关系。

2.利用OCR软件对文字图像进行识别,理解正确率的概念。

实验要求:

1.利用photoshop等软件对效果不佳的图像进行预处理,以提高OCR识别的正确率。

2.用OCR软件对未经预处理和经过预处理的简体和繁体中文字符图像进行识别并比较正确率。

图像4内容既有简体又有繁体,从识别结果中可了解到错误基本处在繁体字。

遇到的问题及解决方案:

实验中自动旋转几乎没效果,所以都是采用手动旋转;在对图像4进行识别时若采用系统自己的版面分析,则几乎识别不出什么,所以实验中使用手动画框将诗的内容和标题及作者分开识别。

主要实验方法:

1.使用汉王OCR软件对所给简体和繁体测试文件进行识别;

2.理,再次识别;

实验结果:

不经过图像预处理

经过图像预处理

实验图像

图像1

图像2

图像3

图像4

图像1

图像2

字符总数

458

《模式识别》实验报告 K-L变换 特征提取

基于K-L 变换的iris 数据分类一、实验原理K-L 变换是一种基于目标统计特性的最佳正交变换。

它具有一些优良的性质:即变换后产生的新的分量正交或者不相关;以部分新的分量表示原矢量均方误差最小;变换后的矢量更趋确定,能量更集中。

这一方法的目的是寻找任意统计分布的数据集合之主要分量的子集。

设n 维矢量12,,,Tn x x x ⎡⎤⎣⎦=x ,其均值矢量E ⎡⎤⎣⎦=μx ,协方差阵()T x E ⎡⎤⎣⎦=--C x u)(x u ,此协方差阵为对称正定阵,则经过正交分解克表示为x =T C U ΛU ,其中12,,,[]n diag λλλ=Λ,12,,,n u u u ⎡⎤⎣⎦=U 为对应特征值的特征向量组成的变换阵,且满足1T -=U U 。

变换阵T U 为旋转矩阵,再此变换阵下x 变换为()T -=x u y U ,在新的正交基空间中,相应的协方差阵12[,,,]x n diag λλλ==x UC U C 。

通过略去对应于若干较小特征值的特征向量来给y 降维然后进行处理。

通常情况下特征值幅度差别很大,忽略一些较小的值并不会引起大的误差。

对经过K-L 变换后的特征向量按最小错误率bayes 决策和BP 神经网络方法进行分类。

二、实验步骤(1)计算样本向量的均值E ⎡⎤⎣⎦=μx 和协方差阵()T x E ⎡⎤⎣⎦=--C x u)(x u 5.8433 3.0573 3.7580 1.1993⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦=μ,0.68570.0424 1.27430.51630.04240.189980.32970.12161.27430.3297 3.1163 1.29560.51630.1216 1.29560.5810x ⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦----=--C (2)计算协方差阵x C 的特征值和特征向量,则4.2282 , 0.24267 , 0.07821 , 0.023835[]diag =Λ-0.3614 -0.6566 0.5820 0.3155 0.0845 -0.7302 -0.5979 -0.3197 -0.8567 0.1734 -0.0762 -0.4798 -0.3583 0.0755 -0.5458 0.7537⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦=U 从上面的计算可以看到协方差阵特征值0.023835和0.07821相对于0.24267和4.2282很小,并经计算个特征值对误差影响所占比重分别为92.462%、5.3066%、1.7103%和0.52122%,因此可以去掉k=1~2个最小的特征值,得到新的变换阵12,,,new n k u u u -⎡⎤⎣⎦=U 。

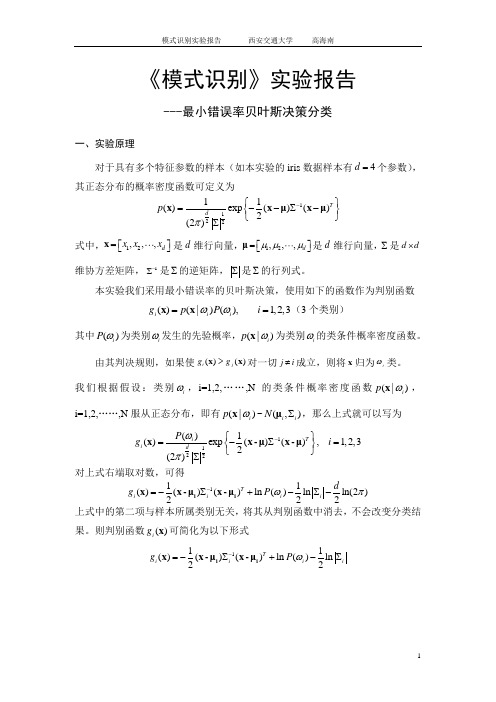

《模式识别》实验报告-贝叶斯分类

《模式识别》实验报告---最小错误率贝叶斯决策分类一、实验原理对于具有多个特征参数的样本(如本实验的iris 数据样本有4d =个参数),其正态分布的概率密度函数可定义为112211()exp ()()2(2)T d p π-⎧⎫=--∑-⎨⎬⎩⎭∑x x μx μ 式中,12,,,d x x x ⎡⎤⎣⎦=x 是d 维行向量,12,,,d μμμ⎡⎤⎣⎦=μ是d 维行向量,∑是d d ⨯维协方差矩阵,1-∑是∑的逆矩阵,∑是∑的行列式。

本实验我们采用最小错误率的贝叶斯决策,使用如下的函数作为判别函数()(|)(),1,2,3i i i g p P i ωω==x x (3个类别)其中()i P ω为类别i ω发生的先验概率,(|)i p ωx 为类别i ω的类条件概率密度函数。

由其判决规则,如果使()()i j g g >x x 对一切j i ≠成立,则将x 归为i ω类。

我们根据假设:类别i ω,i=1,2,……,N 的类条件概率密度函数(|)i p ωx ,i=1,2,……,N 服从正态分布,即有(|)i p ωx ~(,)i i N ∑μ,那么上式就可以写为1122()1()exp ()(),1,2,32(2)T i i dP g i ωπ-⎧⎫=-∑=⎨⎬⎩⎭∑x x -μx -μ对上式右端取对数,可得111()()()ln ()ln ln(2)222T i i i i dg P ωπ-=-∑+-∑-i i x x -μx -μ上式中的第二项与样本所属类别无关,将其从判别函数中消去,不会改变分类结果。

则判别函数()i g x 可简化为以下形式111()()()ln ()ln 22T i i i i g P ω-=-∑+-∑i i x x -μx -μ二、实验步骤(1)从Iris.txt 文件中读取估计参数用的样本,每一类样本抽出前40个,分别求其均值,公式如下11,2,3ii iii N ωωω∈==∑x μxclear% 原始数据导入iris = load('C:\MATLAB7\work\模式识别\iris.txt'); N=40;%每组取N=40个样本%求第一类样本均值 for i = 1:N for j = 1:4w1(i,j) = iris(i,j+1); end endsumx1 = sum(w1,1); for i=1:4meanx1(1,i)=sumx1(1,i)/N; end%求第二类样本均值 for i = 1:N for j = 1:4 w2(i,j) = iris(i+50,j+1);end endsumx2 = sum(w2,1); for i=1:4meanx2(1,i)=sumx2(1,i)/N; end%求第三类样本均值 for i = 1:N for j = 1:4w3(i,j) = iris(i+100,j+1); end endsumx3 = sum(w3,1); for i=1:4meanx3(1,i)=sumx3(1,i)/N; end(2)求每一类样本的协方差矩阵、逆矩阵1i -∑以及协方差矩阵的行列式i ∑, 协方差矩阵计算公式如下11()(),1,2,3,41i ii N i jklj j lk k l i x x j k N ωωσμμ==--=-∑其中lj x 代表i ω类的第l 个样本,第j 个特征值;ij ωμ代表i ω类的i N 个样品第j 个特征的平均值lk x 代表i ω类的第l 个样品,第k 个特征值;iw k μ代表i ω类的i N 个样品第k 个特征的平均值。

模式识别方PCA实验报告

模式识别作业《模式识别》大作业人脸识别方法一 ---- 基于PCA 和欧几里得距离判据的模板匹配分类器一、 理论知识1、主成分分析主成分分析是把多个特征映射为少数几个综合特征的一种统计分析方法。

在多特征的研究中,往往由于特征个数太多,且彼此之间存在着一定的相关性,因而使得所观测的数据在一定程度上有信息的重叠。

当特征较多时,在高维空间中研究样本的分布规律就更麻烦。

主成分分析采取一种降维的方法,找出几个综合因子来代表原来众多的特征,使这些综合因子尽可能地反映原来变量的信息,而且彼此之间互不相关,从而达到简化的目的。

主成分的表示相当于把原来的特征进行坐标变换(乘以一个变换矩阵),得到相关性较小(严格来说是零)的综合因子。

1.1 问题的提出一般来说,如果N 个样品中的每个样品有n 个特征12,,n x x x ,经过主成分分析,将它们综合成n 综合变量,即11111221221122221122n nn n n n n nn ny c x c x c x y c x c x c x y c x c x c x =+++⎧⎪=+++⎪⎨⎪⎪=+++⎩ij c 由下列原则决定:1、i y 和j y (i j ≠,i,j = 1,2,...n )相互独立;2、y 的排序原则是方差从大到小。

这样的综合指标因子分别是原变量的第1、第2、……、第n 个主分量,它们的方差依次递减。

1.2 主成分的导出我们观察上述方程组,用我们熟知的矩阵表示,设12n x x X x ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦是一个n 维随机向量,12n y y Y y ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦是满足上式的新变量所构成的向量。

于是我们可以写成Y=CX,C 是一个正交矩阵,满足CC ’=I 。

坐标旋转是指新坐标轴相互正交,仍构成一个直角坐标系。

变换后的N 个点在1y 轴上有最大方差,而在n y 轴上有最小方差。

同时,注意上面第一条原则,由此我们要求i y 轴和j y 轴的协方差为零,那么要求T YY =Λ12n λλλ⎡⎤⎢⎥⎢⎥Λ=⎢⎥⎢⎥⎣⎦令T R XX =,则T T RC C =Λ经过上面式子的变换,我们得到以下n 个方程111111212112111221122111121211()0()0()0n n n n n n nn n r c r c r c r c r c r c r c r c r c λλλ-+++=+-++=+++-=1.3 主成分分析的结果我们要求解出C ,即解出上述齐次方程的非零解,要求ij c 的系数行列式为0。

模式识别实习报告

实习报告一、实习背景及目的随着科技的飞速发展,模式识别技术在众多领域发挥着越来越重要的作用。

模式识别是指对数据进行分类、识别和解释的过程,其应用范围广泛,包括图像处理、语音识别、机器学习等。

为了更好地了解模式识别技术的原理及其在实际应用中的重要性,我参加了本次模式识别实习。

本次实习的主要目的是:1. 学习模式识别的基本原理和方法;2. 掌握模式识别技术在实际应用中的技巧;3. 提高自己的动手实践能力和团队协作能力。

二、实习内容及过程实习期间,我们团队共完成了四个模式识别项目,分别为:手写数字识别、图像分类、语音识别和机器学习。

下面我将分别介绍这四个项目的具体内容和过程。

1. 手写数字识别:手写数字识别是模式识别领域的一个经典项目。

我们使用了MNIST数据集,这是一个包含大量手写数字图片的数据集。

首先,我们对数据集进行预处理,包括归一化、数据清洗等。

然后,我们采用卷积神经网络(CNN)作为模型进行训练,并使用交叉验证法对模型进行评估。

最终,我们得到了一个识别准确率较高的模型。

2. 图像分类:图像分类是模式识别领域的另一个重要应用。

我们选择了CIFAR-10数据集,这是一个包含大量彩色图像的数据集。

与手写数字识别项目类似,我们先对数据集进行预处理,然后采用CNN进行训练。

在模型训练过程中,我们尝试了不同的优化算法和网络结构,以提高模型的性能。

最终,我们得到了一个识别准确率较高的模型。

3. 语音识别:语音识别是模式识别领域的又一项挑战。

我们使用了TIMIT数据集,这是一个包含大量语音样本的数据集。

首先,我们对语音样本进行预处理,包括特征提取、去噪等。

然后,我们采用循环神经网络(RNN)作为模型进行训练。

在模型训练过程中,我们尝试了不同的优化算法和网络结构。

最后,我们通过对模型进行评估,得到了一个较为可靠的语音识别系统。

4. 机器学习:机器学习是模式识别领域的基础。

我们使用了UCI数据集,这是一个包含多个数据集的数据集。

实验七基于神经网络的模式识别实验

实验七基于神经网络的模式识别实验

一、实验背景

模式识别是机器学习领域中的一项重要研究领域,它可以被应用于多个领域,包括计算机视觉,图像处理,智能交通,自然语言处理和生物信息学等。

模式识别的目的是从观察到的数据中检测,理解和预测结果。

其中,神经网络(应用模式识别)是人工智能的关键部分,它模拟人类的神经元的工作方式,并且可以被用来识别,分类,计算和获取模式。

二、实验目标

本次实验的目的是,探讨神经网络在模式识别中的应用,并使用一个基于神经网络的模式识别系统来识别模式。

三、实验内容

(一)数据预处理

在进行本次实验之前,需要进行数据预处理,以便能够更好地使用神经网络。

数据预处理的目的是通过将原始数据处理成神经网络可以处理的格式,以便更好地提取特征。

(二)神经网络模型设计

(三)神经网络模型训练

在训练神经网络模型时,首先需要准备一组被识别的模式。

模式识别实验

模式识别实验

一、实验任务

本次实验任务是模式识别,主要包括形式化的目标追踪、字符流分类和语音识别等。

二、所需软件

本实验所需软件包括MATLAB、Python等。

三、实验步骤

1. 首先需要安装MATLAB 和Python等软件,并建立实验环境。

2. 然后,通过MATLAB 进行基于向量量化(VQ) 的目标追踪实验,搭建端到端的系统,并使用Matlab编程实现实验内容。

3. 接着,使用Python进行字符流分类的实验,主要包括特征提取、建模和识别等,并使用Python编程实现实验内容。

4. 最后,使用MATLAB 进行语音识别的实验,主要是使用向量量化方法识别语音,并使用Matlab编程实现实验内容。

四、结果分析

1.在基于向量量化的目标追踪实验中,我们通过计算误差,确定了最优参数,最终获得了较高的准确率。

2.在字符流分类实验中,我们通过选择最佳分类器,得到了较高的准确率。

3.在语音识别实验中,我们使用向量量化方法,最终也获得了不错的准确率。

五、总结

本次实验研究了基于向量量化的目标追踪、字符流分类和语音识别等三项模式识别技术,经实验,探讨了不同方法之间的优劣,并获得了较高的准确率。

本次实验的结果为日常模式识别工作提供了有价值的参考。

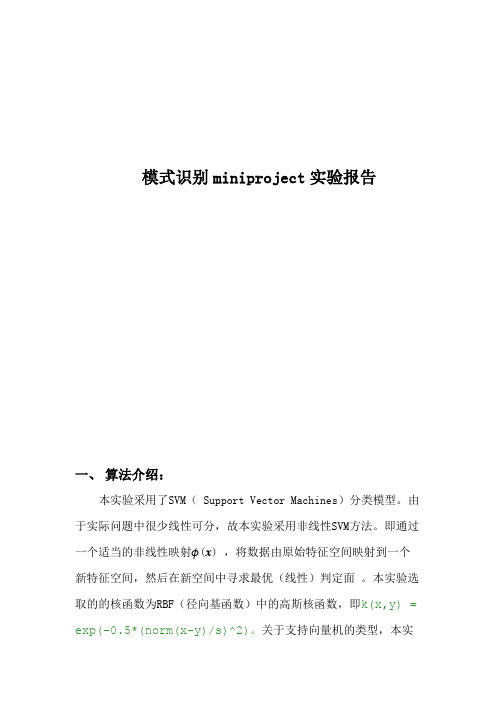

中科大模式识别miniproject实验报告

模式识别miniproject实验报告一、算法介绍:本实验采用了SVM( Support Vector Machines)分类模型。

由于实际问题中很少线性可分,故本实验采用非线性SVM方法。

即通过一个适当的非线性映射ϕ(x) ,将数据由原始特征空间映射到一个新特征空间,然后在新空间中寻求最优(线性)判定面。

本实验选取的的核函数为RBF(径向基函数)中的高斯核函数,即k(x,y) = exp(-0.5*(norm(x-y)/s)^2)。

关于支持向量机的类型,本实验选取为二类分类算法,即svc_c。

算法方面,由于同时求解n个拉格朗日乘子涉及很多次迭代,计算开销太大,所以实验采用Sequential Minimal Optimization(SMO)算法,即每次只更新两个乘子,迭代获得最终解。

计算时,首先根据预先设定的规则,从所有样本中选出两个拉格朗日因子,然后保持其他拉格朗日乘子不变,更新所选样本对应的拉格朗日乘子,循环N次直到满足要求。

二、实验1、评价标准本实验采用正确率来作为评价指标,即。

2、整体试验方法及步骤(1)定义核函数的类型及相关参数;(2)构建两类训练样本:(考虑到实验程序运行时间问题,本实验只选用了testdata的第200至1200项共1000个作为训练样本)(3)训练支持向量机;(4)寻找支持向量;(5)测试输出;(6)计算评价指标,即正确率3、分类器训练算法的参数调整步骤(1)随机生成多个参数向量(解)(2)在目标函数上验证解的质量(3)根据解的质量由好到坏进行排序。

取出其中较好的一部分(例如一半)解,在这些解的每一个元素上加上一个随机数,从而得到一些新解(4)把新解和老解比较,取出最好的一部分,作为下一次迭代的初始解4、实验结果经实验,得到测试输出,将其第十一列,即样本类别与testdata 中的第十三列相比,即可得到正确率。

本实验将以上结果取于EXECL 中进行统计,部分结果截图如下。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

样本集合的散布矩阵为:

散布矩阵的特征值和特征向量为:

1000个 三 维 高 斯 分 布 的 三 维 散 点 图

20 样本 第一特征向量 第二特征向量 第三特征向量

15

10

5 20 15 10 5 0 -10 -5 5 0 10

1.6

对集合 X 中的每一个向量 x 进行下面的变换,生成集合 Y

y DX (x mx )

9

0.4 1

生成 1000 个二维样本矢量的数据集合 X,并绘出该样本集合的二维散点图。

散布矩阵的特征值和特征

向量,在二维坐标中,以均值向量为中心,画出每一个特征向量方向的直线,特 征向量方向的直线叠加在二维散点图上。 样本集合的均值向量和散布矩阵为:

1

0.8

0.6

0.4

0.2

0

-0.2 -5

0

5

10

15

20

计算得到的分类器的训练误差:

2.7

实验结果分析

通过对比 fisher 线性判别方法找的最优方向与非最优方向的分类结果,前者 的效果不如后者。由于样本点的个数不能反映真实的误差情况,需要更多的样本 点来验证最优方向的分类效果要好于非最优方向。

-1.9 0.76 -2.1; 0.87 -1.0 -2.6]; w(:,:,2)=[-0.4 0.58 0.089; -0.31 0.27 -0.04; 0.38 0.055 -0.035; -0.15 0.53 -0.35 0.47 0.011; 0.034;

m x 为集合 X 的均值向量,Dx [e1 ,e2 ,e3 ] 为散布矩阵的特征向量,分别绘出

集合 X 和集合 Y 的三维散点图。

集 合 X和 集 合 Y的 三 维 散 点 图

20 15 10 5 0 -5 -10 20 10 0 -5 -10 -10 0 10 5

结论:可以从图中看出,集合 Y 是集合 X 经过平移旋转之后得到的,且其 与集合 X 正交。

从直线上来看,右图比较好,可以很好地将不同类别的样本点分离。 2.1 样本均值 如果 mi 为 d 维样本均值为

mi

那么,投影后的点的样本均值为

1 ni 1

xi

x

t

(7)

mi

1 ni

y

y w n

i

i x

x w t mi

(8)

i

2.2 类内散布矩阵 Si 和总类内散布矩阵 Sw

2.

Fisher 线性判别分析 %fisher 线性判别 w(:,:,1)=[0.42 -0.087 0.58;

-0.2 -3.3 -3.4; 1.3 -0.32 1.7; 0.39 0.71 0.23; -1.6 -5.3 -0.15; -0.029 0.89 -4.7; -0.23 1.9 0.27 -0.3 2.2; -0.87;

类数据看作满足一维高斯分布,求出其均值和方差。并且求出分类决策面(两个 一维高斯分布的交点处) 。 类别 w2 在最优方向 w 投影后数据的均值和方差为:

类别 w3 在最优方向 w 投影后数据的均值和方差为:

最优方向及样本点投影后在直线上的位置

4 3 2 1 0 -1 2 1 0 -1 -1 -2 0 2 1 第 2类 样 本 点 第 3类 样 本 点 最优方向

散布矩阵的特征值和特征向量为:

1000个 二 维 高 斯 分 布 的 二 维 散 点 图 12 样本 第一特征向量 第二特征向量

10

8

6

4

2

0

-2 -6

-4

-2

0

2

4

6

8

10

12

14

1.3

对集合 X 中的每一个向量 x 进行下面的变换,生成集合 Y

y DX (x mx )

m x 为集合 X 的均值向量, Dx [e1 , e2 ] 为散布矩阵的特征向量,分别绘出集

2.

Fisher 线性判别分析

2.1

编写用 Fisher 线性判别方法,对三维数据求最优方向 w 的通用程序。 求最优方向的函数为:fisher()函数 对表格中的类别 w2 和 w3 ,计算最优方向 w 。 类别 w2 和 w3 的最优方向 w 为:

2.2

2.3 2.4

画出表示最优方向 w 的直线,并且标记出投影后的点在直线上的位置。 在这个子空间中,对每种分布用一维高斯函数拟合,即把投影后的每一

2.6

使用非最优方向 w (1.0, 2.0, 1.5)t 重复实验 2.4、2.5 两个步骤,计算在 类别 w2 在最优方向 w 投影后数据的均值和方差为:

这个非最优子空间中的训练误差。

类别 w3 在最优方向 w 投影后数据的均值和方差为:

两类样本投影后的一维高斯分布 1.2 第 2类 投 影 一 维 高 斯 第 3类 投 影 一 维 高 斯 决策面 第 2类 正 确 分 类 第 3类 正 确 分 类

使得类与类之间尽可能分开。 有一组 n 个 d 维的样本 x1 , x 2 , 它们分属于两个不同的类别, 即其中的 , xn , 大小为 n1 的样本属于 1 ,大小为 n2 的样本属于 2 。如果对 x 中的各个成分作线 性组合,就得到点积,结果是一个标量

y wt x

(6)

当 x 是二维的,我们就是要找一条直线(方向为 w)来做投影,然后寻找最 能使样本点分离的直线。如下图:

x m ae a k et (x k m)

(3)

3.1 散布矩阵

S (x k m)(x k m)t

k 1 n

(4)

4.1 直线 e 的最优方向 散布矩阵最大的本征值对应的那个本征向量作为投影直线 e 的方向:

Se e

(5)

2.

Fisher 线性判别分析

Fisher 线性判别是将 n 类 m 维数据尽可能地投影到一个方向(一条直线) ,

, x n ,用一个 d 维的向量 x 0 代表 n 个样本,平方误差准

n 2

J 0 (x 0 ) x 0 x k

k 1

(1)

J 0 (x 0 ) 最小化的那个 d 维的向量 x 0 m ,其中 m 是样本均值:

m 1 n xk n k 1

(2)

2.1 样本投影的直线 通过把全部样本向通过样本均值的一条直线作投影, 我们能够得到代表全部 样本的一个一维向量, e 表示通过样本均值的直线上的单位向量,那么,这条直 线的方程可以表示为:

两类样本投影后的一维高斯分布 4 3.5 3 2.5 2 1.5 1 0.5 0 -0.5 -1 第 2类 投 影 一 维 高 斯 第 3类 投 影 一 维 高 斯 决策面 第 2类 正 确 分 类 第 3类 正 确 分 类

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

1

2.5

计算得到的分类器的训练误差。

深圳大学研究生课程:模式识别理论与方法

课程作业实验报告

实验名称 : PCA 主分量分析与 Fisher 线性判别分析 实验编号:Proj03-02 签 姓 学 名: 名: 罗升 号: 2140130418

截止提交日期:2015 年 4 月 20 日

摘要: PCA 主分量分析是把多个特征映射为少数几个综合特征的一种统计分析方法, 其是寻找在最小均方意义下最能够代表原始数据的投影方法。Fisher 线性判别是将 n 类 m 维数据尽可能地投影到一个方向(一条直线),使得类与类之间尽可能分开。 由 PCA 主分量分析实验可以得出, PCA 分析可以对数据集合在特征空间进行平移和 旋转。由 Fisher 线性判别分析实验可以得出,Fisher 线性判别方法可以实现高维数据 在一维中分类,然而通过对比 Fisher 线性判别方法找的最优方向与非最优方向的分类 结果,前者的分类效果不如后者。

附录

1.

PCA 主分量分析

%生成 1000 个二维样本矢量数据集合 mu1=[5 7]; sigma1=[9 0.4;0.4 1]; X1=mvnrnd(mu1,sigma1,1000); plot(X1(:,1),X1(:,2),'.'); title('1000 个二维高斯分布的二维散点图'); grid on; hold on; %计算样本集合的均值向量和散布矩阵,计算散布矩阵的 %特征值和特征向量,并画出每一个特征向量方向的直线 [mu,S,V ,D]=PCA(X1); %生成 1000 个三维样本矢量数据集合 mu2=[4 5 9]; sigma2=[4 0.2 0;0.2 2 0;0 0 0.5]; X2=mvnrnd(mu2,sigma2,1000); scatter3(X2(:,1),X2(:,2),X2(:,3),'.'); title('1000 个三维高斯分布的三维散点图'); grid on; hold on; %计算样本集合的均值向量和散布矩阵,计算散布矩阵的 %特征值和特征向量,并画出每一个特征向量方向的直线 [mu,S,V ,D]=PCA(X2); %计算样本集合的均值向量和散布矩阵,计算散布矩阵的 %特征值和特征向量,并画出每一个特征向量方向的直线 function [mu,S,V ,D] = PCA(X) %r,N 分别为样本集合,样本点数 %mu 为均值向量,S 为散布矩阵,V ,D 为散布矩阵的特征向量和特征值

Si

x

(x m )(x m )

i i

i

t

(9) (10)

Sw S1 S2

2.3 投影后的最佳方向

w Sw1 (m1 m2 )

(11)

二、 实验方法

1.

PCA 主分量分析