错误概率和译码规则

信息论总结与复习

(3)稳态符号概率: (4)稳态信息熵:

结论:N阶马氏信源稳态信息熵(即极限熵)等于N+1阶条件熵。

第一部分、信息论基础

1.1 信源的信息理论

[例1] 已知二阶马尔可夫信源的条件概率:

p(0|00)=p(1|11)=0.8;p(0|01)=p(1|10)=0.6;

(2)联合熵:

H(XY)= -0.21log0.21 –0.14log0.14 –0.35log0.35 –0.12log0.12 –0.09log0.09–0.09log0.09 =2.3924 bit/符号

第一部分、信息论基础

1.2 信道的信息理论

(3)噪声熵:

由 和

H(Y | X)= – 0.21log0.3 –0.14log0.2 –0.35log0.5

(4)无噪有损信道:分组多对一(归并),其传输矩阵应具 有多行一列的分块对角化形式。

(5)对称信道:传输矩阵的各行都是一些相同元素的重排, 各列也是一些相同元素的重排。

第一部分、信息论基础

1.2 信道的信息理论

3、信道有关的信息熵:

(1)信源熵 (先验熵):

(2)噪声熵 (散布度):

(3)联合熵: (4)接收符号熵:

–0.12log0.4 –0.09log0.3–0.09log0.3

==(0.21+0.12,0.14+0.09,0.35+0.09) = (0.33, 0.23, 0.44)

H(Y)= -0.33log0.33 -0.23log0.23 -0.44log0.44

[例3]求对称信道 解:C =log4-H(0.2,0.3,0.2,0.3) =2+(0.2log0.2+0.3log0.3)×2 = 0.03 bit/符号; 的信道容量。

错误概率、译码规则和有噪信道编码定理

通信过程的可靠性可以用传输的错误概率来衡量。

错误概率(误码率):接收端收到错误码字的概率。

常用平均译码错误概率表示。

∑=j j j e y e p y p P )|()(译码规则: 设计一个函数F(y j ),该函数对于每一个输出符号y j 确定一个唯一的输入符号x j *与其对应,即:},,,{;,,2,1,)(21r j j j x x x x s j x y F ∈==**∑∑*-==j j j j j j j e y x p y p y e p y p P )]|(1)[()|()(平均错误概率为:最大后验概率译码准则(最佳译码准则):把每个输出符号译成具有最大后验概率的那个输入符号,使得信道的平均错误概率最小。

即选择译码函数,)(*=j j x y F **≠≥ji j i j j x x y x p y x p ),|()|(使得最大似然译码准则:已知信道的前向传递概率的情况下,把每个输出符号译成具有最大前向传递概率的那个输入符号。

即选择译码函数,)(*=j j x y F **≠≥j i i j j j x x x y p x y p ),|()|(使得∑∑∑∑∑--*==-==Y x X i j i Y x X ji YjY X j i Yj j e x y p x p y x p y x p y x p y e p y p P *,*,,)|()()()()()|()(平均错误概率为:问题:如何降低错误概率?l改变译码规则;l改变输入符号的概率分布,也就是进行信道编码。

然而,信道编码降低了传输的错误概率,代价是信息传输率的降低。

给定信道容量为C的离散无记忆信道[X, P(y|x), Y],其中P(y|x)为信道传递概率。

当信息传输率R<C时,只要码长n足够长,总可以在输入X n符号集中找到M(=2nR)个码字组成的一组码(2nR, n)和相应的译码规则,使译码的平均错误概率任意小(P E→0)。

《信息论与编码技术》复习提纲复习题

《信息论与编码技术》复习提纲复习题纲第0章绪论题纲:I.什么是信息?II.什么是信息论?III.什么是信息的通信模型?IV.什么是信息的测度?V.自信息量的定义、含义、性质需掌握的问题:1.信息的定义是什么?(广义信息、狭义信息——Shannon信息、概率信息)2.Shannon信息论中信息的三要素是什么?3.通信系统模型图是什么?每一部分的作用的是什么?4.什么是信息测度?5.什么是样本空间、概率空间、先验概率、自信息、后验概率、互信息?6.自信息的大小如何计算?单位是什么?含义是什么(是对什么量的度量)?第1章信息论基础㈠《离散信源》题纲:I.信源的定义、分类II.离散信源的数学模型III.熵的定义、含义、性质,联合熵、条件熵IV.离散无记忆信源的特性、熵V.离散有记忆信源的熵、平均符号熵、极限熵VI.马尔科夫信源的定义、状态转移图VII.信源的相对信息率和冗余度需掌握的问题:1.信源的定义、分类是什么?2.离散信源的数学模型是什么?3.信息熵的表达式是什么?信息熵的单位是什么?信息熵的含义是什么?信息熵的性质是什么?4.单符号离散信源最大熵是多少?信源概率如何分布时能达到?5.信源的码率和信息率是什么,如何计算?6.什么是离散无记忆信源?什么是离散有记忆信源?7.离散无记忆信源的数学模型如何描述?信息熵、平均符号熵如何计算?8.离散有记忆多符号离散平稳信源的平均符号熵、极限熵、条件熵(N阶熵)的计算、关系和性质是什么?9.什么是马尔科夫信源?马尔科夫信源的数学模型是什么?马尔科夫信源满足的2个条件是什么?10.马尔科夫信源的状态、状态转移是什么?如何绘制马尔科夫信源状态转移图?11.马尔科夫信源的稳态概率、稳态符号概率、稳态信息熵如何计算?12.信源的相对信息率和冗余度是什么?如何计算?㈡《离散信道》题纲:I.信道的数学模型及分类II.典型离散信道的数学模型III.先验熵和后验熵IV.互信息的定义、性质V.平均互信息的定义、含义、性质、维拉图VI.信道容量的定义VII.特殊离散信道的信道容量需掌握的问题:1.信道的定义是什么?信道如何分类?信道的数学模型是什么?2.二元对称信道和二元删除信道的信道传输概率矩阵是什么?3.对称信道的信道传输概率矩阵有什么特点?4.根据信道的转移特性图,写出信道传输概率矩阵。

错误概率与译码规则

例:

0.5 0.3 0.2 P 0.2 0.3 0.5

0.3 0.3 0.4

根据最大似然准则可选择译码函数为B:

F (b1) a1

F

(b2

)

a3

F (b3 ) a2

1

1

PE

3 Y , X a*

P(b / a)

[(0.2 0.3) (0.3 0.3) (0.2 0.4)] 3

0.567

Y

Y , X a*

1 错误概率与译码规则

或者写成:

PE

P(bj / ai )P(ai )

Y , X a*

上式也可写成对行求和:

PE P(ai ) P(bj / ai )

X

Y

F (bj ) a

P(ai )Pe(i)

X

如果先验概率相等,则:

PE

1 r

X

P(i) e

1 错误概率与译码规则

P(a* / bj ) P(ai / bj ) ai a*

F(bj ) a*

也就是说,收到一个符号以后译成具有最大后验概率的那个输入符号。

这种译码准则称为“最大后验概率准则”或“最小错误概率准则”。

根据贝叶斯定律,上式也可以写成

P(bj / a*)P(a*) P(bj / ai )P(ai )

所得译码函数为C: 平均错误概率为:

F (b1) a3

F

(b2

)

a3

F (b3 ) a3

P''' E

P(aibj ) (0.125 0.05) (0.075 0.075) (0.05 0.125) 0.5

Y , X a*

可进一步写出平均错误概率:

数据通信中的误码率与纠错编码技术

数据通信中的误码率与纠错编码技术引言:- 说明数据通信中的误码率问题的重要性- 引出纠错编码技术的作用一、误码率的定义和影响因素:- 解释误码率的定义:指在数据传输过程中接收端出现错误比特的概率- 列举影响误码率的主要因素:信道噪声、传输距离、传输速率等二、误码率与纠错编码技术的关系:- 解释纠错编码技术的基本原理:通过在发送端引入冗余信息,接收端可以恢复原始数据- 强调纠错编码技术对误码率降低的作用三、常见的纠错编码技术:1. 奇偶校验码:- 解释奇偶校验码的基本原理:通过在数据最后添加一位校验位,使得数据中的1的个数为偶数或奇数- 介绍奇偶校验码的局限性:只能发现奇数位错误,无法进行纠错2. 海明码:- 解释海明码的基本原理:通过在数据中插入冗余位,并使用校验矩阵进行校验和纠错- 说明海明码的纠错能力:可以检测和纠正多位错误3. 重复编码:- 解释重复编码的基本原理:将每一位数据复制多次进行传输,接收端选择出现次数最多的数据位作为原始数据- 讨论重复编码的效率和纠错能力:虽然效率低下,但对于一定数量的错误能够进行纠正4. BCH码:- 说明BCH码的基本原理:通过多项式运算进行编码和解码,具有高纠错能力- 强调BCH码在数字通信和存储领域的广泛应用四、纠错编码技术的局限性和发展方向:- 提醒纠错编码技术并非完美,仍存在一定的误码率- 提出提高纠错编码技术性能的发展方向:新型编码算法、异构纠错编码等结论:- 总结数据通信中误码率与纠错编码技术的关系和作用- 强调纠错编码技术在实际应用中的重要性- 展望纠错编码技术的未来发展前景及其对数据通信的重要意义注:此为简化版本的范文提纲,实际写作过程中可根据需要适量扩充和调整。

信息理论与编码课后答案第5章

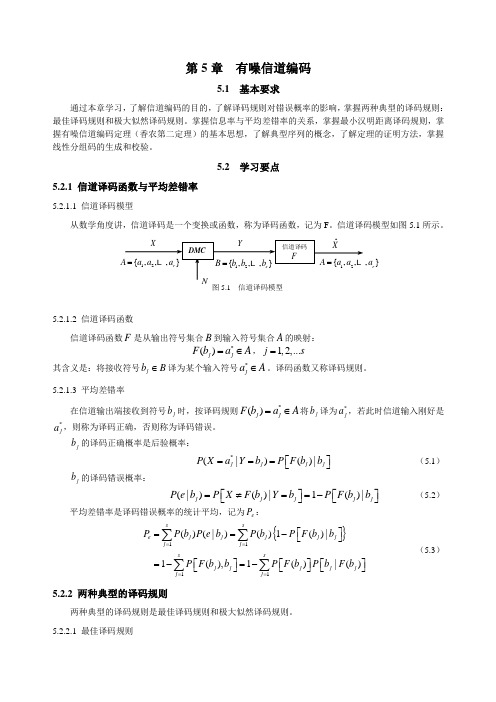

第5章 有噪信道编码5.1 基本要求通过本章学习,了解信道编码的目的,了解译码规则对错误概率的影响,掌握两种典型的译码规则:最佳译码规则和极大似然译码规则。

掌握信息率与平均差错率的关系,掌握最小汉明距离译码规则,掌握有噪信道编码定理(香农第二定理)的基本思想,了解典型序列的概念,了解定理的证明方法,掌握线性分组码的生成和校验。

5.2 学习要点5.2.1 信道译码函数与平均差错率5.2.1.1 信道译码模型从数学角度讲,信道译码是一个变换或函数,称为译码函数,记为F 。

信道译码模型如图5.1所示。

5.2.1.2 信道译码函数信道译码函数F 是从输出符号集合B 到输入符号集合A 的映射:*()j j F b a A =∈,1,2,...j s =其含义是:将接收符号j b B ∈译为某个输入符号*j a A ∈。

译码函数又称译码规则。

5.2.1.3 平均差错率在信道输出端接收到符号j b 时,按译码规则*()j j F b a A =∈将j b 译为*j a ,若此时信道输入刚好是*j a ,则称为译码正确,否则称为译码错误。

j b 的译码正确概率是后验概率:*(|)()|j j j j P X a Y b P F b b ⎡⎤===⎣⎦ (5.1)j b 的译码错误概率:(|)()|1()|j j j j j P e b P X F b Y b P F b b ⎡⎤⎡⎤=≠==-⎣⎦⎣⎦ (5.2)平均差错率是译码错误概率的统计平均,记为e P :{}1111()(|)()1()|1(),1()|()s se j j j j j j j ssj j j j j j j P P b P e b P b P F b b P F b b P F b P b F b ====⎡⎤==-⎣⎦⎡⎤⎡⎤⎡⎤=-=-⎣⎦⎣⎦⎣⎦∑∑∑∑ (5.3)5.2.2 两种典型的译码规则两种典型的译码规则是最佳译码规则和极大似然译码规则。

《信息论与编码理论》(王育民李晖梁传甲)课后习题问题详解高等教育出版社

信息论与编码理论习题解第二章-信息量和熵2.1解: 平均每个符号长为:1544.0312.032=⨯+⨯秒 每个符号的熵为9183.03log 3123log 32=⨯+⨯比特/符号所以信息速率为444.34159183.0=⨯比特/秒2.2 解: 同步信号均相同不含信息,其余认为等概,每个码字的信息量为 3*2=6 比特; 所以信息速率为600010006=⨯比特/秒2.3 解:(a)一对骰子总点数为7的概率是366 所以得到的信息量为 585.2)366(log 2= 比特 (b) 一对骰子总点数为12的概率是361 所以得到的信息量为 17.5361log 2= 比特 2.4 解: (a)任一特定排列的概率为!521,所以给出的信息量为 58.225!521log 2=- 比特 (b) 从中任取13张牌,所给出的点数都不相同的概率为13521313521344!13C A =⨯所以得到的信息量为 21.134log 1313522=C 比特.2.5 解:易证每次出现i 点的概率为21i,所以比特比特比特比特比特比特比特398.221log 21)(807.1)6(070.2)5(392.2)4(807.2)3(392.3)2(392.4)1(6,5,4,3,2,1,21log )(2612=-==============-==∑=i i X H x I x I x I x I x I x I i ii x I i2.6 解: 可能有的排列总数为27720!5!4!3!12= 没有两棵梧桐树相邻的排列数可如下图求得, Y X Y X Y X Y X Y X Y X Y X Y图中X 表示白杨或白桦,它有⎪⎪⎭⎫⎝⎛37种排法,Y 表示梧桐树可以栽种的位置,它有⎪⎪⎭⎫⎝⎛58种排法,所以共有⎪⎪⎭⎫ ⎝⎛58*⎪⎪⎭⎫⎝⎛37=1960种排法保证没有两棵梧桐树相邻,因此若告诉你没有两棵梧桐树相邻时,得到关于树排列的信息为1960log 27720log 22-=3.822 比特 2.7 解: X=0表示未录取,X=1表示录取; Y=0表示本市,Y=1表示外地;Z=0表示学过英语,Z=1表示未学过英语,由此得比特比特比特)01(log )01()0()00(log )00()0()(8113.04log 4134log 43)()(02698.04110435log 104354310469log 10469)1()01(log )01()0()00(log )00()0;(104352513/41)522121()0(/)1())11()1,10()10()1,00(()01(104692513/43)104109101()0(/)0())01()0,10()00()0,00(()00()(4512.04185log 854383log 83)1()01(log )01()0()00(log )00()0;(8551/4121)0(/)1()10()01(8351/43101)0(/)0()00()00()(,251225131)1(,2513100405451)10()1()00()0()0(,54511)1(,51101432141)10()1()00()0()0(,41)1(,43)0(222222222222+=====+=======+==+======+========⨯⨯+========+=========⨯⨯+========+=========+======+========⨯=========⨯=========-===⨯+====+======-===⨯+⨯====+=========x y p x y p x p x y p x y p x p X Y H X H c x p z x p z x p x p z x p z x p z X I z p x p x y p x y z p x y p x y z p z x p z p x p x y p x y z p x y p x y z p z x p b x p y x p y x p x p y x p y x p y X I y p x p x y p y x p y p x p x y p y x p a z p y z p y p y z p y p z p y p x y p x p x y p x p y p x p x p2.8 解:令{}{}R F T Y B A X ,,,,==,则比特得令同理03645.0)()(5.0,02.03.0)2.05.0(log 2.0)()2.05.0(log )2.05.0()2.03.0(log )2.03.0(5.0log 5.03.0log 3.0)5log )1(2.02log )1(5.0log )1(3.05log 2.0log 3.02log 5.0(2.0log 2.0)2.05.0(log )2.05.0()2.03.0(log )2.03.0()()();()(2.0)(,2.05.0)(2.03.0)1(3.05.0)()()()()(5.0max 2'2222223102231022222==∴==+-=---++-+=-+-+-+++-----++-=-===-=+=-⨯+=+==p p I p I p pp p I p p p p p p p p p p p p p p X Y H Y H Y X I p I R P p F P pp p B P B T P A P A T P T P2.9 & 2.12解:令X=X 1,Y=X 1+X 2,Z=X 1+X 2+X 3, H(X 1)=H(X 2)=H(X 3)= 6log 2 比特 H(X)= H(X 1) = 6log 2 =2.585比特 H(Y)= H(X 2+X 3)=6log 61)536log 365436log 364336log 363236log 36236log 361(2222222+++++ = 3.2744比特 H(Z)= H(X 1+X 2+X 3)=)27216log 2162725216log 2162521216log 2162115216log 2161510216log 216106216log 21663216log 2163216log 2161(222222222++++++= 3.5993比特 所以H(Z/Y)= H(X 3)= 2.585 比特 H(Z/X) = H(X 2+X 3)= 3.2744比特 H(X/Y)=H(X)-H(Y)+H(Y/X) = 2.585-3.2744+2.585 =1.8955比特H(Z/XY)=H(Z/Y)= 2.585比特 H(XZ/Y)=H(X/Y)+H(Z/XY) =1.8955+2.585 =4.4805比特 I(Y;Z)=H(Z)-H(Z/Y) =H(Z)- H(X 3)= 3.5993-2.585 =1.0143比特 I(X;Z)=H(Z)-H(Z/X)=3.5993- 3.2744 =0.3249比特 I(XY ;Z)=H(Z)-H(Z/XY) =H(Z)-H(Z/Y)=1.0143比特 I(Y;Z/X)=H(Z/X)-H(Z/XY) = H(X 2+X 3)-H(X 3) =3.2744-2.585 =0.6894比特 I(X;Z/Y)=H(Z/Y)-H(Z/XY) =H(Z/Y)-H(Z/Y) =02.10 解:设系统输出10个数字X 等概,接收数字为Y,显然101)(101)()()(919===∑∑==i j p i j p i Q j w i iH(Y)=log10比特奇奇奇奇偶18log 81101452log 211015)(log)()()(log )()(0)(log ),()(log ),()(22,2222=⨯⨯⨯⨯+⨯⨯⨯=--=--=∑∑∑∑∑∑∑≠====x y p x y p x p x x p x x p x p x y p y x p x y p y x p X Y H x y x i y x y x所以I(X;Y)= 3219.2110log 2=-比特2.11 解:(a )接收前一个数字为0的概率 2180)0()()0(==∑=i i i u p u q wbits p pw u p u I )1(log 11log )0()0(log )0;(2212121-+=-==(b )同理 418)00()()00(==∑=ii iu p u q wbits p p w u p u I )1(log 22)1(log )00()00(log )00;(24122121-+=-== (c )同理 818)000()()000(==∑=ii iu p u q wbits p p w u p u I )1(log 33)1(log )000()000(log )000;(28132121-+=-== (d )同理 ))1(6)1(()0000()()0000(4226818p p p p u p u q w ii i+-+-==∑=bitsp p p p p p p p p p w u p u I 42264242268142121)1(6)1()1(8log ))1(6)1(()1(log )0000()0000(log )0000;(+-+--=+-+--==2.12 解:见2.9 2.13 解: (b))/()/()/(1log)()/(1log)()/()/(1log)()/(1log)()/(XY Z H X Y H xy z p xyz p x y p xyz p xy z p x y p xyz p x yz p xyz p X YZ H x y z xyzxyzxyz+=+===∑∑∑∑∑∑∑∑∑∑∑∑(c))/()/(1log)/()()/(1log)/()()/(X Z H x z p xy z p xy p xy z p xy z p xy p XY Z H xyzxyz=≤=∑∑∑∑∑∑(由第二基本不等式) 或)1)/()/((log )/()()/()/(log)/()()/(1log)/()()/(1log)/()()/()/(=-⨯≤=-=-∑∑∑∑∑∑∑∑∑∑∑∑xy z p x z p e xy z p xy p xy z p x z p xy z p xy p x z p xy z p xy p xy z p xy z p xy p X Z H XY Z H xyzxyzxyzxyz(由第一基本不等式)所以)/()/(X Z H XY Z H ≤(a))/()/()/()/()/(X YZ H XY Z H X Y H X Z H X Y H =+≥+等号成立的条件为)/()/(x z p xy z p =,对所有Z z Y y X x ∈∈∈,,,即在给定X 条件下Y 与Z 相互独立。

信息论与编码期末考试题(全套)

(一)一、判断题共 10 小题,满分 20 分。

1。

当随机变量X 和Y 相互独立时,条件熵)|(Y X H 等于信源熵)(X H . ( )2。

由于构成同一空间的基底不是唯一的,所以不同的基底或生成矩阵有可能生成同一码集。

( )3。

一般情况下,用变长编码得到的平均码长比定长编码大得多. ( ) 4. 只要信息传输率大于信道容量,总存在一种信道编译码,可以以所要求的任意小的误差概率实现可靠的通信.( )5。

各码字的长度符合克拉夫特不等式,是唯一可译码存在的充分和必要条件。

()6. 连续信源和离散信源的熵都具有非负性. ( )7. 信源的消息通过信道传输后的误差或失真越大,信宿收到消息后对信源存在的不确定性就越小,获得的信息量就越小。

8。

汉明码是一种线性分组码。

( ) 9。

率失真函数的最小值是0。

( )10.必然事件和不可能事件的自信息量都是0。

( )二、填空题共 6 小题,满分 20 分.1、码的检、纠错能力取决于.2、信源编码的目的是;信道编码的目的是。

3、把信息组原封不动地搬到码字前k 位的),(k n 码就叫做 。

4、香农信息论中的三大极限定理是、、。

5、设信道的输入与输出随机序列分别为X 和Y ,则),(),(Y X NI Y X I N N =成立的条件 。

6、对于香农-费诺编码、原始香农—费诺编码和哈夫曼编码,编码方法惟一的是。

7、某二元信源01()1/21/2X P X ⎡⎤⎧⎫=⎨⎬⎢⎥⎣⎦⎩⎭,其失真矩阵00a D a ⎡⎤=⎢⎥⎣⎦,则该信源的max D = 。

三、本题共 4 小题,满分 50分.1、某信源发送端有2种符号i x )2,1(=i ,a x p =)(1;接收端有3种符号i y )3,2,1(=j ,转移概率矩阵为1/21/201/21/41/4P ⎡⎤=⎢⎥⎣⎦. (1) 计算接收端的平均不确定度()H Y ; (2) 计算由于噪声产生的不确定度(|)H Y X ; (3) 计算信道容量以及最佳入口分布。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

F (b2 ) a2 F (b3 ) a3

F (b2 ) a3 F (b3 ) a2

电子信息工程学院

信息论

1 错误概率与译码规则

译码规则的选择应该有一个依据,一个自然的依据就 是使平均错误概率最小。 有了译码规则以后,收到 bj 的情况下,译码的条件正 确概率为: P(F (bj ) / bj ) P(ai / bj )

电子信息工程学院

信息论

1 错误概率与译码规则

若采用前边讲到的译码函数A,则平均错误率为:

PE' 1 1 P(b / a) [(0.3 0.2) (0.3 0.3) (0.2 0.5)] 0.6 3 Y , X a* 3

若输入不等概分布,其概率分布为:

1 1 1 P(a1 ) , P(a2 ) , P(a3 ) 4 4 2

Y

Y

Y

X ,Y

Y

p(aib j ) P[a*b j ]

X ,Y Y

Y , X a

P(ai b j )

*

电子信息工程学院

信息论

1 错误概率与译码规则

或者写成:

PE

Y , X a

P(b j / ai ) P(ai )

*

上式也可写成对行求和: P P(a )P(b / a )

PE''

1 1 1 1 P(b / a) (0.3 0.2) (0.3 0.3) (0.2 0.5) 0.6 3 Y , X a* 4 4 2

电子信息工程学院

信息论

1 错误概率与译码规则

若采用最小错误概率译码准则,则联合概率矩阵为:

0.125 0.075 0.05 P(ai b j ) 0.05 0.075 0.125 0.2 0.15 0.15

电子信息工程学院

信息论

1 错误概率与译码规则

而错误译码的概率为收到 bj 后,推测发出除了 ai 之 外其它符号的概率: P(e / bj ) 1 P(ai / bj )

可以得到平均错误译码概率为: m s P e p (b j ) P(e / b j ) p (b j )(1 P( ai / b j )) j 1 j 1 它表示经过译码后平均收到一个符号所产生错误的大小, 也称平均错误概率。

* * j i j i

* j

P(b j / a* ) P(a* ) P(b j )

P(b j / ai ) P(ai ) P(b j )

电子信息工程学院

信息论

1 错误概率与译码规则

即: 当信源等概分布时,上式为:

P(bj / a* ) P(a* ) P(bj / ai ) P(ai ) P(bj / a* ) P(bj / ai )

E i j i X Y

F (b j ) a

P(ai )Pe(i )X如果先验概率相等,则:

PE

1 Pe(i ) r X

电子信息工程学院

信息论

1 错误概率与译码规则

例:

0.5 0.3 0.2 P 0.2 0.3 0.5 0.3 0.3 0.4

信息论

1 错误概率与译码规则

我们来定义译码准则:输入符号集: A {ai }

输出符号集: 译码规则:

F (bj ) ai

例:

0.5 0.3 0.2 P 0.2 0.3 0.5 0.3 0.3 0.4

设计译码准则:A:

和B:

F (b1 ) a1

F (b1 ) a1

所得译码函数为C: 平均错误概率为:

PE'''

F (b1 ) a3 F (b2 ) a3 F (b ) a 3 3

Y , X a

P(aibj ) (0.125 0.05) (0.075 0.075) (0.05 0.125) 0.5

*

电子信息工程学院

信息论

1 错误概率与译码规则

前面已经从理论上讨论了,对于无噪无损信道只要 对信源进行适当的编码,总能以信道容量无差错的传递 信息。但是一般信道总会存在噪声和干扰,那么在有噪 信道中进行无错传输可以达到的最大信息传输率是多少 呢?这就是本章所要讨论的问题。本章的核心是香农第 二定理。

电子信息工程学院

信息论

根据最大似然准则可选择译码函数为B:

F (b1 ) a1 F (b2 ) a3 F (b ) a 3 2

PE 1 1 P(b / a) [(0.2 0.3) (0.3 0.3) (0.2 0.4)] 0.567 3 Y , X a* 3

这称为最大似然译码准则,方法是收到一个 bj 后, 在信道矩阵的第j列,选择最大的值所对应的输入符号作 为译码输出。 可进一步写出平均错误概率:

P 1 P[ F (b j ) / b j ]}P(b j ) E P(b j ) P(e / b j ) {

1 P[ F (b j )b j ] p(aibj ) P[ F (bj )bj ]

1 错误概率与译码规则

为了减少错误,提高通信的可靠性,就必须分析错误 概率与哪些因素有关,有没有办法控制,能控制到什么程 度。 前边已经讨论过,错误概率与信道的统计特性有关, 但并不是唯一相关的因素,译码方法的选择也会影响错误 率。

电子信息工程学院

信息论

1 错误概率与译码规则

例:有一个BSC信 道,如图所示

0 1

2/3 2/3

1/3

0 1

1/3

若收到“0”译作“0”,收到“1”译作“1”,则平均错误概率 2 为: (0) (1) P P (0) P P (1) P

E e e

3

反之,若收到“0”译作“1”,收到“1”译作“0”,则平 均错误概率为1/3,可见错误概率与译码准则有关。 电子信息工程学院

电子信息工程学院

信息论

1 错误概率与译码规则

下面的问题就是如何选择 P(ai / bj ) ,经过前边的讨论可 以看出,为使 P(e / bj ) 最小,就应选择 P(F (bj ) / bj ) 为最大,即选择译码函数 P(a / b ) P(a / b ) a a 并使之满 足条件:F (b ) a 也就是说,收到一个符号以后译成具有最大后验概率 的那个输入符号。这种译码准则称为“最大后验概率准 则”或“最小错误概率准则”。 根据贝叶斯定律,上式也可以写成