tensorflow常用函数及操作命令

tensorflow的embedding函数参数

TensorFlow的embedding函数参数1.导言在使用深度学习进行自然语言处理(N LP)任务时,词嵌入(W or dE mb ed di ng)是一个重要的概念。

它将自然语言中的词语转化为低维稠密向量,可以在机器学习模型中使用。

Te ns or Fl ow是一个广泛应用于深度学习的开源框架,其中的em be dd i ng函数可以帮助我们实现词嵌入的功能。

本文将详细介绍Te ns or Flo w的e mb ed di ng函数以及其参数的使用方法。

2. Te nsorFlo w的e m b e d d i n g函数T e ns or Fl ow的e mbe d di ng函数是一个非常强大和灵活的函数,用于实现词嵌入的功能。

它将一个整数序列作为输入,并将其转换为对应的词嵌入向量序列。

具体来说,e mb ed di ng函数将整数序列表示为矩阵的形式,其中每一行都是一个词嵌入向量。

3. em bedding函数的参数在使用e mb ed di ng函数时,我们可以根据需要设置不同的参数。

下面是一些常用的参数:3.1i n p u t_d i mi n pu t_di m参数指定了输入序列中不同词语的个数。

它是一个正整数。

例如,如果我们的输入序列中有10000个不同的词语,那么i np ut_d im应该设置为10000。

3.2o u t p u t_d i mo u tp ut_d im参数指定了每个词语的词嵌入向量的维度。

它是一个正整数。

例如,如果我们希望每个词语的词嵌入向量是100维的,那么o u tp ut_d im应该设置为100。

3.3i n p u t_l e n g t hi n pu t_le ng th参数指定了输入序列的长度。

它允许我们指定不同序列的长度。

例如,如果我们的输入序列的长度是10,那么i n pu t_le ng th应该设置为10。

3.4e m b e d d i n g s_i n i t i a l i z e re m be dd in gs_i ni tia l iz er参数指定了词嵌入矩阵的初始化方法。

tensorflow和torch的基本函数 -回复

tensorflow和torch的基本函数-回复TensorFlow和Torch是两个流行的机器学习框架,都提供了丰富的基本函数。

本文将逐步回答有关这些函数的问题,并介绍它们的用法和特点。

TensorFlow是由Google开发的一个开源机器学习框架,被广泛用于构建和训练各种类型的神经网络模型。

Torch是一个基于Lua编程语言的科学计算框架,提供了丰富的工具和模块,用于构建深度学习模型。

这两个框架在实现深度学习模型方面都具有很高的性能和灵活性。

在TensorFlow中,基本函数通常用于定义计算图中的各个操作。

计算图是一种有向无环图,其中节点表示操作,边表示数据流。

每个基本函数都代表一个操作节点,用于执行特定的计算。

以下是一些常见的基本函数及其用法:1. tf.constant(value, dtype=None, shape=None, name='Const')这个函数用于创建一个常量张量。

参数value是常量的值,dtype是数据类型,shape是张量的形状,name是操作的名称。

例如,创建一个形状为(2, 2)的常量张量:import tensorflow as tfx = tf.constant([[1, 2], [3, 4]])2. tf.Variable(initial_value, dtype=None, name=None)这个函数用于创建一个可变的张量。

参数initial_value是初始化张量的值,dtype是数据类型,name是操作的名称。

例如,创建一个初始值为0的可变张量:import tensorflow as tfx = tf.Variable(0)3. tf.placeholder(dtype, shape=None, name=None)这个函数用于创建一个占位符张量。

占位符是在模型训练和预测过程中用于输入数据的张量,可以在运行时传入具体的值。

参数dtype是数据类型,shape是张量的形状,name是操作的名称。

size_lookup函数的用法(一)

size_lookup函数的用法(一)Size_lookup函数的用法在深度学习中,我们常常需要将输入数据调整为指定的形状和尺寸。

而size_lookup函数则是一种常用的工具,在TensorFlow中被广泛应用于数据重塑和尺寸调整的场景。

本文将介绍size_lookup函数的用法,希望能对读者有所帮助。

什么是size_lookup函数?size_lookup函数是TensorFlow中的一个操作符,用于查询给定数据的形状和尺寸。

它可以将数据从一个形状转换为另一个形状,同时调整数据的尺寸和维度。

size_lookup函数常用于卷积神经网络、循环神经网络、自编码器等深度学习模型中,以帮助实现数据的重塑和尺寸调整。

size_lookup函数的语法size_lookup函数的语法比较简单,下面是它的基本语法:tf.size_lookup(input, output_shape)其中,input表示待重塑的数据;output_shape表示重塑后的形状。

size_lookup函数的应用下面通过几个例子,来演示size_lookup函数的应用。

例子1:数据重塑假设我们有一个形状为[batch_size, height, width, channels]的数据,现在需要将它重塑为[batch_size, height*width, channels]的形状。

这时,可以使用size_lookup函数来方便地实现数据的重塑。

input= tf.placeholder(tf.float32, shape=[None, 28, 28, 3])output_shape = tf.constant([1,-1,3])output = tf.reshape(input, tf.size_lookup(input, output_shape))在上面的例子中,我们首先定义了一个输入数据input和一个目标形状output_shape,然后使用size_lookup函数查询出目标形状对应的尺寸,并将input按照目标尺寸进行重塑。

Python深度学习库TensorFlow

Python深度学习库TensorFlow一、引言随着人工智能技术的不断发展,深度学习已经成为当前最热门的研究领域之一。

在深度学习中,神经网络是最基本的模型之一,而TensorFlow正是一款用于建立神经网络的深度学习框架。

TensorFlow是谷歌(Google)公司开发的一套开源机器学习库,它能够支持多种语言,包括Python和C++。

TensorFlow提供了一个强大的图计算框架,使得用户可以轻松地构建、训练和优化神经网络模型。

本文将介绍TensorFlow的基本概念、基础用法以及构建深度神经网络模型的相关内容,以帮助初学者快速上手TensorFlow。

本文还将简要介绍TensorFlow在各种领域中的应用案例,以展示TensorFlow的强大功能和广泛应用领域。

二、TensorFlow基本概念TensorFlow的整个计算过程都是基于图(Graph)的,其中节点表示操作(Operation),边表示操作之间的依赖关系。

一个TensorFlow 程序通常包括两个阶段:定义阶段和执行阶段。

在定义阶段,用户需要定义神经网络的结构和目标函数;在执行阶段,TensorFlow会建立图并运行神经网络。

下面是TensorFlow的几个基本概念及其简要介绍:1.张量(Tensor):张量是TensorFlow中的核心数据结构,可以看做是多维数组,可以包含任意数量的维度。

张量用于表示神经网络的输入、输出和参数。

2.操作(Operation):操作是TensorFlow中的基本计算单元,表示节点。

节点可以是数学运算、数组操作或是神经网络层等。

例如,加法操作(tf.add)和矩阵乘法操作(tf.matmul)都是一种操作。

3.变量(Variable):变量是TensorFlow中的一个或多个张量,用于存储模型的参数。

变量在训练过程中会被更新,从而实现模型的优化。

4.会话(Session):会话是TensorFlow中的一个运行环境。

Tensorflow损失函数(lossfunction)及自定义损失函数(三)

Tensorflow损失函数(lossfunction)及⾃定义损失函数(三)版权声明:本⽂为博主原创⽂章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原⽂出处链接和本声明。

本⽂链接:https:///limiyudianzi/article/details/80697711我主要分三篇⽂章给⼤家介绍tensorflow的损失函数,本篇为tensorflow⾃定义损失函数。

(⼀)tensorflow内置的四个损失函数(⼆)其他损失函数(三)⾃定义损失函数⾃定义损失函数是损失函数章节的结尾,学习⾃定义损失函数,对于提⾼分类分割等问题的准确率很有帮助,同时探索新型的损失函数也可以让你⽂章多多。

这⾥我们介绍构建⾃定义损失函数的⽅法,并且介绍可以均衡正负例的loss,以及在多分类中可以解决样本数量不均衡的loss的⽅法。

⾸先为了有⾜够的知识学会⾃定义损失函数,我们需要知道tensorflow都能实现什么样的操作。

其实答案是你常见的数学运算都可以,所以说只要你能把⼼中的损失函数表达为数学式的形式,那么你就能够将其转变为损失函数的形式。

下⾯介绍⼀些常见的函数:四则运算:tf.add(Tensor1,Tensor2),tf.sub(Tensor1,Tensor2), tf.mul(Tensor1,Tensor2),tf.div(Tensor1,Tensor2)这⾥的操作也可以被正常的加减乘除的负号所取代。

这⾥想要指出的是乘法和除法的规则和numpy库是⼀样的,是matlab中的点乘⽽不是矩阵的乘法,矩阵的乘法是tf.matmul(Tensor1, Tensor2)基础运算:取模运算(tf.mod()),绝对值(tf.abs()),平⽅(tf.square()),四舍五⼊取整(tf.round()),取平⽅根(tf.sqrt()) ,⾃然对数的幂(tf.exp()) ,取对数(tf.log()) ,幂(tf.pow()) ,正弦运算(tf.sin())。

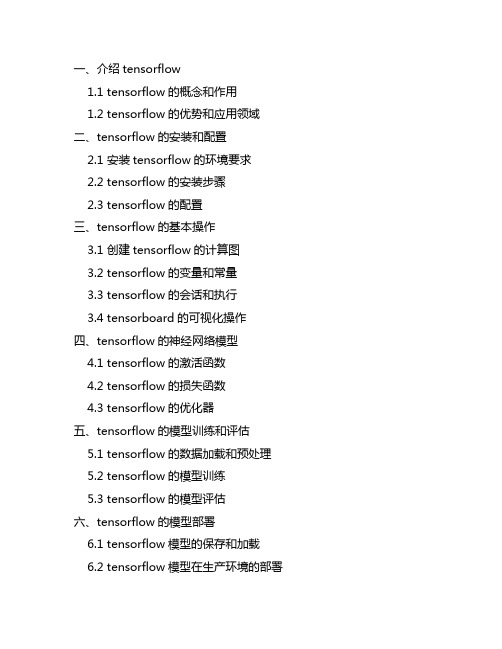

tensorflow的基本用法

一、介绍tensorflow1.1 tensorflow的概念和作用1.2 tensorflow的优势和应用领域二、tensorflow的安装和配置2.1 安装tensorflow的环境要求2.2 tensorflow的安装步骤2.3 tensorflow的配置三、tensorflow的基本操作3.1 创建tensorflow的计算图3.2 tensorflow的变量和常量3.3 tensorflow的会话和执行3.4 tensorboard的可视化操作四、tensorflow的神经网络模型4.1 tensorflow的激活函数4.2 tensorflow的损失函数4.3 tensorflow的优化器五、tensorflow的模型训练和评估5.1 tensorflow的数据加载和预处理 5.2 tensorflow的模型训练5.3 tensorflow的模型评估六、tensorflow的模型部署6.1 tensorflow模型的保存和加载6.2 tensorflow模型在生产环境的部署七、总结在当今大数据和人工智能的时代背景下,深度学习技术的发展已经成为了大势所趋。

而在深度学习技术中,TensorFlow作为Google推出的一款开源的深度学习框架,成为了业界广泛使用的工具。

掌握TensorFlow的基本用法是每一个从事人工智能或深度学习相关工作的从业者必不可少的技能之一。

一、介绍tensorflow1.1 tensorflow的概念和作用TensorFlow是一个端到端开源的机器学习框架。

它拥有一个全面而灵活的生态系统,包括各种工具、库和社区资源,可以帮助研究人员推动先进的机器学习和深度学习算法的发展。

TensorFlow最初是由Google大脑团队(Google Brain Team)的研究人员和工程师开发的,用于机器学习和深度神经网络方面的研究,但现在已经成为了Google内部大部分深度学习项目的首选工具,并且得到了广泛的应用。

tensorflow的张量维度方法

tensorflow的张量维度方法

TensorFlow提供了一系列用于处理张量维度的方法,以下是

一些常用的方法:

1. `tf.shape(tensor)`: 返回张量的形状,以一个一维整数张量的

形式返回。

2. `tf.size(tensor)`: 返回张量中元素的个数,以一个标量张量的

形式返回。

3. `tf.rank(tensor)`: 返回张量的阶数,即张量的维度数。

4. `tf.reshape(tensor, shape)`: 返回一个具有新形状的张量,新形状由参数`shape`指定。

5. `tf.expand_dims(tensor, axis)`: 在指定的`axis`上为张量添加一个新的维度。

6. `tf.squeeze(tensor, axis)`: 移除张量中长度为1的维度,如果

指定了`axis`,则只移除该轴上的长度为1的维度。

7. `tf.concat(tensors, axis)`: 沿指定的`axis`将多个张量连接起来。

8. `tf.split(tensor, num_or_size_splits, axis)`: 沿指定的`axis`将张

量分割为多个子张量。

9. `tf.transpose(tensor, perm)`: 对张量进行转置操作,`perm`参

数指定了新的维度顺序。

10. `tf.tile(tensor, multiples)`: 通过在指定的维度上复制张量的一些或所有维度来创建新的张量。

这些方法可以帮助您灵活地处理和操作张量的维度。

Tensorflow笔记:神经网络优化-损失函数

print(X) print(Y_)

# 1定义神经网络的输入、参数和输出,定义前向传播过程。 x = tf.placeholder(tf.float32, shape=(None, 2)) y_ = tf.placeholder(tf.float32, shape=(None, 1))

w = tf.Variable(tf.random_normal([2, 1], stddev=1, seed=1))

改变神经网络中所有参数使损失函数不断减小从而训练出更高准确率的神经网络模型

Tensorflow笔记:神经网络优化 -损失函数

√ 神经元模型: 用数学公式表示为: (∑xw +b), , f 为激活函数。 神经网络 是 以神经元为基本单元构成的. √ 激活函数: 引入 非线性 激 活因素,提高模型表达力 常用的激活 函数有 relu 、 sigmoid 、 tanh 等。 激活函数 relu: : 在 tensorflow 中, 用 tf.nn.relu()

# coding:utf-8 # 0导入模块,生成模拟数据集。 import tensorflow as tf import numpy as np

BATCH_SIZE = 8 SEED = 23455

# 基于seed产生随机数 rdm = np.random.RandomState(SEED) X = rdm.rand(32, 2) Y_ = [[x1 + x2 +(rdm.rand()/10.0-0.05)] for (x1, x2) in X]

print("After %d training step(s)" % (i)) print("w1:\n", sess.run(w))

tensorflowflow使用手册

tensorflowflow使用手册(实用版)目录1.TensorFlow 简介2.TensorFlow 的安装与配置3.TensorFlow 的基本概念与术语4.TensorFlow 的运算与操作5.TensorFlow 的训练与优化6.TensorFlow 的高级特性与应用7.TensorFlow 的示例与实践正文1.TensorFlow 简介TensorFlow 是一个开源的机器学习框架,由 Google 大脑团队开发。

它广泛应用于各种机器学习任务,如计算机视觉、自然语言处理、语音识别等。

TensorFlow 提供了丰富的 API 和工具,使得开发者可以轻松地构建、训练和部署深度学习模型。

2.TensorFlow 的安装与配置在使用 TensorFlow 之前,需要先安装 TensorFlow。

TensorFlow 支持多种平台,包括 Linux、macOS 和 Windows。

安装 TensorFlow 可以通过 pip 或者克隆 GitHub 代码的方式进行。

安装完成后,需要配置TensorFlow 的环境变量,以便在 Python 程序中调用 TensorFlow 的库。

3.TensorFlow 的基本概念与术语TensorFlow 包含许多基本概念和术语,如张量(Tensor)、节点(Node)、操作(Operation)、变量(Variable)等。

理解这些概念和术语对于深入使用 TensorFlow 至关重要。

4.TensorFlow 的运算与操作TensorFlow 提供了丰富的运算和操作,包括矩阵运算、广播、卷积、归一化等。

这些操作可以用于构建复杂的深度学习模型。

5.TensorFlow 的训练与优化在 TensorFlow 中,可以使用反向传播算法对模型进行训练。

TensorFlow 还提供了多种优化算法,如随机梯度下降(SGD)、Adam、RMSProp 等,以加速模型的收敛。

tf.gather函数用法

tf.gather函数用法

tf.gather函数是TensorFlow中用于按照给定索引从输入张量中收集切片的函数。

它的用法如下:

```python

tf.gather(params, indices, axis=None, batch_dims=0, name=None)

```

参数说明:

- params:输入数据的张量

- indices:一个包含要获取切片的索引的张量。

也可以是一个整数列表,表示每个维度上的索引。

- axis:一个整数,表示从哪个轴获取切片。

默认为None,表示从平铺的完整张量中获取切片。

- batch_dims:一个整数,表示批次维度的数量。

默认为0,意味着只有在第一个维度上分批次获取切片。

- name:可选的操作名称。

示例:

```python

import tensorflow as tf

# 定义输入数据

inputs = tf.constant([[1, 2], [3, 4], [5, 6]])

# 按照给定索引从输入张量中获取切片

out = tf.gather(inputs, [0, 2], axis=0)

print(out.numpy())

# 输出:

# [[1 2]

# [5 6]]

```

在这个例子中,我们使用tf.gather函数按照给定的索引获取了一个新的张量,其中包含输入张量中第0和第2行的数据。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1、tensorflow常用函数TensorFlow 将图形定义转换成分布式执行的操作, 以充分利用可用的计算资源(如CPU 或GPU。

一般你不需要显式指定使用CPU 还是GPU, TensorFlow 能自动检测。

如果检测到GPU, TensorFlow 会尽可能地利用找到的第一个GPU 来执行操作.并行计算能让代价大的算法计算加速执行,TensorFlow也在实现上对复杂操作进行了有效的改进。

大部分核相关的操作都是设备相关的实现,比如GPU。

下面是一些重要的操作/核:操作组操作Maths Add, Sub, Mul, Div, Exp, Log, Greater, Less, EqualArray Concat, Slice, Split, Constant, Rank, Shape, ShuffleMatrix MatMul, MatrixInverse, MatrixDeterminantNeuronal Network SoftMax, Sigmoid, ReLU, Convolution2D, MaxPoolCheckpointing Save, RestoreQueues and syncronizations Enqueue, Dequeue, MutexAcquire, MutexReleaseFlow control Merge, Switch, Enter, Leave, NextIterationTensorFlow的算术操作如下:操作描述tf.add(x, y, name=None) 求和tf.sub(x, y, name=None) 减法tf.mul(x, y, name=None) 乘法tf.div(x, y, name=None) 除法tf.mod(x, y, name=None) 取模tf.abs(x, name=None) 求绝对值tf.neg(x, name=None) 取负(y = -x).tf.sign(x, name=None) 返回符号y = sign(x) = -1 if x < 0; 0 if x == 0; 1 if x > 0.tf.inv(x, name=None) 取反tf.square(x, name=None) 计算平方(y = x * x = x^2).tf.round(x, name=None) 舍入最接近的整数# ‘a’ is [0.9, 2.5, 2.3, -4.4]tf.round(a) ==> [ 1.0, 3.0, 2.0, -4.0 ]tf.sqrt(x, name=None) 开根号(y = \sqrt{x} = x^{1/2}).tf.pow(x, y, name=None) 幂次方# tensor ‘x’ is [[2, 2], [3, 3]]# tensor ‘y’ is [[8, 16], [2, 3]]tf.pow(x, y) ==> [[256, 65536], [9, 27]]tf.exp(x, name=None) 计算e的次方tf.log(x, name=None) 计算log,一个输入计算e的ln,两输入以第二输入为底tf.maximum(x, y, name=None) 返回最大值(x > y ? x : y)tf.minimum(x, y, name=None) 返回最小值(x < y ? x : y)tf.cos(x, name=None) 三角函数cosinetf.sin(x, name=None) 三角函数sinetf.tan(x, name=None) 三角函数tantf.atan(x, name=None) 三角函数ctan张量操作Tensor Transformations•数据类型转换Casting操作描述tf.string_to_number(string_tensor, out_type=None, name=None) 字符串转为数字tf.to_double(x, name=’ToDouble’) 转为64位浮点类型–float64tf.to_float(x, name=’ToFloat’) 转为32位浮点类型–float32tf.to_int32(x, name=’ToInt32’) 转为32位整型–int32tf.to_int64(x, name=’ToInt64’) 转为64位整型–int64tf.cast(x, dtype, name=None) 将x或者x.values转换为dtype# tensor a is [1.8, 2.2], dtype=tf.floattf.cast(a, tf.int32) ==> [1, 2] # dtype=tf.int32•形状操作Shapes and Shaping操作描述tf.shape(input, name=None) 返回数据的shape# ‘t’ is [[[1, 1, 1], [2, 2, 2]], [[3, 3, 3], [4, 4, 4]]] shape(t) ==> [2, 2, 3]tf.size(input, name=None) 返回数据的元素数量# ‘t’ is [[[1, 1, 1], [2, 2, 2]], [[3, 3, 3], [4, 4, 4]]]]size(t) ==> 12tf.rank(input, name=None) 返回tensor的rank注意:此rank不同于矩阵的rank,tensor的rank表示一个tensor需要的索引数目来唯一表示任何一个元素也就是通常所说的“order”, “degree”或”ndims”#’t’ is [[[1, 1, 1], [2, 2, 2]], [[3, 3, 3], [4, 4, 4]]]# shape of tensor ‘t’ is [2, 2, 3]rank(t) ==> 3tf.reshape(tensor, shape, name=None) 改变tensor的形状# tensor ‘t’ is [1, 2, 3, 4, 5, 6, 7, 8, 9]# tensor ‘t’ has shape [9]reshape(t, [3, 3]) ==>[[1, 2, 3],[4, 5, 6],[7, 8, 9]]#如果shape有元素[-1],表示在该维度打平至一维# -1 将自动推导得为9:reshape(t, [2, -1]) ==>[[1, 1, 1, 2, 2, 2, 3, 3, 3],[4, 4, 4, 5, 5, 5, 6, 6, 6]]tf.expand_dims(input, dim, name=None) 插入维度1进入一个tensor中#该操作要求-1-input.dims()# ‘t’ is a tensor of shape [2]shape(expand_dims(t, 0)) ==> [1, 2]shape(expand_dims(t, 1)) ==> [2, 1]shape(expand_dims(t, -1)) ==> [2, 1] <= dim <= input.dims()•切片与合并(Slicing and Joining)操作描述tf.slice(input_, begin, size, name=None) 对tensor进行切片操作其中size[i] = input.dim_size(i) - begin[i]该操作要求0 <= begin[i] <= begin[i] + size[i] <= Di for i in [0, n]#’input’ is#[[[1, 1, 1], [2, 2, 2]],[[3, 3, 3], [4, 4, 4]],[[5, 5, 5], [6, 6, 6]]] tf.slice(input, [1, 0, 0], [1, 1, 3]) ==> [[[3, 3, 3]]]tf.slice(input, [1, 0, 0], [1, 2, 3]) ==>[[[3, 3, 3],[4, 4, 4]]]tf.slice(input, [1, 0, 0], [2, 1, 3]) ==>[[[3, 3, 3]],[[5, 5, 5]]]tf.split(split_dim, num_split, value, name=’split’) 沿着某一维度将tensor分离为num_split tensors # ‘value’ is a tensor with shape [5, 30]# Split ‘value’ into 3 tensors along dimension 1 split0, split1, split2 = tf.split(1, 3, value)tf.shape(split0) ==> [5, 10]tf.concat(concat_dim, values, name=’concat’) 沿着某一维度连结tensort1 = [[1, 2, 3], [4, 5, 6]]t2 = [[7, 8, 9], [10, 11, 12]]tf.concat(0, [t1, t2]) ==> [[1, 2, 3], [4, 5, 6], [7, 8, 9], [10, 11, 12]] tf.concat(1, [t1, t2]) ==> [[1, 2, 3, 7, 8, 9], [4, 5, 6, 10, 11, 12]] 如果想沿着tensor一新轴连结打包,那么可以:tf.concat(axis, [tf.expand_dims(t, axis) for t in tensors])等同于tf.pack(tensors, axis=axis)tf.pack(values, axis=0, name=’pack’) 将一系列rank-R的tensor打包为一个rank-(R+1)的tensor # ‘x’ is [1, 4], ‘y’ is [2, 5], ‘z’ is [3, 6]pack([x, y, z]) => [[1, 4], [2, 5], [3, 6]]# 沿着第一维packpack([x, y, z], axis=1) => [[1, 2, 3], [4, 5, 6]]等价于tf.pack([x, y, z]) = np.asarray([x, y, z])tf.reverse(tensor, dims, name=None) 沿着某维度进行序列反转其中dim为列表,元素为bool型,size等于rank(tensor) # tensor ‘t’ is[[[[ 0, 1, 2, 3],#[ 4, 5, 6, 7],#[ 8, 9, 10, 11]],#[[12, 13, 14, 15],#[16, 17, 18, 19],#[20, 21, 22, 23]]]]# tensor ‘t’ shape is [1, 2, 3, 4]# ‘dims’ is [False, False, False, True]reverse(t, dims) ==>[[[[ 3, 2, 1, 0],[ 7, 6, 5, 4],[ 11, 10, 9, 8]],[[15, 14, 13, 12],[19, 18, 17, 16],[23, 22, 21, 20]]]]tf.transpose(a, perm=None, name=’transpose’) 调换tensor的维度顺序按照列表perm的维度排列调换tensor顺序,如为定义,则perm为(n-1…0)# ‘x’ is [[1 2 3],[4 5 6]]tf.transpose(x) ==> [[1 4], [2 5],[3 6]]# Equivalentlytf.transpose(x, perm=[1, 0]) ==> [[1 4],[2 5], [3 6]] tf.gather(params, indices, validate_indices=None,name=None)合并索引indices所指示params中的切片tf.one_hot(indices, depth, on_value=None, off_value=None, axis=None, dtype=None, name=None) indices = [0, 2, -1, 1] depth = 3on_value = 5.0off_value = 0.0axis = -1#Then output is [4 x 3]: output =[5.0 0.0 0.0] // one_hot(0) [0.0 0.0 5.0] // one_hot(2) [0.0 0.0 0.0] // one_hot(-1) [0.0 5.0 0.0] // one_hot(1)矩阵相关运算操作描述tf.diag(diagonal, name=None) 返回一个给定对角值的对角tensor # ‘diagonal’ is [1, 2, 3, 4]tf.diag(diagonal) ==>[[1, 0, 0, 0][0, 2, 0, 0][0, 0, 3, 0][0, 0, 0, 4]]tf.diag_part(input, name=None) 功能与上面相反tf.trace(x, name=None) 求一个2维tensor足迹,即对角值diagonal之和tf.transpose(a, perm=None, name=’transpose’) 调换tensor的维度顺序按照列表perm的维度排列调换tensor顺序,如为定义,则perm为(n-1…0)# ‘x’ is [[1 2 3],[4 5 6]]tf.transpose(x) ==> [[1 4], [2 5],[3 6]]# Equivalentlytf.transpose(x, perm=[1, 0]) ==> [[1 4],[2 5], [3 6]]tf.matmul(a, b, transpose_a=False,transpose_b=False, a_is_sparse=False, 矩阵相乘tf.matrix_determinant(input, name=None)返回方阵的行列式tf.matrix_inverse(input, adjoint=None,name=None)求方阵的逆矩阵,adjoint 为True 时,计算输入共轭矩阵的逆矩阵tf.cholesky(input, name=None)对输入方阵cholesky 分解,即把一个对称正定的矩阵表示成一个下三角矩阵L 和其转置的乘积的分解A=LL^Ttf.matrix_solve(matrix, rhs, adjoint=None, name=None) 求解tf.matrix_solve(matrix, rhs, adjoint=None, name=None) matrix 为方阵shape 为[M,M],rhs 的shape 为[M,K],output 为[M,K] 复数操作 操作描述plex(real, imag, name=None)将两实数转换为复数形式# tensor ‘real’ is [2.25, 3.25] # tensor imag is [4.75, 5.75]plex(real, imag) ==> [[2.25 + 4.75j], [3.25 + 5.75j]] plex_abs(x, name=None)计算复数的绝对值,即长度。