决策树分类模型算法实验报告

决策树分类实习报告

实习报告:决策树分类实验一、实习背景随着人工智能和机器学习的不断发展,越来越多的任务需要使用机器学习算法进行数据分析和处理。

决策树作为一种常见的机器学习算法,在分类和回归任务中有着广泛的应用。

本次实习,我选择了决策树分类任务,并使用Python的sklearn库进行实验。

二、实习目的1. 熟悉决策树算法的基本原理和实现方式;2. 掌握决策树模型的训练、评估和改进方法;3. 应用决策树算法解决实际问题,提高对机器学习算法的理解和应用能力。

三、实习内容1. 数据集选取与预处理:本次实验选用OpenML的汽车数据集,包含214个样本,11个特征。

首先,对数据集进行加载和探索性分析,了解数据的分布和特点。

然后,进行数据预处理,包括缺失值填充、异常值处理和特征选择等。

2. 模型训练与评估:使用决策树分类器对预处理后的数据集进行训练。

通过调整模型参数,如最大深度、分裂准则等,评估不同模型在测试集上的性能。

评估指标包括准确率、召回率、F1分数等。

3. 改进模型:为了提高模型性能,采用GridSearchCV方法寻找最佳的超参数组合。

同时,针对过拟合问题,限制树的最大深度,并调整类别权重以应对数据集的不平衡。

4. 结果展示:最后,在使用最佳参数的决策树模型上,对测试集进行预测,并使用混淆矩阵、准确率评分和分类报告形式展示模型结果。

四、实习心得1. 决策树算法易于理解和实现,但模型性能受到参数设置的影响较大。

因此,在实际应用中,需要对参数进行调整和优化。

2. GridSearchCV方法是一种有效的参数调整工具,可以较大程度地提高模型性能。

3. 过拟合问题是决策树算法常见的问题之一。

通过限制树的最大深度、调整类别权重等方法,可以有效减轻过拟合现象,提高模型在实际任务中的表现。

4. 本次实习使我更深入地了解了决策树算法,提高了我在实际项目中应用机器学习算法的能力。

五、实习展望1. 进一步学习其他机器学习算法,如支持向量机、随机森林等,提高模型的泛化能力。

(完整版)生物数据挖掘-决策树实验报告

实验四决策树一、实验目的1.了解典型决策树算法2.熟悉决策树算法的思路与步骤3.掌握运用Matlab对数据集做决策树分析的方法二、实验内容1.运用Matlab对数据集做决策树分析三、实验步骤1.写出对决策树算法的理解决策树方法是数据挖掘的重要方法之一,它是利用树形结构的特性来对数据进行分类的一种方法。

决策树学习从一组无规则、无次序的事例中推理出有用的分类规则,是一种实例为基础的归纳学习算法。

决策树首先利用训练数据集合生成一个测试函数,根据不同的权值建立树的分支,即叶子结点,在每个叶子节点下又建立层次结点和分支,如此重利生成决策树,然后对决策树进行剪树处理,最后把决策树转换成规则。

决策树的最大优点是直观,以树状图的形式表现预测结果,而且这个结果可以进行解释。

决策树主要用于聚类和分类方面的应用。

决策树是一树状结构,它的每一个叶子节点对应着一个分类,非叶子节点对应着在某个属性上的划分,根据样本在该属性上的不同取值将其划分成若干个子集。

构造决策树的核心问题是在每一步如何选择适当的属性对样本进行拆分。

对一个分类问题,从已知类标记的训练样本中学习并构造出决策树是一个自上而下分而治之的过程。

2.启动Matlab,运用Matlab对数据集进行决策树分析,写出算法名称、数据集名称、关键代码,记录实验过程,实验结果,并分析实验结果(1)算法名称: ID3算法ID3算法是最经典的决策树分类算法。

ID3算法基于信息熵来选择最佳的测试属性,它选择当前样本集中具有最大信息增益值的属性作为测试属性;样本集的划分则依据测试属性的取值进行,测试属性有多少个不同的取值就将样本集划分为多少个子样本集,同时决策树上相应于该样本集的节点长出新的叶子节点。

ID3算法根据信息论的理论,采用划分后样本集的不确定性作为衡量划分好坏的标准,用信息增益值度量不确定性:信息增益值越大,不确定性越小。

因此,ID3算法在每个非叶节点选择信息增益最大的属性作为测试属性,这样可以得到当前情况下最纯的划分,从而得到较小的决策树。

实验三决策树算法实验实验报告

实验三决策树算法实验实验报告一、引言决策树算法是一种常用的机器学习算法,它通过构建一个决策树模型来解决分类和回归问题。

在本次实验中,我们将使用决策树算法对一个分类问题进行建模,评估算法的性能,并对实验结果进行分析和总结。

二、实验目的1.学习理解决策树算法的基本原理和建模过程。

2. 掌握使用Python编程实现决策树算法。

3.分析决策树算法在不同数据集上的性能表现。

三、实验过程1.数据集介绍2.决策树算法实现我们使用Python编程语言实现了决策树算法。

首先,我们将数据集随机分为训练集和测试集,其中训练集占70%,测试集占30%。

然后,我们使用训练集来构建决策树模型。

在构建决策树时,我们采用了ID3算法,该算法根据信息增益来选择最优的特征进行分割。

最后,我们使用测试集来评估决策树模型的性能,计算并输出准确率和召回率。

3.实验结果与分析我们对实验结果进行了统计和分析。

在本次实验中,决策树算法在测试集上的准确率为0.95,召回率为0.94、这表明决策树模型对于鸢尾花分类问题具有很好的性能。

通过分析决策树模型,我们发现花瓣长度是最重要的特征,它能够很好地区分不同种类的鸢尾花。

四、实验总结通过本次实验,我们学习了决策树算法的基本原理和建模过程,并使用Python实现了决策树算法。

通过实验结果分析,我们发现决策树算法在鸢尾花分类问题上具有很好的性能。

然而,决策树算法也存在一些不足之处,例如容易过拟合和对数据的敏感性较强等。

在实际应用中,可以使用集成学习方法如随机森林来改进决策树算法的性能。

决策树算法实验总结

决策树算法实验总结

决策树算法是一种常用的机器学习算法,它通过对数据集进行递归划分,构建出一棵树状的决策模型。

在实验中,我们使用了决策树算法进行分类任务,并对实验结果进行总结。

首先,我们需要准备一个带有标签的训练数据集,其中包含了多个特征和对应的类别标签。

然后,我们可以使用决策树算法对训练数据集进行训练,构建出一棵具有判断条件的决策树。

在实验中,我们可以使用不同的指标来评估决策树算法的性能,例如准确率、精确率、召回率等。

这些指标可以帮助我们了解决策树算法在分类任务中的表现。

此外,我们还可以通过调整决策树算法的参数来提高其性能。

例如,可以通过限制树的最大深度、设置叶子节点的最小样本数等来控制决策树的复杂度,避免过拟合问题。

在实验总结中,我们可以描述决策树算法在实验中的表现,比较其与其他算法的优劣势,并提出进一步改进的方向。

此外,还可以讨论决策树算法在不同数据集上的适用性,并分析其在实际应用中可能遇到的问题和局限性。

总而言之,决策树算法是一种简单而有效的机器学习算法,可以用于分类任务。

通过实验总结,我们可以更好地理解决策树算法的原理和性能,为进一步的应用和改进提供指导。

决策树 实验报告

实验(实习)名称决策树分析一.实验要求:(1)学习决策树分类学习方法,学习其中C4.5学习算法,了解其他ADtree、Id3等其它分类学习方法。

(2)应用Weka软件,学会导入数据文件,并对数据文件进行预处理。

(3)学会如何选择学习函数并调节学习训练参数以达到最佳学习效果。

(4)学习并应用其他决策树学习算法,可以进行各种算法对照比较。

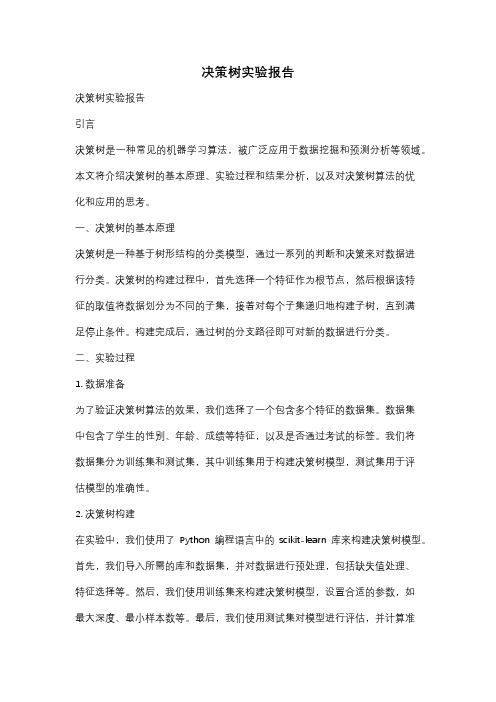

二.实验操作(1)在开始程序(或者桌面图标)中找到WEKA3.6.2,单击即可启动WEKA,启动WEKA 时会发现首先出现的一个命令提示符。

接着将出现如下Weka GUI Chooser界面。

(2)选择GUI Chooser中的探索者(Explorer)用户界面。

点击预处理(Preprocess)功能按钮的,Open file,选择其中的“weather”数据作关联规则的分析。

打开“weather.arff”,可以看到“Current relation”、“Attributes”“Selected attribute”三个区域。

(3)点击“Classify”选项卡。

单击左上方的Choose按钮,在随后打开的层级式菜单中的tree部分找到J48。

(4)选中J48分类器后,J48以及它的相关默认参数值出现在Choose按钮旁边的条形框中。

单击这个条形框会打开J48分类器的对象编辑器,编辑器会显示J48的各个参数的含义。

根据实际情况选择适当的参数,探索者通常会合理地设定这些参数的默认值。

三.实验结果:计算正确率可得:(74+132)/(74+30+64+132)=0.69四.实验小结:通过本次试验,我学习了决策树分类方法,以及其中C4.5算法,并了解了其他ADtree、Id3等其它分类方法,应用Weka软件,学会导入数据文件,并对数据文件进行预处理,今后还需努力。

决策树实验报告

决策树实验报告决策树实验报告引言决策树是一种常见的机器学习算法,被广泛应用于数据挖掘和预测分析等领域。

本文将介绍决策树的基本原理、实验过程和结果分析,以及对决策树算法的优化和应用的思考。

一、决策树的基本原理决策树是一种基于树形结构的分类模型,通过一系列的判断和决策来对数据进行分类。

决策树的构建过程中,首先选择一个特征作为根节点,然后根据该特征的取值将数据划分为不同的子集,接着对每个子集递归地构建子树,直到满足停止条件。

构建完成后,通过树的分支路径即可对新的数据进行分类。

二、实验过程1. 数据准备为了验证决策树算法的效果,我们选择了一个包含多个特征的数据集。

数据集中包含了学生的性别、年龄、成绩等特征,以及是否通过考试的标签。

我们将数据集分为训练集和测试集,其中训练集用于构建决策树模型,测试集用于评估模型的准确性。

2. 决策树构建在实验中,我们使用了Python编程语言中的scikit-learn库来构建决策树模型。

首先,我们导入所需的库和数据集,并对数据进行预处理,包括缺失值处理、特征选择等。

然后,我们使用训练集来构建决策树模型,设置合适的参数,如最大深度、最小样本数等。

最后,我们使用测试集对模型进行评估,并计算准确率、召回率等指标。

3. 结果分析通过实验,我们得到了决策树模型在测试集上的准确率为80%。

这意味着模型能够正确分类80%的测试样本。

此外,我们还计算了模型的召回率和F1值等指标,用于评估模型的性能。

通过对结果的分析,我们可以发现模型在某些特征上表现较好,而在其他特征上表现较差。

这可能是由于数据集中某些特征对于分类结果的影响较大,而其他特征的影响较小。

三、决策树算法的优化和应用1. 算法优化决策树算法在实际应用中存在一些问题,如容易过拟合、对噪声敏感等。

为了提高模型的性能,可以采取以下措施进行优化。

首先,可以通过剪枝操作减少决策树的复杂度,防止过拟合。

其次,可以使用集成学习方法,如随机森林和梯度提升树,来进一步提高模型的准确性和鲁棒性。

实验二决策树实验实验报告

实验二决策树实验实验报告

一、实验目的

本实验旨在通过实际操作,加深对决策树算法的理解,并掌握

决策树的基本原理、构建过程以及应用场景。

二、实验原理

决策树是一种常用的机器学习算法,主要用于分类和回归问题。

其基本原理是将问题划分为不同的决策节点和叶节点,通过一系列

的特征测试来进行决策。

决策树的构建过程包括特征选择、划分准

则和剪枝等步骤。

三、实验步骤

1. 数据收集:从开放数据集或自有数据中选择一个适当的数据集,用于构建决策树模型。

2. 数据预处理:对收集到的数据进行缺失值处理、异常值处理

以及特征选择等预处理操作,以提高模型的准确性和可靠性。

3. 特征选择:采用合适的特征选择算法,从所有特征中选择对

分类或回归任务最重要的特征。

4. 构建决策树模型:根据选定的特征选择算法,以及划分准则(如信息增益或基尼系数)进行决策树模型的构建。

5. 模型评估:使用交叉验证等方法对构建的决策树模型进行评估,包括准确率、召回率、F1-score等指标。

6. 模型调优:根据评估结果,对决策树模型进行调优,如调整模型参数、采用剪枝技术等方法。

7. 模型应用:将得到的最优决策树模型应用于实际问题中,进行预测和决策。

四、实验结果及分析

在本次实验中,我们选择了某电商网站的用户购买记录作为数据集,利用决策树算法构建用户购买意愿的预测模型。

经过数据预处理和特征选择,选取了用户地理位置、年龄、性别和购买历史等特征作为输入。

利用信息增益作为划分准则,构建了一棵决策树模型。

模式识别--决策树算法报告

决策树算法综述摘要:决策树是用于分类和预测的一种树结构。

本文介绍了决策树算法的基本概念,包括决策树的基本原理、分类方法,发展过程及现状等。

详细介绍了基于决策树理论的分类方法,包括ID3算法的基本思想,属性选择度量等。

在分析传统的决策树算法的基础之上,引入了属性关注度,提出了一个基于属性选择度量改进的算法。

关键词:决策树;ID3;属性关注度1.决策树的基本概念1.1决策树的基本原理决策树是用于分类和预测的一种树结构。

决策树学习是以实例为基础的归纳学习算法。

它着眼于从一组无次序、无规则的实例中推理出决策树表示形式的分类规则。

它采用自顶向下的递归方式,在决策树的内部节点进行属性值的比较并根据不同的属性判断从该节点向下的分支,在决策树的叶节点得到结论。

所以从根节点就对应着一条合取规则,整棵树就对应着一组析取表达式规则。

一棵决策树是一棵有向无环树,它由若干个节点、分支、分裂谓词以及类别组成。

节点是一棵决策树的主体。

其中,没有父亲节点的节点称为根节点,没有子节点的节点称为叶子节点,一个节点按照某个属性分裂时,这个属性称为分裂属性。

决策树算法构造决策树来发现数据中蕴涵的分类规则。

如何构造精度高、规模小的决策树是决策树算法的核心内容。

决策树构造可以分两步进行。

第一步,决策树的生成。

决策树采用自顶向下的递归方式:从根节点开始在每个节点上按照给定标准选择测试属性,然后按照相应属性的所有可能取值向下建立分枝,划分训练样本,直到一个节点上的所有样本都被划分到同一个类,或者某一节点中的样本数量低于给定值时为止。

这一阶段最关键的操作是在树的节点上选择最佳测试属性,该属性可以将训练样本进行最好的划分。

最佳测试属性的选择标准有信息增益、基尼指数、以及基于距离的划分等。

第二步,决策树的剪技。

构造过程得到的并不是最简单、紧凑的决策树,因为许多分枝反映的可能是训练数据中的噪声或孤立点。

树剪枝过程试图检测和去掉这种分枝,以提高对未知数据集进行分类时的准确性。