信息论与编码陈运主编答案完整版

《信息论与编码》习题解答-第二章

《信息论与编码》习题解答第二章 信源熵-习题答案2-1解:转移概率矩阵为:P(j/i)=,状态图为:⎪⎩⎪⎨⎧==∑∑j jj ij ii W W P W 1,⎪⎪⎪⎪⎩⎪⎪⎪⎪⎨⎧=++=+=++=1323221313121321233123211W W W W W W W W W W W W 解方程组求得W=2-2求平稳概率符号条件概率状态转移概率解方程组得到 W=2.3 同时掷出两个正常的骰子,也就是各面呈现的概率都为1/6,求: (1) “3和5同时出现”这事件的自信息; (2) “两个1同时出现”这事件的自信息;(3) 两个点数的各种组合(无序)对的熵和平均信息量; (4) 两个点数之和(即2, 3, … , 12构成的子集)的熵; (5) 两个点数中至少有一个是1的自信息量。

解: (1)bitx p x I x p i i i 170.4181log )(log )(18161616161)(=-=-==⨯+⨯=(2)bitx p x I x p i i i 170.5361log )(log )(3616161)(=-=-==⨯=(3)共有21种组合:其中11,22,33,44,55,66的概率是3616161=⨯ 其他15个组合的概率是18161612=⨯⨯symbol bit x p x p X H ii i / 337.4181log 18115361log 3616)(log )()(=⎪⎭⎫ ⎝⎛⨯+⨯-=-=∑(4)参考上面的两个点数的排列,可以得出两个点数求和的概率分布如下:symbolbit x p x p X H X P Xii i / 274.3 61log 61365log 365291log 912121log 1212181log 1812361log 3612 )(log )()(36112181111211091936586173656915121418133612)(=⎪⎭⎫ ⎝⎛+⨯+⨯+⨯+⨯+⨯-=-=⎪⎭⎪⎬⎫⎪⎩⎪⎨⎧=⎥⎦⎤⎢⎣⎡∑(5)bit x p x I x p i i i 710.13611log)(log )(3611116161)(=-=-==⨯⨯=2-4(4)2.5 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。

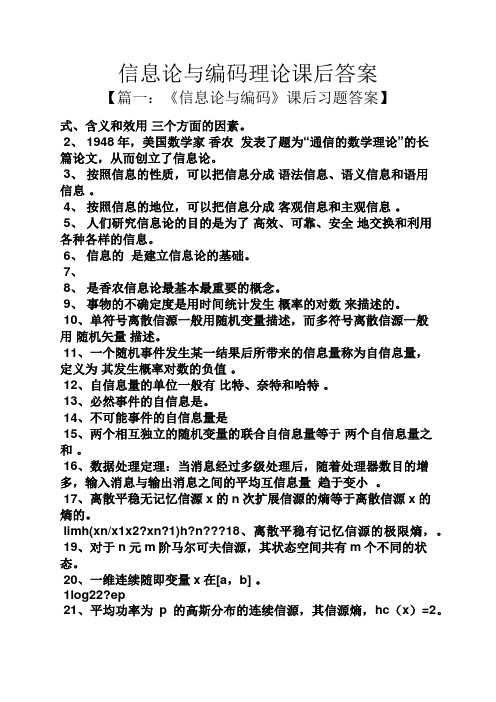

信息论与编码理论课后答案

信息论与编码理论课后答案【篇一:《信息论与编码》课后习题答案】式、含义和效用三个方面的因素。

2、 1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

3、按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。

4、按照信息的地位,可以把信息分成客观信息和主观信息。

5、人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。

6、信息的是建立信息论的基础。

7、8、是香农信息论最基本最重要的概念。

9、事物的不确定度是用时间统计发生概率的对数来描述的。

10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。

12、自信息量的单位一般有比特、奈特和哈特。

13、必然事件的自信息是。

14、不可能事件的自信息量是15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。

16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量趋于变小。

17、离散平稳无记忆信源x的n次扩展信源的熵等于离散信源x的熵的。

limh(xn/x1x2?xn?1)h?n???18、离散平稳有记忆信源的极限熵,。

19、对于n元m阶马尔可夫信源,其状态空间共有m个不同的状态。

20、一维连续随即变量x在[a,b] 。

1log22?ep21、平均功率为p的高斯分布的连续信源,其信源熵,hc(x)=2。

22、对于限峰值功率的n维连续信源,当概率密度均匀分布时连续信源熵具有最大值。

23、对于限平均功率的一维连续信源,当概率密度24、对于均值为0,平均功率受限的连续信源,信源的冗余度决定于平均功率的限定值p和信源的熵功率p25、若一离散无记忆信源的信源熵h(x)等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为。

2728、同时掷两个正常的骰子,各面呈现的概率都为1/6,则“3和5同时出现”这件事的自信息量是 ?mn?ki?11?mp(x)?em29、若一维随即变量x的取值区间是[0,∞],其概率密度函数为,其中:x?0,m是x的数学2期望,则x的信源熵c。

信息论与编码习题参考答案(全)

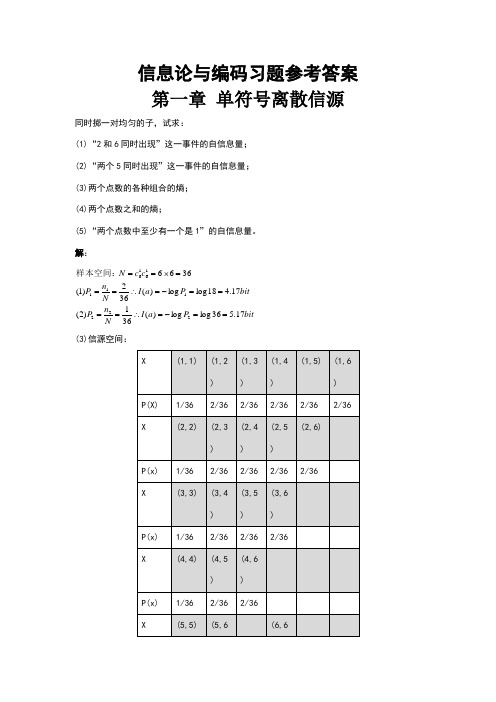

信息论与编码习题参考答案 第一章 单符号离散信源同时掷一对均匀的子,试求:(1)“2和6同时出现”这一事件的自信息量; (2)“两个5同时出现”这一事件的自信息量; (3)两个点数的各种组合的熵; (4)两个点数之和的熵;(5)“两个点数中至少有一个是1”的自信息量。

解:bitP a I N n P bit P a I N n P c c N 17.536log log )(361)2(17.418log log )(362)1(36662221111616==-=∴====-=∴===⨯==样本空间:(3)信源空间:bit x H 32.436log 3616236log 36215)(=⨯⨯+⨯⨯=∴ (4)信源空间:bitx H 71.3636log 366536log 3610 436log 368336log 366236log 36436log 362)(=⨯⨯+⨯+⨯+⨯⨯=∴++ (5) bit P a I N n P 17.11136log log )(3611333==-=∴==如有6行、8列的棋型方格,若有两个质点A 和B ,分别以等概落入任一方格内,且它们的坐标分别为(Xa ,Ya ), (Xb ,Yb ),但A ,B 不能同时落入同一方格内。

(1) 若仅有质点A ,求A 落入任一方格的平均信息量; (2) 若已知A 已落入,求B 落入的平均信息量; (3) 若A ,B 是可辨认的,求A ,B 落入的平均信息量。

解:bita P a P a a P a I a P A i 58.548log )(log )()(H 48log )(log )(481)(:)1(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率bitb P b P b b P b I b P A i 55.547log )(log )()(H 47log )(log )(471)(:B ,)2(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率是落入任一格的情况下在已知bitAB P AB P AB H AB P AB I AB P AB i i i i i i i 14.11)4748log()(log )()()(log )(471481)()3(47481=⨯=-=-=∴⨯=∑⨯=是同时落入某两格的概率从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为%.如果你问一位男士:“你是否是红绿色盲”他的回答可能是:“是”,也可能“不是”。

信息论与编码陈运第二版答案

信息论与编码陈运第二版答案【篇一:信息论与编码第4章】s=txt>(2课时)主要内容:(1)平均失真和信息率失真函数(2)离散信源和连续信源的r(d)计算重点:失真函数、平均失真、信息率失真函数r(d)、信息率失真函数的计算。

难点:信息率失真函数r(d)、信息率失真函数的计算。

作业:4、1。

说明:本堂课推导内容较多,枯燥平淡,不易激发学生兴趣,要注意多讨论用途。

另外,注意,解题方法。

多加一些内容丰富知识和理解。

4-1 引言(一)引入限失真的必要性:失真在传输中是不可避免的;接收者(信宿)无论是人还是机器设备,都有一定的分辨能力与灵敏度,超过分辨能力与灵敏度的信息传送过程是毫无意义的;即使信宿能分辨、能判别,但对通信质量的影响不大,也可以称它为允许范围内的失真;我们的目的就是研究不同的类型的客观信源与信宿,在给定的qos要求下的最大允许(容忍)失真d,及其相应的信源最小信息率r(d)。

对限失真信源,应该传送的最小信息率是r(d),而不是无失真情况下的信源熵h(u). 显然h(u)≥r(d).当且仅当 d=0时,等号成立;为了定量度量d,必须建立信源的客观失真度量,并与d建立定量关系; r(d)函数是限失真信源信息处理的理论基础;(二) r(d)函数的定义?信源与信宿联合空间上失真测度的定义:d(uivj): u?v?r[0,?)其中: ui?u (单消息信源空间) vj?v (单消息信宿空间)则有d???uivjp(uivj)d(uivj)称d为统计平均失真,它在信号空间中可以看作一类“距离”,它有性质 1〉d(uivj)?0, 当ui?vj 2〉ui?u,vj?vmind(uvij)?0473〉0?d(uivj)??对离散信源:i=j=1,2……..n, d(uivj)?dij, 则有:?0,当i?j(无失真)dij??0,当i?j(有失真)?〉若取dij为汉明距离,则有: ?0,当i?j(无失真)dij???1,当i?j(有失真)对连续信源,失真可用二元函数d(u,v)表示。

《信息论与编码》部分课后习题参考答案

1 5 1 5 1 1 1 1 1 1 1 1 = − 2 × log + 2 × log + 2 × log + 2 × log + 2 × log + log 6 36 6 36 9 9 12 12 18 18 36 36 = 3.274 bit / symbol

2.2 如果你在不知道今天是星期几的情况下问你的朋友“明天是星期几?”则答案中含有多 少信息量?如果你在已知今天是星期四的情况下提出同样的问题, 从别人的答案中你能获得 多少信息量(假设已知星期一至星期日得排序)? 答:若不知道今天是星期几,则答案可能有 7 种,这 7 种都是有价值的,所以答案的信息量 为:

2.5 4 个等概率分布的消息 M1、M2、M3、M4 被送入如题所示的信道进行传输,通过编码 使 M1=00,M2=01、M3=10、M4=11.求输入是 M1 和输出的第一个符号是 0 的互信息量是多 少?如果知道第二个符号也是 0,这时带来多少附加信息量? X 0 p p 1 1-p 1-p Y

I(X N ) I (Y )

=

2.1 × 106 13.29

= 1.58 ×105 字

2.4 某居住地区的女孩中有 25%是大学生,在女大学生中有 75%是身高 1.6 米以上的,而女 孩中身高 1.6 米以上的占总数一半。假如我们得知“身高 1.6 米以上的某女孩是大学生”的

消息,问获得多少信息量? 答:设随机变量 X 代表女孩子学历 X x1(是大学生) x2(不是大学生) P(X) 0.25 0.75 设随机变量 Y 代表女孩子身高 Y y1(身高>160cm) P(Y) 0.5

第二章

2.1 同时掷两个骰子,设每个骰子各个面向上的概率都是 1/6。试求: (1)事件“2 和 6 同时出现”的自信息量; (2)事件“两个 3 同时出现”的自信息量; (3)事件“两个点数中至少有一个是 5”的自信息量; (4)两个点数之和的熵。 答: (1)事件“2 和 6 同时出现”的概率为:

信息论与编码(陈运)习题答案

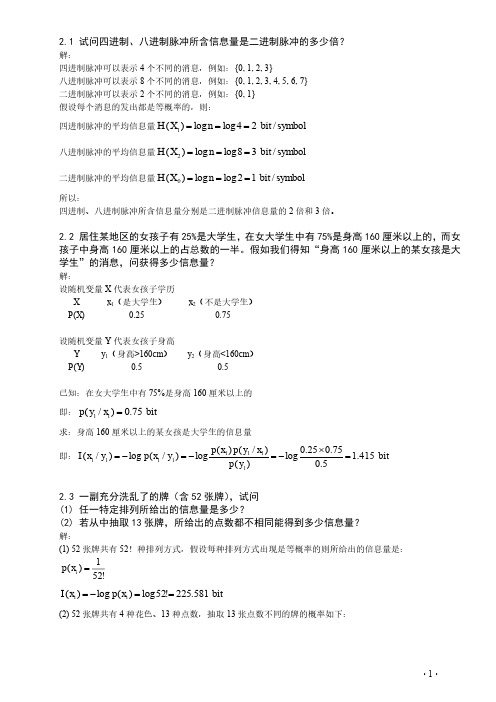

· 1 ·2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍?解:四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3}八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则:四进制脉冲的平均信息量symbol bit n X H / 24log log )(1=== 八进制脉冲的平均信息量symbol bit n X H / 38log log )(2=== 二进制脉冲的平均信息量symbol bit n X H / 12log log )(0=== 所以:四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。

2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。

假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量?解:设随机变量X 代表女孩子学历X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75设随机变量Y 代表女孩子身高Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5已知:在女大学生中有75%是身高160厘米以上的 即:bit x y p 75.0)/(11=求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15.075.025.0log )()/()(log )/(log )/(11111111=⨯-=-=-=2.3 一副充分洗乱了的牌(含52张牌),试问(1) 任一特定排列所给出的信息量是多少?(2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量?解:(1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是:!521)(=i x p bit x p x I i i 581.225!52log )(log )(==-=(2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下:· 2 ·bit C x p x I C x p i i i 208.134log)(log )(4)(135213135213=-=-==2.4 设离散无记忆信源⎭⎬⎫⎩⎨⎧=====⎥⎦⎤⎢⎣⎡8/14/1324/18/310)(4321x x x x X P X ,其发出的信息为(202120130213001203210110321010021032011223210),求 (1) 此消息的自信息量是多少?(2) 此消息中平均每符号携带的信息量是多少?解:(1) 此消息总共有14个0、13个1、12个2、6个3,因此此消息发出的概率是:62514814183⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=p此消息的信息量是:bit p I 811.87log =-=(2) 此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/==2.5 从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为0.5%,如果你问一位男士:“你是否是色盲?”他的回答可能是“是”,可能是“否”,问这两个回答中各含多少信息量,平均每个回答中含有多少信息量?如果问一位女士,则答案中含有的平均自信息量是多少?解: 男士:symbolbit x p x p X H bitx p x I x p bit x p x I x p i i i N N N Y Y Y / 366.0)93.0log 93.007.0log 07.0()(log )()( 105.093.0log )(log )(%93)( 837.307.0log )(log )(%7)(2=+-=-==-=-===-=-==∑女士:symbol bit x p x p X H ii i / 045.0)995.0log 995.0005.0log 005.0()(log )()(2=+-=-=∑2.6 设信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡17.016.017.018.019.02.0)(654321x x x x x x X P X ,求这个信源的熵,并解释为什么H(X) > log6不满足信源熵的极值性。

《信息论与编码》课后习题答案

《信息论与编码》课后习题答案第二章Equation Chapter 1 Section 12.1一个马尔可夫信源有3个符号{}1,23,u u u ,转移概率为:()11|1/2p u u =,()21|1/2p u u =,()31|0p u u =,()12|1/3p u u =,()22|0p u u =,()32|2/3p u u =,()13|1/3p u u =,()23|2/3p u u =,()33|0p u u =,画出状态图并求出各符号稳态概率。

解:状态图如下状态转移矩阵为:1/21/201/302/31/32/30p ⎛⎫ ⎪= ⎪ ⎪⎝⎭设状态u1,u2,u3稳定后的概率分别为W1,W2、W3由1231WP W W W W =⎧⎨++=⎩得1231132231231112331223231W W W W W W W W W W W W ⎧++=⎪⎪⎪+=⎪⎨⎪=⎪⎪⎪++=⎩计算可得1231025925625W W W ⎧=⎪⎪⎪=⎨⎪⎪=⎪⎩2.2 由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =0.8,(0|11)p =0.2,(1|00)p =0.2,(1|11)p =0.8,(0|01)p =0.5,(0|10)p =0.5,(1|01)p =0.5,(1|10)p =0.5。

画出状态图,并计算各状态的稳态概率。

解:(0|00)(00|00)0.8p p ==(0|01)(10|01)0.5p p ==(0|11)(10|11)0.2p p ==(0|10)(00|10)0.5p p == (1|00)(01|00)0.2p p ==(1|01)(11|01)0.5p p == (1|11)(11|11)0.8p p ==(1|10)(01|10)0.5p p ==于是可以列出转移概率矩阵:0.80.200000.50.50.50.500000.20.8p ⎛⎫ ⎪⎪= ⎪ ⎪⎝⎭ 状态图为:设各状态00,01,10,11的稳态分布概率为W1,W2,W3,W4 有411i i WP W W ==⎧⎪⎨=⎪⎩∑ 得 13113224324412340.80.50.20.50.50.20.50.81W W W W W W W W W W W W W W W W +=⎧⎪+=⎪⎪+=⎨⎪+=⎪+++=⎪⎩ 计算得到12345141717514W W W W ⎧=⎪⎪⎪=⎪⎨⎪=⎪⎪⎪=⎩2.3 同时掷出两个正常的骰子,也就是各面呈现的概率都为1/6,求:(1) “3和5同时出现”这事件的自信息; (2) “两个1同时出现”这事件的自信息;(3) 两个点数的各种组合(无序)对的熵和平均信息量; (4) 两个点数之和(即2, 3, … , 12构成的子集)的熵; (5) 两个点数中至少有一个是1的自信息量。

《信息论与编码》部分课后习题参考答案

P ( y1 = 0 | M 1 ) P ( y1 = 0)

因为信道为无记忆信道,所以

P( y1 = 0 | M 1 ) = P( y1 = 0 | x11 x12 = 00) = P( y1 = 0 | x11 = 0) = P(0 | 0) = p

同理,得 I ( y1 = 0 | M i ) = P ( y1 = 0 | xi1 xi 2 ) = P ( y1 = 0 | xi1 ) 输出第一个符号是 y1=0 时, 有可能是四个消息中任意一个第一个数字传送来的。 所以

第二章

2.1 同时掷两个骰子,设每个骰子各个面向上的概率都是 1/6。试求: (1)事件“2 和 6 同时出现”的自信息量; (2)事件“两个 3 同时出现”的自信息量; (3)事件“两个点数中至少有一个是 5”的自信息量; (4)两个点数之和的熵。 答: (1)事件“2 和 6 同时出现”的概率为:

《信息论与编码》

部分课后习题参考答案

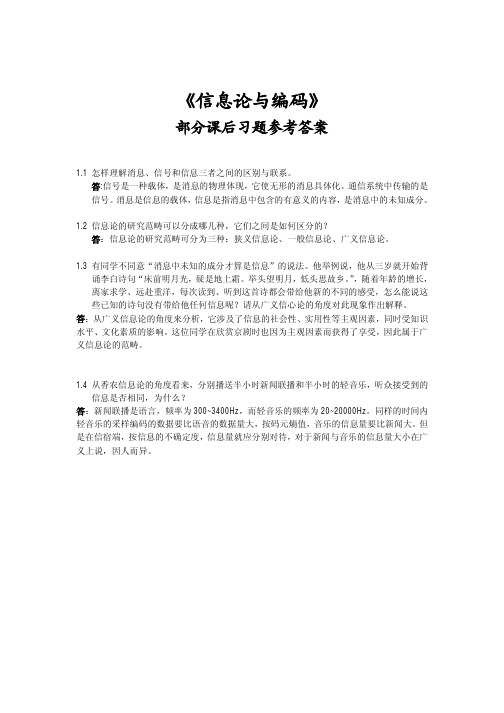

1.1 怎样理解消息、信号和信息三者之间的区别与联系。 答:信号是一种载体,是消息的物理体现,它使无形的消息具体化。通信系统中传输的是 信号。 消息是信息的载体, 信息是指消息中包含的有意义的内容, 是消息中的未知成分。 1.2 信息论的研究范畴可以分成哪几种,它们之间是如何区分的? 答:信息论的研究范畴可分为三种:狭义信息论、一般信息论、广义信息论。 1.3 有同学不同意“消息中未知的成分才算是信息”的说法。他举例说,他从三岁就开始背 诵李白诗句“床前明月光,疑是地上霜。举头望明月,低头思故乡。 ” ,随着年龄的增长, 离家求学、远赴重洋,每次读到、听到这首诗都会带给他新的不同的感受,怎么能说这 些已知的诗句没有带给他任何信息呢?请从广义信心论的角度对此现象作出解释。 答:从广义信息论的角度来分析,它涉及了信息的社会性、实用性等主观因素,同时受知识 水平、文化素质的影响。这位同学在欣赏京剧时也因为主观因素而获得了享受,因此属于广 义信息论的范畴。

《信息论与编码》课后习题答案

《信息论与编码》课后习题答案第二章2.1一个马尔可夫信源有3个符号{}1,23,u u u ,转移概率为:()11|1/2p u u =,()21|1/2p u u =,()31|0p u u =,()12|1/3p u u =,()22|0p u u =,()32|2/3p u u =,()13|1/3p u u =,()23|2/3p u u =,()33|0p u u =,画出状态图并求出各符号稳态概率。

解:状态图如下状态转移矩阵为:1/21/201/302/31/32/30p ⎛⎫ ⎪= ⎪ ⎪⎝⎭设状态u 1,u 2,u 3稳定后的概率分别为W 1,W 2、W 3由1231WP W W W W =⎧⎨++=⎩得1231132231231112331223231W W W W W W W W W W W W ⎧++=⎪⎪⎪+=⎪⎨⎪=⎪⎪⎪++=⎩计算可得1231025925625W W W ⎧=⎪⎪⎪=⎨⎪⎪=⎪⎩2.2 由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =0.8,(0|11)p =0.2,(1|00)p =0.2,(1|11)p =0.8,(0|01)p =0.5,(0|10)p =0.5,(1|01)p =0.5,(1|10)p =0.5。

画出状态图,并计算各状态的稳态概率。

解:(0|00)(00|00)0.8p p == (0|01)(10|01)0.5p p ==(0|11)(10|11)0.2p p == (0|10)(00|10)0.5p p == (1|00)(01|00)0.2p p == (1|01)(11|01)0.5p p == (1|11)(11|11)0.8p p == (1|10)(01|10)0.5p p ==于是可以列出转移概率矩阵:0.80.200000.50.50.50.500000.20.8p ⎛⎫ ⎪⎪= ⎪ ⎪⎝⎭ 状态图为:设各状态00,01,10,11的稳态分布概率为W 1,W 2,W 3,W 4 有411i i WP W W ==⎧⎪⎨=⎪⎩∑ 得 13113224324412340.80.50.20.50.50.20.50.81W W W W W W W W W W W W W W W W +=⎧⎪+=⎪⎪+=⎨⎪+=⎪+++=⎪⎩ 计算得到12345141717514W W W W ⎧=⎪⎪⎪=⎪⎨⎪=⎪⎪⎪=⎩2.3 同时掷出两个正常的骰子,也就是各面呈现的概率都为1/6,求:(1) “3和5同时出现”这事件的自信息; (2) “两个1同时出现”这事件的自信息;(3) 两个点数的各种组合(无序)对的熵和平均信息量; (4) 两个点数之和(即2, 3, … , 12构成的子集)的熵; (5) 两个点数中至少有一个是1的自信息量。

信息论与编码 课后习题答案

信息论与编码课后习题答案信息论与编码课后习题答案[信息论与编码]课后习题答案1、在认识论层次上研究信息的时候,必须同时考虑到形式、含义和效用三个方面的因素。

2、1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

3、按照信息的性质,可以把信息分为语法信息、语义信息和语用信息。

4、按照信息的地位,可以把信息分成客观信息和主观信息。

5、人们研究信息论的目的就是为了高效率、可信、安全地互换和利用各种各样的信息。

6、信息的是建立信息论的基础。

8、就是香农信息论最基本最重要的概念。

9、事物的不确定度是用时间统计发生概率的对数来描述的。

10、单符号线性信源通常用随机变量叙述,而多符号线性信源通常用随机矢量叙述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。

12、自信息量的单位通常存有比特、奈特和哈特。

13、必然事件的自信息是。

14、不可能将事件的自信息量就是15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。

16、数据处理定理:当消息经过多级处置后,随着处理器数目的激增,输出消息与输入消息之间的平均值互信息量趋向变大。

17、离散平稳无记忆信源x的n次扩展信源的熵等于离散信源x的熵的。

limh(xn/x1x2xn1)h n18、线性稳定存有记忆信源的音速熵,。

19、对于n元m阶马尔可夫信源,其状态空间共有m个不同的状态。

20、一维已连续随即变量x在[a,b]。

1log22ep21、平均功率为p的高斯分布的已连续信源,其信源熵,hc(x)=2。

22、对于限峰值功率的n维连续信源,当概率密度均匀分布时连续信源熵具有最大值。

23、对于减半平均功率的一维已连续信源,当概率密度24、对于均值为0,平均功率受限的连续信源,信源的冗余度决定于平均功率的限定值p和信源的熵功率p25、若一线性并无记忆信源的信源熵h(x)等同于2.5,对信源展开相切的并无杂讯二进制编码,则编码长度至少为。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

∑∑∑ ∑∑ = ?

p x x x( i1 i2i3 )log p x( i3 / x xi1 i2 ) +

p x x( i1 i3 )log p x( i3 / xi1)

i1 i2 i3

i1 i3

∑∑∑ ∑∑∑ = ?

p x x x( i1 i2i3 )log p x( i3 / x xi1 i2 ) +

0.25

0.75

设随机变量 Y 代表女孩子身高

Y y1(身高>160cm) y2(身高<160cm)

P(Y)

0.5

0.5

已知:在女大学生中有 75%是身高 160 厘米以上的

即: p y( 1 / x1) = 0.75 bit

求:身高 160 厘米以上的某女孩是大学生的信息量

p x p y( 1) ( 1 / x1 ) log 0.25×0.75 =1.415 bit 即:I

∴H X X( 1 2...Xn) ≤ H X( 1)+H X( 2)+H X( 3)+ +... H X( n)

2.9 设有一个信源,它产生 0,1 序列的信息。它在任意时间而且不论以前发生过什么符号, 均按 P(0) = 0.4,P(1) = 0.6 的概率发出符号。 (1) 试问这个信源是否是平稳的? (2) 试计算 H(X2), H(X3/X1X2)及 H∞; (3) 试计算 H(X4)并写出 X4 信源中可能有的所有符号。

0.17??

HX

i

px px

=?(0.2log0.2 + + + + + H X( ) > log 62 = 2.585

= 2.657 bit symbol/

不满足极值性的原因是

。

i

2.7 证明:H(X3/X1X2) ≤ H(X3/X1),并说明当 X1, X2, X3 是马氏链时等式成立。证明:

H X( 3 / X X1 2 ) ? H X( 3 / X1)

?p x( 1 ) = p e( 1 ) (p x1 /e1 ) + p e( 2 ) (p x1 /e2 ) = p p e?( 1 ) + p p e?( 2 ) = (p + p)/3 =1/3

?? ?p x( 2 ) = p e( 2 ) (p x2 /e2 ) + p e( 3 ) (p x2 /e3 ) =p p e?( 2 ) + p p e?( 3 ) = (p + p)/3 =1/3

解: (1)

?p e( 1 ) = p e p e( 1 ) ( 1 /e1 ) + p e( 2 ) (p e1 /e2 ) ? ?p e( 2 ) = p e( 2 ) (p e2 /e2 ) + p e( 3 ) (p e2 /e3 )

??p e( 3 ) = p e( 3 ) (p e3 /e3 ) + p e p e( 1 ) ( 3 /e1 ) ?p e( 1 ) = p p e?( 1 ) + p p e? ( 2 ) ?? ?p e( 2 ) = p p e? ( 2 ) + p p e? ( 3 )

p x( i ) =

I x( i ) =?log p x( i ) = log52!= 225.581 bit

(2) 52 张牌共有 4 种花色、13 种点数,抽取 13 张点数不同的牌的概率如下:

413 p x( i ) =

C5213 413

I x( i ) = ?log p x( i ) = ?log C5213 =13.208 bit

信息论与编码课后习题答案详解

2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍?

解: 四进制脉冲可以表示 4 个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示 8 个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表 示 2 个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则:

I X( 2 ;X1 ) ≥ 0

? H X( 2 ) ≥ H X( 2 / X1 )

I X( 3;X X1 2 ) ≥ 0

? H X( 3 ) ≥ H X( 3

/ X X1 2 )

...

I X( N;X X1 2...Xn?1) ≥ 0

? H X( N ) ≥ H X( N / X X1 2...Xn?1)

H∞ = lim H X(

N?>∞

(3)

i

N / X X1

∑ 2 ) = H X( 3 ) = ? p x( i )log p x( i ) = ?(0.4log0.4+ =

2...X N?1 ) = H X( N ) = 0.971 bit symbol/

H X(4 ) = 4H X( ) = ?4×(0.4log0.4+ = 3.884 bit symbol/

???p e( 3 ) = p p e?( 3 ) + p p e?

( 1)

?p e( 1 ) = p e( 2 ) = p e( 3 ) ?

?p e( 1 ) + p e( 2 ) + p e( 3 ) =1 ?p e( 1 ) =1/3 ? ?p e( 2 ) =1/3 ??p e( 3 )

=1/3

∑∑∑ ∑∑∑ = ??

p x x( i1 i2 ) (p xi3 / xi1) ?

p x x x( i1 i2i3 )??log2 e

? i1 i2 i3

i1 i2 i3

?

?

?

??

∑∑ ∑ = ??

p x x( i1 i2 )? p x( i3 / xi1)? ?1??log2 e

? i1 i2

? i3

H X(

i

? X ? ? x 2.6

设信源 = 1

x2

x3 x4

x5

0.045 bit symbol/

)

p x( )log p x( )

x6 ? ,求这个信源的熵,并解释为什么

?P X()?? ??0.2 0.19 0.18 0.17 0.16 ?

H(X) > log6 不满足信源熵的极值性。

解:

13

=?

??

1 ?p ?log 3

p +1? 3p

log

1 +? p 3p

?log

p

+ 1 ?p ?log 3

p +1 ? 3p

?log

+ 1 ?p ?log p3

p???

?

( ) = ? p?log p + p?log p bit symbol /

2.11 黑白气象传真图的消息只有黑色和白色两种,即信源 X={黑,白}。设黑色出现的概率为 P(黑) = 0.3,白色出现的概率为 P(白) = 0.7。 (1) 假设图上黑白消息出现前后没有关联,求熵 H(X); (2) 假设消息前后有关联,其依赖关系为 P(白/白) = 0.9,P(黑/白) = 0.1,P(白/黑) =

X 4 的所有符号:

0000 0001 00100011 0100 0101 01100111 1000 1001 10101011 1100 1101 11101111 2.10 一阶马尔可夫信源的状态图如下图所示。信源 X 的符号集为{0, 1, 2}。 (1) 求平稳后信源的概率分布; (2) 求信源的熵 H∞。

p = ??3??14 ×?? 1 ??25 ×?? 1??6 ?8? ? 4? ?8?

此消息的信息量是:I =?log p =87.811 bit

(2) 此消息中平均每符号携带的信息量是:I n/ = 87.811/ 45 =1.951 bit 2.5 从大量统计资料知道,男性中红绿色盲的发病率为 7%,女性发病率为 0.5%,如果你问一 位男士:“你是否是色盲?”他的回答可能是“是”,可能是“否”,问这两个回答中各含 多少信息量,平均每个回答中含有多少信息量?如果问一位女士,则答案中含有的平均自信 息量是多少?解:男士:

x( 1 / y1 ) = ?log p x( 1 / y1 ) = ?log = ?

p y( 1 )

0.5

2.3 一副充分洗乱了的牌(含 52 张牌),试问 (1) 任一特定排列所给出的信息量是多少? (2) 若从中抽取 13 张牌,所给出的点数都不相同能得到多少信息量?

解:

(1) 52 张牌共有 52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是:

p x x x( i1 i2i3 )log p x( i3 / xi1)

i1

i2 i3 i1 i2 i3 p x( i3 / xi1)

∑∑∑ =

i1 i2

i3 p x x x( i1 i2 i3 )log p x( i3 / x xi1 i2 )

∑∑∑ ≤

i1 i2

? p x( i3 / xi1) 1???log2 e i3 p x x x( i1 i2 i3 )??? p x( i3 / x xi1 i2 ) ? ?

2.4 设离散无记忆信源???P X(X )??? = ???x31 /=80 x2 =1 x3 = 2 x4 = 3??,其发出的信息为

1/4 1/4 1/8 ? ,求 (1) 此消息的自信息量是多少? (2) 此消息中平均每符号携带的信息量是多少? 解:

(1) 此消息总共有 14 个 0、13 个 1、12 个 2、6 个 3,因此此消息发出的概率是:

???p x( 3 ) = p e( 3 ) (p x3 /e3 ) + p e p x( 1 ) ( 3 /e1 ) = p p e? ?X ? ?0 1 2?