MapReudce详解

【计算机科学】_正确性证明_期刊发文热词逐年推荐_20140723

2011年 科研热词 推荐指数 标准模型 2 基于身份的密码 2 非递归 1 连续时间markov决策过程 1 语义网 1 计算diffie-hellman问题 1 模糊本体 1 模拟 1 模型论语义 1 模型检测 1 意图生成 1 性质保持 1 循环不变式 1 形式化方法 1 存储 1 基于身份的代理签名 1 回答集逻辑程序 1 回答集 1 否定圈 1 可达概率 1 可信验证 1 参数化系统验证 1 动态门限代理签名 1 功能性能 1 划分集 1 关系数据库 1 信息容量 1 二维抽象 1 三值光学计算机加法器 1 三值光学处理器 1 par方法 1 msd 1 koch曲线 1 cdh-问题 1 bdiagent 1 agent编程语言 1 agentspeak 1

科研热词 推荐指数 除算子 2 等价变换 2 描述逻辑 2 原始算子 2 关系代数的派生算子 2 一阶逻辑 2 阻断攻击 1 闭包系统 1 转换算法 1 规范化的抽象语法树文本 1 自动推理 1 组密钥协商 1 线性时态逻辑 1 策略规范 1 程序分析 1 移动计算 1 离散对数问题 1 知识表示 1 着色时间petri网 1 目标独立 1 流体随机petri网 1 正确性 1 模糊描述逻辑 1 模糊er模型 1 模型转换 1 模型检验 1 概念格 1 概念图 1 构造算法 1 服务网格 1 时间自动机 1 授权决策 1 抽象语法树的解析 1 抽象语法树文本 1 抽象语法树(ast) 1 抽象解释 1 形式化方法 1 形式化分析 1 广播 1 并行算法 1 工作流网 1 密钥管理 1 密码体制 1 安全协议 1 委托凭证 1 划分 1 冗余 1 串空间 1 上下文信息 1 一阶混杂petri网 1 prolog语义 1 petri网 1

Map-Reduce具体实现详解

Map-Reduce具体实现详解Keyword:FileSplit:文件的子集--文件分割体简介:这篇文档描述在hadoop中map和reduce操作是怎样具体完成的。

如果你对Google的MapReduce各式模式不熟悉,请先参阅MapReduce--/papers/mapreduce.htmlMap由于Map是并行地对输入的文件集进行操作,所以它的第一步(FileSplit) 就是把文件集分割成一些子集.如果一个单个的文件大到它已影响到查找效率时,它会被分割成一些小的分割体。

要指出的是分割这个一步是不知道输入文件的内部逻辑结构的,比如,以行为逻辑分割的文本文件会被以任意的字节界限分割,所以这个具体分割要自己去指定也可以用hadoop已经定义的几个简单分割。

然后每个文件分割体都会对应地有一个新的map任务。

当单个map任务开始时,它会对每个配置过的reduce任务开启一个新的输出书写器(writer).紧接着它(writer)会用从指定的特定InputFormat里得到的RecordReader去读它的文件分割体。

InputFormat类分析输入文件并产生key-value键值对.同时InputFormat必需要处理在以文件分割时边界处的记录。

比如TextInputFormat会读取分割边界的文件分割体有最后一行,如果当读取的分割体不是第一个时,TextInputFormat会忽略第一行的内容。

InputFormat类并不需要产生一些对有意义的键值对。

比如TextInputFormat类的默认输出是以输入文本的行内容为value,以行偏移量为key--大多数应用只用到而很少用到偏移量。

传给用户配置的mapper的键值对都是从RecordReader读入的,用户提供的Mapper类就可以对键值对进行任意的操作再调用OutputCollector.collect方法来重新收集自己定义后的键值对。

产生的输出必需用一个Key类和一个value 类,这是因为Map的输出结果要被以SequenceFile的形式写入磁盘,这种形式包括每个文件的类型信息和所有的记录都是同类形的(如果你想输出不同的数据结构你可以继承个子类出来)。

Map-Reduce入门过程解释(温度示例)

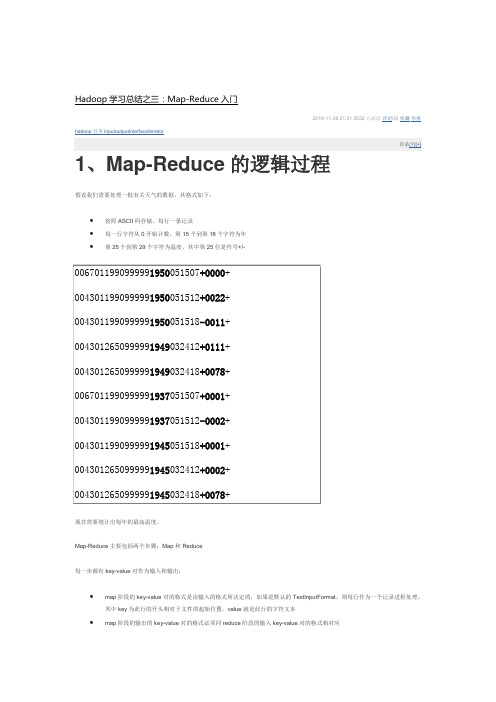

∙按照ASCII码存储,每行一条记录∙每一行字符从0开始计数,第15个到第18个字符为年∙第25个到第29个字符为温度,其中第25位是符号+/-现在需要统计出每年的最高温度。

Map-Reduce主要包括两个步骤:Map和Reduce每一步都有key-value对作为输入和输出:∙map阶段的key-value对的格式是由输入的格式所决定的,如果是默认的TextInputFormat,则每行作为一个记录进程处理,其中key为此行的开头相对于文件的起始位置,value就是此行的字符文本∙map阶段的输出的key-value对的格式必须同reduce阶段的输入key-value对的格式相对应对于上面的例子,在map过程,输入的key-value对如下:在map过程中,通过对每一行字符串的解析,得到年-温度的key-value对作为输出:在reduce过程,将map过程中的输出,按照相同的key将value放到同一个列表中作为reduce的输入在reduce过程中,在列表中选择出最大的温度,将年-最大温度的key-value作为输出:其逻辑过程可用如下图表示:2、编写Map-Reduce程序编写Map-Reduce程序,一般需要实现两个函数:mapper中的map函数和reducer中的reduce函数。

一般遵循以下格式:map: (K1, V1) -> list(K2, V2)reduce: (K2, list(V)) -> list(K3, V3)对于上面的例子,则实现的mapper如下:实现的reducer如下:欲运行上面实现的Mapper和Reduce,则需要生成一个Map-Reduce得任务(Job),其基本包括以下三部分:∙输入的数据,也即需要处理的数据∙Map-Reduce程序,也即上面实现的Mapper和Reducer∙此任务的配置项JobConf欲配置JobConf,需要大致了解Hadoop运行job的基本原理:∙Hadoop将Job分成task进行处理,共两种task:map task和reduce task∙Hadoop有两类的节点控制job的运行:JobTracker和TaskTrackero JobTracker协调整个job的运行,将task分配到不同的TaskTracker上o TaskTracker负责运行task,并将结果返回给JobTracker∙Hadoop将输入数据分成固定大小的块,我们称之input split∙Hadoop为每一个input split创建一个task,在此task中依次处理此split中的一个个记录(record)∙Hadoop会尽量让输入数据块所在的DataNode和task所执行的DataNode(每个DataNode上都有一个TaskTracker)为同一个,可以提高运行效率,所以input split的大小也一般是HDFS的block的大小。

map函数和reduce函数的使用

map函数和reduce函数的使用Map函数和Reduce函数是两个非常重要的概念,它们可以作为在大数据处理中的一种优秀的并行计算模型。

前者主要是将一个输入的集合通过映射规则转换为一个输出集合,而后者主要是通过对输入的集合中各元素进行聚合操作来得到一个最终的输出结果。

在这里,我们将深入探讨Map函数和Reduce函数的使用方法以及它们在实际中的应用。

首先,我们来看看Map函数。

Map函数可以接收一个函数和一个可迭代对象的集合,然后将该函数逐个应用于可迭代对象的每个元素上。

最终,Map函数将返回一个生成器对象,其中包含每个应用程序功能的结果。

例如,如果我们要将一个列表中的所有元素进行加倍处理,我们可以使用Map函数来实现:```numbers = [1, 2, 3, 4, 5]doubled_numbers = map(lambda x: x * 2, numbers)print(list(doubled_numbers))```运行程序后,它将输出以下结果:```[2, 4, 6, 8, 10]```可以看出,Map函数很容易使用,并且可以轻松地将映射规则应用于数据集合中的每个元素。

接下来,让我们来看看Reduce函数。

Reduce函数可以接收一个函数和一个可迭代对象的集合,然后将该函数逐个应用于可迭代对象的元素对中。

具体来说,Reduce函数将应用程序函数作用于序列的两个相邻元素,然后将结果与序列中的下一个元素重复该过程,直到序列只有一个元素为止。

最终,Reduce函数将返回一个聚合后的结果。

例如,如果我们要将一个列表中的所有元素相加,我们可以使用Reduce函数来实现:```from functools import reducenumbers = [1, 2, 3, 4, 5]sum_of_numbers = reduce(lambda x, y: x + y, numbers)print(sum_of_numbers)```运行程序后,它将输出以下结果:```15```可以看出,Reduce函数非常适合处理具有二元性质的聚合操作,例如加和,乘积等。

Map和Reduce的步骤图解

Map和reduce一.Map和reduce的两种操作方式1.Map--reduce环境下多连接查询优化的研究随着社会的发展和数据产生成本的下降,人类产生的数据量正在呈指数级增长,所以海量数据的分析逐渐被人们所关注。

分布式计算被越来越广泛地应用到海量数据分析上,因为集中式的数据仓库在面对爆炸式增长的数据时不能提供较好的可扩展性,而利用分布式计算可以将一个任务分配到多个节点上并行执行,从而获得更好的执行效果。

而google提出的map-reduce框架则为分布式计算提供了很好的框架,它是业界广泛认可的解决海量数据分析的有效工具。

在map-reduce上执行多表连接的方法主要有两种,分别是层叠法和复制哈希法。

但这两种方法都有各自的缺点,它们在某些情况下的效率会比较差。

通过研究,本文提出一种将层叠法和复制哈希法相结合的方法(CRMJ)。

在执行多连接的过程中,会对一些连接采用复制哈希法,而对另外一些连接采用层叠法,这样会取得比这两种方法都好的效果。

采用这种方法会产生很多种执行计划,从而需要判断哪种执行计划所需执行代价最低,所以本文提出了两种寻优算法以找到最优执行计划。

第一种是穷举法寻优算法。

该算法使用连接图划分和递归思想近似遍历所有可能的执行计划,找到最优的执行计划,并进一步通过剪枝缩减搜索空间。

但该种方法通过减枝进行优化所消耗的时间会随着连接表个数的增加而急剧增加,导致算法复杂度很高。

第二种是基于贪婪的寻优算法。

该算法在多连接的层叠法最优执行计划的基础上,寻找代价节省最多的复制哈希连接。

应用该算法可以在较低的复杂度下找到近似最优的执行计划。

经过实验验证,本文提出的CRMJ连接方法要比传统的层叠连接法有更高的执行效率。

同时还通过实验说明:在连接表个数较少时穷举法最优执行计划选取的效果较好;而当连接表个数较多时贪婪寻优算法效果较好。

2.基于Map-Reduce分布式日志信息处理研究与实现随着互联网的高速发展,电子商务网站每天需要处理的日志信息多达几terabyte。

【计算机科学】_服务聚类_期刊发文热词逐年推荐_20140727

推荐指数 2 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1

2013年 序号 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16

科研热词 聚类 本体 语义相似度 语义web服务 能力 聚类算法 检索 标签 服务发现 文本聚类 推荐 不确定域 web服务 mashup dkc值 2d-距离

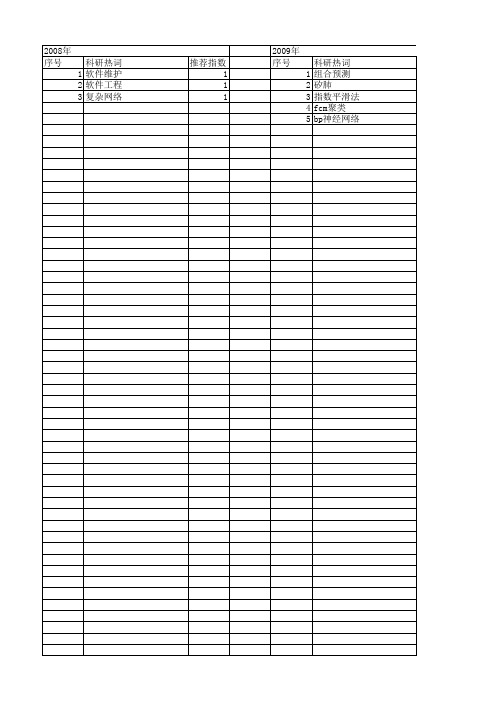

2008年 序号

科研热词 1 软件维护 2 软件工程 3 复杂网络

推荐指数 1 1 1

2009年 序号 1 2 3 4 5

科研热词 组合预测 矽肺 指数平滑法 fcm聚类 bp神经网络

推荐指数 1 1 1 1 1

2010年 序号 1 2 3 4 5 6 7 8 9 10 11 12

科研热词 贝叶斯网络 语义 缩放模式 粗糙遗传算法 相似度 本体 服务推荐 普适计算 文本聚类 多agent 基因表达 1 1 1 1 1 1 1 1 1 1

2014年 序号 1 2 3 4 5

2014年 科研热词 聚类 模糊 服务组合 服务发现 分布式 推荐指数 1 1 1 1 1

推荐指数 1 1 1 1 1 1 1 1 1 1 1 1

2011年 序号 1 2 3 4 5 6 7 8 9 10 11

2011年 科研热词 聚类 需求上下文 自适应权重 粗糙集 粗糙k均值 模糊聚类 模式噪声 服务质量 数据挖掘 数字图像取证 推荐不可信度 推荐指数 2 1 1 1 1 1 1 1 1 1 1

2012年 序号 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32

轻松掌握 mapereduce代码解析与案例

轻松掌握mapereduce代码解析与案例MapReduce 是一种编程模型,用于大规模数据集(大规模数据集)的并行运算。

它通过将任务分解成多个小任务,然后分别在集群中的不同节点上执行这些任务,从而实现高效的数据处理。

在本文中,我们将轻松掌握MapReduce 的代码解析,并通过案例深入了解其应用。

一、MapReduce 基本概念MapReduce 由两个主要阶段组成:Map 阶段和Reduce 阶段。

1.Map 阶段:将输入数据切分成若干个小数据块,然后对每个数据块进行并行处理,生成一系列键值对(key-value pairs)。

2.Reduce 阶段:将Map 阶段产生的键值对按照键进行分组,然后对每个分组进行聚合操作,生成最终的输出结果。

二、MapReduce 代码解析下面以一个简单的WordCount(单词计数)程序为例,对MapReduce 代码进行解析。

1.Map 阶段代码:```javapublic class MapClass extends Mapper<LongWritable, Text, Text, IntWritable> {private final static IntWritable one = new IntWritable(1);private Text word = new Text();public void map(LongWritable key, Text value, Context context)throws IOException, InterruptedException {String line = value.toString();StringTokenizer tokenizer = new StringTokenizer(line);while (tokenizer.hasMoreTokens()) {word.set(tokenizer.nextToken());context.write(word, one);}}}```这段代码定义了一个Mapper 类,输入键类型为LongWritable,输入值类型为Text,输出键类型为Text,输出值类型为IntWritable。

map reduce 原理

map reduce 原理MapReduce原理MapReduce是一种大规模数据处理框架,由Google首先提出,其主要思想是将计算任务分解成许多小的任务,再将这些小任务分配给不同的计算节点,最后将结果合并得到最终结果。

MapReduce的核心思想是分而治之,将一个大问题分解成许多小问题,再将这些小问题分配给多个节点进行并行计算,最终将结果合并得到最终结果。

MapReduce的基本工作流程可以分为两个阶段:Map阶段和Reduce 阶段。

在Map阶段中,系统会将输入数据分割成多个小块,每个小块由一个Map任务处理。

Map任务的输入是一组键值对,其输出也是一组键值对。

在Map任务中,用户需要自定义一个map函数,将输入的键值对转换为中间键值对。

这些中间键值对会被排序后分配给Reduce任务处理。

在Reduce阶段中,系统会将中间键值对按照键进行分组,每组由一个Reduce任务处理。

Reduce任务的输入是一组具有相同键的中间键值对,其输出也是一组键值对。

在Reduce任务中,用户需要自定义一个reduce函数,将输入的中间键值对合并为最终结果。

MapReduce的优点在于其良好的可扩展性和容错性。

由于MapReduce 将计算任务分解成多个小任务并行计算,因此可以轻松地扩展计算能力,提高处理大规模数据的效率。

同时,由于MapReduce采用了数据冗余和任务备份等机制,即使某个节点出现故障,计算任务也能够在其他节点上继续执行,从而保证了计算任务的容错性。

除了基本的Map和Reduce操作外,MapReduce框架还提供了许多其他操作,包括Combiner、Partitioner、InputFormat和OutputFormat等。

其中,Combiner操作可以在Map任务输出中间结果之前对其进行合并,从而减少Reduce任务的输入数据量;Partitioner操作可以将中间结果按照特定规则分配给Reduce任务;InputFormat和OutputFormat操作可以分别处理输入和输出数据的格式,支持多种不同的数据源和数据格式。

离线数据分析流程介绍

离线数据分析流程介绍流程介绍数据分析流程介绍离线数据分析3. 离线注:本环节主要感受数据分析系统的宏观概念及处理流程,初步理解hadoop等框架在其中的应⽤环节,不⽤过于关注代码细节⼀个应⽤⼴泛的数据分析系统:“web⽇志数据挖掘”3.1 需求分析3.1.1 案例名称“⽹站或APP点击流⽇志数据挖掘系统”。

3.1.2 案例需求描述“Web点击流⽇志”包含着⽹站运营很重要的信息,通过⽇志分析,我们可以知道⽹站的访问量,哪个⽹页访问⼈数最多,哪个⽹页最有价值,⼴告转化率、访客的来源信息,访客的终端信息等。

3.1.3 数据来源本案例的数据主要由⽤户的点击⾏为记录获取⽅式:在页⾯预埋⼀段js程序,为页⾯上想要监听的标签绑定事件,只要⽤户点击或移动到标签,即可触发ajax请求到后台servlet程序,⽤log4j记录下事件信息,从⽽在web服务器(nginx、tomcat等)上形成不断增长的⽇志⽂件。

形如:58.215.204.118 - - [18/Sep/2013:06:51:35 +0000] "GET /wp-includes/js/jquery/jquery.js?ver=1.10.2 HTTP/1.1" 304 0"http://blog.fens.me/nodejs-socketio-chat/" "Mozilla/5.0 (Windows NT 5.1;rv:23.0) Gecko/20100101 Firefox/23.0"3.2 数据处理流程3.2.1 流程图解析本案例跟典型的BI系统极其类似,整体流程如下:但是,由于本案例的前提是处理海量数据,因⽽,流程中各环节所使⽤的技术则跟传统BI完全不同,后续课程都会⼀⼀讲解:1) 数据采集:定制开发采集程序,或使⽤开源框架FLUME2) 数据预处理:定制开发mapreduce程序运⾏于hadoop集群3) 数据仓库技术:基于hadoop之上的Hive4) 数据导出:基于hadoop的sqoop数据导⼊导出⼯具5) 数据可视化:定制开发web程序或使⽤kettle等产品6) 整个过程的流程调度:hadoop⽣态圈中的oozie⼯具或其他类似开源产品3.2.2 项⽬技术架构图3.2.3 项⽬相关截图(感性认识,欣赏即可)a) Mapreudce程序运⾏b) 在Hive中查询数据c) 将统计结果导⼊mysql./sqoop export --connect jdbc:mysql://localhost:3306/weblogdb --username root --password root --table t_display_xx --export-dir/user/hive/warehouse/uv/dt=2014-08-033.3 项⽬最终效果经过完整的数据处理流程后,会周期性输出各类统计指标的报表,在⽣产实践中,最终需要将这些报表数据以可视化的形式展现出来,本案例采⽤web程序来实现数据可视化效果如下所⽰:。

【计算机科学】_测试平台_期刊发文热词逐年推荐_20140727

科研热词 gcc 高性能计算 运算延迟 路由管理平台 资源配置 调度算法 调度方法 诊疗费用 评估与分析 评估与优化 认知无线 融合乘加 自动抄表 自动并行化 自动向量化 编程语言 统计分析 粗糙集 研究进展 电力线载波通信 浮点性能 浮点加法 浮点乘法 模糊熵 条件信息熵 智能电网 握手信息 微小卫星 异构计算 并行计算 并行编程模型 并行统计计算 嵌入式瘦web服务器 属性约简 实时更新 安全 增强的syn 可靠 发展趋势 参数相空间 动量相空间 动态负载均衡算法 加速打开机制 列数据库 分离通路 分布式众核 分层赋时着色petri网 典型编译器 信息熵 住院天数 任务调度机制 云计算

推荐指数 2 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1

2009年 序号 1 2 3 4 5 6 7 8

科研热词 移动自组织 核心网 实时响应 安全信息融合 威胁建模 仿真研究 umts nsis

推荐指数 1 1 1 1 1 1 1 1

推荐指数 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1

2013年 序号 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52

推荐指数 2 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

MapReduce

• Map Grab the relevant data from the source User function gets called for each chunk of input

• Reduce Aggregate the results User function gets called for each unique key

– Produces intermediate key/value pairs – These are buffered in memory

read

Shard 2

Map worker

Step 4: Create intermediate files

• Intermediate key/value pairs produced by the user‟s map function buffered in memory and are periodically written to the local disk

User progra m

Remote fork

master

worker

worker

worker

…

Step 3: Map Task

• Reads contents of the input shard assigned to it

• Parses key/value pairs out of the input data • Passes each pair to a user-defined map function

Distributed Systems

16. MapReduce

Paul Krzyzanowski Rutgers University Fall 2013

October 30, 2013

© 2013 Paul Krzyzanowski

1

Credit

Much of this information is from the Google Code University:

• Start up many copies of the program on a cluster of machines

– 1 master: scheduler & coordinator – Lots of workers

• Ir:

– Partitioned into R regions by a partitioning function

• Notifies master when complete

– Passes locations of intermediate data to the master – Master forwards these locations to the reduce worker

– map tasks (each works on a shard) – there are M map tasks – reduce tasks (each works on intermediate files) – there are R

• R = # partitions, defined by the user

/edu/parallel/mapreduce-tutorial.html

See also: /common/docs/current/

for the Apache Hadoop version

Read this (the definitive paper):

Who has it?

• Google:

– Original proprietary implementation

• Apache Hadoop MapReduce

– Most common (open-source) implementation – Built to specs defined by Google

• No dependency among data

• Data can be split into equal-size chunks • Each process can work on a chunk

• Master/worker approach

– Master:

• Initializes array and splits it according to # of workers • Sends each worker the sub-array • Receives the results from each worker

• Inspired by LISP

– Map(function, set of values)

• Applies function to each value in the set (map „length „(() (a) (a b) (a b c))) ⇒ (0 1 2 3)

– Reduce(function, set of values)

/papers/mapreduce.html

Background

• Traditional programming is serial

• Parallel programming

– Break processing into parts that can be executed concurrently on multiple processors

– MapReduce library groups together all intermediate values associated with the same intermediate key & passes them to the Reduce function

• Reduce: intermediate(key/value pairs) → result files

• Break up the input data into M pieces (typically 64 MB)

Shard 0

Shard 1

Shard 2

Shard 3

…

Shard M-1

Input files Divided into M shards

Step 2: Fork processes

• Combines all the values using a binary function (e.g., +) (reduce #'+ „(1 2 3 4 5)) ⇒ 15

MapReduce

• MapReduce

– Framework for parallel computing – Programmers get simple API – Don‟t have to worry about handling

Intermediate file

read Shard 2

MapReduce: what happens in between?

• Map

Map Worker Reduce Worker

– Grab the relevant data from the source (parse into key, value) – Write it to an intermediate file

MapReduce: the complete picture

client

forks

master

Shard 0

Shard 1

Map worker

Assign tasks IF

Reduce worker

Shard 2

Shard 3 … Shard M-1

Map worker

Output file 1

• Amazon Elastic MapReduce

– Uses Hadoop MapReduce running on Amazon EC2

MapReduce

• Map: (input shard) → intermediate(key/value pairs)

– Map calls are distributed across machines by automatically partitioning the input data into M "shards".

– Accepts an intermediate key & a set of values for the key – It merges these values together to form a smaller set of values

– Reduce calls are distributed by partitioning the intermediate key space into R pieces using a partitioning function (e.g., hash(key) mod R).The user specifies the # of partitions (R) and the partitioning function.

– Worker:

• Receives a sub-array from master • Performs processing • Sends results to master

MapReduce

• Created by Google in 2004

– Jeffrey Dean and Sanjay Ghemawat

• Partition

– Partitioning: identify which of R reducers will handle which keys – Map partitions data to target it to one of R Reduce workers based on a partitioning function (both R and partitioning function user defined)